Алгоритм майнинга Scrypt. Алгоритм Scrypt — это программный… | by 51asic

Многочисленный интерес к криптовалюте вызывается ежедневно со стороны простых пользователей интернета. Они не могут понять сути: почему цифровые монеты пользуются таким огромным спросом; почему курс на них стабильно растет; почему инвесторы тратят тысячи долларов для того, чтобы приобрести биткоины? В итоге люди начинают интересоваться криптовалютами и их алгоритмами для майнинга. Один из таковых — алгоритм Scrypt.

Сегодня Scrypt занимает второе место в рейтинге среди популярных алгоритмов для майнинга. С самого первого этапа было понятно, что алгори]SHA-256[/anchor] слишком прост в реализации, поэтому был разработан Sсrypt. Алгоритм Scrypt разрабатывался именно для того, чтобы усложнить реализацию добычи биткоинов при помощи ASIC. За счет алгоритма Sсrypt потребовались более внушительные мощности для добычи криптовалюты.

Майнинг биткоинов очень быстро «перекочевал» с процессора на видеокарты, а после — вовсе на FPGA. Чуть позже программисты сумели запустить заточенные под майнинг микросхемы ASIC.

Что такое майнинг на Scrypt

Под понятием «майнинг Scrypt» имеется в виду добыча криптовалюты на алгоритме Scrypt. История его появления начинается с биткоина.

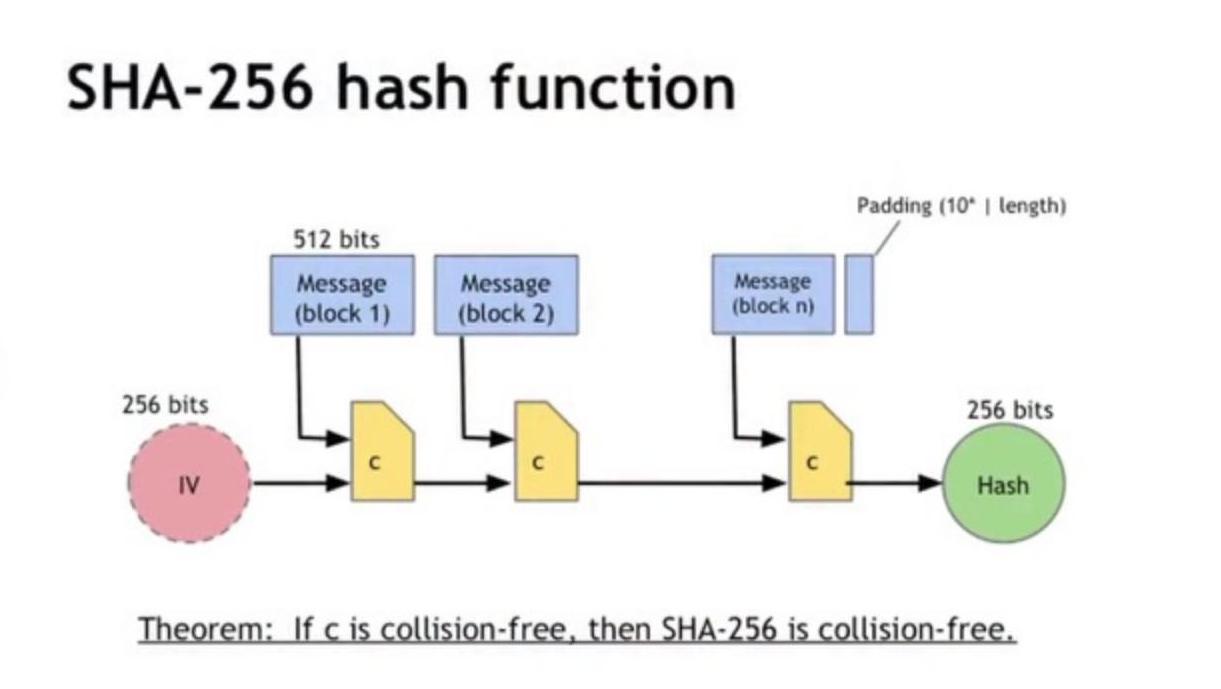

В BTC используется алгоритм SHA-256. Из-за относительной простоты SHA256 стало ясно, что вскоре появится оборудование, которое позволит значительно ускорить добычу биткоина. Уже в 2010 году BTC начали майнить на графических процессорах. Затем сеть Биткоина перешла на майнинг с помощью ASIC — оборудования, специально созданного для добычи монет.

От этой проблемы и решили защититься создатели Scrypt. Выход из ситуации нашли в том, чтобы усложнить реализацию нового оборудования с помощью увеличения количества необходимых для вычисления ресурсов.

Mining на Scrypt не сильно отличается от SHA256. В том числе потому, что скрипт использует SHA-256 как подпрограмму. Но для добычи на Scrypt необходимый больший объем оперативной памяти. Считается, что она должна производится с помощью сразу нескольких компьютеров.

Считается, что она должна производится с помощью сразу нескольких компьютеров.

Изначально монеты на Скрипт майнили с помощью процессора. Но со временем майнеры перешли на видеокарты. Сейчас для это цели применяются и ASIC-устройства — попытка избежать проблем Биткоина не увенчалась успехом.

На Scrypt-алгоритме работает целый ряд популярных криптовалют. Вот некоторые из них:

- Litecoin (LTC) — форк биткоина, который появился еще в 2011 году. Создателем стал бывший разработчик Google Чарльз Ли. Эмиссия ограничена 84 млн монет. Сейчас Litecoin входит в топ-10 криптовалют с капитализацией $4,3 млрд при курсе $74,6 за коин (на 6 августа 2021 года).

- Dogecoin (DOGE). Этот форк Litecoin обрел известность отчасти потому, что назван в честь популярного интернет-мема. Dogecoin появился в 2013 году. На 6 августа капитализация криптовалюты составляет чуть больше $323 млн, но стоимость монеты находится на уровне $0,0027. Такой курс отчасти объясняется крупной эмиссией монет — свыше 116 млрд.

- Viacoin (VIA) — криптовалюта созданная на базе bitcoin. Она появилась еще в 2014 году. Но популярность обрела только спустя четыре года. Главной ее особенностью считается высокая пропускная способность и масштабируемость. Viacoin может быть интересна из-за курса $1,03 при капитализации $23,8 млн.

Помимо этих монет алгоритм использует целый ряд малоизвестных альткоинов — Gulden, Einsteinium, Bitdeal, B3Coin и другие. У всех этих криптовалют есть общая черта — низкая капитализация. В этом списке также можно упомянуть BitConnect, которая оказалась финансовой пирамидой. Некоторые относят к этом списку еще и Verge, но она использует пять алгоритмов.

Классика: SHA-256

Начнем наш обзор, конечно же, с классического SHA-256, с которого все начиналось — именно на этом алгоритме построен биткойн-майнинг, как и майнинг подавляющего большинства биткойн-клонов (альткойнов).

Так что же это такое этот самый SHA-256? Это криптографическая хэш-функция, которая была разработана нашими «друзьями» – Агентством национальной безопасности США. Подождите, не спешите впадать в прострацию, здесь не о чем волноваться. Потерпите немного, обещаю, что скучать вы точно не будете.

Подождите, не спешите впадать в прострацию, здесь не о чем волноваться. Потерпите немного, обещаю, что скучать вы точно не будете.

Основная работа любой хэш-функции заключается в превращении (или хэшировании) произвольного набора элементов данных в значение фиксированной длины («отпечатка» или «дайджеста»). Это значение будет однозначно характеризовать набор исходных данных (служить как бы его подписью), без возможности извлечения этих исходных данных. Это официальное объяснение из Википедии, замечательное и научно-обоснованное, но вот только я, например, не говорю на таком языке. И уверен, что большинство из вас тоже. А посему позвольте мне объяснить значение этого «феномена», по-нашему, по-простому.

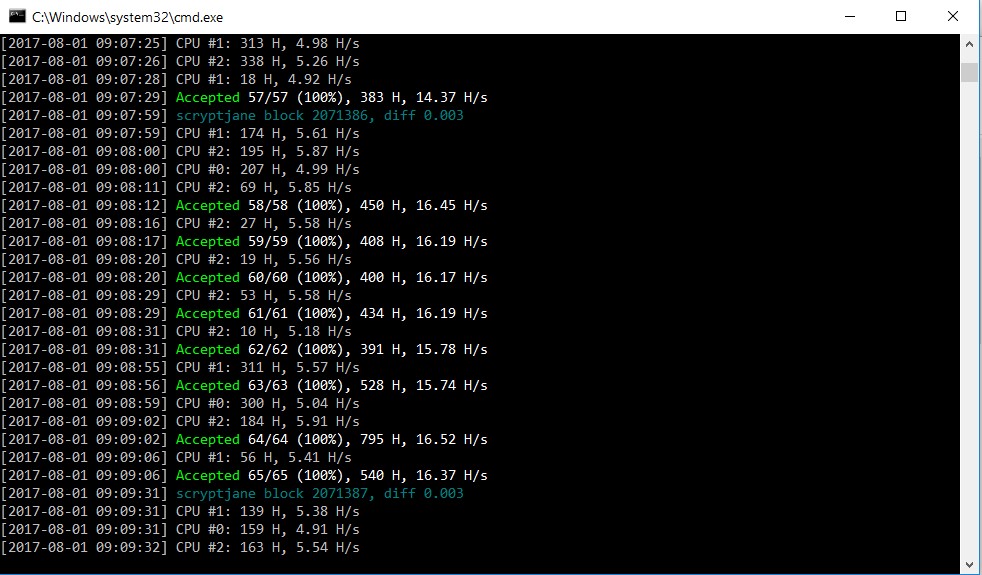

Как мы все знаем, при майнинге SHA-256 криптомонет, мы решаем поставленную задачу при помощи CPU, GPU или специализированного процессора. Процессы преобразования отображаются в интерфейсе программы, предназначенной для майнинга, например, в виде строки «Accepted 0aef41a3b». Значение 0aef41a3b — это и есть хэш. Он является как бы подписью большого набора данных (собственно, очередного блока транзакций с добавленным к нему случайным числом). Эта короткая строка как бы представляет собой блок, который состоит из нескольких тысяч, если не миллионов, подобных строк.

Это также объясняет то, почему вам нужно решить перебором множество задач, прежде чем удастся отыскать нужный хэш для нового блока. Ведь мы ищем не какой попало хэш, а тот, который начинается на определенное количество нулей. У вас имеется один шанс на тысячу, десятки, сотни тысяч, миллионы решений, что случайно получившийся хэш будет иметь нужное количество нулей в начале. Сколько именно? Определяется параметром сложности, которое задает ваш майнинг-пул. Заранее понять, получится у вас «красивый хэш» или нет, невозможно. Это похоже на игру в лотерею, но с машинами, которые могут выполнять вычисление выигрышной комбинации быстрее и лучше, чем любой из нас.

Вы считаете, что для решения задач, связанных с хэшированием при использовании протокола SHA-256, вам потребуется мощное аппаратное обеспечение? В этом есть определенный смысл. Чем больше используется вычислительной мощности, тем лучше, так как увеличиваются шансы на добычу монет. Но имейте в виду, что вы не единственный, кто занимается майнингом. Есть люди, которые располагают более производительным аппаратным обеспечением. Не расстраивайтесь, у вас есть все шансы на выигрыш. Это похоже на игру в лотерею, вы никогда не знаете, когда повезет!

Чем больше используется вычислительной мощности, тем лучше, так как увеличиваются шансы на добычу монет. Но имейте в виду, что вы не единственный, кто занимается майнингом. Есть люди, которые располагают более производительным аппаратным обеспечением. Не расстраивайтесь, у вас есть все шансы на выигрыш. Это похоже на игру в лотерею, вы никогда не знаете, когда повезет!

Теперь вернемся к алгоритму SHA-256. Криптовалюта — это не единичный пример, где используется SHA-256. Есть несколько протоколов, о которых вы, скорее всего, слышали и которые используют данный алгоритм. Это протоколы SSL, SSH, PGP и многие другие. Каждый раз, когда вы заходите на защищенный веб-сайт с помощью сертификата SSL, используется SHA-256. Бьюсь об заклад, вы не задумывались об этом, не так ли? Все мы узнаем что-то новое со временем!

Именно алгоритм SHA-256 реализован во всех выпущенных на настоящий момент специализированных ASIC-майнеров, ASIC-оборудование для других алгоритмов майнинга пока только разрабатывается. Помимо Биткойна, майнинг, основанный на SHA-256, используется в ряде других цифровых валют-клонов. Например, такие альткойны как Peercoin и Namecoin его используют. В последнее время наблюдается всплеск новых SHA-256 монет: Zetacoin, Ocoin, Tekcoin и десятки других.

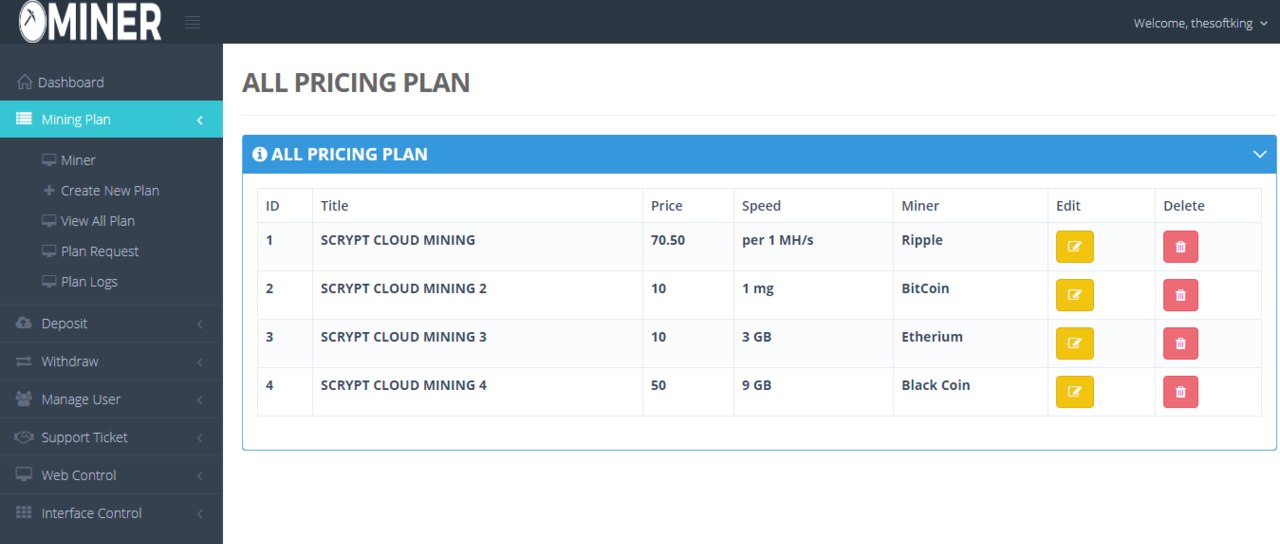

С чего начать майнинг на Scrypt

Настройка mining на Скрипт не отличается от других алгоритмов:

- Нужно выбрать подходящую криптовалюту.

- Подобрать оборудование и сделать ферму.

- Выбрать кошелек для хранения.

- Определится с пулом — в большинстве случаев соло-майнинг потерял прибыльность.

- Подобрать подходящую программу-майнер.

- Настроить софт и начать добычу.

Для примера майнинга криптовалюты на Scrypt можно взять Litecoin. У этой криптовалюты достаточно высокий курс. Майнить ее с помощью процессора можно даже не пытаться из-за роста хешрейта сети. Mining на видеокарте — также не лучшее решение. Для Скрипт существуют ASIC-устройства. Даже топовые видеокарты не могут оказать им конкуренцию.

Bitmain предлагает сразу два варианта AntMiner L3 ++ с мощностью 580 MH/s за $296 и Antminer L3+ c 504 MH/s за $216. Если есть желание майнить с помощью видеокарт, то в сети советуют модели начиная с Radeon RX 480, которая обойдется в $549. Можно поискать и другие версии GPU. После выбора видеокарт или ASIC придется собрать ферму. О том, как это делать и на что обратить внимание, можно прочитать в нашем материале.

Также майнеру понадобится криптокошелек. Здесь главное, чтобы он поддерживал нужную монету и был безопасным. Стоит воспользоваться списком рекоммендуемых бумажников на официальном сайте Litecoin — есть варианты для любой операционной системы.

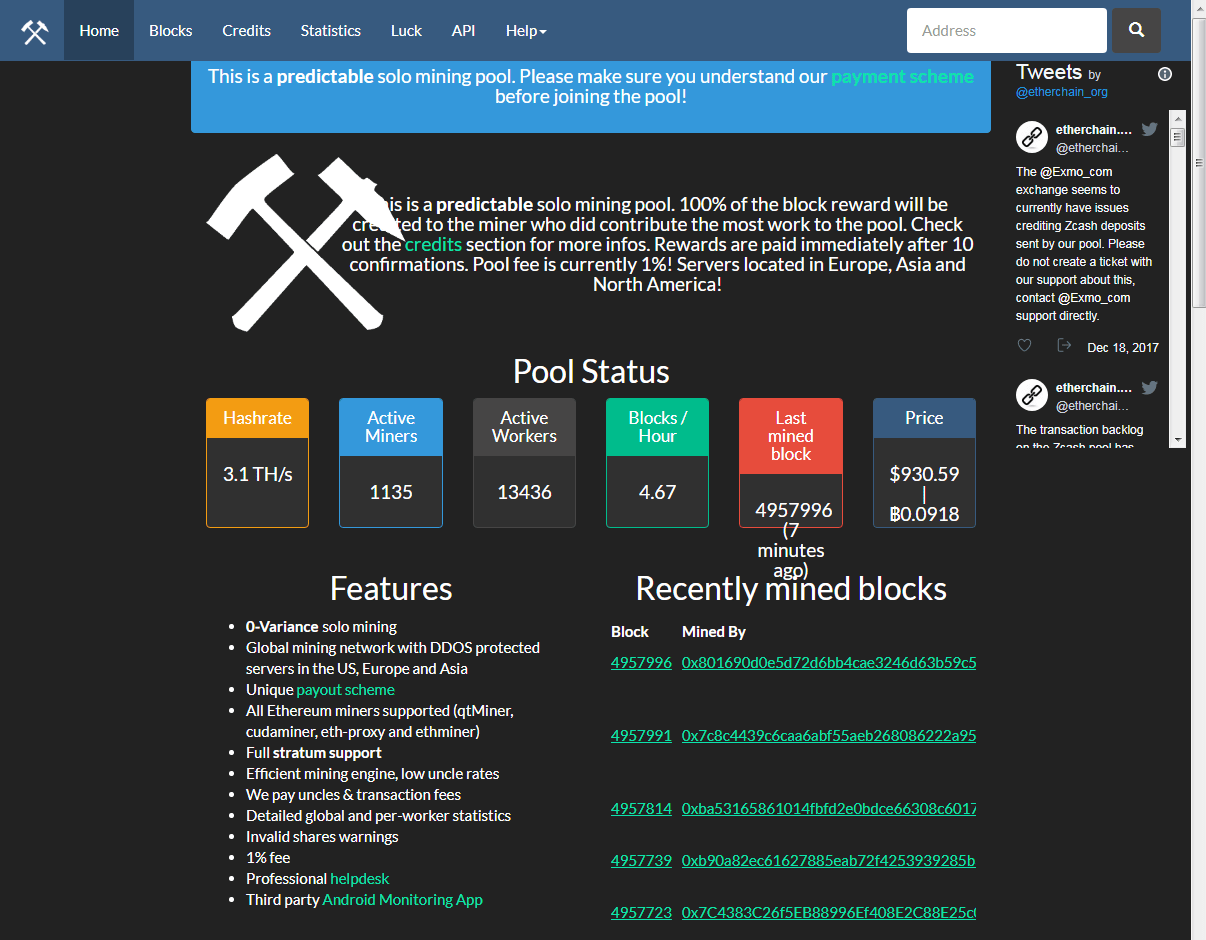

Следующий пункт — выбор пула. В них майнеры объединяют мощности, чтобы увеличить эффективность добычи. Перед тем как выбрать пул придется ознакомится с такими параметрами: хешрейт, минимальная сумма вывода, комиссия. Например, для Litecoin самыми популярными пулами считаются — Litecoinpool, F2Pool и Antpool.

Также стоит остановиться на выборе программ для майнинга. Пользователю нужен софт поддерживающий Скрипт. К числу популярных программ можно отнести CGMiner и BFGMiner. Их главный плюс в мультиплатформенности — программы работают на CPU, GPU, FPGA и ASIC. Можно выделить солидный набор функций начиная с разгона оборудования, заканчивая удаленным управлением.

У обеих программ есть недостаток — отсутствие графического интерфейса. Майнерам без опыта настраивать работу софта может быть сложно. Потому, чтобы использовать эти программы лучше поискать гайд в сети.

CGMiner и BFGMiner популярные программы, но не единственные. При желании можно найти альтернативу. Но до запуска майнинга лучше изучить отзывы о программах. Также, чтобы разобраться в особенностях работы этого ПО можно прочитать наш материал.

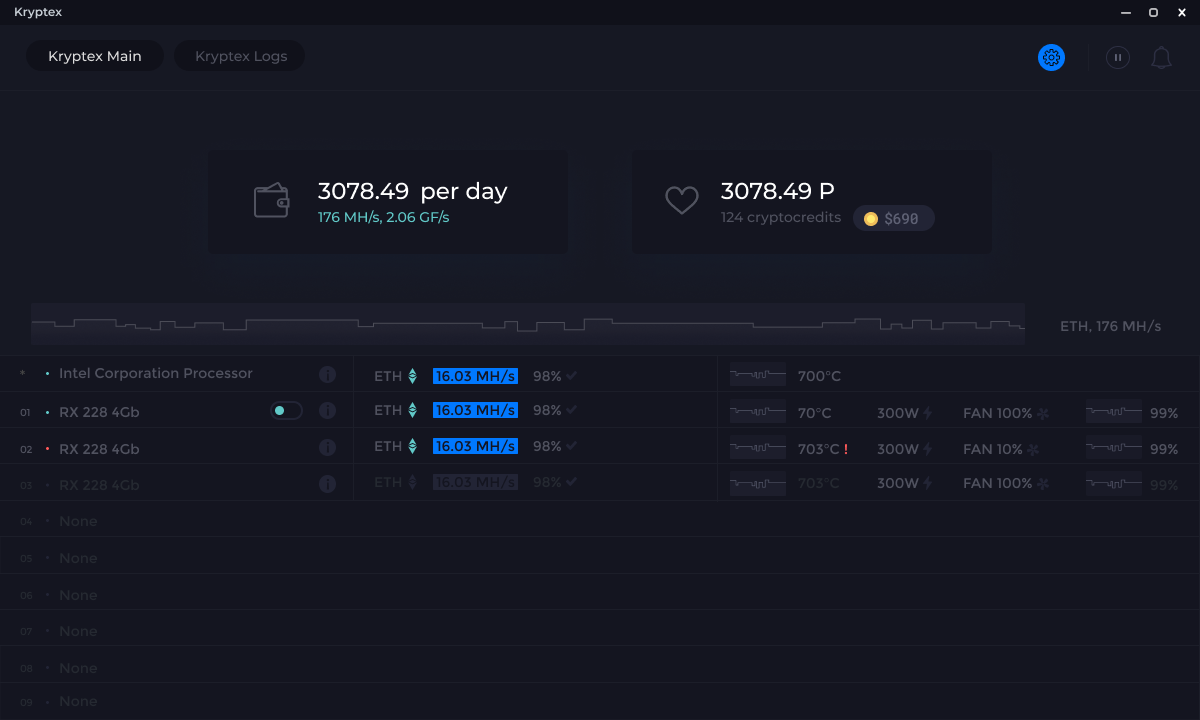

Прибыльность майнинга Scrypt на примере Litecoin

Открытым остается вопрос прибыльности добычи Скрипт-криптовалют. Хотя хейрейт их сети ниже, чем у биткоина, добывать с помощью процессора не получится. Поэтому придется выбирать между ASIC и GPU. Другой вопрос, какой коин майнить. Покупать видеокарты, а тем более ASIC, для заработка монет стоимостью меньше $0,10 — не лучшая идея. Litecoin может оказаться наиболее логичным вариантом.

Поэтому придется выбирать между ASIC и GPU. Другой вопрос, какой коин майнить. Покупать видеокарты, а тем более ASIC, для заработка монет стоимостью меньше $0,10 — не лучшая идея. Litecoin может оказаться наиболее логичным вариантом.

С помощью онлайн-калькулятора Whattomine рассчитаем примерную прибыль с майнинга. Начнем с видеокарты Radeon RX 480. Она дает хешрейт 29 Mh/s при расходе электроэнергии в 150 Вт. При соло-майнинге год работы принесет убыток в $22,50.

Расчеты для ASIC-устройстве AntMiner L3 ++ более позитивные. Хешрейт составляет 580 Mh/s при расходе электроэнергии 1600 Вт. При соло-майнинге он принесет майнеру примерно $163,71 за год.

В обоих случаях базовая стоимость электричества составляла $0,05. Также нужно учитывать, что mining в пуле — эффективнее. К тому же профессиональные майнеры не добывают криптовалюту с помощью одного ASIC-устройства или видеокарты. Стоит также учитывать волатильность криптовалюты, которая однозначно повлияет на окупаемость майнинга.

Алгоритм Scrypt-Jane

Данный алгоритм поддерживает не меньше 3-х разных схем поточного шифрования. В первую очередь это Salsa 20 / 8 – простая функция, главная задача которой заключается в приеме 192-битной строчки и преобразовании ее в Salsa 20 (х) на 64 байт. В свою очередь Salsa-20 состоит из 2-х элементов: потокового шифра и алгоритма сжатия Rumba-20. Это значит, что битовая строка может достигать максимальной длины 192 байта, после чего будет сжата до 64 байт.

Scypt-Jane поддерживает не менее трех различных систем поточного шифрования.

Scrypt-Jane поддерживает такие хэш-функции, как описанный выше SHA-256, его более продвинутая версия SHA-512, а также Blake-256/512, Kessak-256/512, Skein-512. В данном алгоритме предусмотрен свой способ масштабирования сложности хэширования и используется т.н. N-фактор – число, определяющее объем оперативной памяти, требующейся для вычисления. Значение N увеличивается систематически через заданные промежутки времени и соответственно с этим снижается эффективность майнинга.

Изначально данный алгоритм предназначался для CPU как усложненная версия Scrypt. Но доминирование и этого вида криптодобычи, как и практически всех других, продолжалось недолго.

Облачный майнинг Scrypt

Из-за растущей стоимости обычной добычи, многие переходят на клауд-майнинг. Майнеру также нужно взять в аренду мощности у одного из провайдеров. Прежде чем выбрать, придется обратить внимание на следующие факторы:

- Поддерживает ли сервис нужные монеты.

- Длительность контракта.

- Минимальный хешрейт.

- Стоимость.

- Размер комиссии за обслуживание.

- Какую минимальную сумму можно вывести.

- Отзывы о сервисе.

Настройка добычи проста:

- Выбираем криптовалюту.

- Создаем кошелек.

- Выбираем подходящий сервис.

- Заключаем контракт.

Для запуска mining не понадобится собирать ферму, настраивать программу.

Кроме сложности в определении прибыльности, одна из главных проблем клауд-майнинга — много мошенников и компаний, работающих непрозрачно. Потому, особое внимание уделите проверке сервиса перед заключением контракта.

В сети есть три крупных сервиса, поддерживающих облачный майнинг Scrypt, включая добычу Litecoin и других монет — HashFlare, Genesis Mining и Nicehash. Первые два дают возможность майнить LTC, но на август 2021 году эти контракты недоступны.

Остается только HashFlare. С его помощью можно майнить не только Litecoin, но и другие монеты вроде FedoraCoin. Поскольку HashFlare — платформа, объединяющая майнеров и арендаторов, здесь вместо контрактов используется система ордеров. Подробнее о ней можно прочитать в нашем материале.

Выводы

Mining на Scrypt особо не отличается от других видов добычи. Этот алгоритм используют целый ряд альткоинов. Из них больше всего известен Litecoin. Другие монеты не обрели особой популярности, как следствие, не могут похвастаться выскоим курсом.

Но с появлением ASIC-устройств для Scrypt даже mining LTC выглядит спорной затеей. При добыче на видеокарте у пользователя мало шансов просто вернуть вложенные средства. С помощью ASIC можно заработать, но сумма будет гораздо ниже показателей Биткоин и Эфириум.

При добыче на видеокарте у пользователя мало шансов просто вернуть вложенные средства. С помощью ASIC можно заработать, но сумма будет гораздо ниже показателей Биткоин и Эфириум.

Использовать клауд-майнинг также не лучшая идея. На HashFlare и Genesis Mining контракты на добычу Litecoin недоступны. В случае Nicehash все зависит от ордера. Конечно, можно майнить не только LTC, но и другие монеты. Вот только их курс часто не превышает $0,10, что превращает mining в дорогостоящее хобби.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Возможный заработок при добыче криптовалют на алгоритме Scrypt

Для расчета прибыли можно воспользоваться любым специализированным калькулятором (например, bitcoinwisdom.com). Нужно будет указать мощность в KH/s, а приложение само посчитает примерную доходность. Если вы не знаете производительность своего устройства, просто загляните в его техническое руководство или, при отсутствии оного, вбейте название девайса в интернете.

Курс цифровой валюты не зависит от сложности добычи, хотя обратное утверждение отчасти верно. Пользователям, которые приобретают монеты, все равно, насколько трудно их было майнить. Число же создаваемых токенов в месяц фактически вообще не зависит от сложности, и, следовательно, не рухнет в случае ее увеличения.

Обратите внимание! Чтобы следить за курсом криптовалюты в реальном времени можно воспользоваться одним из многочисленных криптовалютных сервисов. Там вы всегда найдете только актуальную информацию.

Алгоритм майнинга Эфириума (Ethereum) — описание работы Ethash

Добыча криптовалют сегодня — это, без лишних преуменьшений, настоящий «хит сезона». Биткоин буквально каждый день бьёт рекорды стоимости, а вслед за ним дорожают и остальные криптовалюты. Однако майнинг самого Биткоина уже давно недоступен для «простых смертных», с каждым днём их все больше и больше вытесняют специализированные и мощные ASIC системы. В связи с этим особую популярность у майнеров во всем мире сейчас имеет относительно молодая, но уже успевшая зарекомендовать себя на рынке криптовалюта Эфириум.

В связи с этим особую популярность у майнеров во всем мире сейчас имеет относительно молодая, но уже успевшая зарекомендовать себя на рынке криптовалюта Эфириум.

Однако чтобы сделать правильный выбор, вы должны понимать, чем именно отличается Эфир от других криптовалют и какие у него особенности. Вполне возможно, что эта валюта совсем не подойдет для майнинга вашим текущим оборудованием и вам придётся искать другие варианты. Или же если оборудования у вас пока нет, то вам тоже совсем не помешает понять, на чём сделать акцент при покупке.

В этой небольшой статье мы хотим обратить внимание на главную отличительную черту любой криптовалюты — алгоритм. Etherium алгоритм имеет несколько особенностей, о которых вы должны знать перед тем, как заняться майнингом этой криптовалюты. Кроме того, мы кратко расскажем о том, какие алгоритмы применяются в других валютах, дабы обрисовать более полную картину различий.

Какие бывают алгоритмы майнинга криптовалют?

Для обеспечения работы каждой криптовалюты используется определенный механизм шифрования — алгоритм. Именно его расшифровкой и занимается ваша домашняя майнинг-ферма. У каждой криптовалюты алгоритм шифрования может быть свой, но поскольку самих виртуальных денег значительно больше, нежели известных алгоритмов, то часто один алгоритм может применяться во множестве различных криптосистем. В результате расшифровки алгоритма пользователи находят так называемый хеш, в результате чего открываются новые блоки и расширяется блокчейн системы. После открытия каждого блока майнер получает награду в виде монет, количество же добытых монет зависит о сложности системы, и во всех криптовалютах стоимость блока зачастую оценивается по-разному.

Алгоритм добычи Эфириума сейчас довольно популярен и применяется не только для Эфира, но и для других криптовалют. Это очень выгодно, поскольку сложность майнинга внутри системы постоянно растёт и с каждым полученным блоком добывать новые становится все труднее.

Также очень популярными на сегодняшний день считаются алгоритмы SHA-256 и Scrypt, но о них немного ниже. Остальные известные алгоритмы не могут похвастаться такой всеобъемлющей любовью разработчиков криптовалют, но тем не менее занимают уверенные позиции. Среди популярных валют сегодня можно встретить алгоритмы, такие как DaggerHashimoto, Scrypt, SHA256, ScryptNf, X11, X13, Keccak, X15, Nist5, NeoScrypt, Blake256r8vnl, Hodl, Decred, CryptoNight, Skunk, Lbry, Equihash, Pascal, X11Gost, Sia, Blake2s, Lyra2RE, WhirlpoolX, Qubit, Quark, Axiom, Lyra2REv2, ScryptJaneNf16, Blake256r8, Blake256r14.

Но поскольку подобное перечисление довольно трудно для восприятия, давайте лучше составим таблицу самых популярных криптовалют и применяемых в них алгоритмов.

| Криптовалюта | Год выхода | Сокращение | Алгоритм | |

| Bitcoin | 2009 | BTC | SHA-256 | |

| Ethereum | 2015 | ETH | Dagger-Hashimoto | |

| Steemit | 2016 | STEEM | SHA-256 | |

| Ripple | 2013 | XRP | ECDSA | |

| DigiByte | 2014 | DGB | SHA256 | |

| Monero | 2014 | XMR | CryptoNight | |

| Siacoin | 2015 | SC | blake2b | |

| Litecoin | 2011 | LTC | Scrypt | |

| EthereumClassic | 2015 | ETC | Dagger-Hashimoto | |

| Dogecoin | 2013 | DOGE | Scrypt | |

| NEM | 2015 | XEM | blockchain | |

| Syscoin | 2014 | SYS | Scrypt | |

| Augur | 2015 | REP | Smart contract | |

| Dash | 2014 | DASH | X11 | |

| ByteCoin | 2012 | BCN | CryptoNight | |

| BelaCoin | 2014 | BELA | Scrypt | |

| lbryCoin | 2016 | LBC | LBRY | |

| Radium | 2015 | RADS | Smartchain | |

| Decred | 2015 | DCR | Blake256 | |

| Einsteinium | 2014 | EMC2 | Scrypt | |

| Gridcoin | 2013 | GRC | BOINC | |

| VertCoin | 2014 | VTC | Lyra2RE | |

| Dashcoin | 2014 | DSH | CryptoNight | |

| Potcoin | 2014 | POT | Scrypt | |

| Peercoin | 2012 | PPC | SHA-256 | |

| Namecoin | 2011 | NMC | SHA-256 | |

| Nautiluscoin | 2014 | NAUT | NXT | |

| Expanse | 2015 | EXP | Dagger-Hashimoto | |

| PinkCoin | 2014 | PINK | X11 | |

| FoldingCoin | 2014 | FLDC | Stanford Folding | |

| Navcoin | 2014 | NAV | X13 | |

| ViaCoin | 2014 | VIA | ||

| DNotes | 2014 | NOTE | Scrypt | |

| Vcash | 2014 | XVC | Blake256 |

SHA-256

Очень старый алгоритм, который появился еще до массового внедрения криптовалют. Он был разработан агентством национальной безопасности США и применялся для защиты веб-сайтов по сертификату безопасности SSI.

Он был разработан агентством национальной безопасности США и применялся для защиты веб-сайтов по сертификату безопасности SSI.

С 2009 года SHA 256 начал применяться как алгоритм шифрования криптовалюты Биткоин, а в скором времени — и других криптовалют, созданных по его прообразу. По сути, SHA 256 представляет собой криптографическую хеш-функцию, которая призвана превращать произвольный набор данных в значение фиксированной длины. При этом полученное значение будет выступать подписью исходных данных, но извлечь их уже никак не получится. Сама подпись в окне программы майнера будет выглядеть примерно как строка «Accepted 0aef41a3b».

Скорость работы майнера с данным алгоритмом напрямую зависит от вычислительной мощности, так как поиск нужного хеша очень вариативен и порой может достигать значений в несколько сотен тысяч к одному. Однако по сравнению с алгоритмом майнинга эфира, SHA 256 имеет очень существенный недостаток. Дело в том, что он очень сильно уязвим для специального вычислительного оборудования ASIC, данные микросхемы очень быстро находят нужное значение хеша и в конечном итоге монополизируют майнинг Биткоина, сделав сложность сети блокчейна недосягаемой для обычных майнинг-ферм.

Scrypt

На сегодняшний день вторым по популярности алгоритмом в мире является скрипт. Он применяется во многих криптовалютах, но, пожалуй, самой известной из них считается «цифровое серебро» Litecoin.

Возникновение алгоритма скрипт в первую очередь связано с тем, что разработчики прогнозировали скорое внедрение специализированных механизмов для расшифровки SHA 256. Монополизация рынка криптовалюты была недопустима, и вскоре на свет появился новый механизм шифрования. Основным отличием этих двух алгоритмом является то, что процесс нахождения нужного хеша для открытия блока сильно усложнен. В начале исполнения алгоритма генерируется большое количество псевдослучайных последовательностей, которые практически невозможно перебрать все за раз. В результате такого подхода майнинг-оборудование должно обладать существенным объёмом оперативной или видеопамяти для хранения исходных данных.

Однако в данном алгоритме все же была небольшая уязвимость, связанная с тем, что при достаточной вычислительной мощности нужный для блока хеш может быть получен случайно, без перебора всех возможных последовательностей. В связи с этим некоторые ASIC все же могли работать со скрипт, хоть и делали это в разы медленнее, чем с SHA 256. Функция хеширования алгоритма Эфириума в этом плане имеет значительное преимущество, так как исключает возможность случайного подбора значений. Однако разработчики и сами это прекрасно понимали, в результате чего в скором времени выпустили более совершенную версию алгоритма под названием Scrypt-n.

Какой алгоритм используется в Ethereum?

Настало время поговорить о том, на каком алгоритме майнится Эфириум. Алгоритм шифрования Ethereum первое время носил имя DaggerHashimoto и очень напоминал собой алгоритм скрипт. Однако сам его механизм хеширования обладал существенным отличием от предшественника, так как создавал целый граф (дерево с большим количеством ответвлений) последовательных узлов. Эта система ещё более усложняла процесс расшифровки и делала практически невозможным случайный подбор значений. В последствии в алгоритм DaggerHashimoto были внесены некоторые улучшения и проведен ребрендинг, в результате которого он был переименован в Ethash.

Теперь описание алгоритма Ethereum выглядит как хеширование метаданных последнего блока системы, для которого используется специальный код под названием Nonce. Сам Нонс представляет собой обычное двоичное число, что задает уникальное значение хеша. Теперь случайный подбор правильного значения становится ещё более проблематичным, чем в предыдущей версии алгоритма: фактически подбор хеша теперь возможен лишь методичным перебором всех возможных вариантов.

Ethash славится своей любовью к видеокартам компании AMD, особенно к архитектуре последнего поколения Polaris. Кроме того, если вы решите майнить эфир на видеокарте, то позаботьтесь о том, чтобы у нее было хотя бы четыре гигабайта видеопамяти, так как в связи с особенностями алгоритма при каждом повышение сложности системы возрастают и требования к памяти устройства. Такой подход практически исключает актуальность ASIC-майнеров и обеспечивает высокую степень децентрализации криптовалюты. Также довольно неплохие результаты в майнинге Эфира демонстрирует последняя линейка видеокарт Nvidia под кодовым названием Pascal. По сути, требования для них аналогичны, что и для карт AMD, разница заключается только в настройке.

Кроме того, если вы решите майнить эфир на видеокарте, то позаботьтесь о том, чтобы у нее было хотя бы четыре гигабайта видеопамяти, так как в связи с особенностями алгоритма при каждом повышение сложности системы возрастают и требования к памяти устройства. Такой подход практически исключает актуальность ASIC-майнеров и обеспечивает высокую степень децентрализации криптовалюты. Также довольно неплохие результаты в майнинге Эфира демонстрирует последняя линейка видеокарт Nvidia под кодовым названием Pascal. По сути, требования для них аналогичны, что и для карт AMD, разница заключается только в настройке.

Заключение

Ethash — Ethereum алгоритм — кажется очень хорошей и перспективной разработкой. На сегодняшний день не так много алгоритмов могут похвастаться настолько хорошей защитой от ASIC-майнеров и в тоже время превосходной стабильностью. Сейчас Ethash работает не только с валютой Эфириум, но также используется в перспективной разработке Expanse. С течением времени появление Ethash ожидается и в новых проектах.

Если вы подбираете оборудование для майнинга Эфира, то позаботьтесь о необходимом количестве видеопамяти видеокарт, которое сейчас составляет минимум три гигабайта и будет повышаться в будущем. Это, пожалуй, главный сейчас показатель наряду с вычислительной мощностью ваших устройств.

Загрузка…Chrome получит функцию блокировки майнинга на сайтах — новости на Tproger

Данные разговоры в консорциуме разработчиков веб-браузеров Chromium начались с середины сентября 2017 года, когда получили распространение услуги майнинга прямо с веб-страниц. Напомним, что Pirate Bay одной из первых начала использовать майнер-скрипт, предоставленный Coinhive, на своём сайте.

Блокировка JavaScript-кода

Многие пользователи стали замечать, что при посещении некоторых веб-сайтов потребление ресурсов процессора увеличивается в несколько раз. Виной всему встроенный в код сайта JS-код от Coinhive, который использует ресурсы компьютера пользователя для майнинга криптовалюты.

Виной всему встроенный в код сайта JS-код от Coinhive, который использует ресурсы компьютера пользователя для майнинга криптовалюты.

Свои идеи по предотвращению такой кражи ресурсов пользователя дал инженер Chrome, работающий над проектом Chromium, Оджан Вафай:

Если интернет-страница использует более Х% ресурсов ЦП в течение Y секунд, мы переводим её в режим «экономии заряда батареи», в котором исполняемые задачи принудительно останавливаются. После этого всплывает окошко, позволяющее пользователю отказаться от перевода страницы в такой режим и продолжить работу дальше с таким потреблением ресурсов.

В случае, если вкладка не активна, то все задачи на ней останавливаются полностью. Нам стоит ещё решить, какие именно меры для X и Y выбрать, но эксперименты стоит начать со 100 и 60 соответственно.

Я действительно считаю важным добавить подобный функционал в будущие версии браузера. Но такие разрешения будут работать только при необычных условиях запуска, а именно, когда страница делает на самом деле плохие вещи.

Внесение майнеров в чёрный список

Наличие разрешения в браузере для блокировки JS-кода, который вызывает высокопроизводительные операции ЦП в течение длительного периода времени, является шагом вперёд. Однако инженеры Google отклонили идею внесения JS-кода майнеров на уровне браузера в чёрный список, как непрактичную.

Мы не можем найти шаблоны кода, чтобы в дальнейшем использовать их для блокировки майнеров на уровне браузера. Веб-страницы могут просто изменять код для майнинга, который не будет блокироваться браузером. Блокировка загрузок подобных майнинг-скриптов возможна с использованием расширений.

На данный момент пользователи Chrome могут блокировать майнинг-скрипты в браузере через такие расширения, как AntiMiner, No Coin и minerBlock. Некоторые блокировщики рекламы и антивирусные продукты также могут блокировать майнеры.

Источник: BleepingComputer

Модели интеллектуального анализа данных (Analysis Services-Data Mining)

- 000Z» data-article-date-source=»ms.date»>05/08/2018

- Чтение занимает 10 мин

В этой статье

Применимо к: SQL Server Analysis Services Azure Analysis Services Power BI Premium

Модель интеллектуального анализа данных создается путем применения алгоритма к данным. Но это больше, чем алгоритм или контейнер метаданных: это набор данных, статистик и шаблонов, которые можно применять к новым данным для формирования прогнозов и вывода взаимосвязей.A mining model is created by applying an algorithm to data, but it is more than an algorithm or a metadata container: it is a set of data, statistics, and patterns that can be applied to new data to generate predictions and make inferences about relationships.

В этом разделе описаны модели интеллектуального анализа данных и возможные варианты их использования: базовая архитектура моделей и структур, свойства моделей интеллектуального анализа данных, способы их создания и применения.This section explains what a data mining model is and what it can be used for: the basic architecture of models and structures, the properties of mining models, and ways to create and work with mining models.

Архитектура модели интеллектуального анализа данныхMining Model Architecture

Определение моделей интеллектуального анализа данныхDefining Data Mining Models

Свойства модели интеллектуального анализа данныхMining Model Properties

Столбцы модели интеллектуального анализа данныхMining Model Columns

Обработка моделей интеллектуального анализа данныхProcessing Mining Models

Просмотр и запрос моделей интеллектуального анализа данныхViewing and Querying Mining Models

Архитектура модели интеллектуального анализа данныхMining Model Architecture

Модель интеллектуального анализа данных получает данные из структуры интеллектуального анализа данных и анализирует их, применяя алгоритм интеллектуального анализа данных. A data mining model gets data from a mining structure and then analyzes that data by using a data mining algorithm. Структура интеллектуального анализа данных и модель интеллектуального анализа данных являются отдельными объектами.The mining structure and mining model are separate objects. В структуре интеллектуального анализа данных хранятся сведения, определяющие источник данных.The mining structure stores information that defines the data source. Модель интеллектуального анализа данных содержит сведения, полученные по итогам статистической обработки данных, например закономерности, обнаруженные в результате анализа.A mining model stores information derived from statistical processing of the data, such as the patterns found as a result of analysis.

A data mining model gets data from a mining structure and then analyzes that data by using a data mining algorithm. Структура интеллектуального анализа данных и модель интеллектуального анализа данных являются отдельными объектами.The mining structure and mining model are separate objects. В структуре интеллектуального анализа данных хранятся сведения, определяющие источник данных.The mining structure stores information that defines the data source. Модель интеллектуального анализа данных содержит сведения, полученные по итогам статистической обработки данных, например закономерности, обнаруженные в результате анализа.A mining model stores information derived from statistical processing of the data, such as the patterns found as a result of analysis.

Модель интеллектуального анализа данных будет пуста до тех пор, пока не будут обработаны и проанализированы данные, переданные структурой интеллектуального анализа данных.A mining model is empty until the data provided by the mining structure has been processed and analyzed. После обработки модель интеллектуального анализа данных содержит метаданные, результаты и привязки к структуре интеллектуального анализа данных.After a mining model has been processed, it contains metadata, results, and bindings back to the mining structure.

Метаданные определяют имя модели и сервер, где она хранится, а также определение модели, включая список столбцов из структуры интеллектуального анализа данных, которые использовались для построения модели, определения всех фильтров, применявшихся при обработке модели, и алгоритм, который использовался для анализа данных.The metadata specifies the name of the model and the server where it is stored, as well as a definition of the model, including the columns from the mining structure that were used in building the model, the definitions of any filters that were applied when processing the model, and the algorithm that was used to analyze the data. Все эти варианты выбора — столбцы данных и их типы данных, фильтры и алгоритмы — обладают мощным влиянием на результаты анализа. All these choices-the data columns and their data types, filters, and algorithm-have a powerful influence on the results of analysis.

All these choices-the data columns and their data types, filters, and algorithm-have a powerful influence on the results of analysis.

Например, одни и те же данные можно использовать для создания нескольких моделей, использующих алгоритм кластеризации, алгоритм дерева принятия решений и упрощенный алгоритм Байеса.For example, you can use the same data to create multiple models, using perhaps a clustering algorithm, decision tree algorithm, and Naïve Bayes algorithm. В каждом из типов моделей создаются различные наборы шаблонов, наборов элементов, правил и формул, которые могут применяться при прогнозировании.Each model type creates different set of patterns, itemsets, rules, or formulas, which you can use for making predictions. Как правило, каждый из алгоритмов анализирует данные по-своему, поэтому содержимое получаемой модели также организуется в различные структуры.Generally each algorithm analyses the data in a different way, so the content of the resulting model is also organized in different structures. В одном из типов моделей данные и шаблоны могут группироваться в кластеры; в модели другого типа данные могут быть упорядочены с помощью деревьев, ветвей и правил, разделяющих и определяющих данные.In one type of model, the data and patterns might be grouped in clusters; in another type of model, data might be organized into trees, branches, and the rules that divide and define them.

Модель также зависит от данных, на которых проводилось ее обучение: даже те модели, обучение которых производилось на основе одной и той же структуры интеллектуального анализа данных, могут выдавать различные результаты, если во время анализа фильтрация данных выполнялась по-разному или использовались разные начальные значения.The model is also affected by the data that you train it on: even models trained on the same mining structure can yield different results if you filter the data differently or use different seeds during analysis. Однако фактические данные не хранятся в сводной статистике модели, а фактические данные находятся в структуре интеллектуального анализа данных.However, the actual data is not stored in the model-only summary statistics are stored, with the actual data residing in the mining structure. Если при обучении модели были созданы фильтры данных, то определения фильтров также сохраняются в объекте модели.If you have created filters on the data when you trained the model, the filter definitions are saved with the model object as well.

Однако фактические данные не хранятся в сводной статистике модели, а фактические данные находятся в структуре интеллектуального анализа данных.However, the actual data is not stored in the model-only summary statistics are stored, with the actual data residing in the mining structure. Если при обучении модели были созданы фильтры данных, то определения фильтров также сохраняются в объекте модели.If you have created filters on the data when you trained the model, the filter definitions are saved with the model object as well.

Модель содержит набор привязок, указывающих на кэшированные в структуре интеллектуального анализа данные.The model does contain a set of bindings, which point back to the data cached in the mining structure. Если в процессе обработки структуры данные были помещены в кэш и не были удалены из него, то эти привязки позволят выполнять детализацию от результатов к вариантам, образующим несущее множество этих результатов.If the data has been cached in the structure and has not been cleared after processing, these bindings enable you to drill through from the results to the cases that support the results. Фактические данные при этом хранятся в кэше структуры, а не в модели.However, the actual data is stored in the structure cache, not in the model.

Архитектура модели интеллектуального анализа данныхMining Model Architecture

Определение моделей интеллектуального анализа данныхDefining Data Mining Models

Чтобы создать модель интеллектуального анализа данных, выполните следующие действия.You create a data mining model by following these general steps:

Создайте базовую структуру интеллектуального анализа данных и включите в нее столбцы данных, которые могут потребоваться.Create the underlying mining structure and include the columns of data that might be needed.

Выберите алгоритм, который наилучшим образом подходит для аналитической задачи.Select the algorithm that is best suited to the analytical task.

Выберите столбцы из структуры для использования в модели и укажите, как они должны использоваться. какой столбец содержит результат, который необходимо спрогнозировать, какие столбцы предназначены только для ввода и т. д.Choose the columns from the structure to use in the model, and specify how they should be used-which column contains the outcome you want to predict, which columns are for input only, and so forth.

Задайте дополнительные параметры для тонкой настройки обработки, проводимой алгоритмом.Optionally, set parameters to fine-tune the processing by the algorithm.

Заполните модель данными, выполнив обработку структуры и модели.Populate the model with data by processing the structure and model.

Службы Analysis ServicesAnalysis Services предоставляют следующие средства, облегчающие работу с моделями интеллектуального анализа данных.provides the following tools to help you manage your mining models:

Мастер интеллектуального анализа данных помогает создать структуру и связанную с ней модель интеллектуального анализа данных.The Data Mining Wizard helps you create a structure and related mining model. Это самый простой способ.This is the easiest method to use. Мастер автоматически создает необходимую структуру интеллектуального анализа данных и помогает настроить важные параметры.The wizard automatically creates the required mining structure and helps you with the configuration of the important settings.

Определение модели можно выполнить с помощью DMX-инструкции CREATE MODEL.A DMX CREATE MODEL statement can be used to define a model. В процессе этого автоматически создается необходимая структура. Поэтому данный метод не позволяет повторно использовать существующую структуру.The required structure is automatically created as part of the process; therefore, you cannot reuse an existing structure with this method. Этот метод следует применять только в том случае, если точно известно, какую модель нужно будет создать, или если необходимо создание скриптов для моделей.

Use this method if you already know exactly which model you want to create, or if you want to script models.

Use this method if you already know exactly which model you want to create, or if you want to script models.Добавить новую модель интеллектуального анализа данных в существующую структуру можно с помощью DMX-инструкции ALTER STRUCTURE ADD MODEL.A DMX ALTER STRUCTURE ADD MODEL statement can be used to add a new mining model to an existing structure. Этот метод хорошо подходит для экспериментов с различными моделями, построенными на одном наборе данных.Use this method if you want to experiment with different models that are based on the same data set.

Модели интеллектуального анализа данных также можно создавать программным образом с помощью объектов AMO или XML для аналитики, а также клиента интеллектуального анализа данных для Excel и других клиентов.You can also create mining models programmatically, by using AMO or XML/A, or by using other clients such as the Data Mining Client for Excel. Дополнительные сведения см. в следующих разделах:For more information, see the following topics:

Архитектура модели интеллектуального анализа данныхMining Model Architecture

Свойства модели интеллектуального анализа данныхMining Model Properties

Каждая модель интеллектуального анализа данных обладает свойствами, которые определяют модель и ее метаданные.Each mining model has properties that define the model and its metadata. В число этих свойств входят имя, описание, дата последней обработки модели, разрешения на модель, а также все фильтры для данных, которые использовались для обучения.These include the name, description, the date the model was last processed, permissions on the model, and any filters on the data that is used for training.

Каждая модель интеллектуального анализа данных также содержит свойства, унаследованные от структуры интеллектуального анализа данных, которые описывают используемые в модели столбцы данных.Each mining model also has properties that are derived from the mining structure, and that describe the columns of data used by the model. Если любой из используемых моделью столбцов является вложенной таблицей, то к нему также может применяться отдельный фильтр.If any column used by the model is a nested table, the column can also have a separate filter applied.

Если любой из используемых моделью столбцов является вложенной таблицей, то к нему также может применяться отдельный фильтр.If any column used by the model is a nested table, the column can also have a separate filter applied.

Кроме того, каждая модель интеллектуального анализа данных имеет два специальных свойства: Algorithm и Usage.In addition, each mining model contains two special properties: Algorithm and Usage.

Свойство Algorithm определяет алгоритм, используемый для создания модели.Algorithm property Specifies the algorithm that is used to create the model. Набор доступных алгоритмов зависит от используемого поставщика.The algorithms that are available depend on the provider that you are using. Список алгоритмов в SQL ServerSQL Server Службы Analysis ServicesAnalysis Servicesсм. в разделе Алгоритмы интеллектуального анализа данных (службы Analysis Services — интеллектуальный анализ данных).For a list of the algorithms that are included with SQL ServerSQL Server Службы Analysis ServicesAnalysis Services, see Data Mining Algorithms (Analysis Services — Data Mining). Свойство Algorithm применяется к модели интеллектуального анализа данных и может быть задано только один раз для каждой модели.The Algorithm property applies to the mining model and can be set only one time for each model. Можно изменить алгоритм позднее, но некоторые столбцы в модели интеллектуального анализа данных могут стать недопустимыми, если они не поддерживаются выбранным алгоритмом.You can change the algorithm later but some columns in the mining model might become invalid if they are not supported by the algorithm that you choose. После изменения свойства модели всегда необходимо выполнять повторную обработку модели.You must always reprocess the model following a change to this property.

Свойство Usage определяет, какие столбцы будут использованы моделью.Usage property Defines how each column is used by the model.

Можно определить используемый столбец как Входные данные, Прогноз, Только прогноз или Ключ.You can define the column usage as Input, Predict, Predict Only, or Key. Свойство Usage применяется к отдельным столбцам модели интеллектуального анализа данных и должно задаваться отдельно для каждого столбца, включенного в модель.The Usage property applies to individual mining model columns and must be set individually for every column that is included in a model. Если структура содержит столбец, который не используется в модели, то для использования задается значение Пропустить.If the structure contains a column that you do not use in the model, the usage is set to Ignore. В качестве примера данных, которые могут включаться в структуру интеллектуального анализа данных, но не использоваться при анализе, можно привести имена клиентов или адреса электронной почты.Examples of data that you might include in the mining structure but not use in analysis might be customer names or e-mail addresses. В таком случае к ним можно будет выполнять запросы позднее, но не включать их на этапе анализа.This way you can query them later without having to include them during the analysis phase.

Можно определить используемый столбец как Входные данные, Прогноз, Только прогноз или Ключ.You can define the column usage as Input, Predict, Predict Only, or Key. Свойство Usage применяется к отдельным столбцам модели интеллектуального анализа данных и должно задаваться отдельно для каждого столбца, включенного в модель.The Usage property applies to individual mining model columns and must be set individually for every column that is included in a model. Если структура содержит столбец, который не используется в модели, то для использования задается значение Пропустить.If the structure contains a column that you do not use in the model, the usage is set to Ignore. В качестве примера данных, которые могут включаться в структуру интеллектуального анализа данных, но не использоваться при анализе, можно привести имена клиентов или адреса электронной почты.Examples of data that you might include in the mining structure but not use in analysis might be customer names or e-mail addresses. В таком случае к ним можно будет выполнять запросы позднее, но не включать их на этапе анализа.This way you can query them later without having to include them during the analysis phase.

Значения свойств модели интеллектуального анализа данных можно изменить после создания модели.You can change the value of mining model properties after you create a mining model. Однако после любого изменения, даже если оно касалось только имени модели интеллектуального анализа данных, необходимо выполнить повторную обработку модели.However, any change, even to the name of the mining model, requires that you reprocess the model. После повторной обработки модели можно получить другие результаты.After you reprocess the model, you might see different results.

Архитектура модели интеллектуального анализа данныхMining Model Architecture

Столбцы модели интеллектуального анализа данныхMining Model Columns

Модель интеллектуального анализа данных содержит столбцы данных, получаемые из определенных в структуре интеллектуального анализа данных столбцов. The mining model contains columns of data that are obtained from the columns defined in the mining structure. Можно выбрать столбцы из структуры интеллектуального анализа данных, используемые в модели, а также создать копии столбцов из структуры интеллектуального анализа данных, переименовать их или изменять способ их использования.You can choose which columns from the mining structure to use in the model, and you can create copies of the mining structure columns and then rename them or change their usage. В процессе создания модели также необходимо определить способы использования столбцов в модели.As part of the model building process, you must also define the usage of the column by the model. Например, столбец может служить ключом, использоваться для прогноза или вообще пропускаться алгоритмом.That includes such information as whether the column is a key, whether it is used for prediction, or whether it can be ignored by the algorithm.

The mining model contains columns of data that are obtained from the columns defined in the mining structure. Можно выбрать столбцы из структуры интеллектуального анализа данных, используемые в модели, а также создать копии столбцов из структуры интеллектуального анализа данных, переименовать их или изменять способ их использования.You can choose which columns from the mining structure to use in the model, and you can create copies of the mining structure columns and then rename them or change their usage. В процессе создания модели также необходимо определить способы использования столбцов в модели.As part of the model building process, you must also define the usage of the column by the model. Например, столбец может служить ключом, использоваться для прогноза или вообще пропускаться алгоритмом.That includes such information as whether the column is a key, whether it is used for prediction, or whether it can be ignored by the algorithm.

При создании модели вместо автоматического добавления всех доступных столбцов данных рекомендуется внимательно проанализировать данные в структуре и включить в модель лишь те столбцы, анализ которых имеет смысл.While you are building a model, rather than automatically adding every column of data that is available, it is recommended that you review the data in the structure carefully and include in the model only those columns that make sense for analysis. Например, не следует включать в модель несколько столбцов с идентичными данными, а также использовать столбцы, содержащие по большей части уникальные значения.For example, you should avoid including multiple columns that repeat the same data, and you should avoid using columns that have mostly unique values. Если столбец не подходит для использования, его не нужно удалять из структуры или модели интеллектуального анализа данных. Можно просто установить для столбца флаг, указывающий, что столбец должен пропускаться во время построения модели.If you think a column should not be used, you do not need to delete it from the mining structure or mining model; instead, you can just set a flag on the column that specifies that it should be ignored when building the model. Это означает, что столбец останется в структуре интеллектуального анализа, но не будет использоваться в модели интеллектуального анализа данных.This means that the column will remain in the mining structure, but will not be used in the mining model. Если детализация из модели в структуру интеллектуального анализа данных включена, то сведения из столбца можно будет извлечь позднее.If you have enabled drillthrough from the model to the mining structure, you can retrieve the information from the column later.

Это означает, что столбец останется в структуре интеллектуального анализа, но не будет использоваться в модели интеллектуального анализа данных.This means that the column will remain in the mining structure, but will not be used in the mining model. Если детализация из модели в структуру интеллектуального анализа данных включена, то сведения из столбца можно будет извлечь позднее.If you have enabled drillthrough from the model to the mining structure, you can retrieve the information from the column later.

В зависимости от выбранного алгоритма некоторые столбцы в структуре интеллектуального анализа данных могут оказаться несовместимыми с конкретными типами моделей или вызвать ухудшение качества результатов.Depending on which algorithm you choose, some columns in the mining structure might be incompatible with certain model types, or might give you poor results. Например, если данные содержат числовые данные в непрерывном интервале (например, в столбце дохода), а модели требуются дискретные значения, то может потребоваться преобразовать данные в дискретные значения или исключить их из модели.For example, if your data contains continuous numeric data, such as an Income column, and your model requires discrete values, you might need to convert the data to discrete ranges or remove it from the model. В некоторых случаях алгоритм автоматически преобразует данные или распределяет их по группам, но результаты таких операций могут оказаться непредсказуемыми или нежелательными.In some cases the algorithm will automatically convert or bin the data for you, but the results might not always be what you want or expect. Рассмотрите возможность создания дополнительных копий столбца и проверки применимости различных моделей.Consider making additional copies of the column and trying out different models. Также можно задать для отдельных столбцов флаги, указывающие, что требуется особая обработка.You can also set flags on the individual columns to indicate where special processing is required. Например, если данные содержат пустые значения (NULL), то для управления их обработкой можно воспользоваться флагом модели.For example, if your data contains nulls, you can use a modeling flag to control handling. Если определенный столбец в модели должен считаться регрессором, то этого можно добиться с помощью флага модели.If you want a particular column to be considered as a regressor in a model you can do that with a modeling flag.

Например, если данные содержат пустые значения (NULL), то для управления их обработкой можно воспользоваться флагом модели.For example, if your data contains nulls, you can use a modeling flag to control handling. Если определенный столбец в модели должен считаться регрессором, то этого можно добиться с помощью флага модели.If you want a particular column to be considered as a regressor in a model you can do that with a modeling flag.

После создания модели можно вносить изменения, например добавлять или удалять столбцы или изменять имя модели.After you have created the model, you can make changes such as adding or removing columns, or changing the name of the model. Однако после любого изменения, даже если оно касалось только метаданных модели, необходимо выполнить повторную обработку модели.However, any change, even only to the model metadata, requires that you reprocess the model.

Архитектура модели интеллектуального анализа данныхMining Model Architecture

Обработка моделей интеллектуального анализа данныхProcessing Mining Models

Модель интеллектуального анализа данных до обработки представляет собой пустой объект.A data mining model is an empty object until it is processed. Во время обработки модели данные, которые были помещены в кэш структурой, передаются через фильтр, если он был определен в модели, и подвергаются анализу в соответствии с заданным алгоритмом.When you process a model, the data that is cached by the structure is passed through a filter, if one has been defined in the model, and is analyzed by the algorithm. Алгоритм вычисляет набор сводных статистических показателей, описывающих данные, выявляет правила и закономерности в данных, а затем на основе правил и закономерностей производит заполнение модели.The algorithm computes a set of summary statistics that describes the data, identifies the rules and patterns within the data, and then uses these rules and patterns to populate the model.

После обработки модель интеллектуального анализа данных содержит ценные сведения о данных и обнаруженных при анализе закономерностях, включая статистические показатели, правила и формулы регрессии. After it has been processed, the mining model contains a wealth of information about the data and the patterns found through analysis, including statistics, rules, and regression formulas. Просмотреть эти сведения можно с помощью пользовательских средств просмотра или создав запросы интеллектуального анализа данных, которые будут извлекать эти сведения и использовать их для анализа и представления.You can use the custom viewers to browse this information, or you can create data mining queries to retrieve this information and use it for analysis and presentation.

After it has been processed, the mining model contains a wealth of information about the data and the patterns found through analysis, including statistics, rules, and regression formulas. Просмотреть эти сведения можно с помощью пользовательских средств просмотра или создав запросы интеллектуального анализа данных, которые будут извлекать эти сведения и использовать их для анализа и представления.You can use the custom viewers to browse this information, or you can create data mining queries to retrieve this information and use it for analysis and presentation.

Архитектура модели интеллектуального анализа данныхMining Model Architecture

Просмотр и запросы моделей интеллектуального анализа данныхViewing and Querying Mining Models

После обработки модели ее можно просмотреть с помощью пользовательских средств просмотра, входящих в состав среды SQL Server Data ToolsSQL Server Data Tools и SQL Server Management StudioSQL Server Management Studio.After you have processed a model, you can explore it by using the custom viewers that are provided in SQL Server Data ToolsSQL Server Data Tools and SQL Server Management StudioSQL Server Management Studio. ДляFor

Запросы к модели интеллектуального анализа данных позволяют создавать прогнозы и получать метаданные модели или закономерности, созданные моделью.You can also create queries against the mining model either to make predictions, or to retrieve model metadata or the patterns created by the model. Для создания запросов используется язык DMX.You create queries by using Data Mining Extensions (DMX).

См. такжеRelated Content

По следующим ссылкам можно получить более конкретную информацию о работе с моделями интеллектуального анализа данных.Use the following links to get more specific information about working with data mining models

См. также:See Also

Объекты баз данных (службы Analysis Services — многомерные данные)Database Objects (Analysis Services — Multidimensional Data)

Анализ локальных выбросов (Углубленный анализ пространственно-временных закономерностей)—ArcGIS Pro

Этот инструмент поддерживает только файлы netCDF, созданные инструментами Создать куб Пространство-Время по агрегации точек, Создать куб Пространство-Время из указанных местоположений и Создать куб Пространство-Время из многомерного растрового слоя.

Каждый бин в кубе пространства-времени содержит значение LOCATION_ID, time_step_ID, COUNT и любое из Полей суммирования или Переменных, агрегированных при создании куба. Набор бинов, связанный с одним и тем же местоположением, имеет одинаковый идентификатор местоположения и представляет собой временной ряд. Набор бинов, связанный с одним и тем же временным интервалом, имеет одинаковый идентификатор шага времени и представляет собой временной срез. Значение в каждом бине представляет число инцидентов или записей, которые присутствуют в определенном местоположении и определенном временном интервале.

Данный инструмент анализирует переменную во Входном кубе пространства-времени netCDF, используя пространственно-временную реализацию статистики Anselin Локальный индекс Морана I.

Выходные объекты добавляются на панель Таблице содержания и представляют обобщенный результат анализа пространства-времени для всех проанализированных местоположений. Если вы укажете Полигональную маску анализа, будут проанализированы только те местоположения, которые попадают в пределы маски анализа; в ином случае будут проанализированы местоположения, которые имеют как минимум одну точку в как минимум одном временном интервале.

Кроме создания Выходных объектов, отчет об анализе записывается в виде сообщений, которые появляются в нижней части панели Геообработка во время выполнения этого инструмента. Вы можете получить доступ к сообщениям, переместив курсор мыши на индикатор выполнения, щелкнув на всплывающую кнопку или развернув раздел сообщений на панели Геообработка. Вы можете также получить доступ к сообщениям предыдущего запуска инструмента с помощью Истории геообработки на панели Каталог.

Инструмент Анализ локальных выбросов идентифицирует статистически значимые кластеры и выбросы в контексте пространства и времени. См. раздел Более подробно о работе инструмента Анализ локальных выбросов, чтобы получить дополнительные сведения об определениях выходных категорий по умолчанию и об алгоритмах, использующихся в этом инструменте анализа.

См. раздел Более подробно о работе инструмента Анализ локальных выбросов, чтобы получить дополнительные сведения об определениях выходных категорий по умолчанию и об алгоритмах, использующихся в этом инструменте анализа.

Для идентификации кластеров и выбросов в кубе пространства-времени, инструмент использует пространственно-временную интерпретацию статистики Anselin Локальный индекс Морана I, при этом значение каждого бина сопоставляется со значениями в соседних бинах.

Чтобы идентифицировать бины, которые будут включены в каждую окрестность анализа, инструмент сначала выявляет бины, которые попадают в заданное Определение пространственных взаимоотношений. Затем для каждого бина определяются бины, расположенные в том же местоположении, но в пределах N предшествующих временных шагов, где N – Временной шаг окрестности, указанный во входных параметрах.

Выбор параметра Определение пространственных взаимоотношений должен отражать внутренние отношения между пространственными объектами, которые вы анализируете. Чем более точно вы сможете смоделировать взаимодействие пространственных объектов в пространстве, тем более точные результаты вы получите. Рекомендации см. в разделе Выбор определения пространственных взаимоотношений: рекомендации.

По умолчанию для параметра Определение пространственных взаимоотношений устанавливается Фиксированное расстояние. Бин считается соседним, если его центроид попадает в указанные вами пределы Расстояния окрестности, а его временной интервал попадает в пределы Временного шага окрестности. Если вы не указываете Расстояние окрестности, оно будет рассчитано по умолчанию на основании пространственного распределения ваших данных. Если вы не указываете Интервал временного шага, то инструмент будет использовать значение по умолчанию, которое составляет 1 интервал временного шага.

Параметр Число соседей может замещать Расстояние соседства для опции Фиксированное расстояние либо расширять поиск соседей для опций Только соседние ребра и Углы соседних ребер. В этих случаях Число соседей используется, как минимальное значение. Например, если вы зададите Фиксированное расстояние с опцией Расстояние соседства равным 10, и значение 3 для параметра Количество соседей, то у каждого из бинов будет минимум по 3 пространственных соседа, даже если для того, чтобы найти их, пришлось бы увеличить Расстояние соседства. Расстояние увеличивается только в тех случаях, где минимальное Количество соседей не найдено. Точно так же с опциями смежности: для бинов с меньшим этого числа смежных соседей будут выбраны дополнительные соседи на основе близости центроидов.

Значение Временного шага окрестности – это количество интервалов временных шагов, включенных в окрестность анализа. Если интервал временного шага в вашем кубе составляет 3 месяца, и вы указали значение 2 для параметра Временной шаг окрестности – все бины, расположенные в пределах Определения пространственных взаимоотношений и все связанные с ними бины в двух предшествующих интервалах временных шагов (в совокупности 9 месяцев) будут включены в окрестность анализа.

Перестановки используются для определения вероятности нахождения актуального пространственного распределения анализируемых значений. Для каждой перестановки, значения, окружающие каждый бин, перераспределяются в случайном порядке, затем вычисляется значение локального индекса Морана I. Результат референсного распределения значений затем сравнивается с наблюдаемым индексом Морана I для определения вероятного нахождения наблюдаемого значения в случайном распределении. По умолчанию используется 499 перестановок; однако распределение случайной выборки улучшается при увеличении числа перестановок, что повышает точность псевдо p-значений.

Если параметр Число перестановок имеет значение 0, в результате получается обычное p-значение, вместо псевдо p-значения.

Перестановки, используемые этим инструментом, могут пользоваться преимуществом увеличения производительности, доступным в системе, использующей несколько CPU (или многоядерные CPU). Инструмент по умолчанию будет использовать 50% доступных процессоров, но количество используемых процессоров может быть увеличено или уменьшено с помощью настройки среды Коэффициент параллельной обработки. Увеличение скорости обработки особенно заметно в больших кубах пространство-время или при запуске инструмента с большим количеством перестановок.

Слой Полигональной маски анализа может содержать один или несколько полигонов, определяющих область анализа. Эти полигоны определяют область, в которой могут встретиться анализируемые точки, и исключают области, в которых точки для анализа не встречаются. Например, если вы анализируете ограбления в жилых кварталах, вы можете использовать Полигональную маску анализа чтобы исключить крупные водоемы, парки и другие области, где нет жилых домов.

Полигон маски для анализа пересекается с экстентом Входного куба Пространство-Время, но не выходит за пределы куба.

Если Полигональная маска анализа, которую вы используете для задания области изучения, покрывает область, выходящую за границы экстента входных объектов, которые были использованы для первоначального создания куба, может потребоваться заново создать куб, используя эту Полигональную маску анализа как параметр среды Экстент. Это позволит гарантировать, что вся область, покрываемая Полигональной маской анализа, будет включена в инструмент Анализ локальных выбросов. Используя Полигональную маску анализа в качестве параметра среды Экстент во время создания куба можно гарантировать, что куб будет соответствовать экстенту Полигональной маски анализа.

- Number of Outliers

- Percentage of Outliers

- Number of Low Clusters

- Percentage of Low Clusters

- Number of Low Outliers

- Percentage of Low Outliers

- Number of High Clusters

- Percentage of High Clusters

- Number of High Outliers

- Percentage of High Outliers

- Местоположения с No Spatial Neighbors

- Местоположения с Outlier in the Most Recent Time Step

- Cluster Outlier Type

- и дополнительная суммарная статистика

Cluster Outlier Type будет всегда обозначать статистически значимые кластеры и выбросы для 95-процентного доверительного интервала, а значения в этом поле будут приведены только для статистически значимых бинов. Эта значимость отражает Коррекцию FDR.

Чтобы обеспечить наличие по крайней мере 1 временного соседства для каждого местоположения, Локальный индекс Морана не вычисляется для первого временного среза. Значения бинов в первом временном срезе, тем не менее, включаются в вычисление глобального среднего.

Запуск инструмента Анализ локальных выбросов позволяет добавить результаты обратно в файл netCDF, представляющий Входной куб Пространство-Время. Каждый бин анализируется совместно с бинами в ближайшей окрестности для измерения кластеризации как высокого, так и низкого значений, и для определения пространственных и временных выбросов в этих кластерах. В результате этого анализа получается локальный индекс Морана I, псевдо p-значение (или p-значение, если не используются перестановки), и кластер или тип выброса (CO_TYPE) для каждого бина в кубе Пространство-Время.

Сводные расчеты по переменным, которые добавляются ко Входному кубу Пространство-Время , перечислены ниже:

| Имя переменной | Описание | Измерение |

|---|---|---|

OUTLIER_{ANALYSIS_VARIABLE}_INDEX | Вычисленный локальный индекс I Морана. | Три измерения: одно значение локального индекса I Морана для каждого бина в кубе пространство-время. |

OUTLIER_{ANALYSIS_VARIABLE}_PVALUE | Статистика Anselin Локальный индекс I Морана псевдо p-значение или p-значение, измеряющее статистическую значимость значения локального индекса Морана I. | Три измерения: одно p-значение или псевдо p-значение для каждого бина в кубе пространство-время. |

OUTLIER_{ANALYSIS_VARIABLE}_TYPE | Полученный тип категории, позволяющий различить статистически значимый кластер высоких значений (HH), кластер низких значений (LL), выброс, в котором высокое значение окружено в основном низкими значениями (HL) и выброс, в котором низкое значение окружено в основном высокими значениями (LH). | Три измерения: один кластер или тип выброса для каждого бина в кубе пространство-время. Бины классифицируются с применением коррекции FDR. |

OUTLIER_{ANALYSIS_VARIABLE} _HAS_SPATIAL_NEIGHBORS | Обозначает местоположения, не имеющие пространственных соседей, а также те, которые основываются только на временных соседях. | Два измерения: одна классификация для каждого местоположения. Анализ местоположений, не имеющих пространственных соседей, проводит к вычислениям, основанных только на временных соседях. |

«Классификация, регрессия и другие алгоритмы Data Mining с использованием R»

Друзья!

Владимир Кириллович и я рады представить вашему вниманию новый результат нашей совместной работы — книгу «Классификация, регрессия и другие алгоритмы Data Mining с использованием R».

В книге рассмотрена широкая совокупность методов построения статистических моделей классификации и регрессии для откликов, измеренных в альтернативной, категориальной и метрической шкалах. Подробно рассматриваются деревья решений, машины опорных векторов с различными разделяющими поверхностями, нелинейные формы дискриминантного анализа, искусственные нейронные сети и т.д. Показана технология применения таких методов бутстреп-агрегирования деревьев решений, как бэггинг, случайный лес и бустинг. Представлены различные методы построения ансамблей моделей для коллективного прогнозирования. Особое внимание уделяется сравнительной оценке эффективности и поиску оптимальных областей значений гиперпараметров моделей с использованием пакета caret. Рассматриваются такие алгоритмы Data Mining, как генерация ассоциативных правил и анализ последовательностей. Отдельная глава посвящена методам многомерной ординации данных и различным алгоритмам кластерного анализа.

Отдельная глава посвящена методам многомерной ординации данных и различным алгоритмам кластерного анализа.

Описание указанных методов сопровождается многочисленными примерами из различных областей на основе общедоступных исходных данных. Представлены несложные скрипты на языке R, дающие возможность читателю легко воспроизвести все расчеты.

Книга может быть использована в качестве учебного пособия по статистическим методам для студентов и аспирантов высших учебных заведений.

Книга распространяется совершенно бесплатно. Ее PDF-версию и соответствующие приложения можно скачать по следующим двум официальным адресам:

Кроме того, книга опубликована в виде отдельного сайта по адресу:

Мы будем благодарны за любые ваши замечания и пожелания касательно этой работы — отправляйте их, пожалуйста, по электронной почте stok1946[«собака»]gmail.com и/или rtutorialsbook[«собака»]gmail.com

Сергей Мастицкий, Владимир Шитиков

P.S.: Как отмечено выше, книга распространяется бесплатно. Однако если она окажется вам полезной и вы сочтете уместным отблагодарить авторов за их работу, вы можете перечислить любую сумму, воспользовавшись следующей кнопкой (все транзакции выполняются в безопасном режиме через систему электронных платежей PayPal; наличие у вас аккаунта в этой системе необязательно):

Создайте собственный алгоритм майнинга блокчейна в Go! | by Coral Health

Учитывая недавнее повальное увлечение майнингом Биткойн и Эфириум, легко задаться вопросом, о чем идет речь. Новички в этой сфере слышат дикие истории о людях, которые заполняют склады графическими процессорами, зарабатывая криптовалюты на миллионы долларов в месяц. Что такое майнинг криптовалюты? Как это работает? Как я могу попробовать написать собственный алгоритм майнинга?

В этом посте мы рассмотрим каждый из этих вопросов, а завершим вас уроком о том, как написать собственный алгоритм майнинга.Алгоритм, который мы вам покажем, называется Proof of Work , который является основой для Биткойн и Эфириум, двух самых популярных криптовалют. Не волнуйтесь, мы вскоре объясним, как это работает.

Не волнуйтесь, мы вскоре объясним, как это работает.

Что такое майнинг криптовалюты?

Криптовалюты должны иметь дефицит, чтобы быть ценными. Если бы кто-нибудь мог производить столько биткойнов, сколько он хотел в любое время, биткойн был бы бесполезен как валюта (подождите, разве Федеральный резерв не делает этого? * Facepalm *).Алгоритм Биткойн выдает некоторое количество Биткойнов победившему члену своей сети каждые 10 минут, при этом максимальная поставка будет достигнута примерно через 122 года. Этот график выпуска также в определенной степени контролирует инфляцию, так как весь фиксированный запас не выпускается в начале. Со временем медленно выпускаются новые.

Процесс, посредством которого определяется победитель и выдается биткойн, требует, чтобы победитель выполнил некоторую «работу» и соревновался с другими, которые также выполняли эту работу. Этот процесс называется , добыча , потому что он аналогичен золотодобытчику, который тратит некоторое время на работу и в конечном итоге (и мы надеемся) находит немного золота.

Алгоритм Биткойн заставляет участников или узлы выполнять эту работу и соревноваться друг с другом, чтобы гарантировать, что Биткойн не будет выпущен слишком быстро.

Как работает майнинг?

Быстрый поиск в Google «как работает майнинг биткойнов?» заполняет ваши результаты множеством страниц, объясняющих, что майнинг биткойнов запрашивает у узла (вас или вашего компьютера) номер для решения сложной математической задачи . Хотя технически это верно, просто назвать это «математической» задачей невероятно банально и банально.Очень интересно понять, как майнинг работает под капотом. Нам нужно немного разобраться в криптографии и хешировании, чтобы узнать, как работает майнинг.

Краткое введение в криптографические хэши

Односторонняя криптография принимает читаемый человеком ввод, такой как «Hello world», и применяет к нему функцию (то есть математическую задачу) для получения не поддающегося расшифровке вывода. Эти функции (или алгоритмы) различаются по характеру и сложности. Чем сложнее алгоритм, тем сложнее его реконструировать.Таким образом, криптографические алгоритмы очень эффективны для защиты таких вещей, как пароли пользователей и военные коды.

Эти функции (или алгоритмы) различаются по характеру и сложности. Чем сложнее алгоритм, тем сложнее его реконструировать.Таким образом, криптографические алгоритмы очень эффективны для защиты таких вещей, как пароли пользователей и военные коды.

Давайте посмотрим на пример SHA-256, популярного криптографического алгоритма. Этот веб-сайт хеширования позволяет легко вычислять хеши SHA-256. Давайте хэшируем «Hello world» и посмотрим, что мы получим:

Попробуйте хешировать «Hello world» снова и снова. Каждый раз вы получаете один и тот же хэш. В программировании получение одного и того же результата снова и снова при одном и том же вводе называется идемпотентностью .

Фундаментальным свойством криптографических алгоритмов является то, что их чрезвычайно сложно реконструировать, чтобы найти входные данные, но чрезвычайно легко проверить выходные данные. Например, используя хэш SHA-256 выше, для кого-то должно быть тривиальным применение хеш-алгоритма SHA-256 к «Hello world», чтобы проверить, действительно ли он дает такой же результирующий хеш, но это должно быть очень сложно чтобы взять полученный хеш и получить из него «Hello world». Вот почему этот тип криптографии называется односторонним .

Биткойн использует Double SHA-256 , который просто применяет SHA-256 снова к хешу SHA-256 «Hello world». Для наших примеров в этом руководстве мы будем использовать только SHA-256.

Майнинг

Теперь, когда мы понимаем, что такое криптография, мы можем вернуться к майнингу криптовалюты. Биткойну нужно найти способ заставить участников, которые хотят зарабатывать биткойны, «работать», чтобы биткойны не выпускались слишком быстро. Биткойн достигает этого, заставляя участников хешировать множество комбинаций букв и цифр до тех пор, пока результирующий хеш не будет содержать определенное количество ведущих «0».

Например, вернитесь на хеш-сайт и введите хэш «886». Он создает хеш с 3 нулями в качестве префикса.

Он создает хеш с 3 нулями в качестве префикса.

Но как мы узнали, что «886» дает что-то с тремя нулями? В этом-то и дело. До написания этого блога у нас не было . Теоретически нам пришлось бы проработать целую кучу комбинаций букв и цифр и протестировать результаты, пока мы не получим ту, которая соответствует требованию трех нулей. Чтобы дать вам простой пример, мы уже работали заранее, чтобы понять, что хеш «886» дает 3 ведущих нуля.