Что такое CPU, GPU и APU – понимание различий

Большинство аппаратных средств на вашем ПК связано с аббревиатурой, и – по мере развития технологий – увеличивается количество этих имён, что ведёт к путанице. Ради того, чтобы сохранить всё в порядке и помочь вам получить необходимое оборудование, давайте посмотрим на различия между терминами CPU, GPU и APU.

Что такое центральный процессор (CPU)

Процессор можно считать мозгом вашего ПК. Он обрабатывает все задачи и расчеты, выполняемые другим оборудованием, что делает его важным звеном производительности вашего устройства. Большинство современных процессоров ПК используют несколько ядер для обработки нескольких задач одновременно, а общая производительность измеряется в гигагерцах (ГГц). Например, если процессор имеет базовую тактовую частоту 2,4 ГГц, он способен обрабатывать до 2,4 миллиарда инструкций в секунду.

Когда дело доходит до производителей процессоров, вы, вероятно, услышите об Intel и Advanced Micro Devices (AMD).

Производительность варьируется довольно широко во всех процессорах от обоих производителей, предлагая множество вариантов, если говорить о цене и энергопотреблении. Вы можете найти низкоэффективный процессор, который отлично подходит для обработки текстов, просмотра веб-страниц и автономной работы, вы также можете найти высокопроизводительный процессор, который будет абсолютно «кромсать» всё, что вы подбросите ему, но также будет высасывать энергию, как пылесос.

Что такое графический процессор (GPU)

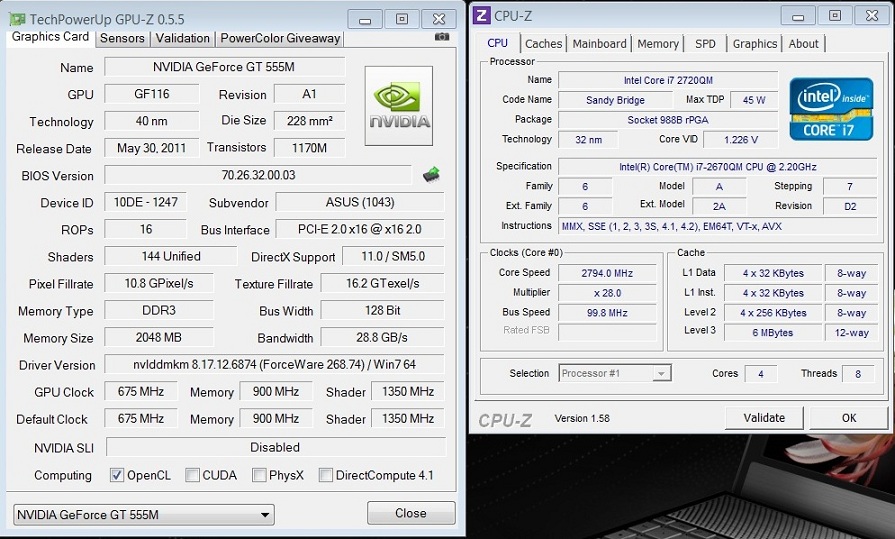

Интегрированные графические процессоры совместно используют пространство с чипсетом процессора, в то время как выделенные графические процессоры представляют собой отдельную аппаратную часть, подключенную к отдельной шине на материнской плате.

Графический процессор предназначен для высокопроизводительных рабочих местах, которые требуют много энергии. Интенсивные игры, VR и редактирование видео – всё это задачи, связанные с графическими процессорами. В то время как центральный процессор является капитаном «команды вашего ПК», GPU можно считать главным помощником, готовым решать самые напряженные задачи.

Что такое ускоренный процессор (APU)

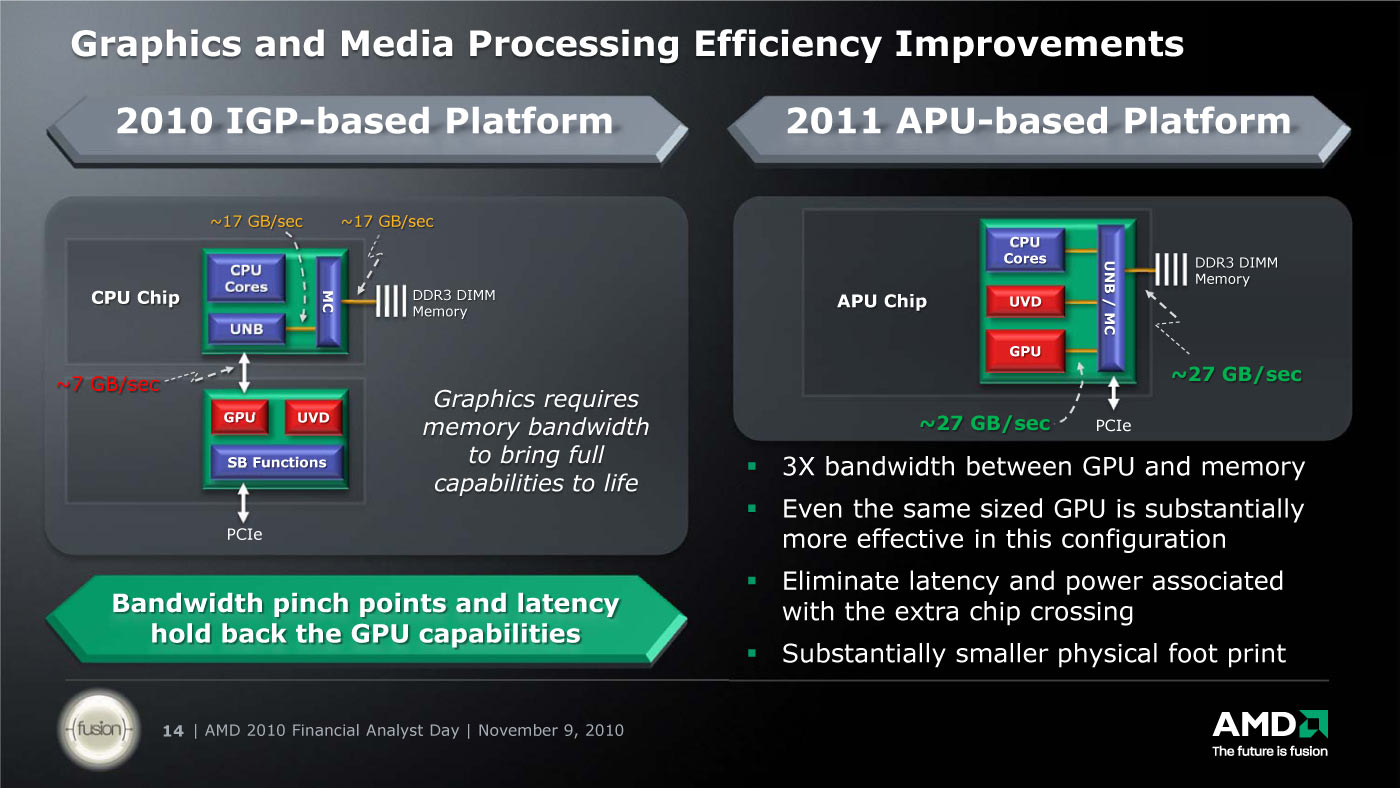

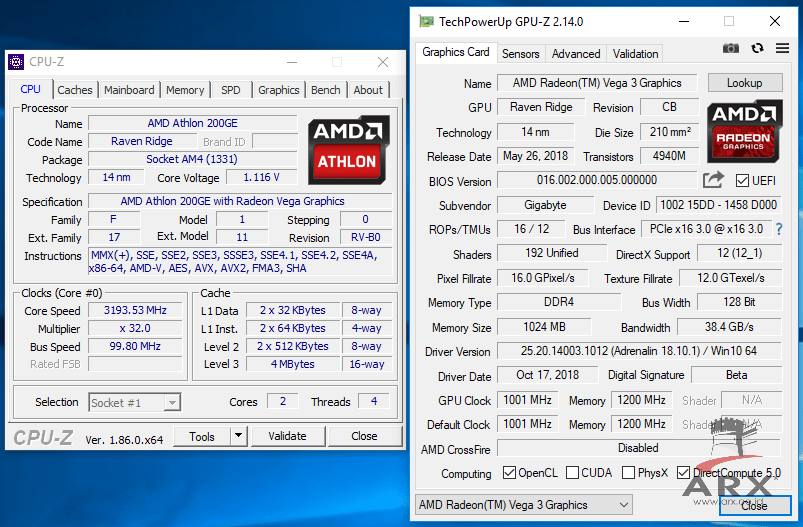

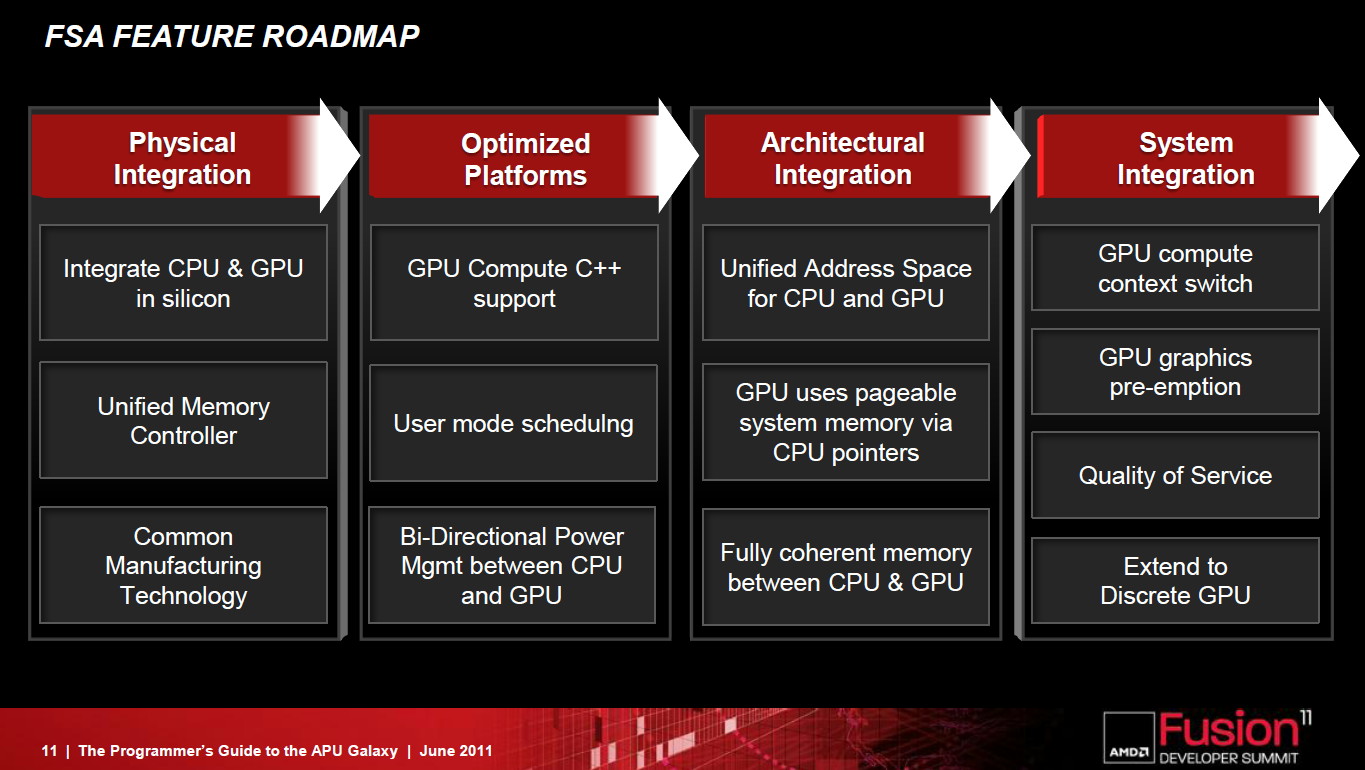

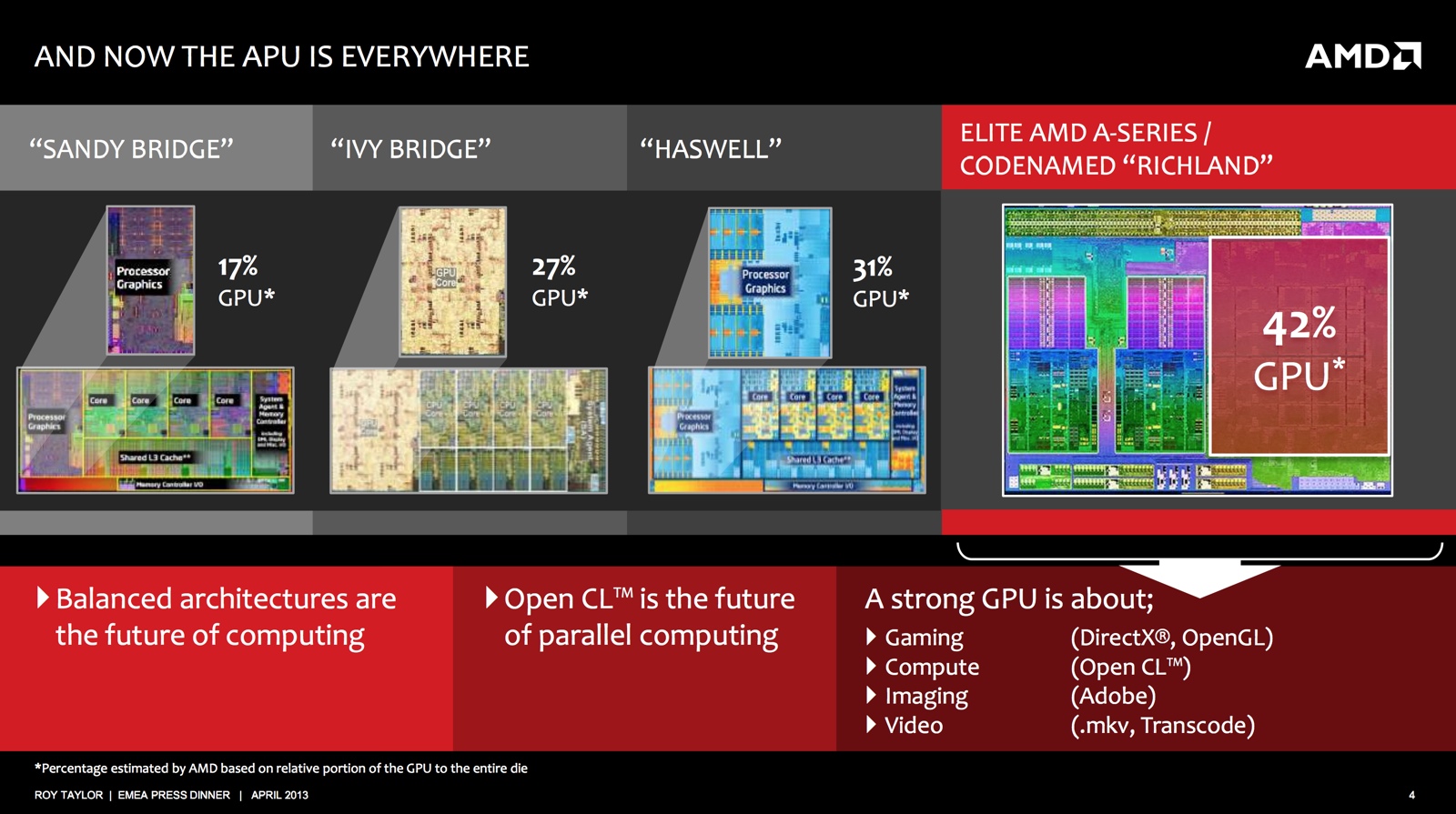

APU – это термин, который AMD придумала для обозначения GPU, интегрированного в архитектуру процессора. И графические процессорные ядра, и стандартные процессорные ядра совместно используют один и тот же кэш и матрицу, и данные передаются по одной и той же шине.

Зачем создавать APU? Наличие как CPU, так и GPU в одном месте позволяет им работать более эффективно для увеличения вычислительной мощности. Аналогично, наличие интегрированных GPU и CPU обычно более энергоэффективно, чем наличие CPU и отдельного выделенного GPU.

Первый APU, использующий кодовое имя Llano, был анонсирован AMD ещё в 2011 году, но проект работает с 2006 года. Если вам интересно, где всё это время был Intel, большинство их процессоров также используют интегрированную графику. Например, Intel Core-i7-8700K, обычно в паре с мощным выделенным графическим процессором, имеет встроенную графику Intel UHD 630. Однако термин APU не используется Intel, вероятно, из-за ассоциации с конкурирующим продуктом AMD.

Слияние CPU и GPU: зачем это нужно и чем может обернуться для PC

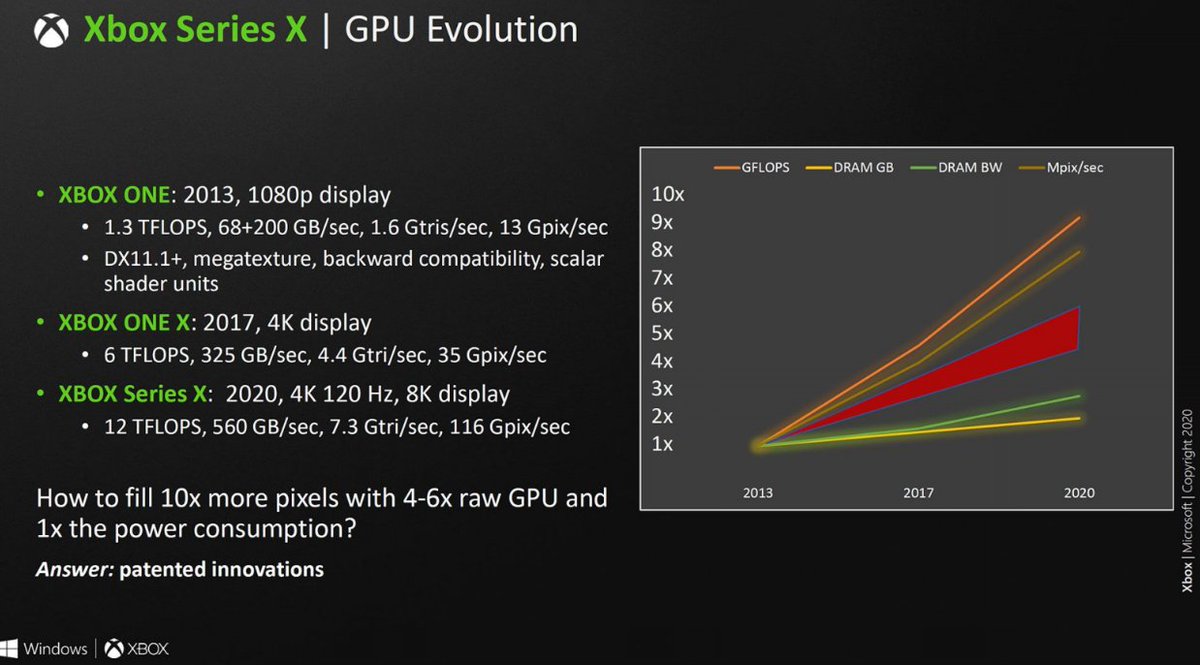

За четыре десятилетия эволюции персональных компьютеров мы привыкли к тому, что в компьютере стоят минимум два процессора. На центральном лежит исполнение всех рутинных обязанностей, а вспомогательный графический отвечает за изображение. Строго говоря, долгое время сердце видеочипов процессором не считалось, но увеличение мощности, расширение функций и возможность прямого программирования привели к рождению в конце 90-х термина GPU (согласно легенде, первой его употребила Nvidia для линейки GeForce).

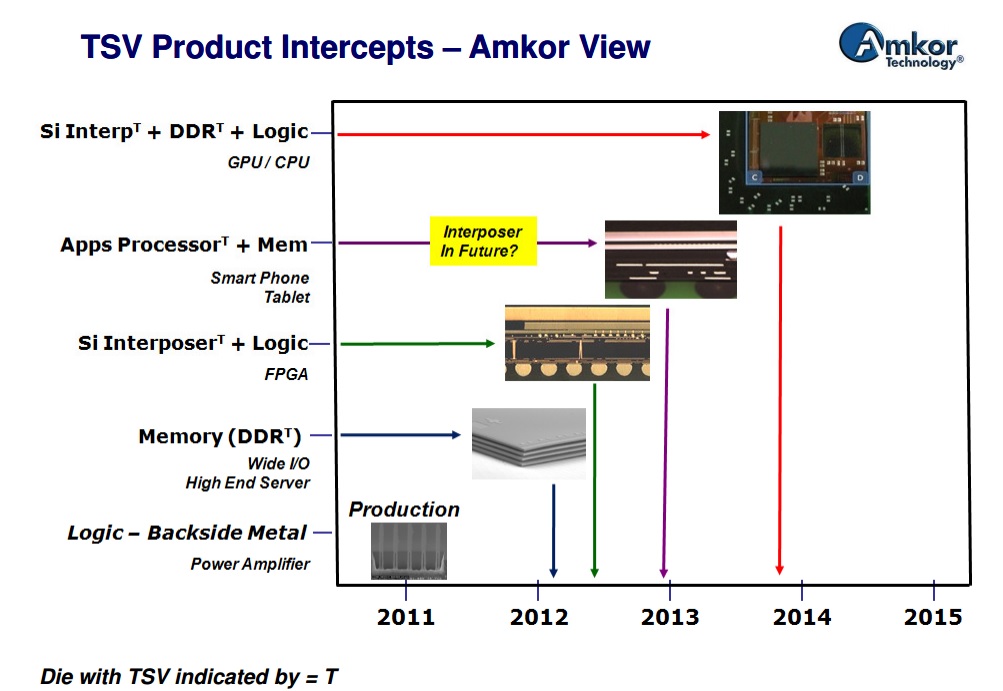

Перестановка слагаемых головокружительна, но изюминка текущего момента в том, что разделение процессорных единиц может исчезнуть вообще. Согласно свежему отчёту о состоянии компьютерного рынка (IHS ISuppli), уже в текущем году половина поставленных ноутбуков и почти половина десктопов будут оснащены универсальными микропроцессорами, совмещающими на одном кристалле центральный и графический вычислительные компоненты. В 2010-м, благодаря Intel Atom, доля таких систем колебалась около одной трети, а к 2014 году восемь из десяти новых ноутбуков и примерно столько же настольных систем будут оснащены новыми типами процессорных единиц.

Устоявшегося термина, обозначающего универсальный микропроцессор, пока нет. Одни, вслед за AMD, именуют такие чипы APU (Accelerated Processing Unit — ускоренное вычислительное устройство). Кто-то предпочитает gCPU (g — от «graphics»). Чаще других звучит аббревиатура GEM (Graphics Enabled Microprocessor — микропроцессор с графическими функциями).

Одни, вслед за AMD, именуют такие чипы APU (Accelerated Processing Unit — ускоренное вычислительное устройство). Кто-то предпочитает gCPU (g — от «graphics»). Чаще других звучит аббревиатура GEM (Graphics Enabled Microprocessor — микропроцессор с графическими функциями).

Но как бы ни называли такие чипы разные производители, у них общая ключевая особенность: графический и основной микропроцессоры размещаются на одном кристалле. Между прочим в AMD эту маленькую деталь считают крупнейшим архитектурным достижением со времён рождения x86.

Несколько упрощая техническую часть, GEM-процессоры можно представить как логическое продолжение так называемой интегрированной графики. Последняя предполагает внедрение видеокарты в материнскую плату (набор системных микросхем, системный чипсет) — и давно стала стандартом де-факто: «интегрированное видео» стоит на девяти из десяти современных компьютеров. Но с точки зрения центрального микропроцессора, интегрированная видеокарта ничем не отличается от обычной, выполненной отдельной платой: общение с ней так же ведётся через чипы-посредники.

Прямое общение основного и графического процессоров, размещённых на одном кристалле, выливается в множество плюсов. Во-первых, увеличивается общая производительность системы и, к примеру, появляется возможность смотреть HD-видео и строить сложные пользовательские интерфейсы без ущерба для основной задачи на слабых нетбуках. Во-вторых, повышается энергоэкономичность: ноутбуки на GEM-процессорах даже при полной загрузке способны продержаться весь рабочий день на одном заряде аккумулятора. Наконец, благодаря однокристалльной схеме становится заметно дешевле производство связки CPU+GPU.

Согласно известной шутке пятнадцатилетней давности, мультимедия — это когда всё поблёскивает, попискивает и помигивает, а работа стоит. К сожалению или счастью, противники мультимедийных штучек недооценили интерес публики к подобным продуктам. Считается, что именно спрос на портативные компьютеры, способные без натуги обрабатывать всё богатство медиапотоков, оставаясь в автономном режиме как можно дольше, подтолкнул к созданию GEM-микропроцессоров.

Конечно, GEM не панацея от всех бед и, к примеру, не в состоянии конкурировать с системой, оптимизированной для игр или обработки видео, где графическая часть возложена на отдельную дорогую видеокарту. Но особенно для нижнего сегмента массового рынка, простёршегося от нетбуков до недорогих десктопов, GEM может оказаться идеальным решением.

В текущем году сражение за GEM-системы развернётся между Intel и AMD. Первая выводит на рынок архитектуру Sandy Bridge, вторая — чипы из семейства Fusion. В обоих случаях выпускаются микропроцессоры для всех классов ходовой вычислительной техники, от нетбуков до серверов. Кроме того, GEM-процессорами занимается Via, но она сосредоточена на встраиваемых и промышленных системах, поэтому её влияние на массовый рынок минимально.

Какие перемены компьютерному миру сулит пришествие GEM-чипов? Аналитики пока очень осторожны в оценках перспектив, отдавая приоритет энергоэкономичности систем с новыми процессорами. Тот факт, что средний GEM-ноутбук, загруженный настоящими (не теоретически-тестовыми) приложениями, способен сохранить автономность на протяжении всего дня, должен подстегнуть фантазию разработчиков программного обеспечения. Что же касается конкуренции GEM с видеокартами, здесь всё ещё сложней. Пришествие GEM-чипов действительно обозначило скорую кончину интегрированной графики, но это обстоятельство эксперты предвидели ещё пару лет назад.

Что же касается конкуренции GEM с видеокартами, здесь всё ещё сложней. Пришествие GEM-чипов действительно обозначило скорую кончину интегрированной графики, но это обстоятельство эксперты предвидели ещё пару лет назад.

Вместе с тем предполагалось, что доминирующее влияние Nvidia на рынке графических чипов будет существенно ослаблено GEM-инициативой Intel и AMD. И вот сторонников этой теории подстерегла настоящая неожиданность. После того, как нынешней зимой Nvidia частично рассекретила проект Denver, стало ясно, что жертва поменялась ролями с хищниками.

Таинственный Denver представляет собой полноценный высокопроизводительный 64-разрядный ARM-совместимый микропроцессор для настольных систем, построенный по уже знакомой схеме GEM: на одном кристалле с главным вычислителем будет размещена и традиционно мощная графическая часть. На прилавках он может появиться через пару лет и сразу же занять хорошее место: ведь к тому времени на ARM-процессорах, популярных сегодня среди производителей портативных устройств, будет работать даже MS Windows.

Таким образом одна из важнейших перемен, могущая произойти благодаря пришествию GEM, заключается в окончании гегемонии x86. Если смелая затея Nvidia удастся, на рынок персональных компьютеров впервые после Alpha придёт альтернативный набор инструкций. Какими коллизиями и трансформациями обернётся этот этап, никто предсказать пока не берётся.

В чем разница между GPU и CPU? Выполняется ли рендеринг параллельно?

Первый: что такое графический процессор

Давным-давно, около 2000 года, видеокарты еще назывались графическими ускорителями. То, что обычно называют картой ускорителя, не является основным компонентом, который похож на сопроцессор M7, который в настоящее время используется Apple. Такие вещи лучше, и они не исключены: пока есть базовый графический вывод, их можно подключить к монитору. Раньше такой отдельный графический процессор могли видеть только некоторые высокопроизводительные рабочие станции и домашние игровые консоли. Позже, с популяризацией ПК, развитием игр и появлением таких гегемонов рынка, как Windows, рабочая нагрузка производителей графического оборудования упростилась, и постепенно стали популярными графические процессоры или видеокарты.

Позже, с популяризацией ПК, развитием игр и появлением таких гегемонов рынка, как Windows, рабочая нагрузка производителей графического оборудования упростилась, и постепенно стали популярными графические процессоры или видеокарты.

Графические процессоры производятся многими производителями.Как и процессоры, производителей больше, но есть только три, с которыми все знакомы, так что все думают, что есть только три производителя графических процессоров: AMD, NVIDIA и Intel.

Два: разница между GPU и CPU

Чтобы понять разницу между GPU и CPU, вам нужно понять, для чего предназначен GPU. Современные функции графического процессора охватывают все аспекты отображения графики, мы возьмем только самое простое направление в качестве примера. Чтобы

Возможно, вы видели изображение выше.Это тест старой версии Direct X, которая представляет собой вращающийся куб. Требуется много шагов, чтобы показать, что такой куб, как этот. Давайте сначала рассмотрим простой. Представьте, что это проволочный каркас без изображения X на стороне. Чтобы немного упростить, здесь нет линий, только восемь точек (у куба восемь вершин). Тогда вопрос упрощается до того, как повернуть эти восемь точек. Прежде всего, когда вы создаете этот куб, у вас должны быть координаты восьми вершин. Все координаты представлены векторами, так что, по крайней мере, это трехмерный вектор. Тогда «вращение» этого преобразования представляется матрицей в линейной алгебре. Вращение вектора — это умножение этой матрицы на вектор. Поворот этих восьми точек равен восьмикратному умножению векторов и матриц. Этот вид расчетов не сложен и представляет собой не что иное, как сложение нескольких продуктов вместе, что означает, что сумма расчета относительно велика. Восемь очков засчитываются как восемь раз, а 2000 очков засчитываются как 2000 раз. Это часть работы графического процессора, преобразование вершин, которое также является самой простой частью. Есть много вещей, которые доставляют больше хлопот, чем это.

Представьте, что это проволочный каркас без изображения X на стороне. Чтобы немного упростить, здесь нет линий, только восемь точек (у куба восемь вершин). Тогда вопрос упрощается до того, как повернуть эти восемь точек. Прежде всего, когда вы создаете этот куб, у вас должны быть координаты восьми вершин. Все координаты представлены векторами, так что, по крайней мере, это трехмерный вектор. Тогда «вращение» этого преобразования представляется матрицей в линейной алгебре. Вращение вектора — это умножение этой матрицы на вектор. Поворот этих восьми точек равен восьмикратному умножению векторов и матриц. Этот вид расчетов не сложен и представляет собой не что иное, как сложение нескольких продуктов вместе, что означает, что сумма расчета относительно велика. Восемь очков засчитываются как восемь раз, а 2000 очков засчитываются как 2000 раз. Это часть работы графического процессора, преобразование вершин, которое также является самой простой частью. Есть много вещей, которые доставляют больше хлопот, чем это. В целом, есть большая разница в дизайне, потому что CPU и GPU изначально используются для обработки разных задач. Они предназначены для двух разных сценариев применения. ЦП нуждается в большой гибкости для обработки различных типов данных, и в то же время он требует логической оценки и вводит большое количество переходов ветвлений и обработки прерываний. Все это чрезвычайно усложняет внутреннюю структуру процессора. Графический процессор работает с унифицированными, независимыми, крупномасштабными данными и чистой вычислительной средой, которую не нужно прерывать.

В целом, есть большая разница в дизайне, потому что CPU и GPU изначально используются для обработки разных задач. Они предназначены для двух разных сценариев применения. ЦП нуждается в большой гибкости для обработки различных типов данных, и в то же время он требует логической оценки и вводит большое количество переходов ветвлений и обработки прерываний. Все это чрезвычайно усложняет внутреннюю структуру процессора. Графический процессор работает с унифицированными, независимыми, крупномасштабными данными и чистой вычислительной средой, которую не нужно прерывать.

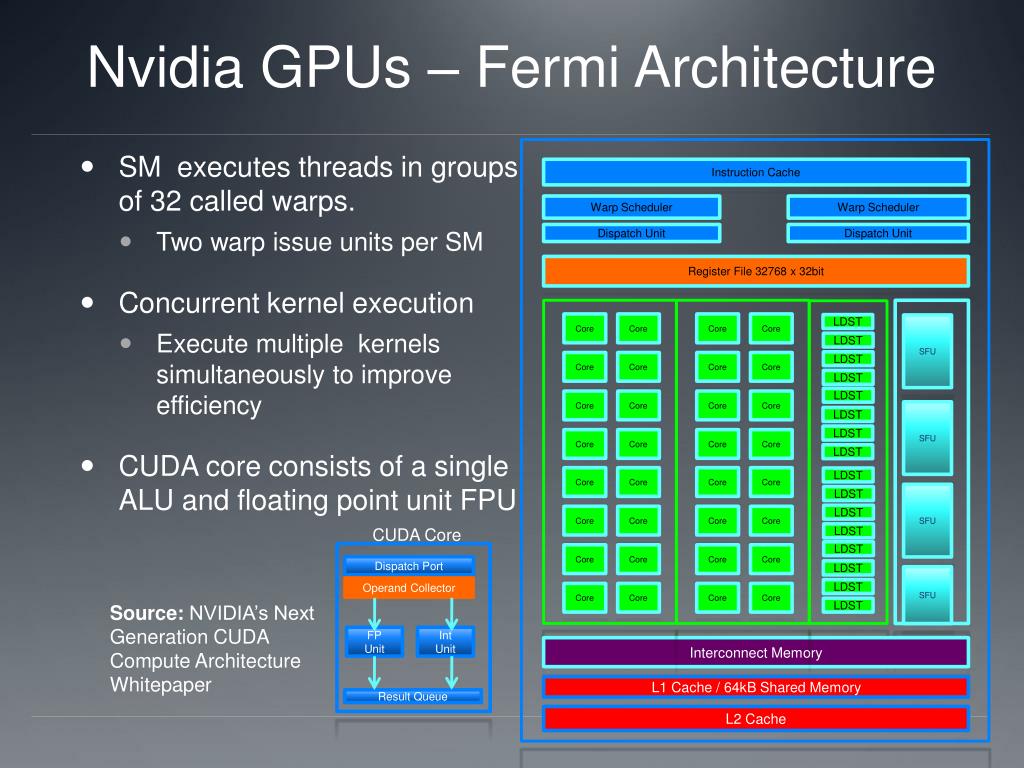

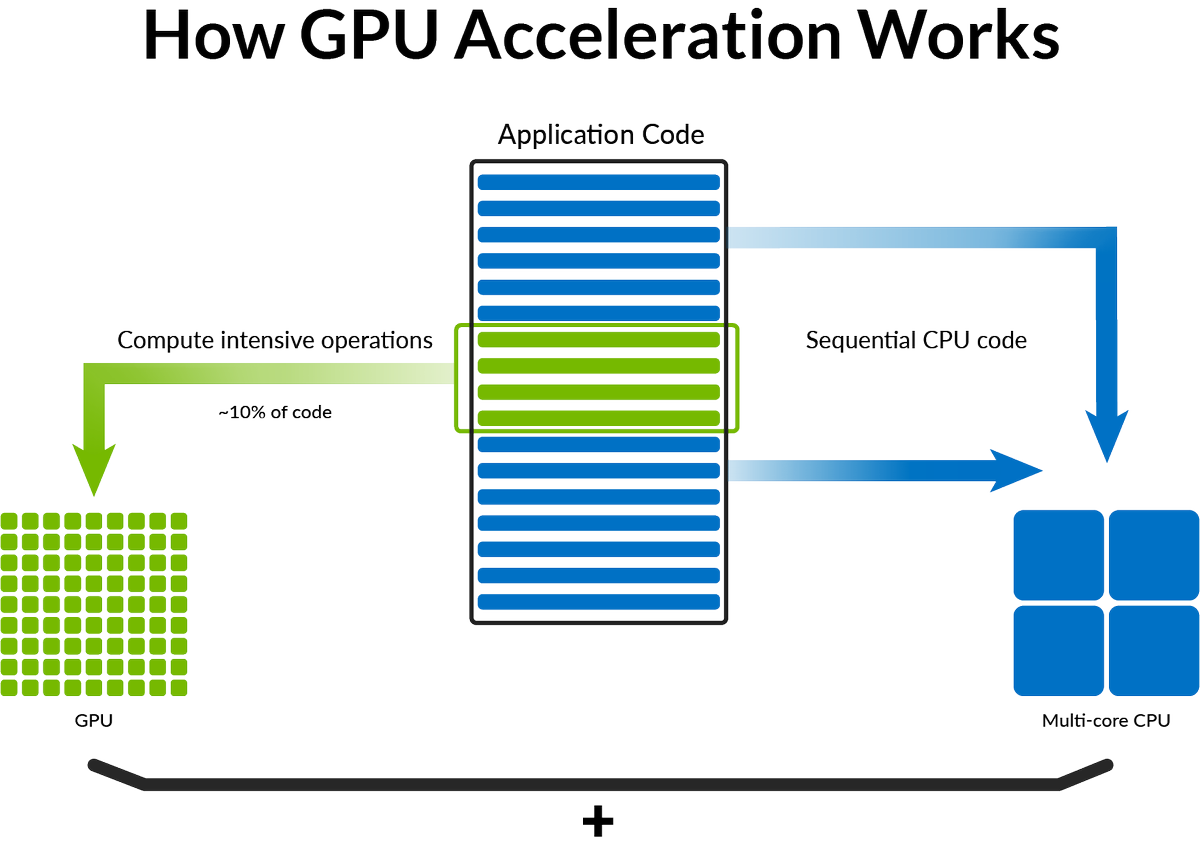

Итак, CPU и GPU представляют собой очень разные архитектуры (схематическая диаграмма):

Выявлена разница между CPU и GPU

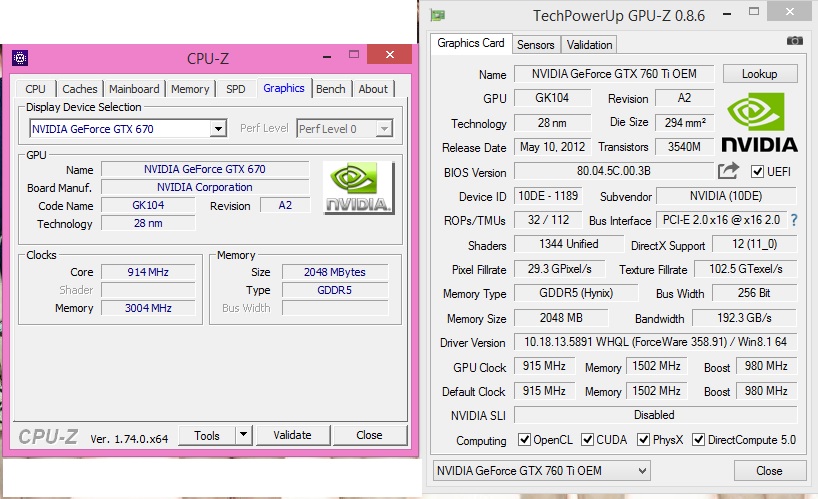

Изображение взято из документа nVidia CUDA. Зеленый — это вычислительный блок, оранжево-красный — это блок памяти, а оранжевый — это блок управления.

Графический процессор использует большое количество вычислительных блоков и длинный конвейер, но имеет только очень простую логику управления и сохраняет кэш. ЦП не только занимает много места в кэше, но также имеет сложную логику управления и множество схем оптимизации, в то время как вычислительная мощность составляет лишь небольшую часть ЦП.

ЦП не только занимает много места в кэше, но также имеет сложную логику управления и множество схем оптимизации, в то время как вычислительная мощность составляет лишь небольшую часть ЦП.

И большая часть работы графического процессора такова, вычисления большие, но нет технического содержания, и их приходится повторять много-много раз. Точно так же, как у вас есть работа, которая требует сотен миллионов сложений, вычитаний, умножений и делений в пределах 100, лучший способ — нанять десятки учеников начальной школы, чтобы они считали вместе, и один человек считает часть.В любом случае эти вычисления не имеют технического содержания и являются чисто физической работой. ЦП похож на старого профессора, учитываются интеграл и дифференциал, то есть зарплата высокая. Старый профессор стоит 20 учеников начальной школы. Если вы Foxconn, кого бы вы наняли? Графический процессор похож на это, используя множество простых вычислительных блоков для выполнения большого количества вычислительных задач, чисто тактика переполнения. Эта стратегия основана на предпосылке, что работа ученика начальной школы А и ученика начальной школы Б независима друг от друга. Многие задачи, связанные с большим количеством вычислений, в основном имеют эту функцию, например, взлом паролей, добыча полезных ископаемых и многие графические вычисления, о которых вы упомянули. Эти вычисления можно разбить на несколько одинаковых простых небольших задач, и каждая задача может быть назначена ученику начальной школы. Но есть еще некоторые задачи, связанные с проблемами «потока». Например, если вы идете на свидание вслепую, обе стороны могут продолжать развиваться, если будут выглядеть приятными для глаз. Разве вы не могли бы здесь еще встретиться и найти кого-нибудь там, чтобы получить все сертификаты. Эта более сложная проблема решается центральным процессором.

Эта стратегия основана на предпосылке, что работа ученика начальной школы А и ученика начальной школы Б независима друг от друга. Многие задачи, связанные с большим количеством вычислений, в основном имеют эту функцию, например, взлом паролей, добыча полезных ископаемых и многие графические вычисления, о которых вы упомянули. Эти вычисления можно разбить на несколько одинаковых простых небольших задач, и каждая задача может быть назначена ученику начальной школы. Но есть еще некоторые задачи, связанные с проблемами «потока». Например, если вы идете на свидание вслепую, обе стороны могут продолжать развиваться, если будут выглядеть приятными для глаз. Разве вы не могли бы здесь еще встретиться и найти кого-нибудь там, чтобы получить все сертификаты. Эта более сложная проблема решается центральным процессором.

И некоторые задачи похожи на проблему, для решения которой изначально использовался GPU, поэтому используйте GPU. Скорость вычислений графического процессора зависит от того, сколько учеников начальной школы нанято, а скорость вычислений центрального процессора зависит от того, насколько влиятельный профессор нанят. Способность профессора справляться со сложными задачами сокрушает учеников начальной школы, но для не таких сложных задач они все равно не выдерживают толпы. Конечно, текущий графический процессор также может выполнять несколько немного сложных задач, что эквивалентно повышению до уровня учеников младших и старших классов. Но ему по-прежнему нужен ЦП, чтобы передать данные в рот, прежде чем он сможет начать работать. Об этом позаботится ЦП.

Способность профессора справляться со сложными задачами сокрушает учеников начальной школы, но для не таких сложных задач они все равно не выдерживают толпы. Конечно, текущий графический процессор также может выполнять несколько немного сложных задач, что эквивалентно повышению до уровня учеников младших и старших классов. Но ему по-прежнему нужен ЦП, чтобы передать данные в рот, прежде чем он сможет начать работать. Об этом позаботится ЦП.

Третье: параллельные вычисления

Прежде всего, давайте поговорим о концепции параллельных вычислений. Это один из видов вычислений, многие из которых выполняются одновременно. Большие проблемы можно разделить на более мелкие, которые затем можно решить одновременно. Он может выполнять совместную обработку с процессором или хостом, иметь собственную память и даже запускать 1000 потоков одновременно.

Когда для вычислений используется графический процессор, с центральным процессором в основном выполняются следующие взаимодействия:

Обмен данными между CPU и GPU, обмен данными на GPU

Позвольте мне сначала объяснить. Вообще говоря, только одно вычисление может выполняться на вычислительном ядре ЦП или ГП (которое мы обычно называем «ядром») одновременно. В технологии гиперпоточности вычислительное ядро может выполнять несколько вычислений одновременно. (Например, для двухъядерного четырехпоточного ЦП каждое вычислительное ядро может выполнять два вычисления одновременно без конфликтов ресурсов), но гиперпоточность обычно только удваивает логическое вычислительное ядро. Обычно мы видим, что используемый нами ЦП может запускать десятки программ одновременно. На самом деле, с микроскопической точки зрения, эти десятки программ все еще в определенной степени последовательны. Например, на четырехъядерном четырехпоточном ЦП то же самое Только 4 вычисления могут выполняться одновременно, и эти десятки программ могут выполняться только поочередно на четырех вычислительных ядрах.Просто из-за высокой скорости переключения макроскопически показано, что эти программы выполняются «одновременно».

Вообще говоря, только одно вычисление может выполняться на вычислительном ядре ЦП или ГП (которое мы обычно называем «ядром») одновременно. В технологии гиперпоточности вычислительное ядро может выполнять несколько вычислений одновременно. (Например, для двухъядерного четырехпоточного ЦП каждое вычислительное ядро может выполнять два вычисления одновременно без конфликтов ресурсов), но гиперпоточность обычно только удваивает логическое вычислительное ядро. Обычно мы видим, что используемый нами ЦП может запускать десятки программ одновременно. На самом деле, с микроскопической точки зрения, эти десятки программ все еще в определенной степени последовательны. Например, на четырехъядерном четырехпоточном ЦП то же самое Только 4 вычисления могут выполняться одновременно, и эти десятки программ могут выполняться только поочередно на четырех вычислительных ядрах.Просто из-за высокой скорости переключения макроскопически показано, что эти программы выполняются «одновременно».

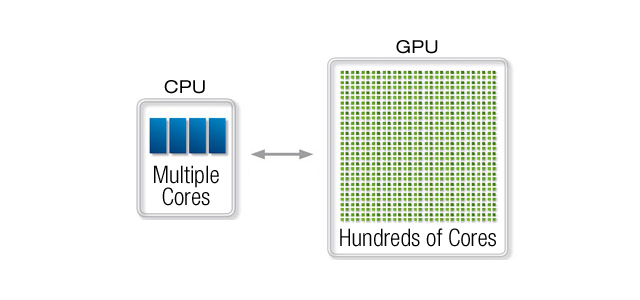

Самая заметная особенность графического процессора состоит в том, что он имеет множество вычислительных ядер. Как правило, у ЦП всего четыре или восемь вычислительных ядер, и обычно не более двух цифр, тогда как графические процессоры, используемые для научных вычислений, могут иметь тысячи вычислительных ядер. Из-за огромного преимущества количества вычислительных ядер количество вычислений, которые графический процессор может выполнять одновременно, намного превышает количество вычислений, выполняемых центральным процессором. В настоящее время для тех вычислений, которые могут выполняться параллельно, преимущество GPU может значительно повысить эффективность. Вот объяснение последовательного расчета и параллельного расчета задач. Как правило, при последовательных вычислениях одно вычисляется перед вычислением следующего, а при параллельных вычислениях выполняется несколько параллельных вычислений одновременно. Например, чтобы вычислить произведение действительного числа a и вектора B = [1 2 3 4], последовательное вычисление состоит в том, чтобы сначала вычислить a * B [1], затем вычислить a * B [2], затем вычислить a * B [3] и, наконец, вычислить a * B [4], чтобы получить результат a * B, параллельное вычисление должно вычислить a * B [1], a * B [2], a * B [3] и a * B [4] одновременно, чтобы получить * Результат Б.

Как правило, у ЦП всего четыре или восемь вычислительных ядер, и обычно не более двух цифр, тогда как графические процессоры, используемые для научных вычислений, могут иметь тысячи вычислительных ядер. Из-за огромного преимущества количества вычислительных ядер количество вычислений, которые графический процессор может выполнять одновременно, намного превышает количество вычислений, выполняемых центральным процессором. В настоящее время для тех вычислений, которые могут выполняться параллельно, преимущество GPU может значительно повысить эффективность. Вот объяснение последовательного расчета и параллельного расчета задач. Как правило, при последовательных вычислениях одно вычисляется перед вычислением следующего, а при параллельных вычислениях выполняется несколько параллельных вычислений одновременно. Например, чтобы вычислить произведение действительного числа a и вектора B = [1 2 3 4], последовательное вычисление состоит в том, чтобы сначала вычислить a * B [1], затем вычислить a * B [2], затем вычислить a * B [3] и, наконец, вычислить a * B [4], чтобы получить результат a * B, параллельное вычисление должно вычислить a * B [1], a * B [2], a * B [3] и a * B [4] одновременно, чтобы получить * Результат Б. Если есть только одно вычислительное ядро, четыре вычислительные задачи не могут выполняться параллельно и могут быть вычислены только по одной последовательно, но если имеется четыре вычислительных ядра, четыре независимых вычислительных задачи могут быть разделены на четыре ядра параллельно Исполнение — это преимущество параллельных вычислений. Из-за этого у графического процессора много вычислительных ядер, а масштаб параллельных вычислений очень велик.Для некоторых вычислительных задач, которые можно решить с помощью параллельных вычислений, он показывает лучшую производительность, чем центральный процессор. Например, чтобы расшифровать код, задача делится на несколько частей, которые могут выполняться независимо, и каждая часть выделяется ядру графического процессора, и несколько задач дешифрования могут выполняться одновременно, тем самым ускоряя декодирование.

Если есть только одно вычислительное ядро, четыре вычислительные задачи не могут выполняться параллельно и могут быть вычислены только по одной последовательно, но если имеется четыре вычислительных ядра, четыре независимых вычислительных задачи могут быть разделены на четыре ядра параллельно Исполнение — это преимущество параллельных вычислений. Из-за этого у графического процессора много вычислительных ядер, а масштаб параллельных вычислений очень велик.Для некоторых вычислительных задач, которые можно решить с помощью параллельных вычислений, он показывает лучшую производительность, чем центральный процессор. Например, чтобы расшифровать код, задача делится на несколько частей, которые могут выполняться независимо, и каждая часть выделяется ядру графического процессора, и несколько задач дешифрования могут выполняться одновременно, тем самым ускоряя декодирование.

Но параллельные вычисления — не панацея. Для этого нужна предпосылка: проблема может быть разложена на несколько частей, которые могут выполняться параллельно. Многие задачи не соответствуют этому условию. Например, задача состоит из двух шагов, и расчет второго шага зависит от результата первого шага. В настоящее время две части не могут выполняться параллельно, а могут выполняться только последовательно. Фактически, наши обычные вычислительные задачи часто имеют сложные зависимости, и многие важные вычислительные задачи невозможно распараллелить. Это недостаток графического процессора.

Многие задачи не соответствуют этому условию. Например, задача состоит из двух шагов, и расчет второго шага зависит от результата первого шага. В настоящее время две части не могут выполняться параллельно, а могут выполняться только последовательно. Фактически, наши обычные вычислительные задачи часто имеют сложные зависимости, и многие важные вычислительные задачи невозможно распараллелить. Это недостаток графического процессора.

В основном существуют следующие методы программирования GPU:

Источник статьи:https://www.renderbus.com/share/post-id-1478

CPU и GPU — что это такое в компьютере?

Приветствую друзья!

В этой маленькой заметке я как всегда очень просто рассказать о некоторых, возможно сложных вещах.

Сразу коротко ответ: CPU и GPU — основные устройства компьютера, представляющие из себя процессор (CPU) и видеокарту (GPU).

Теперь рассмотрим немного подробнее про CPU и GPU:

- CPU — расшифровывается как Central Processor Unit, это процессор, собственно от чего и зависит производительность стационарного ПК или ноутбука.

Он имеет определенное количество ядер, может иметь потоки, и конечно частоту. Чем больше ядер — тем больше ПК может параллельно выполнять программ. А вот чем выше частота — тем быстрее он может работать. Но много ядер и высокая частота — нелегкая задача для производителей, процы с высокой частотой и большим количеством ядер как правило дорогое удовольствие.

Он имеет определенное количество ядер, может иметь потоки, и конечно частоту. Чем больше ядер — тем больше ПК может параллельно выполнять программ. А вот чем выше частота — тем быстрее он может работать. Но много ядер и высокая частота — нелегкая задача для производителей, процы с высокой частотой и большим количеством ядер как правило дорогое удовольствие. - GPU — расшифровывается как Graphics Processing Unit, это видеокарта (графический адаптер), устройство, которое определяет производительность игр, качество визуальных эффектов. Мощная видеокарта — тоже стоит дорого, даже прилично дорого, она также как и мощный проц — греется при максимальной нагрузке, иногда прилично. Поэтому охлаждение CPU или GPU никогда не стоит игнорировать. Видеокарта имеет свою видеопамять, а также разные технологии, которые чем современнее — тем выше качество картинки игры.

Но есть еще iGPU — это встроенное графическое ядро процессора. Простыми словами — видеокарта, которая находится прямо в процессоре, ее более чем достаточно для простых офисных задач, а топовые процы содержат такую встроенную видеокарту, что даже в старые игры можно поиграть более-менее нормально.

Например встроенная видеокарта процессора i9-10900K примерно такой мощности, как раньше были отдельные видеокарты, которые считались мощными, и были дорогие (имею ввиду типа GeForce 8800 GT, хотя наверно встройка i9-10900K будет даже мощнее).

Теперь давайте посмотрим на внешний вид CPU и GPU, вот как выглядит обычная игровая видеокарта (GPU):

РЕКЛАМА

Это обычная прилично игровая видеокарта, стоить она может очень недешево, как топовый процессор. Также стоит учесть, то такая видюха и кушает прилично, поэтому блок питания нужен не только мощный, но и качественный.

А вот сам процессор (CPU), установленный в гнездо материнки (называется сокет):

РЕКЛАМА

На самом деле он очень маленький, его еще называют камушек, камень:

РЕКЛАМА

Важно понимать: на материнскую плату можно установить только тот процессор, который ее поддерживает.

Узнать можно на официальном сайте производителя материнки.

Вот встроенное графическое ядро (iGPU) — которое представляет из себя просто еще один чип под крышкой проца, рядом с основным чипом процессора:

Даже самые дешевые процессоры Intel Celeron/Amd Athlon содержат такое графическое видеоядро, если вы не играете в игры, а комп нужен для офиса — можно смело брать, это приличная экономия. Да и его более чем достаточно для игр, видео, фильмов, даже если большой монитор HD — не проблема.

Надеюсь данная информация оказалась полезной. Удачи и добра, до новых встреч друзья!

На главную! 10.03.2021РЕКЛАМА

Видеокарта (GPU) против процессора (CPU): что важнее всего для игр на ПК

Некоторые решения для игровых ПК просты. Например, ответ на вопрос о том, следует ли обновить пространство на жестком диске (HDD) или твердотельном диске (SSD). Многие, скорее всего, с энтузиазмом ответят «Да!». Другие решения, однако, намного сложнее. Узнать, следует ли вам обновить ваш процессор или графический процессор, например, гораздо сложнее. Мы здесь, чтобы помочь с этим решением.

Многие, скорее всего, с энтузиазмом ответят «Да!». Другие решения, однако, намного сложнее. Узнать, следует ли вам обновить ваш процессор или графический процессор, например, гораздо сложнее. Мы здесь, чтобы помочь с этим решением.

Что такое процессор?

Центральный процессор (ЦП), также называемый «процессор», выполняет и управляет инструкциями компьютерной программы, выполняя операции ввода / вывода (I / O), базовую арифметику и логику. Неотъемлемая часть любого компьютера, процессор получает, направляет и обрабатывает данные компьютера. Поскольку это обычно самый важный компонент, его часто называют «мозгом» или «сердцем» настольного или портативного компьютера, в зависимости от того, какую часть тела вы считаете наиболее важной. И когда дело доходит до игр, это довольно важный компонент игровой системы.

Исторически сложилось так, что у процессоров было только одно ядро, которое было бы сосредоточено на одной задаче. Однако современные процессоры имеют от 2 до 28 ядер, каждое из которых ориентировано на уникальную задачу. Таким образом, многоядерный процессор представляет собой один чип, который содержит два или более ядер процессора.

Таким образом, многоядерный процессор представляет собой один чип, который содержит два или более ядер процессора.

А процессоры с большим количеством ядер более эффективны, чем с меньшим. Двухъядерные (или 2-ядерные) процессоры распространены, но процессоры с 4 ядрами, также называемые четырехъядерными процессорами (например, процессоры Intel® Core ™ 8-го поколения), становятся все более популярными.

Что такое графический процессор?

Графический процессор (GPU), также называемый графической картой или видеокартой, представляет собой специализированную электронную схему, которая ускоряет создание и рендеринг изображений, видео и анимации. Он выполняет быстрые математические вычисления, освобождая процессор для выполнения других задач.

Существует два типа графических процессоров: один представляет собой интегрированный (или встроенный) графический процессор, который живет непосредственно и совместно использует память с процессором. А другой — это дискретный графический процессор, имеющий собственную карту и память.

Графический процессор является чрезвычайно важным компонентом игровой системы, а во многих случаях даже более важным, чем центральный процессор, когда дело доходит до игры в определенные типы игр.

Простое описание: GPU — это однокристальный процессор, который используется главным образом для управления и повышения производительности видео и графики.

В чем «основная» разница между процессором и графическим процессором

В то время как процессор использует несколько ядер, ориентированных на последовательную обработку, графический процессор создан для многозадачности; он имеет от сотен до тысяч меньших ядер для одновременной обработки тысяч потоков (или инструкций). Некоторые процессоры используют технологию многопоточности (в частности, Intel Hyper-Threading), которая позволяет одному ядру процессора работать как два отдельных виртуальных (или «логических») ядра или потока. Идея состоит в том, что они могут разделить рабочую нагрузку между собой и увеличить количество инструкций, действующих на отдельные данные, при одновременном выполнении, что повышает производительность.

Что важнее для игр на ПК: процессор или графический процессор?

Для многих, GPU универсально оценивается как наиболее важный для игр на ПК. Это потому, что GPU — это то, что на самом деле отображает изображения, сцены и анимации, которые вы видите. Большинство современных динамичных игр невероятно требовательны к типу мощности рендеринга, который обеспечивает GPU. В то же время эти игры предназначены для использования преимуществ нескольких ядер и потоков, которые предлагают новые процессоры. И CPU, и GPU важны сами по себе. Для требовательных игр требуется как мощный процессор, так и мощный графический процессор. Но вопрос, насколько они важны для игр на ПК, зависит от того, для чего они будут использоваться в первую очередь, и для каких игр в частности.

Во время игры центральным процессорам даются определенные задачи, которые GPU не так хорошо выполняет, такие как функции искусственного интеллекта (ИИ) неигровых персонажей (NPC). Однако многие задачи лучше выполнять графическому процессору. Некоторые игры работают лучше с большим количеством ядер, потому что они фактически используют их. Другие не могут, потому что они запрограммированы на использование только одного ядра, и игра работает лучше с более быстрым процессором. В противном случае у него не будет достаточно мощности и он будет тормозить. Minecraft, например, работает только с одним ядром, поэтому ему не требуется дополнительная мощность. В этом случае скорость процессора — единственное, что будет влиять на количество кадров в секунду (FPS) во время игры.

Некоторые игры работают лучше с большим количеством ядер, потому что они фактически используют их. Другие не могут, потому что они запрограммированы на использование только одного ядра, и игра работает лучше с более быстрым процессором. В противном случае у него не будет достаточно мощности и он будет тормозить. Minecraft, например, работает только с одним ядром, поэтому ему не требуется дополнительная мощность. В этом случае скорость процессора — единственное, что будет влиять на количество кадров в секунду (FPS) во время игры.

Какие типы игр требуют больше труда от процессора?

Современные быстро развивающиеся игры, в том числе шутеры от первого лица (FPS), многопользовательские игры созданы для того, чтобы воспользоваться преимуществами новейших процессоров, их многоядерных процессоров и потоков.

Например, многопользовательская игра-шутер от первого лица Call of Duty: Black Ops 4 рекомендует по крайней мере четырехъядерный процессор: либо Intel i5-2500K, который имеет 4 ядра и 4 потока, либо AMD Ryzen R5 1600X, который имеет 6 ядра и 12 потоков. Но для игроков, использующих мониторы с высокой частотой обновления (1080p), игра фактически рекомендует AMD Ryzen 1800X (8-ядерный процессор с 16 потоками) или Intel i7-8700K (который имеет 6 ядер и 12 потоков). Восьмое поколение Intel i7-8700K является одним из самых быстрых процессоров с одними из самых высоких тактовых частот (ускорение 4,7 ГГц), которые Intel предлагает для игр и потоковой передачи.

Но для игроков, использующих мониторы с высокой частотой обновления (1080p), игра фактически рекомендует AMD Ryzen 1800X (8-ядерный процессор с 16 потоками) или Intel i7-8700K (который имеет 6 ядер и 12 потоков). Восьмое поколение Intel i7-8700K является одним из самых быстрых процессоров с одними из самых высоких тактовых частот (ускорение 4,7 ГГц), которые Intel предлагает для игр и потоковой передачи.

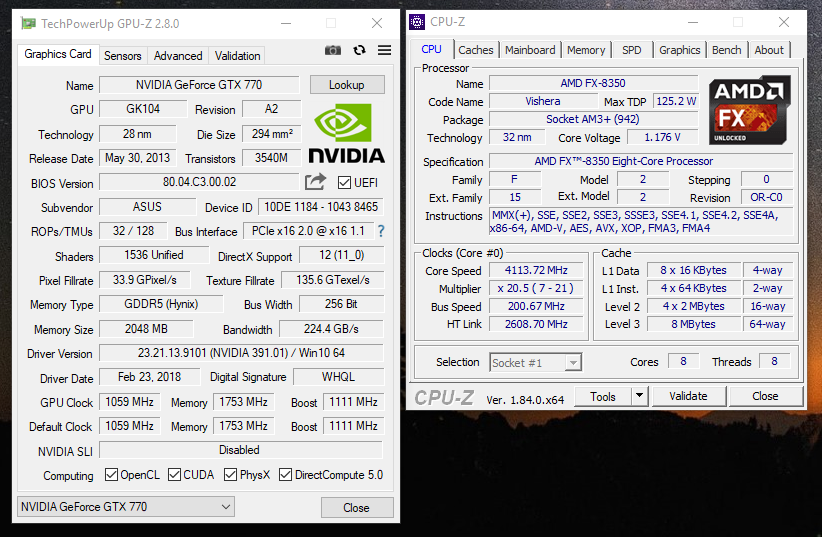

Точно так же известная многопользовательская ролевая онлайн-игра (MMORPG) World of Warcraft рекомендует также четырехъядерные процессоры: Intel i7-4770 (4 ядра, 8 потоков) или AMD FX-8310 (8 ядер, 8 потоков) или выше. Чрезвычайно популярная онлайн-игра Grand Theft Auto V с открытым миром рекомендует Intel i5 3470 (4 ядра, 4 потока) или AMD FX-8350 (8 ядер, 8 потоков). А в эпической игре Battle Royale компании Fortnite Battle Royale рекомендуется процессор Intel i5 с тактовой частотой 2,8 ГГц с 4 ядрами и 4 потоками.

Какие типы игр требуют больше труда от GPU?

Большинство современных игр требуют от GPU много, может быть, даже больше, чем от CPU. Для обработки 2D и 3D графики, рендеринга полигонов, отображения текстур и многого другого требуются мощные и быстрые графические процессоры. Чем быстрее ваша графическая / видеокарта (GPU) сможет обрабатывать информацию, тем больше кадров вы будете получать каждую секунду.

Для обработки 2D и 3D графики, рендеринга полигонов, отображения текстур и многого другого требуются мощные и быстрые графические процессоры. Чем быстрее ваша графическая / видеокарта (GPU) сможет обрабатывать информацию, тем больше кадров вы будете получать каждую секунду.

Например, для Call of Duty: Black Ops 4 рекомендуется использовать графические карты NVIDIA GeForce GTX 970 4 ГБ, GTX 1060 6 ГБ или Radeon R9 390 / AMD RX 580. Все они считаются картами среднего уровня, подходящими для игр в формате 1080p. и запускать игры на средних или даже высоких настройках с более высоким разрешением. Обозначение 1080p относится к разрешению (Full HD) 1920 x 1080 пикселей.

Для более конкурентоспособных игроков Call of Duty: Black Ops 4 рекомендует видеокарты GeForce GTX 1080 или Radeon RX Vega 64. Они считаются высококлассными картами, которые хороши для игр с разрешением 1440p Quad HD (QHD) или мониторами с более высокой частотой обновления, а также VR-гарнитурами.

Но вам нужно убедиться, что у вас есть монитор, соответствующий этим спецификациям (скажем, с частотой обновления 144 Гц), в противном случае не будет смысла приобретать более дорогую и более дорогую видеокарту. И обратное также верно: если у вас есть монитор с частотой обновления до 60 Гц, он не сможет идти в ногу с более мощной картой с пиксельным подталкиванием.

И обратное также верно: если у вас есть монитор с частотой обновления до 60 Гц, он не сможет идти в ногу с более мощной картой с пиксельным подталкиванием.

Для World of Warcraft рекомендуется использовать графический процессор NVIDIA GeForce GTX 960 4 ГБ или AMD Radeon R9 280 или выше. GTX 960 предлагает стабильную производительность 1080p с энергосберегающим потреблением и работает круче и тише, чем предыдущие модели. Хотя R9 280 имеет больше видеопамяти, чем GTX 960, оба графических процессора могут запускать требовательные игры при высоких настройках.

Как приключенческая игра Grand Theft Auto V, так и королевская битва Fortnite Battle Royale рекомендуют NVIDIA GeForce GTX 660 2 ГБ или AMD Radeon HD 7870 2 ГБ. Оба графических процессора по приемлемой цене созданы для быстрой игры в формате 1080p.

Должен ли я обновить свой графический процессор или процессор?

В идеальном мире вы бы просто купили лучшее из обоих. К сожалению, бюджетные ограничения могут привести к необходимости выбора одного или другого, по крайней мере, на данный момент. Многие игры теперь используют больше ядер как само собой разумеющееся (четырехъядерный процессор кажется наиболее распространенным) и, таким образом, имеют более быстрые и лучшие скорости FPS. Так что вы, вероятно, захотите пойти с чуть более дорогими четырехъядерными процессорами, если они не слишком дорогие. Современные двухъядерные процессоры могут стать узким местом для вашей видеокарты и привести к снижению производительности вашей игры, если только ваш графический процессор не является более старой и менее мощной версией.Четырехъядерные процессоры также являются более доступными, более производительными и менее медленными, чем более ранние версии. Все больше и больше новых игр, основанных на нескольких ядрах, а не только на скорости процессора, имеет смысл иметь больше ядер в вашей системе. На самом деле, если вы заядлый геймер и смотрите в будущее и хотите быть уверенным, что сможете запускать самые мощные игры с тройным А (AAA) в будущем — и, что еще важнее, вы можете позволить себе чрезвычайно высокие цены — возможно, имеет смысл использовать премиум-опции в процессорах или графических процессорах.

Многие игры теперь используют больше ядер как само собой разумеющееся (четырехъядерный процессор кажется наиболее распространенным) и, таким образом, имеют более быстрые и лучшие скорости FPS. Так что вы, вероятно, захотите пойти с чуть более дорогими четырехъядерными процессорами, если они не слишком дорогие. Современные двухъядерные процессоры могут стать узким местом для вашей видеокарты и привести к снижению производительности вашей игры, если только ваш графический процессор не является более старой и менее мощной версией.Четырехъядерные процессоры также являются более доступными, более производительными и менее медленными, чем более ранние версии. Все больше и больше новых игр, основанных на нескольких ядрах, а не только на скорости процессора, имеет смысл иметь больше ядер в вашей системе. На самом деле, если вы заядлый геймер и смотрите в будущее и хотите быть уверенным, что сможете запускать самые мощные игры с тройным А (AAA) в будущем — и, что еще важнее, вы можете позволить себе чрезвычайно высокие цены — возможно, имеет смысл использовать премиум-опции в процессорах или графических процессорах.

Что касается процессоров, один из самых мощных процессоров Intel на рынке сегодня — Intel Core i9. Две модели, i9-8950HK и i9-9900K, обе предлагают невероятно высокую производительность и скорость обработки игрового процесса с 8 ядрами и 16 потоками. А если у вас есть или вы планируете купить монитор 4K / Ultra High Definition (UHD), который предлагает более 8 миллионов пикселей, вы можете рассмотреть возможность обновления вашего GPU до карты, подобной NVIDIA GeForce RTX 2080 Ti. Это стоит более 1000 долларов.

Нижняя линия

Графические процессоры могут быть самой дорогой частью вашей игровой сборки, поэтому, если у вас более строгий бюджет, то неплохо было бы сохранить часть этого для своего процессора. Если вы тратите слишком много на графический процессор, не обращая внимания на процессор, то ваш игровой процесс может пострадать с более низкой частотой кадров в секунду.

Обновите свой процессор первым

Если вам нравятся быстро развивающиеся игры, такие как шутеры от первого лица, такие как Call of Duty: Black Ops 4, или стратегические игры в реальном времени, такие как The Age of Empires, или MMORPG, такие как World of Warcraft, то, вероятно, имеет смысл обновить ваш процессор первым.

Обновите свой GPU первым

С другой стороны, если вы в основном играете в онлайн-игры с открытым миром с четко определенной, захватывающей средой и потрясающими визуальными эффектами, такими как Grand Theft Auto V или RPG, такие как The Elder Scrolls V: Skyrim или The Witcher III: Wild Hunt, то сначала обновите GPU.

Что нужно учитывать при обновлении видеокарты

Если вы думаете об обновлении видеокарты, вот несколько вещей, которые следует учитывать:

1. Разрешение монитора. Большинство современных видеокарт соответствуют минимальным игровым требованиям для разрешения 1080p. Тем не менее, вам потребуется карта высокого класса, чтобы соответствовать любому монитору с разрешением 1440 пикселей и выше, включая QHD, WQHD и UHD или 4K.

2. Частота обновления: если ваш монитор имеет частоту обновления 144 Гц или выше, то вам также понадобится карта, которая столь же мощна, чтобы использовать ее потенциал. В то же время монитор с частотой обновления 60 Гц не нуждается в мощной и более дорогой видеокарте.

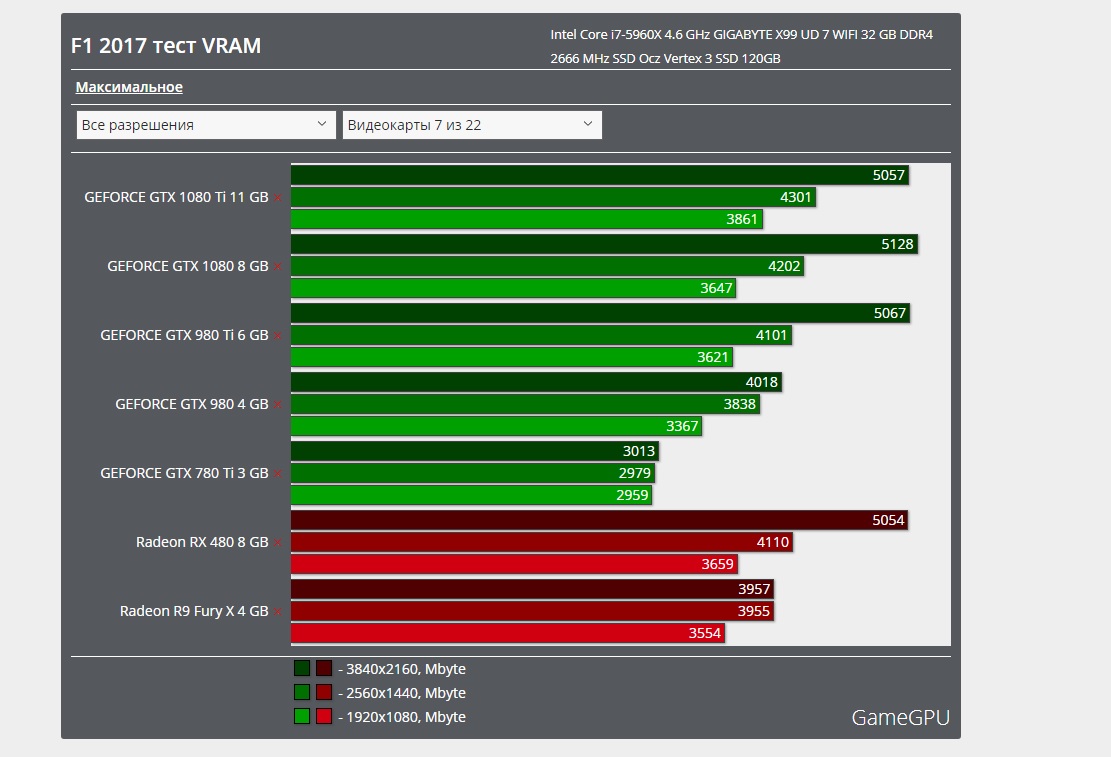

3. Память: память не только имеет значение в процессоре. Ваш графический процессор должен предлагать не менее 4 ГБ для интенсивных игр с

разрешением 1080p и не менее 8 ГБ, если вы хотите увеличить его до 4K мегаигр.

4. Форм-фактор: проверьте характеристики видеокарты, поскольку высота, длина и обхват — это важные измерения, которые следует учитывать для вашего графического процессора. Вам это нужно, чтобы соответствовать вашей игровой системе или корпусу.

5. AMD FreeSync или NVIDIA G-Sync: эти две технологии синхронизируют частоту обновления между графическим процессором и монитором, чтобы уменьшить или устранить разрывы. Перед покупкой новой видеокарты обязательно проверьте, какую технологию поддерживает ваш монитор.

6. Поддержка VR: Если вы собираетесь использовать одну из двух основных платформ виртуальных игр для ПК — HTC Vive или Oculus Rift — вам понадобятся как минимум карты среднего уровня, такие как NVIDIA GTX 1060/1070/1080. или AMD Radeon RX 570/580.

Знайте свои игровые требования

Обновление вашей игровой системы и, в частности, вашего процессора или графического процессора — это очень субъективная ситуация. Вы можете захотеть сделать это, чтобы играть в определенную игру или игру определенного типа. Вы можете быть случайным игроком, который просто хочет играть в разные типы игр время от времени. Или вы можете быть заядлым геймером, который играет достаточно для того, чтобы получить необходимую обработку и производительность, которые будут соответствовать загруженному графику игр.

Существует также ваш бюджет для рассмотрения. Если у вас есть ограниченное количество средств для работы, но вы можете периодически добавлять в свою игровую систему, тогда может иметь смысл сделать дополнительные, более экономичные обновления. Но если вы знаете, что вы будете играть самые последние и лучшие игры AAA, как только они будут выпущены, и у вас есть доступный бюджет, то переход на высокопроизводительный процессор и графический процессор, который вы можете себе позволить, может стоить того.

что это в компьютере. Виды графических процессоров

Процессоры и графические ускорители очень похожи, они оба сделаны из сотен миллионов транзисторов и могут обрабатывать тысячи операций за секунду. Но чем именно отличаются эти два важных компонента любого домашнего компьютера?

В данной статье мы попытаемся очень просто и доступно рассказать, в чем отличие CPU от GPU. Но сначала нужно рассмотреть два этих процессора по отдельности.

CPU (Central Processing Unit или же Центральное Процессорное Устройство) часто называют «мозгом» компьютера. Внутри центрального процессора расположено около миллиона транзисторов, с помощью которых производятся различные вычисления. В домашних компьютерах обычно устанавливаются процессоры, имеющие от 1 до 4 ядер с тактовой частотой приблизительно от 1 ГГц до 4 ГГц.

Процессор является мощным, потому что может делать все. Компьютер способен выполнить какую-либо задачу, так как процессор способен выполнить эту задачу. Программистам удалось достичь этого благодаря широким наборам инструкций и огромным спискам функций, совместно используемых в современных центральных процессорах.

Что такое GPU?

GPU (Graphics Processing Unit или же Графическое Процессорное Устройство) представляет собой специализированный тип микропроцессора, оптимизированный для очень специфических вычислений и отображения графики. Графический процессор работает на более низкой тактовой частоте в отличие от процессора, но имеет намного больше процессорных ядер.

Также можно сказать, что GPU — это специализированный CPU, сделанный для одной конкретной цели — рендеринг видео. Во время рендеринга графический процессор огромное количество раз выполняет несложные математические вычисления. GPU имеет тысячи ядер, которые будут работать одновременно. Хоть и каждое ядро графического процессора медленнее ядра центрального процессора, это все равно эффективнее для выполнения простых математических вычислений, необходимых для отображения графики. Этот массивный параллелизм является тем, что делает GPU способным к рендерингу сложной 3D графики, требуемой современными играми.

Отличие CPU и GPU

Графический процессор может выполнить лишь часть операций, которые может выполнить центральный процессор, но он делает это с невероятной скоростью. GPU будет использовать сотни ядер, чтобы выполнить срочные вычисления для тысяч пикселей и отобразить при этом сложную 3D графику. Но для достижения высоких скоростей GPU должен выполнять однообразные операции.

GPU будет использовать сотни ядер, чтобы выполнить срочные вычисления для тысяч пикселей и отобразить при этом сложную 3D графику. Но для достижения высоких скоростей GPU должен выполнять однообразные операции.

Возьмем, например, Nvidia GTX 1080. Данная видеокарта имеет 2560 шейдерных ядер. Благодаря этим ядрам Nvidia GTX 1080 может выполнить 2560 инструкций или операций за один такт. Если вы захотите сделать картинку на 1% ярче, то GPU с этим справится без особого труда. А вот четырехъядерный центральный процессор Intel Core i5 сможет выполнить только 4 инструкции за один такт.

Тем не менее, центральные процессоры более гибкие, чем графические. Центральные процессоры имеют больший набор инструкций, поэтому они могут выполнять более широкий диапазон функций. Также CPU работают на более высоких максимальных тактовых частотах и имеют возможность управлять вводом и выводом компонентов компьютера. Например, центральный процессор может интегрироваться с виртуальной памятью, которая необходима для запуска современной операционной системы. Это как раз то, что графический процессор выполнить не сможет.

Это как раз то, что графический процессор выполнить не сможет.

Вычисления на GPU

Даже несмотря на то, что графические процессоры предназначены для рендеринга, они способны на большее. Обработка графики — это только вид повторяющихся параллельных вычислений. Другие задачи, такие как майнинг Bitcoin и взломы паролей полагаются на одни и те же виды массивных наборов данных и простых математических вычислений. Именно поэтому некоторые пользователи используют видеокарты для не графических операций. Такое явление называется GPU Computation или же вычисления на GPU.

Выводы

В данной статье мы провели сравнение CPU и GPU. Думаю, всем стало понятно, что GPU и CPU имеют схожие цели, но оптимизированы для разных вычислений. Пишите свое мнение в комментариях, я постараюсь ответить.

Все мы знаем, что у видеокарты и процессора несколько различные задачи, однако знаете ли вы, чем они отличаются друг от друга во внутренней структуре? Как CPU (англ. — central processing unit ), так и GPU (англ. — graphics processing unit ) являются процессорами, и между ними есть много общего, однако сконструированы они были для выполнения различных задач. Подробнее об этом вы узнаете из данной статьи.

— graphics processing unit ) являются процессорами, и между ними есть много общего, однако сконструированы они были для выполнения различных задач. Подробнее об этом вы узнаете из данной статьи.

CPU

Основная задача CPU, если говорить простыми словами, это выполнение цепочки инструкций за максимально короткое время. CPU спроектирован таким образом, чтобы выполнять несколько таких цепочек одновременно или разбивать один поток инструкций на несколько и, после выполнения их по отдельности, сливать их снова в одну, в правильном порядке. Каждая инструкция в потоке зависит от следующих за ней, и именно поэтому в CPU так мало исполнительных блоков, а весь упор делается на скорость выполнения и уменьшение простоев, что достигается при помощи кэш-памяти и конвейера .

GPU

Основная функция GPU — рендеринг 3D графики и визуальных эффектов, следовательно, в нем все немного проще: ему необходимо получить на входе полигоны, а после проведения над ними необходимых математических и логических операций, на выходе выдать координаты пикселей. По сути, работа GPU сводится к оперированию над огромным количеством независимых между собой задач, следовательно, он содержит большой объем памяти, но не такой быстрой, как в CPU, и огромное количество исполнительных блоков: в современных GPU их 2048 и более, в то время как у CPU их количество может достигать 48, но чаще всего их количество лежит в диапазоне 2-8.

По сути, работа GPU сводится к оперированию над огромным количеством независимых между собой задач, следовательно, он содержит большой объем памяти, но не такой быстрой, как в CPU, и огромное количество исполнительных блоков: в современных GPU их 2048 и более, в то время как у CPU их количество может достигать 48, но чаще всего их количество лежит в диапазоне 2-8.

Основные отличия

CPU отличается от GPU в первую очередь способами доступа к памяти. В GPU он связанный и легко предсказуемый — если из памяти читается тексел текстуры, то через некоторое время настанет очередь и соседних текселов. С записью похожая ситуация — пиксель записывается во фреймбуфер, и через несколько тактов будет записываться расположенный рядом с ним. Также графическому процессору, в отличие от универсальных процессоров, просто не нужна кэш-память большого размера, а для текстур требуются лишь 128–256 килобайт. Кроме того, на видеокартах применяется более быстрая память, и в результате GPU доступна в разы большая пропускная способность, что также весьма важно для параллельных расчетов, оперирующих с огромными потоками данных.

Есть множество различий и в поддержке многопоточности: CPU исполняет 1– 2 потока вычислений на одно процессорное ядро, а GPU может поддерживать несколько тысяч потоков на каждый мультипроцессор, которых в чипе несколько штук! И если переключение с одного потока на другой для CPU стоит сотни тактов, то GPU переключает несколько потоков за один такт.

В CPU большая часть площади чипа занята под буферы команд, аппаратное предсказание ветвления и огромные объемы кэш-памяти, а в GPU большая часть площади занята исполнительными блоками. Вышеописанное устройство схематично изображено ниже:

Разница в скорости вычислений

Если CPU — это своего рода «начальник», принимающий решения в соответствии с указаниями программы, то GPU — это «рабочий», который производит огромное количество однотипных вычислений. Выходит, что если подавать на GPU независимые простейшие математические задачи, то он справится значительно быстрее, чем центральный процессор. Данным отличием успешно пользуются майнеры биткоинов.

Майнинг Bitcoin

Суть майнинга заключается в том, что компьютеры, находящиеся в разных точках Земли, решают математические задачи, в результате которых создаются биткоины . Все биткоин-переводы по цепочке передаются майнерам, чья работа состоит в том, чтобы подобрать из миллионов комбинаций один-единственный хэш, подходящий ко всем новым транзакциям и секретному ключу, который и обеспечит майнеру получение награды в 25 биткоинов за раз. Так как скорость вычисления напрямую зависит от количества исполнительных блоков, получается, что GPU значительно лучше подходят для выполнения данного типа задачи, нежели CPU. Чем больше количество произведенных вычислений, тем выше шанс получить биткоины. Дело даже дошло до сооружения целых ферм из видеокарт.

Многие видели аббревиатуру GPU, но не каждый знает, что это такое. Это компонент , который входит в состав видеокарты . Иногда его называют видеокарта, но это не правильно. Графический процессор занимается обработкой команд, которые формируют трехмерное изображение. Это основной элемент, от мощности которого зависит быстродействие всей видеосистемы.

Это основной элемент, от мощности которого зависит быстродействие всей видеосистемы.

Есть несколько видов таких чипов – дискретный и встроенный . Конечно, сразу стоит оговорить, что лучше первый. Его ставят на отдельные модули. Он мощный и требует хорошего охлаждения . Второй устанавливается практически на все компьютеры. Он встраивается в CPU, делая потребление энергии в разы ниже. Конечно, с полноценными дискретными чипами ему не сравниться, но на данный момент он показывает довольно хорошие результаты .

Как работает процессор

GPU занимается обработкой 2D и 3D графики. Благодаря GPU ЦП компьютера становится свободнее и может выполнять более важные задачи. Главная особенность графического процессора в том, что он старается максимально увеличить скорость расчета графической информации. Архитектура чипа позволяет с большей эффективностью обрабатывать графическую информацию, нежели центральный CPU ПК.

Графический процессор устанавливает расположение трехмерных моделей в кадре. Занимается фильтрацией входящих в них треугольников, определяет, какие находятся на виду, и отсекает те, которые скрыты другими объектами.

Немецкого исследователя об использовании вычислений GPU в эконофизике и статистической физике, в том числе для осуществления анализа информации на фондовом рынке. Мы представляем вашему вниманию основные тезисы этого материала.

Примечание: Статья в журнале датирована 2011 годом, с тех пор появились новые модели GPU-устройств, однако общие подходы к использованию этого инструмента в инфраструктуре для онлайн-трейдинга остались неизменными

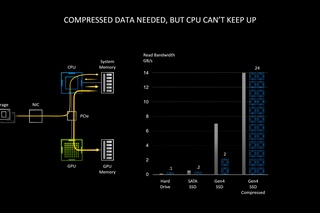

Требования к вычислительным мощностям растут в различных сферах. Одна из них — финансовый анализ, который необходим для успешной торговли на фондовом рынке, особенно средствами HFT. Для того, чтобы принять решение о покупке или продаже акций, алгоритм должен проанализировать серьезный объём входных данных — информация о транзакциях и их параметрах, текущих котировках и трендах изменения цены и т. д.

д.

Время, которое пройдет от создания заявки на покупку или продажу до получения ответа о ее успешныом выполнеии от биржевого сервера называется раундтрипом (round-trip, RTT). Участники рынка всеми силами стремятся снизить это время, в частности для этого используются технологии прямого доступа на биржу, а серверы с торговым софтом располагаются на колокации рядом с торговым движком бирж.

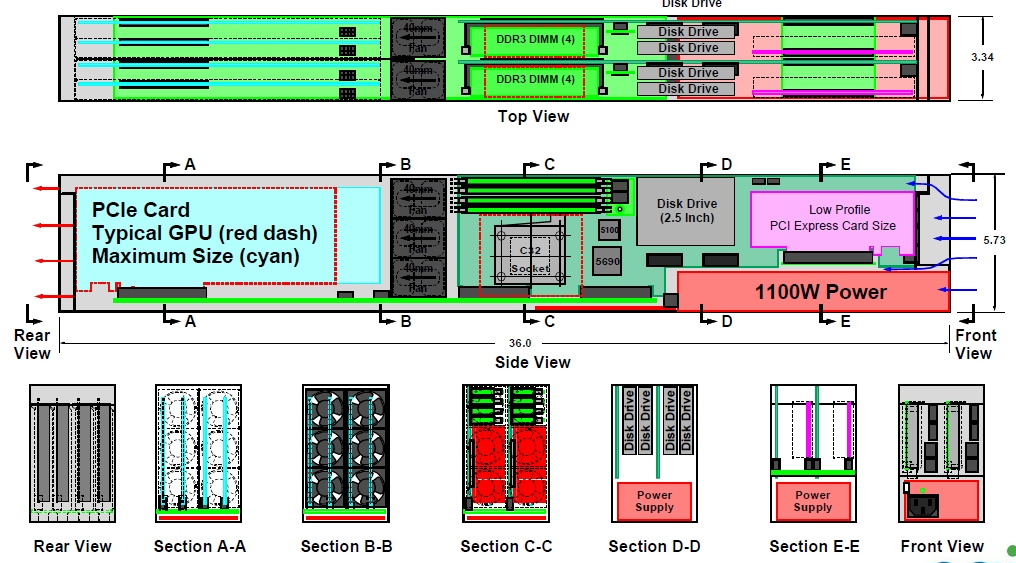

Однако технологические возможности по сокращению раундтрипа ограничены, и после их исчерпания перед трейдерами встает вопрос о том, как еще можно ускорить торговые операции. Для этого применяются новые подходы к построению инфраструктуры для онлайн-трейдинга. В частности используются FPGA и GPU. Об ускорении HFT-трейдинга с помощью «программируемого железа» мы писали ранее, сегодня речь пойдет о том, как для этого можно применять графические процессоры.

Что такое GPU

Архитектура современных графических карт строится на основе масштабируемого массива потоковых мультипроцессоров. Один такой мультипроцессор содержит восемь скалярных процессорных ядер, многопоточный модуль инструкций, разделяемую память, расположенную на чипе (on-chip).

Один такой мультипроцессор содержит восемь скалярных процессорных ядер, многопоточный модуль инструкций, разделяемую память, расположенную на чипе (on-chip).Когда программа на C, использующая расширения CUDA, вызывает ядро GPU, копии этого ядра или потоки, нумеруются и распределяются на доступные мультипроцессоры, где уже начинается их выполнение. Для такой нумерации и распределения сеть ядра подразделяется на блоки, каждый из которых делится на различные потоки. Потоки в таких блоках выполняются одновременно на доступных мультипроцессорах. Для управления большим количеством потоков используется модуль SIMT (single-instruction multiple-thread). Этот модуль группирует их в «пачки» по 32 потока. Такие группы исполняются на том же мультипроцессоре.

Анализ финансовых данных на GPU

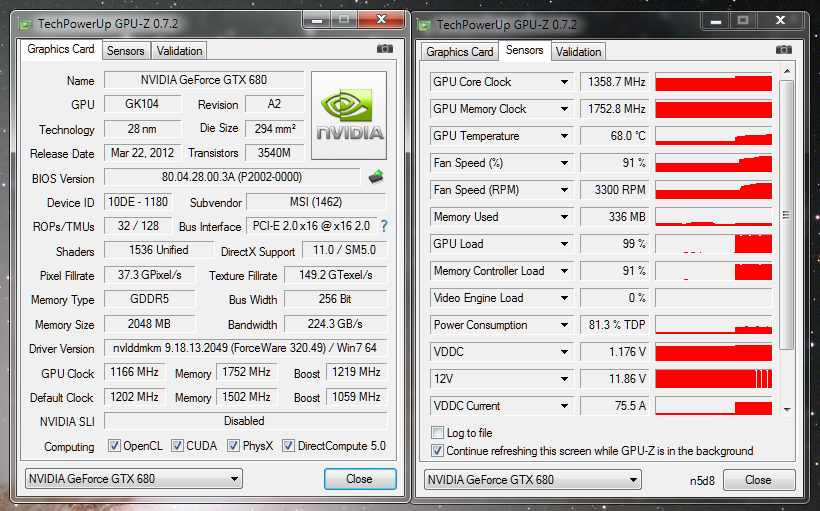

В финансовом анализе применяется множество мер и показателей, расчет которых требует серьезных вычислительных мощностей. Ниже мы перечислим некоторые из них и сравним быстродействие при их обработке, показанное «обычным» процессоромо Intel Core 2 Quad CPU (Q6700) c тактовой частотой 2,66 ГГц и размером кэша 4096 килобайт, а также популярных графических карт.

Экспонента Херста

Мера, называемая экспонентной Херста, используется в анализе временных рядов. Эта величина уменьшается в том случае, если задержка между двумя одинаковыми парами значений во временном ряду увеличивается. Изначально это понятие применялось в гидрологии для определения размеров плотины на реке Нил в условиях непредсказуемых дождей и засух.Впоследствии показатель Херста начали применять в экономике, в частности, в техническом анализе для предсказания трендов движения ценовых рядов. Ниже представлено сравнение быстродействия вычисления показателя Херста на CPU и GPU (показатель «ускорения» β = общее время выисления на CPU / общее время вычисления на GPU GeForce 8800 GT):

Модель Изинга и метод Монте-Карло

Еще одним инструментом, перекочевавшим в сферу финансов на этот раз из физики, является модель Изинга . Эта математическая модель статистической физики предназначена для описания намагничивания материала.Каждой вершине кристаллической решётки (рассматриваются не только трёхмерные, но и одно- и двумерные вариации) сопоставляется число, называемое спином и равное +1 или −1 («поле вверх»/«поле вниз»). N возможных вариантов расположения спинов (где N — число атомов решётки) приписывается энергия, получающаяся из попарного взаимодействия спинов соседних атомов. Далее для заданной температуры рассматривается распределение Гиббса — рассматривается его поведение при большом числе атомов N.

N возможных вариантов расположения спинов (где N — число атомов решётки) приписывается энергия, получающаяся из попарного взаимодействия спинов соседних атомов. Далее для заданной температуры рассматривается распределение Гиббса — рассматривается его поведение при большом числе атомов N.

В некоторых моделях (например, при размерности > 1) наблюдается фазовый переход второго рода. Температура, при которой исчезают магнитные свойства материала, называется критической (точка Кюри). В ее окрестности ряд термодинамических характеристик расходится.

Изначально модель Изинга использовалась для понимания природы ферромагнетизма, однако позднее получила и более широкое распространение. В частности, она применяется для обобщений в социально-экономических системах. Например, обобщение модели Изинга определяет взаимодействие участников финансового рынка. Каждый из них обладает стратегией поведения, рациональность которой может быть ограничена. Решения о том, продавать или покупать акции и по какой цене, зависят от предыдущих решений человека и их результата, а также от действий других участников рынка.

Модель Изинга используется для моделирования взаимодействия между участниками рынка. Для реализации модели Изинга и имитационного моделирования используется метод Монте-Карло, который позволяет построить математическую модель для проекта с неопределенными значениями параметров.

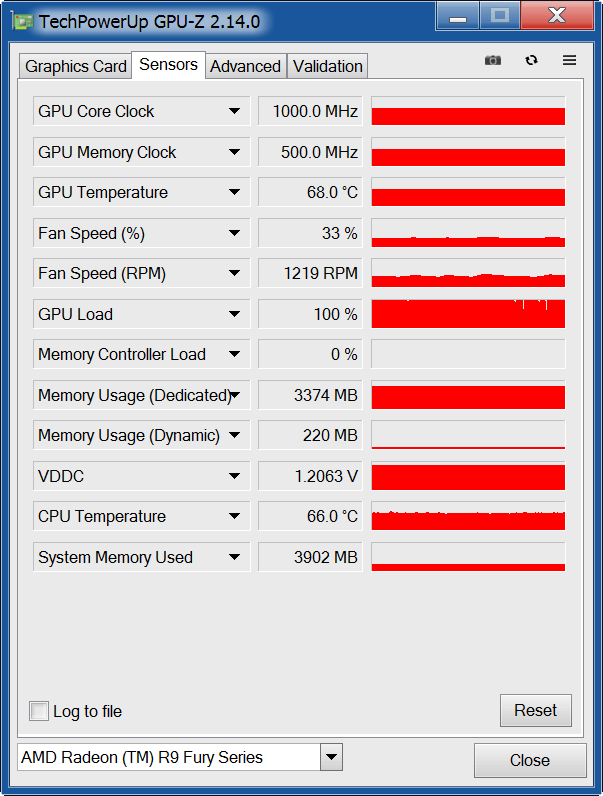

Ниже представлено сравнение быстродействия моделирования на CPU и GPU (NVIDIA GeForce GTX 280):

Существуют реализации модели Изинга с использованием в ходе анализа различного количества спинов. Мультиспиновые реализации позволяет загружать несколько спинов параллельно.

Ускорение с помощью нескольких GPU

Для ускорения обработки данных также используются кластеры GPU-устройств — в данном случае исследователи собрали кластер из двух карточек Tesla C1060 GPU, коммуникация между которыми осуществлялась через Double Data Rate InfiniBand.В случае симуляции модели Изинга методом Монте-Карло результаты говорят о том, что производительность повышается практически линейно при добавлении большего количества GPU.

Заключение

Эксперименты показывают, что использование графических процессоров может приводить к существуенному повышению производительности финансового анализа. При этом выигрыш в скорости по сравнению с использованием архитектуры с CPU может достигать нескольких десятков раз. При этом добиться еще большего повышения производительности можно с помощью создания кластеров GPU — в таком случае она растет практически линейно.В материнской плате расположено много важных составляющих частей компьютера, которые носят свои уникальные названия: CPU, GPU, HDD, SSD, ОЗУ и так далее. Каждая из этих аббревиатур имеет свою расшифровку, но в данный момент имеет значение, что же это — GPU?

Есть схожее название с этим термином — это CPU. Многие неопытные пользователи путают эти названия, что неверно. Для начала стоит пояснить, что CPU — это центральный процессор, который является мозгом всей системы. Расшифровывается эта аббревиатура так — Central Processor Unit.

Однако стоит знать, что GPU — это тоже процессор, только графического решения. В его задачу входит обработка и вывод на экран изображения. Полное название аббревиатуры выглядит таким образом — Graphic Processing Unit.

В его задачу входит обработка и вывод на экран изображения. Полное название аббревиатуры выглядит таким образом — Graphic Processing Unit.

Благодаря этим пояснениям можно понять, что GPU — это не центральный процессор, который обрабатывает только данные графического типа. Он подчиняется протоколам центрального процессора и, в отличие от него, имеет свое логическое устройство. Так же, как и у главного процессора, у графического есть ядра, только их не десятки, а тысячи. Такое большое количество ядер необходимо для получения и обработки данных, связанных с прорисовкой и временными многочисленными задачами.

Теперь, когда уже имеется общее представление о том, что GPU — это графический процессор и его задачей является обработка графических данных, можно перейти к перечислению.

На данный момент есть два вида встроенных графических процессоров — это интегрированные в материнскую плату и встроенные в процессор.

В первом варианте чип графического процессора распаян прямо на текстолите материнской платы, и мало кто знает, что это GPU. Выглядит он как обычный чип черного цвета, на котором есть наименование марки, порядковый номер и комбинация цифр, которая указывает на некоторые параметры. Так как такие графические решения не имеют собственного объема памяти, они заимствуют данный параметр у оперативной памяти, используя ее объем.

Выглядит он как обычный чип черного цвета, на котором есть наименование марки, порядковый номер и комбинация цифр, которая указывает на некоторые параметры. Так как такие графические решения не имеют собственного объема памяти, они заимствуют данный параметр у оперативной памяти, используя ее объем.

В случае со встроенным в процессор чипом его сложно увидеть, получится это только при разборе самого центрального процессора. Практически во всех процессорах нового поколения имеется дополнительное ядро, которое именуется графическим. Цена процессора при этом вырастает не намного, зато избавляет от нужды в дискретной видеокарте.

Встроенные графические процессоры позволяют сэкономить на энергопотреблении на несколько десятков процентов, что положительно сказывается на теплоотдаче. Однако есть и значительные минусы, и один из них — это низкая производительность. Такая экономная графика хорошо подходит для работы с офисными программами и приложениями, не требующими больших мощностей.

GPU в компьютере — что это такое и как его определить? Если ранее было представлено два вида графических процессоров в интегрированном виде, то далее можно рассмотреть вариант дискретной видеокарты. Исходя из этого можно понять, что GPU — это такое обозначение лишь процессора, одной из деталей которого является видеокарта. Однако эта деталь является самой важной. Еще на плате видеокарты расположены чипы памяти, конденсаторы, разъем или разъемы для питания, защитный кожух, радиатор и кулер.

Различие интегрированной и дискретной видеокарты в том, что вторая гораздо мощнее и производительнее, чем встроенный вариант. Во-первых, имеется свой объем памяти, что напрямую влияет на скорость отрисовки объектов. Во-вторых, в ее параметры входит шина расширения, битность которой позволяет увеличить пропускную способность для передачи данных.

Такие графические адаптеры требуют дополнительного питания, чтобы просто запуститься и выдавать качественное изображение. Несмотря на всю мощь, есть и офисные варианты дискретных видеокарт, которые мало чем отличаются от интегрированных собратьев. Игровые варианты более мощные по строению и потенциалу, но потребляют гораздо больше энергии.

Игровые варианты более мощные по строению и потенциалу, но потребляют гораздо больше энергии.

Температурный режим

Для лучшего функционирования нужно знать, что такое GPU в компьютере и его температура. Как охладить встроенный и дискретный GPU? Для охлаждения интегрированного графического процессора достаточно разместить вентиляторы в корпусе, а у дискретных вариантов есть собственная система охлаждения. В зависимости от того, сколько вентиляторов находится над чипом, будет ясно, как хорошо охлаждается чип.

Система охлаждения видеокарты достаточно проста — чип с помощью нанесенной на него термопасты соприкасается с трубками теплоотвода, они переходят к радиатору, который охлаждается с помощью кулера.

Рабочая температура чипа составляет не более 70 градусов, дальнейшее повышение температуры можно считать перегревом. Чтобы не допустить перегрева видеокарты, достаточно своевременно прочищать от пыли видеокарту, менять при этом термопасту. Для того чтобы узнать нынешнее состояние температуры в видеокарте, достаточно запустить соответствующие программы, например, AIDA 64. Там можно увидеть температуру не только графического адаптера, но и всей системы.

Там можно увидеть температуру не только графического адаптера, но и всей системы.

Что такое CUDA – Помощь

В статье мы подробно рассмотрим CUDA — что это за технология, как работает и в каких областях её можно использовать.

Что такое CUDA

CUDA (англ. Compute Unified Device Architecture) — это технология на базе программно-аппаратной архитектуры, которая позволяет повысить производительность параллельных вычислений. Параллельные вычисления — это вычисления, при которых процесс разработки программного обеспечения делится на потоки. Потоки обрабатываются параллельно и взаимодействуют между собой в процессе обработки. Это возможно благодаря процессорам компании NVIDIA, на которых построена работа CUDA. В их основе лежит технология GPGPU.

Прежде чем разобраться, в чём особенность этой технологии, посмотрим, какие бывают типы процессоров и как они работают.

Основные типы процессоров

CPU (англ. Central Processing Unit) — это центральный процессор, который ориентирован на обработку данных в максимально короткие сроки. Работает по следующему принципу: разбивает одну задачу на несколько потоков, каждый из которых обрабатывается отдельно. Затем эти потоки вновь объединяются и выстраиваются в нужном порядке. Такой подход позволяет увеличить скорость последовательной обработки задач. Подробнее читайте в статье Что такое процессор CPU.

Central Processing Unit) — это центральный процессор, который ориентирован на обработку данных в максимально короткие сроки. Работает по следующему принципу: разбивает одну задачу на несколько потоков, каждый из которых обрабатывается отдельно. Затем эти потоки вновь объединяются и выстраиваются в нужном порядке. Такой подход позволяет увеличить скорость последовательной обработки задач. Подробнее читайте в статье Что такое процессор CPU.

GPU (англ. Graphics Processing Unit) — это специальный графический процессор, который заточен на обработку 2D или 3D-графики. Он размещается на видеокарте, что позволяет автоматически освободить основной процессор от лишней нагрузки при обработке данных. GPU состоит из нескольких тысяч ядер, которые в совокупности потребляют небольшое количество энергии. CUDA ядра «выигрывают» у CPU по производительности на 1 ватт потребляемой мощности.

На базе этих основных процессоров были разработаны различные специализированные инструменты. Например, технология GPGPU.

Например, технология GPGPU.

GPGPU (англ. General-purpose computing on graphics processing units) — это технология, которая позволяет использовать графический процессор GPU в операциях, которые обычно выполняет центральный процессор CPU. Например, в математических вычислениях. С помощью GPGPU можно использовать видеокарту для выполнения неграфических вычислений. При этом графический процессор будет работать не вместо центрального, а в качестве вычислительного блока.

CUDA является улучшенной вариацией GPGPU. Она позволяет работать на специальном диалекте — это значит, что программисты могут использовать алгоритмы, предназначенные для графических процессоров при обработке неспецифических задач. С помощью CUDA можно значимо ускорить процессы обработки. Например, можно сократить время ожидания конвертации видео до 20 раз, не задействуя основной процессор.

В каких областях можно использовать CUDA:

- вычислительная математика,

- физика,

- молекулярная биология,

- биоинформатика,

- финансовая аналитика,

- анализ баз данных,

- искусственный интеллект и другие.

В последнее время технология высокоскоростной обработки становится ближе к рядовому пользователю. Например, уже существуют плагины для Photoshop, которые используют мощности GPU. С другими программами и проектами можно познакомиться на официальном сайте.

История возникновения

Первые попытки использовать графические ускорители для нецелевых вычислений предпринимались еще с конца 90-х годов. Однако масштабная работа в этом направлении началась немного позже. В начале 2000-х годов два основных лидера в мире процессоров — компании AMD и Intel – решили побороться за производство самого мощного «мозга» компьютера. В период жесткой конкуренции производителям удалось значимо поднять планку обработки процессорами тактовых частот (например, в промежуток между 2001-м и 2003-м годом частоты подросли с 1,5 до 3 ГГц).

Вместе с этим разработчики из Стенфордского университета поставили перед собой конкретную цель — создать графический адаптер, который позволит проводить неграфические вычисления. Так появился Brook — специализированный язык программирования и реализации. Затем были запущены аналогичные проекты: библиотека Accelerator, Brahma, GPU++ и другие.

Так появился Brook — специализированный язык программирования и реализации. Затем были запущены аналогичные проекты: библиотека Accelerator, Brahma, GPU++ и другие.

Немногим позже к исследовательской работе присоединился лидер индустрии NVIDIA. Компания решила разработать собственные программные платформы и видеокарты для неграфических вычислений. Так появилась CUDA.

NVIDIA СUDA toolkit

Архитектура

Архитектура CUDA базируется на взаимодействии между CPU и GPU процессорами. Это возможно благодаря работе шейдера — программы для исполнения видеокарты процессорами.

Взаимодействие происходит с помощью разноуровневых API. API на первом уровне — Runtime. Он позволяет сделать первичную разбивку задачи на потоки. Затем эти декомпозированные потоки переходят на второй уровень API — Driver. При этом работу API поддерживают библиотеки NVIDIA — Libraries CUBLAS (для алгебраических расчётов) и FFT (расчёт по алгоритму ускоренного вычисления Фурье).

Если говорить максимально упрощенно, то работа алгоритма CUDA выглядит следующим образом:

- Центральный процессор выделяет нужное количество памяти и отправляет её графическому процессору.

- Центральный процессор запускает ядро и также «делится» им с графическим.

- Графический процессор выполняет операции используя память и мощности ядра.

- После обработки данных центральный процессор принимает результаты.

Взаимодействие CPU и GPU

Характеристики и среда разработки CUDA:

- компилятор nvcc,

- отладчик gdb для GPU,

- профилировщик,

- библиотеки численного анализа FFT и BLAS,

- поддержка 32- и 64-битных операционных систем: Linux, macOS, Windows XP, Vista и других,

- поддержка языков программирования: Java, Python, C++, Си, Фортран и других.

Недостатки и преимущества CUDA

CUDA имеет преимущества не только перед вычислениями на CPU, но и перед более ранними технологиями вычисления с помощью GPGPU. Рассмотрим, в чём они заключаются.

Преимущества

- Простой в применении интерфейс программирования на С,

- поддержка CUDA: битовые и целочисленные операции проводятся на аппаратном уровне, не требуя переноса алгоритмов в удобный для концепции графического конвейера вид,

- не ограничена графическими API,

- адресация памяти gather и scatter в линейном порядке,

- эффективный взаимообмен между видеопамятью и системной памятью,

- память размером 16 Кб на мультипроцессор: её можно разделить на потоки и настроить кеш с широкой полосой пропускания.

Как любая технология, CUDA имеет нюансы применения и ограничения.

Ограничения

- CUDA имеет архитектуру с закрытым исходным кодом, которым владеет NVIDIA,

- архитектура работает только на видеочипах компании NVIDIA, начиная с версии GeForce 8,

- для выполняемых функций нет поддержки рекурсии,

- 32 потока — минимально возможная ширина блока.

Несмотря на все достоинства этой технологии, нельзя сказать, что параллельные вычисления полностью заменят классические. Современный центральный процессор заточен под обработку целочисленных данных и данных с плавающей запятой в максимально короткие сроки. В то же время архитектура видеокарты позволяет быстро и без проблем «распараллелить» обработку данных. Поэтому CUDA — это скорее эффективный и необходимый инструментарий для конкретных областей применения.