Почему для анализа финансовых данных применяют графические процессоры

Все мы знаем, что у видеокарты и процессора несколько различные задачи, однако знаете ли вы, чем они отличаются друг от друга во внутренней структуре? Как CPU (англ. — central processing unit ), так и GPU (англ. — graphics processing unit ) являются процессорами, и между ними есть много общего, однако сконструированы они были для выполнения различных задач. Подробнее об этом вы узнаете из данной статьи.

CPU

Основная задача CPU, если говорить простыми словами, это выполнение цепочки инструкций за максимально короткое время. CPU спроектирован таким образом, чтобы выполнять несколько таких цепочек одновременно или разбивать один поток инструкций на несколько и, после выполнения их по отдельности, сливать их снова в одну, в правильном порядке. Каждая инструкция в потоке зависит от следующих за ней, и именно поэтому в CPU так мало исполнительных блоков, а весь упор делается на скорость выполнения и уменьшение простоев, что достигается при помощи кэш-памяти и конвейера .

GPU

Основная функция GPU — рендеринг 3D графики и визуальных эффектов, следовательно, в нем все немного проще: ему необходимо получить на входе полигоны, а после проведения над ними необходимых математических и логических операций, на выходе выдать координаты пикселей. По сути, работа GPU сводится к оперированию над огромным количеством независимых между собой задач, следовательно, он содержит большой объем памяти, но не такой быстрой, как в CPU, и огромное количество исполнительных блоков: в современных GPU их 2048 и более, в то время как у CPU их количество может достигать 48, но чаще всего их количество лежит в диапазоне 2-8.

Основные отличия

CPU отличается от GPU в первую очередь способами доступа к памяти. В GPU он связанный и легко предсказуемый — если из памяти читается тексел текстуры, то через некоторое время настанет очередь и соседних текселов. С записью похожая ситуация — пиксель записывается во фреймбуфер, и через несколько тактов будет записываться расположенный рядом с ним. Также графическому процессору, в отличие от универсальных процессоров, просто не нужна кэш-память большого размера, а для текстур требуются лишь 128–256 килобайт. Кроме того, на видеокартах применяется более быстрая память, и в результате GPU доступна в разы большая пропускная способность, что также весьма важно для параллельных расчетов, оперирующих с огромными потоками данных.

Также графическому процессору, в отличие от универсальных процессоров, просто не нужна кэш-память большого размера, а для текстур требуются лишь 128–256 килобайт. Кроме того, на видеокартах применяется более быстрая память, и в результате GPU доступна в разы большая пропускная способность, что также весьма важно для параллельных расчетов, оперирующих с огромными потоками данных.

Есть множество различий и в поддержке многопоточности: CPU исполняет 1– 2 потока вычислений на одно процессорное ядро, а GPU может поддерживать несколько тысяч потоков на каждый мультипроцессор, которых в чипе несколько штук! И если переключение с одного потока на другой для CPU стоит сотни тактов, то GPU переключает несколько потоков за один такт.

В CPU большая часть площади чипа занята под буферы команд, аппаратное предсказание ветвления и огромные объемы кэш-памяти, а в GPU большая часть площади занята исполнительными блоками. Вышеописанное устройство схематично изображено ниже:

Разница в скорости вычислений

Если CPU — это своего рода «начальник», принимающий решения в соответствии с указаниями программы, то GPU — это «рабочий», который производит огромное количество однотипных вычислений. Выходит, что если подавать на GPU независимые простейшие математические задачи, то он справится значительно быстрее, чем центральный процессор. Данным отличием успешно пользуются майнеры биткоинов.

Выходит, что если подавать на GPU независимые простейшие математические задачи, то он справится значительно быстрее, чем центральный процессор. Данным отличием успешно пользуются майнеры биткоинов.

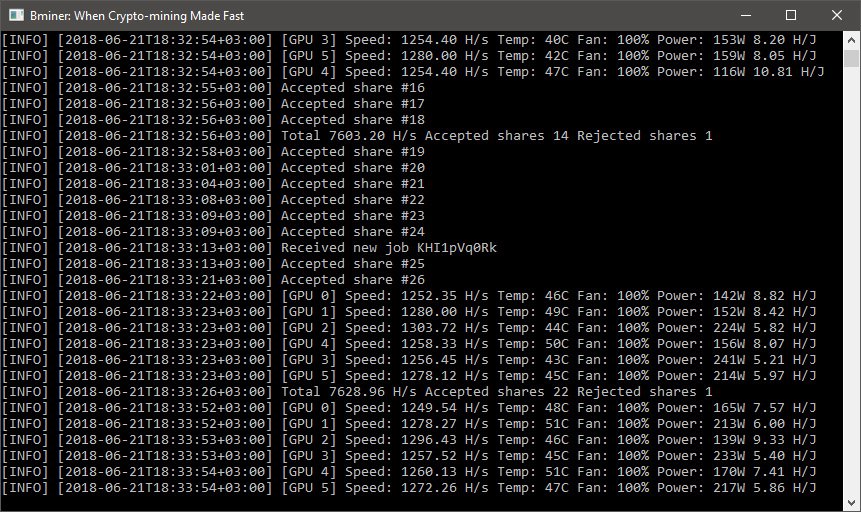

Майнинг Bitcoin

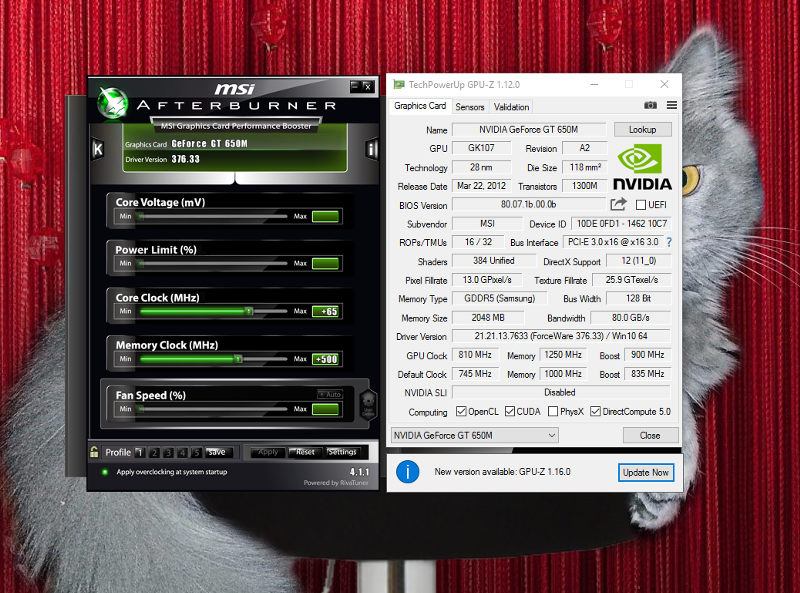

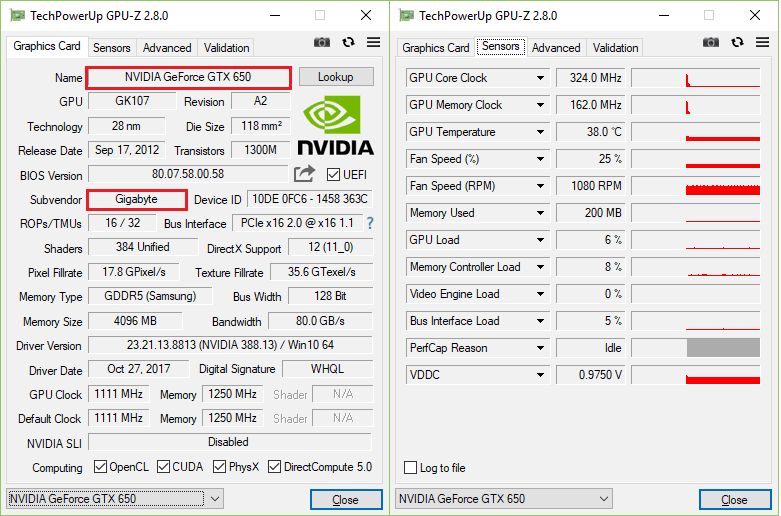

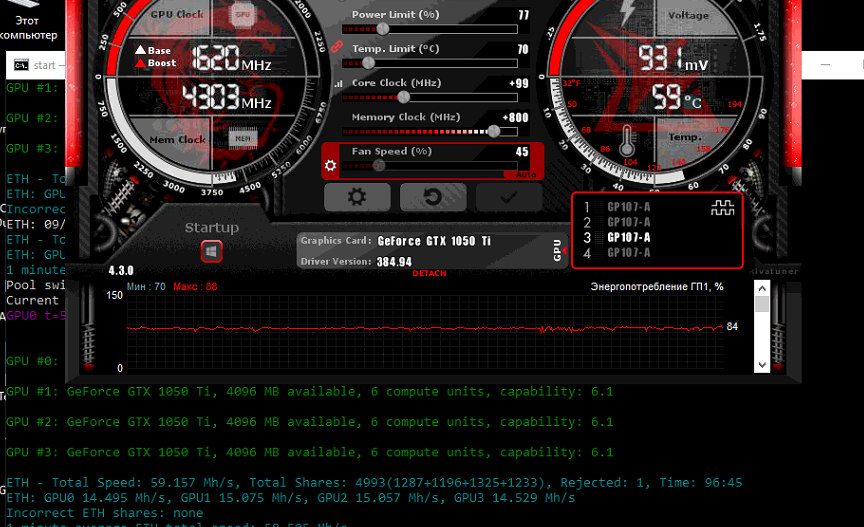

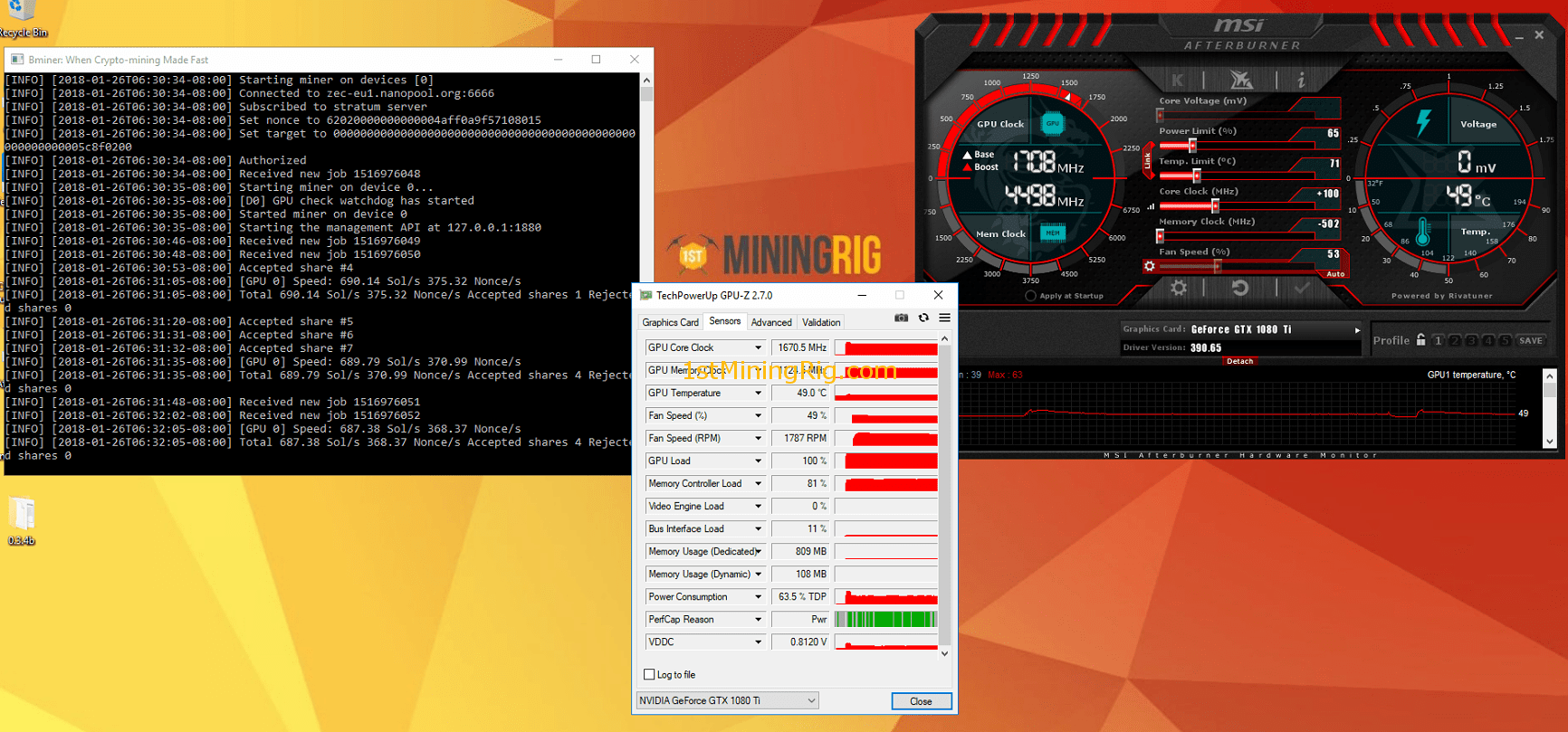

Суть майнинга заключается в том, что компьютеры, находящиеся в разных точках Земли, решают математические задачи, в результате которых создаются биткоины . Все биткоин-переводы по цепочке передаются майнерам, чья работа состоит в том, чтобы подобрать из миллионов комбинаций один-единственный хэш, подходящий ко всем новым транзакциям и секретному ключу, который и обеспечит майнеру получение награды в 25 биткоинов за раз. Так как скорость вычисления напрямую зависит от количества исполнительных блоков, получается, что GPU значительно лучше подходят для выполнения данного типа задачи, нежели CPU. Чем больше количество произведенных вычислений, тем выше шанс получить биткоины. Дело даже дошло до сооружения целых ферм из видеокарт.

Немецкого исследователя об использовании вычислений GPU в эконофизике и статистической физике, в том числе для осуществления анализа информации на фондовом рынке. Мы представляем вашему вниманию основные тезисы этого материала.

Мы представляем вашему вниманию основные тезисы этого материала.

Примечание: Статья в журнале датирована 2011 годом, с тех пор появились новые модели GPU-устройств, однако общие подходы к использованию этого инструмента в инфраструктуре для онлайн-трейдинга остались неизменными

Требования к вычислительным мощностям растут в различных сферах. Одна из них — финансовый анализ, который необходим для успешной торговли на фондовом рынке, особенно средствами HFT. Для того, чтобы принять решение о покупке или продаже акций, алгоритм должен проанализировать серьезный объём входных данных — информация о транзакциях и их параметрах, текущих котировках и трендах изменения цены и т.д.

Время, которое пройдет от создания заявки на покупку или продажу до получения ответа о ее успешныом выполнеии от биржевого сервера называется раундтрипом (round-trip, RTT). Участники рынка всеми силами стремятся снизить это время, в частности для этого используются технологии прямого доступа на биржу, а серверы с торговым софтом располагаются на колокации рядом с торговым движком бирж.

Однако технологические возможности по сокращению раундтрипа ограничены, и после их исчерпания перед трейдерами встает вопрос о том, как еще можно ускорить торговые операции. Для этого применяются новые подходы к построению инфраструктуры для онлайн-трейдинга. В частности используются FPGA и GPU. Об ускорении HFT-трейдинга с помощью «программируемого железа» мы писали ранее, сегодня речь пойдет о том, как для этого можно применять графические процессоры.

Что такое GPU

Архитектура современных графических карт строится на основе масштабируемого массива потоковых мультипроцессоров. Один такой мультипроцессор содержит восемь скалярных процессорных ядер, многопоточный модуль инструкций, разделяемую память, расположенную на чипе (on-chip).Когда программа на C, использующая расширения CUDA, вызывает ядро GPU, копии этого ядра или потоки, нумеруются и распределяются на доступные мультипроцессоры, где уже начинается их выполнение. Для такой нумерации и распределения сеть ядра подразделяется на блоки, каждый из которых делится на различные потоки.

Анализ финансовых данных на GPU

В финансовом анализе применяется множество мер и показателей, расчет которых требует серьезных вычислительных мощностей. Ниже мы перечислим некоторые из них и сравним быстродействие при их обработке, показанное «обычным» процессоромо Intel Core 2 Quad CPU (Q6700) c тактовой частотой 2,66 ГГц и размером кэша 4096 килобайт, а также популярных графических карт.Экспонента Херста

Мера, называемая экспонентной Херста, используется в анализе временных рядов. Эта величина уменьшается в том случае, если задержка между двумя одинаковыми парами значений во временном ряду увеличивается. Изначально это понятие применялось в гидрологии для определения размеров плотины на реке Нил в условиях непредсказуемых дождей и засух.

В некоторых моделях (например, при размерности > 1) наблюдается фазовый переход второго рода. Температура, при которой исчезают магнитные свойства материала, называется критической (точка Кюри). В ее окрестности ряд термодинамических характеристик расходится.

Изначально модель Изинга использовалась для понимания природы ферромагнетизма, однако позднее получила и более широкое распространение. В частности, она применяется для обобщений в социально-экономических системах. Например, обобщение модели Изинга определяет взаимодействие участников финансового рынка. Каждый из них обладает стратегией поведения, рациональность которой может быть ограничена. Решения о том, продавать или покупать акции и по какой цене, зависят от предыдущих решений человека и их результата, а также от действий других участников рынка.

Модель Изинга используется для моделирования взаимодействия между участниками рынка. Для реализации модели Изинга и имитационного моделирования используется метод Монте-Карло, который позволяет построить математическую модель для проекта с неопределенными значениями параметров.

Ниже представлено сравнение быстродействия моделирования на CPU и GPU (NVIDIA GeForce GTX 280):

Существуют реализации модели Изинга с использованием в ходе анализа различного количества спинов. Мультиспиновые реализации позволяет загружать несколько спинов параллельно.

Ускорение с помощью нескольких GPU

Для ускорения обработки данных также используются кластеры GPU-устройств — в данном случае исследователи собрали кластер из двух карточек Tesla C1060 GPU, коммуникация между которыми осуществлялась через Double Data Rate InfiniBand.В случае симуляции модели Изинга методом Монте-Карло результаты говорят о том, что производительность повышается практически линейно при добавлении большего количества GPU.

Заключение

Эксперименты показывают, что использование графических процессоров может приводить к существуенному повышению производительности финансового анализа. При этом выигрыш в скорости по сравнению с использованием архитектуры с CPU может достигать нескольких десятков раз. При этом добиться еще большего повышения производительности можно с помощью создания кластеров GPU — в таком случае она растет практически линейно.Привет, друзья.

Вы любите поиграть в реалистичные игры на компе? Или посмотреть фильм в качестве, при котором четко видно каждую мелочь? Значит, вы должны представлять, что такое gpu в компьютере. Ничего о нем не знаете? Моя статья поможет вам избавиться от этого недоразумения;-).

GPU — это не видеокарта

Неизвестное для многих сочетание букв подразумевает под собой понятие «graphics processing unit», что на нашем языке означает графический процессор. Именно он отвечает за воспроизведение картинки на вашем железе, и чем лучше его характеристики, тем качественнее будет изображение.

Всегда считали, что эти функции выполняет ? Вы, конечно, правы, но она является комплексным устройством, и главным ее компонентом выступает как раз графический проц. Он может существовать и автономно от видюхи. Об этом поговорим немного позже.

GPU: не путать с CPU

Несмотря на сходство аббревиатур, не путайте предмет нашего разговора с (Central Processor Unit). Да, они похожи, как в названии, так и в функциях. Последний тоже может воспроизводить графику, правда, слабее в этом деле. Все же это абсолютно разные устройства.

Они отличаются архитектурой. CPU является многоцелевым девайсом, который отвечает за все процессы в компьютере. Для этого ему хватает нескольких , с помощью которых он последовательно обрабатывает одну задачу за другой.

В свою очередь, GPU изначально разработан как специализированное устройство, предназначенное для выполнение графического рендеринга, с высокой скоростью обрабатывающее текстуры и сложные изображения. Для таких целей его оснастили многопоточной структурой и множеством ядер, чтобы он работал с большими массивами информации единовременно, а не последовательно.

Для таких целей его оснастили многопоточной структурой и множеством ядер, чтобы он работал с большими массивами информации единовременно, а не последовательно.

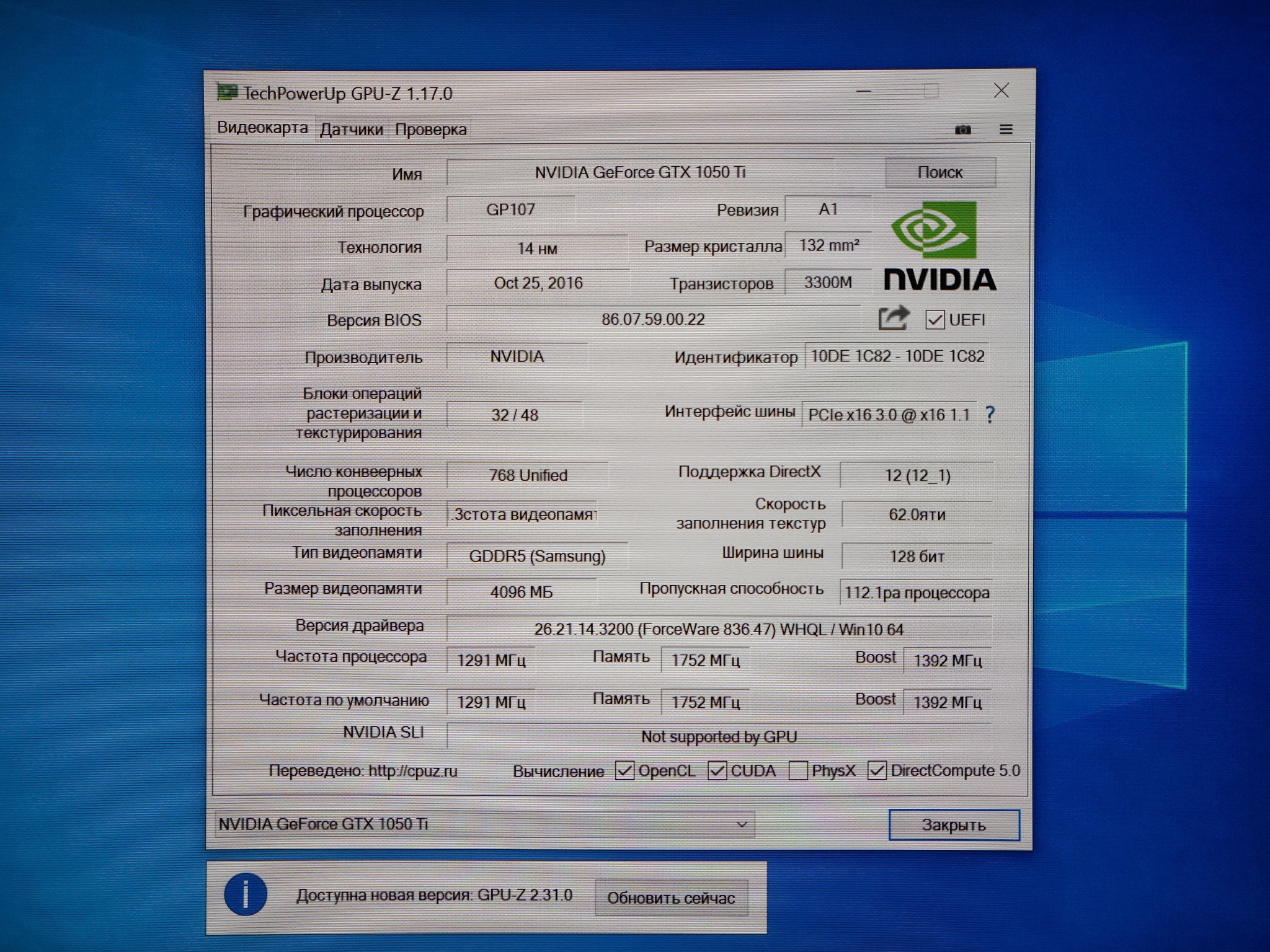

В виду этого преимущества, лидеры среди производителей видеоадаптеров выпустили модели, в которых графические процессоры могут стать усовершенствованной заменой центральным. У бренда nVidia такой девайс называется GTX 10xx, а у его главного конкурента AMD — RX.

Виды графических процев

Чтобы вы могли ориентироваться на рынке GPU, предлагаю ознакомиться с видами этого устройства:

- Интегрированный (IGP). Раньше впаивался в материнскую плату, теперь встраивается в центральный процессор. Изначально не годился для воспроизведения реалистичных игр и тяжелых графических программ, однако новые модели справляются с этими задачами. Все же учтите, что такие чипы несколько медлительнее, потому что не имеют личной оперативки и обращаются к памяти CPU.

- Гибридная графическая обработка.

Это 2 в 1, то есть когда в компьютере устанавливается и первый вид, и второй вид GPU. В зависимости от выполняемых задач, включается в работу или один, или другой. Однако бывают ноутбуки, в которых могут работать сразу 2 вида устройств.

Это 2 в 1, то есть когда в компьютере устанавливается и первый вид, и второй вид GPU. В зависимости от выполняемых задач, включается в работу или один, или другой. Однако бывают ноутбуки, в которых могут работать сразу 2 вида устройств. - Внешний тип. Как несложно догадаться, это графический процессор, расположенный снаружи компа. Чаще всего такую модель выбирают обладатели ноутбуков, которым сложно впихнуть в свое железо дискретную видеокарту, но очень хочется получить достойную графику.

Как выбирать?

Когда будете подбирать для себя видеоадаптер, обращайте внимание на такие характеристики:

- Тактовая частота. Указывается в мегагерцах. Чем цифра выше, тем больше информации за секунду сможет обработать устройство. Правда, не только она влияет на его результативность. Архитектура также имеет значение.

- Число вычислительных блоков. Они призваны обрабатывать задачи — шейдеры, отвечающие за вершинные, геометрические, пиксельные и универсальные расчеты.

- Быстрота заполнения (филлрейт). Этот параметр может рассказать, с какой скоростью GPU может вырисовывать картинку. Он делится на 2 вида: пиксельный (pixel fill rate) и текстурный (texel rate). На первый влияет количество ROP-блоков в структуре проца, а на второй — текстурных (TMU).

Обычно в последних моделях GPU первых блоков меньше. Они записывают рассчитанные видеоадаптером пиксели в буферы и смешивают их, что по-умному называется блендинг. TMU выполняют выборку и фильтрацию текстур и другой информации, требуемой для выстраивания сцены и общих расчетов.

Геометрические блоки

Раньше на них никто не обращал внимания, потому что виртуальные игры имели простую геометрию. Этот параметр стали учитывать после появления в DirectX 11 тесселяции. Не понимаете, о чем я? Давайте по порядку.

Является средой (набором инструментов) для написания игр. Чтобы вы ориентировались в теме, скажу, что последняя версия продукта — 12-я, которая вышла в 2015 году.

Тесселяция — это деление плоскости на части для заполнения их новой информацией, что повышает реализм игры.

Таким образом, если вы захотите с головой окунуться в атмосферу Metro 2033, Crysis 2, HAWX 2 и т. п., при выборе GPU учитывайте количество геометрических блоков.

Память

Собрались брать новую видеокарту? Значит, вам нужно учесть еще несколько характеристик оперативки:

- Объем. Важность RAM несколько переоценена, так как не только ее емкость, но также тип и свойства влияют на производительность карты.

- Ширина шины. Это более весомый параметр. Чем шире, тем больше информации сможет отправить память чипу и наоборот за определенное время. Для воспроизведения игр необходимо минимум 128 бит.

- Частота. Тоже определяет пропускную способность оперативки. Но учтите, что память с 256-битной шиной и частотой 800(3200) МГц работает продуктивнее, чем со 128 битами на 1000(4000) МГц.

- Тип.

Не буду грузить вас лишней информацией, а лишь назову оптимальные на сегодня типы — это GDDR 3 и 5 поколения.

Не буду грузить вас лишней информацией, а лишь назову оптимальные на сегодня типы — это GDDR 3 и 5 поколения.

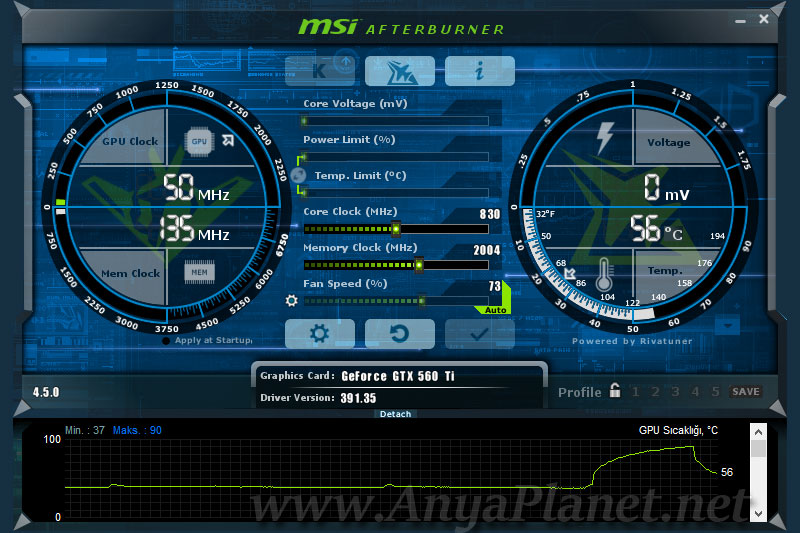

Немного об охлаждении

Задумали установить мощный чип? Сразу позаботьтесь о дополнительном охлаждении в виде радиаторов, кулеров, а если собираетесь регулярно выжимать из девайса все соки, можно подумать и над жидкостной системой.

В целом, следите за температурой видюхи. Помочь в этом вам может программа GPU-Z и т. п., которая помимо этого параметра расскажет все об устройстве.

Конечно, современные видеокарты оснащаются защитной системой, которая вроде бы не допускает перегрева. Для разных моделей предельная температура отличается. В среднем, она составляет 105 °C, после чего адаптер сам выключается. Но лучше поберечь дорогой девайс и обеспечить вспомогательное охлаждение.

Привет ребята. Сегодня мы будем говорить про GPU Speed — я расскажу простыми словами что это. Ну для начала разберем само название, GPU это графический процессор или по-простому видеокарта ваша, кстати расшифровывается как Graphics Processing Unit. Второе слово это Speed и оно означает скорость. Какой вывод? GPU Speed означает скорость видеокарты.

Второе слово это Speed и оно означает скорость. Какой вывод? GPU Speed означает скорость видеокарты.

Но что означает скорость видеокарты? Вот и я подумал.. скорость, как бы такого понятия нет. Есть частота видюхи, то есть графического процессора. И чем выше эта частота, тем соответственно быстрее работает видюха.

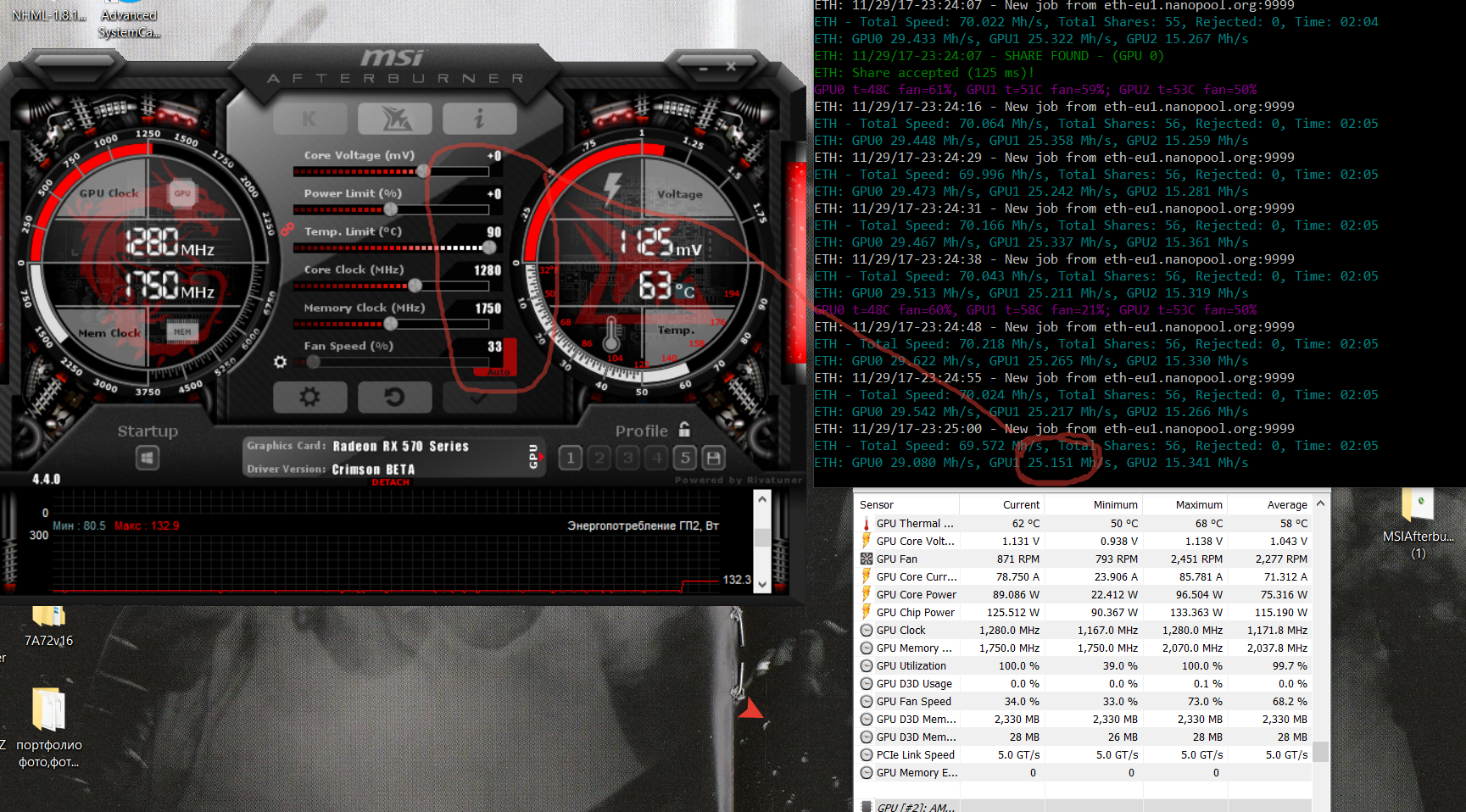

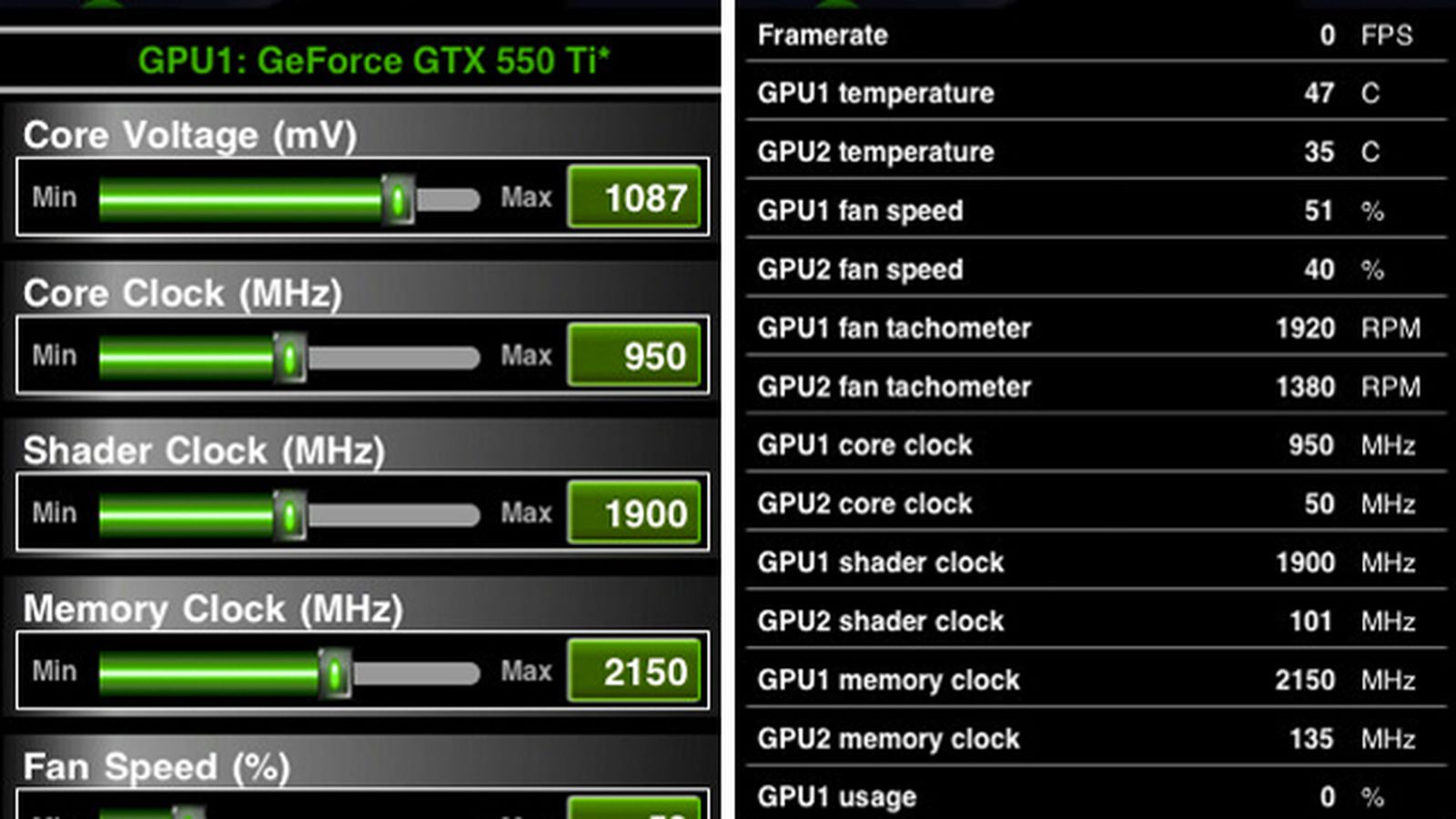

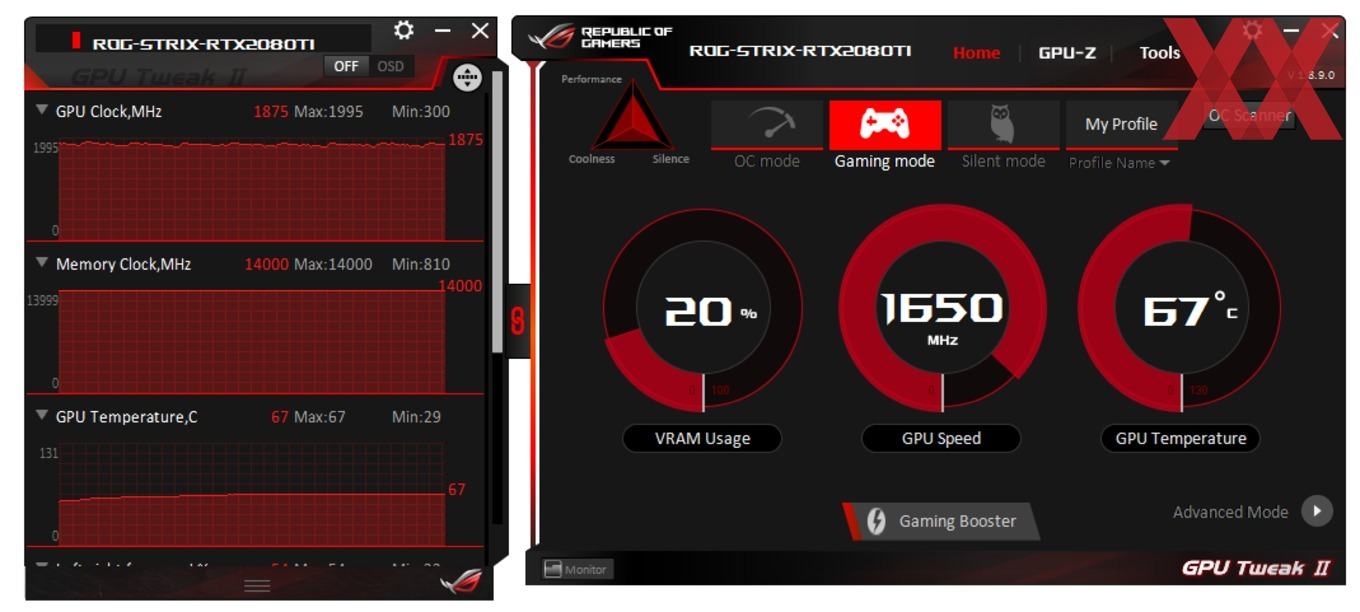

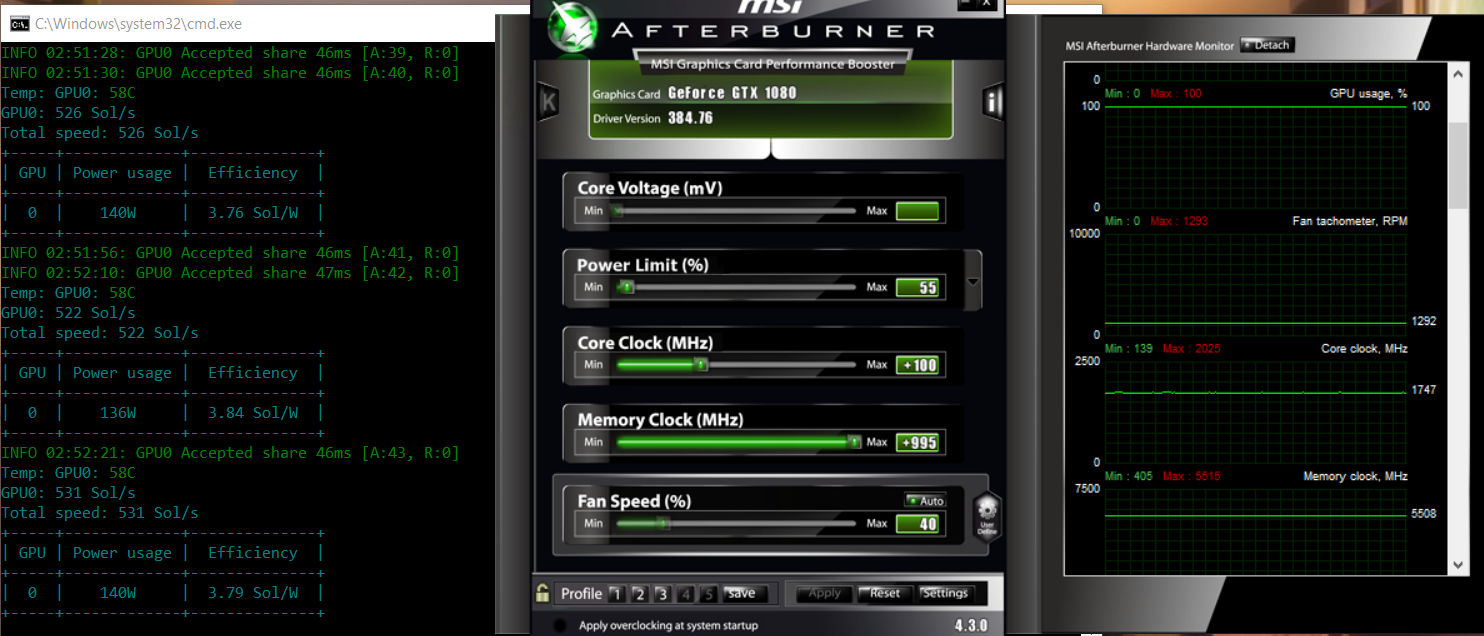

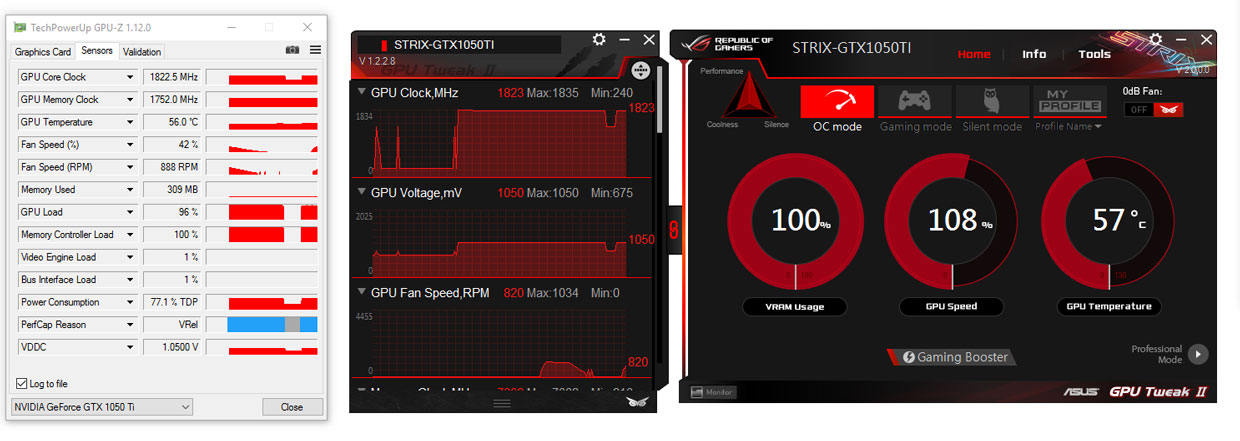

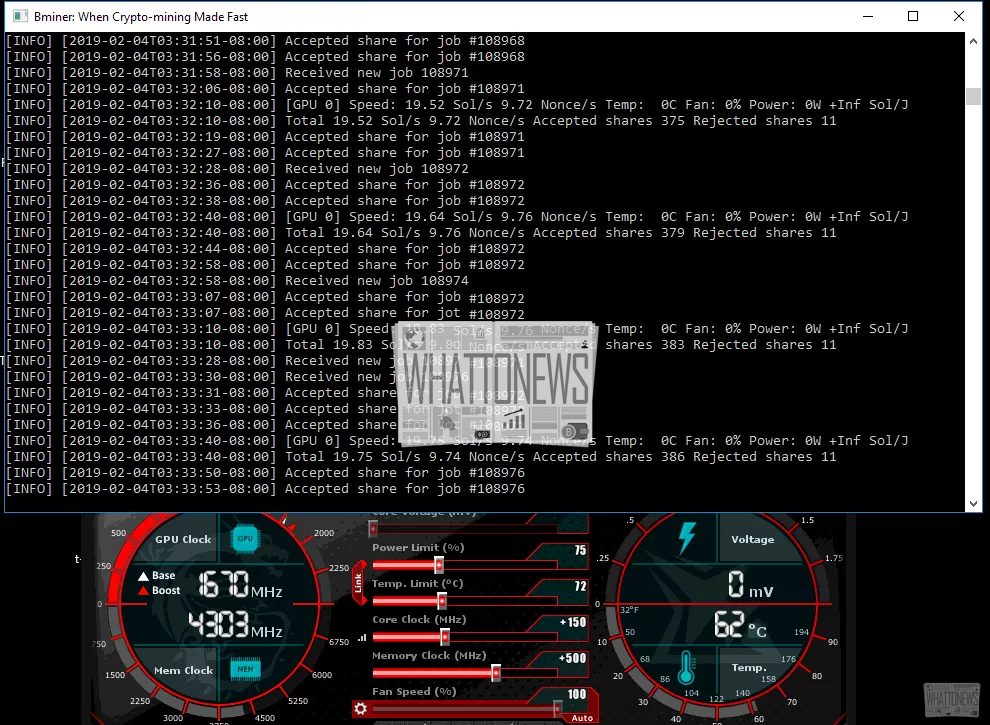

Я пошел в интернет чтобы немного прояснить эту ситуацию и.. вот что узнал, смотрите, вот нашел такую картинку:

На картинке фирменная прога от Asus, это GPU Tweak II. И я так понимаю что прога позволяет переключать режимы видюхи. И вот смотрите, на картинке написано 122%, верно? Что это означает? А означает то, что видюха работает на 22% производительнее чем обычно. То есть некий такой разгончик себе. И справа сразу мы видим температуру, чтобы смотреть как там дела, ведь при разгоне температура повышается все таки.

То есть первый реальный случай где может быть GPU Speed — это фирменная прога по настройке видюхи, обычно в ней идут всякие режимы, там игровой, офисный, тихий режим, и может еще какие-то. И вроде даже можно создать собственный режим.

И вроде даже можно создать собственный режим.

Вот я нашел еще одну картинку, тут все таже прога, но уже 137% стоит:

И вверху видите выбран режим Gaming Mode, то есть игровой режим.

GPU Speed 100 — это нормально?

Значит ребята, в интернете видел сообщения некоторых, они спрашивают GPU Speed 100 это нормально или нет? Ну тут вопрос не совсем ясный мне, да и должен признаться я не особо разбираюсь в видеокартах.. Но есть серьезная причина, по которой я решил написать.

Значит смотрите, при простое видеокарта также может скидывать частоту как это умеет делать процессор? Я посмотрел в интернете — вроде умеет. Но что это значит, когда видеокарта в простое загружена на все 100 процентов? А тут ребята не все так просто. Я могу ошибаться, но не так много есть программ, которые нагружают именно видеокарту, а не как обычно процессор. То есть если проге нужна мощь, то обычно она берет себе процессор, верно? Но не видеокарту, я конечно не имею ввиду игры.. если игра грузит видюху, то я думаю это нормально как бэ. Но знаете к чему я клоню? Да вот к тому, что может быть это.. майнер. Есть такие вирусы, которые используют мощь видюхи в своих целях. Некоторые это делают нагло и поэтому это сразу заметно, а некоторые используют чучуть только производительности и делают так, чтобы это было незаметно..

Но знаете к чему я клоню? Да вот к тому, что может быть это.. майнер. Есть такие вирусы, которые используют мощь видюхи в своих целях. Некоторые это делают нагло и поэтому это сразу заметно, а некоторые используют чучуть только производительности и делают так, чтобы это было незаметно..

Еще раз — то есть вирус использует не процессор, как это делают большинство и вирусов и обычных программ, а в первую очередь именно видюху. Или вернее графический процессор. Таким образом они майнят там что-то, типа биткоины какие-то добывают, зарабатывают что ли, непонятно. Можете поискать в интернете про майнеры, такие вирусы как бы не редкость, в интернете куча сообщений о том что какой-то процесс грузит без причины так комп.

В общем если видеокарта загружена на 100 процентов в простое, то первым делом я бы проверил комп на вирусы. Для этого я советую вам использовать утилиту Dr.Web CureIt!, ее скачать можно вот тут (это офф сайт):

Кстати вот я могу ошибаться.. но смотрите на картинку:

Видите, там где GPU Speed, то там 100%, а вот там где VRAM Usage, то там 1%. Повторюсь, что я не особо понимаю в видеокартах, но мне кажется что это странная ситуация, когда графический процессор нагружен на все 100%, а вот видеопамять (это VRAM Usage) вообще не используется.. Вот это ситуация как мне кажется подозрительная.

Повторюсь, что я не особо понимаю в видеокартах, но мне кажется что это странная ситуация, когда графический процессор нагружен на все 100%, а вот видеопамять (это VRAM Usage) вообще не используется.. Вот это ситуация как мне кажется подозрительная.

Fan Speed GPU это что?

Fan Speed означает скорость вентилятора, это относится к охлаждению. И если в Fan Speed GPU показываются проценты, то это означает на сколько работает система охлаждения видеокарты. Просто могут быть не проценты а RPM — это количество оборотов вентилятора. Вот например прога от AMD Radeon Settings и тут есть такой вот показатель, правда просто Fan Speed, без GPU, в общем смотрите:

А вот прога снова GPU Tweak II и тут есть Fan Speed и как я понимаю можно регулировать в процентах:

Вот такие дела ребята, надеюсь что инфа была вам полезна, ну а если что не так, то извините! Удачи вам и пусть у вас все будет хорошо!

Процессоры и графические ускорители очень похожи, они оба сделаны из сотен миллионов транзисторов и могут обрабатывать тысячи операций за секунду. Но чем именно отличаются эти два важных компонента любого домашнего компьютера?

Но чем именно отличаются эти два важных компонента любого домашнего компьютера?

В данной статье мы попытаемся очень просто и доступно рассказать, в чем отличие CPU от GPU. Но сначала нужно рассмотреть два этих процессора по отдельности.

CPU (Central Processing Unit или же Центральное Процессорное Устройство) часто называют «мозгом» компьютера. Внутри центрального процессора расположено около миллиона транзисторов, с помощью которых производятся различные вычисления. В домашних компьютерах обычно устанавливаются процессоры, имеющие от 1 до 4 ядер с тактовой частотой приблизительно от 1 ГГц до 4 ГГц.

Процессор является мощным, потому что может делать все. Компьютер способен выполнить какую-либо задачу, так как процессор способен выполнить эту задачу. Программистам удалось достичь этого благодаря широким наборам инструкций и огромным спискам функций, совместно используемых в современных центральных процессорах.

Что такое GPU?

GPU (Graphics Processing Unit или же Графическое Процессорное Устройство) представляет собой специализированный тип микропроцессора, оптимизированный для очень специфических вычислений и отображения графики. Графический процессор работает на более низкой тактовой частоте в отличие от процессора, но имеет намного больше процессорных ядер.

Графический процессор работает на более низкой тактовой частоте в отличие от процессора, но имеет намного больше процессорных ядер.

Также можно сказать, что GPU — это специализированный CPU, сделанный для одной конкретной цели — рендеринг видео. Во время рендеринга графический процессор огромное количество раз выполняет несложные математические вычисления. GPU имеет тысячи ядер, которые будут работать одновременно. Хоть и каждое ядро графического процессора медленнее ядра центрального процессора, это все равно эффективнее для выполнения простых математических вычислений, необходимых для отображения графики. Этот массивный параллелизм является тем, что делает GPU способным к рендерингу сложной 3D графики, требуемой современными играми.

Отличие CPU и GPU

Графический процессор может выполнить лишь часть операций, которые может выполнить центральный процессор, но он делает это с невероятной скоростью. GPU будет использовать сотни ядер, чтобы выполнить срочные вычисления для тысяч пикселей и отобразить при этом сложную 3D графику. Но для достижения высоких скоростей GPU должен выполнять однообразные операции.

Но для достижения высоких скоростей GPU должен выполнять однообразные операции.

Возьмем, например, Nvidia GTX 1080. Данная видеокарта имеет 2560 шейдерных ядер. Благодаря этим ядрам Nvidia GTX 1080 может выполнить 2560 инструкций или операций за один такт. Если вы захотите сделать картинку на 1% ярче, то GPU с этим справится без особого труда. А вот четырехъядерный центральный процессор Intel Core i5 сможет выполнить только 4 инструкции за один такт.

Тем не менее, центральные процессоры более гибкие, чем графические. Центральные процессоры имеют больший набор инструкций, поэтому они могут выполнять более широкий диапазон функций. Также CPU работают на более высоких максимальных тактовых частотах и имеют возможность управлять вводом и выводом компонентов компьютера. Например, центральный процессор может интегрироваться с виртуальной памятью, которая необходима для запуска современной операционной системы. Это как раз то, что графический процессор выполнить не сможет.

Вычисления на GPU

Даже несмотря на то, что графические процессоры предназначены для рендеринга, они способны на большее. Обработка графики — это только вид повторяющихся параллельных вычислений. Другие задачи, такие как майнинг Bitcoin и взломы паролей полагаются на одни и те же виды массивных наборов данных и простых математических вычислений. Именно поэтому некоторые пользователи используют видеокарты для не графических операций. Такое явление называется GPU Computation или же вычисления на GPU.

Обработка графики — это только вид повторяющихся параллельных вычислений. Другие задачи, такие как майнинг Bitcoin и взломы паролей полагаются на одни и те же виды массивных наборов данных и простых математических вычислений. Именно поэтому некоторые пользователи используют видеокарты для не графических операций. Такое явление называется GPU Computation или же вычисления на GPU.

Выводы

В данной статье мы провели сравнение CPU и GPU. Думаю, всем стало понятно, что GPU и CPU имеют схожие цели, но оптимизированы для разных вычислений. Пишите свое мнение в комментариях, я постараюсь ответить.

Настройка производительности графических процессоров с использованием…

В этом документе представлена информация о вариантах, доступных в Radeon™ ватт, который обеспечивает возможность индивидуальной настройки производительности графических адаптеров (GPU).

Обзор Radeon Вт

Radeon ватт, впервые представленная в 16.6.2 по™ выпуска программного обеспечения Radeon Crimson. Она обеспечивает производительность и мониторинг поведения графического процессора, позволяя выполнять тонкую настройку игровых возможностей для различных приложений.

Она обеспечивает производительность и мониторинг поведения графического процессора, позволяя выполнять тонкую настройку игровых возможностей для различных приложений.

Этот документ поможет вам выполнить все этапы настройки графического процессора с помощью Radeon ватт. Важно отметить, что для настройки графического процессора требуется продвинутый уровень технических знаний. Для большинства пользователей настройки оборудования, используемые по умолчанию для графических ПРОЦЕССОРов и графической памяти, обеспечивают максимальную производительность для большинства приложений.

| Примечание | При ручном перерасходе лучше не Оверклокинг за небольшое увеличение, а затем проверить стабильность после каждой корректировки. Для этого лучше всего Заработайте 3D-игры и приложения, как это делается в течение нескольких часов. Если система становится нестабильной (например, вы можете столкнуться со сбоями, зависанием и/или графическим повреждением), вы должны вернуться к последним стабильным параметрам. |

Требования Radeon Вт

Radeon ватт поддерживается в продукции на базе процессоров AMD Radeon R7 260 и выше. Рекомендуется всегда использовать новейший совместимый драйвер для графического процессора при конфигурировании Radeon ватт в системе на базе ОС Windows® .

| Примечание |

|

Конфигурирование Radeon ватт

Чтобы получить доступ к Radeon ватт, откройте настройки Radeon, щелкнув правой кнопкой мыши на рабочем столе и выбрав настройки AMD Radeon.

Перейдите на вкладку «игры».

Нажмите «глобальные настройки».

Перейдите на вкладку Global ватт ватт и прочтите условия использования. Если вы согласны с настоящими условиями, нажмите «принять», чтобы продолжить.

Если вы согласны с настоящими условиями, нажмите «принять», чтобы продолжить.

| Примечание | ГАРАНТИЯ НА ПРОДУКЦИЮ AMD НЕ ВКЛЮЧАЕТ В СЕБЯ УБЫТКИ, ВЫЗВАННЫЕ ПРЕВЫШЕНИЕМ ТАКТОВОЙ ЧАСТОТЫ, ДАЖЕ ЕСЛИ ФУНКЦИЯ ПЕРЕТАКТА ВКЛЮЧЕНА С АППАРАТНЫМ ОБЕСПЕЧЕНИЕМ И/ИЛИ ПРОГРАММНЫМ ОБЕСПЕЧЕНИЕМ AMD. |

После принятия условий использования вы можете начать настраивать настройки Radeon ватт.

| Примечание | В конфигурациях™ AMD CrossFire к каждому графическому процессору в системе должны быть применены настройки Radeon ватт. Вы можете выбрать каждый графический процессор, перейдя на вкладки графического процессора, как отмеченные далее. |

| Примечание | Если после настройки основного графического процессора варианты, расположенные под вкладками (-ы) для оставшихся графических процессоров, отключаются (без серого цвета), вам может потребоваться вывести на работу процессор (ы). Это можно сделать, перейдя между вкладками. Это можно сделать, перейдя между вкладками. |

В следующем разделе описаны варианты, реализованные в Radeon Вт, которые позволяют настраивать и контролировать производительность графического процессора. В их число входят:

- Профили производительности/ватт

- Контроль настройки

- Управление тактовой частотой

- Контроль частоты памяти

- Время памяти

- Управление напряжениями

- Температура вентиляторов &

- Нулевую RPM

- Минимальный уровень акустического ограничения

- Ограничение мощности

- Гистограмм

| Примечание | Изменения Global ватт будут применены ко всем 3D-приложениям. Если вы хотите создать индивидуальный профиль Radeon Вт для конкретных 3D-приложений, обратитесь к разделу: как настроить настройки AMD Radeon, чтобы добиться оптимального игрового процесса (URL-адрес: https://www.amd.com/en/support/kb/faq/dh-012). |

| Примечание | Изменения, внесенные в условиях Global Ватт или в профиль приложения, вступают в силу незамедлительно. Любые изменения, внесенные в настройки в Radeon ватт, сохраняются только после нажатия кнопки «применять», расположенной в правом верхнем углу интерфейса Radeon ватт. Любые изменения, внесенные в настройки в Radeon ватт, сохраняются только после нажатия кнопки «применять», расположенной в правом верхнем углу интерфейса Radeon ватт. |

Профили производительности/ватт

В Radeon ватт имеется четыре профиля производительности/ватт, которые позволяют настраивать производительность графического процессора и прорисовку энергии. Эта функция в настоящее время поддерживается графикой Radeon™ RX Vega RX.

Четыре профиля производительности/ватт:

- Энергосбережение

- Распределяют

- –

- Настройка

Выберите профиль Performance (Мощность/Ватт) с помощью ползунка, а затем нажмите «Apply» (Apply).

| Примечание | Профили производительности/ватт поддерживаются только в графической системе Radeon™ RX Vega-Series. |

Контроль настройки

Управление настройками становится доступным при использовании пользовательского профиля Performance (Мощность/Ватт) и предлагает следующие варианты:

- Вручную

- Графический процессор с автоматической заменой вольт

- Автоматический Оверклокинг графический процессор

- Автоматическая Оверклокинг памяти

Выберите профиль контроля настройки, прочитайте предупреждающее сообщение, нажмите «продолжить», чтобы добавить профиль, или «Отмена», чтобы вернуться к предыдущему меню.

| Примечание | Управление настройками поддерживается только в графике Radeon™ RX Vega RX. |

Управление тактовой частотой

Radeon ватт позволяет настраивать семь состояний тактовой частоты производительности графического процессора, которые определяются с помощью уникальных тактовой частоты и напряжения. Используя контроль частоты синхронизирующих импульсов, вы можете настроить каждый из этих семи состояний на личный выбор.

- Состояние синхронизирующих импульсов 0 является самым низким энергопотреблением и не может быть изменено.

- Тактовая частота 7 — это самая высокая тактовая частота графического процессора, которая обеспечивает максимальную производительность.

Управление тактовой частотой можно регулировать разными способами. В их число входят:

Простая контрольная кривая — режим по умолчанию позволяет одновременно выполнять корректировки всех состояний часов.

Передвиньте ползунок частоты вправо или влево, чтобы увеличить или уменьшить частоту графического процессора соответственно. Этот ползунок будет регулировать тактовую частоту с шагом в 0,5%.

Передвиньте ползунок частоты вправо или влево, чтобы увеличить или уменьшить частоту графического процессора соответственно. Этот ползунок будет регулировать тактовую частоту с шагом в 0,5%.- Управление кривой динамической частоты-Динамический режим можно изменить, выбрав параметр «частота» и изменив его на динамический. Динамическое управление часами обеспечивает индивидуальную настройку каждого состояния таймера, обеспечивая более высокую контроль над производительностью.

Установите требуемую частоту и нажмите «Apply» (Apply). В этом примере базовый процессор по умолчанию для состояния 7 для этого графического процессора 1340Mhz и был увеличен до 1350Mhz.

Примечание Увеличение тактовой частоты может повлиять на стабильность работы и может потребовать увеличения напряжения, чтобы стабилизировать систему. Управление напряжениями рассматривается в следующем разделе настоящего документа.

Контроль частоты памяти

Функция контроля частоты памяти использует только одно состояние (статус 2). В режиме по умолчанию настройте частоту памяти в увеличенном объеме 5Mhz с помощью ползунка.

В режиме по умолчанию настройте частоту памяти в увеличенном объеме 5Mhz с помощью ползунка.

Установите требуемую частоту и нажмите «Apply» (Apply).

Динамическое управление часами позволяет вводить желаемую частоту вручную. В данном примере основной такт по умолчанию для состояния 1 для этого графического процессора — 2000Mhz, и он был увеличен до 2005Mhz.

| Примечание | Управление частотой памяти не поддерживается в процессорах AMD Radeon Pro Duo, Radeon R9 Fury Series и Radeon R9 серии Nano. |

Время памяти

Синхронизация памяти сокращает время задержки памяти в зависимости от выбранного уровня. Более низкий уровень задержек памяти может повысить производительность некоторых приложений.

По времени памяти есть три варианта:

- Автоматические — по умолчанию — времена BIOS

- Уровень времени памяти 1

- Уровень времени памяти 2

Нажмите «время работы с памятью», чтобы переключаться между уровнями времени памяти Нажмите «Apply» (Apply), чтобы сохранить изменения.

| Примечание | Время обработки памяти доступно только для RX400, RX500 и RX серии Vega для графики |

Управление напряжениями

Контроль напряжения означает степень напряжения, применяемого к графическому процессору в каждом энергографическом состоянии.

Управление напряжениями может помочь стабилизировать графический процессор при увеличении тактовой частоты. Это потребует большего энергопотребления и повышает тактовую частоту, обеспечивая более высокую скорость вращения вентилятора и шум вентилятора.

Напряжение для частоты графического процессора можно изменить, выбрав опцию контроль напряжения и изменив ее на ручной. Ручное управление напряжениями позволяет настраивать напряжение для каждого состояния процессора.

| Примечание | В ручном режиме лучше всего увеличить напряжение на небольшие, а затем проверить стабильность. Это лучше сделать, запустив обычные игры и 3D-приложения с предпочтительными настройками. |

| Примечание | Если внесенные выше корректировки приводят к нестабильной работе, можно восстановить заводские настройки по умолчанию, нажав кнопку «Сброс», расположенную в правом верхнем углу. |

| Примечание | Показания напряжения не связаны с часами графического процессора и памяти. Оба варианта устанавливаются независимо друг от друга. |

Установите требуемое напряжение и нажмите «Apply» (Apply). В данном примере значение напряжения по умолчанию для состояния 7 равно 1150, и оно увеличено до 1175.

Для управления напряжением на память используется только одно состояние (статус 2).

Напряжение для частоты памяти можно изменить, выбрав опцию контроль напряжения и изменив ее на ручной. Ручное управление напряжениями обеспечивает возможность настройки напряжения для состояния процессора 2.

Установите требуемое напряжение и нажмите «Apply» (Apply). В данном примере напряжением по умолчанию для штата 2 является 950, и оно увеличено до 1000.

В данном примере напряжением по умолчанию для штата 2 является 950, и оно увеличено до 1000.

Температура вентиляторов &

Производительность и температура вентиляторов автоматически управляются графическим процессором и настраиваются в соответствии с температурой, в зависимости от текущей рабочей нагрузки.

По умолчанию переключатель скорости/температуры настроен на автоматический режим.

Нажмите на выключатель «скорость/температура», чтобы переключиться в режим «вручную» и обеспечить контроль над скоростью вращения вентилятора и рабочими нагрузками графического процессора при запуске 3D-приложения (при загрузке).

В ручном режиме предлагается пять настраиваемых состояний с помощью кривой вентиляторов с графическим процессором. Каждое состояние соответствует целевой скорости вентилятора графического процессора и температуре графического процессора. Скорость вращения вентилятора измеряется в RPM (революция в минуту), а чем выше скорость вращения вентилятора, тем больше устройств охлаждения, что может привести к увеличению шума вентилятора.

Каждая точка в кривой может быть перемещается вверх/вниз, чтобы установить скорость вентилятора графического процессора и оставить ее в правильном положении в соответствии с требуемой температуре процессора.

Нулевую RPM

Нулевое значение RPM обеспечивает бесшумное выполнение операций в любое время, когда графический процессор находится в светлых нагрузках и включен по умолчанию. Вентиляторы графического процессора должны вращаться по мере роста графического процессора при загрузке системы и увеличении температуры.

Минимальный уровень акустического ограничения

Минимальный уровень акустического ограничения позволяет пользователю установить базовую частоту, в которой будет работать графический процессор. Если тактовая частота графического процессора (МГц) падает после установленного минимального значения акустического ограничения, скорость вращения вентилятора увеличится по мере необходимости, чтобы регулировать температуру графического процессора, чтобы можно было поддерживать базовую частоту.

Ограничение мощности

Ограничение мощности контролирует уровень мощности, посылаемой на графический процессор. Увеличение этого значения может повысить производительность графического процессора, позволяя графическому процессору сохранять максимальную тактовую частоту (состояние 7).

Ограничение энергопотребления может быть увеличено или уменьшено на +/-20-100% и должно быть установлено на максимальное значение при увеличении тактовой частоты процессора или памяти.

| Примечание | Ограничение мощности% зависит от того, какой графический процессор вы используете. |

Гистограмм

Гистограмма обеспечивает мониторинг и сбор данных о текущих, средних и пиковых действиях графического процессора, температуре, скорости вентилятора и тактовой частоте графического процессора.

Наведите указатель мыши на диаграмму, чтобы просмотреть подробные сведения об определенном момент времени, как показано ниже.

Профили Radeon Вт

После того как вы приступите к оптимальной конфигурации Radeon ватт, настройки можно сохранить в качестве профиля.

Начиная с программного обеспечения Radeon адреналин Edition, теперь можно создавать и загружать множество профилей в зависимости от использования системы — например:

- Профиль для высокопроизводительных игр с более высокими ограничениями энергопотребления и скоростью вращения вентиляторов, которые обеспечивают более высокую тактовую частоту.

- Профиль для снижения энергопотребления и скорости вращения вентиляторов, что приводит к снижению температуры и скрытой системе.

Кроме того, профили Radeon Вт также могут быть созданы на уровне каждого приложения, предоставляя тот же набор настраиваемых параметров, как описано выше, с помощью профилей игровых приложений. При загрузке конкретного профиля приложения глобальные настройки будут переопределяться во время работы приложения.

Чтобы загрузить или сохранить профиль Radeon Ватт (глобальные или индивидуальные приложения), нажмите кнопку «Загрузить профиль» или «сохранить профиль». Профили (сохраненные в формате XML) по умолчанию хранятся в следующем расположении: : \Усерс\ \Аппдата\локал\амд\кн

Профили (сохраненные в формате XML) по умолчанию хранятся в следующем расположении: : \Усерс\ \Аппдата\локал\амд\кн

Информацию о том, как создать профиль приложения, см. в следующей области базы знаний: « Создание профилей приложений».

Восстановление настроек по умолчанию

Если вы хотите вернуться к настройкам по умолчанию, вы можете восстановить настройки глобальных или индивидуальных приложений Radeon ватт в соответствии со значениями по умолчанию, нажав кнопку Reset (пере) в правом верхнем углу глобального или отдельного меню Radeon ватт.

Radeon присесть

Radeon присесть — это функция энергосбережения, которая динамически регулирует частоту кадров в зависимости от движения ваших символов и камеры в игре2.

По мере уменьшения движения присесть Radeon сокращает частоту геймплей частоты, экономит энергию и понижает температуру графического процессора.

Сначала необходимо активировать Radeon присесть в меню «игровые/глобальные настройки»/«глобальные настройки».

Во время геймплейи Radeon присесть можно включать и выключать, нажимая назначенное сочетание клавиш. Сочетание клавиш можно изменить на другое, выбрав присесть клавишу «», а затем нажав нужную клавишу.

Для получения дополнительной информации о Radeon присесть и списке поддерживаемых игр перейдите на страницу «технология Radeon присесть».

После того как Radeon присесть был активирован глобально, можно настроить Radeon присесть на уровне каждого приложения в рамках профиля приложения:

- Присесть -активировать Radeon присесть для текущей игры

- ПРИСЕСТЬ min — минимальное значение частоты кадров для присесть для работы в пределах (минимальное значение составляет 30 кадров в секунду, значение по умолчанию — 70).

- ПРИСЕСТЬ Max — максимальная частота кадров для присесть для работы (максимальная частота в 300 кадров в секунду, значение по умолчанию — 144)

Информацию о том, как создать профиль приложения, см. в следующей области базы знаний: « Создание профилей приложений».

в следующей области базы знаний: « Создание профилей приложений».

1 При использовании любого процессора AMD, в том числе без ограничений, изменение тактовой частоты/множителей или значений времени/напряжения памяти, для работы за пределами их складских спецификаций будет аннулирована любая применимая гарантия на продукцию AMD даже в том случае, если такая перечисленость включена по аппаратному и/или программному обеспечению AMD. Это может также аннулировать гарантии, предлагаемые производителем системы или розничным продавцом. Пользователи считают все риски и обязательства, которые могут возникать из-за превышения тактовой частоты процессоров AMD, включая отсутствие каких-либо ограничений, отказов или ущерба для аппаратного обеспечения, снижения производительности системы и/или потери данных, повреждения или уязвимости.

2 Узнайте больше на сайте https://www.AMD.com/en/Technologies/Radeon-Software-Chill

* Корпорация Intel предложите вам материалы на сторонних веб-сайтах для вашего удобства и может предоставить ссылки на дополнительные сайты сторонних компаний. Предоставление такого контента и/или ссылок означает только предложения и не должно считаться одобрением или рекомендацией для выполнения каких-либо конкретных действий. Выполнение действий, рекомендованных сторонними поставщиками, может привести к неправильной работе, повреждению системной платы или процессора или сокращению срока службы продукции. Корпорация Intel не несет никакой ответственности в отношении использования вами сторонних компаний или материалов, а также отказывается от прямых или косвенных гарантий, связанных с сайтами или материалами сторонних компаний. Корпорация Intel не контролирует и не проверяет сторонние материалы или веб-сайты сторонних компаний, упоминаемые на веб-сайтах других компаний. Вы должны посетить веб-сайт, на котором есть ссылка, и подтвердить точность данных, указанных в ссылке.

Предоставление такого контента и/или ссылок означает только предложения и не должно считаться одобрением или рекомендацией для выполнения каких-либо конкретных действий. Выполнение действий, рекомендованных сторонними поставщиками, может привести к неправильной работе, повреждению системной платы или процессора или сокращению срока службы продукции. Корпорация Intel не несет никакой ответственности в отношении использования вами сторонних компаний или материалов, а также отказывается от прямых или косвенных гарантий, связанных с сайтами или материалами сторонних компаний. Корпорация Intel не контролирует и не проверяет сторонние материалы или веб-сайты сторонних компаний, упоминаемые на веб-сайтах других компаний. Вы должны посетить веб-сайт, на котором есть ссылка, и подтвердить точность данных, указанных в ссылке.

Как пользоваться ASUS GPU Tweak II

Обладатели видеокарт от Asus могут воспользоваться возможностями утилиты ASUS GPU Tweak II. Установить GPU Tweak 2 можно непосредственно с диска драйверов и утилит или же с официального сайта производителя. Стоит сказать, что для комфортной работы придётся подучить английский язык, так как русский язык интерфейса в официальной версии отсутствует.

Установить GPU Tweak 2 можно непосредственно с диска драйверов и утилит или же с официального сайта производителя. Стоит сказать, что для комфортной работы придётся подучить английский язык, так как русский язык интерфейса в официальной версии отсутствует.

Эта статья расскажет как пользоваться ASUS GPU Tweak II. Обладателям последней версии операционной системы рекомендуем загрузить обновлённую версию программы. К основным особенностям и возможностям утилиты относят средства оптимизации системы, настройки скорости вентиляторов и собственно простой разгон графического адаптера.

ASUS GPU Tweak II Windows 10

Оптимизация системы

В пользователей есть возможность с помощью утилиты ASUS GPU Tweak II выполнить оптимизацию системы под управлением Windows 10. Доступные средства оптимизации будут полезны только тем, в кого установленные процессоры среднего ценового сегмента. ASUS GPU Tweak II позволяет сделать настройку визуальных эффектов, так званого быстродействия Windows 10, отключить ненужные службы и процессы и выполнить дефрагментацию диска.

- Перейдите в Simple Mode, и нажмите кнопку Gaming Booster — BoostMySystem.

- В окне оптимизации системы пользователя нажмите Start для запуска процесса.

Настройка вентиляторов

ASUS GPU Tweak II обладает широкими возможностями по разгону, а значит и настройке вращения вентиляторов. Все мощные видеокарты с современным охлаждением по умолчанию попросту отключают вентиляторы. Видеокарта охлаждается без активного охлаждения до определённых температур, после чего включаются вентиляторы.

Перейдите в Advanced Mode и в пункте Fan Speed выберите User Define. Дальше в зависимости от температуры графического чипа установите нужное значение скорости вентиляторов.

Дополнительно обратите внимание на переключатель 0dB Fan, который по умолчанию включён. Если же отключить его, все вентиляторы начнут вращаться на минимальных оборотах охлаждая Вашу видеокарту даже в режиме простоя. В некоторых ситуациях переключатель только включает обороты, а выключить не может (вероятно из-за конфликта с приложением настроек Radeon, в которых также реализован похожий функциональность).

В некоторых ситуациях переключатель только включает обороты, а выключить не может (вероятно из-за конфликта с приложением настроек Radeon, в которых также реализован похожий функциональность).

Разгон видеокарты

Что касается разгона видеокарты по памяти, то всё делается действительно очень просто. Первым делом стоит обратить внимание на различные профили работы доступные по умолчанию. В пространстве пользователя есть возможность выбрать между OC Mode, Gaming Mode и Silent Mode. Основные различия между текущими профилями содержатся в базовой тактовой частоте.

Важно! Разгон видеокарты значительно повышает рабочую температуру графического чипа. Перед разгоном несколько раз подумайте, стоит ли такой риск прибавки всего нескольких кадров в секунду в любимой игре. На горячих чипах такой риск не всегда оправдывается, из-за больших температур. Смотрите также: Как узнать температуру видеокарты в Windows 10.

Для получения большего количества кадров в секунду в играх нужно повышать рабочую частоту ядра и общую частоту памяти. Сильно увеличить значения частот без увеличения вольтажа не получиться. Плюсом утилиты ASUS GPU Tweak II есть простота повышения частоты ядра, повышая частоту ядра автоматически увеличивается вольтаж.

На сайте производителя рекомендуется перед началом разгона перетянуть ползунки GPU Voltage и Power Target вправо до максимума. После чего уже немного увеличивать значения параметров GPU Clock и Memory Clock. Мы же рекомендуем в процессе разгона немного повышать все доступные параметры, и сразу же проверять стабильность работы видеокарты в FurMark.

Сначала ознакомитесь с инструкцией: Как пользоваться программой FurMark. А также стоит отметить наличие модифицированной версии программы FurMark от Asus. Независимо от модификации, главное понимать, как выполнить тестирование и на какие параметры в процессе тестирования стабильности нужно обращать внимание.

Заключение

Помимо основных возможностей по разгону видеокарты и оптимизации системы в пользователя есть возможность посмотреть полные характеристики графического адаптера и включить мониторинг параметров. Обновлённая версия программы получила несколько изменённый интерфейс, по факту с доступными ранее возможностями.

КРАТКОЕ РУКОВОДСТВО ПО FIRESTORM | ZOTAC

КРАТКОЕ РУКОВОДСТВО ПО FIRESTORM

2019.09.09 1:00 AMПриветствуем новых пользователей!

Если вам впервые довелось приобрести/использовать видеокарту ZOTAC/ZOTAC GAMING, то вы обратились точно по адресу. Мы расскажем, как выжать из вашей видеокарты максимум. Читайте далее, чтобы узнать больше о нашей утилите настройки Firestorm. Чем больше вы знаете, тем больше сможете выжать из вашей видеокарты и тем лучше будут ваши игровые впечатления. Начнем!

ЗАГРУЗКА FIRESTORM

Первым делом убедитесь, что вы установили последнюю версию программного обеспечения FireStorm на ваш компьютер:

— Для владельцев ZOTAC GAMING GeForce RTX 30 Series

ЗАГРУЗКА ВАШЕЙ ВЕРСИИ

— Для владельцев ZOTAC GAMING GeForce RTX 20 Series & GTX 16 Series

ЗАГРУЗКА ВАШЕЙ ВЕРСИИ

— Для владельцев ZOTAC GeForce GTX 10 Series & GT Series

ЗАГРУЗКА ВАШЕЙ ВЕРСИИ

НАСТРОЙКИ GPU

Запустите FireStorm, чтобы получить доступ к самому свежему, современному и простому пользовательскому интерфейсу. Будет еще проще, если мы отметим три важные зоны разными цветами:

Будет еще проще, если мы отметим три важные зоны разными цветами:

Зеленая зона (по середине) отвечает за тактовые частоты GPU (сверху) и памяти (снизу).

Синяя зона (слева) показывает температуру GPU, скорость вращения вентилятора и ее настройки.

Наконец, красная зона (справа) – это область настроек, которая понадобится, чтобы максимизировать производительность.

РЕГУЛИРОВКА ПРОФИЛЕЙ ВЕНТИЛЯТОРОВ

Для настройки профилей вентиляторов есть вкладки «АВТО» (по умолчанию), «ВРУЧНУЮ» и «ПРОДВИНУТАЯ».

«АВТО» – заводские настройки по умолчанию.

Выбор варианта «ВРУЧНУЮ» позволит вам устанавливать скорость вращения вентилятора на видеокарте (в %). Эта настройка диктует вентилятору скорость, с которой он должен вращаться, вне зависимости от температуры видеокарты.

Розовое поле слева позволит воспользоваться преимуществами активного управления вентилятором (если это поддерживается моделью), которое доступно в линейке RTX. Так можно установить индивидуальную скорость вращения для каждого вентилятора. В случае видеокарт с тремя вентиляторами левый и центральный объединены в группу 1, а правый выделен в группу 2.

Так можно установить индивидуальную скорость вращения для каждого вентилятора. В случае видеокарт с тремя вентиляторами левый и центральный объединены в группу 1, а правый выделен в группу 2.

Если активное управление вентиляторами доступно для вашей видеокарты, вы сможете выбрать Группу 1 или Группу 2. В противном случае выбор будет недоступен. Выберите группу (если доступно) и сдвиньте ползунок влево или вправо, чтобы выставить желаемый процент скорости вращения вентилятора. Настройки будут применены автоматически.

ТОНКАЯ НАСТРОЙКА

В блоке справа вы сможете настроить тактовую частоту GPU, напряжение (если доступно), тактовую частоту памяти, мощность, целевую температуру GPU и тактовую частоту монитора. Разблокировать напряжение GPU, мощность, целевую температуру и тактовую частоту монитора можно, нажав на значок «блокировка».

Но помните, что производительность при разгоне различается в зависимости от модели вашей видеокарты и качества кремниевой пластины. Стоит начинать настройку с увеличения тактовой частоты с небольшим шагом. Если слишком увлечетесь, то может произойти сбой видеокарты или всей системы. Так что всегда действуйте с осторожностью. Вновь и вновь делайте проверки, чтобы добиться оптимального результата.

Стоит начинать настройку с увеличения тактовой частоты с небольшим шагом. Если слишком увлечетесь, то может произойти сбой видеокарты или всей системы. Так что всегда действуйте с осторожностью. Вновь и вновь делайте проверки, чтобы добиться оптимального результата.

При выборе вкладки «ПРОДВИНУТАЯ» появится всплывающее окно с кривой скорости вентилятора. Кривая скорости вентилятора без вмешательства выглядит как лестница, ведущая снизу слева вверх вправо, как это показано выше (учтите, это не профиль вентилятора видеокарты по умолчанию). Это более продвинутая версия настроек «ВРУЧНУЮ» для большей точности.

На примере, приведенном выше (исключительно в иллюстративных целях), вы можете видеть, что вентиляторы работают на 0% до момента, когда температура видеокарты достигает 60 градусов. В этот момент они переключаются на 70%. При температуре 100 градусов вентиляторы работают на 100%… Но мы гарантируем, что видеокарты ZOTAC никогда не достигают такого значения. В случае видеокарт с поддержкой возможности остановки вентиляторов FREEZE она будет работать даже в неидеальных условиях.

В случае видеокарт с поддержкой возможности остановки вентиляторов FREEZE она будет работать даже в неидеальных условиях.

Хотя имейте в виду, что не все модели оснащены функцией FREEZE. Если ваш вентилятор не поддерживает ее, даже при установке скорости вращения на 0, он просто будет вращаться максимально медленно, насколько это возможно. Не забудьте нажать «ПРИМЕНИТЬ», когда настроите кривую вращения вентилятора.

OC SCANNER

Одна из самых новых функций, которая доступна для видеокарт ZOTAC GAMING GeForce RTX series – это OC SCANNER. Это новая возможность позволяет увеличить производительность буквально в один клик. Процесс сканирования занимает 5-10 минут, так что на это время оставьте свою систему в покое. Как только сканирование завершится, ваша видеокарта начнет работать быстрее.

НАСТРОЙКИ ПРОГРАММЫ

Когда вы нажмете на значок настроек в правом верхнем углу (шестеренка), то попадете в меню с кнопками «МОНИТОРИНГ», «НАСТРОЙКИ», «ПОМОЩЬ» и «ИНФОРМАЦИЯ».

Раздел «МОНИТОРИНГ» открывает доступ к полезной информации о состоянии вашей видеокарты: скорости процессора, тактовой частоте памяти, напряжению, температуре и % использования GPU и памяти GPU.

Кнопка «НАСТРОЙКИ» позволит вам выбрать, хотите ли вы запускать FireStorm при старте системы, запускать в свернутом виде, разгонять при запуске, другими словами, при запуске FireStorm будет применяться последняя сохраненная конфигурация. Здесь же можно настроить прозрачность интерфейса утилиты FireStorm, чтобы вы могли видеть то, что находится за ним.

В меню «ПОМОЩЬ» мы добавили несколько полезных советов по разгону вашей видеокарты и управлению скоростью вращения вентилятора.

Более подробно все описано в разделе «ИНФОРМАЦИЯ». Проверьте, установили ли вы самую свежую версию драйверов и BIOS для своей видеокарты, а также узнайте технические характеристики вашей видеокарты.

ЭКСПЕРИМЕНТЫ С ПОДСВЕТКОЙ SPECTRA

Если вы без ума от RGB-подсветки видеокарты, вы по достоинству оцените возможность создать собственную схему освещения в разделе SPECTRA (красная область на рисунке ниже). Продвинутая светодиодная система освещения позволит вам создать собственную цветовую схему для вашей видеокарты с помощью обновленной утилиты FireStorm. (Пожалуйста, учтите, что интерфейс на иллюстрации выше будет доступен только при использовании моделей RTX AMP Extreme / AMP Extreme Core.)

ХОЛОСТОЙ И АКТИВНЫЙ

Выберите «ХОЛОСТОЙ» или «АКТИВНЫЙ» в меню сверху. Лучше всего использовать разные световые эффекты для разных режимов, так вы сможете сразу видеть, когда видеокарта работает, а когда – нет.

АКТИВНЫЙ режим – видеокарта работает по полной

ХОЛОСТОЙ режим – видеокарта находится в режиме ожидания

ПАЛИТРА ВАШЕГО СТИЛЯ

По умолчанию светодиоды голубого цвета, но вы сможете настроить от одного до семи цветов – красный, желтый, пурпурный, зеленый, голубой, синий и белый. Или же создать уникальный оттенок из широкого ассортимента.

Или же создать уникальный оттенок из широкого ассортимента.

Если у вас видеокарта RTX AMP Extreme / AMP Extreme Core, вы также можете назначить эффекты разным зонам в ИНДИВИДУАЛЬНОМ режиме. Проще говоря, СИНХРОНИЗИРОВАТЬ подсветку всех зон в один клик.

Яркость и уровень скорости также можно изменить, когда вы выбираете новый эффект или цвет.

РЕЖИМЫ ОСВЕЩЕНИЯ

Список доступных в SPECTRA эффектов зависит от модели вашей видеокарты, однако вы в любом случае сможете насладиться многообразием настроек. Вот список доступных вам базовых эффектов:

СТАТИКА – постоянное однотонное свечение

ДЫХАНИЕ – затемнение и высветление

ВСПЫШКА – включение и выключение

ВОЛНА – непрерывный переход из одного цвета в другой

ЦИКЛ – затемнение и высветление со сменой цветов

Серия ZOTAC GAMING GeForce RTX, модели AMP Extreme и AMP Extreme Core оснащены более продвинутой системой подсветки SPECTRA 2. 0, которая поддерживает 7 СТАНДАРТНЫХ ЭФФЕКТОВ и 5 АНИМИРОВАННЫХ ЭФФЕКТОВ. Вы сможете наслаждаться не только акцентированным логотипом, но и впечатляющей яркой подсветкой передней стороны.

0, которая поддерживает 7 СТАНДАРТНЫХ ЭФФЕКТОВ и 5 АНИМИРОВАННЫХ ЭФФЕКТОВ. Вы сможете наслаждаться не только акцентированным логотипом, но и впечатляющей яркой подсветкой передней стороны.

СТАНДАРТНЫЕ ЭФФЕКТЫ

СТАТИКА – постоянное однотонное свечение

ДЫХАНИЕ – затемнение и высветление

ИСЧЕЗНОВЕНИЕ – непрерывный переход из одного цвета в другой

МИГАНИЕ – включение и выключение

МИГАЛКА – включение и выключение в синем и красном цветах

СИЯНИЕ – изменение яркости в соответствии с музыкой и звуками системы

СЛУЧАЙНО – россыпь искр

АНИМИРОВАННЫЕ ЭФФЕКТЫ

СКОЛЬЖЕНИЕ – движение светового следа

РАДУГА – непрерывный радужный перелив

БЕГУЩАЯ СТРОКА – поток света, движущийся по кругу

КАПЕЛЬ – искра, движущаяся по кругу

ТАНЕЦ – пульсация в такт музыке и звукам системы

Under ANIMATED EFFECTS, the arrows at the bottom allow you to change the direction of how the lights move.

Стрелки в разделе «АНИМИРОВАННЫЕ ЭФФЕКТЫ» позволят изменить направление движения света.

Мы также добавили ряд интересных функций, например, возможность индивидуально настраивать каждую видеокарту при SLI-подключении, так что вам будет еще интереснее, если в вашей системе будут установлены две видеокартыNVLink SLI-ready.

НЕ ЗАБУДЬТЕ СОХРАНИТЬСЯ, СЛОВНО ВЫ УЖЕ ИГРАЕТЕ

Последнее по порядку, но не по значению: после того, как вы прочитали эту длинную статью, после того, как вложили столько усилий в настройку, едва ли вам захочется переделывать все еще раз. Так что перед тем, как переходить к игре, не забудьте СОХРАНИТЬ свои ПРОФИЛИ кнопкой внизу. В следующий раз вам достаточно будет нажать ЗАГРУЗИТЬ, чтобы восстановить желаемые настройки.

Развлекайтесь с утилитой FireStorm! И обязательно дайте нам знать, если вам потребуется какая-то Поддержка!

Как определяется GPU и использование памяти в результатах nvidia-smi?

В настоящее время я использую инструмент, поставляемый с драйвером NVIDIA ‘nvidia-smi’ для мониторинга производительности на GPU. Когда мы используем «nvidia-smi-a», он будет давать информацию о текущей информации GPU, включая использование ядра GPU и памяти, температуру и так далее:

Когда мы используем «nvidia-smi-a», он будет давать информацию о текущей информации GPU, включая использование ядра GPU и памяти, температуру и так далее:

==============ЖУРНАЛ NVSMI==============

Timestamp : Вторник

22 февраля 22:39:09 2011 г.

версия драйвера : 260.19.26

GPU 0:

Product Name : GeForce 8800 GTX PCI Device/Vendor ID : 19110de PCI Location ID : 0:4:0 Board Serial : 211561763875 Display : Connected Temperature : 55 C Fan Speed : 47% Utilization GPU : 1% Memory : 0%

Мне любопытно, как определяются GPU и использование памяти? Например, использование ядра GPU составляет 47%. это означает, что есть 47% из SMs активных рабочих? Или все GPU ядра заняты в 47% времени, в то время как другие 53% времени бездействуют? Для памяти использование означает отношение между текущей пропускной способностью и максимальной пропускной способностью, или отношение времени занятости в последней единице времени?

cuda gpu nvidiaПоделиться Источник fflower 23 февраля 2011 в 03:50

2 ответа

- Несоответствие IDs между ‘nvidia-smi-L’ и cuDeviceGetName()

Я запускаю эту команду в shell и получаю: C:\Users\me>nvidia-smi -L GPU 0: Quadro K2000 (UUID: GPU-b1ac50d1-019c-58e1-3598-4877fddd3f17) GPU 1: Quadro 2000 (UUID: GPU-1f22a253-c329-dfb7-0db4-e005efb6a4c7) Но в моем коде, когда я запускаю cuDeviceGetName (.

., ID) , где ID -это ID, заданное…

., ID) , где ID -это ID, заданное… - NVIDIA-smi GPU измерение производительности не имеет смысла

Я использую Nvidia GTX Titan X для проведения эксперимента по глубокому обучению. Я использую nvidia-smi для мониторинга состояния работы GPU, но состояние perf (ormance), предоставленное инструментом, не имеет смысла. Я проверил руководство nvidia-smi, в нем говорилось следующее: Состояние…

5

В сообщении модератора на форумах NVIDIA говорится, что показатели использования GPU и использования памяти основаны на активности за последнюю секунду:

GPU занят-это фактически процент времени за последнюю секунду, когда SMs был занят, а использование памяти-это фактически процент пропускной способности, используемой в течение последней секунды. Полная статистика потребления памяти поставляется со следующим выпуском.

Поделиться Matt 28 марта 2011 в 13:11

Поделиться ackratos 15 мая 2014 в 09:25

Похожие вопросы:

Как получить максимальное использование памяти GPU для процесса на Ubuntu? (Для Nvidia GPU)

У меня есть сервер с установленным Ubuntu 16. 04. У него есть K80 GPU. Несколько процессов используют GPU. Некоторые процессы имеют непредсказуемое использование GPU, и я хочу надежно контролировать…

04. У него есть K80 GPU. Несколько процессов используют GPU. Некоторые процессы имеют непредсказуемое использование GPU, и я хочу надежно контролировать…

почему nvprof и nvidia-smi сообщают о разных результатах по мощности?

Я использовал nvprof и nvidia-smi для мониторинга рассеивания мощности GPU соответственно, но наблюдал разные результаты, суммированные в таблице ниже….

Как объяснить эту цифру о `nvidia-smi` с NVIDIA GPUs?

Я только что запустил simpleMultiGPU на сервере с двумя установленными K20m GPUs. А затем выполните команду nvidia-smi , чтобы показать состояние GPUs. В результате получается следующее: Проблемы…

Несоответствие IDs между ‘nvidia-smi-L’ и cuDeviceGetName()

Я запускаю эту команду в shell и получаю: C:\Users\me>nvidia-smi -L GPU 0: Quadro K2000 (UUID: GPU-b1ac50d1-019c-58e1-3598-4877fddd3f17) GPU 1: Quadro 2000 (UUID:…

NVIDIA-smi GPU измерение производительности не имеет смысла

Я использую Nvidia GTX Titan X для проведения эксперимента по глубокому обучению. Я использую nvidia-smi для мониторинга состояния работы GPU, но состояние perf (ormance), предоставленное…

Я использую nvidia-smi для мониторинга состояния работы GPU, но состояние perf (ormance), предоставленное…

nvidia-smi показывает использование GPU, когда он не используется

Я запускаю tensorflow на GPU id 1 с помощью export CUDA_VISIBLE_DEVICES=1 , все в nvidia-smi выглядит хорошо, мой процесс python работает на gpu 1, память и энергопотребление показывают, что GPU 1…

компания NVIDIA-SMI-на летучих GPU-использование объяснений?

Я знаю, что nvidia-smi -l 1 будет давать GPU использование каждую секунду (аналогично следующему). Однако я был бы признателен за объяснение того, что на самом деле означает Volatile GPU-Util . Это…

NVIDIA-SMI не удалось. Может ли’nt общаться с драйвером Nvidia

Я запускаю экземпляр cloud на узле gpu. Я установил CUDA и nvidia-smi показал детали драйвера, утлилизацию памяти. Через пару дней я столкнулся с этой ошибкой «NVIDIA-SMI потерпел неудачу,…

nvidia-smi не отображает использование памяти

Я хочу использовать видеокарту NVIDIA-SMI на монитор моего GPU для моих проектов machine-learning/ AI. Однако, когда я запускаю nvidia-smi в моем cmd, git bash или powershell, я получаю следующие…

Однако, когда я запускаю nvidia-smi в моем cmd, git bash или powershell, я получаю следующие…

В чем разница между использованием памяти nvidia-smi и использованием памяти GPU?

Например, при выполнении команды nvidia-smi отображается: В чем разница между Memmory-Usage и GPU Memory Usage ?

Развертывание графических устройств с помощью vGPU RemoteFX

- Чтение занимает 4 мин

В этой статье

Область применения: Windows Server 2016, Microsoft Hyper-V Server 2016Applies to: Windows Server 2016, Microsoft Hyper-V Server 2016

Примечание

Из соображений безопасности процессор RemoteFX vGPU по умолчанию отключен для всех версий Windows, начиная с обновления для системы безопасности за 14 июля 2020 г. Because of security concerns, RemoteFX vGPU is disabled by default on all versions of Windows starting with the July 14, 2020 Security Update. См. KB 4570006.To learn more, see KB 4570006.

Because of security concerns, RemoteFX vGPU is disabled by default on all versions of Windows starting with the July 14, 2020 Security Update. См. KB 4570006.To learn more, see KB 4570006.

Функция виртуальных машин для RemoteFX позволяет нескольким виртуальным машинам совместно использовать физический GPU.The vGPU feature for RemoteFX makes it possible for multiple virtual machines to share a physical GPU. Визуализация и вычисление ресурсов динамически используются в виртуальных машинах, что делает виртуальную машину RemoteFX пригодной для высокопроизводительных рабочих нагрузок, когда выделенные ресурсы GPU не требуются.Rendering and compute resources are shared dynamically among virtual machines, making RemoteFX vGPU appropriate for high-burst workloads where dedicated GPU resources are not required. Например, в службе VDI виртуальный графический процессор RemoteFX можно использовать для разгрузки затрат на визуализацию приложений в GPU, что приводит к снижению нагрузки на ЦП и улучшению масштабируемости служб. For example, in a VDI service, RemoteFX vGPU can be used to offload app rendering costs to the GPU, with the effect of decreasing CPU load and improving service scalability.

For example, in a VDI service, RemoteFX vGPU can be used to offload app rendering costs to the GPU, with the effect of decreasing CPU load and improving service scalability.

Требования к RemoteFX vGPURemoteFX vGPU requirements

Требования к системе узла:Host system requirements:

- Windows Server 2016Windows Server 2016

- Совместимый с DirectX 11,0 графический процессор с драйвером 1,2 WDDM, совместимым с курьером.A DirectX 11.0-compatible GPU with a WDDM 1.2-compatible driver

- ЦП с поддержкой преобразования адресов второго уровня (SLAT)A CPU with Second Level Address Translation (SLAT) support

Требования к гостевым виртуальным машинам:Guest VM requirements:

Дополнительные рекомендации для гостевых виртуальных машин:Additional considerations for guest VMs:

- Функции OpenGL и OpenCL доступны только в гостевых ОС Windows 10 или Windows Server 2016.OpenGL and OpenCL functionality is only available in guests running Windows 10 or Windows Server 2016.

- DirectX 11,0 доступен только для гостей под Windows 8 или более поздней версии.DirectX 11.0 is only available for guests running Windows 8 or later.

Включить RemoteFX для виртуальных GPUEnable RemoteFX vGPU

Чтобы настроить виртуальный жесткий процессор RemoteFX на узле Windows Server 2016, выполните следующие действия.To configure RemoteFX vGPU on your Windows Server 2016 host:

- Установите графические драйверы, рекомендованные поставщиком GPU для Windows Server 2016.Install the graphics drivers recommended by your GPU vendor for Windows Server 2016.

- Создайте виртуальную машину под управлением гостевой ОС, поддерживаемой виртуальным процессором RemoteFX.Create a VM running a guest OS supported by RemoteFX vGPU. Дополнительные сведения см. в разделе Поддержка RemoteFX 3D Video Adapter (виртуальный графический адаптер).To learn more, see RemoteFX 3D Video Adapter (vGPU) support.

- Добавьте на виртуальную машину адаптер 3D Graphics для RemoteFX.

Add the RemoteFX 3D graphics adapter to the VM. Дополнительные сведения см. в статье Настройка 3D-адаптера RemoteFX для виртуальных GPU.To learn more, see Configure the RemoteFX vGPU 3D adapter.

Add the RemoteFX 3D graphics adapter to the VM. Дополнительные сведения см. в статье Настройка 3D-адаптера RemoteFX для виртуальных GPU.To learn more, see Configure the RemoteFX vGPU 3D adapter.

По умолчанию виртуальный графический процессор RemoteFX будет использовать все доступные и поддерживаемые GPU.By default, RemoteFX vGPU will use all available and supported GPUs. Чтобы ограничить количество GPU, используемых виртуальным графическим процессором RemoteFX, выполните следующие действия.To limit which GPUs the RemoteFX vGPU uses, follow these steps:

- В диспетчере Hyper-V перейдите к параметрам Hyper-V.Navigate to the Hyper-V settings in Hyper-V Manager.

- Выберите физические GPU в параметрах Hyper-V.Select Physical GPUs in Hyper-V Settings.

- Выберите графический процессор, который не нужно использовать, а затем снимите флажок Использовать этот графический процессор в RemoteFX.Select the GPU that you don’t want to use, and then clear Use this GPU with RemoteFX.

Настройка трехмерного адаптера vGPU RemoteFXConfigure the RemoteFX vGPU 3D adapter

Вы можете использовать пользовательский интерфейс диспетчера Hyper-V или командлеты PowerShell, чтобы настроить трехмерный графический адаптер vGPU RemoteFX.You can use either the Hyper-V Manager UI or PowerShell cmdlets to configure the RemoteFX vGPU 3D graphics adapter.

Настройка RemoteFX для виртуальных GPU с помощью диспетчера Hyper-VConfigure RemoteFX vGPU with Hyper-V Manager

Останавливает виртуальную машину, если она выполняется в данный момент.Stop the VM if it’s currently running.

Откройте диспетчер Hyper-V, перейдите к разделу Параметры виртуальной машины, а затем выберите Добавить оборудование.Open Hyper-V Manager, navigate to VM Settings, then select Add Hardware.

Выберите адаптер RemoteFX 3D Graphics и нажмите кнопку Добавить.

Select RemoteFX 3D Graphics Adapter, then select Add.

Select RemoteFX 3D Graphics Adapter, then select Add.Задайте максимальное число мониторов, максимальное разрешение монитора и используемой видеопамяти, либо оставьте значения по умолчанию.Set the maximum number of monitors, maximum monitor resolution, and dedicated video memory, or leave the default values.

Примечание

- Установка большего числа значений для любого из этих параметров повлияет на масштаб службы, поэтому следует задать только то, что необходимо.Setting higher values for any of these options will impact your service scale, so you should only set what is necessary.

- Если необходимо использовать 1 ГБ выделенной видеопамяти, для получения наилучших результатов используйте 64-разрядную гостевую виртуальную машину вместо 32-bit (x86).When you need to use 1 GB of dedicated VRAM, use a 64-bit guest VM instead of 32-bit (x86) for best results.

Нажмите кнопку ОК , чтобы завершить настройку.

Select OK to finish the configuration.

Select OK to finish the configuration.

Настройка виртуальных GPU RemoteFX с помощью командлетов PowerShellConfigure RemoteFX vGPU with PowerShell cmdlets

Используйте следующие командлеты PowerShell для добавления, проверки и настройки адаптера:Use the following PowerShell cmdlets to add, review, and configure the adapter:

Мониторинг производительностиMonitor performance

Производительность и масштаб службы, поддерживающей RemoteFX на виртуальных GPU, определяется различными факторами, такими как количество графических процессоров в системе, Общая память GPU, объем системной памяти и скорость памяти, число ядер ЦП и тактовая частота ЦП, скорость хранения и реализация NUMA.The performance and scale of a RemoteFX vGPU-enabled service are determined by a variety of factors such as number of GPUs on your system, total GPU memory, amount of system memory and memory speed, number of CPU cores and CPU clock frequency, storage speed, and NUMA implementation.

Память системы узлаHost system memory

Для каждой виртуальной машины, поддерживающей виртуальный графический процессор, RemoteFX использует системную память как в гостевой операционной системе, так и на сервере узла.For every VM enabled with a vGPU, RemoteFX uses system memory both in the guest operating system and in the host server. Гипервизор гарантирует доступность системной памяти для гостевой операционной системы.The hypervisor guarantees the availability of system memory for a guest operating system. На узле каждому виртуальному рабочему столу с поддержкой виртуальных рабочих столов необходимо объявить требования к системной памяти гипервизору.On the host, each vGPU-enabled virtual desktop needs to advertise its system memory requirement to the hypervisor. Когда запускается виртуальный рабочий стол с поддержкой виртуальных рабочих столов, гипервизор резервирует дополнительный объем системной памяти на узле.When the vGPU-enabled virtual desktop starts, the hypervisor reserves additional system memory in the host.

Требования к памяти для сервера с поддержкой RemoteFX являются динамическими, так как объем памяти, потребляемой на сервере с поддержкой RemoteFX, зависит от числа мониторов, связанных с виртуальными рабочими столами с поддержкой виртуальных рабочих столов, и максимального разрешения этих мониторов.The memory requirement for the RemoteFX-enabled server is dynamic because the amount of memory consumed on the RemoteFX-enabled server is dependent on the number of monitors that are associated with the vGPU-enabled virtual desktops and the maximum resolution for those monitors.

Видеопамять основного GPU узлаHost GPU video memory

Каждый виртуальный рабочий стол с поддержкой виртуальных рабочих столов использует аппаратную видеопамять GPU на сервере узла для подготовки к просмотру рабочего стола.Every vGPU-enabled virtual desktop uses the GPU hardware video memory on the host server to render the desktop. Кроме того, кодек использует видео-память для сжатия отображаемого экрана. In addition, a codec uses the video memory to compress the rendered screen. Объем памяти, необходимый для отрисовки и сжатия, непосредственно зависит от количества мониторов, подготовленных для виртуальной машины.The amount of memory needed for rendering and compression is directly based on the number of monitors provisioned to the virtual machine. Объем зарезервированной видеопамяти зависит от разрешения экрана системы и количества мониторов.The amount of reserved video memory varies based on the system screen resolution and how many monitors there are. Некоторым пользователям требуется более высокое разрешение экрана для определенных задач, но существует большая масштабируемость с более низкими параметрами разрешения, если все остальные параметры остаются постоянными.Some users require a higher screen resolution for specific tasks, but there’s greater scalability with lower resolution settings if all other settings remain constant.