с чего начать / Хабр

В мире энтерпрайза наступило пресыщение фронтовыми системами, шинами данных и прочими классическими системами, которые внедряли все кому не лень последние 10-15 лет. Но есть один сегмент, который до недавнего времени был в статусе «все хотят, но никто не знает, что это». И это Big Data. Красиво звучит, продвигается топовыми западными компаниями – как не стать лакомым кусочком?

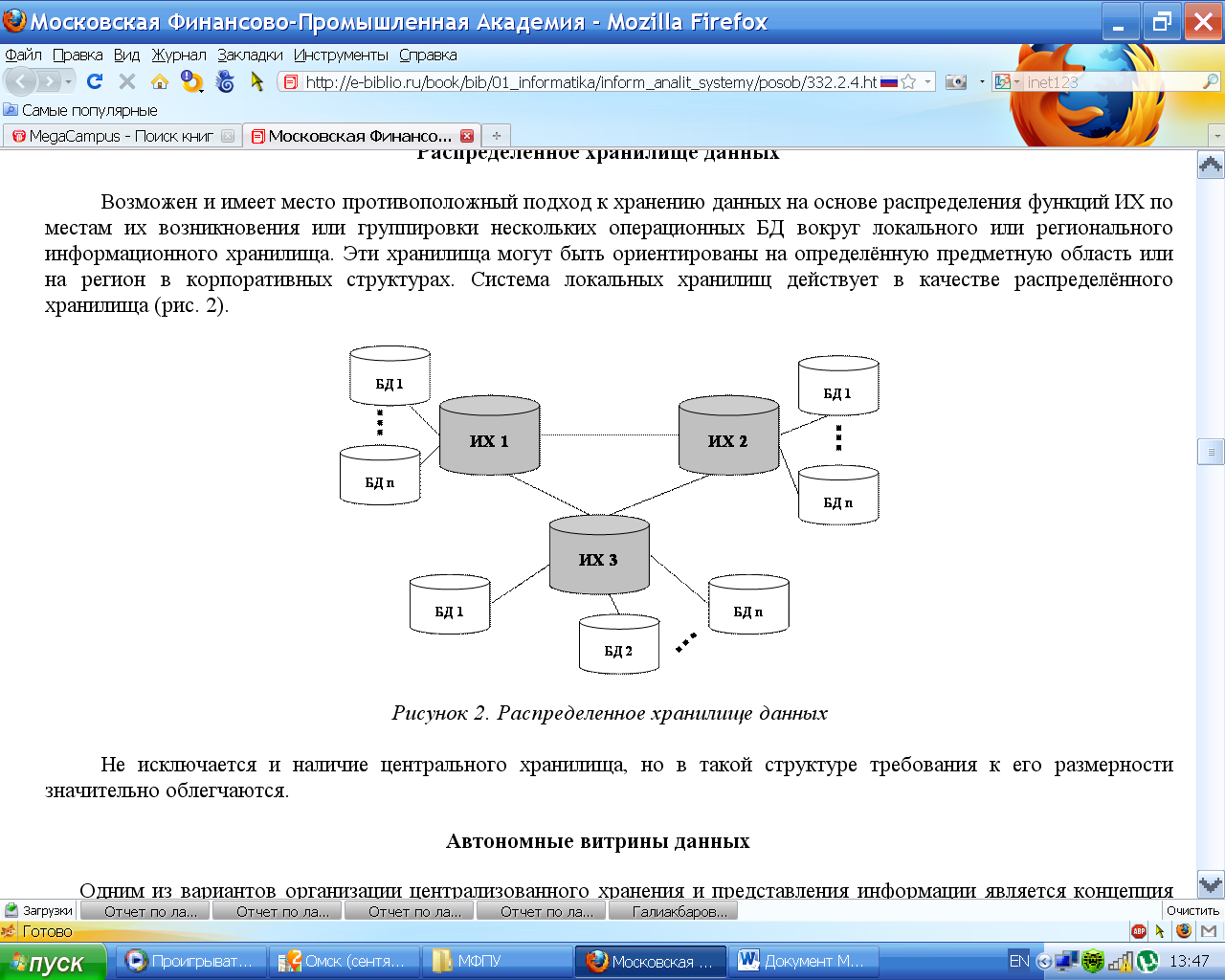

Но пока большинство только смотрит и приценивается, некоторые компании начали активно внедрять решения на базе этого технологического стека в свой IT ландшафт. Важную роль в этом сыграло появление коммерческих дистрибутивов Apache Hadoop, разработчики которых обеспечивают своим клиентам техническую поддержку. Ощутив необходимость в подобном решении, один из наших клиентов принял решение об организации распределенного хранилища данных в концепции Data Lake на базе Apache Hadoop.

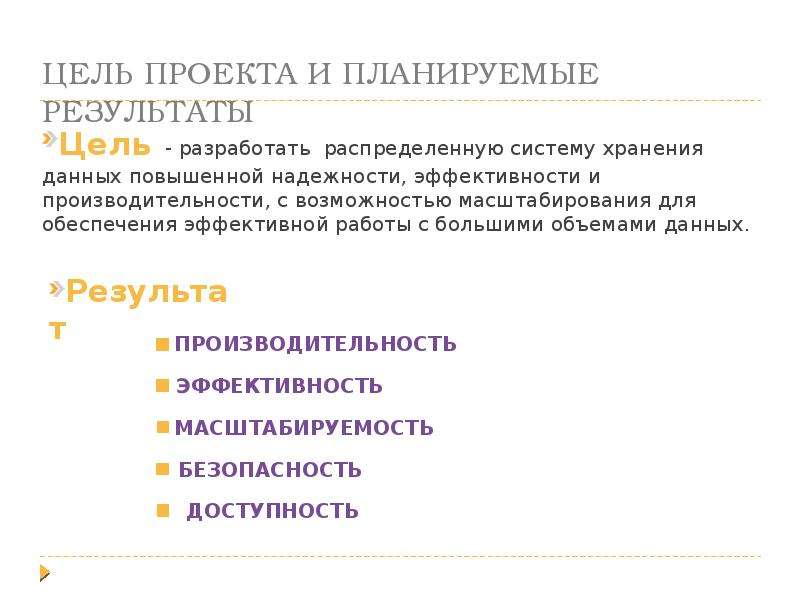

Цели проекта

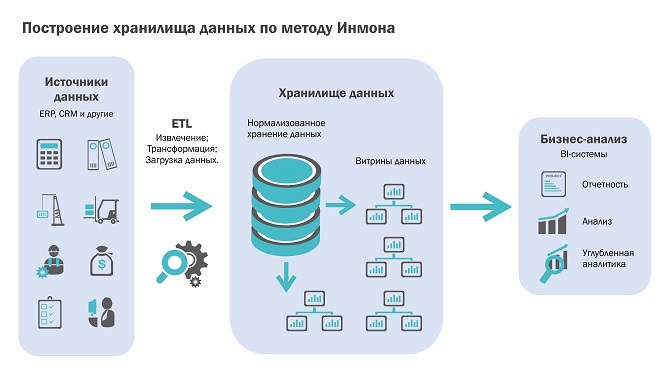

Во-первых, оптимизировать работу департамента управления рисками. До начала работ расчетом факторов кредитного риска (ФКР) занимался целый отдел, и все расчеты производились вручную. Перерасчет занимал каждый раз около месяца и данные, на основе которых он базировался, успевали устареть. Поэтому в задачи решения входила ежедневная загрузка дельты данных в хранилище, перерасчет ФКР и построение витрин данных в BI-инструменте (для данной задачи оказалось достаточно функционала SpagoBI) для их визуализации.

До начала работ расчетом факторов кредитного риска (ФКР) занимался целый отдел, и все расчеты производились вручную. Перерасчет занимал каждый раз около месяца и данные, на основе которых он базировался, успевали устареть. Поэтому в задачи решения входила ежедневная загрузка дельты данных в хранилище, перерасчет ФКР и построение витрин данных в BI-инструменте (для данной задачи оказалось достаточно функционала SpagoBI) для их визуализации.

Во-вторых, обеспечить высокопроизводительные инструменты Data Mining для сотрудников банка, занимающихся Data Science. Данные инструменты, такие как Jupyter и Apache Zeppelin, могут быть установлены локально и с их помощью также можно исследовать данные и производить построение моделей. Но их интеграция с кластером Cloudera позволяет использовать для расчетов аппаратные ресурсы наиболее производительных узлов системы, что ускоряет выполнение задач анализа данных в десятки и даже сотни раз.

В качестве целевого аппаратного решения была выбрана стойка Oracle Big Data Appliance, поэтому за основу был взят дистрибутив Apache Hadoop от компании Cloudera. Стойка ехала довольно долго, и для ускорения процесса под данный проект были выделены сервера в приватном облаке заказчика. Решение разумное, но был и ряд проблем, о которых расскажу ниже по тексту.

Стойка ехала довольно долго, и для ускорения процесса под данный проект были выделены сервера в приватном облаке заказчика. Решение разумное, но был и ряд проблем, о которых расскажу ниже по тексту.

В рамках проекта были запланированы следующие задачи:

- Развернуть Cloudera CDH (Cloudera’s Distribution including Apache Hadoop) и дополнительные сервисы, необходимые для работы.

- Произвести настройку установленного ПО.

- Настроить непрерывную интеграцию для ускорения процесса разработки (будет освещена в отдельной статье).

- Установить BI-средства для построения отчетности и инструментов Data Discovery для обеспечения работы датасайентистов (будет освещена в отдельном посте).

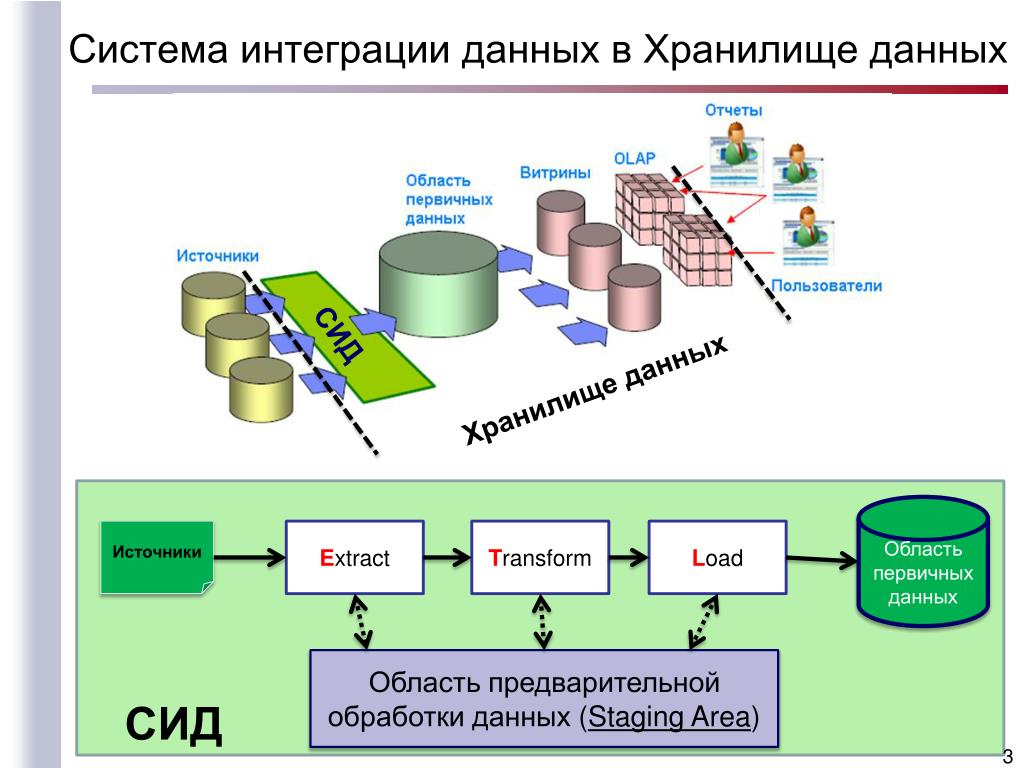

- Разработать приложения для загрузки необходимых данных из конечных систем, а также их регулярной актуализации.

- Разработать формы построения отчетности для визуализации данных в BI-средстве.

Компания Neoflex не первый год занимается разработкой и внедрением систем на базе Apache Hadoop и даже имеет свой продукт для визуальной разработки ETL-процессов — Neoflex Datagram.

Ресурсы

До того, как начинать установку, рекомендуется подготовить для нее все необходимое.

Количество и мощность железа напрямую зависит от того, сколько и каких сред потребуется развернуть. Для целей разработки можно установить все компоненты хоть на одну хилую виртуалку, но такой подход не приветствуется.

На этапе пилотирования проекта и активной разработки, когда количество пользователей системы было минимально, было достаточно одной основной среды – это позволяло ускоряться за счет сокращения времени загрузки данных из конечных систем (наиболее частая и долгая процедура при разработке хранилищ данных). Сейчас, когда система стабилизировалась, пришли к конфигурации с тремя средами – тест, препрод и прод (основная).

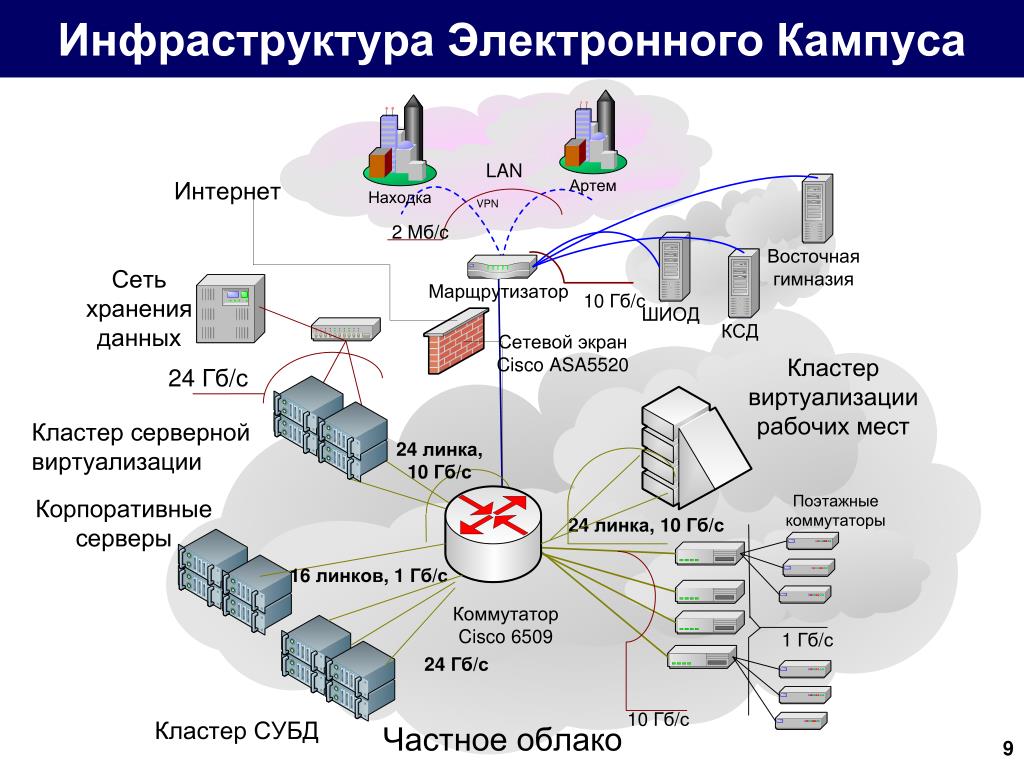

В приватном облаке были выделены сервера для организации 2 сред – основной и тестовой. Характеристики сред приведены в таблице ниже:

| Назначение | Количество | vCPU | vRAM, Gb | Диски, Gb |

|---|---|---|---|---|

| Основная среда, сервисы Cloudera | 3 | 8 | 64 | 2 200 |

| Основная среда, HDFS | 3 | 22 | 288 | 5000 |

| Основная среда, инструменты Data Discovery | 1 | 16 | 128 | 2200 |

| Тестовая среда, сервисы Cloudera | 1 | 8 | 64 | 2200 |

| Тестовая среда, HDFS | 2 | 22 | 256 | 4000 |

| Основная среда, инструменты Data Discovery | 1 | 16 | 128 | 2200 |

| CI | 2 | 6 | 48 | 1000 |

Позднее основная среда мигрировала на Oracle BDA, а сервера были использованы для организации препрод среды.

Решение о миграции было обоснованным – ресурсов выделенных под HDFS серверов объективно не хватало. Узкими местами стали крохотные диски (что такое 5 Tb для Big Data?) и недостаточно мощные процессоры, стабильно загруженные на 95% при штатной работе задач по загрузке данных. С прочими серверами ситуация обратная – практически все время они простаивают без дела и их ресурсы с большей пользой можно было бы задействовать на других проектах.

С софтом дела обстояли непросто – из-за того, что разработка велась в частном облаке без доступа к интернету, все файлы приходилось переносить через службу безопасности и только по согласованию. В связи с этим приходилось заранее выгружать все необходимые дистрибутивы, пакеты и зависимости.

В этой непростой задаче очень помогала настройка keepcache=1 в файлике /etc/yum.conf (в качестве OS использовался RHEL 7.3) – установить нужное ПО на машине с выходом в сеть намного проще, чем руками выкачивать его из репозиториев вместе с зависимостями 😉

Что потребуется развернуть:

- Oracle JDK (без Java никуда).

- База данных для хранения информации, создаваемой и используемой сервисами CDH (например Hive Metastore). В нашем случае был установлен PostgreSQL версии 9.2.18, но может быть использована любая из поддерживаемых сервисами Cloudera (список отличается для разных версий дистрибутива, см. раздел «Requirements and Supported Versions» официального сайта). Здесь надо заметить, что выбор БД оказался не вполне удачным – Oracle BDA поставляется с БД MySQL (один из их продуктов, перешедший к ним вместе с покупкой Sun) и логичнее было использовать аналогичную базу для других сред, что упростило бы процедуру миграции. Рекомендуется выбирать дистрибутив исходя из целевого аппаратного решения.

- Демон Chrony для синхронизации времени на серверах.

- Cloudera Manager Server.

- Демоны Cloudera Manager.

Подготовка к установке

Перед началом установки CDH стоит провести ряд подготовительных работ. Одна их часть пригодится во время установки, другая упростит эксплуатацию.

Установка и настройка ОС

Прежде всего, стоит подготовить виртуальные (можно и реальные) машины, на которых будет располагаться система: установить на каждую из них операционную систему поддерживаемой версии (список отличается для разных версий дистрибутива, см. раздел «Requirements and Supported Versions» официального сайта), присвоить хостам понятные имена (например, <system_name>master1,2,3…, <system_name>slave1,2,3…), а также разметить диски под файловое хранилища и временные файлы, создаваемые в ходе работы системы.

Рекомендации по разметке следующие:

- На серверах с HDFS создать том хотя бы на 500 Gb для файлов, которые создает YARN в ходе работы задач и помещает в директорию /yarn (куда этот том и надо подмонтировать после установки CDH). Небольшой том (порядка 100 Gb) стоит выделить для ОС, сервисов Cloudera, логов и прочего хозяйства. Все свободное место, которое останется после этих манипуляций, стоит объединить в один большой том и примонтировать к директории /dfs до начала загрузки данных в хранилище.

HDFS хранит данные в виде достаточно мелких блоков и лучше лишний раз не заниматься их переносом. Также для удобства последующего добавления дисков рекомендуется использовать LVM – проще будет расширять хранилище (особенно когда оно станет действительно BIG).

HDFS хранит данные в виде достаточно мелких блоков и лучше лишний раз не заниматься их переносом. Также для удобства последующего добавления дисков рекомендуется использовать LVM – проще будет расширять хранилище (особенно когда оно станет действительно BIG). - На серверах с сервисами Cloudera можно монтировать все доступное место в корневую директорию – проблем с большими объемами файлов быть не должно, особенно если регулярно чистить логи. Единственное исключение составляет сервер с базой данных, которую используют сервисы Cloudera для своих нужд – на данном сервере имеет смысл разметить отдельный том под директорию, в которой хранятся файлы этой БД (будет зависеть от выбранного дистрибутива). Сервисы пишут довольно умеренно и 500 Gb должно хватить с лихвой. Для подстраховки также можно использовать LVM.

Настройка http сервера и offline установка пакетов yum и CDH

Поскольку установка софта производится без доступа в интернет, для упрощения установки пакетов рекомендуется поднять HTTP сервер и с его помощью создать локальный репозиторий, который будет доступен по сети. Можно устанавливать весь софт локально с помощью, к примеру, rpm, но при большом количестве серверов и появлении нескольких сред удобно иметь единый репозиторий, из которого можно ставить пакеты без необходимости переносить их руками с машины на машину.

Можно устанавливать весь софт локально с помощью, к примеру, rpm, но при большом количестве серверов и появлении нескольких сред удобно иметь единый репозиторий, из которого можно ставить пакеты без необходимости переносить их руками с машины на машину.

Установка производилась на ОС Red Hat 7.3, поэтому в статье будут приводиться команды, специфичные для нее и других операционных систем на базе CentOS. При установке на других ОС последовательность будет аналогичной, отличаться будут только пакетные менеджеры.

Вот что потребуется сделать:

1. Выбирается машина, на которой будет располагаться HTTP сервер и дистрибутивы.

2. На машине с аналогичной ОС, но подключенной к интернету, выставляем флаг keepcache=1 в файле /etc/yum.conf и устанавливается httpd со всеми зависимостями:

yum install httpdЕсли данная команда не работает, то требуется добавить в список репозиториев yum репозиторий, в котором есть данные пакеты, например, этот —

centos. excellmedia.net/7/os/x86_64

excellmedia.net/7/os/x86_64:

echo -e "\n[centos.excellmedia.net]\nname=excellmedia\nbaseurl=http://centos.excellmedia.net/7/os/x86_64/\nenabled=1\ngpgcheck=0" > /etc/yum.repos.d/excell.repoПосле этого командой

yum repolistпроверяем, что репозиторий подтянулся — в списке репозиториев должен появиться добавленный репозиторий (repo id — centos.excellmedia.net; repo name — excellmedia).

Теперь проверяем, что yum увидел нужные нам пакеты:

yum list | grep httpdЕсли в выводе присутствуют нужные пакеты, то можно установить их приведенной выше командой.

3. Для создания репозитория yum нам потребуется пакет createrepo. Он также есть в указанном выше репозитории и ставится аналогично:

yum install createrepo4.

Как я уже говорил, для работы сервисов CDH требуется база данных. Установим для этих целей PostgreSQL:

yum install postgresql-server5.

Одним из обязательных условий для корректной работы CDH является синхронизация времени на всех серверах, входящих в кластер. Для этих целей используется пакет

chronyd(на тех ОС, где мне приходилось разворачивать CDH, он был установлен по умолчанию). Проверяем его наличие:

chronyd -vЕсли он не установлен, то устанавливаем:

yum install chronyЕсли же установлен, то просто скачиваем:

yumdownloader --destdir=/var/cache/yum/x86_64/7Server/<repo id>/packages chrony6.

Заодно сразу загрузим пакеты, необходимые для установки CDH. Они доступны на сайте

archive.cloudera.com—

archive.cloudera.com/cm///x86_64/cm//RPMS/x86_64/. Можно скачать пакеты руками (cloudera-manager-server и cloudera-manager-daemons) либо по аналогии добавить репозиторий и установить их:

yum install cloudera-manager-daemons cloudera-manager-server7.

После установки пакеты и их зависимости закешируются в папке /var/cache/yum/x86_64/7Server/\/packages. Переносим их на машину, выбранную под HTTP сервер и дистрибутивы, и устанавливаем:

rpm -ivh <имя пакета>8.

Запускаем httpd, делаем его видимым с других хостов нашего кластера, а также добавляем его в список сервисов, запускаемых автоматически после загрузки:

systemctl start httpd

systemctl enable httpd

systemctl stop firewalld # Требуется также сделать для остальных хостов

systemctl disable firewalld # Требуется также сделать для остальных хостов

setenforce 09.

Теперь у нас есть работающий HTTP сервер. Его рабочая директория

/var/www/html. Создадим в ней 2 папки — одну для репозитория yum, другую для парселей Cloudera (об этом чуть позже):

cd /var/www/html

mkdir yum_repo parcels10.

Для работы сервисов Cloudera нам потребуется

Java. На все машины требуется установить JDK одинаковой версии, Cloudera рекомендует Hot Spot от Oracle. Скачиваем дистрибутив с официального сайта (http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html) и переносим в папку

На все машины требуется установить JDK одинаковой версии, Cloudera рекомендует Hot Spot от Oracle. Скачиваем дистрибутив с официального сайта (http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html) и переносим в папку

.

11. Создадим в папке yum_repo репозиторий yum с помощью утилиты createrepo чтобы пакет с JDK стал доступен для установки с машин кластера:

createrepo -v /var/www/html/yum_repo/12.

После создания нашего локального репозитория на каждом из хостов требуется добавить его описание по аналогии с пунктом 2:

echo -e "\n[yum.local.repo]\nname=yum_repo\nbaseurl=http://<имя хоста с httpd>/yum_repo/\nenabled=1\ngpgcheck=0" > /etc/yum.repos.d/yum_repo.repoТакже можно сделать проверки, аналогичные пункту 2.

13. JDK доступен, устанавливаем:

yum install jdk1.8.0_161.x86_64 Для эксплуатации Java потребуется задать переменную JAVA_HOME.![]() Рекомендую сделать ее экспорт сразу после установки, а также записать ее в файлы

Рекомендую сделать ее экспорт сразу после установки, а также записать ее в файлы

и

/etc/default/bigtop-utilsчтобы она автоматически экспортировалась после перезапуска серверов и ее расположение предоставлялось сервисам CDH:

export JAVA_HOME=/usr/java/jdk1.8.0_161

echo "JAVA_HOME=/usr/java/jdk1.8.0_161" >> /etc/environment

export JAVA_HOME=/usr/java/jdk1.8.0_144 >> /etc/default/bigtop-utils14.

Таким же образом устанавливаем chronyd на всех машинах кластера (если, конечно, он отсутствует):

yum install chrony15.

Выбираем хост, на котором будет работать PostgreSQL, и устанавливаем его:

yum install postgresql-server16.

Аналогично, выбираем хост, на котором будет работать Cloudera Manager, и устанавливаем его:

yum install cloudera-manager-daemons cloudera-manager-server17.

Пакеты установлены, можно приступать к настройке ПО перед установкой.

Дополнение:

В ходе разработки и эксплуатации системы потребуется добавлять пакеты к репозиторий yum для их установки на хостах кластера (например дистрибутив Anaconda). Для этого помимо самого переноса файлов в папку yum_repo требуется выполнить следующие действия:

Настройка вспомогательного софта

Настало время сконфигурировать PostgreSQL и создать базы данных для наших будущих сервисов. Данные настройки актуальны для версии CDH 5.12.1, при установке других версий дистрибутива рекомендуется ознакомиться с разделом «Cloudera Manager and Managed Service Datastores» официального сайта.

Для начала произведем инициализации базы данных:

postgresql-setup initdbТеперь настраиваем сетевое взаимодействие с БД. В файле

/var/lib/pgsql/data/pg_hba.confв секции «IPv4 local connections» меняем метод для адреса 127.0.0.1/32 на метод «md5», добавляем метод «trust» и добавляем подсеть кластера с методом «trust»:

vi /var/lib/pgsql/data/pg_hba. conf

pg_hba.conf:

-----------------------------------------------------------------------

# TYPE DATABASE USER ADDRESS METHOD

# "local" is for Unix domain socket connections only

local all all peer

# IPv4 local connections:

host all all 127.0.0.1/32 md5

host all all 127.0.0.1/32 trust

host all all <cluster_subnet> trust

-----------------------------------------------------------------------

conf

pg_hba.conf:

-----------------------------------------------------------------------

# TYPE DATABASE USER ADDRESS METHOD

# "local" is for Unix domain socket connections only

local all all peer

# IPv4 local connections:

host all all 127.0.0.1/32 md5

host all all 127.0.0.1/32 trust

host all all <cluster_subnet> trust

-----------------------------------------------------------------------Затем внесем некоторые коррективы в файл /var/lib/pgsql/data/postgres.conf (приведу только те строки, которые надо изменить или проверить на соответствие:

vi /var/lib/pgsql/data/postgres.conf

postgres.conf:

-----------------------------------------------------------------------

listen_addresses = '*'

max_connections = 100

shared_buffers = 256MB

checkpoint_segments = 16

checkpoint_completion_target = 0. 9

logging_collector = on

log_filename = 'postgresql-%a.log'

log_truncate_on_rotation = on

log_rotation_age = 1d

log_rotation_size = 0

log_timezone = 'W-SU'

datestyle = 'iso, mdy'

timezone = 'W-SU'

lc_messages = 'en_US.UTF-8'

lc_monetary = 'en_US.UTF-8'

lc_numeric = 'en_US.UTF-8'

lc_time = 'en_US.UTF-8'

default_text_search_config = 'pg_catalog.english'

-----------------------------------------------------------------------

9

logging_collector = on

log_filename = 'postgresql-%a.log'

log_truncate_on_rotation = on

log_rotation_age = 1d

log_rotation_size = 0

log_timezone = 'W-SU'

datestyle = 'iso, mdy'

timezone = 'W-SU'

lc_messages = 'en_US.UTF-8'

lc_monetary = 'en_US.UTF-8'

lc_numeric = 'en_US.UTF-8'

lc_time = 'en_US.UTF-8'

default_text_search_config = 'pg_catalog.english'

-----------------------------------------------------------------------После окончания конфигурации требуется создать базы данных (для тех, кому ближе терминология Oracle – схемы) для сервисов, которые будем устанавливать. В нашем случае были установлены следующие сервисы: Cloudera Management Service, HDFS, Hive, Hue, Impala, Oozie, Yarn и ZooKeeper. Из них Hive, Hue и Oozie нуждаются в базах, а также 2 базы потребуются для нужд сервисов Cloudera – одна для сервера Cloudera Manager, другая для менеджера отчетов, входящего в Cloudera Management Service. Запустим и PostgreSQL и добавим его в автозагрузку:

systemctl start postgresql

systemctl enable postgresqlТеперь мы можем подключиться и создать нужные базы:

sudo -u postgres psql

> CREATE ROLE scm LOGIN PASSWORD '<password>';

> CREATE DATABASE scm OWNER scm ENCODING 'UTF8'; # Роль и база Cloudera Manager

> CREATE ROLE rman LOGIN PASSWORD '<password>';

> CREATE DATABASE rman OWNER rman ENCODING 'UTF8'; # Роль и база менеджера отчетов

> CREATE ROLE hive LOGIN PASSWORD '<password>';

> CREATE DATABASE metastore OWNER hive ENCODING 'UTF8'; # Роль и база Hive Metastore

> ALTER DATABASE metastore SET standard_conforming_strings = off; # Рекомендуется для PostgreSQL старше версии 8. 2.23

> CREATE ROLE hue_u LOGIN PASSWORD '<password>';

> CREATE DATABASE hue_d OWNER hue_u ENCODING 'UTF8'; # Роль и база Hue

> CREATE ROLE oozie LOGIN ENCRYPTED PASSWORD '<password>' NOSUPERUSER INHERIT CREATEDB NOCREATEROLE;

> CREATE DATABASE "oozie" WITH OWNER = oozie ENCODING = 'UTF8' TABLESPACE = pg_default LC_COLLATE = 'en_US.UTF-8' LC_CTYPE = 'en_US.UTF-8' CONNECTION LIMIT = -1; # Роль и база Oozie согласно рекомендациям официального сайта:

> \q

2.23

> CREATE ROLE hue_u LOGIN PASSWORD '<password>';

> CREATE DATABASE hue_d OWNER hue_u ENCODING 'UTF8'; # Роль и база Hue

> CREATE ROLE oozie LOGIN ENCRYPTED PASSWORD '<password>' NOSUPERUSER INHERIT CREATEDB NOCREATEROLE;

> CREATE DATABASE "oozie" WITH OWNER = oozie ENCODING = 'UTF8' TABLESPACE = pg_default LC_COLLATE = 'en_US.UTF-8' LC_CTYPE = 'en_US.UTF-8' CONNECTION LIMIT = -1; # Роль и база Oozie согласно рекомендациям официального сайта:

> \qДля других сервисов базы данных создаются аналогично.

Не забываем прогнать скрипт для подготовки базы сервера Cloudera Manager, передав ему на вход данные для подключения к созданной для него базе:

. /usr/share/cmf/schema/scm_prepare_database.sh postgresql scm scm <password>Создание репозитория с файлами CDH

Cloudera предоставляет 2 способа установки CDH – с помощью пакетов (packages) и с помощью парсэлей (parcels). Первый вариант предполагает скачивание набора пакетов с сервисами нужных версий и последующую их установку. Данный способ предоставляет большую гибкость конфигурации кластера, но Cloudera не гарантируют их совместимость. Поэтому более популярен второй вариант установки с использованием парсэлей – заранее сформированных наборов пакетов совместимых версий. Самые свежие версии доступны по следующей ссылке: archive.cloudera.com/cdh5/parcels/latest. Более ранние можно найти уровнем выше. Помимо самого парсэля с CDH требуется скачать manifest.json из той же директории репозитория.

Данный способ предоставляет большую гибкость конфигурации кластера, но Cloudera не гарантируют их совместимость. Поэтому более популярен второй вариант установки с использованием парсэлей – заранее сформированных наборов пакетов совместимых версий. Самые свежие версии доступны по следующей ссылке: archive.cloudera.com/cdh5/parcels/latest. Более ранние можно найти уровнем выше. Помимо самого парсэля с CDH требуется скачать manifest.json из той же директории репозитория.

Для эксплуатации разработанного функционала нам также требовался Spark 2.2, не входящий в парсэль CDH (там доступна первая версия данного сервиса). Для его установки требуется загрузить отдельный парсэль с данным сервисом и соответствующий manifest.json, также доступные в архиве Cloudera.

После загрузки парсэлей и manifest.json требуется перенести их в соответствующие папки нашего репозитория. Создаем отдельные папки для файлов CDH и Spark:

cd /var/www/html/parcels

mkdir cdh sparkПереносим в созданные папки парсэли и файлы manifest. json. Чтобы сделать их доступными для установки по сети выдаем папке с парсэлями соответствующие доступы:

json. Чтобы сделать их доступными для установки по сети выдаем папке с парсэлями соответствующие доступы:

chmod -R ugo+rX /var/www/html/parcelsМожно приступать к установке CDH, о чем я расскажу в следующем посте.

Распределенное хранение данных: от облака до блокчейна

Материал опубликован в рамках совместного спецпроекта ForkLog и Storj Labs «Блокчейн и хранение данных». С полным списком опубликованных материалов можно ознакомиться здесь.

Поиски эффективного применения технологии блокчейн распространяются не только на финансовый сектор и все, что с ним связано, но и на такие сферы, как распределенное хранение данных. Несмотря на достаточно высокую эффективность и популярность, проблемы с традиционными, то есть централизованными, хранилищами по-прежнему существуют.

Одна из самых показательных и громких историй — закрытие файлообменника MegaUpload, сервера которого были физически отключены провайдером LeaseWeb по требованию американских спецслужб. Сами основатели сервиса при этом были арестованы.

Сами основатели сервиса при этом были арестованы.

Неоднократно был скомпрометирован и такой популярный сервис как Dropbox. Примечательно, что в отличие от многих своих централизованных конкурентов Dropbox не использует шифрования данных, в то время как каждое децентрализованное хранилище по умолчанию шифрует данные пользователя.

К сожалению, большинство облачных сервисов хранения данных подвержено рискам, вытекающим из централизации, и распределенные системы с изначально заложенным потенциалом к постоянному расширению действительно могут быть гораздо эффективнее как с точки зрения стойкости к цензуре, так и с точки зрения безопасности в целом. И именно в сфере распределенного хранения данных блокчейн может изменить ситуацию кардинально.

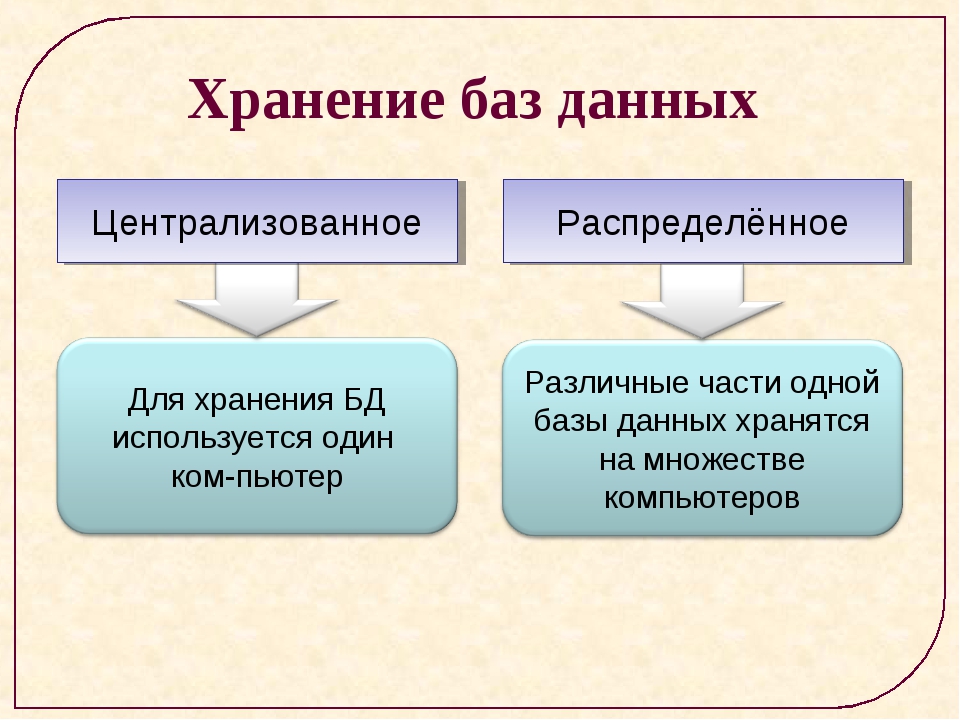

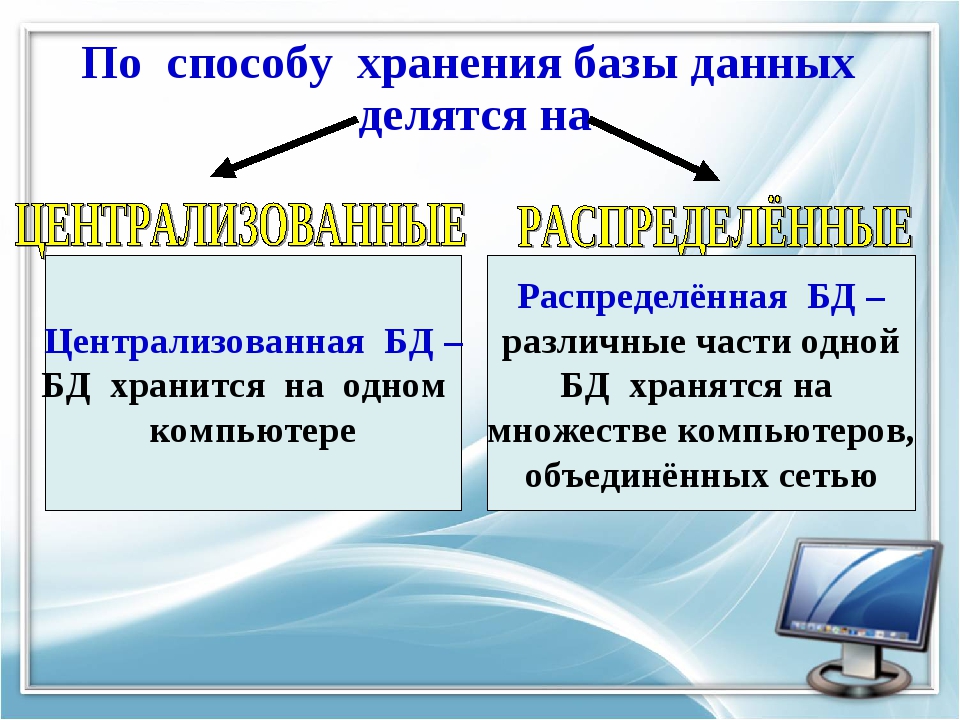

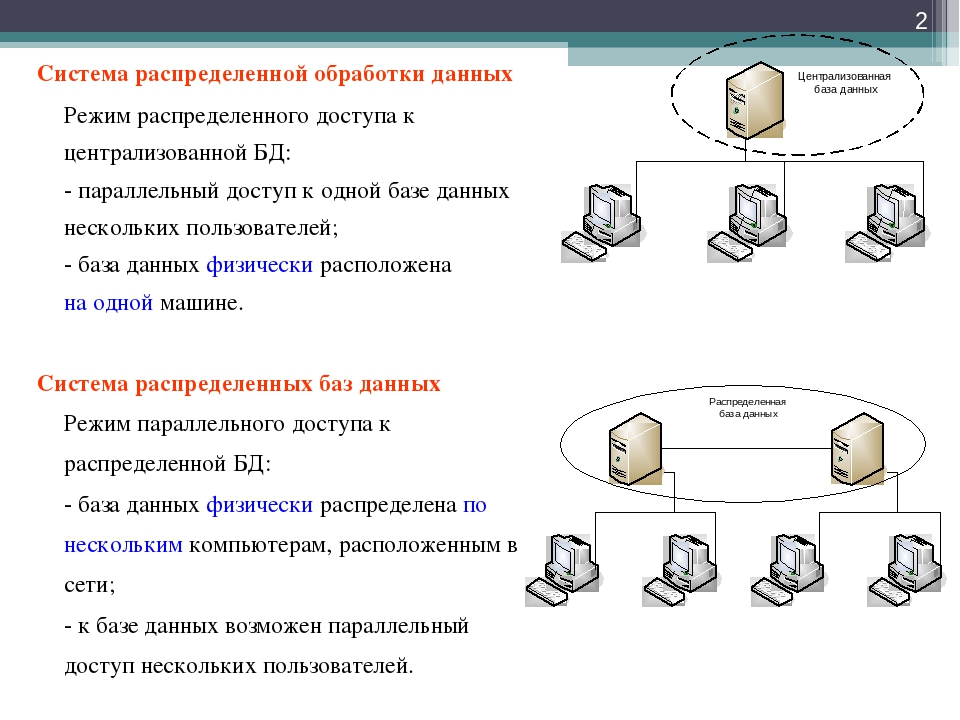

Если говорить о децентрализованном хранении данных как таковом, можно разделить его на два типа:

1) Принцип работы облачных хранилищ.

2) Принцип работы торрентов.

В случае с облачными хранилищами такое хранение данных не совсем корректно называть децентрализованным, поскольку в системе всегда есть некий единый оператор, который арендует оборудование у сторонних компаний или располагает собственными серверами. Одна из ключевых проблем современных облачных хранилищ заключается именно в частичной централизации всей системы.

Одна из ключевых проблем современных облачных хранилищ заключается именно в частичной централизации всей системы.

В случае с торрентами файлы могут храниться у обычных пользователей, которые таким образом вносят свой вклад в развитие сети и как бы предоставляют свои услуги по хранению данных в обмен на возможность скачивать файлы от других пользователей. При этом в такой сети могут присутствовать и достаточно крупные сервера, на которых хранится большое количество файлов, поэтому, строго говоря, система такого типа содержит свои риски централизации. Но ключевой недостаток торрентов состоит в отсутствии четко определенных и ощутимых стимулов для участников сети.

И здесь как нельзя кстати можно вспомнить о концепции криптовалюты Permacoin, которая была предложена рабочей группой Microsoft Research еще в 2010 году. Очень упрощенно Permacoin — это протокол, похожий на торрент, с внутренним токеном, который используется для вознаграждения пользователей за хранение данных. Одной из предпосылок к работе над концепцией Permacoin для рабочей группы стало желание утилизировать ресурсы майнеров более полезным образом, чем это происходит в случае с биткоином. Правда, и сам майнинг при этом решении был бы устроен иначе, чем обсчитывание хешей.

Правда, и сам майнинг при этом решении был бы устроен иначе, чем обсчитывание хешей.

Таким образом, возвращаясь к облачным хранилищам и торрентам, будет более корректно и уместно использовать термин «распределенное хранение данных», а не децентрализованное.

И поскольку идея использования блокчейна для распределенного хранения данных лежит на поверхности, на данный момент уже существует несколько проектов, работающих в данном направлении. На сегодняшний день к проектам, которые работают в направлении применения блокчейна для распределенного хранения данных и дистрибуции контента относятся: Storj, Sia, MaidSafe, Decent, LBRY Credits, FileCoin и другие.

STORJ

Проект был запущен в 2014 году. Токен SJCX выпущен через протокол Counterparty, который работает поверх блокчейна биткоина. Стоит отметить, что совсем недавно представители Storj заявили о переносе токена и основной архитектуры проекта на блокчейн Ethereum, поскольку обслуживание в рамках сети биткоина стало обходиться слишком дорого, и, что самое главное, — слишком медленно. Перенос на Ethereum состоится после очередного этапа привлечения средств через Token Sale, который стартует 19 мая.

Перенос на Ethereum состоится после очередного этапа привлечения средств через Token Sale, который стартует 19 мая.

На данный момент цена хранения 1 GB данных при пропускной способности в 30 GB в месяц обходится в $1.51. При этом стоит ожидать, что после переноса проекта на блокчейн Ethereum стоимость хранения данных снизится.

по данным storj.io

Принцип хранения данных в Storj устроен достаточно просто. Файл, загружаемый пользователем в сеть, шифруется так, чтобы доступ к нему был только у владельца. Полученный результат разбивается на несколько частей и отправляется в сеть. Ниже приведена схема, описывающая базовый принцип хранения данных в системе.

Схема, описывающая принцип хранения данных в системе Storj

Процесс предоставления дискового пространства для хранения данных в обмен на токены проекта называется фарминг. На ранней стадии развития проекта, чтобы начать фарминг, нужно было иметь в своем кошельке 10 000 монет SJCX, однако впоследствии это правило отменили.

MaidSafe

Команда проекта родом из Шотландии и разрабатывает инфраструктуру для децентрализованного хранения данных c 2006 года. Сама монета MaidSafe существует и торгуется на биржах с 2014 года. Токен был выпущен через протокол MasterCoin, существующий поверх протокола Bitcoin. Стоит сразу отметить, что блокчейн не используется в данном проекте для достижения консенсуса, фактически использование распределенного реестра ограничено выпуском токена и внедрением некоторых дополнительных функций. О том, как может достигаться консенсус без блокчейна, команда опубликовала достаточно подробный и аргументированный пост в официальном блоге проекта еще в 2015 году.

На данный момент на официальном сайте доступна первая альфа-версия проекта, однако точные даты по следующим релизам пока неизвестны. Помимо хранения данных, MaidSafe предлагает безопасный доступ к информации пользователя без взаимодействия с третьей стороной. Простыми словами, никому не нужно хранить записи о файлах пользователя или информации, необходимой для авторизации, соответственно, и доступ к данным и их дешифровке есть только у владельца.

Все файлы, загруженные пользователем в сеть, шифруются и разбиваются на небольшие части, называемые чанками, которые распространяются по всей сети. При этом благодаря сложной системе аутентификации, доступ к итоговому файлу и его чанкам есть только у владельца данных.

Вместо майнинга в сети MaidSafe также используется понятие фарминг, а сам процесс заключается в предоставлении дискового пространства и вычислительных мощностей компьютера для обслуживания сети и хранения файлов, загруженных пользователями. В качестве награды за фарминг пользователи получают токены SafeCoin.

Стоит отметить, что торгуемый на данный момент на биржах токен MAID (MaidSafeCoin) подлежит обмену на токен SafeCoin, а сама процедура обмена будет запущена после окончательного релиза продукта. Учитывая специфику развития биткоина за последние три года, есть вероятность, что этот токен будет выпущен поверх другой блокчейн-системы.

SIA

Проект существует с 2015 года и использует блокчейн, близкий по своим свойствам к блокчейну биткоина. Логика хранения данных у SIA схожа с MaidSafe: файлы пользователя шифруются, разбиваются на части и распределяются по децентрализованной сети. Доступ к файлам пользователя осуществляется через приватный ключ, так что никто кроме владельца не может получить доступ к загруженной в сеть информации. Награда за предоставление дискового пространства распределяется в токенах SIA.

Логика хранения данных у SIA схожа с MaidSafe: файлы пользователя шифруются, разбиваются на части и распределяются по децентрализованной сети. Доступ к файлам пользователя осуществляется через приватный ключ, так что никто кроме владельца не может получить доступ к загруженной в сеть информации. Награда за предоставление дискового пространства распределяется в токенах SIA.

Любопытны и представленные на сайте проекта расчеты о стоимости хранения данных в сети SIA в сравнении с популярными облачными хранилищами. Согласно представленной калькуляции, хранение 1 Тб информации в сети SIA обойдется как минимум в 10 раз дешевле, чем на таких сервисах как Amazon S3 или Microsoft Azure.

по данным sia.tech

Команда проекта даже выпустила отличную и достаточно подробную инфографику, описывающую устройство SIA.

Вместо заключения

На данный момент распределенное хранение данных, наряду с распределенными вычислениями, — один из основных трендов блокчейн-экономики. Многие проекты все еще находятся на ранней стадии разработки и тестировании гипотез, соответственно, о реальной конкуренции с централизованными сервисами хранения пока говорить рано. Но в случае сохранения динамики роста блокчейн-рынка, в скором времени распределенные хранилища на блокчейне будут конкурировать между собой. И основными параметрами конкуренции станут скорость, масштабируемость, безопасность и низкая стоимость услуг.

Но в случае сохранения динамики роста блокчейн-рынка, в скором времени распределенные хранилища на блокчейне будут конкурировать между собой. И основными параметрами конкуренции станут скорость, масштабируемость, безопасность и низкая стоимость услуг.

Нашли ошибку в тексте? Выделите ее и нажмите CTRL+ENTER

Современные распределенные хранилища данных: обзор технологий и перспективы

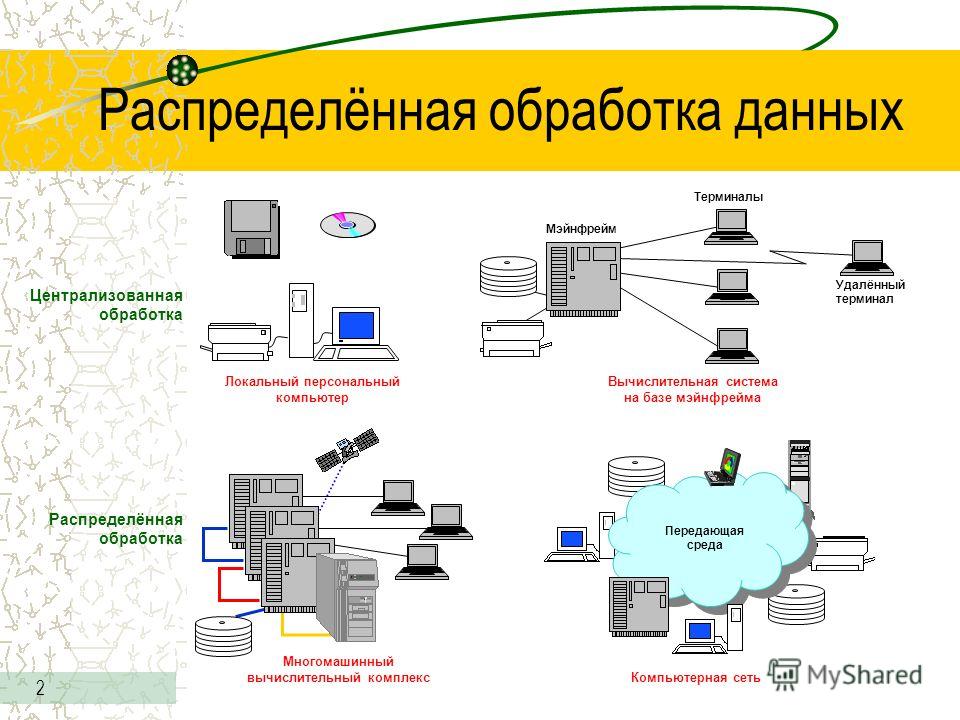

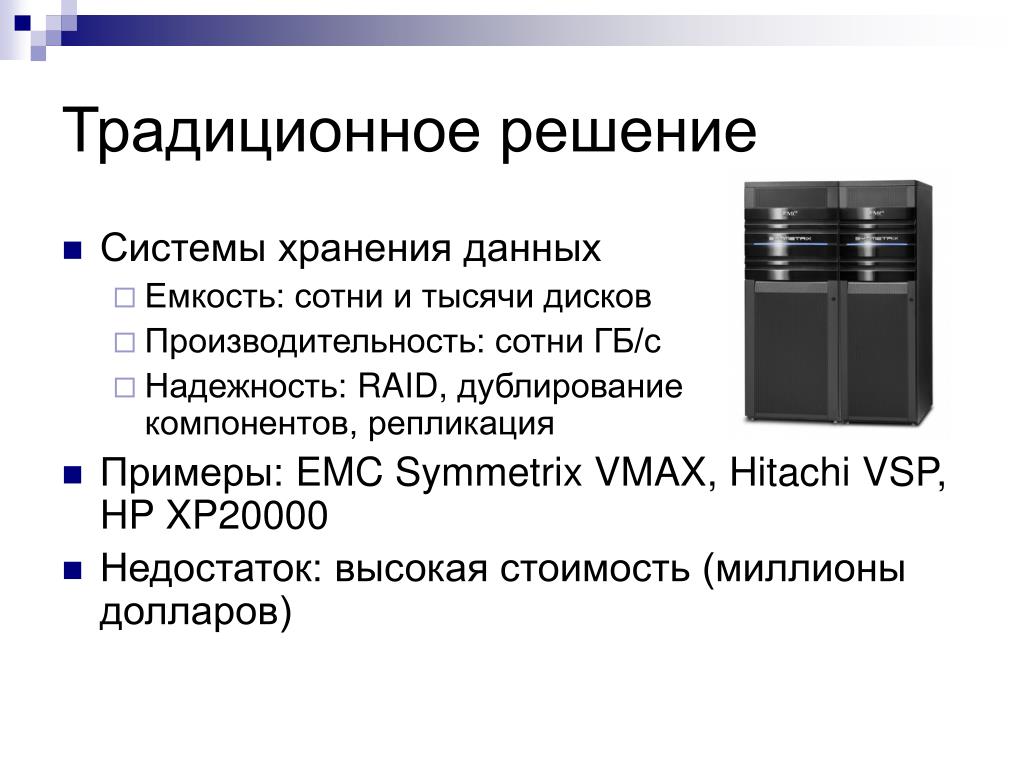

Сегодня поговорим о том, как лучше хранить данные в мире, где сети пятого поколения, сканеры геномов и беспилотные автомобили производят за день больше данных, чем всё человечество породило в период до промышленной революции. Наш мир генерирует всё больше информации. Какая-то её часть мимолётна и утрачивается так же быстро, как и собирается. Другая должна храниться дольше, а иная и вовсе рассчитана «на века» — по крайней мере, так нам видится из настоящего. Информационные потоки оседают в дата-центрах с такой скоростью, что любой новый подход, любая технология, призванные удовлетворить этот бесконечный «спрос», стремительно устаревают. 40 лет развития распределённых СХД. Первые сетевые хранилища в привычном нам виде появились в 1980-х. Многие из вас сталкивались с NFS (Network File System), AFS (Andrew File System) или Coda. Спустя десятилетие мода и технологии изменились, а распределённые файловые системы уступили место кластерным СХД на основе GPFS (General Parallel File System), CFS (Clustered File Systems) и StorNext. В качестве базиса использовались блочные хранилища классической архитектуры, поверх которых с помощью программного слоя создавалась единая файловая система. Эти и подобные решения до сих пор применяются, занимают свою нишу и вполне востребованы.

40 лет развития распределённых СХД. Первые сетевые хранилища в привычном нам виде появились в 1980-х. Многие из вас сталкивались с NFS (Network File System), AFS (Andrew File System) или Coda. Спустя десятилетие мода и технологии изменились, а распределённые файловые системы уступили место кластерным СХД на основе GPFS (General Parallel File System), CFS (Clustered File Systems) и StorNext. В качестве базиса использовались блочные хранилища классической архитектуры, поверх которых с помощью программного слоя создавалась единая файловая система. Эти и подобные решения до сих пор применяются, занимают свою нишу и вполне востребованы.

Воспользуйтесь нашими услугами

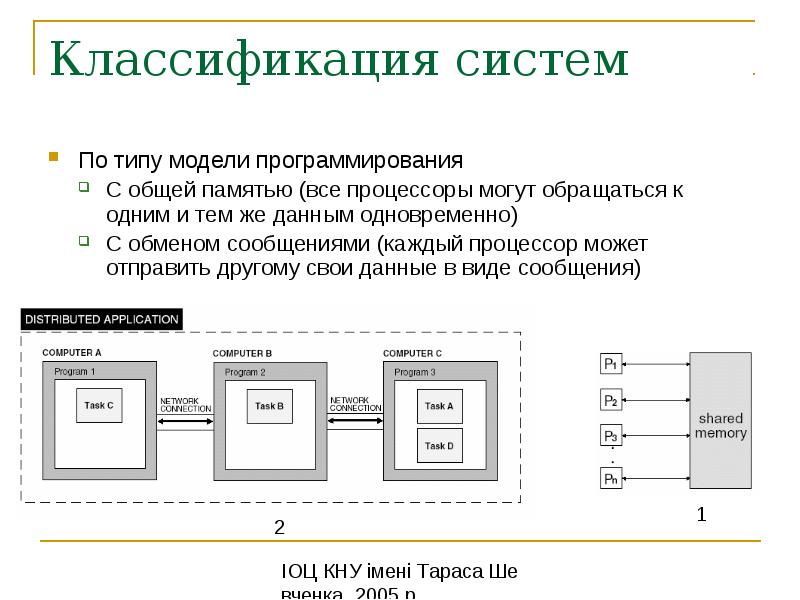

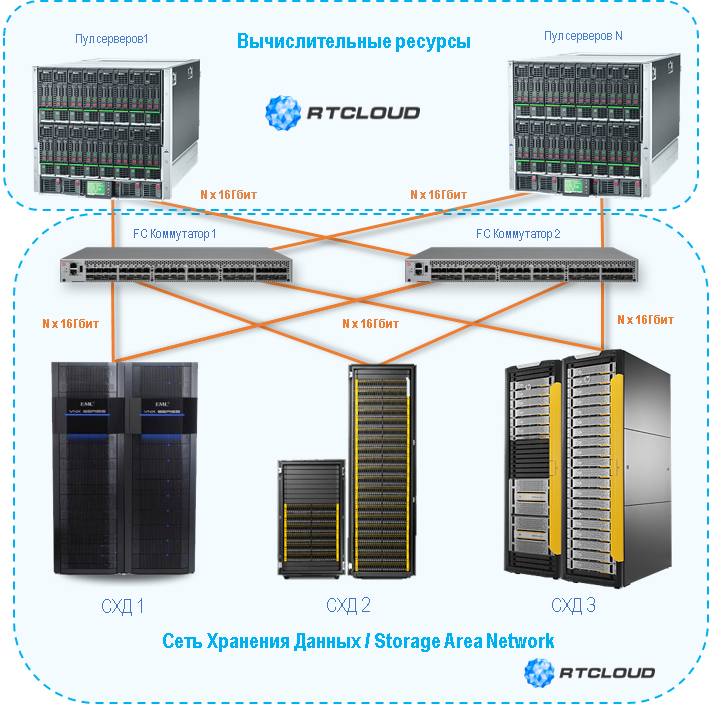

На рубеже тысячелетий парадигма распределённых хранилищ несколько поменялась, и на лидирующие позиции вышли системы с архитектурой SN (Shared-Nothing). Произошёл переход от кластерного хранения к хранению на отдельных узлах, в качестве которых, как правило, выступали классические серверы с обеспечивающим надёжное хранение ПО; на таких принципах построены, скажем, HDFS (Hadoop Distributed File System) и GFS (Global File System).

Ближе к 2010-м заложенные в основу распределённых систем хранения концепции всё чаще стали находить отражение в полноценных коммерческих продуктах, таких как VMware vSAN, Dell EMC Isilon и наша Huawei OceanStor. За упомянутыми платформами стоит уже не сообщество энтузиастов, а конкретные вендоры, которые отвечают за функциональность, поддержку, сервисное обслуживание продукта и гарантируют его дальнейшее развитие. Такие решения наиболее востребованы в нескольких сферах.

Операторы связи

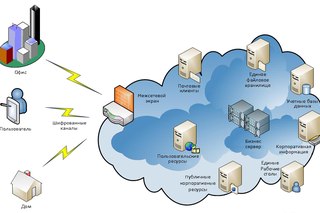

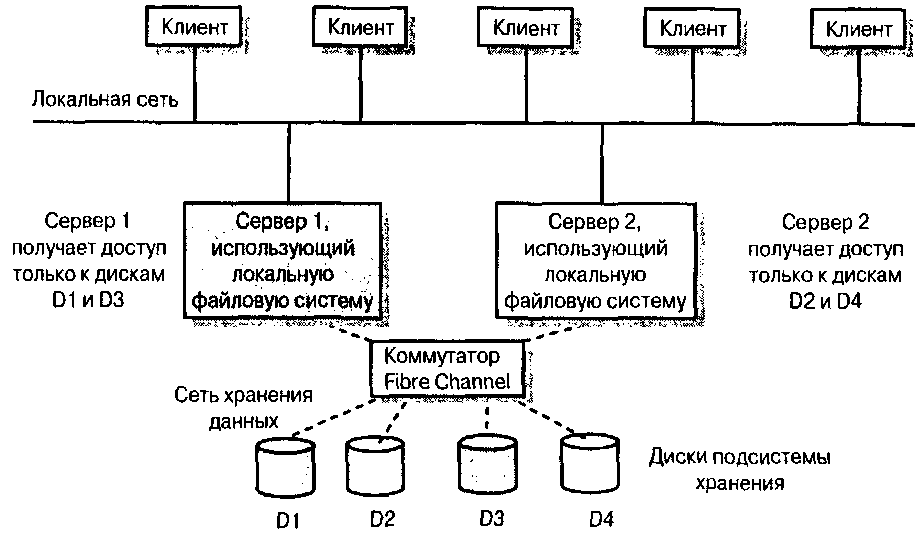

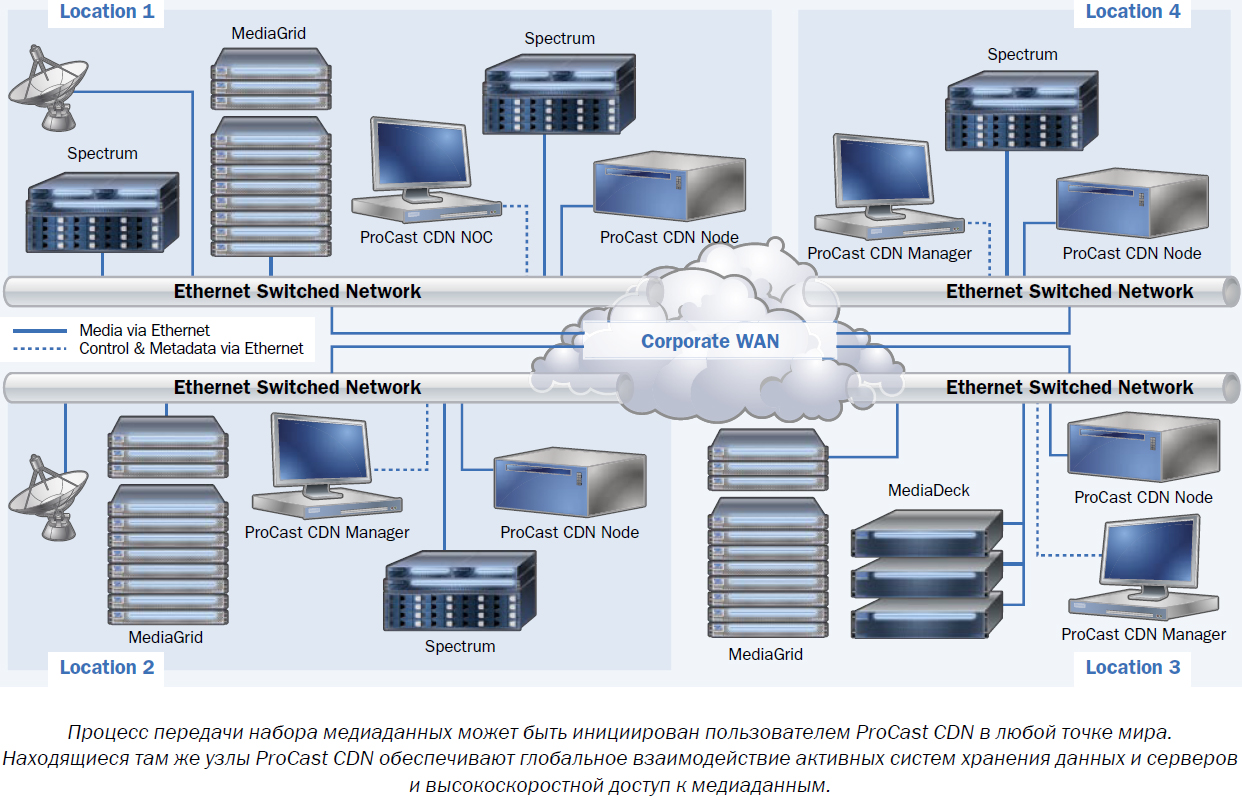

Пожалуй, одними из старейших потребителей распределённых систем хранения являются операторы связи. На схеме видно, какие группы приложений производят основной объём данных. OSS (Operations Support Systems), MSS (Management Support Services) и BSS (Business Support Systems) представляют собой три дополняющих друг друга программных слоя, необходимых для предоставления сервиса абонентам, финансовой отчётности провайдеру и эксплуатационной поддержки инженерам оператора.

Зачастую данные этих слоев сильно перемешаны между собой, и, чтобы избежать накопления ненужных копий, как раз и используются распределённые хранилища, которые аккумулируют весь объём информации, поступающей от работающей сети..png) Хранилища объединяются в общий пул, к которому и обращаются все сервисы.

Хранилища объединяются в общий пул, к которому и обращаются все сервисы.

Наши расчёты показывают, что переход от классических СХД к блочным позволяет сэкономить до 70% бюджета только за счёт отказа от выделенных СХД класса hi-end и использования обычных серверов классической архитектуры (обычно x86), работающих в связке со специализированным ПО. Сотовые операторы уже довольно давно начали приобретать подобные решения в серьезных объёмах. В частности, российское операторы используют такие продукты от Huawei более шести лет.

Да, ряд задач с помощью распределённых систем выполнить не получится. Например, при повышенных требованиях к производительности или к совместимости со старыми протоколами. Но не менее 70% данных, которые обрабатывает оператор, вполне можно расположить в распределённом пуле.

Банковская сфера

В любом банке соседствует множество разношёрстных IT-систем, начиная с процессинга и заканчивая автоматизированной банковской системой. Эта инфраструктура тоже работает с огромным объёмом информации, при этом большая часть задач не требует повышенной производительности и надёжности систем хранения, например разработка, тестирование, автоматизация офисных процессов и пр. Здесь применение классических СХД возможно, но с каждым годом всё менее выгодно. К тому же в этом случае отсутствует гибкость расходования ресурсов СХД, производительность которой рассчитывается из пиковой нагрузки.

Здесь применение классических СХД возможно, но с каждым годом всё менее выгодно. К тому же в этом случае отсутствует гибкость расходования ресурсов СХД, производительность которой рассчитывается из пиковой нагрузки.

При использовании распределённых систем хранения их узлы, по факту являющиеся обычными серверами, могут быть в любой момент конвертированы, например, в серверную ферму и использованы в качестве вычислительной платформы.

Озёра данных

На схеме выше приведён перечень типичных потребителей сервисов data lake. Это могут быть службы электронного правительства (допустим, «Госуслуги»), прошедшие цифровизацию предприятия, финансовые структуры и др. Всем им необходимо работать с большими объёмами разнородной информации.

Эксплуатация классических СХД для решения таких задач неэффективна, так как требуется и высокопроизводительный доступ к блочным базам данных, и обычный доступ к библиотекам сканированных документов, хранящихся в виде объектов. Сюда же может быть привязана, допустим, система заказов через веб-портал. Чтобы всё это реализовать на платформе классической СХД, потребуется большой комплект оборудования под разные задачи. Одна горизонтальная универсальная система хранения вполне может закрывать все ранее перечисленные задачи: понадобится лишь создать в ней несколько пулов с разными характеристиками хранения.

Чтобы всё это реализовать на платформе классической СХД, потребуется большой комплект оборудования под разные задачи. Одна горизонтальная универсальная система хранения вполне может закрывать все ранее перечисленные задачи: понадобится лишь создать в ней несколько пулов с разными характеристиками хранения.

Генераторы новой информации

Количество хранимой в мире информации растёт примерно на 30% в год. Это хорошие новости для поставщиков систем хранения, но что же является и будет являться основным источником этих данных?

Десять лет назад такими генераторами стали социальные сети, это потребовало создания большого количества новых алгоритмов, аппаратных решений и т. д. Сейчас выделяются три главных драйвера роста объёмов хранения. Первый — cloud computing. В настоящее время примерно 70% компаний так или иначе используют облачные сервисы. Это могут быть электронные почтовые системы, резервные копии и другие виртуализированные сущности.

Вторым драйвером становятся сети пятого поколения..jpg) Это новые скорости и новые объёмы передачи данных. По нашим прогнозам, широкое распространение 5G приведёт к падению спроса на карточки флеш-памяти. Сколько бы ни было памяти в телефоне, она всё равно кончается, а при наличии в гаджете 100-мегабитного канала нет никакой необходимости хранить фотографии локально.

Это новые скорости и новые объёмы передачи данных. По нашим прогнозам, широкое распространение 5G приведёт к падению спроса на карточки флеш-памяти. Сколько бы ни было памяти в телефоне, она всё равно кончается, а при наличии в гаджете 100-мегабитного канала нет никакой необходимости хранить фотографии локально.

К третьей группе причин, по которым растёт спрос на системы хранения, относятся бурное развитие искусственного интеллекта, переход на аналитику больших данных и тренд на всеобщую автоматизацию всего, чего только можно.

Особенностью «нового трафика» является его неструктурированность. Нам надо хранить эти данные, никак не определяя их формат. Он требуется лишь при последующем чтении. К примеру, банковская система скоринга для определения доступного размера кредита будет смотреть выложенные вами в соцсетях фотографии, определяя, часто ли вы бываете на море и в ресторанах, и одновременно изучать доступные ей выписки из ваших медицинских документов. Эти данные, с одной стороны, всеобъемлющи, а с другой — лишены однородности.

Океан неструктурированных данных

Какие же проблемы влечет за собой появление «новых данных»? Первейшая среди них, конечно, сам объём информации и расчётные сроки её хранения. Один только современный автономный автомобиль без водителя каждый день генерирует до 60 Тбайт данных, поступающих со всех его датчиков и механизмов. Для разработки новых алгоритмов движения эту информацию необходимо обработать за те же сутки, иначе она начнёт накапливаться. При этом храниться она должна очень долго — десятки лет. Только тогда в будущем можно будет делать выводы на основе больших аналитических выборок.

Одно устройство для расшифровки генетических последовательностей производит порядка 6 Тбайт в день. А собранные с его помощью данные вообще не подразумевают удаления, то есть гипотетически должны храниться вечно.

Наконец, всё те же сети пятого поколения. Помимо собственно передаваемой информации, такая сеть и сама является огромным генератором данных: журналов действий, записей звонков, промежуточных результатов межмашинных взаимодействий и пр.

Всё это требует выработки новых подходов и алгоритмов хранения и обработки информации. И такие подходы появляются.

Технологии новой эпохи

Можно выделить три группы решений, призванных справиться с новыми требованиями к системам хранения информации: внедрение искусственного интеллекта, техническая эволюция носителей данных и инновации в области системной архитектуры. Начнём с ИИ.

В новых решениях Huawei искусственный интеллект используется уже на уровне самого хранилища, которое оборудовано ИИ-процессором, позволяющим системе самостоятельно анализировать своё состояние и предсказывать отказы. Если СХД подключить к сервисному облаку, которое обладает значительными вычислительными способностями, искусственный интеллект сможет обработать больше информации и повысить точность своих гипотез.

Помимо отказов, такой ИИ умеет прогнозировать будущую пиковую нагрузку и время, остающееся до исчерпания ёмкости. Это позволяет оптимизировать производительность и масштабировать систему ещё до наступления каких-либо нежелательных событий..jpg)

Теперь об эволюции носителей данных. Первые флеш-накопители были выполнены по технологии SLC (Single-Level Cell). Основанные на ней устройства были быстрыми, надёжными, стабильными, но имели небольшую ёмкость и стоили очень дорого. Роста объёма и снижения цены удалось добиться путём определённых технических уступок, из-за которых скорость, надёжность и срок службы накопителей сократились. Тем не менее тренд не повлиял на сами СХД, которые за счёт различных архитектурных ухищрений в целом стали и более производительными, и более надёжными.

Но почему понадобились СХД класса All-Flash? Разве недостаточно было просто заменить в уже эксплуатируемой системе старые HDD на новые SSD того же форм-фактора? Потребовалось это для того, чтобы эффективно использовать все ресурсы новых твердотельных накопителей, что в старых системах было попросту невозможно.

Компания Huawei, например, для решения этой задачи разработала целый ряд технологий, одной из которых стала FlashLink, позволившая максимально оптимизировать взаимодействия «диск — контроллер».

Интеллектуальная идентификация дала возможность разложить данные на несколько потоков и справиться с рядом нежелательных явлений, таких как WA (write amplification). Вместе с тем новые алгоритмы восстановления, в частности RAID 2.0+, повысили скорость ребилда, сократив его время до совершенно незначительных величин.

Отказ, переполненность, «сборка мусора» — эти факторы также больше не влияют на производительность системы хранения благодаря специальной доработке контроллеров.

А ещё блочные хранилища данных готовятся встретить NVMe. Напомним, что классическая схема организации доступа к данным работала так: процессор обращался к RAID-контроллеру по шине PCI Express. Тот, в свою очередь, взаимодействовал с механическими дисками по SCSI или SAS. Применение NVMe на бэкенде заметно ускорило весь процесс, однако несло в себе один недостаток: накопители должны были иметь непосредственное подключение к процессору, чтобы обеспечить тому прямой доступ в память.

Следующей фазой развития технологии, которую мы наблюдаем сейчас, стало применение NVMe-oF (NVMe over Fabrics). Что касается блочных технологий Huawei, они уже сейчас поддерживают FC-NVMe (NVMe over Fibre Channel), и на подходе NVMe over RoCE (RDMA over Converged Ethernet). Тестовые модели вполне функциональны, до официальной их презентации осталось несколько месяцев. Заметим, что всё это появится и в распределённых системах, где «Ethernet без потерь» будет весьма востребован.

Что касается блочных технологий Huawei, они уже сейчас поддерживают FC-NVMe (NVMe over Fibre Channel), и на подходе NVMe over RoCE (RDMA over Converged Ethernet). Тестовые модели вполне функциональны, до официальной их презентации осталось несколько месяцев. Заметим, что всё это появится и в распределённых системах, где «Ethernet без потерь» будет весьма востребован.

Дополнительным способом оптимизации работы именно распределённых хранилищ стал полный отказ от зеркалирования данных. Решения Huawei больше не используют n копий, как в привычном RAID 1, и полностью переходят на механизм EC (Erasure coding). Специальный математический пакет с определённой периодичностью вычисляет контрольные блоки, которые позволяют восстановить промежуточные данные в случае их потери.

Механизмы дедупликации и сжатия становятся обязательными. Если в классических СХД мы ограничены количеством установленных в контроллеры процессоров, то в распределённых горизонтально масштабируемых системах хранения каждый узел содержит всё необходимое: диски, память, процессоры и интерконнект. Этих ресурсов достаточно, чтобы дедупликация и компрессия оказывали на производительность минимальное влияние.

Этих ресурсов достаточно, чтобы дедупликация и компрессия оказывали на производительность минимальное влияние.

И об аппаратных методах оптимизации. Здесь снизить нагрузку на центральные процессоры удалось с помощью дополнительных выделенных микросхем (или выделенных блоков в самом процессоре), играющих роль TOE (TCP/IP Offload Engine) или берущих на себя математические задачи EC, дедупликации и компрессии.

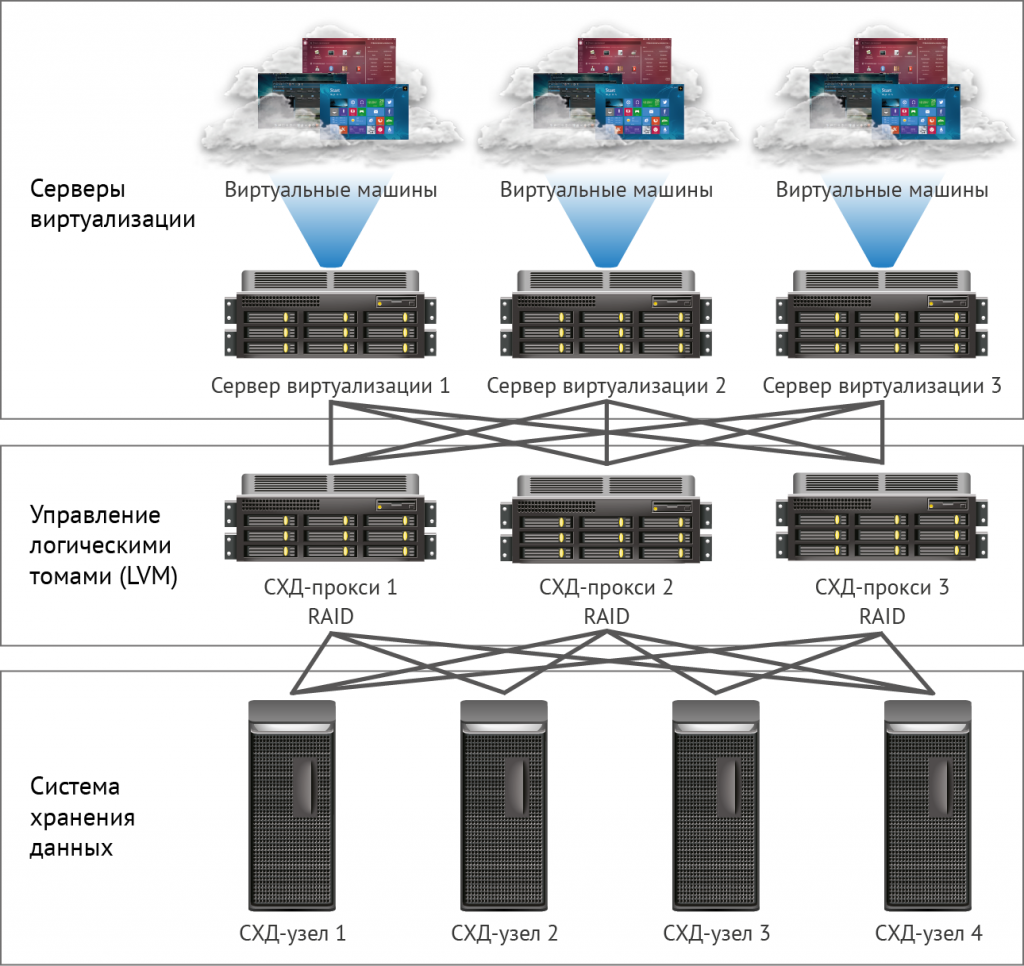

Новые подходы к хранению данных нашли воплощение в дезагрегированной (распределённой) архитектуре. В системах централизованного хранения имеется фабрика серверов, по Fibre Channel подключённая к SAN с большим количеством массивов. Недостатками такого подхода являются трудности с масштабированием и обеспечением гарантированного уровня услуги (по производительности или задержкам). Гиперконвергентные системы используют одни и те же хосты — как для хранения, так и для обработки информации. Это даёт практически неограниченный простор масштабирования, но влечёт за собой высокие затраты на поддержание целостности данных.

В отличие от обеих вышеперечисленных, дезагрегированная архитектура подразумевает разделение системы на вычислительную фабрику и горизонтальную систему хранения. Это обеспечивает преимущества обеих архитектур и позволяет практически неограниченно масштабировать только тот элемент, производительности которого не хватает.

От интеграции к конвергенции

Классической задачей, актуальность которой последние 15 лет лишь росла, является необходимость одновременно обеспечить блочное хранение, файловый доступ, доступ к объектам, работу фермы для больших данных и т. д. Вишенкой на торте может быть ещё, например, система бэкапа на магнитную ленту.

На первом этапе унифицировать удавалось только управление этими услугами. Разнородные системы хранения данных замыкались на какое-либо специализированное ПО, посредством которого администратор распределял ресурсы из доступных пулов. Но так как аппаратно эти пулы были разными, миграция нагрузки между ними была невозможна. На более высоком уровне интеграции объединение происходило на уровне шлюза. При наличии общего файлового доступа его можно было отдавать через разные протоколы.

На более высоком уровне интеграции объединение происходило на уровне шлюза. При наличии общего файлового доступа его можно было отдавать через разные протоколы.

Самый совершенный из доступных нам сейчас методов конвергенции подразумевает создание универсальной гибридной системы. Именно такой, какой должна стать наша OceanStor 100D. Универсальный доступ использует те же самые аппаратные ресурсы, логически разделённые на разные пулы, но допускающие миграцию нагрузки. Всё это можно сделать через единую консоль управления. Таким способом нам удалось реализовать концепцию «один ЦОД — одна СХД».

Стоимость хранения информации сейчас определяет многие архитектурные решения. И хотя её можно смело ставить во главу угла, мы сегодня обсуждаем «живое» хранение с активным доступом, так что производительность тоже необходимо учитывать. Ещё одним важным свойством распределённых систем следующего поколения является унификация. Ведь никто не хочет иметь несколько разрозненных систем, управляемых из разных консолей. Все эти качества нашли воплощение в новой серии продуктов Huawei OceanStor Pacific.

Все эти качества нашли воплощение в новой серии продуктов Huawei OceanStor Pacific.

Массовая СХД нового поколения

OceanStor Pacific отвечает требованиям надёжности на уровне «шести девяток» (99,9999%) и может использоваться для создания ЦОД класса HyperMetro. При расстоянии между двумя дата-центрами до 100 км системы демонстрируют добавочную задержку на уровне 2 мс, что позволяет строить на их основе любые катастрофоустойчивые решения, в том числе и с кворум-серверами.

Продукты новой серии демонстрируют универсальность по протоколам. Уже сейчас OceanStor 100D поддерживает блочный доступ, объектовый доступ и доступ Hadoop. В ближайшее время будет реализован и файловый доступ. Нет нужды хранить несколько копий данных, если их можно выдавать через разные протоколы.

Казалось бы, какое отношение концепция «сеть без потерь» имеет к СХД? Дело в том, что распределённые системы хранения данных строятся на основе быстрой сети, поддерживающей соответствующие алгоритмы и механизм RoCE. Дополнительно увеличить скорость сети и снизить задержки помогает поддерживаемая нашими коммутаторами система искусственного интеллекта AI Fabric. Выигрыш производительности СХД при активации AI Fabric может достигать 20%.

Дополнительно увеличить скорость сети и снизить задержки помогает поддерживаемая нашими коммутаторами система искусственного интеллекта AI Fabric. Выигрыш производительности СХД при активации AI Fabric может достигать 20%.

Что же представляет собой новый узел распределённой СХД OceanStor Pacific? Решение форм-фактора 5U включает в себя 120 накопителей и может заменить три классических узла, что даёт более чем двукратную экономию места в стойке. За счёт отказа от хранения копий КПД накопителей ощутимо возрастает (до +92%).

Мы привыкли к тому, что программно-определяемая СХД — это специальное ПО, устанавливаемое на классический сервер. Но теперь для достижения оптимальных параметров это архитектурное решение требует и специальных узлов. В его состав входят два сервера на базе ARM-процессоров, управляющие массивом трёхдюймовых накопителей.

Эти серверы мало подходят для гиперконвергентных решений. Во-первых, приложений для ARM достаточно мало, а во-вторых, трудно соблюсти баланс нагрузки. Мы предлагаем перейти к раздельному хранению: вычислительный кластер, представленный классическими или rack-серверами, функционирует отдельно, но подключается к узлам хранения OceanStor Pacific, которые также выполняют свои прямые задачи. И это себя оправдывает.

Мы предлагаем перейти к раздельному хранению: вычислительный кластер, представленный классическими или rack-серверами, функционирует отдельно, но подключается к узлам хранения OceanStor Pacific, которые также выполняют свои прямые задачи. И это себя оправдывает.

Для примера возьмём классическое решение для хранения больших данных с гиперконвергентной системой, занимающее 15 серверных стоек. Если распределить нагрузку между отдельными вычислительными серверами и узлами СХД OceanStor Pacific, отделив их друг от друга, количество необходимых стоек сократится в два раза! Это снижает затраты на эксплуатацию дата-центра и уменьшает совокупную стоимость владения. В мире, где объём хранимой информации растет на 30% в год, подобными преимуществами не разбрасываются.

Автор: denisdubinin3

Источник: https://habr.com/

Воспользуйтесь нашими услугами

Понравилась статья? Тогда поддержите нас, поделитесь с друзьями и заглядывайте по рекламным ссылкам!

база данных, кеш, файловое хранилище

Современные приложения оперируют различными типами данных, которые хранятся в базах данных (БД). Это могут быть целочисленные, строковые, бинарные, дата-временные и другие. Такие базы данных, как MySQL или PostgreSQL, могут хранить в себе любые объёмы самых различных данных, но эффективно ли размещать в одном экземпляре всё подряд? Мы опытным путём разделили данные на три категории: часто используемые, текстово-числовые и файловые. В часто используемые попадают те данные, к которым наиболее часто обращаются пользователи. Файловые — это все файлы, в основном картинки, видео и архивы.

Это могут быть целочисленные, строковые, бинарные, дата-временные и другие. Такие базы данных, как MySQL или PostgreSQL, могут хранить в себе любые объёмы самых различных данных, но эффективно ли размещать в одном экземпляре всё подряд? Мы опытным путём разделили данные на три категории: часто используемые, текстово-числовые и файловые. В часто используемые попадают те данные, к которым наиболее часто обращаются пользователи. Файловые — это все файлы, в основном картинки, видео и архивы.

Для каждой категории мы используем отдельное хранилище — такой подход повышает эффективность работы с данными.

Управление ИТ услугами

Реляционное хранилище

Главным местом хранения данных любого приложения является реляционная база данных. SimpleOne использует PostgreSQL для текстово-числовых данных. Эта реляционная система управления базами данных выбрана за стабильность и надёжность, а также множество встроенных инструментов для работы с таблицами и дополнительных модулей. База данных открыто распространяется, имеет огромное комьюнити и постоянно развивается. Например, мы используем встроенный инструмент глобального поиска, и он отлично работает в нашей системе, нет необходимости разрабатывать собственные решения или искать дополнительные расширения. В будущем, с развитием нашей платформы, PostgreSQL всегда сможет удовлетворить наши запросы.

База данных открыто распространяется, имеет огромное комьюнити и постоянно развивается. Например, мы используем встроенный инструмент глобального поиска, и он отлично работает в нашей системе, нет необходимости разрабатывать собственные решения или искать дополнительные расширения. В будущем, с развитием нашей платформы, PostgreSQL всегда сможет удовлетворить наши запросы.

Кеш

Как бы быстро ни работала реляционная система управления базами данных, есть способ сделать работу платформы ещё быстрее — настроить кеширование самых часто используемых данных. Использовать данные из кеша более экономично, чем каждый раз обращаться к PostgreSQL. Для кеширования мы используем БД Redis, это нереляционная база данных, которая размещает информацию в оперативной памяти сервера. Redis выбрали за его простоту, удобство использования, возможность кластеризации и шардирования. Когда нам становится недостаточно одного сервера для кеша, мы добавляем дополнительные в кластер и тем самым увеличиваем производительность.

Чтобы кеш работал эффективно, он должен содержать часто используемые, но редко обновляемые данные, для этого все запросы к БД анализируются по частоте запросов. Данные в кеше могут храниться только до момента их обновления, затем кеш освобождается и перезаписывается новой информацией. Чтобы не происходило постоянного процесса стирания-записи, для кеширования выбираются те данные, которые обновляются редко. Например, это могут быть агрегаты.

Агрегаты — это сложные объекты, которые имеют много связей. Чтобы собрать агрегат и показать его пользователю, необходимо сделать несколько обращений к БД. Если агрегат целиком поместить в кеш, не надо будет каждый раз тратить время и ресурсы на его сборку. В качестве примера агрегата, помещаемого в кеш, можно назвать систему управления таблицами. Агрегат содержит элементы управления колонками и столбцами, фильтры, сортировщики, кнопки и формы. Все эти элементы описаны в различных таблицах, формируют один объект и редко обновляются. Содержимое самой таблицы, напротив, регулярно изменяется.

Если взять такой агрегат и целиком поместить в Redis, то для его загрузки не надо будет обращаться к PostgreSQL, такая операция станет выполняться значительно быстрее. А динамично обновляющиеся данные в таблицу будут по-прежнему загружаться напрямую из базы данных.

Если все данные записывать в базу данных, то её размер будет стремительно увеличиваться, время доступа расти, а поиск замедляться. Поэтому все файлы мы храним в отдельном S3-хранилище.

MinIO по S3

S3 — это протокол доступа к неструктурированным данным, разработанный компанией Amazon для своего продукта AWS S3. Компания создала распределённое хранилище, написала для него API и предоставила к нему доступ. Протокол стал настолько популярным, что многие компании выпустили свои версии хранилищ, совместимых с S3. Для SimpleOne мы используем сервер MinIO, который нативно работает с данным протоколом. Взаимодействие платформы с MinIO реализовано с помощью инструментария AWS SDK.

Среди аналогичных продуктов, таких как OpenStack Swift, мы выбрали MinIO, так как его возможностей нам достаточно, а отсутствие лишних компонентов не перегружает систему и не мешает работать. MinIO — живой проект, постоянно развивается и имеет хорошую перспективу. С другой стороны, если его возможностей нам в какой-то момент будет недостаточно, мы всегда сможем смигрировать на другую аналогичную платформу без вмешательства в код программы, так как инструменты взаимодействия по протоколу S3 для всех одинаковы.

Схема: SimpleOne + AWS SDKИспользование такого хранилища позволяет предоставить пользователям доступ к файлам по http, то есть дать ссылку на файл, а также разграничить права доступа, разложить файлы по корзинам, осуществить резервное копирование данных, кластеризовать и шардировать. Предоставление доступа к файлам осуществляется напрямую, без необходимости перемещения файла на другие серверы.

Наше хранилище S3, так же как и другие сервисы платформы, работает из контейнера Docker, с помощью технологии контейнеров происходит и взаимодействие между сервисами: backend-сервером, frontend-серером и другими. В зависимости от сложности проекта и числа пользователей мы можем запускать несколько контейнеров на одном сервере или разнести их по отдельным физическим машинам. Технология Docker позволяет автоматически масштабировать систему и динамично перераспределять нагрузку тем контейнерам, у которых в настоящий момент полная загрузка. В любой момент можно подключить дополнительный сервер — распределить нагрузку и повысить производительность системы.

В зависимости от сложности проекта и числа пользователей мы можем запускать несколько контейнеров на одном сервере или разнести их по отдельным физическим машинам. Технология Docker позволяет автоматически масштабировать систему и динамично перераспределять нагрузку тем контейнерам, у которых в настоящий момент полная загрузка. В любой момент можно подключить дополнительный сервер — распределить нагрузку и повысить производительность системы.

Почему распределённая система хранения данных эффективнее

Существует несколько причин высокой эффективности такой системы — как скоростных, так и архитектурных.

Например, такая система отлично масштабируется. Когда пользователь загружает файл на платформу, он попадает на backend-сервер. Таких серверов может быть несколько, а обращение идёт по единому URL-адресу. Предугадать, на который из них этот файл загрузится, невозможно. Когда пользователю вновь потребуется этот файл, его может не оказаться в Сети: сервер завис, остановлен или недоступен по другим причинам..png) Поэтому сразу после загрузки файла система перекладывает его на выделенный сервер хранения S3, формирует ссылку и передаёт её клиенту для возможности независимой загрузки.

Поэтому сразу после загрузки файла система перекладывает его на выделенный сервер хранения S3, формирует ссылку и передаёт её клиенту для возможности независимой загрузки.

На хранилище S3 можно размещать файлы любых форматов и любого размера, это никак не сказывается на производительности самого хранилища, но значительно разгружает веб-сервер. Когда на S3 заканчивается место, мы всегда можем добавить диски или подключить дополнительную систему хранения данных без каких-либо структурных и программных изменений.

Схема работы с S3Заключение

Распределённое хранение данных — это быстро и удобно. Правильно настроенные системы кеширования и файлового хранения в S3 позволили нам улучшить масштабирование и повысить скорость работы с данными более чем на 50%. Мы использовали открытые системы и протоколы, а также стандартные SDK и API — это позволило сократить сроки разработки, упростить техническую поддержку. Тем самым мы получили возможность сменить программные компоненты без вмешательства в код платформы. Для создания SimpleOne мы используем современные технологии и решения, чтобы сделать платформу, удобную как для конечных пользователей, так и для разработчиков и администраторов.

Для создания SimpleOne мы используем современные технологии и решения, чтобы сделать платформу, удобную как для конечных пользователей, так и для разработчиков и администраторов.

☸️ Распределенное хранение данных в Kubernetes – IT is good

Kubernetes отлично подходит для приложений без учета их состояния.

Разверните свое приложение, масштабируйте его до сотен экземпляров, будьте счастливы.

Но как вы управляете хранилищем?

Как мы можем гарантировать, что каждое из наших сотен приложений получит надежное, быстрое и дешевое хранилище?

Давайте возьмем типичный кластер Kubernetes с несколькими узлами (серверами Linux), которые обеспечивают несколько копий нашего приложения:

Обратите внимание на наши грустные, неиспользованные диски!

Kubernetes, безусловно, приносит много побед, но разве мы больше являемся системными администраторами, если не управляем огромными RAID-массивами?

Persistent Volume Claims

В Kubernetes мы определяем PersistentVolumeClaims, чтобы запросить нашу систему хранения.

Проще говоря, приложение «требует» немного памяти, и система отвечает настраиваемым способом:

App1 – > VolumeClaim

К сожалению, большинство облачных провайдеров стремятся использовать простоту Kubernetes, «отвечая» на ваш запрос хранилища, подключая Cloud Storage (например, Amazon EBS).

У этой стратегии есть ряд недостатков для потребителей:

- Производительность и стоимость: производительность томов EBS (и других поставщиков облачных вычислений) зависит от его размера – это означает, что меньший диск – это то же самое, что и более медленный диск.

- Характеристики: поставщики облачных услуг обычно предлагают жесткие диски, SDD и опцию «подготовленного ввода-вывода». Это ограничивает системных администраторов в их системах хранения. Где находится резервная копия? А как насчет NVMe? Как диск подключен к серверу, на котором работает мой код?

- Переносимость / блокировка: EBS – это EBS, а постоянные диски Google – это постоянные диски Google.

Поставщики облачных услуг настойчиво пытаются привязать вас к своим платформам и обычно прячут инструменты файловой системы, которые мы знаем и любим за облачной системой моментальных снимков.

Поставщики облачных услуг настойчиво пытаются привязать вас к своим платформам и обычно прячут инструменты файловой системы, которые мы знаем и любим за облачной системой моментальных снимков.

Итак … Что нам тогда нужно, так это система управления хранилищем данных с открытым исходным кодом, которая будет работать в любом кластере Kubernetes и может преобразовывать кучи дисков в пулы хранения, доступные для наших подов!

Введите Rook.io

Что такое Rook?

С веб-сайта Rook:

Облачное хранилище с открытым исходным кодом для Kubernetes» с «Хранилищем готовых файлов, блоков и объектов».

Если говорить о маркетинге, Rook – это версия AWS EBS и S3 с открытым исходным кодом, которую вы можете установить в свои кластеры.

Это также бэкэнд для системы хранения KubeSail, и именно так мы создаем RAID-массивы для поддержки приложений наших пользователей!

Rook и Ceph

Rook – это система, которая находится в вашем кластере и отвечает на запросы на хранение, но сама она не является системой хранения.

Хотя это немного усложняет ситуацию, вы должны чувствовать себя хорошо, потому что, хотя Rook и новичок, система хранения, которую он использует под капотом, закалена и далека от бета-тестирования.

Мы будем использовать Ceph, которому около 15 лет, который используется и разрабатывается такими компаниями, как Canonical, CERN, Cisco, Fujitsu, Intel, Red Hat и SanDisk.

Это очень далеко от Kubernetes-Hipster, несмотря на то, как круто выглядит проект Rook!

Учитывая, что Rook версии 1.0 и Ceph поддерживают некоторые из самых важных в мире наборов данных, я бы сказал, что настало время обрести уверенность и вернуть контроль над нашим хранилищем данных!

Я буду строить RAID-массивы в 2020-х годах, и никто не сможет меня остановить!

Установка

Я не буду концентрироваться на первоначальной установке здесь, так как руководство по Rook простое.

После установки Rook мы создадим несколько компонентов:

- CephCluster, который отображает узлы и их диски в нашу новую систему хранения.

- CephBlockPool, который определяет, как хранить данные, включая количество реплик, которые мы хотим.

- StorageClass, который определяет способ использования хранилища из CephBlockPool.

Давайте начнем с CephCluster:

#?filename=ceph-cluster.yaml&mini=true&noApply=true

---

apiVersion: ceph.rook.io/v1

kind: CephCluster

metadata:

name: rook-ceph

namespace: rook-ceph

spec:

mon:

count: 3

allowMultiplePerNode: false

storage:

useAllNodes: false

useAllDevices: true

location:

config:

osdsPerDevice: "1"

directories:

- path: /opt/rook

nodes:

- name: "my-storage-node-1"

- name: "my-storage-node-2"

- name: "my-storage-node-3"

Здесь важно отметить, что CephCluster – это, по сути, карта, на которой показаны ноды и какие диски или каталоги на этих узлах будут использоваться для хранения данных.

Многие учебные пособия будут предлагать useAllNodes:true, что мы настоятельно не рекомендуем.

Вместо этого мы рекомендуем управлять меньшим пулом поднаборов «storage workers» – это позволяет позже использовать различные типы систем (например, очень медленные диски) без случайного / неосознанного добавления его в пул хранения.

Мы будем предполагать, что /opt/rook является точкой монтирования, но Rook может использовать неформатированные диски, а также каталоги.

Еще одно замечание: mon – система мониторинга Rook.

Мы настоятельно рекомендуем запускать по крайней мере три и гарантировать, что allowMultiplePerNode имеет значение false.

Теперь наш кластер выглядит так:

Кстати, вы наверняка захотите взглянуть на поды, работающие в пространстве имен rook-ceph!

Вы найдете свои OSD (Object-Storage-Device) поды, а также поды мониторинга и агента, живущие в этом пространстве имен.

Давайте создадим наш CephBlockPool и StorageClass, который он использует:

#?filename=ceph-blockpool. yaml&mini=true&noApply=true

---

apiVersion: ceph.rook.io/v1

kind: CephBlockPool

metadata:

name: my-storage-pool

namespace: rook-ceph

spec:

failureDomain: osd

replicated:

size: 2

---

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: my-storage

provisioner: rook.io/block

parameters:

pool: my-storage-pool

yaml&mini=true&noApply=true

---

apiVersion: ceph.rook.io/v1

kind: CephBlockPool

metadata:

name: my-storage-pool

namespace: rook-ceph

spec:

failureDomain: osd

replicated:

size: 2

---

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: my-storage

provisioner: rook.io/block

parameters:

pool: my-storage-pool

Мы подождем, пока наш CephCluster будет установлен – а вы уже можете взглянуть на созданный вами объект CephCluster:

➜ kubectl -n rook-ceph get cephcluster rook-ceph -o json | jq .status.ceph.health

"HEALTH_OK"Теперь мы готовы сделать запрос на хранение!

Теперь мы можем запросить хранилище несколькими стандартными способами.#?filename=ceph-pvc. yaml&mini=true&noApply=true

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: test-data

spec:

accessModes:

- ReadWriteOnce

# Use our new ceph storage:

storageClassName: my-storage

resources:

requests:

storage: 1000Mi

yaml&mini=true&noApply=true

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: test-data

spec:

accessModes:

- ReadWriteOnce

# Use our new ceph storage:

storageClassName: my-storage

resources:

requests:

storage: 1000Mi

➜ kubectl get pv --watch

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS AGE

pvc-... 1000Mi RWO Delete Bound default/test-data my-storage 13mИтак, поехали!

Удобная, довольно простая в использовании, нативная система хранения Kubernetes.

Мы можем принести свои собственные диски, мы можем использовать любой облачный провайдер … Свобода!

Поделитесь статьей:

10 минут, чтобы понять: распределенное решение для хранения данных для 100 миллионов пользователей!

Нажмите на «Выбор задней части технологии«Выберите« Топ общего числа »

Техническая статья отправлена в первый раз!

Автор:Северный код города Сельское хозяйство Алекс

segmentfault.

com/a/1190000019460946

Толкатьрекомендуючитатьчитать(Нажмите, чтобы прочитать чтение)

1. Агрегация контента Scraphboot

2. Интервью Вопрос Содержание Агрегация

3. Режим дизайна Агрегация контента

4. Сортировка алгоритма Содержание агрегации

5. Многопоточная агрегация контента

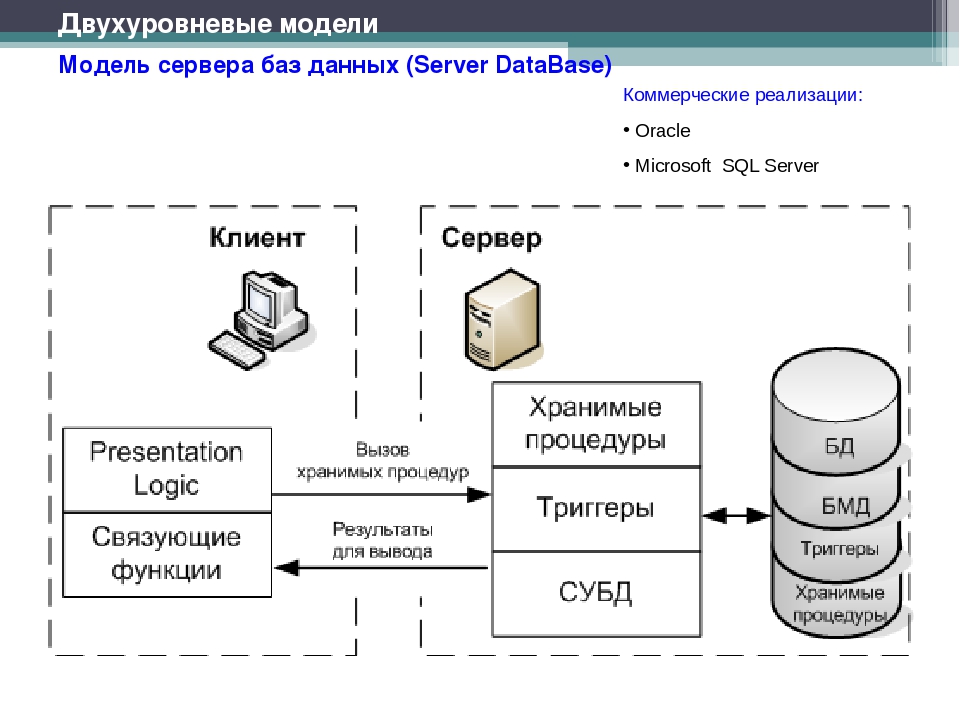

Распределенные базы данных и распределенные хранения являются крупнейшими и крупными проблемами в распределенных системах, а также является наиболее подверженным проблемам. Интернет-компании решают только проблему хранения распределенных данных, могут поддерживать приток более 100 миллионов пользователей.

Далее вы потратите десять минут, чтобы освоить следующие три аспекта:

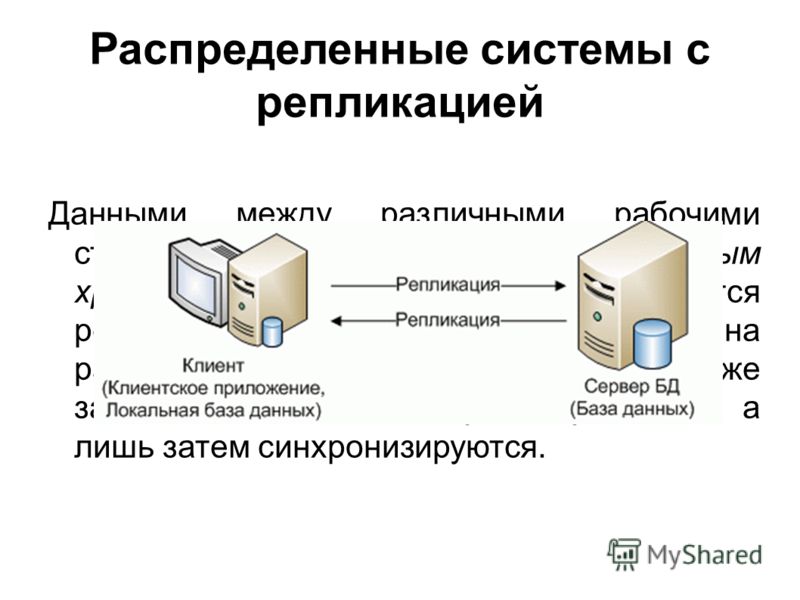

Репликация MySQL: в том числе репликация Master-Slave и основная копия;

Фрагмент данных: принцип фрагментации данных, схема фрагментации и расширение фрагментационной базы данных;

Несколько программ распределенного развертывания базы данных.

Во-первых, MySQL Copy

1. Mysql Master-Place Copy

Репликация Mysql Master-Slave — скопировать данные в основной базе данных MySQL в базу данных.

Основная цель состоит в том, чтобы добиться разделения записи с чтением базы данных, операция записи в режиме ожидания основной базы данных, доступом к работе с чтением в базе данных, что позволяет базу данных иметь более мощную емкость доступа, поддержать больше пользователей.

Его основной принцип репликации: когда клиент приложения отправляет команду обновления в базу данных, база данных будет записывать эту команду обновления в Binlog, а затем прочитайте этот журнал из Binlog из Binlog по другому потоку, а затем скопируйте его с сервера с сервера с сервера После того, как вы получите этот журнал обновления с сервера, добавьте его в свой собственный журнал реле, затем выполните темы из другого SQL из журнала реле. Этот новый журнал и повторно выполните его в локальной базе данных.

Это когда клиентское приложение выполняет команду обновления, эта команда выполняется синхронно в основной базе данных и из базы данных, что позволяет основную базу данных копировать из базы данных, что позволяет одни и те же данные из базы данных и основной базы данных.

2. MySQL Один Главный Больше от копии

Репликация MySQL’s Master-Slave — это механизм синхронизации данных. В дополнение к копированию данных в основной базе данных в базу данных подчиненной базы данных, вы также можете скопировать данные из основной базы данных для нескольких из базы данных, то есть так называемого основного MySQL Больше от копии.

Когда несколько баз данных связаны с основной базой данных, скопируйте журнал BINLOG в основной базе данных, чтобы несколько из базы данных. Выполняя журналы, дайте каждому из данных из базы данных и данных в основной базе данных. Операции по обновлению данных в этом указывают на то, что все обновления базы данных, в дополнение к операциям по чтению данных, такие как SELECT, другие вставки, удаление, обновление записи DML-записи и создания таблицы, выпадают, удаленные таблицы и т. Д. Операция DDL также может быть синхронно скопирована в базу данных.

3. Одно главное от копирования преимуществ

У одного из людей четырех преимуществ от репликации, соответственно, и специализируются на специальных машинах, простых в использовании.

а. Распространение нагрузки

Распространите операции только для чтения в нескольких из базы данных для распределения нагрузки на несколько серверов.

б. Специальная машина

Различные типы запросов могут быть использованы для разных типов запросов.

с. Легко остыть

Даже если база данных копируется мастером, в некоторых экстремальных случаях. Также возможно заставить серверы данных во всем центре обработки данных, которые будут потеряны. Поэтому обычно многие компании сделают данные холодными, но есть сложная точка при переносе охлаждения, заключается в том, что если база данных написана, данные охлаждения могут быть неполными, а файл данных может быть в поврежденном состоянии. Резервное копирование времени отключения может быть достигнуто с помощью копии из копирования. Необходимо только отключить процесс репликации данных данных, файл закрыт, то файл данных скопирован, и копия вновь вписывается после завершения копии.

д. очень доступны

Если сервер опустится, до тех пор, пока вы не отправляете запрос, у вас не будет проблем. Когда этот сервер восстановлен, запрос перенаправляется на этот сервер. Таким образом, в случае большинства определенное влияние на всю систему очень мало.

4. Основная копия MySQL

Тем не менее, хост способен реализовать только эти преимущества с сервера. Когда основная база данных недоступна, данные все еще не переписаны, поскольку данные не могут быть записаны на верхнюю часть сервера, читается с сервера. Оф.

Чтобы решить проблему наличия основного сервера, мы можем использовать основную схему MySQL. Так называемая схема первичной копии относится к обоим серверам в качестве главного сервера, и операции записи, полученные на любом сервере, скопированы на другой сервер.

В качестве основного копирования схема основного мастера, когда клиентская программа выполняет операции обновления данных на первичном сервере A, основной сервер A будет записывать операцию обновления в журнал Binlog. Затем Binlog синхронизирует журнал данных на первичный сервер B, пишет в журнал реле сервера основного сервера, а затем включить журнал реле, чтобы получить журнал обновлений в журнале реле, выполните операции SQL для записи в локальную базу данных сервера базы данных B. Обновление на сервере B также копирует сервер A на сервер A BINLOG на сервер A, а затем обновлять данные в сервере A через журнал реле.

Затем Binlog синхронизирует журнал данных на первичный сервер B, пишет в журнал реле сервера основного сервера, а затем включить журнал реле, чтобы получить журнал обновлений в журнале реле, выполните операции SQL для записи в локальную базу данных сервера базы данных B. Обновление на сервере B также копирует сервер A на сервер A BINLOG на сервер A, а затем обновлять данные в сервере A через журнал реле.

Таким образом, любой из серверов A или B принимает операцию записи данных, будет обновляться на другой сервер, а владелец базы данных реализован. Основная копия может улучшить запись системы, а можно реализовать высокую доступность операций записи.