Обзор, тестирование, разгон видеокарты GIGABYTE GeForce RTX™ 3080 VISION OC 10G, Играемся с возможно самой красивой моделью RTX3080

Вступление

Видеокарты серии RTX 3080 поступили в продажу почти месяц назад, но найти их на прилавках магазинах все еще очень сложно. Мне, к счастью, стоять в виртуальных очередях и участвовать в лотерее за право покупки новой видеокарты NVIDIA не нужно — компания GIGABYTE предоставила мне ее на обзор. Графическая плата GeForce RTX™ 3080 VISION OC 10G семейства VISION – трехвентиляторная, почти трехслотовая модель с заводским разгоном, фирменным охлаждением WINDFORCE 3X и элегантным дизайном, ориентирована на создателей всевозможного медиаконтента. Маркетинг маркетингом, а мне кажется, покупать VISION будут ради стильного дизайна в белых и серебристых тонах. Цена видеокарты на момент публикации обзора сильно колеблется – от 77 до 82 тыс. ₽.

Видеокарта GIGABYTE на базе ГП GeForce RTX™ 3080 построена на 8-нм техпроцессе (производственные мощности Samsung) с использованием новейшей GDDR6X памяти от Micron. Сердцем RTX 3080 является чип GA102 архитектуры Ampere с 8704 ядрами CUDA, 68 ядрами для трассировки лучей в реальном времени и 272 тензорными ядрами. Микросхемы памяти GDDR6x объемом 10 Гбайт работают на частоте 19000 МГц, что вкупе с 320-разрядной шиной памяти обеспечивает пропускную способность до 760 Гбит/с. Заводской разгон GeForce RTX™ 3080 VISION OC 10G предусматривает прирост частоты ядра ГП с эталонных 1710 МГц до 1800 МГц. Решения на базе микроархитектуры NVIDIA Ampere предлагают два значимых новшества — поддержку HDMI 2.1 (модель GeForce RTX™ 3080 VISION OC 10G оснащена двумя портами HDMI 2.1) и реализацию шинного интерфейса PCIe 4.0.

Сердцем RTX 3080 является чип GA102 архитектуры Ampere с 8704 ядрами CUDA, 68 ядрами для трассировки лучей в реальном времени и 272 тензорными ядрами. Микросхемы памяти GDDR6x объемом 10 Гбайт работают на частоте 19000 МГц, что вкупе с 320-разрядной шиной памяти обеспечивает пропускную способность до 760 Гбит/с. Заводской разгон GeForce RTX™ 3080 VISION OC 10G предусматривает прирост частоты ядра ГП с эталонных 1710 МГц до 1800 МГц. Решения на базе микроархитектуры NVIDIA Ampere предлагают два значимых новшества — поддержку HDMI 2.1 (модель GeForce RTX™ 3080 VISION OC 10G оснащена двумя портами HDMI 2.1) и реализацию шинного интерфейса PCIe 4.0.

Вместе с заводским разгоном увеличилось и энергопотребление GeForce RTX™ 3080 VISION OC 10G – с 320 Вт у эталонных плат NVIDIA до почти 360 Вт, если верить показаниям встроенных в видеокарту датчиков. Посему, перед покупкой стоит убедиться в способности блока питания справиться с такими требованиями. Официально GIGABYTE рекомендует применять, как минимум, 750-Вт блоки питания категории не ниже 80 PLUS Gold. Также стоит обратить внимание на габариты видеокарты – ее длина составляет 320 мм, а ширина – 55 мм, или почти три слота PCIe.

Также стоит обратить внимание на габариты видеокарты – ее длина составляет 320 мм, а ширина – 55 мм, или почти три слота PCIe.

Внешний вид

Несмотря на внушительные габариты видеокарты, поставляется она в стандартного размера коробке. Комплект поставки включает видеокарту и маленький буклет с информацией о продукте. Внешний вид GPU соответствует всем атрибутам серии VISION, сочетая белый и серебристый оттенки кожуха, вентиляторов и бекплейта с платой черного цвета и фиолетовой вставкой на лицевой панели со встроенной RGB. Традиционно для GIGABYTE подсветки немного — горит только лого GIGABYTE. Управляется подсветка при помощи фирменного ПО RGB Fusion 2.1, которое позволяет синхронизировать подключенные девайсы между собой.

Серия продуктов VISION ориентирована на создателей контента, занимающихся видеомонтажом, работой с фото, графическим дизайном, архитектурными визуализациями и 3D анимациями. GeForce RTX™ 3080 VISION OC 10G — игровая модель видеокарты, но и на нее распространяется поддержка студийных драйверов от Nvidia, оптимизированных для работы в профессиональных приложениях. Функционально дизайн модели GeForce RTX™ 3080 VISION OC 10G почти не отличается от серий Eagle и Gaming (у Gaming есть двойной BIOS) — та же система охлаждения WINDFORCE 3X с 7 тепловыми трубками и фирменными вентиляторами, 3 порта DisplayPort 1.4, 2 порта HDMI 2.1, подсветка RGB Fusion 2.1 и солидная VRM с дизайном 13+4. В сравнении с эталонной Founders Edition, GIGABYTE добавила дополнительную фазу питания видеопамяти. Для питания видеокарты используется стандартные 8-пиновые разъемы в количестве двух штук.

Функционально дизайн модели GeForce RTX™ 3080 VISION OC 10G почти не отличается от серий Eagle и Gaming (у Gaming есть двойной BIOS) — та же система охлаждения WINDFORCE 3X с 7 тепловыми трубками и фирменными вентиляторами, 3 порта DisplayPort 1.4, 2 порта HDMI 2.1, подсветка RGB Fusion 2.1 и солидная VRM с дизайном 13+4. В сравнении с эталонной Founders Edition, GIGABYTE добавила дополнительную фазу питания видеопамяти. Для питания видеокарты используется стандартные 8-пиновые разъемы в количестве двух штук.

В дизайне видеокарты используется много алюминия, который выполняет не только декоративную роль: верхняя панель видеокарты помогает отводить и рассеивать тепло — во время работы она неплохо так нагревается. Также на верхней панели можно обнаружить отверстие, которое позволяет одному из трех вентиляторов выдувать теплый воздух вверх. За охлаждение отвечают два 90 мм и один 80 мм вентиляторы, центральный из которых крутится в противоположном направлении для уменьшения эффекта турбулентности. Управляются 80 мм и 90 мм вентиляторы отдельно друг от друга — скорость вращения и ее кривая работы настраиваются в фирменном софте AORUS Engine.

Управляются 80 мм и 90 мм вентиляторы отдельно друг от друга — скорость вращения и ее кривая работы настраиваются в фирменном софте AORUS Engine.

Конфигурация системы

Тестирование видеокарты проводилось в закрытом корпусе, СЖО была установлена на передней панели корпуса на вдув, скорость вращения всех вентиляторов была зафиксирована на отметке ~900-1200 Об/м, что соответствует уровню шума в 36.5 Дб на расстоянии 1 метра от корпуса.

Конфигурация системы:

- Процессор: Intel Core i7 10700K OC 5Ghz

- Оперативная память: 16Gb Crucial Ballistix Sport LT @ 3866 MHz CL16

- Материнская плата: GIGABYTE Z490 VISION G

- Системный SSD: Samsung EVO 860 500Gb

- SSD с играми: Kingston KC2500 1TB

- Охлаждение CPU: Arctic Liquid Freezer II 280 mm (Rev. 2)

- Блок питания: XFX XTR Black Edition 750W Gold

- Корпус: Thermaltake H550 TG

- Операционная система: Windows 10, 2004

- Версия драйвера: NVIDIA 456.71 Game Ready Driver

- Видеокарта: GIGABYTE GeForce RTX™ 3080 VISION OC 10G

Шум, температура, энергопотребление

Для тестирования температуры видеокарты использовался стресс-тест синтетического бенчмарка Superposition в пресете 1080p Extreme. По истечении 10 минут с начала теста измерялись показания температуры в программе HwInfo и скорость вращения вентилятора. Для измерения энергопотребления использовалась HwInfo, уровень шума измерялся при помощи шумомера, расположенного на расстоянии 1 метра от корпуса.

По истечении 10 минут с начала теста измерялись показания температуры в программе HwInfo и скорость вращения вентилятора. Для измерения энергопотребления использовалась HwInfo, уровень шума измерялся при помощи шумомера, расположенного на расстоянии 1 метра от корпуса.

Заводской разгон видеокарты позволяет стабильно удерживать частоту ядра на отметке ~1920 МГц, энергопотребление при этом держится на отметке 350-365 Вт. Профиль работы системы охлаждения мне не понравился — GIGABYTE жертвует уровнем шума ради высоких частот, энергопотребления и частоты ядра. Как результат видеокарта старается поддерживать высокие значения буста и не опускаться ниже 1920 МГц по ядру при температуре не выше 70 градусов. Так как мой корпус является далеко не лучшим в плане продуваемости, это сказалось на уровне шума и работе вентиляторов.

В более продуваемом корпусе ситуация будет чуточку лучше, но я бы предпочел видеть температуры в районе 75 градусов при низком уровне шума — ручная настройка кривой охлаждения это вполне позволяет.

Тесты в играх

Тестирование проводилось в двух разрешениях — 2560×1440 и 3840×2160.

Rainbow Six: Siege, Vulkan

Для тестирования использовались “соревновательные” настройки графики, которые далеки от Ультра и встроенный бенчмарк, который теперь переселился с карты Дом на Орегон.

GIGABYTE GeForce RTX™ 3080 VISION OC 10G позволяет играть 4K@144Hz — ниже этой отметки FPS в бенчмарке не падает. Ручной разгон видеокарты, как видно, почти ничего не дает — видеокарта уже работает на максимуме возможностей.

World War Z, Vulkan

Еще одна игра, работающая на API Vulkan. В настройках все показатели графики были выставлены на максимум, для тестирования использовался встроенный бенчмарк.

В 1440p видеокарта еще не загружается на полную, и это при использовании разогнанного 10700K с оптимизированной оперативкой, работающей на частоте 3866 МГц. Порой в бенчмарке видеокарта загружается всего на 92-96%. 4K уже нагружает видеокарту на полную, обеспечивая средний показатель FPS в 118 единиц. Разгон видеокарты почти ничего не дает.

Разгон видеокарты почти ничего не дает.

Control DX12, RTX + DLSS

Первый RTX тайтл в нашем списке. Все настройки выкручены на максимум, DLSS на стандартной отметке, тестирование проводилось в игровых условиях без использования бенчмарка.

Видеокарта GIGABYTE GeForce RTX™ 3080 VISION OC 10G обеспечивает комфортный уровень игры, как в 1440p, так и в 4K, однако в тяжелых сценах FPS немного проседает ниже отметки в 60 кадров/сек. Разгон практически ничего не дает, но в 4К пара FPS сверху может неплохо помочь.

Crysis Remastered RTX

Смеха ради все-таки решил поделиться результатами в этой игре. При тестировании других видеокарт этой игры в списке не будет по понятным причинам. Тестирование проводилось в игре на максимальных настройках графики.

30 FPS, статтер, вырвиглазная картинка. Оптимизации в игре нет, лучи убивают производительность напрочь. Разгон не спасает.

Horizon Zero Dawn

Тестирование проводилось при использовании внутриигрового бенчмарка, все настройки выкручены на максимум, FOV зафиксирован на отметке 80 FPS. В игре все еще присутствуют проблемы с утечками памяти и рандомными падениями производительности, из-за чего тесты проделывал много раз с перезагрузками компьютера и перезапуском игры, пока не собрал консистентную информацию.

В игре все еще присутствуют проблемы с утечками памяти и рандомными падениями производительности, из-за чего тесты проделывал много раз с перезагрузками компьютера и перезапуском игры, пока не собрал консистентную информацию.

Видеокарта обеспечивает комфортный уровень производительности. В 4K мы опять наблюдаем больше 60FPS.

Gears Tactics

Эта игра не такая популярная, однако является отличным примером оптимизированной игры на Unreal Engine 4. Все настройки выкручены на максимум, для тестирования использовался встроенный бенчмарк

И снова — больше 60 FPS в 4K.

Resident Evil 3

RE Engine У Capcom получился отменный: красивая графика, высокий уровень FPS, возможность создавать большие открытые локации — впереди нас ждет все больше и больше игр, построенных на этом движке. Тестирование проводилось на максимальном уровне графики с текстурам High 4GB.

В 4K легко получается выжимать больше 100 FPS в среднем — видеокарта отлично скалируется в этой игре между разными разрешениями.

Total War: Three Kingdoms DX12

Серия Total War всегда предлагала высокий уровень графики и устрашающие системные требования. Three Kingdoms — не исключение, максимальные (Безумные) настройки графики требуют очень и очень мощных ПК. Тестирование проводилось во внутриигровом бенчмарке “Битва”.

Больше 60 FPS в 1440p и 37 FPS в 4K — вроде и не густо, но в сравнении с другими видеокартами — очень и очень мощно.

Metro Exodus DX12, RTX, DLSS

Второй и последний RTX+DLSS бенчмарк. Тестирование проводилось в “Истории Сэма” при использовании “Ультра” настроек графики с отключенными PhysX и Hairworks.

Почти 100 FPS в 1440p и больше 60 в 4K.

Red Dead Redemption 2, DX12

С GIGABYTE GeForce RTX™ 3080 VISION OC 10G я чувствую себя храбрым, поэтому тестировать будем на максимальных настройках графики, включая отражения, физику воды и тесселяцию деревьев. MSAA сглаживание было отключено, тестирование проводилось во внутриигровом бенчмарке.

Почти-почти NVIDIA RTX 3080 справляется с игрой в 4K. Уменьшение пары настроек на один клик позволит получить более комфортный игровой опыт практически без потери в качестве графики, но на абсолютном максимуме видеокарте чуть-чуть не хватает. Верю, что RTX 3090 справится с этим монстром!

В завершение добавим сравнение CPU в нескольких играх:

Какой нужен CPU для раскрытия потенциала видеокарты? Углубляться в тестирование процессоров я не буду, но для сравнения я выбрал две популярных модели от AMD и Intel. AMD Ryzen 3600 и Intel Core i7 10700K находятся в разных ценовых категориях, однако представляют собой два популярных выбора: бюджетный игровой процессор и абсолютный игровой процессор.

В 4K разницы практически нет — 10700K показывает результаты в среднем чуть-чуть выше, но в 1440P появляются различия в производительности. Ryzen 3600 не хватает для раскрытия потенциала RTX 3080 в World War Z и Rainbow Six Siege, обе из которых работают на API Vulkan — и это еще самые лучший вариант для процессора AMD. Для игры в 1440p@144Hz стоит вложиться в более производительный процессор, нежели Ryzen 3600.

Для игры в 1440p@144Hz стоит вложиться в более производительный процессор, нежели Ryzen 3600.

Разгон

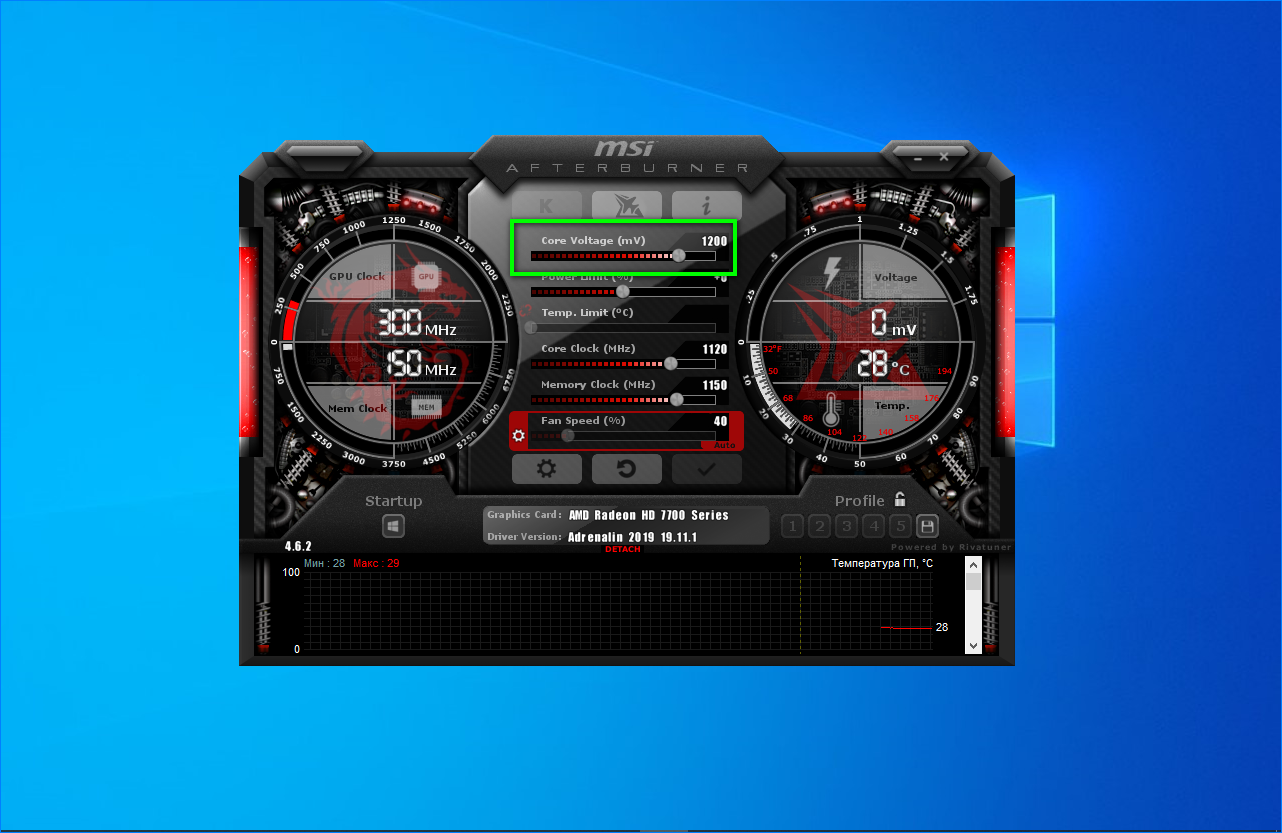

Как мы увидели выше, ручной разгон видеокарты практически ничего не дает, но отдельного разговора этот вопрос все равно заслуживает. Тестировать производительность и стабильность будем в бенчмарке Superposition 1080p Extreme.

Процессор в этом бенчмарке вообще не нагружается, а сам тест очень сильно нагружает все аспекты видеокарты и наглядно демонстрирует эффект разгона. Разгонять видеокарту будем при помощи AORUS Engine.

Во-первых, посмотрим на функцию Авто Разгон, которая в течение ~20 минут гоняет какие-то тесты, пока ты пьешь чай или кофе, а потом выдает оптимизированную кривую напряжения/частоты.

Удивительно, но компьютеры в 2020 году очень умные — видеокарты теперь сами себя разгоняют, да еще и разгон оказывается абсолютно стабильный. Результаты выше, видеокарта потребляет на 15 Вт меньше. Не разгон, а просто сказка — а главное, выполняется в одно нажатие кнопки. Однако разгоняется здесь только частота ядра.

Однако разгоняется здесь только частота ядра.

Ручной разгон показывает результаты выше, но это во многом благодаря разгону памяти. Память удалось легко погнать выше отметки в 20000 МГц, но я решил не тратить много времени на отлов артефактов и поиск максимума, просто остановившись на этой отметке. В среднем, от видеокарт серии RTX 3080 можно ждать частот выше 20000 МГц.

Лучшим вариантом я считаю именно такой вариант: дать компьютеру оптимизировать ваш конкретный экземпляр видеокарты, что обеспечивает уменьшение энергопотребления и прирост частоты ядра, руками разогнать память и по желанию настроить кривую работы вентиляторов. Но в целом, от разгона GeForce RTX™ 3080 VISION OC 10G толку мало — видеокарта уже работает на пределе возможностей.

Заключение

GeForce RTX™ 3080 VISION OC 10G — абсолютный монстр. Энергопотребление видеокарты хоть и высокое, но система охлаждения отлично справляется с отводом такого количества тепла. Прирост производительности по сравнению с предыдущим поколением видеокарт огромный, технологии RTX и DLSS уже успели созреть, да и никакая другая видеокарта не способна обеспечить тот самый заветный 4K гейминг на максималках. RTX 3080 на сегодняшний день — единственная видеокарта на рынке, которая за вменяемую сумму гарантирует запас прочности на несколько лет вперед.

RTX 3080 на сегодняшний день — единственная видеокарта на рынке, которая за вменяемую сумму гарантирует запас прочности на несколько лет вперед.

И речь идет не только о производительности — видеокарта оснащена всеми необходимыми интерфейсами и технологиями будущего, начиная от фирменных RTX и DLSS, которые продолжают расширять свое влияние на рынке, современными интерфейсами подключения PCIe 4.0 и HDMI 2.1 и очень интересными изменениями архитектуры. Как вы, наверняка, слышали из презентаций новых консолей, PS5 и XboX Series X внедряют в свою архитектуру технологию прямого сообщения интерфейсов хранения данных с видеокартой для утилизации высоких скоростей PCIe 4.0 SSD. И видеокарты серии RTX 3000 поддерживают эту технологию. Как скоро она придет на ПК рынок — неясно, но обладатели видеокарт от Nvidia поколения Ampere к ней уже готовы. Таким образом GeForce RTX™ 3080 VISION OC 10G предлагает абсолютный максимум сегодня, обеспечивая комфортный уровень игры при любых разрешениях — будь то 1440p@144hz или 4K@60hz и оставляет хороший задел на будущее.

Разгон NVIDIA GeForce RTX — руководство Hardwareluxx

Страница 1: Разгон NVIDIA GeForce RTX — руководство Hardwareluxx

Первый вопрос, на который придется ответить потенциальному покупателю видеокарты GeForce RTX, заключается в выборе модели. На данный момент в линейке GeForce три варианта (GeForce RTX 2070, GeForce RTX 2080 и GeForce RTX 2080 Ti) по три опции в каждом. Можно взять видеокарту начального уровня с эталонными тактовыми частотами, модель Founders Editions от NVIDIA с умеренным заводским разгоном и фирменным кулером, либо high-end видеокарту на альтернативном дизайне от партнеров NVIDIA с максимальным уровнем заводского разгона.

Мы подготовили руководство, которое можно использовать для любых видеокарт GeForce RTX. Но в качестве базы мы взяли ASUS ROG Strix GeForce RTX 2080 Ti OC.

Видеокарта ASUS ROG Strix GeForce RTX 2080 Ti OC работает в режиме OC с минимальной планкой Boost 1.665 МГц. Эталонная частота составляет 1.545 МГц, в случае Founders Edition NVIDIA подняла ее до 1.635 МГц. Питание на видеокарту подается двумя 8-контактными штекерами. Планка Power Target составляет 260 Вт, но ее можно поднять на +25% до 325 Вт.

Мы специально взяли данную модель, поскольку кулер хорошо зарекомендовал себя в наших тестах, температуры GPU не превысили уровень 70 °C. Кроме того, если повысить скорость вращения вентиляторов, то температуры можно еще снизить, поскольку данные результаты были получены на сравнительно низких оборотах. Конечно, система водяного охлаждения позволила бы еще сильнее раскрыть потенциал GPU благодаря низким температурам.

Весьма важна и планка Power Target, она задает ограничение, которое весьма сложно обойти. В случае видеокарт Turing появилось даже «народное средство» в виде замены BIOS, чтобы увеличить Power Limit. Подробности можно узнать в соответствующей ветке форума GeForce RTX 2080 Ti.

В случае видеокарт Turing появилось даже «народное средство» в виде замены BIOS, чтобы увеличить Power Limit. Подробности можно узнать в соответствующей ветке форума GeForce RTX 2080 Ti.

ASUS на ROG Strix GeForce RTX 2080 Ti OC установила 19 фаз питания, хотя не все они контролируются индивидуально, часть фаз сгруппированы. У столь большого числа фаз есть преимущество по распределению выделяющегося тепла по всем фазам, непосредственно на питание влияние не такое существенное, по крайней мере, без экстремального разгона GPU.

GPU с суффиксом A и без такового

NVIDIA представила два варианта каждого GPU Turing, то есть TU102, TU104 и TU106. Они отличаются суффиксом «A». Таким образом, например, можно приобрести видеокарту на чипах TU102-300 или TU102-300A. NVIDIA для Founders Edition использует чипы TU102-300A, то же самое касается альтернативных дизайнов партнеров с заводским разгоном. У обычных видеокарт без заводского разгона используются GPU TU102.

У обычных видеокарт без заводского разгона используются GPU TU102.

Вариант чипа важен, если планируется замена BIOS для повышения планки Power Limit. Замену BIOS можно выполнять только при условии одинаковых версий чипа, с суффиксом A или без него. Если планируется разгон, то следует выбирать видеокарту на GPU с суффиксом A.

ASUS для ROG Strix GeForce RTX 2080 Ti OC тоже использовала GPU TU102-300A.

<>Разгон NVIDIA GeForce RTX — руководство HardwareluxxРазгон через NV Scanner и вручную

Geforce GT240 (разгон, прошивка, тест) Как я уже неоднократно упоминал «в компьютерные игры я не играю, но за обновлением, в стане графических адаптеров, слежу с любопытством зрителя, подглядывающего в замочную скважину, т.е возможности, так сказать, воочую, оценить мощь новых флагманских моделей, с завидной переодичностью, не имею, но всё же стараюсь быть в курсе событий. Моя надежда задействовать вычислительные ресурсы графического акселератора с треском провалилась, когда уровень загрузки при использовании CUDA остался неизменным зеро….Из описания стало ясно, что пресловутая CUDA наибольший эффект демонстрирует при многочисленном наложении фильтров на исходный видеоряд, а также в случаях «эксплуатации» серьёзных решений вида GTX260-280. Посему моя Утилита верно определила исходные частотные показатели ядра/шейдерного домена/памяти (500/1339/1700MHz), а также уведомила о том, что система охлаждения фунциклирует на 35% оборотистом номинале. Исходя из результативности разгона geforce gt240  Так, в частности, упоминалась сложность в ручном управлении частотой вращения, у кого то скорость оставалась на постоянном уровне вне зависимости от настроек ручного управления, иные не получали доступ к изменению и вовсе. Указанная трудность меня лично миновала, и при процентном изменении в настройках EVGA Precision 1.9.3 скорость вращения крыльчатки вентилятора тот час же изменялась. Замечу, что при номинальных значениях прогон в 3DMark 2006 давал в среднем результат в 9800 тестовых единиц или попросту попугаев. Температура графического чипа достигала 59 градусов. Не стану утомлять читателя описанием результативности многочисленных проходов в 3DMark, перейдя непосредственно к финальному забегу…. Так, в частности, упоминалась сложность в ручном управлении частотой вращения, у кого то скорость оставалась на постоянном уровне вне зависимости от настроек ручного управления, иные не получали доступ к изменению и вовсе. Указанная трудность меня лично миновала, и при процентном изменении в настройках EVGA Precision 1.9.3 скорость вращения крыльчатки вентилятора тот час же изменялась. Замечу, что при номинальных значениях прогон в 3DMark 2006 давал в среднем результат в 9800 тестовых единиц или попросту попугаев. Температура графического чипа достигала 59 градусов. Не стану утомлять читателя описанием результативности многочисленных проходов в 3DMark, перейдя непосредственно к финальному забегу….Опытным путём было установлено, что предельные устойчивые/стбильные значения частот для geforce gt240 вмоём конкретном случае составили 650/1583/2000MHz соответственно, при этом величина температуры графического чипа не превысила отметки в 60 градусов Цельсия, во многом благодаря фиксированному значению 80 процентной скорости вращения вентилятора. Запустив NiBiTor v5.5 я наконец-то получил доступ к содержимому видеобиос geforce gt240 ddr5 Как в видеокартах предыдущих поколений используется система уровней производительности, в самом общем смысле реализующая принцип разумного увеличения частот при изменении характера нагрузки. Так, например, в 2D-режиме, априори, не требуется заоблачного быстродействия и частотные ряды geforce gt240 ddr5 выглядят более чем скромно. По мере роста нагрузки происходит выборка соответствующего уровня производительности…. Всё вышеизложенное, логично трансформируется в пониженные значения уровней напряжения питания…Я режил зафиксировать результативные значения частотных рядов, приведя их к максимально достигнутым значениям..иными словами, geforce gt240 ddr5 отныне будет постоянно трудиться на единственных значениях частот для ядра, шейдерного домена, памяти. Для фиксирования значения частот нужно… Прописать идентичные значения частот для каждого из уровней производительности, аналогично поступив и с уровнями напряжений… Единственным пока, недостижимым, минусом, стала отсутствие возможности скорректировать соотношения температуры и оборотов вентилятора, которые приходится «лочить» вручную на уровне 70-80%. Надеюсь, что эта проблема будет в скором времени решена очередным этаппом правки биоса видеокарты. Теперь же остаётся сохранить полученный образ биоса и из под ДОС-а произвести обновление прошивки средствами nvflash -5 -6 new.rom Окончательная проверка стабильности разогнанной geforce gt240, возможна тестовым пакетом FurMark… Удобный мониторинг температуры в режиме «реального времени», позволяет оперативно отслеживать состояние графического процессора geforce gt240 За сим прощаюсь более писать не о чем…. Маслёнков Андрей суббота, 15 мая 2010 г. |

Обзор видеокарты GeForce GTX 1660 SUPER: приятное усиление

Компания NVIDIA усиливает свои позиции в очень популярном сегменте игровых видеокарт стоимостью до $250. Разработчик сегодня представил очередную новинку – GeForce GTX 1660 SUPER. На первый взгляд технически несложным приемом калифорнийцам удалось повысить привлекательность своих устройств даного класса на базе чипов с архитектурой Turing. Модель интересна для тех, кто еще не решился на покупку видеокарты с трассировкой лучей и DLSS, но все же хочет за умеренную сумму обновить свою систему для комфортной игры в горячих осенних проектах. Возможности новинки мы рассмотрим, используя оригинальную модель серии – Palit GeForce GTX 1660 SUPER GamingPro OC 6GB.

NVIDIA GeForce GTX 1660 SUPER

Нынешний год оказался весьма продуктивным для NVIDIA. В середине лета компания обновила линейку GeForce RTX, представив Super-модификации популярных моделей RTX 2060/2070/2080. Пришло время для улучшений устройств серии GeForce GTX на базе чипов с архитектурой Turing. Несмотря на то, что видеокарты серий GeForce GTX 1660/1660 Ti были представлены только в начале весны, разработчики видят повод и возможность оптимизировать линейку, предложив версию GeForce GTX 1660 SUPER.

Итак, для новой видеокарты используется уже хорошо знакомый графический процессор TU116, в котором активировано 22 потоковых мультипроцессора (SM), включающих 1408 CUDA-ядер, 88 текстурных блоков и 48 растеризаторов. GPU точно такой же конфигурации используется для GeForce GTX 1660. Более того, в данном случае совсем не изменилась даже частотная формула GPU – 1530/1785 МГц. Однако в отличие от классической версии, модификация GeForce GTX 1660 SUPER получила чипы памяти GDDR6, вместо GDDR5 у младшей модели. Для микросхем нового стандарта используется высокая эффективная частота – 14 000 МГц, что совсем уж не характерно для устройств подобного класса. Даже у старшей модификации – GeForce GTX 1660 Ti – по умолчанию чипы работают на эффективных 12 000 МГц. Что касается общего объема памяти, то здесь без изменений – 6 ГБ, разрядность шины также сохранена – 192 бита.

| GeForce GTX 1660 Ti | GeForce GTX 1660 SUPER | GeForce GTX 1660 | GeForce GTX 1060 | |

| Наименование кристалла | TU116 | TU116 | TU116 | GP106 |

| Графическая архитектура | Turing | Turing | Turing | Pascal |

| Техпроцесс производства | 12 нм | 12 нм | 12 нм | 16 нм |

| Площадь кристалла | 284 мм² | 284 мм² | 284 мм² | 200 мм² |

| Количество транзисторов, млрд | 6,6 млрд. | 6,6 млрд. | 6,6 млрд. | 4,4 млрд. |

| Тактовая частота GPU | 1500/1770 МГц | 1530/1785 МГц | 1530/1785 МГц | 1506/1709 МГц |

| Потоковые процессоры | 1536 | 1408 | 1408 | 1280 |

| Текстурные блоки | 96 | 88 | 88 | 80 |

| Блоки растеризации | 48 | 48 | 48 | 48 |

| Память (тип, объем) | GDDR6, 6 ГБ | GDDR6, 6 ГБ | GDDR5, 6 ГБ | GDDR5, 6 ГБ |

| Шина памяти | 192 бит | 192 бит | 192 бит | 192 бит |

| Эффективная тактовая частота памяти | 12 000 МГц | 14 000 МГц | 8000 МГц | 8008 МГц |

| Пропускная способность памяти | 288 ГБ/c | 336 ГБ/c | 192 ГБ/c | 192 ГБ/c |

| Энергопотребление, Вт | 120 Вт | 125 Вт | 120 Вт | 120 Вт |

Итак, после замены микросхем GDDR5 (8000 МГц) на GDDR6 (14 000 МГц) пропускная способность подсистемы памяти увеличилась на 75% – с 192 ГБ/c до 336 ГБ/c. Аналогичные показатели имеет стандартная GeForce RTX 2060. В общем, очень и очень внушительно. Разработчики заявляют, что после такого ускорения работы с памятью, можно ожидать общего прироста производительности до 20%, а преимущество над культовой GeForce GTX 1060 в этом случае может составлять до 50%.

Напомним, что GPU с архитектурой Turing получили выделенные аппаратные блоки для обработки целочисленных инструкций. В случае с TU116 для GTX 1660/1660 Super вычислительная способность чипа находится на уровне 5 TFLOPs для FP32 и те же 5 TFLOPs для целочисленных INT32.

Несмотря на то, что графический процессор TU116 производится компанией TSMC по 12-нанометровой технологии, видеокарты на его основе получаются весьма экономичными. GeForce GTX 1660 и GTX 1660 Ti укладываются в рамки теплового пакета в 120 Вт. Для новой GTX 1660 SUPER значение TDP увеличено до 125 Вт. Ускоренные чипы памяти требуют чуть больше энергии, но разница вполне допустимая, учитывая преимущества, которые сулит быстрая GDDR6.

В случае с GeForce GTX 1660 SUPER, разработчик не будет предлагать референсные устройства, полагаясь на инженерный потенциал производителей видеокарт. Последним также на этот раз не понадобится много усилий. Технологически простой апгрейд замены чипов GDDR5 на GDDR6 позволяет использовать уже имеющиеся дизайны печатных плат и систем охлаждения.

Рекомендованная цена GeForce GTX 1660 SUPER для американского рынка – $229. Очень привлекательный ценник на фоне того, что классическая GeForce GTX 1660 изначально оценивалась NVIDIA в $219, а GeForce GTX 1660 Ti – $279.

Для Украины рекомендованный для GeForce GTX 1660 SUPER ценник установлен на уровне 6990 грн. (~$280). Это значение стоит рассматривать лишь как условный ориентир, фактическая стоимость видеокарт будет зависеть от многих факторов.

Вместе с GeForce GTX 1660 SUPER компания анонсировала еще одну новинку обновленного семейства – GeForce GTX 1650 SUPER. Младшая представительница Super-серии получила удивительный апгрейд, в сравнении с классической GTX 1650. Данная версия вместо прежнего TU117 уже основана на чипе TU116. При этом функциональная конфигурация СUDA-ядер/текстурников/растеризаторов приобрела вид 1280/80/32 вместо прежней – 896/56/32. Шина памяти остается 128 битовой, но и здесь GDDR5 (8000 МГц) заменили на GDDR6 (12 000 МГц). После такого апдейта пропускная способность увеличилась со 128 ГБ/c до 192 ГБ/c (+50%). После такой тотальной модернизации, TDP видеокарты увеличился с 75 Вт до 100 Вт. Судя по результатам на представленном слайде, в некоторых случаях можно ожидать прироста производительности до 50%. Это самое мощное Super-усиление среди новинок серий RTX и GTX. Что же, производительность устройств в этом классе действительно стоило подтянуть.

Интригой пока остается рекомендованная цена. Видеокарты GeForce GTX 1650 SUPER появятся в продаже с 22-го ноября. Стоимость будет озвучена ближе к этой дате. NVIDIA сохраняет интригу и ожидает встречного хода от основного конкурента. Нужно признать, что графическая партия проходит очень увлекательно.

Вместе с аппаратными новинками NVIDIA предложила ряд программных улучшений для более эффективного использования возможностей видеокарт. Разработчик добавил в настройках драйвера параметр Image Sharpening, позволяя повышать резкость картинки без потерь производительности.

Ранее такая возможность появилась в виде фильтра из набора Freestyle, доступного через GeForce Experience. Теперь же эта опция перекочевала в панель управления NVIDIA. Такой вариант гораздо удобнее и проще в настройке. В опциях можно выбрать степень усиления резкости, причем можно задать этот параметр глобально или индивидуально для каждого проекта. Функция доступна для всех игр с API DirectX 9/11/12.

Технология хорошо работает, повышая резкость изображения. Она наверняка понравится любителям «звенящей» картинки. Важно, что интенсивность можно корректировать, потому как слишком резкие текстуры также не всегда во благо.

Такая возможность может быть также полезна, например, для игр на 4К-мониторе с понижением разрешения. В этом случае при интерполяции резкость картинки естественно снижается, а с помощью Image Sharpening это можно частично компенсировать. В общем хорошая альтернатива технологии Radeon Image Sharpening от AMD.

Очередное обновление получила технология снижения задержек отрисовки очередного кадра Ultra Low Latency. На этот раз разработчики постарались устранить возможные нюансы при использовании функции одновременно с активированной технологией G-Sync.

NVIDIA также добавила набор фильтров ReShade, которые теперь можно использовать для Freestyle и Ansel, вызываемых оверлеем во время игры. Набор фильтров зависит зависит от игры. В частности графические оптимизации не должны влиять на результаты в соревновательных играх, потому в таких проектах перечень «улучшайзеров» ограничен. Для активации возможностей Freestyle и Ansel понадобится использовать GeForce Experience.

Palit GeForce GTX1660 Super GamePro OC 6G

К моменту официального старта продаж GeForce GTX 1660 SUPER компания Palit подготовила несколько моделей. К нам попала старшая версия линейки – Palit GTX1660 Super GamePro OC 6G.

[hl id=18283338]

Для видеокарты предусмотрен заводской разгон графического процессора. Вместо рекомендованных 1530/1785 МГц, GPU получил частотную формулу 1530/1830 МГц. Локальная память работает на штатных 14 000 МГц.

На момент подготовки материала диагностическая утилита GPU-Z еще не вполне корректно распознавала новинку, однако основные технические характеристики видеокарты отображены на скриншоте.

Видеокарта предлагается в компактной коробке. В комплекте лишь краткое руководство по установке устройства.

Внешен видеокарта очень напоминает Palit GeForce GTX 1660 Ti DUAL. Это двухслотовый адаптер средних габаритов длиной 236 мм.

Для устройства используется оригинальный кулер, включающий наборную кассету из алюминиевых пластин, пронизанных парой тепловых трубок. Элементы силовой подсистемы и чипы памяти контактируют с основным охладителем через теплопроводящие прокладки.

Радиаторный блок продувается двумя 90-миллиметровыми вентиляторами осевого типа с полупрозрачными лопастями. Сверху видеокарту прикрывает пластиковый кожух с несложным декоративным оформлением.

Для подключения дополнительного питания видеокарты предусмотрен один 8-контактный разъем. NVIDIA рекомендует использовать для систем с GeForce GTX 1660 SUPER использовать блоки питания мощностью от 450 Вт. Такие же требования указаны и на упаковочной коробке рассматриваемой модели.

Тыльная сторона адаптера прикрыта пластиковой крышкой с исключительно декоративной функцией. Панель закрывает печатную плату, что добавляет целостности внешнему виду устройства. Это может иметь значение если используется корпус с прозрачной боковой стенкой.

На интерфейсную панель выведены три видеовыхода – полноразмерные DisplayPort, HDMI и DVI-D. Последний все реже встречается на новых видеокартах, но для тех кто не планирует менять свой возрастной монитор, такой порт позволяет обойтись без дополнительных переходников.

Примерно две трети панели обильно перфорированы крупными ячейками для вывода нагретого воздуха за пределы системного блока. Учитывая продольную ориентацию алюминиевых пластин радиатора такая конструкция заглушки вполне оправдана – часть воздуха изначально выдувается вентиляторами видеокарты.

Palit GTX1660 Super GamePro OC 6G не осталась без декоративной подсветки. На верхней кромке под крупной надписью GeForce GTX расположен сегмент со световодом, который подсвечивается белым.

Режимы работы иллюминации можно настроить в фирменном приложении Palit Thunder Master. Возможностей здесь не так много. Регулируется яркость свечения, доступная опция с пульсацией, а также изменением интенсивности в зависимости от температуры GPU. Также можно отключить подсветку.

В работе

В режиме покоя видеокарта не останавливает вентиляторы системы охлаждения. По умолчанию они вращаются со скоростью порядка 1000 об/мин.

Уровень издаваемого шума минимальный, вряд ли они будут слышны в закрытом корпусе. Учитывая активное охлаждение, температура GPU в простое едва превышает 30С.

Под игровой нагрузкой на открытом стенде графический процессор прогревался всего до 65С. При этом скорость вращения вентиляторов на пике увеличивалась вплоть до 2000 об/мин.

Согласно заданному алгоритму, скорость вращения вентиляторов повышается до 76% от максимума при достижении температуры чипа в 63С. На наш взгляд, эффективности используемого кулера достаточно, чтобы без последствий снизить обороты, не опасаясь перегрева GPU.

Для этого можно воспользоваться той же утилитой Thunder Master, где есть возможность вручную установить график зависимости скорости вращения вентиляторов от температуры процессора. При желании здесь можно поэкспериментировать. Финальные цифры будут зависеть от условий использования видеокарты. Логично будет подобрать такой алгоритм, при котором GPU не будет нагреваться выше 70–75С. Здесь результаты будут зависеть от общих условий охлаждения компонентов внутри корпуса. Опять таки, на открытом стенде при максимальных ~1600 об/мин температура GPU поднималась до 70–72С.

Благодаря работе динамического авторазгона GPU Boost, графический процессор под нагрузкой ускорялся до 1965 МГц. В среднем рабочие частоты были все же пониже – 1880–1920 МГц.

Разгон GeForce GTX 1660 SUPER

Конечно нам интересно было оценить разгонный потенциал потенциал GeForce GTX 1660 SUPER. Графический процессор TU116 зачастую уверенно берет планку в 2000 МГц под нагрузкой. Учитывая базовые значения и даже заводское ускорение модели от Palit, чип наверняка имеет дополнительный потенциал.

По результатам экспериментов начальное значение частоты удалось увеличить до 1620 МГц (+5,8%). При этом среднее ускорение повысилось с 1830 до 1920 МГц.

Нам также удалось очень неплохо ускорить чипы памяти. Микросхемы GDDR6 работали на 15 800 МГц вместо штатных 14 000 МГц. Итоговые 380 ГБ/c – внушительная пропускная способность для видеокарты такого класса. Это вдвое больше, чем у GeForce GTX 1660. Дополнительные +13% к эффективной рабочей частоте чипов памяти наверняка скажутся на производительности.

После дополнительного разгона, температура GPU под нагрузкой повысилась до 69С, а пиковая скорость вращения вентиляторов увеличилась до 2100 об/мин. Скорость вращения можно корректировать, но тут стоит следить за увеличивающейся температурой чипа при форсаже.

Производительность

Учитывая технические характеристики GeForce GTX 1660 SUPER, основной интригой в появлении этой модели было то, какое место она займет в табели о рангах устройств на базе Turing. Даже без практических экспериментов можно было предположить, что производительность Super-версии окажется между таковой для классической GTX 1660 и GTX 1660 Ti, но вот фактическое соотношение сил все же было очень любопытно.

Для наглядности мы также добавили результаты GeForce GTX 1070 8 ГБ – очень удачной модели класса middle-top на базе GPU с архитектурой Pascal. Видеокарта представлена 3,5 года назад и была очень желанной покупкой для тех, кто готов тратить на видеокарту порядка $400.

В списке участников экспресс-теста недостает представителя от AMD. Здесь была бы уместной Radeon RX 590 8 ГБ. С этой моделью зачастую уверенно соперничает GeForce GTX 1660 6 ГБ, тогда как ускоренная Super-версия очевидно смогла бы подтянуть производительность в проектах, где чуть выигрышнее смотрится решение AMD.

«Междусобойчик» NVIDIA мы начинаем с результатов 3DMark Time Spy. Начало очень даже многообещающее. В стоковом варианте GeForce GTX 1660 SUPER всего на 5% уступила GeForce GTX 1660 Ti, опередив обычную версию на 12%. GeForce GTX 1070 в этом DX12-тесте смогла опередить лишь базовую GTX 1660. Однако это все же оптимистичная синтетика, посмотрим на положение дел в реальных играх.

Первые замеры показывают, что соотношение сил представительниц серии GTX 1660 примерно сохраняется на том же уровне. Super-модификация тяготеет к показателям GTX 1660 Ti, имея заметное преимущество над обычной версией. Очевидно, что пропускная способность памяти в этой конфигурации GPU заметно сдерживает общий потенциал видеокарты.

Заводской разгон рассматриваемой видеокарты Palit приносит дополнительный буст на уровне 2–3%. А вот дополнительный ручной разгон с форсированием GPU и чипов памяти может увеличить показатели GTX 1660 Super на 5–10% (в среднем – 8,2%). И этого оказывается достаточно для того, чтобы в большинстве игр такая версия оказывалась быстрее остальных участников теста.

С помощью умеренного разгона вполне реально получить результаты GeForce GTX 1660 Ti. Тюнингованные версии видеокарт в штатном режиме не будут получать подобного ускорения, но если самому озаботиться разгоном, это вполне реально. NVIDIA в последнее время старалась не допускать ситуаций, в которых младшая модель линейки была бы способна дотянуться до показателей следующего устройства серии, которое стоит дороже.

Появление GeForce GTX 1660 SUPER можно назвать атипичной ситуацией и наверняка это не просто желание производителя оптимизировать свою линейку. Градация моделей GTX 1660 и GTX 1660 Ti в плане цены и производительности изначально была вполне приемлемой. Острой необходимости выпускать Super-версию, которая по производительности тяготеет к GTX 1660 Ti, а цене – к GTX 1660, наверняка не было. Вернее, она назревала, но совсем по иной причине. Это похоже на подготовку к появлению в этом сегменте новых решений от конкурента на базе чипов Navi с архитектурой RDNA.

Total War: Three Kingdoms и Borderlands 3 показали, что есть еще проекты в которых GeForce GTX 1070 8 ГБ может продемонстрировать свои сильные стороны. Конечно, это если не учитывать тот факт, что она заметно дороже дерзких новичков на Turing, а модели серии GTX 1660 в целом скорее являются заменой для GeForce GTX 1060. Просто так получилось, что из-за своих возможностей они могут «подсиживать» даже устройства предыдущего поколения классом повыше. Кстати, это наглядный пример прогресса дискретной графики, на который не всегда обращаешь внимание. Новые видеокарты за $229 на равных тягаются с моделями за $379, представленными 3,5 года назад.

Энергопотребление

В рамках тестирования мы замеряли общее энергопотребление платформы под игровой нагрузкой. Полученные значения представлены на диаграмме.

Ожидаемо самой экономичной оказалась базовая версия GeForce GTX 1660. Несмотря на идентичный TDP в 120 Вт, на 10–15 Вт больше расходует GeForce GTX 1660 Ti. Еще на 5 Вт больше энергии требовала GTX 1660 SUPER. Тепловой пакет новинки не случайно увеличен до 125 Вт – этого явно потребовали скоростные чипы памяти GDDR6, работающие на эффективных 14 000 МГц. Дополнительный разгон GPU/памяти также увеличивает потребление на 10–15 Вт.

При заявленном TDP в 150 Вт, видеокарта GeForce GTX 1070 расходует заметно больше энергии, чем экономичное семейство GTX 1660. Речь о дополнительных 40–50 Вт. Налицо еще один пример улучшения энергоэффективности Turing.

Итоги

GeForce GTX 1660 SUPER стала приятным сюрпризом осеннего игрового сезона. Эффектным техническим приемом NVIDIA удалось заметно улучшить привлекательность своих решений среднего уровня. Скоростная память GDDR6 позволила новинке приблизиться к показателям GeForce GTX 1660 Ti, заметно (~10–15%) опередив классическую модель GeForce GTX 1660 с чипами GDDR5. Учитывая стоимость и возможности Super-версии, первым моделям на TU116 явно понадобится дополнительная уценка. Стоит отметить и программные апдейты NVIDIA. «Звенящую» картинку повышенной резкости теперь можно получить без потерь производительности и сложных настроек, а любители визуальных эффектов получили возможность в экспериментировать с фильтрами ReShade.

Плюсы: Отличное соотношение производительность/цена; хорошие возможности для игр в режиме Full HD с высоким качеством графики; эффективная система охлаждения; отвод тепла от элементов VRM и чипов памяти; заводской разгон; потенциал для дальнейшего ускорения; дополнительная подсветка

Минусы: Скорость вращения вентиляторов под нагрузкой желательно снизить (можно настроить самостоятельно)

Вывод: Рассмотренная версия GeForce GTX 1660 SUPER от Palit в целом производит хорошее впечатление. Субъективно для адаптера нужна лишь небольшая корректировка алгоритма работы кулера под нагрузкой. Процедуру легко можно провести с помощью комплектной утилиты Thunder Master. В остальном, все вполне на уровне. Стартовый заводской разгон приносит пару-тройку дополнительных кадров/с, а потенциал для дальнейшего ускорения позволяет оставить позади таких грозных оппонентов как GeForce GTX 1660 Ti и GeForce GTX 1070. Стоимость модели вскоре можно будет узнать на hotline.ua, но наверняка она будеть чуть ниже, чем у схожих моделей других вендоров. В любом случае в начале продаж не стоит ожидать $229 даже с поправкой на налоги и логистику, здесь нужно будет время для снижения стартового ажиотажа.

Технические характеристики

Разгон. Результаты тестов — Страница 2

Содержание материала

Страница 2 из 3

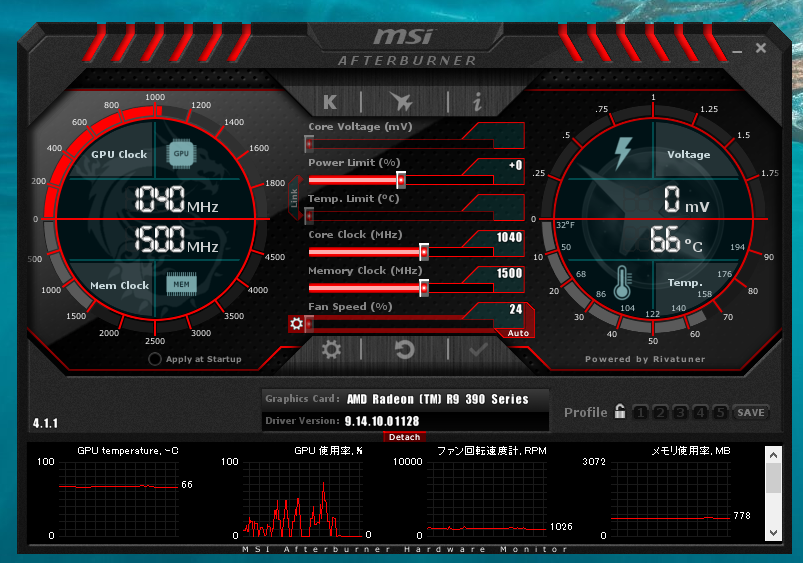

Разгон видеокарты GeForce GTX 660Ti Phantom

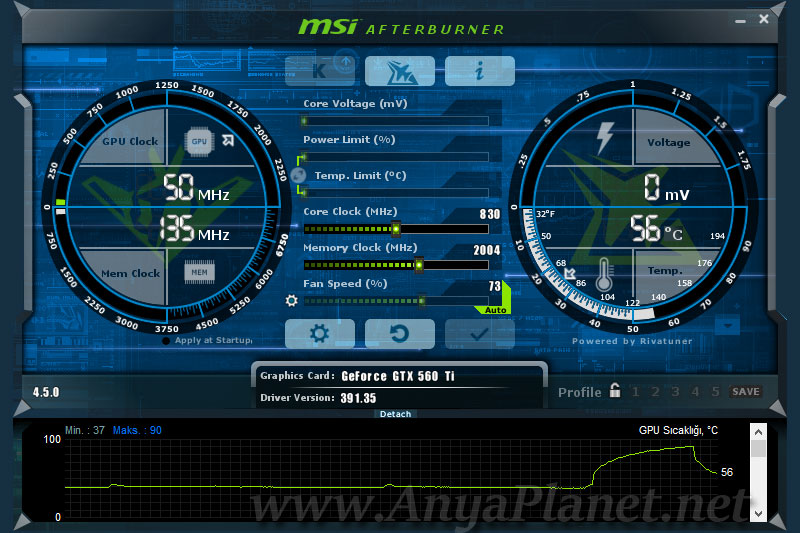

Для разгона мы использовали утилиту MSI Afterburner 2.3.0. Сначала увеличили предел энергопотребления:

Далее начали разгон:

Срабатывание защиты отслеживали через графики:

Итоговый разгон:

Напряжение на GPU повышено на 50 мВ.

Даже с учетом заводского разгона, видеокарта разогналась весьма прилично. А с памятью не повезло — собственно она уже на заводе установлена на своей номинальной частоте и даже немного выше.

Показатель «качества» GPU:

Похоже, что Nvidia пытается отучать от этого показателя — он для трех карт 600-го семейства, которые были у нас, оказался равен 100%.

Результаты тестирования видеокарт

Расшифровка обозначений на диаграммах:

nVidia GeForce GTX 580 3072Mb (772/1002) — Leadtek GeForce GTX 580 3072Mb на новом стенде;

nVidia GeForce GTX 580 3072Mb (900/1200) — Leadtek GeForce GTX 580 3072Mb на новом стенде и с разгоном;

AMD Radeon HD 7970 3072Mb (925/1375) — AMD Radeon HD 7970 в номинале;

AMD Radeon HD 7970 3072Mb (1125/1575) — AMD Radeon HD 7970 с разгоном;

NVidia GeForce GTX 660 Ti 2048Mb (915/1502) — NVidia GeForce GTX 660 Ti на номинальной частоте;

NVidia GeForce GTX 660 Ti 2048Mb (1106/1577) — NVidia GeForce GTX 660 Ti с разгоном;

NVidia GeForce GTX 670 2048Mb (915/1502) — NVidia GeForce GTX 670 с номинальной частотой;

AMD Radeon HD 7870 2048Mb (1000/1200) — AMD Radeon HD 7870 в номинале;

AMD Radeon HD 7870 2048Mb (1250/1400) — AMD Radeon HD 7870 в разгоне;

AMD Radeon HD 7950 3072Mb (800/1250) — AMD Radeon HD 7950 без разгона;

AMD Radeon HD 7950 3072Mb (1125/1800) — AMD Radeon HD 7950 с разгоном;

Palit GeForce GTX 680 4096Mb (1006/1502) — Palit GeForce GTX 680 JetStream 4096Мб с номинальной частотой GeForce GTX 680;

Palit GeForce GTX 680 4096Mb (1106/1702) — Palit GeForce GTX 680 JetStream 4096Мб c разгоном.

Результаты тестов видеокарты NVidia GeForce GTX 660 Ti выделены голубым на диаграммах.

3DMark 11

Производительность новинки в данной дисциплине очень достойная — на уровне Radeon HD 7950, как в номинале, так и после разгона.

Heaven Benchmark 3.0

Баллы:

Урезание шины памяти не могло не сказаться — GeForce GTX 670 вне досягаемости даже после разгона. А с соперниками GeForce GTX 660Ti расправляется вполне уверенно.

Кадры в секунду:

S.T.A.L.K.E.R.: Call of Pripyat

Без сглаживания GeForce GTX 660Ti не хватает звезд с неба — производительность на уровне 7950 первой редакции, и это после разгона.

Включение сглаживания Х4 сдвигает GeForce GTX 660Ti на одну позицию вниз — GeForce GTX 580 выходит вперед.

Aliens vs Predator

AvP уже давно «захвачен красными», так что большого успеха от GeForce GTX 660Ti я не ждал. Так оно и вышло 🙂 Производительность очень сильно падает после включения антиалиасинга.

Lost Planet 2

В Lost Planet 2 GeForce GTX 660Ti произвела небольшую сенсацию — производительность очень высока. Даже Radeon HD 7970 не устоял.

Metro 2033

В Metro 2033 GeForce GTX 660Ti не менее успешно компенсирует предыдущий триумф таким же сенсационным провалом, так …

Без сглаживания:

Так и при включении сглаживания Х4:

Экстремальный разгон и вольтмод видеокарты Palit GeForce GTX 780 Super JetStream

Введение

Мы стремимся уважать информацию личного характера, касающуюся посетителей нашего сайта. В настоящей Политике конфиденциальности разъясняются некоторые из мер, которые мы предпринимаем для защиты Вашей частной жизни.

Конфиденциальность информации личного характера

«Информация личного характера» обозначает любую информацию, которая может быть использована для идентификации личности, например, фамилия или адрес электронной почты.

Использование информации частного характера.

Информация личного характера, полученная через наш сайт, используется нами, среди прочего, для целей регистрирования пользователей, для поддержки работы и совершенствования нашего сайта, отслеживания политики и статистики пользования сайтом, а также в целях, разрешенных вами.

Раскрытие информации частного характера.

Мы нанимаем другие компании или связаны с компаниями, которые по нашему поручению предоставляют услуги, такие как обработка и доставка информации, размещение информации на данном сайте, доставка содержания и услуг, предоставляемых настоящим сайтом, выполнение статистического анализа. Чтобы эти компании могли предоставлять эти услуги, мы можем сообщать им информацию личного характера, однако им будет разрешено получать только ту информацию личного характера, которая необходима им для предоставления услуг. Они обязаны соблюдать конфиденциальность этой информации, и им запрещено использовать ее в иных целях.

Мы можем использовать или раскрывать Ваши личные данные и по иным причинам, в том числе, если мы считаем, что это необходимо в целях выполнения требований закона или решений суда, для защиты наших прав или собственности, защиты личной безопасности пользователей нашего сайта или представителей широкой общественности, в целях расследования или принятия мер в отношении незаконной или предполагаемой незаконной деятельности, в связи с корпоративными сделками, такими как разукрупнение, слияние, консолидация, продажа активов или в маловероятном случае банкротства, или в иных целях в соответствии с Вашим согласием.

Мы не будем продавать, предоставлять на правах аренды или лизинга наши списки пользователей с адресами электронной почты третьим сторонам.

Доступ к информации личного характера.

Если после предоставления информации на данный сайт, Вы решите, что Вы не хотите, чтобы Ваша персональная информация использовалась в каких-либо целях, связавшись с нами по следующему адресу: [email protected].

Наша практика в отношении информации неличного характера.

Мы можем собирать информацию неличного характера о Вашем посещении сайта, в том числе просматриваемые вами страницы, выбираемые вами ссылки, а также другие действия в связи с Вашим использованием нашего сайта. Кроме того, мы можем собирать определенную стандартную информацию, которую Ваш браузер направляет на любой посещаемый вами сайт, такую как Ваш IP-адрес, тип браузера и язык, время, проведенное на сайте, и адрес соответствующего веб-сайта.

Использование закладок (cookies).

Файл cookie — это небольшой текстовый файл, размещаемый на Вашем твердом диске нашим сервером. Cookies содержат информацию, которая позже может быть нами прочитана. Никакие данные, собранные нами таким путем, не могут быть использованы для идентификации посетителя сайта. Не могут cookies использоваться и для запуска программ или для заражения Вашего компьютера вирусами. Мы используем cookies в целях контроля использования нашего сайта, сбора информации неличного характера о наших пользователях, сохранения Ваших предпочтений и другой информации на Вашем компьютере с тем, чтобы сэкономить Ваше время за счет снятия необходимости многократно вводить одну и ту же информацию, а также в целях отображения Вашего персонализированного содержания в ходе Ваших последующих посещений нашего сайта. Эта информация также используется для статистических исследований, направленных на корректировку содержания в соответствии с предпочтениями пользователей.

Агрегированная информация.

Мы можем объединять в неидентифицируемом формате предоставляемую вами личную информацию и личную информацию, предоставляемую другими пользователями, создавая таким образом агрегированные данные. Мы планируем анализировать данные агрегированного характера в основном в целях отслеживания групповых тенденций. Мы не увязываем агрегированные данные о пользователях с информацией личного характера, поэтому агрегированные данные не могут использоваться для установления связи с вами или Вашей идентификации. Вместо фактических имен в процессе создания агрегированных данных и анализа мы будем использовать имена пользователей. В статистических целях и в целях отслеживания групповых тенденций анонимные агрегированные данные могут предоставляться другим компаниям, с которыми мы взаимодействуем.

Изменения, вносимые в настоящее Заявление о конфиденциальности.

Мы сохраняeм за собой право время от времени вносить изменения или дополнения в настоящую Политику конфиденциальности — частично или полностью. Мы призываем Вас периодически перечитывать нашу Политику конфиденциальности с тем, чтобы быть информированными относительно того, как мы защищаем Вашу личную информацию. С последним вариантом Политики конфиденциальности можно ознакомиться путем нажатия на гипертекстовую ссылку «Политика конфиденциальности», находящуюся в нижней части домашней страницы данного сайта. Во многих случаях, при внесении изменений в Политику конфиденциальности, мы также изменяем и дату, проставленную в начале текста Политики конфиденциальности, однако других уведомлений об изменениях мы можем вам не направлять. Однако, если речь идет о существенных изменениях, мы уведомим Вас, либо разместив предварительное заметное объявление о таких изменениях, либо непосредственно направив вам уведомление по электронной почте. Продолжение использования вами данного сайта и выход на него означает Ваше согласие с такими изменениями.

Связь с нами. Если у Вас возникли какие-либо вопросы или предложения по поводу нашего положения о конфиденциальности, пожалуйста, свяжитесь с нами по следующему адресу: [email protected].

ЗакрытьКак разогнать видеокарту | Windows коучинг

Всем привет! Основной причиной торможения видео и графики в играх является слабая видеокарта. Выйти из такого положения можно путем замены устаревшей видеокарты на другую с лучшими параметрами. Но такой вариант является дорогостоящим, и поэтому не каждый пользователь может осуществить такую замену. Кроме такого варианта имеется еще один – это разгон видеокарты.

Как известно, видеокарты выпускаются двумя популярными компаниями: «NVidia» и «ATI». В данном материале уделим внимание рассмотрению вопроса о том, как разогнать видеокарту «GeForce» от «NVidia» и с какой целью это делают. Ведь именно видеокарты «GeForce» являются наиболее подходящими для игр.

Как разогнать видеокарту и что вообще представляет собой разгон видеокарты?

Разгон видеокарты представляет собой процесс, при котором осуществляется изменение штатных параметров работы устройства, тем самым осуществляется увеличение ее производительности. Разогнав видеокарту, предоставляется возможность пользователю комфортно играть в компьютерные игры, то есть такие игры, которые на штатных настройках видеокарты не запускаются.

Как узнать, какая видеокарта стоит на компьютере?

Важно знать! Разгон видеокарты позволяет сэкономить финансы, так как при этом не потребуется приобретать новое более мощное устройство.

Казалось бы, все очень просто, главное выполнить процедуру разгона видеокарты. Но в действительности не все так просто, ведь после разгона видеокарта становится более подверженной высокой вероятности выхода из строя. Если пользователь принимает решение разогнать видеокарту, то такими действиями он ставит под угрозу выход из строя аппаратной части компьютера. Не рекомендуется проводить такие действия, если отсутствует уверенность в том, что видеокарта выдержит высокие нагрузки.

Важно знать! Чтобы обеспечить надежную работу разогнанной видеокарты, требуется не выжимать из нее все соки и подходить с умом к ее производительности.

Для примера возьмем видеокарту GeForce типа GT 520M, которую и будем разгонять. Аналогичным способом можно осуществить разгон любой видеокарты производителя Nvidia. Для видеокарт от компании ATI (Radeon) существует другая методика разгона, о которой будет рассмотрено в другом материале.

Как разогнать видеокарту: Поэтапная инструкция

Разгон видеокарты GeForce предусматривает увеличение следующих параметров работы устройства:

— Частота графического ядра.

— Частота памяти.

— Частота шейдерных блоков.

Как можно узнать температуру видеокарты?

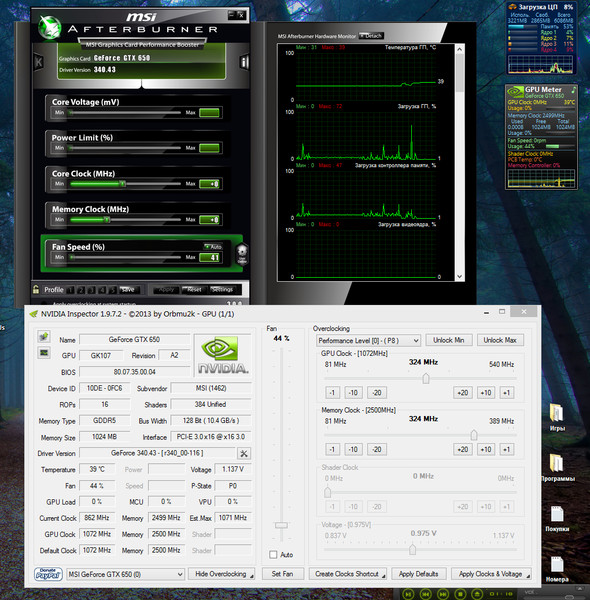

Кроме этого также понадобится увеличить напряжение питания видеокарты. Приступаем к процессу разгона изделия. Для этого первоначально требуется загрузить с официального сайта утилиту под названием GPU-Z. Эта утилита нужна для того, чтобы узнать показатели видеокарты.

После того, как приложение будет загружено и запущено, на экране компьютера появится информация о характеристиках видеокарты.

Выше на скриншоте видно, что видеокарта типа «GeForce GT 520M» в штатном режиме обладает следующими параметрами: частота графического ядра составляет 650 MHz, частота памяти видеокарты 667 MHz, частота шейдерных блоков составляет 1344 MHz. Также обязательно обратите внимание, чтобы приложение показывало информацию о видеокарте GeForce, а не о встроенном графическом адаптере. Для этого в левой нижней части выберите соответствующее название видеокарты.

При помощи данного приложения можно определить продуктивность анализируемой видеокарты: пропускная способность памяти составляет 12,8 GB/s.

Для разгона видеокарты, вышеуказанные и выделенные параметры требуется изменить, для чего не обойтись без приложения под названием «nVidia Inspektor». Это приложение не требует установки на компьютер, поэтому после скачивания, сразу осуществляем запуск. Открывается окошко с перечнем информации, а снизу имеется кнопка с названием «Show Overclocking».

После нажатия по этой кнопке появится диалоговое окно, в котором потребуется нажать на кнопку «Да». Теперь перед вами открывается окно, в котором можно осуществить разгон видеокарты.

Теперь для разгона видеокарты следует изменить значение частоты ядра, которое указано на английском, как GPU Clock, а также частота шейдерных блоков (Schader Clock). Данные параметры являются взаимосвязанными, поэтому при увеличении частоты шейдерных блоков происходит автоматическое увеличение значение частоты графического ядра.

Важно знать! Увеличивать значение частоты шейдерных блоков можно не более чем на 15%. Увеличение на большее значение может повлечь за собой выход из строя видеокарты.

Как повысить FPS?

При увеличении значения 1344 MHz на 15% получится 1545 MHz. Для вступления изменений в силу, потребуется нажать кнопку «Apply Clock & Voltage». Прежде чем переходить к повышению частоты памяти устройства, требуется первоначально убедиться в стабильности работы видеокарты с новыми параметрами частоты шейдерных блоков и ядра. Для этого видеокарту требуется протестировать, после чего на основании теста выяснить графические возможности устройства.

Важно знать! Для тестирования видеокарты мною используется приложение «FunMark».

Особенности тестирования видеокарты с помощью FunMark

Чтобы проверить и протестировать видеокарту, потребуется установить на компьютер приложение FunMark. После открытия приложения требуется кликнуть по кнопке «Burn-in test», после чего наблюдать за появившейся картинкой. Узнать о том, что видеокарта работает нормально с новыми параметрами можно по отсутствию таких эффектов, как мерцание, мигание, возникновение точек и прочие действия. Немаловажно и следить за температурными значениями видеокарты. Температурные значения отображаются в нижней части окна открытого приложения. Значение не должно превышать показатель в 90 градусов Цельсия. В случае возникновения различных фигур или артефактов, или же значение температуры начнет превышать показания в 90 градусов, то тест потребуется немедленно остановить. Сделать это можно путем нажатия на кнопку с названием «Escape». После этого снижаем частоту шейдерных блоков на 5%, а затем вновь повторяем процесс тестирования. Ниже представлено окно тестирования видеокарты при помощи приложения FunMark.

После того, как будут найдены оптимальные значения частоты шейдерных блоков и ядер, потребуется вернуться к приложению nVidia Inspektor, чтобы увеличить частоту памяти видеокарты. Для этого на 15% увеличивается значение под названием «Memory Clock». Сохраняются параметры, после чего повторяется тестирование видеокарты. При возникновении артефактов осуществляется снижение установленного предварительно значения.

После того, как будут найдены оптимальные значения частот, потребуется только поднять величину напряжения. Для этого при помощи значения «Voltage», понадобится сместить ползунок вправо на 1 шаг. Если ползунок установлен на максимальном значении, как в нашем случае, то данную процедуру следует пропустить.

Переходить из штатного состояния видеокарты в разогнанное, можно при помощи специального сохраненного файла. Для этого необходимо сохранить внесенные настройки в приложении nVidia Inspector. Такой файл сохраняется непосредственно после осуществленных настроек. Для этого в окне приложения требуется выбрать пункт с названием «Creat Clocks Chortcut». При этом файл появится на рабочем столе вашего компьютера. Файл нужно будет попросту запустить в тот момент, когда потребуется использовать видеокарту в разогнанном режиме. Можно также сохраненный файл добавить в папку «Автозагрузка», после чего его запуск будет выполняться автоматически при старте компьютера.

Если возникает потребность разгона видеокарты на постоянной основе, что делать не рекомендуется, то для этого потребуется войти в оболочку BIOS, и провести соответствующую прошивку. Как это сделать, можно найти в интернете, но стоит еще раз повториться, что делать это не рекомендуется, так как риск выхода из строя устройства повышается до 99%. Обязательно запомните это, уважаемые пользователи.

Как увеличить быстродействие компьютера?

Итак, подводя итог сегодняшнего выпуска «Как разогнать видеокарту» немаловажно стоит отметить, что после разгона видеокарты ее рабочая температура будет увеличена, поэтому немаловажно предусмотреть установку дополнительных кулеров для охлаждения. Для контроля температуры видеокарты. Процессора и прочих устройств, потребуется загрузить специальную утилиту. При этом нужно заботиться о техническом состоянии основных элементов компьютера: процессор, видеокарта, материнская плата, жесткий диск. К тому же обязательно избегайте появления слоя пыли на плате видеокарты, в противном случае в разогнанном состоянии она попросту сгорит.

Если у вас возникли какие-либо вопросы, предложения или пожелания относительно этой статьи или всего блога в целом, тогда жду ваших комментариев, уважаемые друзья!

Руководство по разгоне NVIDIA Geforce RTX 3060 Ti

Руководство по разгоне NVIDIA RTX 3060 Ti: Введение

Вы здесь, потому что Cyberpunk 2077 работает немного медленно? Возможно, это будущее, и новые видеокарты уже вышли, вы хотите получить немного больше от существующего оборудования. В любом случае цель этой статьи — добиться большей производительности от уже имеющейся у вас видеокарты. В то время как NVIDIA добилась больших успехов в улучшении качества обслуживания конечных пользователей.Мы все еще можем выжать из видеокарты немного больше производительности. В этом руководстве я расскажу о технологии NVIDIA Boost, о разгоне RTX 3060 Ti в ручном режиме и использовании сканера NVIDIA Auto OC Scanner для автономной работы.

Хотя я использую MSI RTX 3060 Ti Gaming X Trio для написания части этого руководства, можно также использовать любой вариант или модель, потому что все они являются графическими процессорами RTX 3060 Ti (GA104) Ampere. Хотя у каждой карты будут разные общие смещения ядра и температуры, описанные здесь принципы разгона NVIDIA RTX 3060 Ti будут одинаковыми для всех видеокарт RTX 3060 Ti.Некоторые из них действительно применимы к другим графическим процессорам Ampere: 3070 (GA104) и, возможно, будущим версиям.

ОТКАЗ ОТ ОТВЕТСТВЕННОСТИ!

ВНИМАНИЕ! Разгоняйте на свой страх и риск. Разгон видеокарты может привести к аннулированию гарантии (если это указано производителем). Это может вызвать другие необратимые проблемы, такие как артефакты видео и преждевременный отказ оборудования! OverclockersClub не несет ответственности за неправильное использование некоторой или всей информации, представленной в этом руководстве. Пожалуйста, если у вас есть вопросы, заходите на форумы и задавайте их! Разгоняйте на свой страх и риск!

Программное обеспечение в руководстве:

MSI Форсаж

MSI Комбустор

UNIGINE Heaven Benchmark

Тест суперпозиции UNIGINE

HWMonitor (дополнительно)

3DMark (дополнительно)

GPU-Z (дополнительно)

Утилиты для конкретных брендов:

EVGA: EVGA Precision X1

Zotac: Утилита FireStorm

MSI: MSI Afterburner

.Гигабайт: AORUS ENGINE

ASUS: графический процессор Tweak II

Palit: ThunderMaster

Видеоурок:

Если вы найдете эти видео полезными, не забудьте оставить отзыв и сообщить нам, как у нас дела! Ваши отзывы на протяжении многих лет оказали огромное влияние на канал и контент YouTube.Мы хотим создавать лучший контент, поэтому все отзывы приветствуются здесь, в OCC!

Общие сведения об NVIDIA Auto GPU Boost:

Перед тем, как погрузиться в разгон, очень важно понять, как NVIDIA справляется с этим автоматически. Да, верно, NVIDIA Boost — это функция, которая была включена в несколько поколений сейчас и включена на базовом уровне в драйверы. Это означает, что хотя NVIDIA действительно гарантирует базовую тактовую частоту для ядра, частота повышения может быть намного выше, чем указано в официальных спецификациях.Вы, наверное, думаете про себя: это отличная новость. Хотя да, это здорово для большинства потребителей, на самом деле это может неосознанно негативно повлиять на ручной разгон. Поскольку это руководство по разгону, а не полное описание архитектуры графического процессора, я дам более короткую версию, охватывающую NVIDIA Boost, для тех, кто хочет узнать немного больше о внутренней работе графического процессора.

NVIDIA Boost разработана просто для того, чтобы предоставить потребителю безопасный и плавный игровой процесс без использования стороннего программного обеспечения для разгона.Он встроен в драйверы и обеспечивает хороший рост производительности при соблюдении правильных условий. Это все хорошо, но что делает NVIDIA Boost для достижения этих результатов, спросите вы? Технология NVIDIA Boost работает очень хорошо и использует три простых для понимания правила, регулирующих NVIDIA Boost. Это предел напряжения, целевой предел мощности и предел температуры. Все три правила в точности такие, как звучат.

Voltage Limit ограничивает общее количество напряжения, которое GPU может получить под нагрузкой.Power Target определяет общее количество энергии, которое видеокарта может потреблять, а Temperature Limit контролирует максимальную рабочую температуру графического процессора. Так, например, если предел напряжения достигнут, графический процессор больше не будет автоматически повышать базовую частоту ядра выше кривой частоты, установленной NVIDIA. Если температура превышает 83 ° C, видеокарта автоматически понижает частоту ядра до тех пор, пока не будет достигнута безопасная температура. Кстати, предельную температуру можно вручную поднять до 90 ° C.

Наконец, если будет достигнута потребляемая мощность, карта больше не будет подавать больше напряжения, что снизит общую тактовую частоту. Все три из них предназначены для защиты графического процессора от чрезмерного разгона.

Что делает это таким важным, так это понимание того, что NVIDIA имеет установленные по умолчанию параметры, которые предназначены для всех типов операционных сред. Однако это означает, что NVIDIA Boost не всегда использует весь потенциал карты. Вот тут-то и пригодится ручной разгон.RTX 3060 Ti, хотя и подчиняется тем же правилам и нормам, похоже, больше всего страдает от ограничения общей мощности платы, как и для остальных графических процессоров Ampere. Даже с этими ограниченными параметрами вы все равно можете получить дополнительную производительность от видеокарты, поэтому это руководство по разгоне существует для вашего потребления.

Требования к питанию:

Хорошо известно, что графический процессор Ampere в целом потребляет много энергии с RTX 3080, а RTX 3090 может легко использовать до 500 Вт, если это разрешено.К счастью, RTX 3060 Ti немного более ручной, со скромным энергопотреблением в 200 Вт для Founders Edition. Партнеры по плате могут увеличить этот предел, однако вы обнаружите, что у многих все еще ниже 250 Вт. Тем не менее, хотя очень важно иметь хороший источник питания, он может стать причиной многих проблем. Не забудьте также рассчитать процессор, если он тоже разогнан. Немного PSA для тех, кто забывает, что при разгоне системы она потребляет больше энергии.

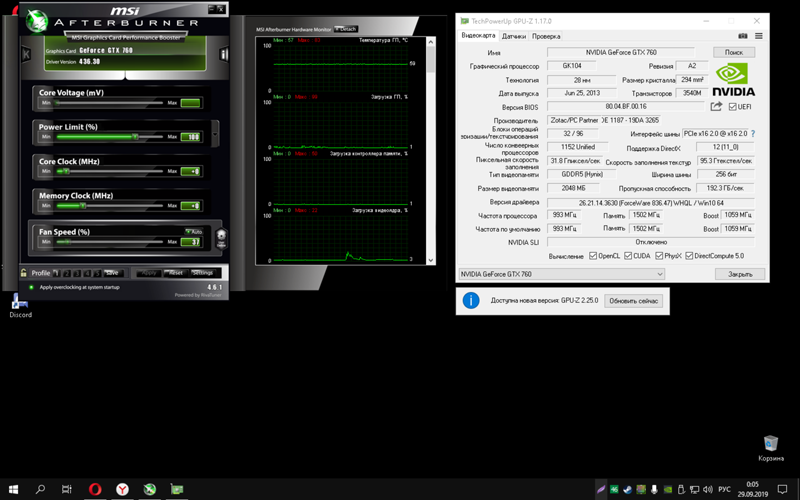

Настройка MSI Afterburner:

Для этого урока я буду использовать MSI Afterburner, потому что по нему легко ориентироваться.Больше всего я сталкиваюсь с тем, что каждый раз, когда я загружаю новую версию MSI Afterburner, скин графического интерфейса по умолчанию меняется. Со временем на видео на YouTube накапливаются комментарии, в которых спрашивают, почему они выглядят иначе. Как и в руководстве по RTX 3080 OC, я решил включить в него описание того, как изменить скин графического интерфейса пользователя, чтобы он выглядел так, как в этом руководстве. Эта часть на 100% необязательна, так как она не влияет на разгон, но будет выглядеть иначе, и все будет перемещено, если вы ее не измените. С учетом сказанного, первое, что вам нужно сделать, это найти символ «Шестеренка» и щелкнуть по нему.

После того, как вы найдете символ «Шестеренки», который открывает меню настроек приложения, перейдите на последнюю страницу в разделе «Пользовательский интерфейс» и установите скин «Белый киборг». Ниже, если вы хотите увеличить размер, вы можете увеличить масштаб до 200%.

Затем, чтобы разблокировать управление напряжением, на вкладке «Общие» вы найдете флажок «Разблокировать управление напряжением». Отметьте его и примените настройки. Это не всегда разблокирует в зависимости от текущих драйверов и версии программного обеспечения.Если он не разблокируется, это не окажет заметного воздействия при использовании воздушного или даже водяного охлаждения. Никто за пределами NVIDIA не знает, насколько сильно этот слайдер влияет на разгон. Я достиг тех же результатов без его включения. В тот момент это могло быть просто пережитком прошлого, когда регулирование напряжения было вариантом. По правде говоря, я не заметил никакой разницы с тех пор, как поколение Паскаля было отключено по сравнению с включенным.

Руководство по разгоне NVIDIA RTX 3060 Ti: Auto OC Scanner

Хорошо, теперь графический интерфейс выглядит лучше, давайте поговорим об Auto OC Scanner.Как гласит история, EVGA первой разработала свою версию публично, которая, конечно же, работала только с картами марки EVGA. Спустя несколько месяцев NVIDIA создала универсальную версию, которую все используют сейчас.

Но вы спросите, что такое Auto OC Scanner? Что ж, это, как кажется, утилита для автоматического разгона. А теперь представьте, что вам не нужно тратить время на получение идеального разгона, а затем выполнять утомительную задачу по проверке стабильности и валидации. Да, именно это и делает эта функция.Откажитесь от ручного разгона и позвольте программе сделать все за вас. Почему это не главное в маркетинговых кампаниях, мне непонятно. Ответ на этот вопрос прост: обычно он ломается при каждом следующем обновлении драйвера. По крайней мере, по моим наблюдениям.

Чтобы использовать эту функцию, вам нужно будет нажать кнопку «OC» в левом верхнем углу, и откроется диалоговое окно. Скажите программе начать сканирование. Это займет добрых 30 минут, так что будьте готовы подождать! Кстати, он не будет регулировать частоту памяти, целевую мощность или температурный предел.Это все еще управляется вручную.

Когда это будет завершено, на Core Clock должно появиться сообщение «Curve», что означает, что используется нелинейный разгон. Вы можете увидеть это в действии, щелкнув значок «Радио» рядом с Core Clock слева. Здесь мы видим, что для каждой точки напряжения на графике значение было скорректировано до «оптимальной» точки, как считает программное обеспечение для автоматического разгона. В целом это очень простой метод для разгона.Однако, как правило, это не самый высокий уровень производительности графического процессора, но он, безусловно, занимает намного меньше времени, чем ручной разгон. Если вам нравится то, что вы видите, обязательно сохраните этот профиль, иначе он будет утерян после закрытия программы, и вам придется перезапустить сканирование заново.

Разгон одним щелчком мыши в Geforce Experience

Чтобы испытать «автоматический» разгон Nvidia, мы взяли нашу тестовую копию Geforce RTX 3080 Founders Edition и установили последнюю бета-версию Geforce Experience.Вопрос, который мы задали себе, заключается в том, может ли Geforce Experience соответствовать нашим ручным усилиям и стоит ли использовать эту функцию.

Новый инструмент совместим со всеми картами серий Turing и Ampere, то есть Geforce RTX 2000 и RTX 3000. Когда эта статья будет опубликована, возможно, что функция вышла из стадии бета-тестирования и является регулярной частью опыт Geforce.

Достаточно грамотный обзор вы получите

Инструмент предоставил немного больше параметров для настройки, чем мы ожидали

Но от результата не падаешь сразу…

Итак, давайте перейдем к тому, как это работает на практике, где мы сравним результаты с базовыми частотами карты и нашим ручным разгоном.

Стандартный | Вручную OC | Geforce Experience OC | |

|---|---|---|---|

Geforce RTX 3080 FE (GPU / RAM) 9154 9197 | 1 749/19 408 |

Geforce Experience « Performance Tuning » оказывается ограничивающим в том, сколько он осмеливается потреблять, и в результате получается тактовая частота и скорость памяти оказывается посередине между стандартными частотами карты и нашим ручным разгоном.2,1 процента.

3DMark Time Spy (Экстремальный) | Battlefield V (4K, Ultra) | |

|---|---|---|

Geforce RTX 3080 FE | 9000 1094 9697 / 91 | |

Geforce RTX 3080 FE (ручной запуск) | 9 069/9 600 | 116/98 |

Geforce RTX 3080 FE (9 Geforce7 OC) 8 807/9 266 | 111/94 |

По фактической производительности не выглядит значительно лучше.В 3Dmark Time Spy оценка графики увеличивается с 9 113 до 9 266, или примерно 1,7 процента, а в Battlefield V средняя частота кадров увеличивается на 1,8 процента. В свою очередь, ручной разгон увеличил результат на 5,3 и 6,4 процента соответственно.

Конечно, впечатления будут немного отличаться в зависимости от того, какая карта у вас есть, какой у нее бюджет мощности в стандартной комплектации, а также от того, разогнана ли она на заводе или нет. Но, судя по нашим тестам, можно констатировать, что разгон с помощью Geforce Experience вряд ли того стоит.

Тот факт, что процесс занимает много времени и что результаты различаются от каждого запуска, также означает, что в настоящее время мы рекомендуем ручной разгон тем, кто действительно хочет добиться большей производительности от своих карт. Если вы думаете, что использовать ручной разгон страшно, то, конечно, неплохо было бы иметь альтернативу, но проблема скорее в том, что эта альтернатива не способствует какому-либо значительному улучшению.

Вы обычно разгоняете видеокарты или запускаете их в стандартной версии? Похоже на то, что автоматический разгон Nvidia вам подходит?

Разгон NVIDIA GeForce RTX 3080 Ti Founders Edition

Введение

2 июня и , 2021 NVIDIA выпустила GeForce RTX 3080 Ti Founders Edition по рекомендованной розничной цене 1199 долларов.Пора взять эту GeForce RTX 3080 Ti, разогнать ее и посмотреть, сможет ли она превзойти заводскую разогнанную GeForce RTX 3090!

GeForce RTX 3080 Ti — это, по сути, урезанная, но очень немного урезанная GeForce RTX 3090. Она основана на той же 8-нанометровой матрице GA102 Samsung, что и GeForce RTX 3090, основанная на архитектуре Ampere. Он имеет 10240 ядер CUDA, 112 ROP, 320 TMU, 80 ядер RT (2 и Gen) и 320 тензорных ядер (3 rd Gen). Тактовая частота Boost установлена на 1665 МГц.Он имеет 12 ГБ GDDR6X вместо 24 ГБ на GeForce RTX 3090. Он работает на частоте 19 ГГц, обеспечивая 912 ГБ / с по 384-битной шине. TDP составляет 350 Вт.

Еще одним фактором, который делает GeForce RTX 3080 Ti Founders Edition уникальным, является то, что он не использует более крупный формат дизайна GeForce RTX 3090 Founders Edition. Вместо этого он использует размер, аналогичный GeForce RTX 3080 Founders Edition. Он по-прежнему использует конструкцию с перевернутым вентилятором с двухтактной конфигурацией, занимая такую же меньшую площадь, как GeForce RTX 3080 FE.Это позволяет легче разместить его в небольших корпусах.

В нашем обзоре видеокарта оказалась очень быстрой. Она фактически не отставала от видеокарты GIGABYTE GeForce RTX 3090 GAMING OC, а в некоторых случаях даже превосходила ее. Это было очень впечатляюще, и наша теория заключалась в увеличении частот GPU Boost. Он мог поддерживать более высокую постоянную частоту ускорения по сравнению с GeForce RTX 3090, и это позволяло ему быстрее вычислять, в основном, несмотря на меньшее количество ядер CUDA, для игр.

Вот почему нам очень любопытно, как он будет себя вести при разгоне. Позволит ли повышение частоты графического процессора и памяти еще больше превзойти заводскую разогнанную GeForce RTX 3090? Посмотрим.

Разгон GeForce RTX 3080 Ti Founders Edition

Перед тем, как разгонять видеокарту, нам действительно нужно было подтвердить, что она работает по умолчанию. В нашем обзоре GeForce RTX 3080 Ti Founders Edition мы выяснили, что во время игр видеокарта работала в среднем около 1804 МГц.Это намного выше указанной частоты разгона в 1665 МГц. GPU Boost работает хорошо, чтобы увеличить частоту видеокарты выше этой. С таким большим ударом уже от GPU Boost мы беспокоились, что может не хватить большого запаса для разгона. Приятно удивились, что в баке еще осталось много бензина.