Большое тестирование и сравнение Nvidia GeForce GTX 980 Ti в 2019

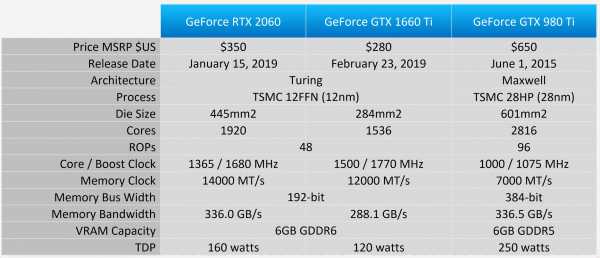

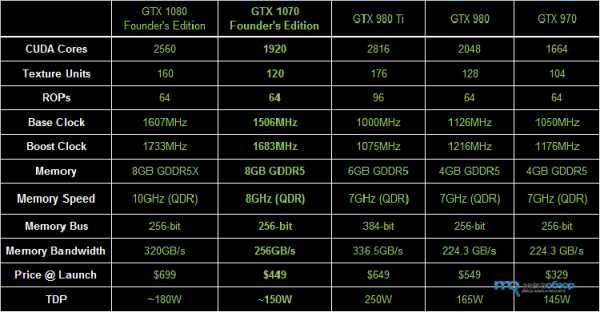

Здравствуйте! Сегодня мы протестируем видеоускоритель GeForce GTX 980 Ti, чтобы увидеть, как он проявит себя в сравнении с недавно выпущенными RTX 2060 и GTX 1660 Ti, особенно в более свежих играх, таких как Apex Legends, Resident Evil 2 и Far Cry New Dawn. Сейчас GTX 1660 Ti продается за 280 долларов, а RTX 2060 стоит 350 долларов, GTX 980 Ti был намного дороже при своём релизе и стоил 650 долларов.

В то время как в 980 Ti присутствуют 2816 ядер CUDA, RTX 2060 имеет на 32% меньше ядер, а 1660 Ti на 45% меньше ядер. Но ядра Тьюринг шире, что позволяет им выполнять больше инструкций за такт, и они работают на более высокой частоте. Спецификация Nvidia для 980 Ti располагает тактовой частотой в 1075 МГц, это дает RTX 2060 преимущество в 56%, а GTX 1660 Ti — 65%.

Графические процессоры Turing также имеют более высокую тактовую частоту памяти типа GDDR6, поэтому RTX 2060 имеет 192-битную шину памяти, в отличие от более широкой 384-битной шины 980 Ti, более быстрая память компенсирует разницу, поэтому оба GPU имеют ту же пропускную способность в 336 ГБ / с. Пропускная способность 1660 Ti была понижена до 288 ГБ/с с памятью 12 Гбит/с, но, как оказалось, это не сильно сказывается на его производительности.

Карты тестировались с процессором Core i9-9900K. Было протестировано в общей сложности 33 игры, обсудим результаты дюжины из них, а затем рассмотрим сводные данные и графики производительности. Все тесты проводились в разрешении 1440p, эталонную карту разогнали до 1190 МГц, что позволило поддерживать тактовые частоты буста в районе 1,3 ГГц по ядру.

Результаты тестирования

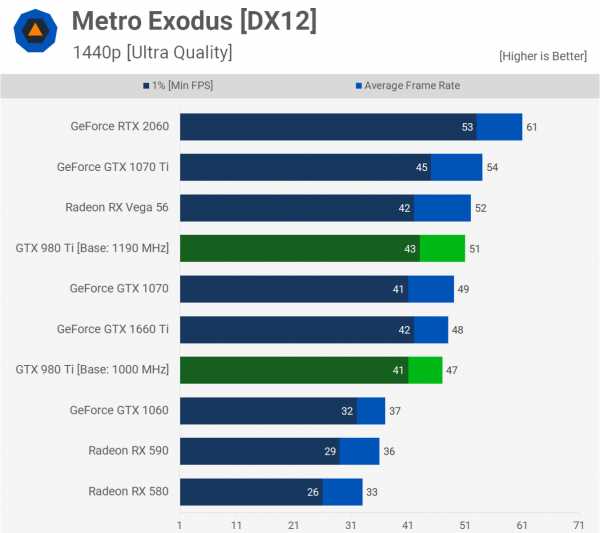

Первый тест в Metro Exodus был единственным, в который включили результат 980 Ti на стоковых частотах. Здесь видно, что разгон обеспечил прирост производительности на 9%, что вполне прилично.

980 Ti немного медленнее в стоке, чем GTX 1070, и немного быстрее в разгоне.

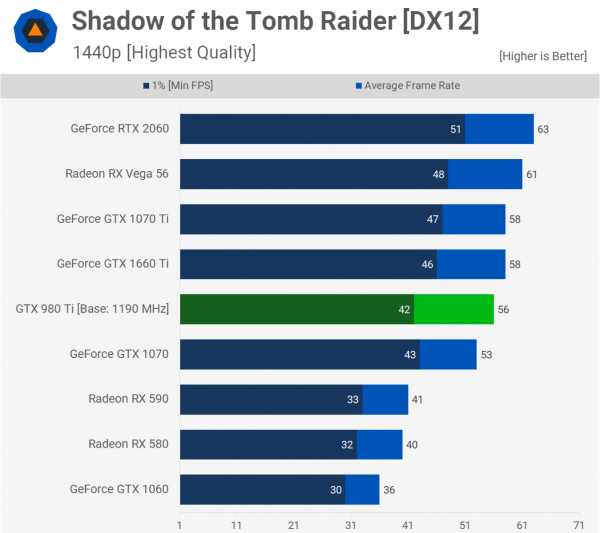

Разогнанный 980 Ti очень хорошо работает в Shadow of the Tomb Raider

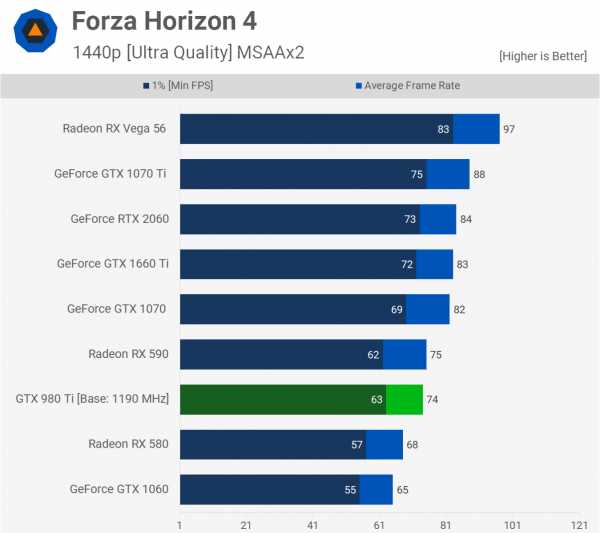

В Forza Horizon 4, GTX 980 Ti смог сравниться только с Radeon RX 590, что на 10% медленнее, чем у 1660 Ti и RTX 2060.

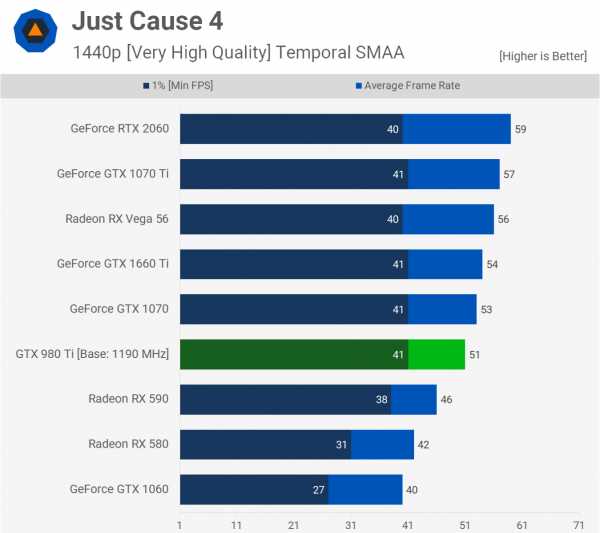

Далее у нас Just Cause 4, и здесь GTX 980 Ti следует за GTX 1070 и 1660 Ti. Ничего необычного в этих результатах, так что давайте двигаться дальше.

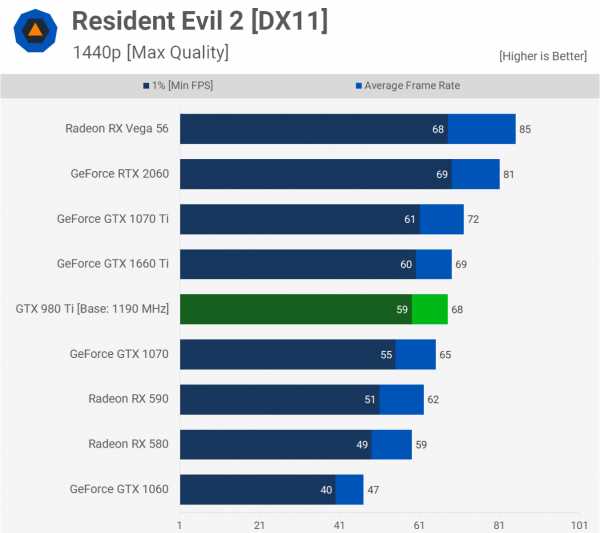

Запустив Resident Evil 2, мы видим, что разогнанный 980 Ti способен примерно соответствовать GTX 1660 Ti, это делает его на 16% медленнее, чем RTX 2060.

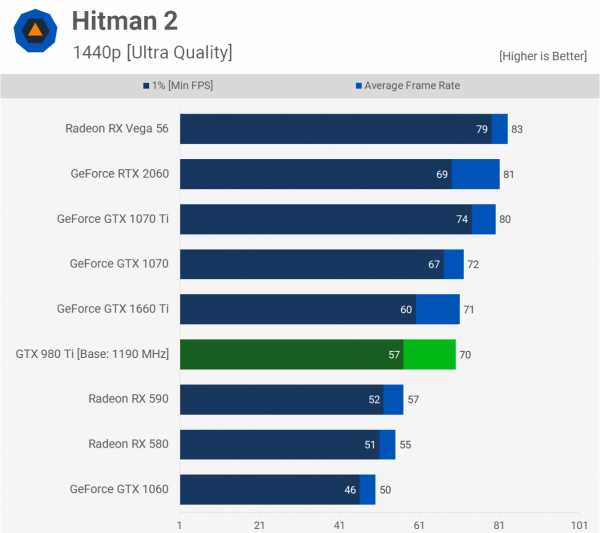

Тестирование в Hitman 2 показало, что 980 Ti соответствует GTX 1660 Ti — это на 14% медленнее, чем RTX 2060, и на 16% медленнее, чем Vega 56. Тем не менее, довольно хороший результат для графического процессора поколения Maxwell.

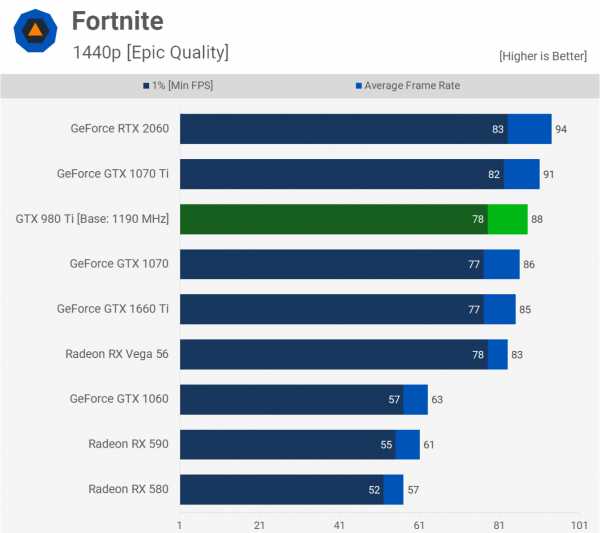

В Fortnite GTX 980 Ti просто вытеснил GTX 1070 и 1660 Ti, уступив лишь немного GTX 1070 Ti и RTX 2060. Он также опередил AMD Vega 56 с запасом в 6%.

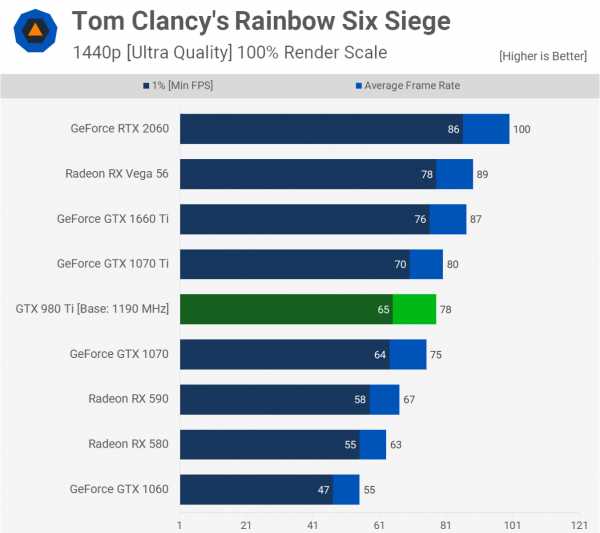

В Tom Clancy’s Rainbow Six Siege, GTX 980 Ti показывает отличные результаты по сравнению с конкурентами Pascal, опережая 1070 на несколько кадров. Тем не менее, Тьюринг очень хорошо работает в этой игре и таким образом, 980 Ti был на 10% медленнее, чем 1660 Ti, и на 22% медленнее, чем RTX 2060.

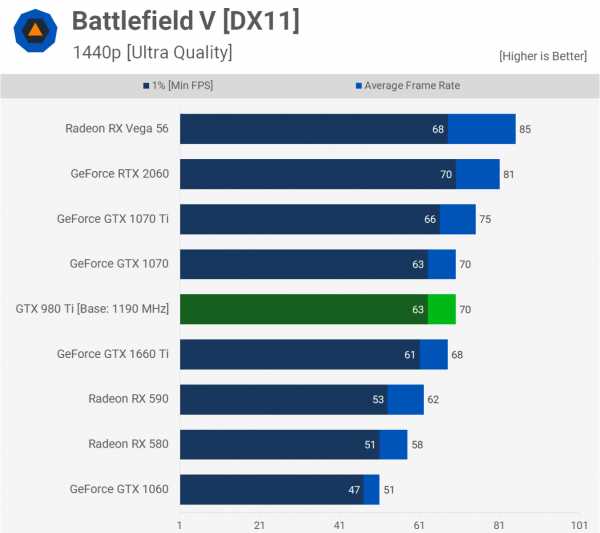

При тестировании в Battlefield V мы видим, что разогнанный GTX 980 Ti находится на одном уровне с GTX 1070 и GTX 1660 Ti.

World of Tanks хорошо оптимизирован для старых архитектур графических процессоров, и Nvidia позаботилась о том, чтобы их старые графические процессоры по-прежнему работали так, как должны в этом популярном тайтле. В случае с 980 Ti это означает обеспечение производительности уровня GTX 1070 Ti, что делает его на 16% быстрее, чем 1660 Ti, и всего на 6% медленнее, чем RTX 2060.

Apex Legends — одна из новейших игр, которые мы тестируем, и, как вы можете видеть, разогнанный GTX 980 Ti отстает от GTX 1070, GTX 1660 Ti и значительно отстает от RTX 2060.

Разрыв с Pascal не слишком велик, но более свежая архитектура Turing обеспечивает здесь значительное повышение производительности, особенно если сравнивать графические процессоры с аналогичным количеством ядер.

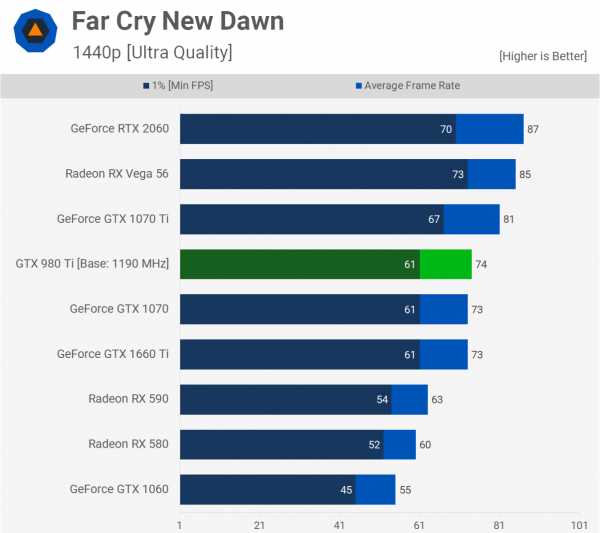

Последняя игра в этом раунде — Far Cry New Dawn. Здесь результаты 980 Ti совпали с GTX 1070 и 1660 Ti со средним значением в 74 кадра в секунду, это на 15% медленнее, чем у RTX 2060.

Индивидуальное сравнение

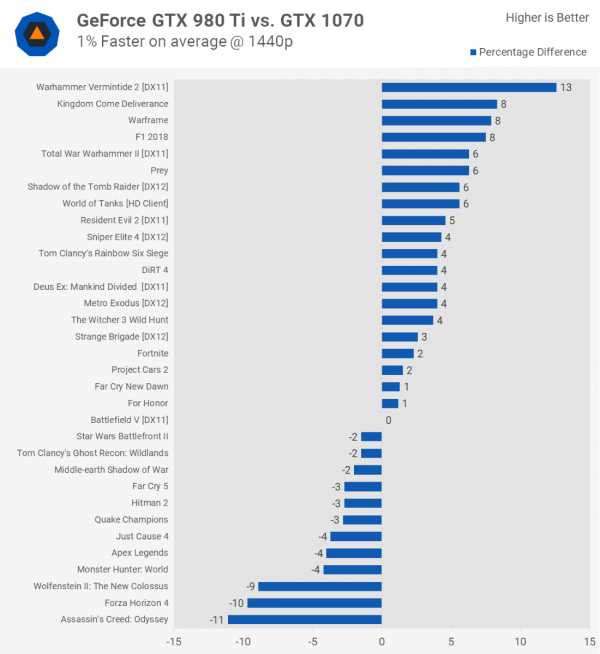

GTX 980 Ti vs. GTX 1070

GTX 980 Ti и GTX 1070 обеспечивают практически одинаковую производительность. В базовой комплектации Nvidia 1070 — немного быстрее, и при разгоне до максимума они также очень близки в производительности.

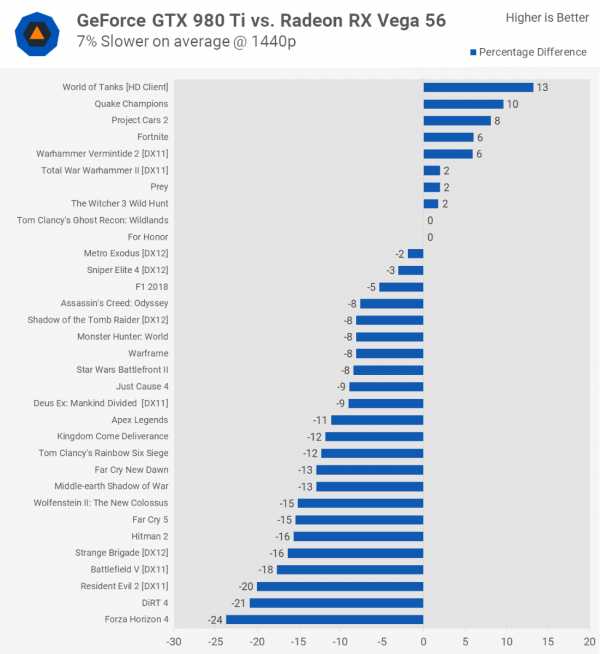

GTX 980 Ti vs. Vega 56

GTX 980 Ti vs. GTX 1660 Ti

GTX 980 Ti vs. RTX 2060

В среднем GTX 980Ti уступает 12%, но также были случаи, когда она была на 20-25% медленнее, например, в Assassin’s Creed Odyssey, Rainbow Six Siege, Wolfenstein II и Apex Legends.

Вывод:

Если вы выбираете между покупкой новой GTX 1660 Ti или подержанной GTX 980 Ti, вы потенциально можете сэкономить около 50 долларов, купив 980 Ti (подержанная цена колеблется около 235 долларов)

Очевидно, что 980 Ti является старым продуктом, поэтому никаких гарантий не будет. Риск экономии 50 долларов, похоже этого не стоит. Существует также проблема поддержки драйверов. Несомненно, GTX 1660 Ti будет устаревать дольше, продвигаясь вперед с оптимизацией под конкретные игры.

В целом, видеоускоритель GTX 980 Ti отлично проявил себя, и сегодня он по-прежнему способен доставить удовольствие от игры в 1440p.

Переведено с сайта techspot

Ещё больше интересного материала, качественного косплея и превосходных артов вы сможете найти >ЗДЕСЬ<!!!

overclockers.ru

Обзор и тестирование видеокарты NVIDIA GeForce GTX 980 Ti / Overclockers.ua

Весной этого года компания NVIDIA представила видеокарту на самом мощном графическом чипе Maxwell, о котором было много слухов, но выпуск реальных решений на базе этого GPU все время откладывался. GeForce GTX Titan X сразу поднял планку производительности на новый уровень, недостижимый для уже существующих графических решений. По мере приближения момента выпуска новой линейки видеоадаптеров AMD во главе с Radeon R9 Fury X последовал еще один упреждающий удар — запуск в серию GeForce GTX 980 Ti.

Увеличение всех вычислительных блоков на половину привело к соответствующему росту размеров кристалла. Столь массивный кремниевый чип выдвигает более серьезные требования к организации питания и охлаждения. Но благодаря энергоэффективной архитектуре Maxwell эти параметры вполне сопоставимы с топовыми решениями прошлых поколений. GeForce GTX 980 Ti будет мощнее и горячее GeForce GTX 980, но заявленный TDP в 250 Вт соответствует уровню GeForce GTX 780 Ti.

| Видеоадаптер | GeForce GTX Titan X | GeForce GTX 980 Ti | GeForce GTX 980 | GeForce GTX 780 Ti |

| Ядро | GM200 | GM200 | GM204 | GK110 |

| Количество транзисторов, млн. шт | 8000 | 8000 | 5200 | 7100 |

| Техпроцесс, нм | 28 | 28 | 28 | 28 |

| Площадь ядра, кв. мм | 601 | 601 | 398 | 561 |

| Количество потоковых процессоров | 3072 | 2816 | 2048 | 2880 |

| Количество текстурных блоков | 192 | 176 | 128 | 240 |

| Количество блоков рендеринга | 96 | 96 | 64 | 48 |

| Частота ядра, МГц | 1000–1075 | 1000–1075 | 1126–1216 | 875–926 |

| Шина памяти, бит | 386 | 386 | 256 | 384 |

| Тип памяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

| Частота памяти, МГц | 7010 | 7010 | 7010 | 7010 |

| Объём памяти, МБ | 12288 | 6144 | 4096 | 3072 |

| Поддерживаемая версия DirectX | 12.1 | 12.1 | 12 | 11.1 |

| Интерфейс | PCI-E 3.0 | PCI-E 3.0 |

www.overclockers.ua

большой Maxwell пошел в массы / Видеокарты

В контексте существующего тренда на развитие GPU в сторону универсальных вычислительных устройств, который активно поддерживает сама NVIDIA, архитектура процессора GM200 стала вынужденным компромиссом. Так как производство крупных дискретных GPU еще не вырвалось из тисков техпроцесса 28 нм, ограничивающего всесторонний рост производительности за счет простого увеличения транзисторных бюджетов, для архитектуры Maxwell пришлось расставить четкие приоритеты: графика – в первую очередь, вычисления двойной точности (FP64) – по остаточному принципу (более подробно об этой архитектуре вы можете прочитать в обзорах GeForce GTX 750 Ti и GeForce GTX 980).

В качестве ускорителя для игр и вычислительных задач, не включающих операции FP64, TITAN X сделал большой шаг вперед относительно как GTX 980, так и группы плат, построенных на старшем чипе архитектуры Kepler – GK110: GTX 780/780 Ti, TITAN/TITAN Black. Но GeForce GTX 980 Ti неизбежно должен быть ограничен в конфигурации вычислительных блоков по сравнению с TITAN X, ведь производительность FP64, и так чрезвычайно низкая у GM200, не может служить фактором, отличающим плату серии TITAN от лидера игровой линейки GeForce. Основная интрига связана с тем, где в промежутке между GTX 980 и TITAN X производитель решит поместить новинку.

Как выяснилось, в GPU нового флагмана были отключены лишь 2 из 24 потоковых мультипроцессоров (SMM). Соответственно, GTX 980 Ti обладает 2816 активными ядрами CUDA и 176 текстурными блоками вместо 3072 и 192 в GPU TITAN X. Число ROP (96) не изменилось, равно как широта шины памяти (384 бит). Тактовые частоты GPU и памяти также остались в неприкосновенности, однако объем RAM был уполовинен до 6 Гбайт. Вот, собственно, и вся разница между GTX 980 Ti и TITAN X.

| Модель | Графический процессор | Видеопамять | TDP, Вт | Рекомендованная розничная цена для рынка США (без налогов), $ | ||||||||

| Кодовое название | Число транзис-торов, млн | Тактовая частота, МГц: Base Clock / Boost Clock | Число ядер CUDA | Число текстур-ных блоков | Число ROP | Разряд-ность шины, бит | Тип микро-схем | Тактовая частота: реальная (эффектив-ная), МГц | Объем, Мбайт | |||

| GeForce GTX TITAN X | GM200 | 8 000 | 1000/1076 | 3072 | 192 | 96 | 384 | GDDR5 SDRAM | 1753 (7012) | 12 280 | 250 | 999 |

| GeForce GTX 980 Ti | GM200 | 8 000 | 1000/1076 | 2816 | 176 | 96 | 384 | GDDR5 SDRAM | 1753 (7012) | 6 144 | 250 | 649 |

| GeForce GTX 980 | GM204 | 5 200 | 1126/1216 | 2048 | 128 | 64 | 256 | GDDR5 SDRAM | 1750 (7000) | 4 096 | 165 | 499 |

| GeForce GTX 780 Ti | GK110 | 7 100 | 875/928 | 2880 | 240 | 48 | 384 | GDDR5 SDRAM | 1750 (7000) | 3 072 | 250 | 699 (до снятия с продажи) |

За эту скромную жертву полагается существенная скидка: GeForce GTX 980 Ti имеет рекомендованную цену $649 (США, без налогов) – куда дешевле, чем TITAN X ($999). Рублевый эквивалент составляет 39 990 р. Новый флагман основной геймерской линейки NVIDIA GTX 980 Ti получился дешевле, чем 780 Ti, до снятия с производства продававшийся за $699, и в то же время дороже, чем GTX 980 ($549 на момент релиза). Кстати, последний в связи с выходом 980 Ti получил уценку до $499.

Топовый однопроцессорный адаптер AMD – Radeon R9 290X – по прежнему остается наиболее выгодным предложением в верхнем сегменте игровых видеоадаптеров ($369), хотя равным соперником для него может быть в лучшем случае GTX 980, но никак не GTX 980 Ti. Более интересно столкнуть новоприбывшего с Radeon R9 295X2 (цена – от $789). И хотя последний – это уже устройство классом выше как по цене, так и по производительности, интересно проверить, что новый продукт NVIDIA сможет противопоставить такому монстру.

⇡#Поддержка новых аппаратных функций в DirectX 12 и GameWorks VR

Осталось немного времени до выхода в свет Windows 10, поэтому DirectX 12 уже обрел окончательный вид. В частности, представлены два «уровня» аппаратных функций (feature level). Напомним, что новая версия DirectX – это, с одной стороны, другой API, поддержка которого может быть внедрена в драйверы GPU, выпущенных до его появления. Соответственно, относительно старое «железо» также сможет воспользоваться преимуществами DX12 – в первую очередь более эффективным расходованием ресурсов CPU. С другой стороны, DirectX 12 представляет новые функции рендеринга, которые опционально могут быть реализованы в графических процессорах, но не требуются для работы новой runtime-библиотеки API. GPU, принадлежащие ко второй итерации архитектуры Maxwell, включая GM200, обладают полной поддержкой данных функций (feature level 12_0 и 12_1), среди которых можно выделить Volume Tiled Resources и Conservative Raster.

Первая дает возможность по требованию загружать в память видеоадаптера необходимые части большой трехмерной текстуры (необходимой для рендеринга жидкости или дыма), не расходуя ресурс RAM на текстуру целиком. Вторая обеспечивает точную локализацию пересекающихся границ полигонов, что в ряде ситуаций помогает избежать артефактов с прозрачными текстурами или, к примеру, наложением теней методом Ray Tracing, как показано на следующем слайде.

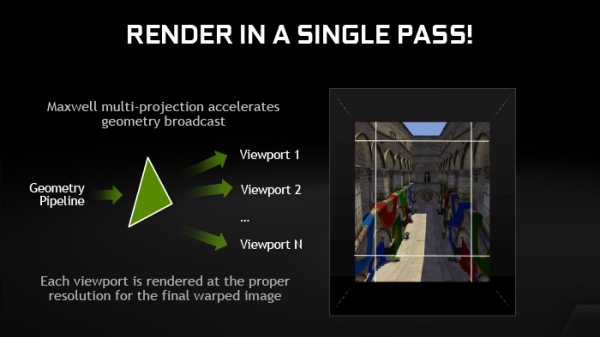

Одновременно с GTX 980 Ti NVIDIA представила набор библиотек GameWorks VR, предназначенных для адаптации игр к шлемам виртуальной реальности. Одна из ключевых функций GameWorks VR, которая опирается на аппаратные алгоритмы в GPU архитектуры Maxwell, – Multi-Res Shading – должна увеличить производительность при рендеринге сцены для стереоскопического шлема.

В окулярах шлема установлены линзы, позволяющие глазам сфокусироваться на близко расположенных LCD-экранах, потому картинка, отрисованная GPU, должна быть модифицирована, чтобы компенсировать искажение геометрии: края изображения сжимаются, как в фотоснимке, сделанном на объектив-«рыбий глаз». В результате часть работы, которую выполнил GPU, потратив ресурсы на рендеринг пикселов по краям изображения, обесценивается компрессией.

NVIDIA предлагает разделить кадр на несколько зон (viewports), рендеринг в которых выполняется одновременно, но с различным разрешением: больше в центре, меньше – по краям. Специальные алгоритмы задействуются, чтобы сопоставить края пикселей разного размера на границе зон, а затем формируется финальный кадр с искаженной геометрией. По утверждению разработчиков, Multi-Res Shading увеличивает производительность пиксельных шейдеров в 1,3-2 раза по сравнению с такой ситуацией, когда изображение изначально строится в высоком разрешении.

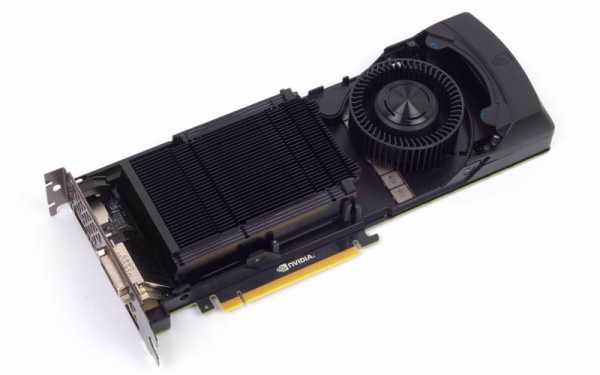

⇡#Конструкция

С виду GeForce GTX 980 Ti отличает от TITAN X только маркировка, цвет кожуха системы охлаждения (светлый в данном случае и черный у TITAN X), да еще количество микросхем памяти: поскольку объем RAM вдвое меньше, все чипы разместились на лицевой стороне платы, под общим радиатором.

Видеокарта оснащается закрытым кулером, уже неоднократно использованным NVIDIA в других топовых решениях, начиная с самого первого TITAN.

Не будем в очередной раз описывать устройство этой системы охлаждения. Достаточно отметить, что в радиатор GPU вмонтирована испарительная камера, которая также применялась в адаптерах на базе GK110, но отсутствовала в GTX 980.

Видеокарта обладает тремя разъемами DisplayPort и по одной штуке – HDMI и Dual-Link DVI-I.

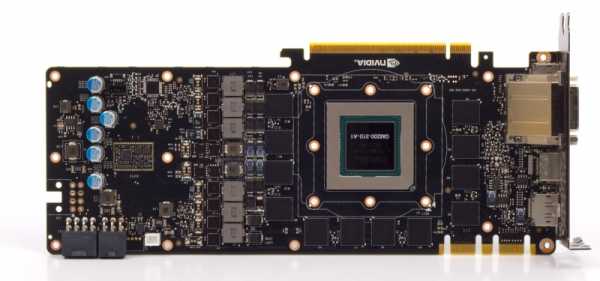

⇡#Плата

Печатные платы GTX 980 Ti и TITAN X различаются лишь количеством распаянных чипов RAM. Память набрана 12 микросхемами SK hynix H5GQ4h34MFR-R2C со штатной частотой 7 ГГц.

Преобразователь напряжения построен по схеме 6+2 (число фаз для питания GPU и микросхем памяти соответственно) и содержит контроллер ON Semiconductor NCP81174. Дополнительное питание подается через один восьмиконтактный и один шестиконтактный разъемы.

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

3dnews.ru

Сравнение GeForce GTX 1070 и GTX 980 Ti. Видеокарты Palit NE51070h25P2-1041G и EVGA 06G-P4-1996-KR

С момента успешного старта нового поколения видеокарт NVIDIA PASCAL уже прошло несколько месяцев, первые партии разлетелись по российским магазинам. К текущему моменту успели стабилизироваться цены на фоне роста количества доступных предложений. Но рано ли списывать со счетов 900 серию поколения NVIDIA MAXWELL? Предлагаем разобраться в этом вопросе вместе, сравнив быстродействие видеокарт GeForce GTX 1070 (на примере Palit GTX 1070 GameRock NE51070h25P2-1041G) и GeForce GTX 980 Ti (EVGA GeForce GTX 980 Ti HYBRID 06G-P4-1996-KR). К августу на фоне заметного снижения стоимости 900 серии, в Европе стоимость этих серий сравнялась. Плюс этот сравнительный обзор будет интересен тем, кто выбирает между покупкой новой видеокарты в магазине и приобретением на вторичном рынке, который тоже просел после выхода 10 серии.

Сравнение GeForce GTX 1070 и GTX 980 Ti

GeForce GTX 1070 получила 8 Гбайт графической памяти GDDR5, GeForce GTX 980 Ti располагает только 6 Гбайт памяти. Старшая GeForce GTX 1080 работает с памятью GDDR5X. Но опять же, несмотря на одинаковый тип памяти, был добавлен ряд оптимизаций, эффективней использующих шину.

Температура

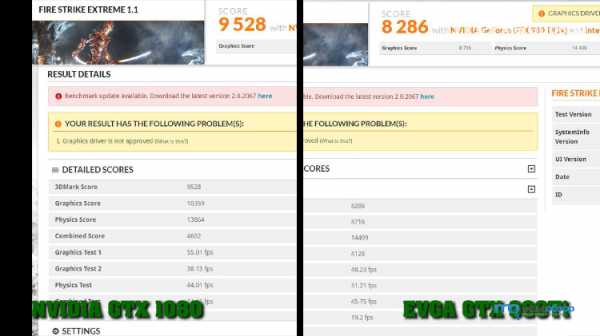

3DMark11

3DMark Fire Strike Ultra

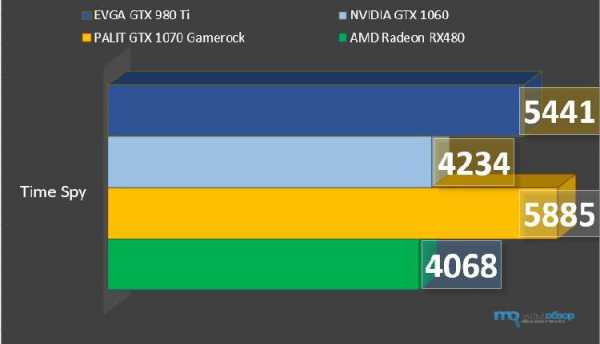

3DMark Time Spy

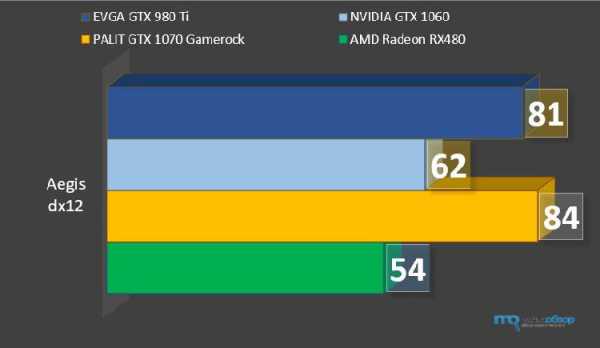

DirectX 12: Ashes of the Singularity

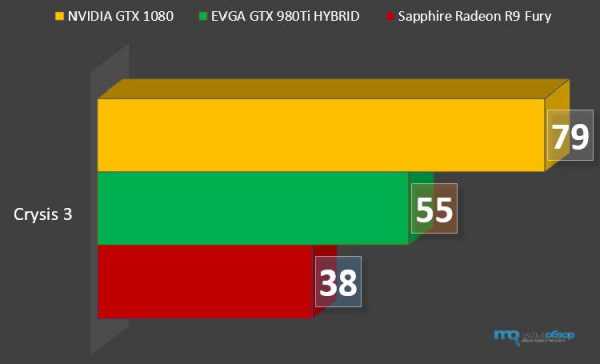

Crysis 3

Hitman Absolution

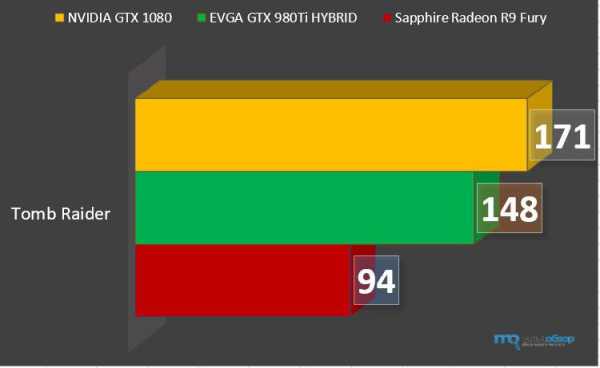

Tomb Raider

Shadow of Mordor

Batman Arkham Knight

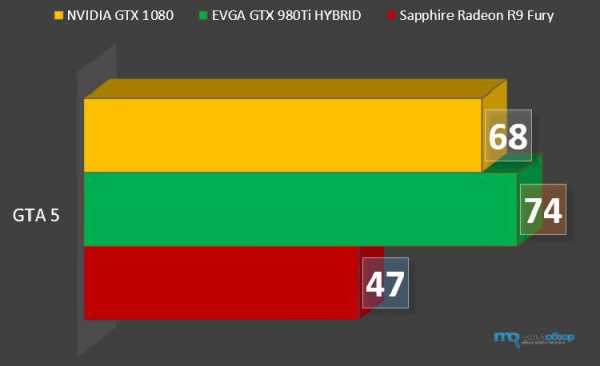

GTA 5

FarCry Primal

Tom Clancy’s The Division

Doom

Doom Ultra HD

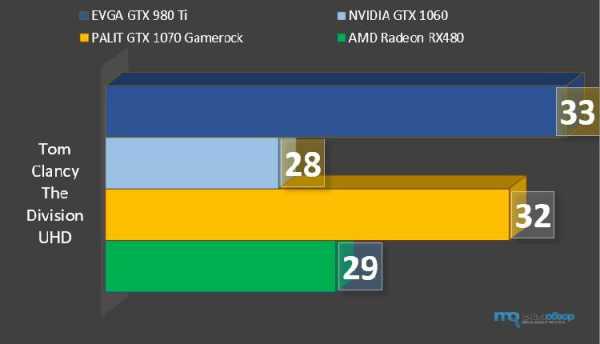

Tom Clancy The Division Ultra HD

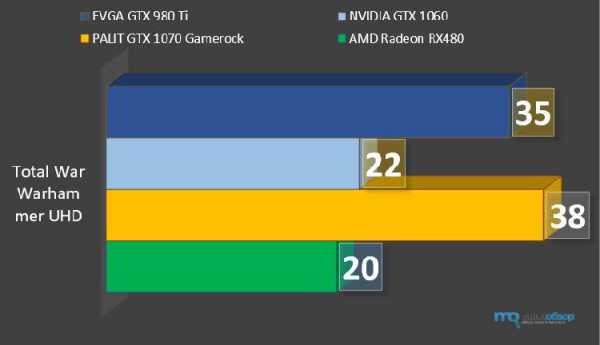

Total War Warhammer Ultra HD

Palit GeForce GTX 1070 GameRock Premium Edition обзор

EVGA GeForce GTX 980 Ti HYBRID обзор

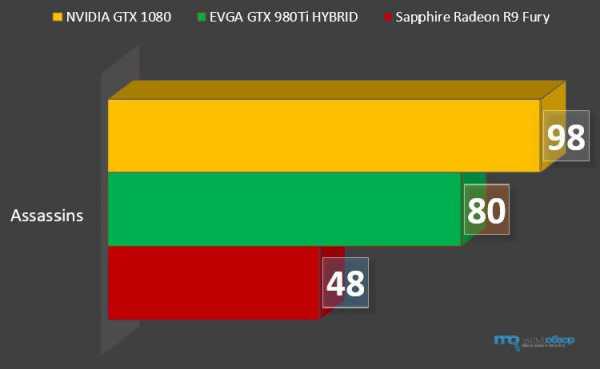

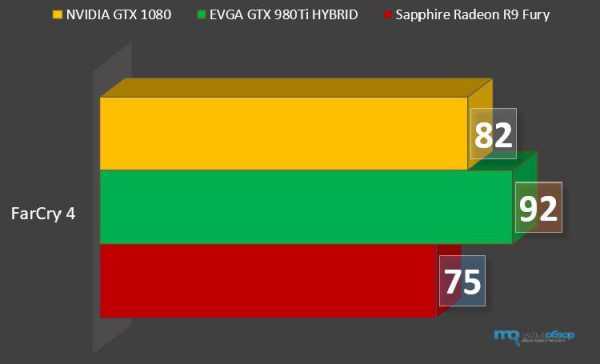

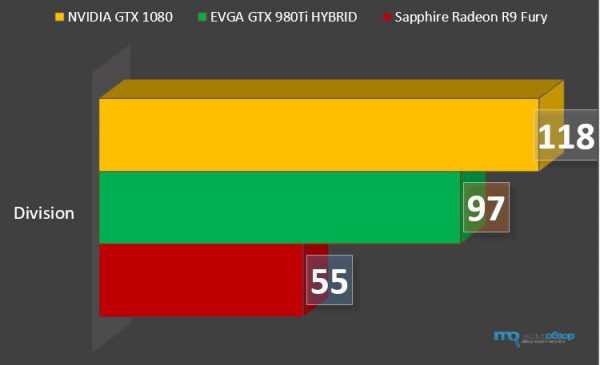

Сравнение NVIDIA GTX 1080 vs GTX 980 Ti

Как показали детальные сравнительные тесты, GeForce GTX 1070 опережает GeForce GTX 980 Ti в среднем на 5-10 кадров. Обе видеокарты демонстрируют высокий уровень FPS на ультра-настройках в Full HD разрешении. Хватает и на разрешение 2К, а вот с 4К рекомендуем присмотреться уже к старшей GTX 1080 или в идеале дождаться появления GeForce GTX 1080 Ti. На стороне GeForce GTX 1070 меньший уровень энергопотребления, высокие рабочие частоты и хороший потенциал разгона, а также приоритет в дальнейшей программной поддержке со стороны NVIDIA. Покупка GeForce GTX 980 Ti оправдана при удачном поиске предложений с низкой стоимостью на вторичном рынке. Также по личному опыту, эта видеокарта показала себя лучше в рендеринге видео в продуктах Adobe. Для сравнения не случайно была выбрана Palit GTX 1070 GameRock, это одно из лучших предложений в серии по соотношению быстродействия и стоимости. Причем, как у конкурентов, предлагается эффектная система охлаждения с настраиваемой подсветкой.megaobzor.com

Обзор NVIDIA GTX 1080 vs GTX 980 Ti, Pascal vs Maxwell, GP104 vs GM200 (EVGA GeForce GTX 980 Ti HYBRID 06G-P4-1996-KR)

Вчера мы опубликовали детальное тестирование первой видеокарты на базе Pascal — NVIDIA GeForce GTX 1080. Новые техпроцесс, технологии и архитектура продемонстрировали впечатляющие результаты. NVIDIA удалось провести заметный рывок, оставив далеко позади решения от AMD, включая карточки с новой HBM-памятью, заявлено и заметное преимущество над решениями MAXWELL серии GTX 900. Причем, в этот раз противопоставление проводилось на презентации не только с GTX 980 для GTX 1080, но и даже TITAN X. Перспективы заманчивы с учетом того, что это еще стоит она сопоставимо с GTX 980 Ti.

NVIDIA GTX 1080 vs GTX 980 Ti обзор

NVIDIA GeForce GTX 1080 Founder’s Edition построена на чипе GP104 с памятью GDDR5X. EVGA GeForce GTX 980 Ti HYBRID основана на чипе GM200 с памятью GDDR5. При меньшей ширине шины, 256 бит против 384 бит, NVIDIA GeForce GTX 1080 обладает большей пропускной способностью, здесь же надо учитывать новые технологии компрессии цвета. 6 против 8 Гбайт графической памяти.

Тестирование NVIDIA GTX 1080 и GTX 980 Ti

NVIDIA GTX 1080 или GTX 980 Ti?

NVIDIA GeForce GTX 1080 Founder’s Edition в Full HD разрешении продемонстрировала преимущество относительно EVGA GeForce GTX 980 Ti HYBRID как в современных играх, так и синтетических тестах. Уступает она только в паре игр: GTA 5 и FarCry 4. В ближайшее время мы проведем сравнение этих карточек в 4K, здесь, как можем предположить, преимущество будет на стороне GTX 980 Ti, как будет в реальности, узнаем далее. Пока же можно констатировать, что инженеры NVIDIA не зря едят свой «хлеб». Реализован 16нм техпроцесс, повышены частоты ядра и памяти, новый движок обработки изображения с оптимизацией под несколько мониторов и VR, SLI с объединением памяти, технологии сжатия, уменьшение энергопотребления, улучшение асинхронных вычислений.megaobzor.com

Nvidia Geforce GTX 980 Ti

Самый производительный однопроцессорный ускоритель игрового классаСодержание

Представляем базовый детальный материал с исследованием Nvidia Geforce GTX 980 Ti.

Справочные материалы

Объект исследования: Ускоритель трехмерной графики (видеокарта) Nvidia Geforce GTX 980 Ti 6144 МБ 384-битной GDDR5 PCI-E

Сведения о разработчике: Компания Nvidia Corporation (торговая марка Nvidia) основана в 1993 году в США. Штаб-квартира в Санта-Кларе (Калифорния). Разрабатывает графические процессоры, технологии. До 1999 года основной маркой была Riva (Riva 128/TNT/TNT2), с 1999 года и по настоящее время — Geforce. В 2000 году были приобретены активы 3dfx Interactive, после чего торговые марки 3dfx/Voodoo перешли к Nvidia. Своего производства нет. Общая численность сотрудников (включая региональные офисы) около 5000 человек.

Часть 1: Теория и архитектура

Совсем недавно отгремел анонс топовой новинки Nvidia из «титановой» премиальной серии — Geforce GTX Titan X, и вот мы снова знакомимся с почти столь же мощной видеокартой, но уже из привычной линейки Geforce GTX 900. Компания Nvidia приготовила свой ответ на ожидаемое вскоре новое топовое решение конкурента (даже не верится, что скоро мы увидим и его) и решила выпустить его в продажу чуть раньше видеокарты соперника. Собственно, ответ этот у них готов уже очень давно, даже Geforce GTX Titan X вышел не сразу, как только представилась такая возможность, а сегодняшний герой и вовсе является минимальной модификацией этого решения, во многом повторяющего его характеристики.

Мы уже много раз писали о новинках Nvidia, созданных на базе графических процессоров их последней архитектуры Maxwell, и осветили, пожалуй, практически все вопросы, связанные с работой этих видеокарт: все архитектурные изменения, новинки в функциональности, вопросы производительности. Казалось бы, писать больше особо не о чем. Но в последнее время появляются данные о новых технологиях, которые должны поработать для того, чтобы рынок игрового ПК-железа не зачах.

К примеру, ближе к концу года ожидается выход долгожданного обновления графического API Microsoft в виде DirectX 12, о котором мы подробнее напишем чуть ниже. Нельзя не отметить и набирающий силу интерес к использованию устройств вывода информации сверхвысокого разрешения — в так называемом 4K-разрешении. Благодаря резкому снижению цен на соответствующие мониторы и телевизоры, все большее число пользователей ПК обзаводится такими дисплеями.

За последний год количество 4K-мониторов у игроков выросло вдвое, и это только начало. К поддержке 4K-разрешения все видеокарты Nvidia на чипах архитектуры Maxwell также отлично подготовлены, они имеют специальные оптимизации для работы в таких условиях, поддерживают эффективные методы сжатия информации в кадровом буфере, а также единственные на рынке имеют поддержку видеовывода HDMI 2.0, позволяющую подключить 4K-телевизоры в полном разрешении при частоте обновления в 60 Гц.

Еще одним фактором (пока что лишь потенциальным) роста считаются устройства виртуальной реальности. Широкое появление VR-шлемов, очков и других аналогичных устройств в продаже ожидается в следующем году, и для популяризации виртуальной реальности важно, чтобы пользователи имели достаточно мощные видеокарты на базе GPU последних поколений, имеющие специальные оптимизации для VR и в целом обеспечивающие высокую производительность при минимальных задержках. Все это также относится к видеочипам семейства Maxwell в полной мере.

На данный момент, компания Nvidia выпустила уже несколько решений на основе чипов архитектуры Maxwell второго поколения, и сегодня к ним присоединяется еще одна модель — Geforce GTX 980 Ti. Это решение высочайшего уровня, обеспечивающего 3D-производительность лишь чуть хуже мощнейшей Geforce GTX Titan X. Новинка отличается большой математической и текстурной мощью, этот GPU включает 2816 потоковых ядер и оснащен шестью гигабайтами быстрой GDDR5-памяти. Новинка из топового ценового сегмента позволит будущим пользователям на несколько лет забыть о проблемах и тормозах, играя во все современные ПК-игры.

Так как рассматриваемая модель видеокарты от компании Nvidia основана на топовом графическом процессоре архитектуры «Maxwell» второго поколения, который мы уже рассматривали и который во многом схож с чипами предыдущей архитектуры «Kepler», то перед прочтением данного материала полезно ознакомиться с более ранними статьями о видеокартах компании Nvidia:

Итак, давайте рассмотрим подробные характеристики видеоплаты Geforce GTX 980 Ti, основанной на графическом процессоре GM200.

| Графический ускоритель Geforce GTX 980 Ti | |

|---|---|

| Параметр | Значение |

| Кодовое имя чипа | GM200 |

| Технология производства | 28 нм |

| Количество транзисторов | около 8 млрд. |

| Площадь ядра | около 600 мм2 |

| Архитектура | Унифицированная, с массивом общих процессоров для потоковой обработки многочисленных видов данных: вершин, пикселей и др. |

| Аппаратная поддержка DirectX | DirectX 12, с поддержкой уровня возможностей Feature Level 12.1 |

| Шина памяти | 384-битная: шесть независимых контроллеров памяти шириной по 64 бита с поддержкой GDDR5-памяти |

| Частота графического процессора | 1000 (1075) МГц |

| Вычислительные блоки | 22 активных (из 24) потоковых мультипроцессора, включающих 2816 (из 3072) скалярных ALU для расчетов с плавающей запятой одинарной и двойной точности (с темпом 1/32 от FP32) в рамках стандарта IEEE 754-2008; |

| Блоки текстурирования | 176 активных (из 192) блоков текстурной адресации и фильтрации с поддержкой FP16- и FP32-компонент в текстурах и поддержкой трилинейной и анизотропной фильтрации для всех текстурных форматов |

| Блоки растеризации (ROP) | 6 широких блоков ROP (96 пикселей) с поддержкой различных режимов сглаживания, в том числе программируемых и при FP16- или FP32-формате буфера кадра. Блоки состоят из массива конфигурируемых ALU и отвечают за генерацию и сравнение глубины, мультисэмплинг и блендинг |

| Поддержка мониторов | Интегрированная поддержка до четырех мониторов, подключенных по интерфейсам Dual Link DVI, HDMI 2.0 и DisplayPort 1.2 |

| Спецификации референсной видеокарты Geforce GTX 980 Ti | |

|---|---|

| Параметр | Значение |

| Частота ядра | 1000 (1075) МГц |

| Количество универсальных процессоров | 2816 |

| Количество текстурных блоков | 176 |

| Количество блоков блендинга | 96 |

| Эффективная частота памяти | 7000 (4×1750) МГц |

| Тип памяти | GDDR5 |

| Шина памяти | 384-бит |

| Объем памяти | 6 ГБ |

| Пропускная способность памяти | 336,5 ГБ/с |

| Вычислительная производительность (FP32) | около 6 терафлопс |

| Теоретическая максимальная скорость закраски | 96 гигапикселей/с |

| Теоретическая скорость выборки текстур | 176 гигатекселей/с |

| Шина | PCI Express 3.0 |

| Разъемы | Один разъем Dual Link DVI, один HDMI 2.0 и три DisplayPort 1.2 |

| Энергопотребление | до 250 Вт |

| Дополнительное питание | Один 8-контактный и один 6-контактный разъемы |

| Число слотов, занимаемых в системном корпусе | 2 |

| Рекомендуемая цена | $649 (США), 39990 руб (Россия) |

Новая модель Geforce GTX 980 Ti получила привычное для последних серий Geforce наименование — к названию менее мощного решения просто добавили приставку Ti. Новинка не заменяет в текущей продуктовой линейке компании других решений, а наращивает ее сверху, не вытесняя премиальные Titan X и двухчиповую Titan Z. Ну а ниже ее располагается модель Geforce GTX 980, основанная на менее сложном чипе GM204.

Рекомендованная цена на новую плату составляет $649, и это даже ниже ожиданий рынка. Как показывает практика, от Nvidia редко можно ждать цен ниже тех, что предполагаются экспертами, но сегодня — именно тот случай. Хотя новинка и является одним из лучших по производительности решений на рынке одночиповых видеокарт, но стоит не запредельно дорого (если учесть, что цена еще и включает ключ к игре Batman: Arkham Knight — по крайней мере, на западных рынках).

Похоже, что Nvidia таким образом наносит превентивный удар по позициям конкурента, переименованная (в очередной раз!) линейка которого должна вот-вот появиться, будучи дополненной только новым топовым решением. Естественно, изменились и цены на все остальные платы в серии Geforce GTX 900. Для GTX 980 рекомендованная цена теперь установлена в $499, GTX 970 будет стоить от $329, а GTX 960 — от $199. Очень хорошие цены, хотя конкурент может снизить их еще больше — им просто не остается ничего другого.

Рассматриваемая сегодня модель компании Nvidia основана на чипе GM200, имеющем 384-битную шину памяти, и память работает на частоте 7 ГГц, как у Titan X, что дает такую же пиковую пропускную способность в 336,5 ГБ/с — в полтора раза больше, чем в GTX 980. С такой шиной, объем установленной на видеокарту видеопамяти мог быть 6 или 12 ГБ, и в данном случае смысла в большем значении просто нет, к тому же оно занято моделью серии Titan. А на GTX 980 Ti установлено 6 ГБ, чего вполне достаточно для запуска любых 3D-приложений с любыми настройками качества — сейчас такого объема видеопамяти хватит для всех игр. Да и будущий топовый конкурент с предполагаемыми 4 ГБ памяти нового стандарта HBM останется в проигрыше.

Печатная плата Geforce GTX 980 Ti ничем особо не отличается от платы GTX Titan X, что неудивительно — они похожи по всем характеристикам. Значение типичного энергопотребления для Geforce GTX 980 Ti составляет 250 Вт — столько же, что и у Titan X. Да и в остальном платы одинаковы, длина референсной платы Geforce GTX 980 Ti составляет 267 мм, и на ней установлены такие же разъемы для вывода изображения: один Dual-Link DVI, один HDMI 2.0 и три DisplayPort.

Архитектура

Как и видеокарта Geforce GTX Titan X, анонсированная чуть ранее, новинка основана на графическом процессоре GM200. Он включает все архитектурные возможности чипа GM204, поэтому все сказанное в статье по GTX 980 относится в полной мере и к сегодняшней новинке — советуем сначала ознакомиться с материалом, в котором более полно рассмотрены архитектурные особенности Maxwell.

На сегодняшний день, GM200 — это самый мощный GPU как у Nvidia, так и вообще на рынке. Архитектурно видеочип GM200 полностью соответствует младшей модели GM204, он также состоит из кластеров GPC, в которые собрано по несколько мультипроцессоров SM. Графический процессор содержит шесть кластеров GPC, состоящих из 24 мультипроцессоров, но в данной модели были отключены два из них — в основном, чтобы Titan X оказалась все же немного быстрее, оправдывая свои название и цену.

Поэтому видеочип в варианте для модели Geforce GTX 980 Ti выпускается в слегка урезанном виде, он содержит на пару потоковых мультипроцессоров меньше, чем полное ядро GM200. Из 24 мультипроцессоров этого GPU, в данном варианте активны 22 штуки. Соответственно, чип включает 2816 потоковых процессора CUDA из 3072 имеющихся физически, и 176 (из 192) блоков выборки и фильтрации текстур TMU.

А вот количество блоков ROP и присоединенная к ним кэш-память второго уровня остались нетронутыми. GPU этой модификации имеет все 96 блока ROP и 3 МБ L2-кэша, имеющихся в графическом процессоре физически. Важно отметить, что так как по количеству ROP и объему кэш-памяти второго уровня в этой модификации ничего не урезано, то у Geforce GTX 980 Ti нет и проблем, аналогичных модели GTX 970, у которой урезаны ROP и L2-кэш, а вместе с ними и полоса пропускания для одного из сегментов видеопамяти (0.5 ГБ из имеющихся 4 ГБ в этой модели отличаются крайне медленным доступом). Nvidia не допустила подобной ситуации еще раз и скорость чтения из всех 6 ГБ памяти тут одинаково высокая.

Базовая тактовая частота новинки равна 1000 МГц, а средняя турбо-частота Boost Clock — 1075 МГц, то есть ровно столько же, сколько было у GTX Titan X. Не забываем, что реальная частота работы GPU в играх может отличаться от этих показателей, чаще всего в большую сторону, а средняя турбо-частота соответствует определенному набору приложений и условий. Теоретически, по сравнению с GTX Titan X, чип в новой модели может работать на несколько более высокой частоте, так как часть функциональных блоков отключена, что может позволить повысить рабочую частоту. Ну и возможности разгона должны быть чуть лучше — по первым отзывам, частот порядка 1400 МГц и даже выше добиться вполне реально.

Что касается оперативной памяти, то и тут все осталось неизменным по отношению к Titan X. Графический процессор GM200 в составе GTX 980 Ti имеет 384-битную шину памяти (шесть каналов по 64-бита), а чипы видеопамяти GDDR5 в объеме шести гигабайт работают на эффективной частоте в 7 ГГц. Что дает те же 336,5 ГБ/с, что и у дорогой старшей модели. То есть, по ПСП новинка аж на 50% быстрее младшей модели GTX 980.

Но сравнение с младшей сестрой не так интересно, как с ожидаемым решением конкурента, который будет оснащен новым типом памяти — High Bandwidth Memory, которая должна обеспечить порядка 512 ГБ/с. Само по себе преимущество в полосе пропускания памяти очень важно в графических задачах, но подсистему памяти и кэширования данных могут ограничивать и другие факторы, мешающие показать высокую эффективность и использовать все возможности GPU и видеопамяти. Так, чтобы решить эти потенциальные проблемы, в чипах второго поколения архитектуры Maxwell внедрили новое поколение подсистемы памяти, которое использует имеющуюся ПСП эффективнее.

Мы уже писали об этом более подробно ранее, все новые GPU компании Nvidia используют уже третье поколение алгоритма компрессии информации о цвете в кадровом буфере, которое поддерживает новые методы сжатия. Дополнительно к этому, каждый из мультипроцессоров SMM в чипе GM200 имеет собственную общую память объемом в 96 КБ, тогда как кэш-память первого уровня и текстурный кэш объединены в 48 КБ область на каждый мультипроцессор. Это решение выгодно отличает новые GPU от семейства Kepler, в которых использовалась общая память объемом в 64 КБ, которая также была и L1-кэшем. Все это дополнено кэш-памятью второго уровня приличного объема в 3 МБ. В итоге даже при негативной разнице в ПСП по сравнению с конкурирующими решениями, видеокарты Nvidia обычно показывают себя не хуже.

Во всем остальном чип GM200 ничем не отличается от GM204 по своим возможностям и поддерживаемым технологиям. И все то, что мы ранее писали про GTX 980 и GTX 970, в полной мере относится и к GTX 980 Ti. Поэтому по всем остальным вопросам функциональных тонкостей новинки вы можете обратиться к обзорам Geforce GTX 980 и GTX 750 Ti, в которых мы подробно писали об архитектуре Maxwell, устройстве потоковых мультипроцессоров (Streaming Multiprocessor — SMM), организации подсистемы памяти и некоторых других архитектурных отличиях. Там же вы можете ознакомиться и с функциональными возможностями, вроде аппаратной поддержки ускорения расчета глобального освещения VXGI, новых методов полноэкранного сглаживания и улучшенных возможностей графического API DirectX 12.

Некоторые изменения были внесены в возможности технологии G-Sync, которая позволяет получить максимально плавную смену кадров при условии использования поддерживаемого монитора. Технология реально значительно влияет на повышение комфортности при игре и заставляет устройство вывода сменять изображение только тогда, когда оно полностью рассчитано графическим процессором.

Такой подход убирает артефакты разрыва картинки и неплавности частоты кадров, которые появляются при использовании обычных мониторов с выключенной и включенной вертикальной синхронизацией. С технологией G-Sync получается так, что частота обновления картинки на мониторе полностью совпадает с частотой кадров, обеспечиваемой игровой системой.

Среди свежих нововведений в G-Sync выделим Variable Overdrive — технологию, которая обеспечивает более аккуратный цветовой сдвиг (color-shifting). Также новой для G-Sync является поддержка не полноэкранного режима работы, а оконного. Если раньше G-Sync по этому показателю уступал конкурирующей технологии от AMD, то теперь пользователи видеокарт Nvidia и соответствующих мониторов могут использовать 3D-приложения с точной синхронизацией и в оконном режиме.

Весьма ожидаемым стало появление поддержки G-Sync в игровых ноутбуках от компаний Gigabyte, MSI, Asus и Clevo, в которых применяются специальные LCD-панели, хорошо подходящие для игр, в том числе с разрешением 3К и 4К, а также частотой обновления в 75 Гц. Кроме этого, на рынке ожидается появление нескольких новых моделей мониторов с поддержкой этой технологии.

Так, компании Asus и Acer вскоре предложат пользователям по несколько новых моделей G-Sync-мониторов, включая наиболее интересные 34-дюймовые модели с изогнутой IPS-матрицей высокого разрешения 3440х1440 пикселей и частотой обновления в 75 Гц.

Полная поддержка возможностей DirectX 12

Компания Microsoft в своих материалах в основном рассказывает о внесенных в новую версию графического API оптимизациях производительности — Direct3D 12 позволяет меньше грузить CPU бесполезной работой, удобно контролировать использование ресурсов GPU, что раньше делалось операционной системой и видеодрайвером, а графический код можно лучше распараллелить на несколько вычислительных устройств. Все это позволяет значительно повысить производительность, особенно в условиях, когда она ограничена большим количеством вызовов функций отрисовки (draw calls). Что даже еще более важно, эти возможности поддерживаются на всех видеокартах Geforce, начиная с GTX 400.

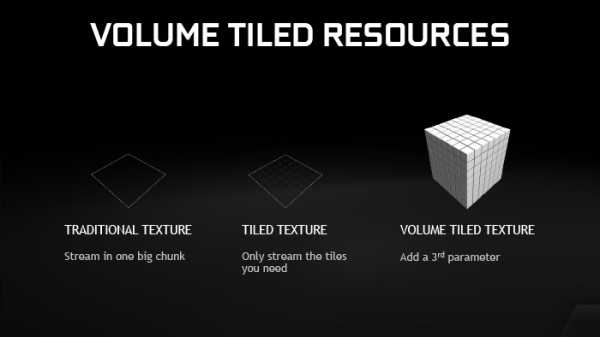

Но не только оптимизации производительности отличают DirectX 12, в этом API есть еще и новые функции, помогающие внедрению в 3D-приложения новых эффектов. Среди них отметим появление поддержки объемных тайловых ресурсов (volume tiled resources), которые можно использовать при рендеринге реалистично выглядящих огня и дыма. DirectX 12 предлагает два уровня поддержки функциональности Feature Level: 12.0 и 12.1.

Уровень 12.0 включает поддержку тайловых ресурсов (tiled resources), которые можно использовать для рендеринга теней при помощи карт теней разного разрешения, bindless-текстур, увеличивающих одновременное количество обрабатываемых текстур в одной шейдерной программе и снижающих нагрузку на CPU, а также Typed UAV (Unordered Access Views). Уровень 12.1 добавляет ко всем этим особенностям еще и консервативную растеризацию и raster ordered view — эта функция дает контроль над порядком операций пиксельного шейдера и позволяет использовать алгоритмы для рендеринга полупрозрачных поверхностей, не требующие предварительной сортировки, например.

Дополнительно, все графические чипы семейства GM2xx поддерживают объемные тайловые ресурсы (volume tiled resources), схожие по типу с просто тайловыми, но в трехмерном виде. Принцип работы тайловых ресурсов состоит в разделении текстур на тайлы, а в процессе рендеринга приложение определяет и загружает в видеопамять лишь те тайлы, которые нужны для визуализации. Эта возможность позволяет игровым разработчикам получать более разнообразные текстуры на объектах в сцене при меньшем использовании видеопамяти, а также помогает в организации текстурного стриминга.

Так вот, ранее тайловые ресурсы были доступны лишь для двумерных текстур, а объемные тайловые текстуры переносят эту же функциональность на 3D-текстуры. Это логично, ведь множество эффектов нуждаются в объеме, чтобы выглядеть реалистично: жидкости, дым, огонь, туман — это лишь самые очевидные примеры. И рендеринг сложных сцен с содержанием подобных эффектов на GPU с поддержкой объемных тайловых текстур позволяет использовать ресурсы видеопамяти более эффективно, и также улучшать качество имитации того или иного эффекта. К примеру, для качественной имитации дыма в играх можно использовать симуляцию жидкостей, как показывала Nvidia в нескольких демонстрационных программах:

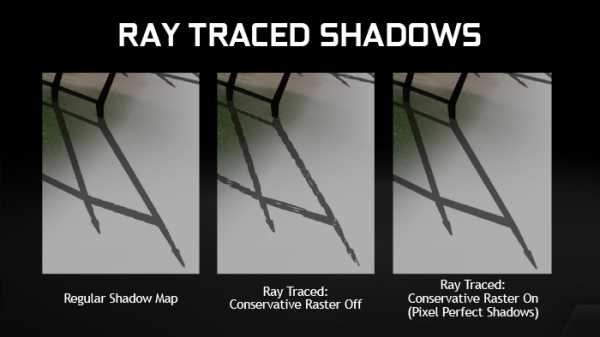

Ну а консервативная растеризация, также поддерживаемая чипами семейства Maxwell и являющаяся обязательной возможностью Feature Level 12.1, отличается от обычной растеризации тем, что в процессе отрисовываются не только те пиксели, в центр которых попала геометрия сцены, а все пиксели, в площадь которых попал даже маленький кусочек треугольника. Эту функциональность можно использовать в процессе вокселизации (конвертации геометрии в воксели), как в алгоритме глобального освещения VXGI от Nvidia, о котором мы неоднократно писали.

Операция эта далеко не бесплатная, консервативная растеризация в любом случае медленнее привычной, но если графический процессор обеспечивает аппаратную поддержку этой возможности, то вычисления производятся в разы быстрее, что будет полезно для некоторых алгоритмов, ожидаемых в играх в ближайшем будущем. Еще одним примером использования консервативной растеризации в играх можно считать качественный рендеринг теней, просчитанных при помощи трассировки лучей:

Как видите, такие тени выгодно отличаются от привычных теней с использованием карт теней отсутствием пиксельных «лесенок». А при обычном методе растеризации и алгоритме трассировки лучей в тенях получаются неприятные артефакты. Избавиться от них помогает включение консервативной растеризации, обеспечивающее этому алгоритму рендеринга теней идеальную пиксельную точность.

Самый важный вопрос — когда мы увидим все это великолепие в играх? По данным компании Microsoft, около 100 игровых разработчиков уже занимаются разработкой 3D-приложений, использующих возможности новой версии их графического API, и мы уже видели несколько соответствующих демонстраций на CryENGINE, Unity и Unreal Engine, запущенных на ПК с видеокартами Geforce на различных мероприятиях. Главное, что архитектура Maxwell от Nvidia обладает полноценной поддержкой всех возможностей текущей версии DirectX 12 уровня Feature Level 12.1 — самого совершенного на данный момент.

Виртуальная реальность с GameWorks VR

Наверняка почти все наши читатели уже в курсе новой реинкарнации виртуальной реальности, которая начала свой путь с подачи компании Oculus VR, позднее купленной компанией Facebook. Много-много лет назад довольно примитивные по современным меркам VR-шлемы выпускались многими компаниями, были довольно массивными при плохом качестве изображения, и при этом стоили сотни и даже тысячи долларов. С улучшением технических возможностей, за проекты шлемов и очков виртуальной реальности взялись несколько компаний, наиболее заметной из которых все же стала Oculus.

Виртуальная реальность — это один из возможных движителей, который возродит рынок игрового ПК-железа, так как все новинки быстрее приживаются на универсальной системе, позволяющей подключить буквально все, что угодно, и использовать это так, как хочется. ПК в качестве такой экспериментальной системы вполне подходит, поэтому есть надежда, что VR на ПК даст новый толчок рынкам комплектующих и игровому.

Но для успешного внедрения VR требуется не только аппаратная, но и программная поддержка. Как раз этим и занимаются в компаниях виртуальной реальности, так как с аппаратной точки зрения в VR-шлеме нет особо сложных технологий, почти все уже давно отработано. Самая главная проблема VR заключается в больших задержках между физическим действием игрока (поворотом головы) и изображением на экране — тут важна буквально каждая миллисекунда! Это на взгляд мы не заметим небольших задержек, а мозг наш все заметит. Отсюда и все проблемы с головокружением и тошнотой, которые и стараются сейчас решить, прежде всего.

Хотя не только это важно для VR, также очень полезной была бы специализированная поддержка VR со стороны графических процессоров, чтобы облегчить задачу рендеринга — ведь в таком случае картинку высокого разрешения приходится рендерить дважды — для каждого глаза отдельно. Инженеры компании Nvidia тесно работают с производителями аппаратного и программного обеспечения для виртуальной реальности и уже разработали несколько технологий, обеспечивающих лучшую поддержку VR со стороны GPU, назвав инициативу объединяющим наименованием GameWorks VR.

К примеру, можно взять различные оптимизации рендеринга. Общеизвестно, что VR-устройства используют в работе специальную оптическую систему из экрана высокого разрешения и линз, установленных перед ними в нескольких сантиметрах. Эти самые линзы и создают ощущение виртуальной реальности, обеспечивая соответствующий сверхширокий обзор с большим полем зрения.

Для работы VR-устройств, на их встроенный экран нужно вывести изображение, искаженное специальным образом — центр картинки крупно, а периферия по краям сжатая. В итоге с применением специальной линзы пользователь увидит правильное изображение с большим полем зрения (Field of View). И все это нужно сделать дважды — отдельно для каждого глаза.

Так как графические процессоры изначально спроектированы для получения обычного двумерного изображения, они не имеют специальной поддержки рендеринга специально растянутых изображений для систем виртуальной реальности. Вопрос приходится решать программным способом, отрисовывая 3D-картинку в нормальном режиме и сжимая изображение на периферии перед подачей его в VR-устройство.

Хотя такой подход отлично работает в VR с точки зрения качества картинки, он не слишком эффективен с точки зрения расходования вычислительных ресурсов. Ведь графический процессор рендерит изображение как типичную картинку для обычного монитора, когда центр изображения и его края одинаковы по значению. А при искажении изображения, требуемом VR-устройствами, огромная часть пикселей просто отбрасывается без пользы. Пиксели на периферии кадра сжимаются в несколько раз, и многие из них просто оказываются не нужны (см. иллюстрацию выше). В середине пиксели остаются почти один к одному, а с краев большая площадь заметно уменьшается в итоговом VR-изображении — это неэффективный подход.

Для решения проблемы эффективности VR-рендеринга, компанией Nvidia была придумана технология Multi-Res Shading, разработанная специально для систем виртуальной реальности и использующая возможности мультипроецирования (multi-projection) — все графические процессоры Maxwell второго поколения умеют одновременно проецировать геометрию сцены на несколько проекций.

В случае с виртуальной реальностью, технология работает так — картинка делится на несколько областей (viewport) и каждая из них отрисовывается в разных разрешениях, в зависимости от расположения. Так, разрешение центральной области остается без изменений, а боковые области масштабируются в зависимости от требуемого качества. На обычных GPU без поддержки мультипроецирования, потребовалось бы несколько раз отрисовать одну и ту же геометрию в несколько буферов, а эта возможность позволяет за один проход спроецировать геометрию сразу в несколько буферов.

В результате, по оценке Nvidia, эта технология обеспечивает 1.3-2-кратный рост производительности пиксельных шейдеров, по сравнению с традиционным подходом рендеринга всего изображения с одинаковым разрешением. Что самое важное, эта технология из GameWorks SDK уже доступна разработчикам систем виртуальной реальности, многие из которых уже занимаются ее внедрением.

Видеокарты Geforce последнего поколения, основанные на графических процессорах архитектуры Maxwell второго поколения, можно назвать идеальной платформой для разработки и использования систем виртуальной реальности, ожидаемых от многих компаний в ближайшие месяцы. Помимо того, что для VR-систем критичным показателем является высокая производительность и максимально плавная смена кадров, которая вполне обеспечивается топовым Geforce GTX 980 Ti, для них важна и программная и аппаратная поддержка со стороны производителя GPU.

В случае VR-систем особенно важной станет правильная подстройка параметров игры и качества 3D-графики, чтобы обеспечить максимальную плавность, ведь проблемы с производительностью могут вызвать физическое недомогание у игроков. Тут как нельзя лучше подойдет утилита Geforce Experience, входящая в комплект драйверов Nvidia, которая обеспечит оптимальные настройки для всех 3D-приложений, в том числе и VR (в будущем). А для VR-разработчиков очень полезной является инициатива GameWorks VR, сочетающая набор API, библиотек и технологий, помогающих в освоении виртуальной реальности.

Совсем скоро мы наконец-то увидим результаты этой работы в широком доступе, а пока что приходится довольствоваться видеороликами из многочисленных демонстрационных версий и пятиминутными просмотрами в VR-шлемах на различных мероприятиях, посвященных играм и 3D-графике. Демонстрации довольно впечатляющие, надо сказать, их выпустили уже несколько компаний, вот лишь несколько примеров: «Thief in the Shadows» — совместная разработка Nvidia, Epic, Oculus и WETA Digital – студии, создававшей визуальные эффекты в кинотрилогии «Хоббит», «Back to Dinosaur Island» — перезагрузка известной 14 лет назад демо-программы «X-Isle: Dinosaur Island» от Crytek, демонстрации от Valve: «Portal», «Job Simulator», «TheBluVR» и «Gallery», а также демо-программа виртуальной реальности на движке Unity 5.

Предварительная оценка производительности

Для начала давайте рассмотрим табличку сравнения Geforce GTX 980 Ti с моделями схожего позиционирования прошлых лет: GTX 680 и GTX 780 Ti, которые завоевали немалую популярность у ПК-игроков. Новинка Nvidia выглядит заметно лучше своих предшественниц, она до трех раз быстрее GTX 680, обеспечивает играбельную частоту кадров даже в 4K-разрешении во всех играх с максимальными настройками. Кроме того, графический процессор GM200 архитектуры Maxwell поддерживает все возможности Feature Level 12.1 из DirectX 12, а видеокарта оснащена шестью гигабайтами видеопамяти, против 2 и 3 ГБ у предшественниц.

Новая топовая видеокарта хороша, как ни крути. Особенно если рассматривать ее энергоэффективность, ведь технологический процесс за долгие годы не изменился, как и потребление энергии, а производительность выросла в разы. Исходя из теории, Geforce GTX 980 Ti по скорости располагается куда ближе к GTX Titan X, чем к GTX 980, например. Так, новинка имеет на 38% больше блоков ALU и TMU, значительно больше блоков ROP. да и по ПСП имеет серьезное преимущество. В целом, Geforce GTX 980 Ti урезан относительно GTX Titan X примерно на 10% (по количеству блоков ALU и TMU — самых важных для видеочипа), а по блокам ROP и ПСП и вовсе идет вровень.

Зато по сравнению с Geforce GTX 980, у новинки на 38% больше процессоров CUDA и текстурных блоков, а по пропускной способности памяти еще больше — это очень приличная разница. В целом, по сравнению с топовыми моделями Geforce GTX предыдущих поколений, новая модель выглядит намного более производительной в теории. Да и на практике это подтверждается, особенно в удобных для новинки высоких и сверхвысоких разрешениях:

По оценке компании Nvidia, по средней частоте кадров в самых современных играх, включая Witcher 3, Assassin’s Creed: Unity, Grand Theft Auto: IV, Far Cry 4, Dragon Age: Inquisition, Shadow of Mordor и Watch Dogs, запущенных на топовой системе с высокими игровыми настройками в разных разрешениях, представленная сегодня модель Geforce GTX 980 Ti от двух до трех раз быстрее, чем Geforce GTX 680 (максимальная разница наблюдается в разрешении 4K, разумеется), а предшественница GTX 780 Ti обойдена в среднем в полтора раза. Приводит Nvidia и конкретные примеры игр, протестированных в самом высоком разрешении:

Как видите, Geforce GTX 980 Ti обеспечивает куда большую частоту кадров в таких условиях, если сравнивать ее с давно устаревшей моделью GTX 680. Преимущество в 2.2-2.6 раз в таких случаях совершенно неудивительно. Куда интереснее будет сравнить новинку с… а ее сейчас особенно и сравнивать то не с чем. Ведь конкурента от AMD для топовых решений Nvidia до сих пор нет на рынке, они только обещают выпустить свой вариант в июне — нам придется подождать его еще какое-то время.

Выводы по теоретической части

С архитектурной точки зрения, графический процессор, применяемый в Geforce GTX 980 Ti, не отличается от того, что мы видели в GTX Titan X. GM200 включает лучшее из прошлых архитектур компании, дополнительную функциональность и улучшения второго поколения Maxwell. При помощи полной переработки исполнительных блоков, инженеры компании Nvidia добились для этого поколения GPU лучшего показателя энергоэффективности — соотношения производительности к потреблению энергии, добавив при этом еще в функциональности (полная поддержка Feature Level 12.1 из графического API DirectX 12).

Компания Nvidia выпустила очередного флагмана для своей линейки в виде модели Geforce GTX 980 Ti, предназначенной для энтузиастов компьютерных игр. Ей нипочем любые игровые настройки, любые разрешения и уровни сглаживания, она всегда обеспечит приемлемую играбельность. Особенно выгодно она выделяется на фоне многочиповых решений, имеющих определенные недостатки, связанные с неплавной сменой кадров и увеличением задержек — одночиповое решение всегда лучше при прочих равных, да и при небольшой разнице в цене оно обеспечивает не только лучшую скорость, но и меньшие нагрев и шум.

Увы, но сравнивать с одночиповыми видеокартами Geforce GTX 980 Ti толком не получится — у нее нет конкурентов, если не считать таковым старшую сестру GTX Titan X. Компания AMD так до сих пор и не выпустила конкурентоспособную топовую видеокарту, но мы ждем ее анонса с недели на неделю. И мы уверены, что сражение новинок от Nvidia и AMD будет жарким!

Geforce GTX 980 Ti отличается применением самого мощного GPU компании Nvidia, лишь слегка урезанного по своей производительности и содержащего 2816 активных потоковых процессоров (по сравнению с 3072 ядер у GTX Titan X). Аналогично было уменьшено количество текстурных блоков. Зато количество блоков растеризации и каналов памяти осталось тем же, в итоге подсистема памяти новинки включает шесть 64-битных каналов (всего 384-бита), по которым подключены 6 ГБ памяти, работающей на частоте в 7 ГГц.

Тактовые частоты новинки ничуть не изменились — 1000 МГц базовой и 1075 МГц Boost-частоты. В целом, пусть GTX 980 Ti немного уступает GTX Titan X из элитной серии, но разница в производительности не должна быть больше 5-10%, а шести гигабайт видеопамяти хватит на то время, пока этот GPU не потеряет своей актуальности — то есть, на несколько следующих лет.

Кроме этого, Geforce GTX 980 Ti получила еще и весьма привлекательную цену в $649, даже несколько неожиданную для топового решения Nvidia. Непонятно, насколько сильно на цену повлиял предполагаемый скорый выпуск конкурента от компании AMD, но факт есть факт. Представленная сегодня модель очень мощная, но при этом совсем не настолько дорогая, как GTX Titan X с почти той же производительностью и ровно теми же возможностями. Отличное предложение для энтузиастов ПК-игр!

Анонс новинки совпал с началом работы выставки Computex 2015, которая вот-вот начнется на Тайване, а появления видеокарт от партнеров Nvidia в магазинах можно ожидать уже в течение недели после анонса, в зависимости от рынка. На российском рынке новая топовая видеокарта Geforce ожидается уже с 2 июня. Конечно же, в продажу выйдут не только видеокарты референсного дизайна, чуть позже производители начнут продавать и изделия, имеющие оригинальные печатные платы и системы охлаждения.

В следующих частях нашего материала мы исследуем скорость рендеринга новой видеокарты Nvidia Geforce GTX 980 Ti на практике, сравнив ее скорость с производительностью самых мощных видеосистем от компании AMD и со скоростными показателями плат на чипах производства Nvidia, сначала в нашем привычном наборе синтетических тестов, а потом и в играх.

| Средняя текущая цена (количество предложений) в московской рознице: | |

|---|---|

| Рассматриваемые карты | Конкуренты |

| GTX 980 Ti — $655 (на 01.06.16) | R9 290X — $431(33) |

| GTX 980 Ti — $655 (на 01.06.16) | GTX 780 Ti — $518(11) |

| GTX 980 Ti — $655 (на 01.06.16) | GTX 980 — $495 (на 01.06.16) |

и лично Ирину Шеховцову

за предоставленную на тестирование видеокарту

| 2 блока питания Thermaltake DPS G 1050W/Амур 1200 для тестового стенда предоставлены компанией Thermaltake | Корпус Corsair Obsidian 800D Full Tower для тестового стенда предоставлен компанией Corsair | Модули памяти Corsair Vengeance CMZ16GX3M4X1600C9 для тестового стенда предоставлены компанией Corsair | Corsair Hydro SeriesT h200i CPU Cooler для тестового стенда предоставлен компанией Corsair |

| Монитор Dell UltraSharp U3011 для тестовых стендов предоставлен компанией Юлмарт | Системная плата Asus Sabertooth X79 для тестового стенда предоставлена компанией Asustek | Системная плата MSI X79A-GD45(8D) для тестового стенда предоставлена компанией MSI | Жесткий диск Seagate Barracuda 7200.14 3 ТБ для тестового стенда предоставлен компанией Seagate |

| Накопитель SSD OCZ Octane 512 ГБ для тестового стенда предоставлен компанией OCZ Russia | 2 накопителя SSD Corsair Neutron SeriesT 120 ГБ для тестового стенда предоставлены компанией Corsair | Монитор Asus ProArt PA249Q для рабочего компьютера предоставлен компанией Asustek | Клавиатура Cougar 700K для рабочего компьютера предоставленa компанией Cougar |

www.ixbt.com

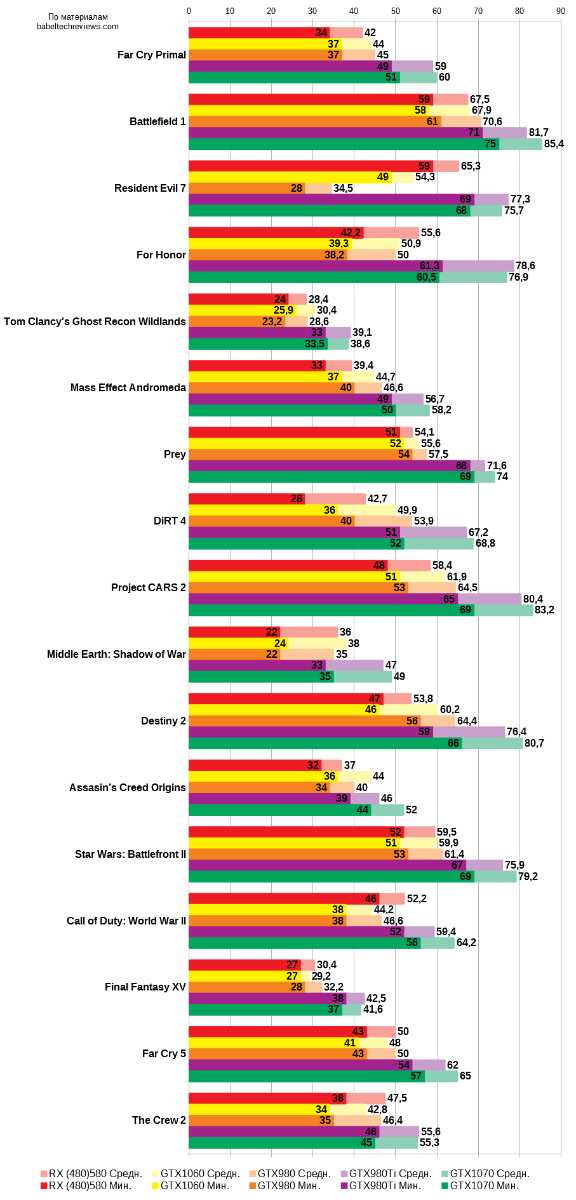

Тестирование GTX 1070, 1060, 980 Ti, 980, RX 480(580), Fury X

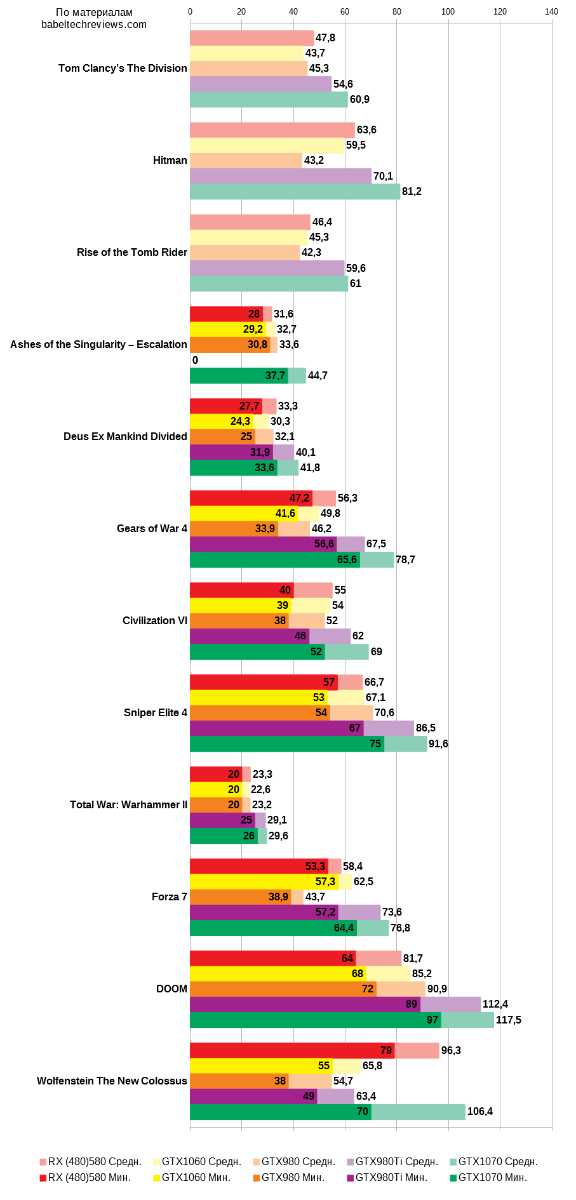

Пока мы с нетерпением ждем анонса новых видеокарт от Nvidia, на различных ресурсах все еще появляются свежие тесты текущих графических решений этой компании и графических решений прошлых поколений. Например, на портале BabelTechReviews появился ряд тестов видеокарт Nvidia GTX 1060, 980, AMD RX 480, Nvidia GTX 1070, 980Ti, AMD R9 Fury X, автор тестов Марк Поппин (Mark Poppin). Тестирования проводились в разрешениях 1440p (2560 x 1440) и 4K (3840 x 2160). В данном посте я предлагаю Вам ознакомиться с краткими результатами тестирования только для разрешения 1440p и без учета результатов R9 Fury X. Если у вас возникнет интерес, то вы можете ознакомиться с полными результатами, перейдя по ссылкам, ведущим на первоисточники.

основные составляющие тестовой конфигурации

- Intel Core i7 8700K, HT On, TB по всем ядрам 4,7 ГГц

- Team Group 16 GB DDR4 (2x8GB, 3200 МГц)

- Team Group 480 GB, Micron 1100 2 TB, SanDisk Enterprise 2 TB SSD’s

- GTX 1070 Founders Edition, 8GB

- GTX 1060 EVGA SC, 6GB

- GTX 980 Ti EVGA SC, 6GB

- GTX 980 Founders Edition, 4GB

- RX 480 Gigabyte G1 Gaming, 8GB

- PowerColor Fury X, 4 GB

Используемые драйверы видеокарт: Nvidia’s GeForce 398.36 и AMD Adrenalin Software 18.7.1. Частоты всех видеокарт Nvidia были установлены равными частотам соответствующих версий Founders Edition. Частоты RX 480 Gigabyte G1 Gaming были подняты до уровня RX 580 Gaming, поэтому в результатах тестов фигурирует RX 580.

игры и бенчмарки, участвующие в тестировании

- 3D Mark

- GTA V

- The Witcher 3

- FallOut 4

- Watch Dogs 2

- Just Cause 3

- Rainbow Six Siege

- Far Cry Primal

- Battlefield 1

- Resident Evil 7

- For Honor

- Tom Clancy’s Ghost Recon Wildlands

- Mass Effect Andromeda

- Prey

- DiRT 4

- Project CARS 2

- Middle Earth: Shadow of War

- Destiny 2

- Assasin’s Creed Origins

- Star Wars: Battlefront II

- Call of Duty: World War II

- Final Fantasy XV

- Far Cry 5

- The Crew 2

- Tom Clancy’s The Division (DX12)

- Hitman (DX12)

- Rise of the Tomb Rider (DX12)

- Ashes of the Singularity – Escalation (DX12)

- Deus Ex Mankind Divided (DX12)

- Gears of War 4 (DX12)

- Civilization VI (DX12)

- Sniper Elite 4 (DX12)

- Total War: Warhammer II (DX12)

- Forza 7 (DX12)

- Doom (Vulkan)

- Wolfenstein The New Colossus (Vulkan)

результаты тестов

Telegram-канал @overclockers_news — это удобный способ следить за новыми материалами на сайте. С картинками, расширенными описаниями и без рекламы.

Telegram-канал @overclockers_news — это удобный способ следить за новыми материалами на сайте. С картинками, расширенными описаниями и без рекламы. overclockers.ru