| 1 | AMD Radeon Pro Vega 64X | для рабочих станций | 100.00 | 54.87 | 2019 | 366 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 2 | NVIDIA GeForce GTX 1080 SLI (мобильная) | для ноутбуков | 74.40 | 72.93 | 2016 | 352 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 3 | AMD Radeon RX 5700 XT 50th Anniversary | десктопная | 72.70 | 62.57 | 2019 | 409 USD | 225 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 4 | NVIDIA TITAN Xp | десктопная | 70.37 | 71.66 | 2017 | 408 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 5 | NVIDIA GeForce GTX 980 SLI (мобильная) | для ноутбуков | 62. 25 25 | 59.21 | 2015 | 301 USD | 330 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 6 | NVIDIA Quadro P3000 (мобильная) | для мобильных рабочих станций | 59.94 | 60.13 | 2017 | 537 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 7 | NVIDIA GeForce GTX 1070 SLI | десктопная | 48.97 | 71.42 | 2016 | 539 USD | 300 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 8 | NVIDIA Tesla M40 24 GB | для рабочих станций | 43.07 | 47.05 | 2015 | 499 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 9 | AMD Radeon Pro Vega 48 | для рабочих станций | 41.56 | 42.69 | 2019 | 671 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 10 | AMD Radeon Pro W6600 | для рабочих станций | 41. 41 41 | 51.99 | 2021 | 812 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 11 | NVIDIA GeForce RTX 2060 Super | десктопная | 41.30 | 61.66 | 2019 | 667 USD | 175 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 12 | NVIDIA GeForce GTX 1070 (мобильная) | для ноутбуков | 36.94 | 39.25 | 2016 | 379 USD | 120 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 13 | AMD Radeon Pro W5500 | для рабочих станций | 35.90 | 34.72 | 2020 | 612 USD | 125 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 14 | AMD Radeon RX 6600 XT | десктопная | 35.79 | 58.83 | 2021 | 724 USD | 160 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 15 | NVIDIA GeForce GTX 1060 3 GB | десктопная | 34. 17 17 | 35.96 | 2016 | 363 USD | 120 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 16 | NVIDIA GeForce GTX 1650 (мобильная) | для ноутбуков | 33.89 | 26.13 | 2019 | 301 USD | 50 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 17 | NVIDIA GeForce GTX 1070 | десктопная | 32.24 | 50.33 | 2016 | 563 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 18 | NVIDIA GeForce GTX 1660 SUPER | десктопная | 32.11 | 47.60 | 2019 | 663 USD | 125 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 19 | NVIDIA GeForce GTX 1660 Super | десктопная | 32.11 | 47.60 | 2019 | 663 USD | 125 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 20 | NVIDIA GeForce GTX 1070 | десктопная | 31. | 50.33 | 2016 | 563 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 21 | NVIDIA GeForce RTX 2060 | десктопная | 31.62 | 52.06 | 2019 | 725 USD | 160 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 22 | AMD Radeon Pro Vega 20 | для мобильных рабочих станций | 31.49 | 22.29 | 2018 | 360 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 23 | AMD Radeon Pro W5700 | для рабочих станций | 31.10 | 56.27 | 2019 | 1143 USD | 205 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 24 | NVIDIA GeForce GTX 1660 | десктопная | 30.41 | 43.66 | 2019 | 645 USD | 120 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 25 | NVIDIA Titan X Pascal | десктопная | 30. 06 06 | 48.86 | 2016 | 596 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 26 | AMD Radeon RX 580 (мобильная) | для ноутбуков | 30.06 | 34.46 | 2017 | 410 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 27 | NVIDIA GeForce GTX 1080 Ti | десктопная | 29.84 | 67.80 | 2017 | 902 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 28 | NVIDIA GeForce GTX 1080 Ti | десктопная | 29.74 | 67.80 | 2017 | 902 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 29 | NVIDIA GeForce GTX 980 Ti | 29.62 | 52.04 | 2015 | 546 USD | 250 W | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 30 | NVIDIA GeForce GTX 1060 6 GB | десктопная | 28. 84 84 | 38.45 | 2016 | 475 USD | 120 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 31 | AMD Radeon RX 6600 | десктопная | 28.05 | 49.68 | 2021 | 771 USD | 132 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 32 | NVIDIA GeForce RTX 2080 Super | десктопная | 27.95 | 73.08 | 2019 | 1056 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 33 | NVIDIA Tesla M6 | для рабочих станций | 27.61 | 28.16 | 2015 | 350 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 34 | NVIDIA GeForce GTX 1080 | десктопная | 27.31 | 56.93 | 2016 | 748 USD | 180 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 35 | AMD Radeon RX 5700 XT | | 27. 17 17 | 63.19 | 2019 | 963 USD | 225 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 36 | NVIDIA GeForce GTX 1080 | десктопная | 27.09 | 56.93 | 2016 | 748 USD | 180 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 37 | NVIDIA TITAN V | десктопная | 26.71 | 64.23 | 2017 | 989 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 38 | AMD Radeon RX 6700 XT | | 26.12 | 70.40 | 2021 | 1081 USD | 230 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 39 | NVIDIA GeForce RTX 2070 Super Max-Q | для ноутбуков | 25.82 | 54.20 | 2020 | 812 USD | 80 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 40 | NVIDIA GeForce GTX 1650 SUPER | десктопная | 25. 49 49 | 37.39 | 2019 | 657 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 41 | NVIDIA GeForce RTX 3060 Ti | десктопная | 25.31 | 74.24 | 2020 | 1153 USD | 200 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 42 | NVIDIA GeForce RTX 2080 Super Max-Q | для ноутбуков | 24.97 | 52.41 | 2020 | 812 USD | 80 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 43 | NVIDIA GeForce RTX 3070 | десктопная | 24.84 | 82.27 | 2020 | 1262 USD | 220 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 44 | AMD Radeon RX 5700 | десктопная | 24.48 | 55.08 | 2019 | 938 USD | 180 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 45 | AMD Radeon RX 5700 | десктопная | 24. 48 48 | 55.08 | 2019 | 938 USD | 180 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 46 | AMD Radeon Pro WX 8200 | для рабочих станций | 23.91 | 51.69 | 2018 | 1346 USD | 230 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 47 | AMD Radeon RX 5600 XT | десктопная | 23.42 | 51.72 | 2020 | 924 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 48 | AMD Radeon Pro 5700 | для рабочих станций | 23.29 | 44.42 | 2020 | 1200 USD | 130 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 49 | AMD Radeon R9 Nano | десктопная | 22.99 | 31.83 | 2015 | 379 USD | 175 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 50 | NVIDIA GeForce RTX 3060 | десктопная | 22. 89 89 | 62.37 | 2021 | 1090 USD | 170 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 51 | NVIDIA GeForce GTX 1660 Ti (мобильная) | для ноутбуков | 22.88 | 38.17 | 2019 | 682 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 52 | AMD Radeon Pro WX 7100 | для рабочих станций | 22.81 | 29.28 | 2017 | 582 USD | 130 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 53 | AMD Radeon Vega Frontier Edition | десктопная | 22.27 | 51.99 | 2017 | 961 USD | 300 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 54 | NVIDIA GeForce RTX 3070 Ti | десктопная | 22.18 | 84.95 | 2021 | 1401 USD | 290 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 55 | NVIDIA GeForce GTX 1650 | десктопная | 22. 05 05 | 29.07 | 2019 | 555 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 56 | NVIDIA GeForce GTX 1660 Ti | десктопная | 21.91 | 44.17 | 2019 | 858 USD | 120 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 57 | NVIDIA GeForce GTX 980 | десктопная | 21.79 | 42.22 | 2014 | 536 USD | 220 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 58 | AMD Radeon RX 5600M | для ноутбуков | 21.49 | 28.01 | 2020 | 525 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 59 | AMD Radeon RX 580 | десктопная | 20.92 | 33.28 | 2017 | 574 USD | 185 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 60 | NVIDIA GeForce GTX TITAN X | десктопная | 20. 74 74 | 49.07 | 2015 | 711 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 61 | NVIDIA GeForce RTX 2080 | десктопная | 20.73 | 69.76 | 2018 | 1277 USD | 215 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 62 | NVIDIA GeForce GTX 980M SLI | для ноутбуков | 20.56 | 38.84 | 2014 | 499 USD | 200 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 63 | NVIDIA GeForce RTX 2080 Ti | десктопная | 20.24 | 81.45 | 2018 | 1450 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 64 | NVIDIA Quadro P5000 (мобильная) | для мобильных рабочих станций | 20.24 | 80.78 | 2017 | 2137 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 65 | NVIDIA GeForce RTX 2070 Super | десктопная | 20. 24 24 | 68.11 | 2019 | 1277 USD | 215 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 66 | AMD Radeon RX 6800 | десктопная | 20.15 | 77.89 | 2020 | 1410 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 67 | NVIDIA Quadro P2000 (мобильная) | для мобильных рабочих станций | 19.98 | 52.01 | 2017 | 1477 USD | 50 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 68 | NVIDIA Quadro P4000 Max-Q | для мобильных рабочих станций | 19.62 | 33.06 | 2017 | 803 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 69 | NVIDIA GeForce GTX 1050 Ti | десктопная | 19.47 | 23.75 | 2016 | 340 USD | 70 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 70 | NVIDIA GeForce GTX 1050 Ti | десктопная | 19. 47 47 | 23.75 | 2016 | 340 USD | 70 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 71 | NVIDIA Quadro P1000 | для рабочих станций | 18.96 | 16.71 | 2017 | 301 USD | 47 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 72 | NVIDIA GeForce RTX 2070 | десктопная | 18.82 | 60.32 | 2018 | 1232 USD | 175 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 73 | NVIDIA Quadro M5000M | для мобильных рабочих станций | 18.30 | 25.93 | 2015 | 468 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 74 | NVIDIA GeForce GTX 780 Ti | десктопная | 18.15 | 34.56 | 2013 | 400 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 75 | AMD Radeon RX 6800 XT | десктопная | 18. 06 06 | 86.48 | 2020 | 1630 USD | 300 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 76 | NVIDIA Quadro P4000 (мобильная) | для мобильных рабочих станций | 17.78 | 36.83 | 2017 | 1053 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 77 | NVIDIA Quadro P4000 | для рабочих станций | 17.41 | 43.38 | 2017 | 1346 USD | 105 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 78 | NVIDIA Quadro RTX 3000 (мобильная) | для мобильных рабочих станций | 17.37 | 72.26 | 2019 | 2393 USD | 80 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 79 | NVIDIA Quadro P2000 Max-Q | для мобильных рабочих станций | 17.28 | 18.94 | 2017 | 426 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 80 | AMD Radeon RX 5500 | десктопная | 17. 17 17 | 32.56 | 2019 | 816 USD | 110 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 81 | AMD Radeon R9 FURY X | десктопная | 17.09 | 38.00 | 2015 | 670 USD | 275 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 82 | AMD Radeon RX 5500 XT | десктопная | 16.59 | 34.34 | 2019 | 877 USD | 130 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 83 | AMD Radeon Pro Vega 16 | для мобильных рабочих станций | 16.10 | 17.56 | 2018 | 511 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 84 | AMD Radeon RX 6900 XT | десктопная | 15.48 | 95.06 | 2020 | 1905 USD | 300 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 85 | AMD Radeon RX Vega 64 | десктопная | 15. 45 45 | 55.00 | 2017 | 1330 USD | 295 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 86 | NVIDIA Quadro M6000 24 GB | для рабочих станций | 15.09 | 47.45 | 2016 | 1503 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 87 | AMD Radeon Pro SSG | для рабочих станций | 14.93 | 39.37 | 2017 | 1499 USD | 350 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 88 | NVIDIA Quadro P4200 | для мобильных рабочих станций | 14.67 | 37.28 | 2018 | 1526 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 89 | NVIDIA Quadro RTX 5000 Max-Q | для мобильных рабочих станций | 14.54 | 52.76 | 2019 | 2130 USD | 80 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 90 | AMD Radeon Pro W6800 | для рабочих станций | 14. 32 32 | 72.01 | 2021 | 2800 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 91 | NVIDIA GeForce GTX 1050 | десктопная | 14.10 | 19.23 | 2016 | 342 USD | 60 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 92 | NVIDIA GeForce GTX 1050 | десктопная | 14.10 | 19.23 | 2016 | 342 USD | 60 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 93 | NVIDIA Quadro RTX 8000 | для рабочих станций | 13.90 | 73.62 | 2018 | 2920 USD | 260 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 94 | AMD Radeon R9 390X | десктопная | 13.62 | 35.71 | 2015 | 750 USD | 275 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 95 | NVIDIA Quadro T1000 (мобильная) | для мобильных рабочих станций | 13. 60 60 | 42.99 | 2019 | 1890 USD | 50 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 96 | NVIDIA Quadro RTX 4000 | для рабочих станций | 13.46 | 58.47 | 2018 | 2482 USD | 160 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 97 | NVIDIA GeForce GTX 1080 Max-Q | для ноутбуков | 13.43 | 38.28 | 2017 | 1008 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 98 | NVIDIA TITAN V CEO Edition | десктопная | 13.31 | 63.71 | 2018 | 1630 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 99 | NVIDIA GeForce GTX TITAN BLACK | десктопная | 13.21 | 34.20 | 2014 | 550 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 100 | AMD Radeon RX Vega 7 | для ноутбуков | 13. 05 05 | 15.38 | 2020 | 387 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 101 | NVIDIA GeForce RTX 3080 | десктопная | 12.90 | 92.05 | 2020 | 2077 USD | 320 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 102 | NVIDIA GeForce GTX 1060 Max-Q 6 GB | для ноутбуков | 12.80 | 36.59 | 2017 | 1010 USD | 80 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 103 | AMD Radeon RX Vega 56 | десктопная | 12.77 | 51.01 | 2017 | 1443 USD | 210 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 104 | NVIDIA GeForce GTX 960 | десктопная | 12.75 | 22.66 | 2015 | 331 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 105 | NVIDIA GeForce RTX 2080 Max-Q | для ноутбуков | 12. 73 73 | 52.11 | 2019 | 1268 USD | 80 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 106 | NVIDIA Quadro M4000 | для рабочих станций | 12.63 | 24.98 | 2015 | 603 USD | 120 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 107 | NVIDIA GeForce RTX 2070 Super Mobile | для ноутбуков | 12.49 | 64.34 | 2020 | 1443 USD | 115 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 108 | NVIDIA GeForce GTX 1650 Ti Mobile | для ноутбуков | 12.24 | 29.24 | 2020 | 892 USD | 50 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 109 | NVIDIA Quadro P5000 | для рабочих станций | 11.88 | 44.52 | 2016 | 1936 USD | 180 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 110 | AMD Radeon PRO WX 9100 | для рабочих станций | 11. 64 64 | 47.64 | 2017 | 2327 USD | 230 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 111 | NVIDIA GeForce RTX 3080 Ti | десктопная | 11.49 | 100.00 | 2020 | 2310 USD | 350 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 112 | AMD Radeon RX 570 | десктопная | 11.29 | 26.13 | 2017 | 733 USD | 120 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 113 | NVIDIA GeForce GTX 1660 Ti Max-Q | для ноутбуков | 11.12 | 33.06 | 2019 | 1037 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 114 | NVIDIA GeForce GTX 1050 Ti (мобильная) | для ноутбуков | 11.02 | 22.20 | 2017 | 545 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 115 | NVIDIA Quadro M5000 | для рабочих станций | 10. 83 83 | 35.62 | 2015 | 1300 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 116 | AMD Radeon R9 295X2 | десктопная | 10.79 | 31.54 | 2014 | 600 USD | 500 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 117 | AMD Radeon RX 5300 | десктопная | 10.79 | 27.56 | 2020 | 1037 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 118 | NVIDIA GeForce RTX 2060 (мобильная) | для ноутбуков | 10.65 | 42.58 | 2019 | 1250 USD | 115 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 119 | NVIDIA Quadro K6000 | для рабочих станций | 10.60 | 30.48 | 2013 | 731 USD | 225 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 120 | NVIDIA GeForce RTX 2070 Max-Q | для ноутбуков | 10. 51 51 | 45.58 | 2019 | 1311 USD | 80 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 121 | NVIDIA Quadro GP100 | для рабочих станций | 10.15 | 58.31 | 2016 | 2969 USD | 235 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 122 | NVIDIA Quadro M6000 | для рабочих станций | 10.10 | 42.27 | 2015 | 1733 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 123 | NVIDIA Quadro RTX 5000 | для рабочих станций | 9.94 | 61.00 | 2018 | 3283 USD | 230 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 124 | AMD Radeon RX 560X (мобильная) | для ноутбуков | 9.92 | 20.01 | 2017 | 520 USD | 65 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 125 | NVIDIA Quadro RTX 5000 (мобильная) | для мобильных рабочих станций | 9. 89 89 | 55.63 | 2019 | 3065 USD | 110 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 126 | NVIDIA Quadro M4000M | для мобильных рабочих станций | 9.75 | 25.10 | 2015 | 832 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 127 | AMD Radeon RX Vega 9 | для ноутбуков | 9.46 | 11.63 | 2017 | 302 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 128 | NVIDIA Quadro P2200 | для рабочих станций | 9.39 | 35.95 | 2019 | 2230 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 129 | NVIDIA GeForce RTX 2080 Super Mobile | для ноутбуков | 9.33 | 64.55 | 2020 | 1671 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 130 | AMD Radeon Pro 5300 | для рабочих станций | 9. 28 28 | 28.20 | 2020 | 1749 USD | 85 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 131 | NVIDIA Quadro RTX 4000 (мобильная) | для мобильных рабочих станций | 9.26 | 48.42 | 2019 | 2890 USD | 110 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 132 | NVIDIA GeForce GTX 980M | для ноутбуков | 9.20 | 27.42 | 2014 | 583 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 133 | NVIDIA Tesla T4 | для рабочих станций | 9.19 | 41.60 | 2018 | 2569 USD | 70 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 134 | AMD Radeon RX 5300M | для ноутбуков | 8.94 | 14.58 | 2019 | 525 USD | 85 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 135 | AMD Radeon RX Vega 8 (Ryzen 4000) | для ноутбуков | 8. 89 89 | 16.77 | 2020 | 631 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 136 | NVIDIA Quadro P6000 | для рабочих станций | 8.50 | 58.04 | 2016 | 3527 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 137 | AMD Radeon RX Vega M GH | для ноутбуков | 8.34 | 25.44 | 2018 | 1031 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 138 | NVIDIA Quadro M2000M | для мобильных рабочих станций | 8.24 | 13.37 | 2015 | 363 USD | 55 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 139 | AMD Radeon R9 370 | десктопная | 7.90 | 17.71 | 2015 | 380 USD | 110 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 140 | AMD Radeon RX 580 2048SP | десктопная | 7. 78 78 | 28.95 | 2018 | 1373 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 141 | NVIDIA GeForce GTX 970M SLI | для ноутбуков | 7.77 | 38.94 | 2014 | 1326 USD | 162 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 142 | NVIDIA GeForce GTX TITAN | десктопная | 7.70 | 31.98 | 2013 | 806 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 143 | AMD Radeon Pro WX Vega M GL | для мобильных рабочих станций | 7.59 | 22.69 | 2018 | 1359 USD | 65 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 144 | AMD Radeon RX 560 (мобильная) | для ноутбуков | 7.34 | 15.07 | 2017 | 468 USD | 55 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 145 | AMD FirePro W7100 | для рабочих станций | 7. 19 19 | 21.73 | 2014 | 660 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 146 | NVIDIA Quadro P3200 | для мобильных рабочих станций | 7.14 | 31.90 | 2017 | 2122 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 147 | AMD Radeon Pro 5500 XT | для рабочих станций | 7.10 | 31.09 | 2020 | 2499 USD | 125 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 148 | AMD FirePro W8100 | для рабочих станций | 7.01 | 27.13 | 2014 | 987 USD | 220 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 149 | AMD FirePro W4300 | для рабочих станций | 6.97 | 10.85 | 2015 | 332 USD | 50 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 150 | NVIDIA Quadro M5500 | для мобильных рабочих станций | 6. 92 92 | 29.69 | 2016 | 1700 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 151 | AMD Radeon Pro 5500M | для мобильных рабочих станций | 6.90 | 24.80 | 2019 | 1950 USD | 85 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 152 | NVIDIA Quadro M2000 | для рабочих станций | 6.74 | 14.94 | 2016 | 602 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 153 | NVIDIA GeForce GTX 1070 Max-Q | для ноутбуков | 6.56 | 26.07 | 2017 | 1244 USD | 115 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 154 | AMD Radeon R7 370 | десктопная | 6.50 | 16.67 | 2015 | 418 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 155 | NVIDIA TITAN RTX | десктопная | 6. 47 47 | 70.73 | 2018 | 2579 USD | 280 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 156 | NVIDIA Quadro T1000 | для рабочих станций | 6.44 | 24.32 | 2019 | 2048 USD | 50 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 157 | NVIDIA Quadro K5200 | для рабочих станций | 6.44 | 22.20 | 2014 | 753 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 158 | NVIDIA GeForce GTX 1650 Ti Max-Q | для ноутбуков | 6.42 | 23.42 | 2020 | 1183 USD | 50 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 159 | AMD Radeon PRO WX 2100 | для мобильных рабочих станций | 6.35 | 6.57 | 2018 | 343 USD | 35 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 160 | NVIDIA Quadro M3000M | для мобильных рабочих станций | 6. 29 29 | 21.24 | 2015 | 981 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 161 | AMD FirePro W7000 | для рабочих станций | 6.26 | 16.03 | 2012 | 337 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 162 | AMD Radeon RX Vega 6 (Ryzen 4000) | для ноутбуков | 6.16 | 13.88 | 2020 | 717 USD | − | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 163 | NVIDIA GeForce GTX 1650 Max-Q | для ноутбуков | 6.03 | 22.09 | 2019 | 1185 USD | 30 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 164 | AMD Radeon Pro VII | для рабочих станций | 6.00 | 63.21 | 2020 | 4876 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 165 | NVIDIA GeForce RTX 2070 (мобильная) | для ноутбуков | 5. 98 98 | 46.33 | 2019 | 1758 USD | 115 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 166 | NVIDIA Quadro P5200 | для мобильных рабочих станций | 5.91 | 45.39 | 2017 | 3894 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 167 | AMD Radeon R9 270X | десктопная | 5.82 | 18.42 | 2013 | 350 USD | 180 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 168 | AMD FirePro W7170M | для мобильных рабочих станций | 5.60 | 14.44 | 2015 | 600 USD | 100 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 169 | NVIDIA Quadro P2000 | для рабочих станций | 5.59 | 27.26 | 2017 | 2108 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 170 | NVIDIA GeForce GTX 1050 Ti Max-Q | для ноутбуков | 5. 59 59 | 20.64 | 2018 | 1140 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 171 | NVIDIA Quadro T2000 (мобильная) | для мобильных рабочих станций | 5.57 | 23.31 | 2019 | 2221 USD | 60 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 172 | AMD Radeon RX 560 | десктопная | 5.41 | 13.50 | 2017 | 596 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 173 | AMD Radeon Pro 5300M | для мобильных рабочих станций | 5.37 | 21.56 | 2019 | 2068 USD | 85 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 174 | AMD Radeon Pro WX 3200 | для мобильных рабочих станций | 5.30 | 9.50 | 2019 | 740 USD | 65 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 175 | NVIDIA GeForce RTX 3090 | десктопная | 5. 29 29 | 97.72 | 2020 | 3163 USD | 350 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 176 | NVIDIA Quadro K1200 | для рабочих станций | 5.27 | 10.76 | 2015 | 319 USD | 45 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 177 | NVIDIA GeForce RTX 2080 (мобильная) | для ноутбуков | 5.24 | 56.66 | 2019 | 2003 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 178 | NVIDIA GeForce RTX 2060 Max-Q | для ноутбуков | 5.24 | 36.67 | 2019 | 1680 USD | 65 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 179 | AMD FirePro W9000 | для рабочих станций | 5.24 | 23.02 | 2012 | 839 USD | 274 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 180 | NVIDIA RTX A2000 | десктопная | 5. 11 11 | 53.99 | 2021 | 2539 USD | 70 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 181 | AMD Radeon RX 560X | десктопная | 5.09 | 15.46 | 2018 | 907 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 182 | AMD Radeon RX 5500M | для ноутбуков | 5.00 | 15.19 | 2019 | 998 USD | 85 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 183 | AMD Radeon R9 270 | десктопная | 4.92 | 16.15 | 2013 | 317 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 184 | AMD Radeon Pro 455 | для мобильных рабочих станций | 4.71 | 11.67 | 2016 | 696 USD | 35 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 185 | NVIDIA GeForce GTX 690 | десктопная | 4. 67 67 | 21.01 | 2012 | 569 USD | 300 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 186 | AMD FirePro S7150 | для рабочих станций | 4.65 | 23.54 | 2016 | 1683 USD | 150 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 187 | AMD FirePro S10000 | для рабочих станций | 4.56 | 19.63 | 2012 | 699 USD | 375 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 188 | NVIDIA Quadro K2200 | для рабочих станций | 4.54 | 13.29 | 2014 | 418 USD | 68 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 189 | AMD Radeon Pro 555X | для мобильных рабочих станций | 4.42 | 12.13 | 2017 | 894 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 190 | NVIDIA GeForce GTX 860M SLI | для ноутбуков | 4. 41 41 | 18.62 | 2014 | 489 USD | 120 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 191 | NVIDIA GeForce GTX TITAN Z | десктопная | 4.30 | 34.11 | 2014 | 1785 USD | 375 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 192 | AMD Radeon HD 7970 | десктопная | 4.30 | 19.68 | 2011 | 542 USD | 250 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 193 | AMD FirePro W9100 | для рабочих станций | 4.25 | 29.07 | 2014 | 1744 USD | 275 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 194 | AMD Radeon Pro 555 | для мобильных рабочих станций | 4.25 | 11.78 | 2017 | 894 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 195 | NVIDIA GeForce GTX 970M | для ноутбуков | 4. 24 24 | 22.03 | 2014 | 848 USD | 81 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 196 | AMD Radeon Pro WX 5100 | для рабочих станций | 4.24 | 20.95 | 2016 | 1797 USD | 75 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 197 | AMD FirePro S9050 | для рабочих станций | 4.20 | 14.67 | 2014 | 550 USD | 225 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 198 | AMD Radeon Pro Vega 56 | для рабочих станций | 4.19 | 45.79 | 2017 | 4999 USD | 210 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 199 | AMD Radeon RX 550 | десктопная | 4.15 | 10.24 | 2017 | 540 USD | 50 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 200 | AMD Radeon HD 7870 | десктопная | 4. 05 05 | 17.48 | 2012 | 452 USD | 200 W | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

выбираем лучшие из девяти новых GPU / Хабр

Весной 2021 года NVIDIA представила новую линейку видеокарт RTX Ax000 и Ax0 на архитектуре Ampere, с тензорными ядрами третьего поколения. На тот момент в Selectel уже можно было арендовать

выделенные и облачные серверы с GPUTesla M60, T4, V100 и даже топовыми NVIDIA A100.

Поскольку мы стараемся предоставлять клиентам только актуальное железо с современными технологиями, решили, что пора обновить линейку видеокарт. Предлагать все анонсированные NVIDIA видеокарты нерационально как для нас, так и для клиентов. Под катом расскажу, как мы выбирали лучших из лучших и поделюсь результатами нашего бенчмарка на тестовой сборке.

Подход, с помощью которого мы в Selectel выбираем железо — видеокарты, процессоры и другие комплектующие, — довольно прост. Мы предполагаем, что клиент хочет решить свои бизнес-задачи эффективно и с минимальными затратами. Соответственно, отталкиваемся от следующей формулы:

Соответственно, отталкиваемся от следующей формулы:

По ней же мы выбирали лидеров среди новых видеокарт.

Какие видеокарты рассматривали

Сравнивали девять GPU: видеокарты RTX от А2000 до А6000, А10, А16, А30, А40 и A100 PCIe. A2000 вышла только летом этого года, но это не помешало рассмотреть характеристики чипа и протестировать образец.Тут у нас «семья» RTX Ax000 — от старшей A5000 до младшей А2000.

Все участники тестирования — серверные видеокарты, десктопных GeForce RTX 3080 и 3090 в списке нет. Эти карты (а если быть точным, установка драйверов NVIDIA) запрещены к использованию в серверах в дата-центрах. Производитель строго следит за соблюдением ограничений: санкции за нарушение применяются не только к провайдеру, но и клиенту, который арендует сервер с десктопным железом или устанавливает на нем ПО NVIDIA.

Для оценки видеокарт мы отталкивались от нескольких характеристик, которые важны для решения задач, часто возникающих у клиентов. То есть смотрели на то, за что, вообще, берут эти GPU. Назначение ядер представлено в упрощенной форме, каждый тип влияет на производительность видеокарты.

То есть смотрели на то, за что, вообще, берут эти GPU. Назначение ядер представлено в упрощенной форме, каждый тип влияет на производительность видеокарты.

Среди них:

- Число ядер CUDA (для тех, кто не знает, это условное обозначение скалярных вычислительных блоков в видеочипах NVIDIA). Чем больше ядер, тем лучше карта справляется с работой с графикой и вычислениями в целом.

- Число тензорных ядер, которые динамически оптимизируют вычисления и здорово справляются с нагрузками, характерными для работы с ИИ, перемножением матриц для обучения нейросетей и анализа данных.

- Число RT (Ray Tracing) ядер, которые обеспечивают высокую точность рендеринга.

К слову, NVIDIA не всегда указывает точное количество CUDA, RT и тензорных ядер. Для сравнения мы использовали данные сторонних источников.

- Объем памяти.

- Пропускная способность памяти. Эти два пункта логично влияют на производительность видеокарты.

- Поддержка виртуальных GPU VDI.

Этот пункт важен, поскольку инфраструктуру виртуальных рабочих столов нередко используют наши клиенты.

Этот пункт важен, поскольку инфраструктуру виртуальных рабочих столов нередко используют наши клиенты. - Энергопотребление. Это, скорее, пунктик для нас: для дата-центра этот показатель важен при выборе корпуса, питания для сервера и стойки.

Вот что получилось по цифрам:

Данные не предоставляются NVIDIA, взяты из открытых сторонних источников (pny.eu, techpowerup.com).

Какие выводы можно сделать из этой таблички

Для линейки RTX Ax000 характеристики растут почти линейно с ростом индекса модели.

A16 — это четыре видеокарты в одной. NVIDIA позиционирует устройство как специальное решение для VDI.

A30, на первый взгляд, менее производительная, чем A10, однако тип памяти HBM2 имеет большую пропускную способность. NVIDIA позиционирует A30 как решение для ИИ. По обоим устройствам компания не публикует данные по количеству тензорных и других ядер (характеристики получены из сторонних источников).

В сравнение с другими видеокартами в таблице, топовое решение A100 в форм-факторе PCIe имеет максимальную пропускную способность памяти и максимальное количество тензорных ядер, что ожидаемо. Очевидно, что основное назначение этой GPU — работа с искусственным интеллектом и сложными вычислениями. В линейке NVIDIA это самая производительная видеокарта на сегодняшний день, особенно версия с 80 ГБ памяти в форм-факторе SXM. Но последняя распаивается на плате, и из соображений унификации мы рассматривали только вариант в форм-факторе PCIe.

Очевидно, что основное назначение этой GPU — работа с искусственным интеллектом и сложными вычислениями. В линейке NVIDIA это самая производительная видеокарта на сегодняшний день, особенно версия с 80 ГБ памяти в форм-факторе SXM. Но последняя распаивается на плате, и из соображений унификации мы рассматривали только вариант в форм-факторе PCIe.

А сколько стоит

Следуя уже озвученной формуле по выбору комплектующих, рассмотрим цены. Сложно писать о них в 2021 году, который запомнился кризисом чипов и постоянными перебоями поставок.

Точных цифр не будет по двум причинам. Во-первых, это коммерческая тайна. Во-вторых, и это главное, с момента анонсирования карт весной цены успели измениться (и, уверен, продолжат меняться далее).

Будем использовать такой подход: примем за эталон GPU A5000 — его цена в сравнительной таблице будет равняться 1 «попугаю». Цены на остальные карты я представлю через отношение к цене A5000. A10 и A16 в близком ценовом диапазоне, поэтому «стоят» столько же.

На этом этапе соотношение цен и заявленных характеристик ожидаемо. Первый кандидат на добавление в линейку видеокарт Selectel, на роль младшей модели, – А2000. Также вызывает интерес паритет между A5000, A10 и A16.

Изнанка наших GPU.Перейдем к тестированию производительности претендентов.

Тестирование видеокарт

Проводить тесты оборудования — обычная практика для Selectel. Мы используем большое количество железа в различных продуктах компании, поэтому тестируем его как на совместимость друг с другом и ПО, так и на производительность.

Для этого у нас есть своя «лаборатория» — Selectel Lab. Некоторое оборудование мы даже предоставляем клиентам для бесплатного тестирования в их проектах. Из свежих примеров: отдаем на тест настоящего монстра DGX A100 c 8 одноименными видеокартами. Подробней о его бенчмарке можно прочитать по ссылке.

Для тестирования новых видеокарт мы собрали тестовые серверы с двумя мощными процессорами от Intel и достаточным количеством оперативной памяти.

Характеристики следующие:

- 2 × Intel® Xeon® Gold 6240: 18 ядер с частотой 2.6 ГГц

- 192–384 ГБ DDR4;

- 240–480 ГБ SSD SATA;

- 1 × выбранный GPU

Бенчмарки, которые мы выбрали:

GeekBench 5 — общий тест, моделирующий выполнение задач и определяющий производительность GPU.

AI-benchmark — тест производительности, который замеряет скорость обучения и применения различных нейронных сетей на задачах распознавания и классификации.

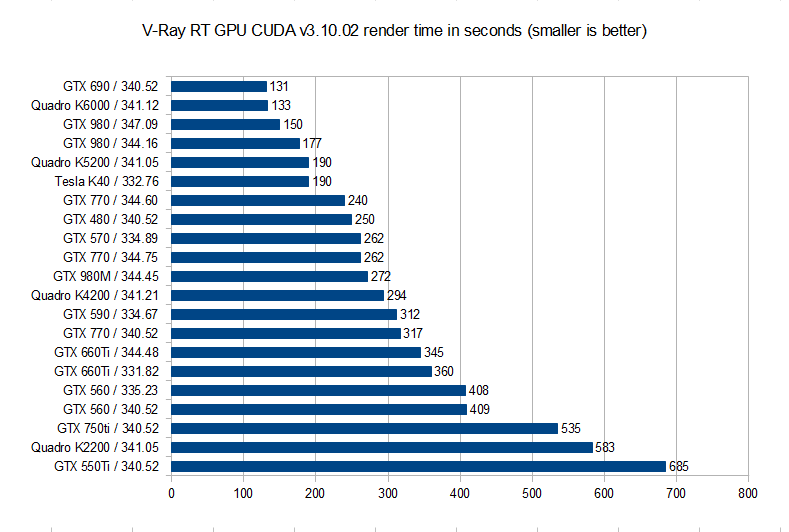

V-Ray Benchmark — тест для проверки скорости рендеринга.

ffmpeg NVENC — тест на производительность при транскодинге видео.

Результаты тестирования представлены в таблице. Выделили лидеров по каждому пункту.

На время написания статьи видеокарт A16 и RTX A6000 на руках у нас не было, поэтому в таблицу они не вошли. Их бенчмарк планируется позже.

Лидеры бенчмарка

По результатам тестирования A5000 побеждает по соотношению цены и качества. Лучший результат в OpenCL Compute Score, незначительно уступает более дорогим A40 и A100 в CUDA Compute Score и подойдет для работы с графикой. Второе место в AI-benchmark после A100. Лидер в V-Ray тесте на скорость рендеринга, лидер в тесте на транскодинг. Поддерживает VDI. Безоговорочно наш вариант, если сопоставить с таблицей цен.

Лучший результат в OpenCL Compute Score, незначительно уступает более дорогим A40 и A100 в CUDA Compute Score и подойдет для работы с графикой. Второе место в AI-benchmark после A100. Лидер в V-Ray тесте на скорость рендеринга, лидер в тесте на транскодинг. Поддерживает VDI. Безоговорочно наш вариант, если сопоставить с таблицей цен.

A2000 — в пять раз дешевле A5000, при этом демонстрирует приемлемые результаты бенчмарка для базовой модели. Не поддерживает VDI, но подходит для работы с графикой и задач ИИ.

A4000 — «середнячок» по производительности между A2000 и A5000, не поддерживает VDI, но в остальном выдерживает критику по соотношению цены и результатов бенчмарков.

A100, как я уже писал, — безоговорочный лидер для работы с искусственным интеллектом, обучением моделей, инференсом, анализом данных и сложными вычислениями. Оптимален для инфраструктуры удаленных рабочих столов.

Остальные GPU при сравнении бенчмарков и цены показали меньшие результаты.

Финал

На пьедестале победителей (которые, кстати, уже можно заказать на сайте) — четыре видеокарты.

Нашей формуле соответствуют RTX A2000, RTX A4000, RTX A5000 и A100.

Нашей формуле соответствуют RTX A2000, RTX A4000, RTX A5000 и A100.Мы хотим предоставить клиентам свободу выбора: от недорогих серверов с одним GPU до кластеров с несколькими видеокартами на борту. Если нужен «крепкий» сервер для рендеринга, добавьте в него A2000 — выполнит работу на пять и не «съест» бюджет. А для амбициозных задач со сложными вычислениями, ИИ, крупными VDI-проектами есть сервер с восемью А100. Уже есть готовый конфиг. Несмотря на наш строгий отбор, мы готовы предоставить клиенту любую карту NVIDIA (кроме десктопных RTX 3080 и 3090, конечно).

Выбранные карты в наличии на складе, а это значит, что кастомный сервер с ними вы получите в течение пяти дней. Если подойдет уже собранный сервер с GPU, он будет готов для работы уже через 2-60 минут.

Технический обзор Surface Book 3 GPU — Surface

- Статья

- Чтение занимает 9 мин

Оцените свои впечатления

Да Нет

Хотите оставить дополнительный отзыв?

Отзывы будут отправляться в корпорацию Майкрософт. Нажав кнопку «Отправить», вы разрешаете использовать свой отзыв для улучшения продуктов и служб Майкрософт. Политика конфиденциальности.

Нажав кнопку «Отправить», вы разрешаете использовать свой отзыв для улучшения продуктов и служб Майкрософт. Политика конфиденциальности.

Отправить

Спасибо!

В этой статье

Введение

Surface Book 3, самый мощный пока выпущенный ноутбук Surface, интегрирует полностью модернизированные возможности вычислений и графики в свой знаменитый съемный форм-фактор. Под руководством четырехъядерного 10-го поколения Intel® Core™ i7 и NVIDIA® Quadro RTX™ 3000 графических процессоров (GPU) на 15-дюймовой модели, Surface Book 3 поставляется в широком диапазоне конфигураций для потребителей, творческих специалистов, архитекторов, инженеров и ученых данных. В этой статье объясняются основные различия между конфигурациями GPU для 13-дюймовых и 15-дюймовых моделей Surface Book 3.

Значительным дифференциатором Surface Book трех моделей является конфигурация GPU. Помимо интегрированного GPU Intel, встроенного во все модели, все устройства, кроме начального уровня 13,5-дюймового core i5, также оснащены дискретным GPU NVIDIA с max-Q Design, который включает функции, оптимизируя энергоэффективность для мобильных форм-факторов.

Встроенный в базу клавиатуры, дополнительный GPU NVIDIA предоставляет расширенные возможности визуализации графики и поставляется в двух основных конфигурациях: GeForce® GTX® 1650/1660 Ti для потребителей или творческих специалистов и Quadro RTX 3000 для творческих специалистов, инженеров и других бизнес-специалистов, которым необходимы расширенные графики или возможности глубокого обучения. В этой статье также описано, как оптимизировать использование GPUs приложения, указав, какие приложения должны использовать интегрированный iGPU по сравнению с дискретным GPU NVIDIA.

Surface Book 3 GPUs

В этом разделе описываются интегрированные и дискретные GPUs для Surface Book 3 моделей. Сведения о конфигурации всех моделей со ссылкой на приложение A: Surface Book 3 SKUs.

Сведения о конфигурации всех моделей со ссылкой на приложение A: Surface Book 3 SKUs.

Intel Iris™ Plus Graphics

Интегрированный GPU (iGPU), включенный во все модели Surface Book 3, включает более широкий графический движок и переработанный контроллер памяти с поддержкой LPDDR4X. Установленный в качестве вторичного GPU на большинстве Surface Book 3 моделей, Intel Iris Plus Graphics выполняет функции сингулярного GPU в основной модели i5 с диагональю 13,5 дюйма. Хотя номинально устройство начального уровня в строке Surface Book 3, оно предоставляет расширенные графические возможности, позволяющие потребителям, любителям и онлайн-создателям запускать новейшее программное обеспечение производительности, например Adobe Creative Cloud, или наслаждаться играми в 1080p.

NVIDIA GeForce GTX 1650

NVIDIA GeForce GTX 1650 с помощью дизайна Max-Q обеспечивает крупное обновление основного мультипроцессора потоковой передачи для более эффективного обработки сложной графики современных игр. Одновременное выполнение операций плавающей точки и многостройки повышает производительность в вычислительных нагрузках современных игр. Новая архитектура единой памяти с двукратным кэшом предшественника позволяет улучшить производительность сложных современных игр. Новые улучшения в области затенки повышают производительность, повышают качество изображения и обеспечивают новые уровни геометрической сложности.

Одновременное выполнение операций плавающей точки и многостройки повышает производительность в вычислительных нагрузках современных игр. Новая архитектура единой памяти с двукратным кэшом предшественника позволяет улучшить производительность сложных современных игр. Новые улучшения в области затенки повышают производительность, повышают качество изображения и обеспечивают новые уровни геометрической сложности.

NVIDIA GeForce GTX 1660 Ti

Чем быстрее GeForce GTX 1650, тем быстрее GeForce GTX 1660 Ti обеспечивает Surface Book 3 дополнительные улучшения производительности и включает в себя новый и обновленный кододер NVIDIA, что делает его лучше для потребителей, геймеров, живых стримеров и творческих специалистов.

Благодаря 6 ГБ графической памяти GDDR6, Surface Book 3 модели, оснащенные NVIDIA GeForce GTX 1660 TI, обеспечивают превосходные скорости на передовом программном обеспечении производительности бизнеса и популярных играх, особенно при запуске самых современных названий или livestreaming. С необязательным SSD 2 TB (доступно только в США), 15-дюймовая модель с GeForce GTX 1660 Ti обеспечивает наибольшее хранилище любого устройства Surface Book 3.

С необязательным SSD 2 TB (доступно только в США), 15-дюймовая модель с GeForce GTX 1660 Ti обеспечивает наибольшее хранилище любого устройства Surface Book 3.

NVIDIA Quadro RTX 3000

NVIDIA Quadro RTX 3000 открывает несколько ключевых функций для профессиональных пользователей: отрисовку трассировки лучей и ускорение ИИ, а также расширенные показатели графики и вычислений. Сочетание 30 ядер RT, 240 ядер тенсора и 6 ГБ графической памяти GDDR6 позволяет использовать несколько расширенных рабочих нагрузок, включая рабочие процессы с питанием от «Аль», создание 3D-контента, усовершенствование редактирования видео, профессиональное вещание и рабочие процессы с несколькими приложениями. Enterprise оборудование и поддержка программного обеспечения интегрируют средства развертывания для максимального простоя и минимизации требований к ИТ-поддержке. Сертифицированные для самых современных программных средств в мире, драйверы Quadro оптимизированы для профессиональных приложений и настроены, протестированы и проверены для обеспечения сертификации приложений, стабильности, надежности, доступности и поддержки с расширенной доступностью продукта.

Сравнение GPUs в Surface Book 3

GPUs NVIDIA обеспечивают пользователям большую производительность для игр, livestreaming и создания контента. Продукты GeForce GTX отлично подходит для геймеров и создателей контента. Продукты Quadro RTX ориентированы на профессиональных пользователей, обеспечивают большую производительность в играх и создании контента, а также добавляют следующие функции:

- Ускорение RTX для отслеживания лучей и ИИ. Это позволяет отрисовка объектов и сред с физическими точными тенями, отражениями и преломлями. А его аппаратные возможности ускоренного ИИ означает, что расширенные функции на основе ИИ в популярных приложениях могут работать быстрее, чем когда-либо ранее.

- Enterprise оборудования, драйверов и поддержки, а также сертификации приложений ISV.

- Функции ИТ-управления, включая дополнительный уровень специальных корпоративных средств для удаленного управления, которые помогают увеличить время простоя и свести к минимуму требования к ИТ-поддержке.

Если вы не засчитаете себя в рядах специалистов в области разработки, дизайна, архитектуры или науки о данных, Surface Book 3, оснащенные графическими возможностями NVIDIA GeForce, скорее всего, будут отвечать вашим потребностям. И наоборот, если вы уже работаете или хотите присоединиться к профессии, которая требует высокоразвитых возможностей графики в переносном форм-факторе, который позволяет работать из любого места, Surface Book 3 с Quadro RTX 3000 заслуживает серьезного внимания. Дополнительные сведения можно найти в техническом Surface Book 3 Quadro RTX 3000.

Таблица 1: Дискретные GPUs на Surface Book 3

| GeForce GTX 1650 | GeForce GTX 1660 Ti | Quadro RTX 3000 | |

|---|---|---|---|

| Целевые пользователи | Геймеры, любители и создатели в Интернете | Геймеры, творческие специалисты и создатели в Интернете | Творческие специалисты, архитекторы, инженеры, разработчики, специалисты по данным |

| Рабочий процесс | Графический дизайн Фотография Видео | Графический дизайн Фотография Видео | Рабочий процесс с питанием от al Сертификация приложений Видео с высоким уровнем повторной записи Pro вещания Рабочий процесс с несколькими приложениями |

| Ключевые приложения | Adobe Creative Suite | Adobe Creative Suite | Adobe Creative Suite Autodesk AutoCAD Dassault Systemes SolidWorks |

| Ускорение GPU | Обработка видео и изображений | Обработка видео и изображений | Отслеживание лучей + AI + 6K видео Pro вещания Enterprise поддержки |

Таблица2. Технические характеристики GPU на Surface Book 3

Технические характеристики GPU на Surface Book 3

| GeForce GTX 1650 | GeForce GTX 1660 Ti | Quadro RTX 3000 | |

|---|---|---|---|

| Ядра обработки NVIDIA CUDA | 1024 | 1536 | 1920 |

| NVIDIA Tensor Cores | Нет | Нет | 240 |

| NVIDIA RT Cores | Нет | Нет | 30 |

| Память GPU | 4 ГБ | 6 ГБ | 6 ГБ |

| Пропускная способность памяти (GB/sec) | До 112 | До 288 | До 288 |

| Тип памяти | GDDR5 | GDDR6 | GDDR6 |

| Интерфейс памяти | 128-bit | 192-bit | 192-bit |

| Boost clock MHz | 1245 | 1425 | 1305 |

| Базовые часы (MHz) | 1020 | 1245 | 765 |

| Отслеживание лучей в режиме реального времени | Нет | Нет | Да |

| Ускорение оборудования ИИ | Нет | Нет | Да |

| Аппаратный коддер | Да | Да | Да |

| Драйвер готовности к игре (GRD) | Да 1 | Да 1 | Да 2 |

| Драйвер Studio (SD) | Да 1 | Да 1 | Да 1 |

| Оптимальный драйвер для Enterprise (ODE) | Нет | Нет | Да |

| Драйвер новых функций Quadro (QNF) | Нет | Нет | Да |

API Microsoft DirectX 12, API Vulkan, Open GL 4. 6 6 | Да | Да | Да |

| Защита цифрового контента с высокой пропускной способностью (HDCP) 2.2 | Да | Да | Да |

| Повышение GPU NVIDIA | Да | Да | Да |

- Рекомендуется

- Поддерживается

Оптимизация мощности и производительности Surface Book 3

Windows 10 включает режим saver батареи с ползунком производительности, который позволяет повысить производительность приложения (сдвинув его вправо) или сохранить время автономной работы (сдвинув его влево). Surface Book 3 реализует эту функцию алгоритмически для оптимизации мощности и производительности в следующих компонентах:

- Регистры энергоэффективности ЦП (технология смены скорости Intel) и другие параметры настройки SoC для максимальной эффективности.

- Fan Maximum RPM с четырьмя режимами: тихой, номинальной, производительной и максимальной.

- Крышки мощности процессора (PL1/PL2).

- Ограничения IA Turbo процессора.

По умолчанию, когда батарея опускается ниже 20 процентов, saver батареи регулирует параметры, чтобы продлить срок службы батареи. При подключении к мощности Surface Book 3 по умолчанию для параметров «Лучшая производительность», чтобы обеспечить работу приложений в режиме высокой производительности на вторичном GPU NVIDIA, присутствуют во всех системах i7 Surface Book 3.

Использование параметров по умолчанию рекомендуется для оптимальной производительности при использовании в качестве ноутбука или отсоединения в режиме планшета или студии. Вы можете получить доступ к saver батареи, выбрав значок батареи справа от панели задач.

Режим игры

Surface Book 3 включает новый режим игры, который автоматически выбирает максимальные параметры производительности при запуске.

Сейф Detach

Новые в Surface Book 3, приложения, включенные для Сейф Detach, позволяют отключиться во время использования GPU приложения. Для поддерживаемых приложений, таких как World of Warcraft, ваша работа перемещается в iGPU.

Для поддерживаемых приложений, таких как World of Warcraft, ваша работа перемещается в iGPU.

Изменение параметров приложения, чтобы всегда использовать определенный GPU

Вы можете переключаться между энергосберегаемой, но все еще способной встроенной графикой Intel и более мощным дискретным GPU NVIDIA и связать GPU с определенным приложением. По умолчанию Windows 10 автоматически выбирает соответствующий GPU, назначая графически требующие приложения дискретным GPU NVIDIA. В большинстве случаев нет необходимости вручную настраивать эти параметры. Однако если вы часто отсоединяем и повторно отсоединяем дисплей от базы клавиатуры при использовании графического приложения, обычно необходимо закрыть приложение до отсоединения. Чтобы включить непрерывное использование приложения, не закрывая его каждый раз, когда вы отсоедините или повторно прикрепите дисплей, вы можете назначить его интегрированному GPU, хотя и с некоторой потерей производительности графики.

В некоторых случаях Windows 10 может назначить графически требующим приложения iGPU; например, если приложение не полностью оптимизировано для гибридной графики. Чтобы исправить это, можно вручную назначить приложение дискретным GPU NVIDIA.

Чтобы исправить это, можно вручную назначить приложение дискретным GPU NVIDIA.

Настройка приложений с помощью настраиваемых параметров каждого GPU:

Перейдите Параметры > **** > системный дисплей и выберите графические Параметры.

- Для настольной Windows выберите классический обзор приложенийи > **** найдите ее.

- Для приложения UWP выберите универсальное приложение, а затем выберите приложение из выпадаемого списка.

Выберите Добавить, чтобы создать новую запись в списке для выбранной программы, выберите Параметры для открытия спецификаций графики, а затем выберите нужный вариант.

Чтобы проверить, какой GPU используется для каждого приложения, откройте диспетчер задач, выберите Performance и просмотреть столбец GPU Engine.

Приложение A: Surface Book 3 SKUs

| Display | Процессор | Графический процессор | ОЗУ | Storage |

|---|---|---|---|---|

| 13,5-дюймовый | Четырехъядерный 10-й gen Core i5-1035G7 | Intel Iris™ Plus Graphics | 16 LPDDR4x | 256 ГБ |

| 13,5-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA GeForce GTX 1650.  Max-Q Design с 4 ГБ графической памяти GDDR5 Max-Q Design с 4 ГБ графической памяти GDDR5 | 16 LPDDR4x | 256 ГБ |

| 13,5-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA GeForce GTX 1650. Max-Q Design с 4 ГБ графической памяти GDDR5 | 32 LPDDR4x | 512 ГБ |

| 13,5-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA GeForce GTX 1650. Max-Q Design с 4 ГБ графической памяти GDDR5 | 32 LPDDR4x | 1 ТБ |

| 15-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA GeForce GTX 1660 Ti. Max-Q Design с графической памятью GDDR6 с 6 ГБ | 16 LPDDR4x | 256 ГБ |

| 15-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA GeForce GTX 1660 Ti. Max-Q Design с графической памятью GDDR6 с 6 ГБ | 32 LPDDR4x | 512 ГБ |

| 15-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA GeForce GTX 1660 Ti.  Max-Q Design с графической памятью GDDR6 с 6 ГБ Max-Q Design с графической памятью GDDR6 с 6 ГБ | 32 LPDDR4x | 1 ТБ |

| 15-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA GeForce GTX 1660 Ti. Max-Q Design с графической памятью GDDR6 с 6 ГБ | 32 LPDDR4x | 2 ТБ |

| 15-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA Quadro RTX 3000. Max-Q Design с графической памятью GDDR6 с 6 ГБ | 32 LPDDR4x | 512 ГБ |

| 15-дюймовый | Четырехъядерный 10-й gen Core i7-1065G7 | Графика Intel Iris Plus NVIDIA Quadro RTX 3000. Max-Q Design с графической памятью GDDR6 с 6 ГБ | 32 LPDDR4x | 1 ТБ |

Примечание

2TB SSD доступен только в США: Surface Book 3 15″ с NVIDIA GTX 1660Ti

Сводка

Созданная для производительности, Surface Book 3 включает различные конфигурации GPU, оптимизированные для выполнения определенных рабочих нагрузок и требований к использованию. Интегрированный графический GPU Intel Iris функционирует как единственный GPU на устройстве начального уровня Core i5 и как вторичный GPU на всех остальных моделях. GeForce GTX 1650 имеет крупное обновление основного потокового мультипроцессора для более эффективного запуска сложной графики. Чем быстрее GeForce GTX 1660 Ti Surface Book 3 с дополнительными улучшениями производительности, тем лучше для потребителей, геймеров, живых стримеров и творческих специалистов. Quadro RTX 3000 открывает несколько ключевых функций для профессиональных пользователей: отрисовку трассировки лучей и ускорение ИИ, а также расширенные показатели графики и вычислений.

Интегрированный графический GPU Intel Iris функционирует как единственный GPU на устройстве начального уровня Core i5 и как вторичный GPU на всех остальных моделях. GeForce GTX 1650 имеет крупное обновление основного потокового мультипроцессора для более эффективного запуска сложной графики. Чем быстрее GeForce GTX 1660 Ti Surface Book 3 с дополнительными улучшениями производительности, тем лучше для потребителей, геймеров, живых стримеров и творческих специалистов. Quadro RTX 3000 открывает несколько ключевых функций для профессиональных пользователей: отрисовку трассировки лучей и ускорение ИИ, а также расширенные показатели графики и вычислений.

Подробнее

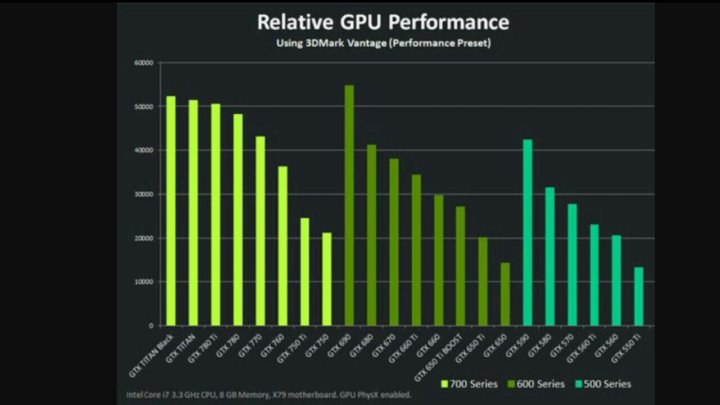

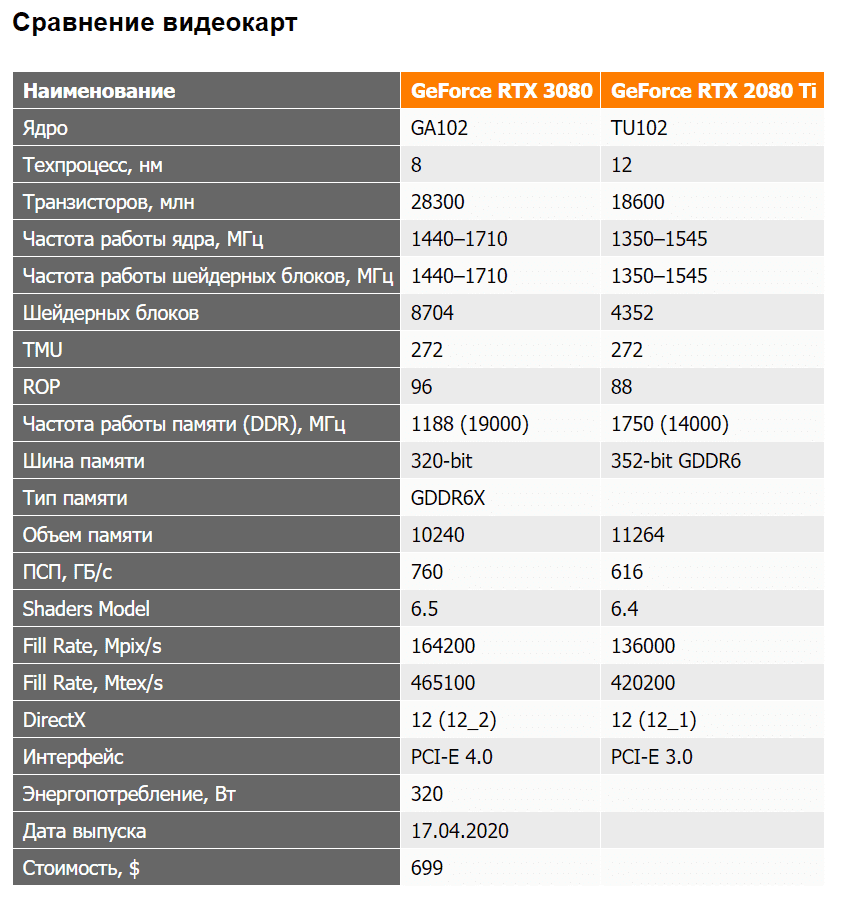

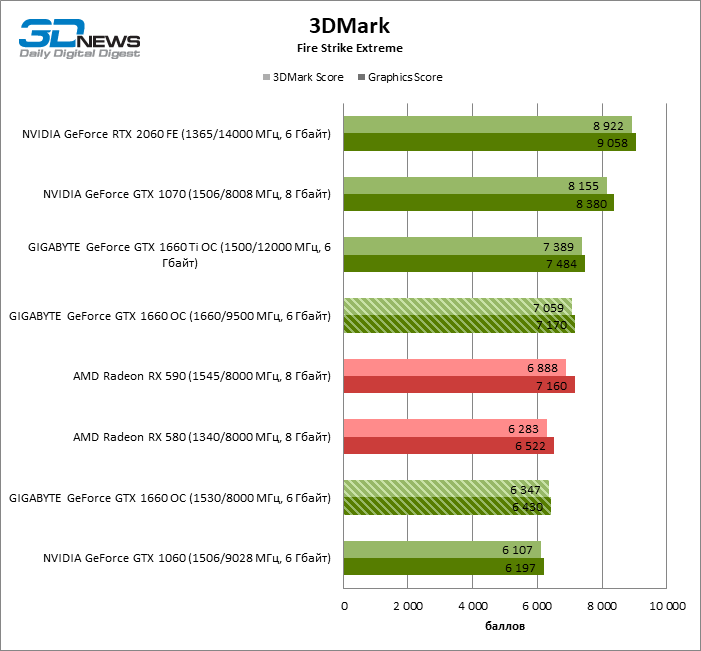

Сравнение архитектуры процессоров Nvidia Ampere и Turing [GPU]

Опубликовано 15.09.2020, 13:50 · Комментарии:15

Turing и Ampere — это две передовые технологии графических процессоров от Nvidia, используемые в их видеокартах серии RTX. Обе эти архитектуры предлагают значительное улучшение по сравнению с более старых версий Nvidia, которые включают в себя Volta и Pascal. Эти два новейших графических процессоров (Turing и Ampere) имеют некоторое сходство друг с другом.

Эти два новейших графических процессоров (Turing и Ampere) имеют некоторое сходство друг с другом.

Ampere является более новой из двух и используется в видеокартах Nvidia последнего поколения, включая RTX 30 Series, а Turing обслуживает видеокарты RTX 20 Series. Архитектура Ampere поставляется с некоторыми новыми функциями и улучшениями по сравнению с архитектурой Turing GPU. Итак, чтобы помочь вам узнать о существенных различиях между этими видами графических процессоров, здесь я провожу общее сравнение двух типов процессоров по важным параметрам.

Архитектура графического процессора Turing

Тьюринг — непосредственный преемник графического процессора Volta. Архитектура построена по 12-нм техпроцессу и поддерживает GDDR5, HBM2 и память GDDR6. Tensor GPU поставляется с ядрами CUDA, RT Core и тензорными ядрами в одном чипе GPU (за исключением карт серии GTX 16). Это первая архитектура, поддерживающая трассировку лучей в реальном времени, которая используется для создания реалистичных изображений, теней, отражений и других сложных световых эффектов./data/SS2_m_1024_A.png)

Более того, архитектура Тьюринга также поддерживает DLSS (Deep Learning Super Sampling), которая представляет собой технологию на основе искусственного интеллекта, использующую тензорные ядра для увеличения частоты кадров в играх без ущерба для качества изображения или графики. Однако следует отметить, что для использования преимуществ этих двух технологий игра также должна поддерживать их (трассировку лучей и DLSS). Архитектура Turing GPU обеспечивает увеличение производительности до 6 раз по сравнению со старой архитектурой Pascal GPU, что является большим шагом вперед.

Графические карты на базе архитектуры Turing GPU включают GeForce RTX 20 Series и GTX 16 Series. Однако видеокарты Turing серии GeForce GTX 16 не поставляются с ядрами RT и тензорными ядрами. Видеокарты серии GeForce RTX 20 также поддерживают VirtualLink через разъем USB Type-C для подключения гарнитуры VR следующего поколения через порт USB Type-C для получения потрясающих впечатлений от виртуальной реальности. Архитектура Turing GPU также используется в видеокартах для рабочих станций, включая Quadro RTX 4000, Quadro RTX 5000, Quadro RTX 6000 и Quadro RTX 8000.

Архитектура Turing GPU также используется в видеокартах для рабочих станций, включая Quadro RTX 4000, Quadro RTX 5000, Quadro RTX 6000 и Quadro RTX 8000.

Архитектура графического процессора Ampere

Ampere является преемником от графического процессора Turing. Он построен по 8-нм техпроцессу и поддерживает высокоскоростную память GDDR6, HBM2 и GDDR6X. Память GDDR6X в настоящее время является самой быстрой графической памятью, которая может достигать скорости до 21 Гбит/с и обеспечивать пропускную способность до 1 ТБ/с. Архитектура Ампер обеспечивает значительное улучшение по сравнению с Тюрингом и поставляется с 2 — го поколения RT ядер и 3 — го поколения тензорных сердечников.

Эти новые ядра RT и Tensor обеспечивают примерно в 2 раза пропускную способность или производительность по сравнению с ядрами RT и Tensor предыдущего поколения, используемыми в архитектуре Turing. Это означает, что вы получаете значительный прирост производительности в играх и других приложениях, если игра или приложение поддерживает технологии Ray Tracing и AI.

Архитектура Ampere теперь поддерживает стандарт PCIe Gen 4, что вдвое увеличивает пропускную способность интерфейса PCIe Gen3. Архитектура поддерживает CUDA версии 8.0 и включает 2 потоковых мультипроцессора FP32, что означает двойную производительность FP32 по сравнению с Turing. Архитектура графического процессора Ampere поддерживает NVLink 3.0 для увеличения вычислительной мощности системы, использующей более одного графического процессора. Архитектура Ampere обеспечивает повышение производительности на ватт до 1,9 раза по сравнению с архитектурой Turing.

Еще одним отличным дополнением к Ampere является поддержка HDMI 2.1, который поддерживает сверхвысокое разрешение и частоту обновления, которая составляет 8K при 60 Гц и 4K при 120 Гц. Он также поддерживает Dynamic HDR, а общая пропускная способность, поддерживаемая HDMI 2.1, составляет 48 Гбит/с.

RTX IO — это еще одна новая функция, представленная в архитектуре Ampere, которая может снизить накладные расходы на ввод-вывод ЦП и значительно сократить время загрузки игры за счет распаковки игровых текстур/данных внутри памяти графического процессора с помощью графического процессора. Эта функция работает вместе с Microsoft Windows DirectStorage API. Графические карты, использующие архитектуру графического процессора Ampere, — это видеокарты серии RTX 30, в том числе GeForce RTX 3090, RTX 3080, RTX 3070.

Эта функция работает вместе с Microsoft Windows DirectStorage API. Графические карты, использующие архитектуру графического процессора Ampere, — это видеокарты серии RTX 30, в том числе GeForce RTX 3090, RTX 3080, RTX 3070.

Сравнение архитектур Nvidia Ampere и GPU Turing

Быстрое и краткое сравнение архитектур графических процессоров Ampere и Turing от Nvidia.

| Архитектура GPU | Ampere | Turing |

| Производитель | Nvidia | Nvidia |

| Процесс изготовления | 8 нм (Samsung) | 12 нм (TSMC) |

| Версия CUDA | 8 | 7,5 |

| RT ядра | 2-е поколение | 1-е поколение |

| Тензорные ядра | 3-е поколение | 2-е поколение |

| Потоковые мультипроцессоры | 2x FP32 | 1x FP32 |

| DLSS | DLSS 2. 0 0 |

DLSS 1.0 |

| Поддержка памяти | HBM2, GDDR6X | GDDR6, GDDR5, HBM2 |

| Поддержка PCIe | PCIe Gen 4 | PCIe Gen 3 |

| Кодировщик NVIDIA (NVENC) | Gen 7 | Gen 7 |

| Декодер NVIDIA (NVDEC) | Gen 5 | Gen 4 |

| DirectX 12 Ultimate | да | да |

| VR технология | да | да |

| Поддержка нескольких GPU | NVLink 3.0 | NVLink 2.0 |

| Энергоэффективность | Лучше, чем Turing | Лучше, чем Volta |

| Видео порты | HDMI 2.1, DisplayPort 1.4a | HDMI 2.0b, DisplayPort 1.4a |

| Графические карты | RTX 30 серии | Серия RTX 20, серия GTX 16 |

| Приложения | Игры, домашний пк, искусственный интеллект (AI) | Игры, домашний пк, искусственный интеллект (AI) |

Заключение

Что ж, архитектура графического процессора Ampere предлагает значительные улучшения, когда дело доходит до трассировки лучей и DLSS, но даже когда эти функции не используются, прирост производительности в Ampere больше, чем у Turing. Другим значительным дополнением к Ampere является поддержка PCIe Gen 4, которая предлагает гораздо более высокую пропускную способность и может оказаться весьма полезной в будущем.

Другим значительным дополнением к Ampere является поддержка PCIe Gen 4, которая предлагает гораздо более высокую пропускную способность и может оказаться весьма полезной в будущем.

AMD vs Nvidia: что лучше?

Авторы данного обзора решили сравнить AMD и Nvidia, дабы выяснить – кто же станет безусловным чемпионом. Для самых заядлых геймеров данное соперничество является не менее важно, чем, скажем, соперничество между донецким «Шахтёром» и киевским «Динамо», между «Кока-кола» и «Пепси», между «Marvel» и «DC Comics». Кто делает лучшие процессоры: AMD или Nvidia? В нашем обществе существует несколько распространённых представлений о сильных и слабых сторонах каждого из этих брендов, и данное сравнение призвано проверить все эти точки зрения.

Информация о компаниях

AMD

- Изначально компания получила известность в качестве производителя вычислительных процессоров (CPU), однако, затем плотно вошла на рынок графических процессоров (GPU).

- Присутствует на рынках CPU и GPU, занимая на них вторые позиции, в то время как первые позиции на этих рынках занимают Intel и Nvidia соответственно.

- Выпускает превосходную продукцию в нижнем и среднем классах.

- Удаётся запускать высокопроизводительные приложения.

- Вырабатывает большее количество тепла, поскольку использует большие массивы памяти для повышения производительности.

Nvidia

- С первых дней своего существования занимается GPU и по сей день видеокарты Nvidia занимают первую позицию в данном секторе.

- Заметное присутствие на рынке GPU и небольшое присутствие на рынке CPU.

- Выпускает отличные графические процессоры среднего и высокого класса.

- Создала единственный GPU, который действительно способен запускать высокопроизводительные приложения – такие, как игры 2K и 4K.

- Генерирует меньшую мощность и потребляет меньшее количество энергии.

Цена

В сообществе геймеров принято считать, что AMD предлагает лучшее соотношение цены и качества своих продуктов, чем Nvidia. И хотя в целом это справедливая оценка, на самом деле всё обстоит немного сложнее. В перечне основных моделей процессоры Nvidia часто стоят значительно дороже, чем их аналоги более раннего поколения. Но отчасти это можно объяснить тем фактом, что Nvidia совсем недавно сократила своё новое поколение Turing. Однако, трудно игнорировать тот факт, что RTX 2080 Ti стоит почти вдвое дороже GTX 1080 Ti, или то, что стандартный RTX 2080 стоит примерно 800 долларов.

Впрочем, на базовой конференции Nvidia прозвучало обещание компании снизить цены, так что вскоре всё может измениться. И Nvidia уже предлагает процессоры CPU стоимостью всего в 150 долларов. На данный момент AMD предлагает значительно более выгодные цены на большинство моделей, но ситуация может измениться, когда на рынке появится их процессор Navi следующего поколения, а Nvidia внесёт некоторые изменения в свою ценовую политику. Что касается высокопроизводительных игровых видеокарт, то здесь расхождение становится менее заметным. Высокопроизводительный AMD Radeon VII стоит всего на 100 долларов дешевле, чем его аналог от Nvidia несмотря на то, что он не совсем соответствует тем же ключевым параметрам.

Что касается высокопроизводительных игровых видеокарт, то здесь расхождение становится менее заметным. Высокопроизводительный AMD Radeon VII стоит всего на 100 долларов дешевле, чем его аналог от Nvidia несмотря на то, что он не совсем соответствует тем же ключевым параметрам.

Производительность

Nvidia Corporation может ставить премиальные цены на свои игровые видеокарты, но многие утверждают, что это их заслуженное право. Лучшие графические процессоры от Nvidia впечатляют и завораживают. RT 2080 Ti может стоить почти целое состояние, но на рынке более нет ничего подобного! Память GDDR6 объёмом 11 ГБ сочетается с новой трассировкой лучей и выборкой, управляемой искусственным интеллектом (подробнее об этом речь пойдёт ниже), и это делает её очень удобной для игр многих будущих поколений. И хотя Radeon VII выглядит в значительной степени сопоставимым с точки зрения своих характеристик, игроманы определённо заметят разницу, когда начнут использовать DirectX 12.

В общем, если говорить кратко, то процессоры Nvidia просто более мощные, особенно для игр. Они лучше работают в многозадачном режиме, способны выполнять исключительно сложные задачи и справляются с этим при значительно меньшем энергопотреблении. И хотя AMD предлагает больший объём памяти в линейке процессоров младших классов, это также означает, что они быстрее перегреваются, поэтому они просто не могут конкурировать друг с другом на более высоком уровне. И, несмотря на то, что разрыв в мощности постепенно сокращается, Nvidia по-прежнему имеет явное преимущество по этому показателю.

Победитель: NvidiaАдаптивная синхронизация

И Nvidia, и AMD любят использовать множество модных технологий, однако пользователям не следует упускать из виду адаптивную синхронизацию, представленную соответственно технологиями G-Sync и FreeSync. Данные технологии максимально используют частоту обновления монитора, чтобы уменьшить разрывы, обеспечить постоянство частоты кадров и, в целом, просто обеспечить более приятный игровой процесс. И поскольку две упомянутые выше технологии совместимы лишь с картами соответствующих производителей, разницу следует учитывать.

И поскольку две упомянутые выше технологии совместимы лишь с картами соответствующих производителей, разницу следует учитывать.

Здесь мнения пользователей и экспертов расходятся, поскольку две компании достигли совершенно различных результатов при реализации этих технологий. Мониторы G-Sync работают исключительно с мониторами, поддерживающими G-Sync, и это считается премиальной функцией, часто доступной лишь в более дорогих моделях. FreeSync, напротив, имеет более высокую совместимость и будет работать с большинством мониторов стоимостью от 130 долларов и выше. Но, как и в целом обстоит дело с этими двумя компаниями, технология AMD жертвует мощностью ради доступности. G-Sync – это лучший вариант, а более высокие стандарты, применяемые к мониторам G-Sync, означают, что они, как правило, действительно приносят в адаптивную синхронизацию всё, чего она стоит.

Победитель: ничья в зависимости от того, сколько денег вы готовы потратить.Программное обеспечение