Видеокарта NVIDIA GeForce GTX TITAN

| Наименование: | NVIDIA GeForce GTX TITAN |

| Серия: | GeForce 700 |

| Архитектура GPU: | Kepler |

| Модель GPU: | GK110-400 |

| Ядер CUDA: | 2688 |

| Базовая тактовая частота (Boost): | 837 MHz (876 MHz) |

| Быстродействие памяти: | 6000 Мбит/с |

| Память: | 6 Gb GDDR5 384-bit |

Видеокарта NVIDIA GeForce GTX TITAN создана на основе 28 nm техпроцесса и основанная на графическом процессоре GK110-400. Карта поддерживает Directx 12 (API). NVIDIA разместила 6144 мегабайт памяти GDDR5, которая подключена с использованием 384-bit интерфейса памяти.

Графический процессор работает на частоте 837 MHz, которую можно повысить до 876 MHz. Количество ядер CUDA составляет 2688, с быстродействием 6000 Мбит/с.

Энергопотребление видеокарты составляет 250 Вт, а рекомендуемый блок питания на 600 Вт.

NVIDIA GeForce GTX TITAN поддерживает Microsoft DirectX 12 (API) и OpenGL 4.5.

Характеристики видеокарты NVIDIA GeForce GTX TITAN

| Характеристики GPU: | |

|---|---|

| Модель: | NVIDIA GeForce GTX TITAN |

| Серия: | GeForce 700 |

| Модель GPU: | GK110-400 |

| Архитектура: | Kepler |

| Техпроцесс: | 28 nm |

| Ядер CUDA: | 2688 |

| Графических процессоров (GPC): | 5 |

| Потоковых мультипроцессоров (SMs): | 14 |

| Текстурных блоков (TMUs): | 224 |

| Базовая тактовая частота: | 837 MHz |

| Тактовая частота с ускорением (Boost): | 876 MHz |

| Количество транзисторов: | 7.1 миллиарда |

| Характеристики памяти: | |

|---|---|

| Объем памяти: | 6 Gb |

| Тип памяти: | GDDR5 |

| Шина памяти: | 384-bit |

| Быстродействие памяти: | 6000 Mbps (6 Gbps) |

| Скорость заполнения текстур: | 187.5 GTexel/s |

| Технологии и возможности: | |

|---|---|

| CUDA: | Да |

| Ansel: | Да |

| SLI: | Да |

| G-Sync: | Да |

| V-Sync: | Да |

| PhysX: | Да |

| 3D Vision: | Да |

| GPU Boost: | 2.0 |

| DirectX: | 12 (API) |

| Vulkan API: | Да |

| OpenGL: | 4.5 |

| Шина: | PCIe 3.0 |

| Поддержка ОС: | Microsoft Windows 7-10, Linux, FreeBSDx86 |

| Поддержка дисплеев: | |

|---|---|

| Максимальное цифровое разрешение: | 3840×2160@30Гц или 4096×2160@24Гц через HDMI. 4096×2160@60Гц |

| Максимальное VGA разрешение: | 2048×1536 |

| Стандартные разъемы: | Dual Link DVI-I, Dual Link DVI-D, HDMI, DisplayPort |

| Поддержка нескольких мониторов: | Да |

| HDCP: | Да |

| HDMI: | Да |

| Аудио вход для HDMI: | Internal |

| Тепловые характеристики: | |

|---|---|

| Максимальная температура GPU: | 95 ℃ |

| Потребление энергии (TDP): | 250 Вт |

| Рекомендованные требования по питанию: | 600 Вт |

| Дополнительные разъемы питания: | 6-pin + 8-pin |

| Размеры видеокарты: | |

|---|---|

| Высота: | 10,16 см |

| Длина: | 26,67 см |

| Ширина: | 2 слота |

Обратите внимание: : в таблице представлены эталонные характеристики видеокарты, они могут отличаться у разных производителей.

| Скачать драйверы, для видеокарты NVIDIA GeForce GTX TITAN: | ||||

|---|---|---|---|---|

| Операционная система | Версия | Тип | Хеш | |

| Windows 10 64-bit | 431.36 WHQLНовый | Стандарт | Скачать | MD5 |

| Windows 10 64-bit | 431.36 WHQLНовый | DCH | Скачать | MD5 |

| Windows 7, 8.1, 8 64-bit | 431.36 WHQLНовый | Стандарт | Скачать | MD5 |

| Windows 10 32-bit | 391.35 WHQLУстарел | Стандарт | Скачать | MD5 |

| Информация о драйвере: | ||||

| Язык драйвера: | Русский | |||

| Опубликовано: | 09.07.2019 | |||

| Информация о драйвере: | Release Notes (PDF) | |||

| HD Audio Driver: | 1.3.38.16 | |||

| NVIDIA PhysX System Software: | 9.19.0218 | |||

| GeForce Experience: | 3.19.0.107 | |||

| Набор инструментов CUDA: | 10.1 | |||

| для Windows XP: | ||||

| для Windows XP: 32-bit | 340.52 WHQLНовый | Стандарт | Скачать | MD5 |

| для Windows XP: 64-bit | 340.52 WHQLНовый | Стандарт | Скачать | MD5 |

| Информация о драйвере: | ||||

| Язык драйвера: | Русский | |||

| Опубликовано: | 29.04.2014 | |||

| Размер: | 220 Мб | |||

| Информация о драйвере: | Release Notes (PDF) | |||

Или воспользуйтесь программой GeForce Experience — она автоматически подберет необходимый драйвер для Вашей видеокарты.

Скачивание драйвера для видеокарты NVIDIA GeForce GTX TITAN Производится с официального сайта!

Видеообзоры видеокарты NVIDIA GeForce GTX TITAN:

Администрация сайта может не разделять мнения авторов видеообзоров!

| Частые вопросы и ответы по видеокарте NVIDIA GeForce GTX TITAN: | |

|---|---|

| Вопрос: Какая это серия у видеокарты? | Ответ: GeForce 700 |

| Вопрос: Какой DirectX поддерживает? | Ответ: Видеокарта поддерживает DirectX 12 (API) |

| Вопрос: Какое энергопотребление у видеокарты? | Ответ: Максимальное энергопотребление составляет 250 Вт |

| Вопрос: Какой блок питания нужен для видеокарты? | Ответ: Рекомендуемый БП на 600 Вт |

| Вопрос: Есть ли разъемы дополнительного питания? | Ответ: 6-pin + 8-pin |

| Вопрос: Какая максимально допустимая температура? | Ответ: Не более 95 ℃ |

| Вопрос: Где скачать драйвер? | Ответ: Драйвер для geforce GTX ТИТАН |

Архитектура Kepler

Видеокарты на 6Gbgeforce-gtx.com

Обзор и тестирование видеокарты Nvidia GeForce GTX Titan X: навстречу 4K

А – длина печатной платы, без учета системы охлаждения и планки портов видеовыходов.

В – ширина печатной платы, без учета контактов PCI-E и системы охлаждения.

С – высота от горизонтальной плоскости печатной платы до уровня верхней поверхности системы охлаждения.

D – диаметр вентилятора/ов по внешнему радиусу.

А1 – длина печатной платы, с учетом системы охлаждения (если выходит за пределы печатной платы) до планки портов видеовыходов.

В1 – ширина печатной платы, без учета контактов PCI-E, но с замером системы охлаждения (если выходит за пределы печатной платы).

С1 – высота, с учетом задней пластины (если есть)/винтов крепления радиатора до уровня верхней поверхности системы охлаждения. Если она ниже высоты задней планки портов видеовыходов, то измеряется высота до верхней точки планки.

Количество и расположение портов не изменилось. Для GeForce GTX 970/ GTX 980/ GTX Titan X соблюден единый стандарт: три DisplayPort, по одному HDMI и DVI. Суммарное количество независимых источников – три. Несмотря на то, что печатная плата позволяет подключить большее число мониторов, для объединения их в единое рабочее пространство будет доступно лишь три видеовыхода.

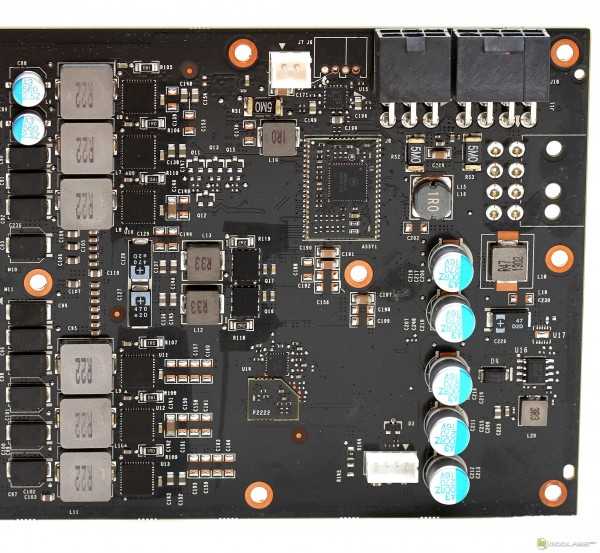

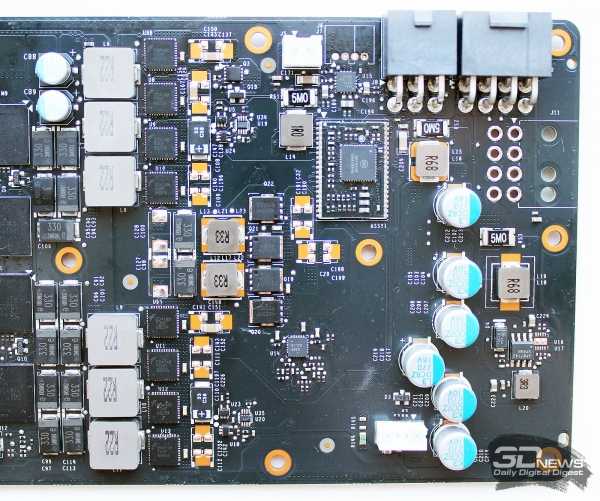

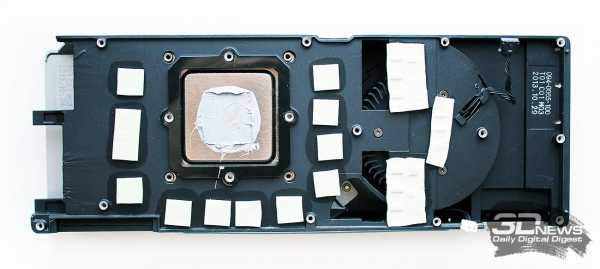

Печатная плата

Внешне GeForce GTX Titan X мало чем выделяется на фоне своих же братьев GeForce GTX 980 или GTX 780 Ti. Печатная плата по-прежнему частично использует ранние наработки, в том числе отдельный ШИМ-контроллер на выносной плате и комбинацию из 6+2 фазы питания GPU.

В компании Nvidia ранее заявляли, что прислушались к жалобам пользователей по поводу посторонних звуков под нагрузкой и установили больше емкостей, а также другие катушки. Но на практике перед нами абсолютно типичные конденсаторы и катушки, ровно те же, что были на печатной плате GeForce GTX 980 или GTX 780 Ti. Не думаю, что одни только слова смогут избавить видеокарту от писка под нагрузкой.

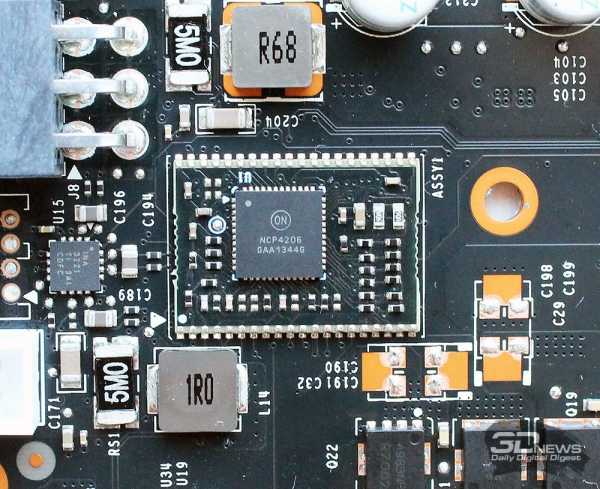

Аналогичным образом с предыдущих решений переехал и ШИМ-контроллер, оставшись тем же самым – NCP4206. Им легко управлять сторонними утилитами. Но воспользоваться всем диапазоном вольтмода затруднительно из-за ограничения энергопотребления видеокарты, задаваемого разработчиками Nvidia.

Есть и хорошая новость – стандартное TDP 250 Вт теперь легко увеличивается до 275 Вт под длительной нагрузкой. В пике видеокарта иногда превышает его, но ненадолго.

Объем памяти на GeForce GTX Titan X колоссальный – 12 Гбайт, причем микросхемы расположены с обеих сторон. Номинальные частоты видеокарты составляют 1000 МГц для графического процессора (GPU Boost до 1075 МГц) и 1750 МГц для памяти. На практике GPU часто достигает частот 1177-1200 МГц.

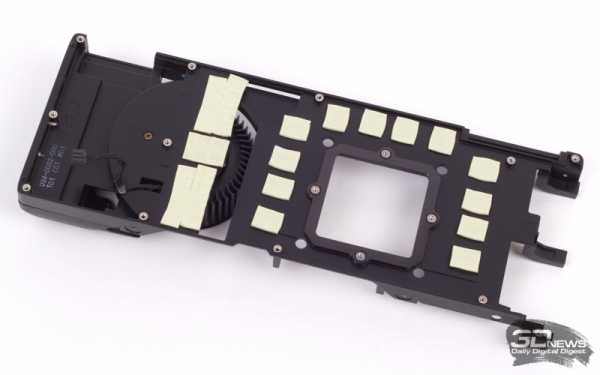

Система охлаждения

Вопреки слухам внутренняя конструкция системы охлаждения позаимствована у GeForce GTX 780 Ti.

Внутри вместо простых тепловых трубок использована испарительная камера, поскольку лишь она в силах передать большое количество тепла на ребра радиатора.

Основной теплорассеиватель не спаян с радиатором системы охлаждения и памяти. Благодаря этому есть возможность установить отдельный водоблок.

Боковая надпись «GeForce GTX» подсвечивается зеленым светодиодом, которым можно управлять через отдельное приложение. На выбор предлагается три режима: выключено, горит или плавно затухающая подсветка. Многие пользователи рассчитывали увидеть подсветку вентилятора, как на демонстрационных слайдах, но, увы, это только рендер и не более того.

Видеокарта GeForce GTX Titan X — характеристики, отзывы, цены — МИР NVIDIA

Видеоускоритель GeForce GTX Titan X в настоящее время (апрель 2015 года) является самым технологически совершенным в мире. Он обладает беспрецедентной производительностью, не имеющей аналогов в мире. Видеокарта Titan X предназначена для профессиональных и опытных геймеров, а также для энтузиастов PC. Плата построена на базе новой архитектуры Maxwell от компании NVIDIA, которая характеризуется удвоенной, по сравнению с прошлым поколением GPU Kepler, производительностью и невероятной энергоэффективностью.

Видеокарта GeForce GTX Titan X оснащена графическим процессором GM200, в котором включены абсолютно все 3072 вычислительных ядра CUDA, что является максимальной величиной для модельного ряда GeForce GTX 900.

Инновационный графический процессор GM200 обладает рядом впечатляющих игровых технологий, которые как достались по наследству от предыдущих поколений ускорителей, так и были разработаны инженерами NVIDIA с нуля. Наряду с известными технологиями поддержки 3D дисплеев 3D Vision, адаптивной синхронизации G-Sync и алгоритмами сглаживания MSAA и TXAA, в видеокартах семейства GeForce GTX 900 появилась технология многокадрового сглаживания (MFAA), гарантирующая прирост производительности на 30%; метод сглаживания с использованием сверхвысокого разрешение DSR; а также воксельная глобальная иллюминация (VXGI), которая ускоряет эффекты динамического освещения для обеспечения захватывающего игрового процесса кинематографического качества.

Данный ускоритель, как и прочие карты модельного ряда, получил обновлённую технологию автоматического разгона NVIDIA GPU Boost 2.0, которая отслеживает работу видеокарты, ещё эффективней управляя температурой GPU, повышением тактовой частоты процессора и напряжением, что позволяет добиться максимальной производительности GPU.

В продукт внедрена технология адаптивной синхронизации NVIDIA Adaptive Vertical Sync. Эта технология включается при высокой частоте смены кадров для устранения разрывов изображения, а при низкой — отключается, чтобы свести дрожание кадров к минимуму.

Разработчик гарантирует полноценную работу видеокарты с новым API Microsoft DirectX 12, который позволяет значительно снизить нагрузку на центральный процессор и ускорить рендер изображений.

В целом, новый ускоритель является идеальным решением для игр в сверхвысоком разрешении UHD 4K на максимальных настройках качества. Он также обеспечивает достаточную производительность в набирающих популярность системах виртуальной реальности.

nvworld.ru

NVIDIA представила видеокарту GeForce GTX TITAN

Компания NVIDIA представила новый флагман графической линейки – GeForce GTX TITAN. На этот раз в ход идет тяжелая артиллерия. Видеокарта основана на процессоре GK110, который ранее использовался только для профессиональных ускорителей Tesla. Под натиском самых требовательных энтузиастов, пришло время оптимизировать решение с максимальной вычислительной мощностью для нужд любителей поиграть в режимах с высокими разрешениями и запредельными настройками качества.

Даже судя по названию, GeForce GTX TITAN стоит особняком в линейке графических решений NVIDIA. Чтобы подчеркнуть особый статус устройства, для адаптера не используется традиционный числовой индекс, отражающий позицию в актуальной серии видеокарт. Имя «TITAN» имеет свою небольшую, но весьма любопытную предысторию.

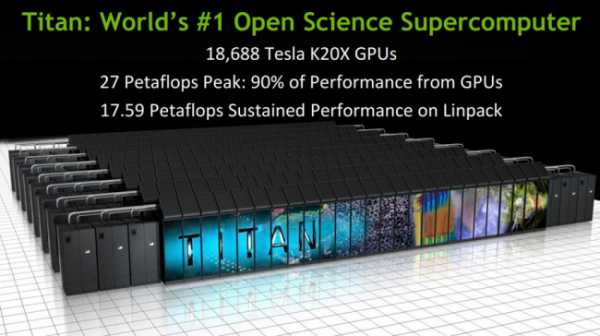

Ноябрьский список суперкомпьютеров TOP500 возглавила система с названием Titan, созданная компанией Cray для Окриджской Национальной Лаборатории (Oak Ridge National Laboratory). Эта платформа продемонстрировала рекордную пиковую производительность на уровне 27 петафлопс и порядка 17,5 петафлопс в тесте Linpack. В достижении подобных показателей немалая заслуга Tesla K20x – топовых вычислителей NVIDIA, основанных на графических процессорах GK110. Учитывая то, что для GeForce GTX TITAN используется тот же GPU, название для новой видеокарты было предопределено.

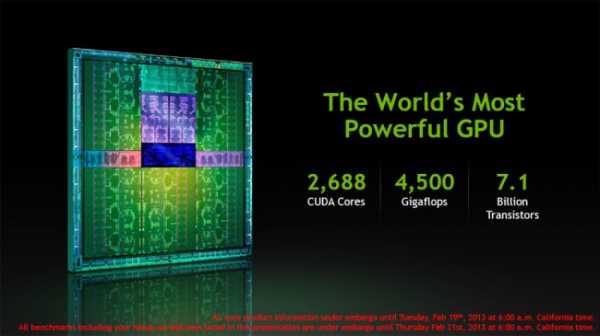

Для GeForce GTX TITAN впервые используется процессор GK110 с архитектурой Kepler, который ранее применялся только для специализированных вычислителей. Чип содержит 7,1 млрд. транзисторов и производится по 28-нанометровому техпроцессу.

Чип содержит 5 графических вычислительных кластеров (GPC), которые суммарно включают 2688 CUDA-ядер. При этом GK110 имеет 224 текстурных модуля, 48 блоков растеризации (ROP) и 1,5 МБ кеш-памяти L2. В количественном выражении это существенно больше, чем у GeForce GTX 680.

| GeForce GTX TITAN | GeForce GTX 680 | GeForce GTX 580 | Radeon HD 7970 | |

| Наименование кристалла | GK110 | GK104 | GF110 | Tahiti XT |

| Техпроцесс производства, нм | 28 | 28 | 40 | 28 |

| Площадь кристалла, мм² | ~550 | 294 | 520 | 365 |

| Количество транзисторов, млрд | 7,1 | 3,54 | 3 | 4,31 |

| Тактовая частота GPU, МГц | 836/876 | 1006/1058 | 772 | 925 |

| Количество потоковых процессоров | 2688 | 1536 | 512 | 2048 |

| Количество текстурных блоков | 224 | 128 | 64 | 128 |

| Количество блоков растеризации | 48 | 32 | 48 | 32 |

| Память (тип, объем), МБ | GDDR5, 6144 | GDDR5, 2048 | GDDR5, 1536/3072 | GDDR5, 3072 |

| Шина памяти, бит | 384 | 256 | 384 | 384 |

| Эффективная тактовая частота памяти, МГц | 6008 | 6008 | 4008 | 5500 |

| Пропускная способность памяти, ГБ/c | 288,4 | 192 | 192 | 264 |

| Энергопотребление, Вт | 250 | 195 | 244 | 250 |

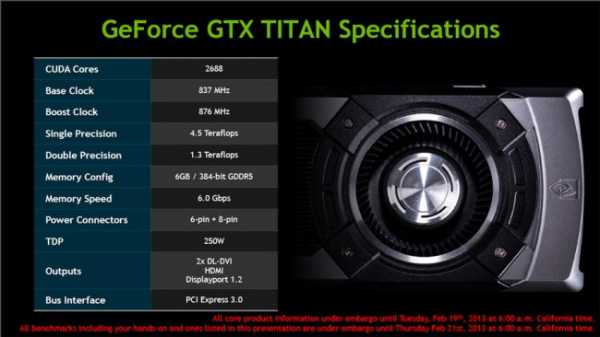

GPU имеет сравнительно невысокую базовую частоту – 836 МГц. При этом среднее значение после динамического ускорения (Boost Clock) обозначено на уровне 876 МГц.

GeForce GTX TITAN получил 6 ГБ памяти, при этом для передачи данных используется 384-битовая шина. С учетом того, что в данном случае применяется GDDR5, а ее эффективная тактовая частота составляет 6008 МГц, итоговая пропускная способность подсистемы памяти – 288,4 ГБ/c. Это рекордное значение, которое до этого момента принадлежало Radeon HD 7970 с 264 ГБ/c.

Теоретическая производительность GTX TITAN составляет 4,5 терафлопс, тогда как в случае с вычислениями двойной точности – 1,3 терафлопс.

Для подключения дополнительного питания используется два разъема – 6- и 8-контактный. Заявленный уровень энергопотребления составляет 250 Вт. В целом показатель довольно ожидаемый, учитывая то, что для GTX 680 уровень TDP составляет 195 Вт, а у двухчиповой GTX 690 – 300 Вт. Что касается требований к блоку питания, то производитель рекомендует использовать в системе с GeForce GTX TITAN модель БП мощностью от 600 Вт.

Видеокарта имеет два разъема SLI, что позволяет создавать конфигурации с тремя адаптерами в одной системе – 3-Way SLI.

GeForce GTX TITAN выглядит очень эффектно. Адаптер выполнен в едином стиле c двухчиповым GeForce GTX 690, дизайн которого многим пришелся по душе, в том числе и нам.

Для внешнего защитного кожуха используется комбинация хромированного алюминия и пластика. Винтовое крепление элементов добавляет баллов за оформление устройства. В центральной части адаптера расположено поликарбонатное окно, за которым просматриваются радиаторные пластины кулера.

Основу системы охлаждения составляет массивная испарительная камера, площадь рассеивания которой значительно увеличивает кассета алюминиевых пластин. Производитель отмечает, что в данном случае был использован очень эффективный термоинтерфейс японского производителя Shin-Etsu, который позволил существенно улучшить передачу тепла от кристалла к испарительной камере. Для охлаждения чипов памяти и силовых элементов используется массивная алюминиевая пластина.

Конструкция продувается вентилятором центробежного типа. В данном случае большая часть нагретого воздуха будет выводиться за пределы системного блока.

Как и у двухчипового собрата, на верхней кромке TITAN имеется логотип «GeForce GTX», который подсвечивается во время работы. При этом интенсивность индикатора регулируется программно, есть возможность настроить режим, когда яркость свечения будет изменяться в зависимости от текущей нагрузки видеокарты.

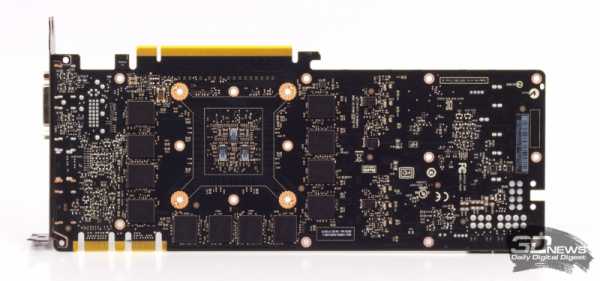

Референсная печатная плата имеет длину 265 мм. В центральной части расположен графический процессор GK110. Отметим, что чип не имеет теплораспределительной защитной крышки, потому монтировать альтернативные СО нужно будет довольно аккуратно, чтобы избежать сколов кристалла. Вокруг GPU расположены 12 микросхем памяти, такое же количество чипов размещено с обратной стороны PCB. Силовая подсистема выполнена по восьмифазной схеме (6+2), шесть из них отвечают за питание графического процессора, еще две выделены на нужды ОЗУ. В цепи используются конденсаторы с танталовыми сердечниками.

Разъемы для подключения дополнительного питания размещены у верхней кромки, потому подсоединение силовых кабелей не будет увеличивать общую длину конструкции. На печатной плате отчетливо видно посадочное место для еще одного 8-контактного коннектора.

Для подключения устройств отображения на интерфейсной панели предусмотрено четыре видеовыхода: пара DVI (Dual-Link), а также полноформатные DisplayPort и HDMI.

На начальном этапе все видеокарты GeForce GTX TITAN будут основаны на референсном дизайне, отличаясь комплектацией, прикладным ПО и некоторыми параметрами устройств.

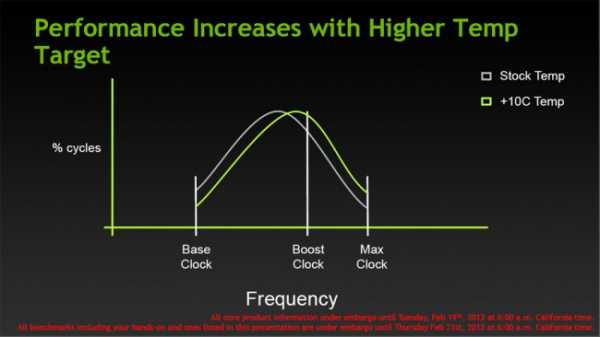

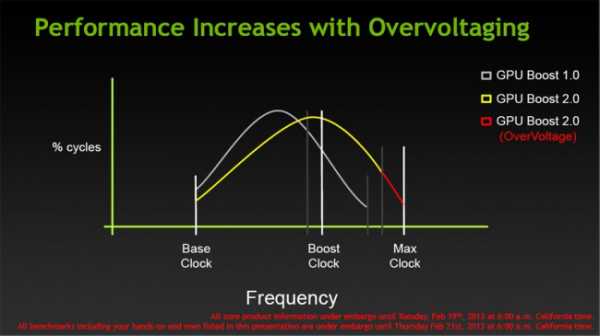

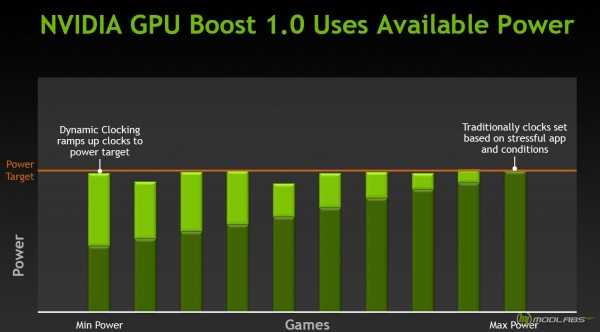

GPU Boost 2.0

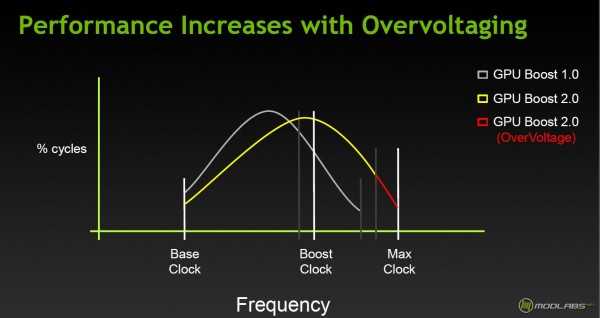

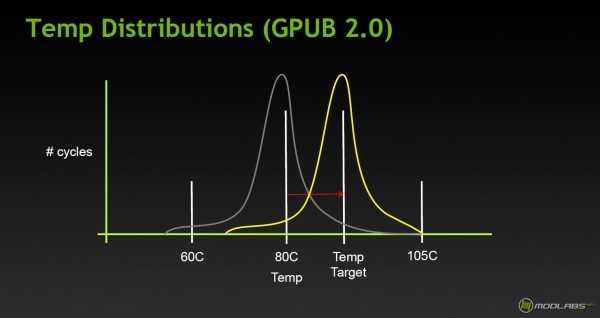

Среди интересных технических решений, которые получил GeForce GTX TITAN, стоит отметить усовершенствованную технологию динамического ускорения GPU Boost 2.0. В работе механизма авторазгона первого поколения, отправной точкой для повышения тактовой частоты был уровень энергопотребления видеокарты (Power Target). Однако такой метод является не самым эффективным в плане использования потенциала устройства. Теперь же ключевым параметром становится температура графического чипа (Temperature Target).

GeForce GTX TITAN сможет в некоторых рамках повышать частоту GPU и напряжение питания до тех пор, пока GPU не прогреется до определенной температуры. Заданное значение по умолчанию – 80 С.

При этом оно может изменяться пользователем (предположительно речь идет о +10С). При таком подходе улучшенное охлаждение видеокарты позволит добиться более высоких результатов.

Кроме того, в случае с GTX TITAN расширится диапазон допустимых рабочих напряжений. В штатном режиме он задан NVIDIA и находится в рамках, позволяющих гарантировать долгосрочную работу адаптера. Если вы готовы рисковать ради получения максимальной производительности, то такая возможность появится. Функция OverVoltage

Однако наличие такой возможности – уже прерогатива производителя видеокарты, который может активировать или отключить такую функцию на уровне VBIOS.

Для ценителей «бесшовной» картинки в играх, которую обеспечивает активация Vsync, NVIDIA приготовила сюрприз. Если ранее в подобном режиме частота смены кадров составляла 60 кадров/c, вне зависимости от того, какую производительность может обеспечить графическая карта, то вместе с GPU Boost 2.0 разработчики предлагают расширить данную границу до 80 кадров/c, воспользовавшись функцией Display Overclocking.

Для «разгона пикселей» понадобится воспользоваться утилитами производителей видеокарт. По словам NVIDIA, не все мониторы способны обеспечить такую частоту обновления, потому пользователям здесь придется поэкспериментировать. Будем надеяться, что количество подходящих моделей не ограничится 3D-мониторами со штатными 120 Гц.

Производительность

NVIDIA решила растянуть удовольствие анонса GeForce GTX TITAN, сохранив на несколько дней информацию о производительности, которая официально будет обнародована лишь 21 февраля. Очевидно, что GTX TITAN будет заметно производительнее GeForce GTX 680 и одночипового решения от основного конкурента – Radeon HD 7970 GHz Edition. Вопрос лишь в том, насколько существенной будет разница.

Если же сравнивать возможности GTX TITAN c таковыми для двухчипового GTX 690, то последний все еще может удивлять, все же пара GK104 – это гремучая смесь, однако, в случае мультиадаптерных конфигураций все не так однозначно. По мнению NVIDIA, конфигурация «ПК мечты» заядлого игромана теперь должна выглядеть примерно так.

После анонса GeForce GTX TITAN двухчиповая видеокарта GeForce GTX 690 остается в строю. По мнению разработчика, это востребованное решение для владельцев мониторов с большой диагональю и разрешением. Тогда как адаптер на GK110 предпочтительнее для решений с несколькими экранами и условий, когда игра не позволяет в полной мере использовать ресурсы двух GPU.

Цена

Если говорить о цене новинки, то NVIDIA в полной мере решила использовать ситуацию на рынке. Предлагая безальтернативное решение, компания рассчитывает получить за него соответствующее вознаграждение. Рекомендованная стоимость GeForce GTX TITAN для рынка США составляет $999. Для Украины ценник еще более впечатляющий – 9190 грн. Поставки видеокарт начнутся с 4 марта, в числе партнеров, которые первыми смогут предложить новые видеокарты с GK110 – ASUS, Gigabyte, Palit и ZOTAC.

itc.ua

Обзор и тестирование NVIDIA GeForce GTX TITAN X: избиение младенцев / Видеокарты

Появление крупного GPU на базе архитектуры Maxwell было неизбежно, вопрос только в том, когда это произойдет и в какой форме. В итоге оправдалось предположение, что GM200 повторит путь своего аналога из семейства Kepler — GK110, дебютировав в составе ускорителя под маркой TITAN.

NVIDIA GeForce GTX TITAN X

Времени на тестирование новой видеокарты в этот раз было крайне мало, поэтому обзор будет сжатым. Отбросив необязательные рассуждения, перейдем сразу к делу. Архитектура Maxwell, по сравнению с Kepler, характеризуется упрощенным и оптимизированным строением потоковых мультипроцессоров (SMM), что позволило радикально уменьшить площадь SMM, сохранив 90% прежней производительности. Кроме того, GM200 принадлежит ко второй итерации архитектуры Maxwell, как и выпущенные ранее чипы GM204 (GeForce GTX 970/980) и GM206 (GeForce GTX 960). А следовательно, обладает более производительным геометрическим движком PolyMorph Engine версии 3.0 и поддерживает на уровне «железа» некоторые вычислительные функции, которые, вероятно, войдут в новый feature level Direct3D 12, а также необходимы для аппаратного ускорения технологии глобального освещения VXGI, разработанной NVIDIA. За более подробным описанием архитектуры Maxwell первого и второго поколения отсылаем читателей к обзорам GeForce GTX 750 Ti и GeForce GTX 980.

Блок-схема графического процессора NVIDIA GM200

Качественно графический процессор GM200 и более младшие GPU в линейке не отличаются друг от друга, за исключением того, что только GM206 имеет выделенный блок декодирования видео, сжатого по стандарту H.265 (HEVC). Различия сугубо количественные. GM200 включает беспрецедентное число транзисторов — 8 млрд, поэтому вычислительных блоков в нем в полтора-два раза больше, чем в GM204 (в зависимости от того, какие именно считать). Кроме того, вернулась в строй 384-битная шина памяти. По сравнению с чипом GK110 новый флагманский GPU не столь устрашающе могуч, но, к примеру, число ROP здесь вдвое больше, что делает GM200 отлично подготовленным к 4К-разрешению.

В плане поддержки вычислений двойной точности GM200 ничем не отличается от GM204. Каждый SMX содержит только четыре ядра CUDA, совместимых с FP64, поэтому совокупная производительность при такой нагрузке составляет 1/32 от FP32.

|  | |

⇡#Технические характеристики, цена

В TITAN X используется наиболее мощная версия ядра GM200 с полным набором активных вычислительных блоков. Базовая частота GPU составляет 1000 МГц, Boost Clock — 1076 МГц. Память работает на стандартной для продуктов на базе Maxwell частоте 7012 МГц. А вот объем невиданный для игровых видеокарт — 12 Гбайт (а TITAN X — это в первую очередь игровая видеокарта, по крайней мере до появления GM200 в основной, «номерной» линейке GeForce).

Рекомендованные розничные цены на TITAN X были объявлены в последние часы перед публикацией обзора. Для рынка США установлена цена в 999 долларов — столько же, сколько в свое время стоил первый TITAN на базе GK110.

Прим.: цены в таблице для GeForce GTX 780 Ti и TITAN Black приведены на момент снятия с производства последних.

Модель | Графический процессор | Видеопамять | TDP, Вт | РРЦ* для рынка США (без налогов), $ | ||||||||

Кодовое название | Число транзисторов, млн | Тактовая частота, МГц: Base Clock / Boost Clock | Число ядер CUDA | Число текстурных блоков | Число ROP | Разрядность шины, бит | Тип микросхем | Тактовая частота: реальная (эффективная), МГц | Объем, Мбайт | |||

GeForce GTX 780 Ti | GK110 | 7 100 | 875/928 | 2880 | 240 | 48 | 384 | GDDR5 SDRAM | 1750 (7000) | 3072 | 250 | 699 |

GeForce GTX TITAN Black | GK110 | 7 100 | 889/980 | 2880 | 240 | 48 | 384 | GDDR5 SDRAM | 1750 (7000) | 6144 | 250 | 999 |

GeForce GTX 980 | GM204 | 5 200 | 1126/1216 | 2048 | 128 | 64 | 256 | GDDR5 SDRAM | 1750 (7000) | 4096 | 165 | 549 |

GeForce GTX TITAN X | GM110 | 8 000 | 1000/1076 | 3072 | 256 | 96 | 384 | GDDR5 SDRAM | 1753 (7012) | 12 280 | 250 | 999 |

* Рекомендованная розничная цена.

⇡#Конструкция

Начиная с самого первого «Титана» NVIDIA использует в топовых видеокартах, с некоторыми вариациями, одну и ту же систему охлаждения. TITAN X выделяется в ряду своих предшественников только абсолютно черным корпусом (лишь две вставки на боках остались неокрашенными).

NVIDIA GeForce GTX TITAN X

Задняя пластина, которой в порядке эксперимента оснастили GeForce GTX 980, в TITAN X вновь отсутствует, несмотря на то, что на оборотной стороне платы распаяна часть микросхем памяти. Хотя чипам GDDR5 дополнительное охлаждение, в общем-то, и не требуется.

NVIDIA GeForce GTX TITAN X, вид сзади

Зато вернулся радиатор с испарительной камерой, который в GTX 980 был заменен более простым вариантом.

NVIDIA GeForce GTX TITAN X, система охлаждения

NVIDIA GeForce GTX TITAN X, система охлаждения

NVIDIA GeForce GTX TITAN X, система охлаждения

NVIDIA GeForce GTX TITAN X, система охлаждения

Видеокарта обладает тремя разъемами DisplayPort и по одной штуке — HDMI и Dual-Link DVI-I.

⇡#Плата

Дизайн печатной платы, что совершенно неудивительно, вызывает ассоциации с серией видеоадаптеров на чипе GK110. Преобразователь напряжения построен по схеме 6+2 (число фаз для питания GPU и микросхем памяти соответственно). Питание подается через один восьмиконтактный и один шестиконтактный разъем. А вот контроллер питания графического процессора ON Semiconductor NCP81174 мы здесь видим впервые.

24 микросхемы памяти SK hynix H5GQ4h34MFR-R2C со штатной частотой 7 ГГц расположены на обеих сторонах платы.

NVIDIA GeForce GTX TITAN X, печатная плата, передняя сторона

NVIDIA GeForce GTX TITAN X, печатная плата, задняя сторона

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

3dnews.ru

geforce gtx titan » Обзоры процессоров, видеокарт, материнских плат на ModLabs.net

Вступление. Архитектура GK110, новые возможности GeForce GTX TITAN.

Ещё несколько месяцев назад на страницах зарубежных новостных ресурсов стали появляться скудные данные о некоем мифическом 3D ускорителе от компании NVIDIA. Судя по первым слухам, которые, впоследствии подтвердились, новая видеокарта должна была получить гордое имя “TITAN”, а её сердцем должен был стать супермощный GPU с архитектурой Kepler. Скептики не верили в существование Титана, поклонники же, отнюдь, всем сердцем ждали новинку и пророчили флагманской графике AMD поражение в борьбе с зелёным монстром. Так бы и продолжались словесные перепалки, если бы, наконец, не произошёл долгожданный анонс, после которого все смогли оценить способности новоиспечённого одночипового флагмана. Ну а я, в свою очередь, после того, как эмоциональный накал от выхода GeForce GTX TITAN немного спал, хочу спокойно и без спешки посмотреть на производительность ускорителя GeForce GTX TITAN в самых современных играх вроде Tomb Raider и Crysis 3. Сделаю я это не так как большинство журналистов, поскольку в отличие от многих в нашей тестовой лаборатории используется платформа AMD.

Прежде всего, как мне кажется, нужно разобраться с архитектурой графического процессора GeForce GTX TITAN. Начнём.

Знаю наверняка, от чего не умрут маркетологи NVIDIA. От скромности 🙂 Новый ускоритель GeForce GTX TITAN зовётся основой для игрового суперкомпьютера. Звучит, конечно, красиво, однако так можно назвать, пожалуй, любую игровую станцию на базе одной или нескольких флагманских видеокарт, по крайней мере, на стадии анонса или сразу после него. Впрочем, не буду придираться, продолжу.

Осознание способностей графического процессора GeForce GTX TITAN, лучше всего приходить после выставления точки отсчёта. В данном случае ей стал один из экстремальных процессоров Intel – Core i7 3960X Extreme Edition. По сравнению с этим чипом, GPU TITAN, действительно, является суперкомпьютером, жаль только, что вся эта вычислительная мощь актуальна для игроков лишь при наличии маленького кусочка кремния от Intel или AMD….

Чтобы понять, откуда растут ноги, и благодаря чему удалось достичь столь впечатляющих вычислительных показателей, нужно немного углубиться в историю и покопаться в архитектуре GPU ускорителя GeForce GTX TITAN. Дело в том, что после анонса графических ускорителей поколения Kepler, стало ясно, что GeForce GTX 680 не состоялся как флагман в полном смысле этого слова. Этот ускоритель использовал GPU GK104, который, по своей топологии оказался больше похож на Middle-High продукт, нежели на флагманское решение. Чтобы убедится в этом, посмотрите на устройство чипов GF110 и GF114 на базе Fermi, поймёте о чём я. Судя по всему, технологические проблемы не позволили NVIDIA в разумные сроки наладить массовый выпуск полноценных GK110 и, чтобы даром время не терять, был найден компромисс. В общем-то, NVIDIA этого факта и не скрывала, GeForce GTX 680 был временным игроком, который должен был получить более мощного преемника как только удастся решить проблемы с 28-нм техпроцессом. Впрочем, при кажущейся простоте, GeForce GTX 680 обладал отличной производительностью и довольно неплохими характеристиками энергопотребления и тепловыделения. Теперь, с выпуском графического ускорителя GeForce GTX TITAN инженеры компании подвели некоторую технологическую черту, за которую одночиповые решения NVIDIA вряд ли выйдут в рамках архитектуры Kepler, поскольку настольная версия GK110 получила практически все заложенные в неё возможности.

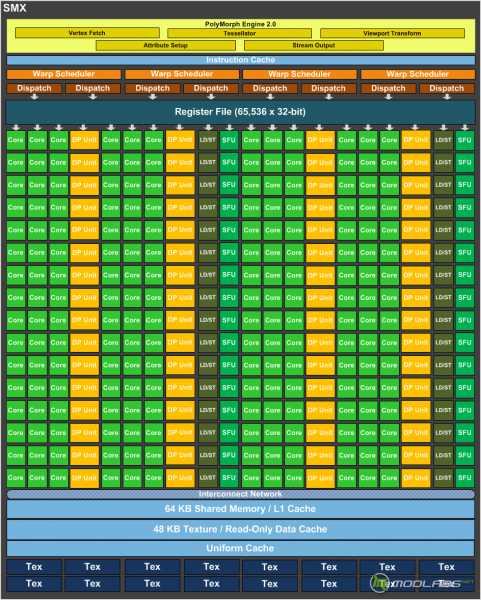

Графический процессор GK110 содержит блок управления потоками, именуемый GigaThread Enginе, кеш память для инструкций и данных, контроллеры памяти, блоки растровых операций, а также Graphics Processing Clusters (GPC), который выполняет вычислительные операции и операции с текстурами. В составе GK110 находятся пять блоков GPC. Внутри каждого GPC, в свою очередь, находится по одному движку растеризации, а также по три так называемых SMX (SM – в терминологии NVIDIA для GPU Tesla и Fermi) — потоковых мультипроцессора. В отличие от серверного Tesla K20/K20X, в составе которых трудится полноценная версия GK110 с 15-ю активными блоками SMX, настольный графический чип GK110 получил лишь 14 активных потоковых мультипроцессора. Количество текстурных блоков равно 224, а блоков растеризации – 48.

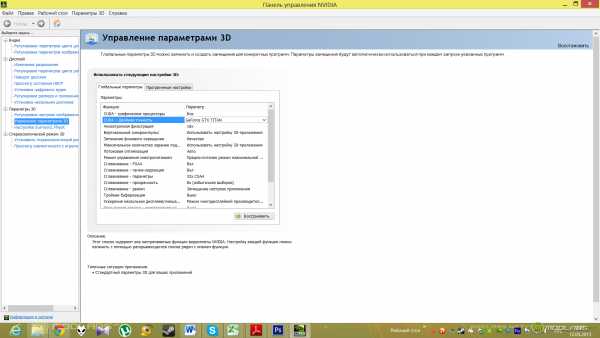

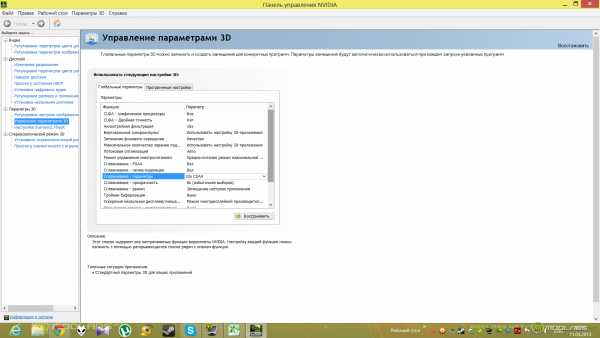

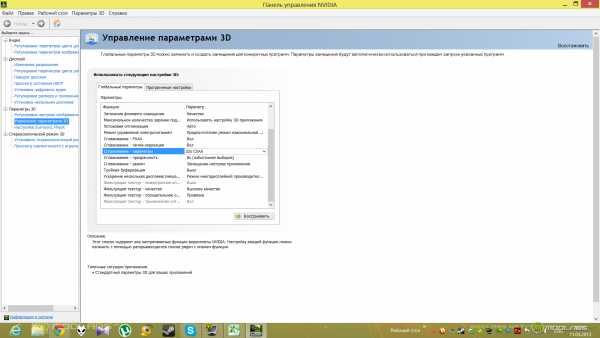

В составе SMX трудятся 224 текстурных блока и 48 ROP (блоков растеризации), особого рассмотрения заслуживают блоки операций с двойной точностью. Общее количество блоков FP64 (те самые блоки операций с двойной точностью) составляет 896 штук, по 64 на каждый SMX, – это положительное отличие от GK104. Не очень хорошо то, что по умолчанию, ядра, предназначенные для работы с FP64, работают на 1/8 от частоты других блоков, размещённых в SMX. Правда стоит отметить, что в драйверах есть возможность поднять тактовую частоту FP64 блоков, переключив видеокарту в режим “CUDA двойная точность”, однако общая тактовая частота GPU снизится. Вот что получилось при запуске 3D приложения после включения вышеозначенной опции (значения Temp Target было сдвинуто до 90 градусов Цельсия):

Отключаем режим двойной точности, получаем:

Так вот, поскольку суммарное количество ядер CUDA в GK110 равно 2688 (по 192 штуки на один блок SMX), а количество FP64 блоков – 896, получаем, что соотношение FP64/FP32 блоков = 1/3. Если вспомнить, что FP64 блоки работают на 1/8 частоты GPU, получим, что эффективность выполнения операций с двойной точностью составляет 1/24 от FP32! Да, да, близкая ситуация в FP64 операциях была и у GeForce GTX 680, из за столь же низкой эффективности таких вычислений он “сливал” старине GTX 580. Вот только в данном случае низкая эффективность при работе с FP64 компенсируется за счёт колоссального увеличения количества самих вычислительных блоков. У AMD, кстати, при переходе к FP64 провал заметно меньше, скорость падает примерно вдвое. Это, конечно, на словах звучит страшно, на практике же, применительно к играм, всё не так плохо, скорее даже очень хорошо, поскольку архитектура Fermi, а теперь и Kepler имеет не так много слабых мест и решения на её основе более чем конкурентоспособны.

Контроллер памяти у GK110 заметно подтянут относительно оного у GK104, теперь он 384 битный, против 256 битного, а суммарный объём локальной видеопамяти GeForce GTX TITAN составляет 6144 Мбайт = 6 Гбайт! Здесь полный порядок.

В итоге мы получаем, что настольная версия видеокарт, базирующихся на GPU GK110, обладает следующими характеристиками.

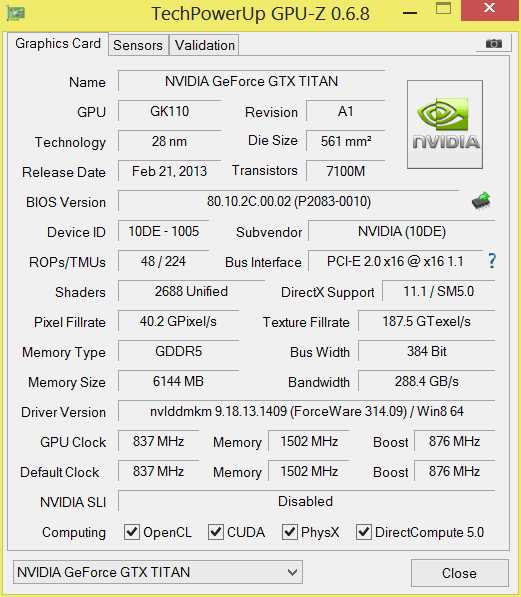

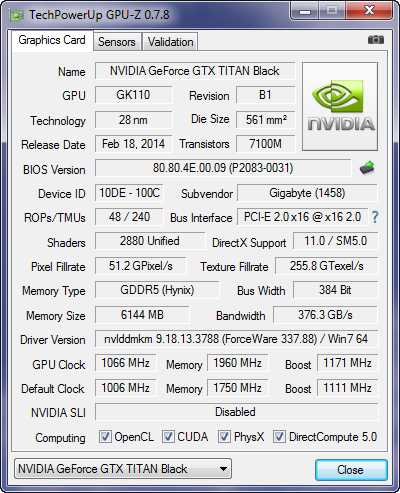

Ещё пару лет назад, снимок экрана с окном программы GPU-Z, отображающей характеристики GeForce TITAN, сочли бы как минимум поддельными, а как максимум, назвали бы автора этих снимков сумасшедшим. Нынче же ситуация иная, перед нами настоящий Титан, по крайней мере по формальным характеристикам. Согласитесь, тактовые частоты GPU 837/876 МГц, частота видеопамяти 6008 МГц, шина памяти 384 бит (ПСП памяти 288 Гбайт/с), 48 блоков растеризации и 224 текстурных блока, 2688 ядер CUDA и всё это при использовании 7,1 млрд. транзисторов! Даже сейчас это выглядит круто, при этом TDP платы GeForce GTX TITAN не пугает современного пользователя – всего 250 Вт.

Если по части архитектуры GPU и подсистемы памяти мы разобрались, то оверклокерские характеристики ещё требуют описания. Уж поверьте, есть на что обратить внимание. Эти данные, определённо, нужно будет учитывать при подходе к разгону.

Динамический разгон. Технология NVIDIA GPU Boost ver. 2.0

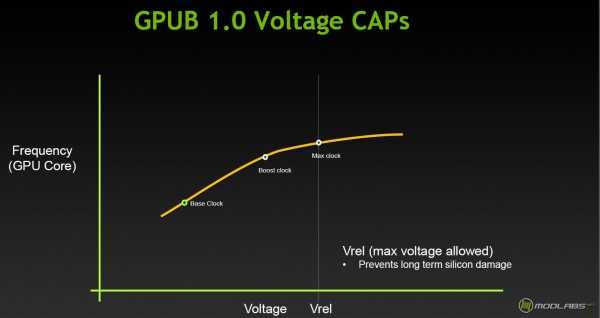

Итак, первая версия технологии форсирования частоты GPU от NVIDIA в своей работе учитывала только один параметр – предел мощности/напряжение GPU, который изменялся в определённых рамках. Сейчас же появился ещё один фактор – предельная температура, при которой GPU в состоянии функционировать без сбоев.

По умолчанию значение предельной температуры выставлено на уровень 80 градусов Цельсия, однако пользователь вручную может изменить этот уровень до 94 градусов. Такое смещение позволит работать графическому процессору под нагрузкой при более высоких частотах. Судя по слайдам с презентации, именно рабочая температура GPU будет решающим фактором в достижении максимальной частоты при работе GPU Boost 2.0.

На практике при разгоне видеокарты мы будем выставлять не только значение Power Target, но и Temperature Target. Кстати, отмечу, что в технической документации от NVIDIA написано о возможности регулировки напряжения как об опции, которая может быть выключена производителем посредствам VBIOS. Думаю, что вряд ли кто-то будет намеренно глушить эту возможность.

Одной из интересных возможностей ускорителей NVIDIA является технология адаптивной вертикальной синхронизации, суть которой заключается в нивелирование эффекта “разрыва кадра” и “подёргиваний“ картинки при резком изменении частоты смены кадров. Новизна Adaptive V-sync в случае с GeForce GTX TITAN заключается в том, что отныне ограничение частоты смены кадров при адаптивной вертикальной синхронизации можно увеличить до 120 Гц включительно.

Напоследок, хочу вспомнить о технологии NVIDIA SLI. Не секрет, что максимальное количество одновременно задействованных GPU в системе с видеокартами NVIDIA может достигать четырёх. Пара GeForce GTX 690 – отличный пример работы 4-Way SLI. Использование такого тандема, как мне кажется, оправдано довольно редко, поскольку помимо ограничений в вычислительной мощи центрального процессора, остро стоит проблема синхронизации четырёх чипов для работы над картинкой. Коэффициент полезного действия 4-Way SLI систем существенно ниже, чем у, скажем, 2-Way или 3-Way SLI. Зная об этом, NVIDIA с выходом GeForce TITAN активно продвигает тему 3-Way SLI, как самую оптимальную с точки зрения эффективности и самую высокопроизводительную. На мой взгляд, такое позиционирование оправдывает себя, особенно для видеосистемы класса TITAN. Вот только крайне рекомендую для “Титановых” SLI связок обзавестись мощнейшим процессором, да ещё и разогнать его.

На этом я заканчиваю теоретическую часть материала, пришла пора знакомиться с Титаном лично.

Ускоритель ZOTAC GeForce GTX TITAN. Внешний вид и особенности аппаратного оснащения.

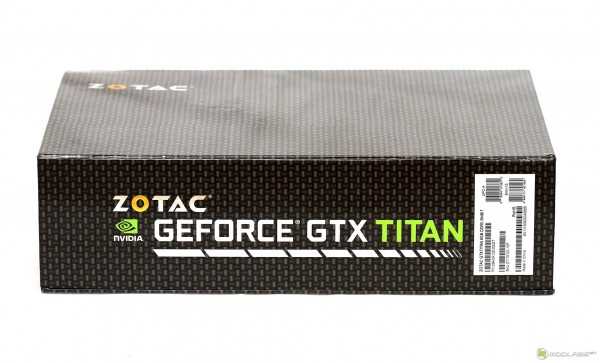

Всё, как обычно, начинается с упаковки. Она, пожалуй, единственное, что отличает ZOTAC GeForce GTX TITAN от большинства выпущенных на данный момент “Титанов” других производителей. Перед нами красочный чехол из тонкого картона, который опоясывает достаточно увесистую коробку, в которой находится набор аксессуаров и сам ускоритель. Помимо основных технических данных, нам сходу сообщают о том, что на этот продукт действует расширенная гарантия от ZOTAC, а также о том, что внутри нас ждёт подарок – три игры из серии Assasin’s Creed. Те, кто любит эти игры, оценит, остальные же отнесутся спокойно, поскольку игры из подарочного комплекта уже не так свежи. как того хотелось бы.

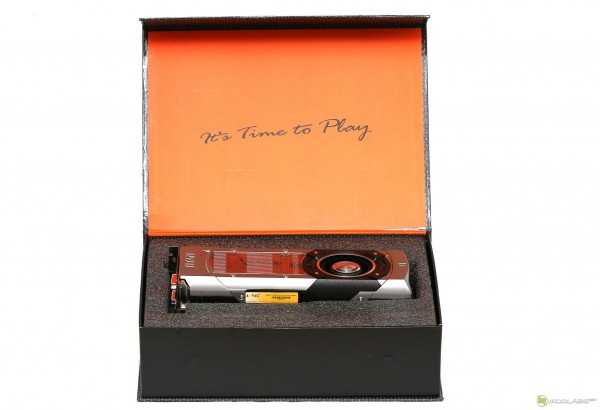

Открываем картонный чемодан. Сверху, под крышкой из прозрачного пластика находится видеокарта ZOTAC GeForce GTX TITAN, она лежит в “кроватке” из пористого синтетического материала. Именно эта кроватка защищает Титана от повреждений при транспортировке.

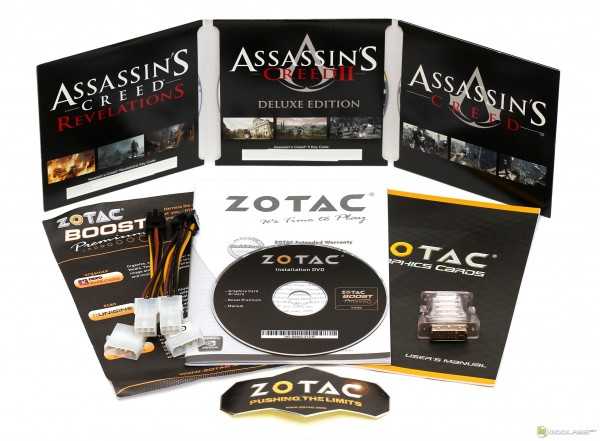

Вытаскиваю видеокарту, залезаю глубже, нахожу аксессуары, заботливо уложенные на заводе в отдельный картонный бокс. Помимо бумажного сопровождения и диска с драйверами я обнаружил обещанные игры из серии Asassin’s Creed (серийники к которым я, с вашего позволения, замазал), пару переходников питания, переходник с DVI на VGA и фирменную наклейку ZOTAC. Уж не знаю, нужно ли что-то ещё покупателю такой вот видеокарты, а лично мне, как обозревателю, этого набора вполне хватает.

Бог с ними, с бумажками. Вот он, герой обзора. Честно сказать, вопреки своей привычке, я очень долго рассматривал GeForce GTX TITAN, крутил плату в руках и никак не мог нарадоваться. На мой вкус, этот ускоритель можно назвать одним из самых правильных с эстетической точки зрения. Пару или даже тройку Титанов нужно ставить в корпус с прозрачной боковой стенкой, чтобы наблюдать всё это великолепие как можно чаще. Крышка системы охлаждения выполнена из алюминия, ближе к панели выводов выдавлена надпись TITAN, ближе к корме присутствует логотип NVIDIA.

Через прозрачное стекло, изготовленное из полимера, видны рёбра радиатора системы охлаждения.

Кстати, при включении видеокарты надпись GeForce GTX светится зелёным цветом, оценить это свечение можно на фото, приведённом чуть ниже.

Панель выводов оснащается четырьмя выходами, два из которых – DVI-I и DVI-D, ещё пара – это полноразмерные HDMI и DisplayPort. Лично для меня такой набор выходов является идеальным, поскольку обычно я использую сразу два DVI разъёма для подключения монитора и плазменной панели. Как и положено флагману, GeForce GTX TITAN от ZOTAC поддерживает разрешение 4K.

Демонтирую систему охлаждения. Процесс проходит легко и непринуждённо. В отличие от первых плат на базе GPU Fermi, для демонтажа системы охлаждения которых предполагалось использование небольшого гранёного ключика, ускоритель GeForce GTX TITAN разбирается при помощи обычной отвёртки. Слава Богу, производитель не стал мудрить с креплением, винтов много, но процесс демонтажа прост как устройство молотка. Я сознательно не стал разбирать систему охлаждения до винтика, поскольку ничего принципиально нового в её устройстве нет. Кулер представляет собой конструкцию из испарительной камеры, радиатора и турбины, прокачивающей воздух сквозь рёбра радиатора, выводя потоки горячего воздуха за пределы корпуса. Подошва испарительной камеры через тонкий слой термопасты контактирует с кристаллом GK110, в то время как сильно греющиеся элементы системы питания, а также чипы памяти отдают тепло на металлическое основание кулера через специальные термопрокладки.

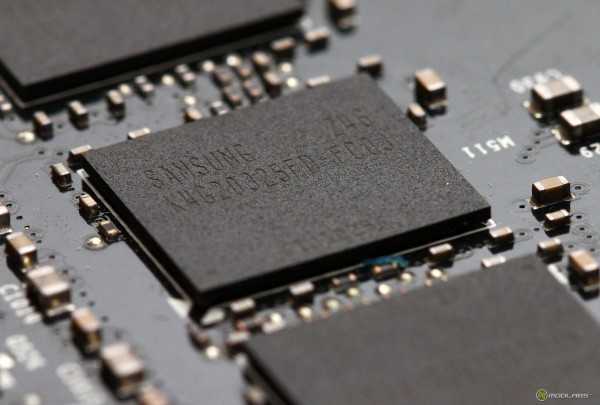

Полная маркировка GPU ускоритель ZOTAC GeForce GTX TITAN такова:

A TAIWAN 1251A1

NFF532.M3W

GK110-400-A1

Чип GK110 имеет ревизию A1 и изготовлен на 51 неделе 2012 года. Для оценки размеров кристалла GF110, взгляните на фото. Десятирублёвая монета помещается целиком, да ещё и остаётся достаточно много места. Как ни крути, а чип получился гигантский, его площадь составляет 561 кв. мм. Металлическая рамка вокруг GPU защищает кристалл от сколов, полезно при установке нестандартной системы охлаждения.

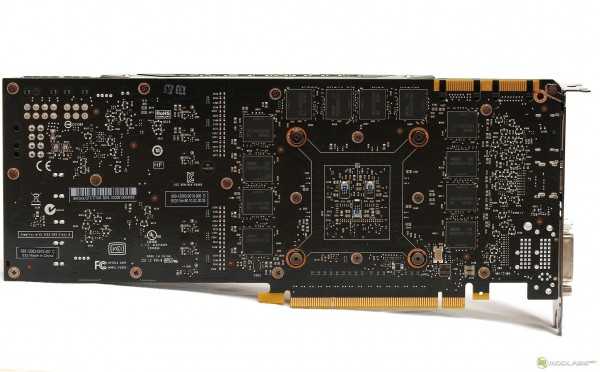

Без системы охлаждения плата GeForce GTX TITAN выглядит не так эффектно, тем не менее, вид флагмана плата сохраняет даже “голышом”. Двадцать четыре микросхемы памяти Samsung K4G20325FD-FC03 размещены по обе стороны печатной платы, микросхемы, расположенные на обратной стороне PCB никак не охлаждаются. Номинальная эффективная тактовая частота для этих чипов памяти составляет 6 ГГц.

За питание графического процессора отвечают 6 фаз, управляемых микросхемой ON Semiconductor NCP4206. Питание памяти двухфазное, для питания PLL выделана одна фаза. В системе питания использованы высококачественные компоненты Dr.Mos.

В общем-то, с описанием теории и аппаратного устройства GeForce GTX TITAN, пожалуй, всё, самое время переходить к практическим испытаниям.

Нагрев, уровень шума. Пара слов о необходимости разгона. Тесты.

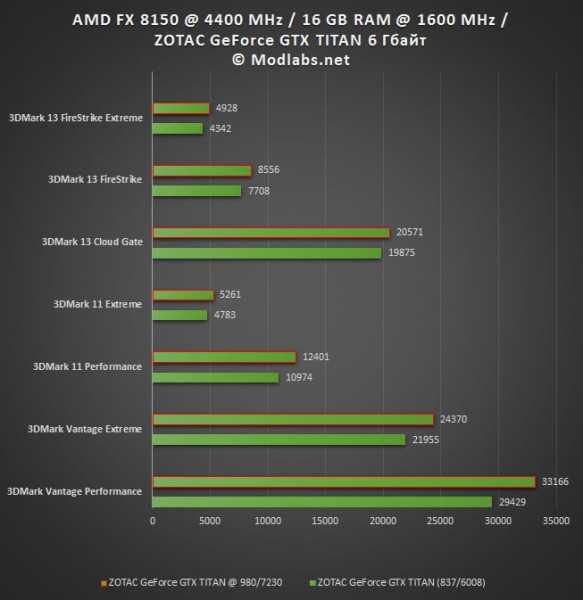

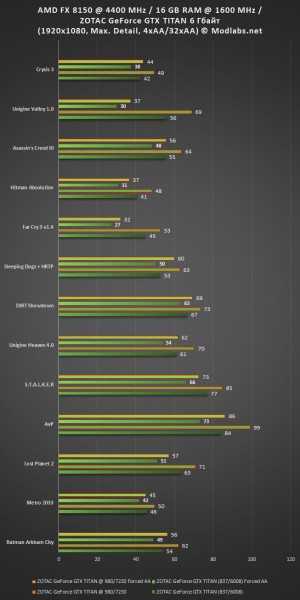

Тестовый стенд Modlabs, на котором проводилась проверка акустических и температурных характеристик, а также тесты производительности GeForce GTX TITAN от ZOTAC, был собран в составе корпуса Cooler Master Cosmos 1000S, все посадочные места которого заняты 120 мм вентиляторами, вращающимися со скоростью 1200 об./мин. Боковая стенка корпуса во время тестирования открыта. Конфигурация тестового стенда такова:

Конфигурация тестового стенда MODLABS | |

Системная плата | MSI 990FXA-GD80 – спасибо, MSI! |

Центральный процессор | AMD FX-8150 @ 4400 МГц – спасибо, AMD! |

Оперативная память | 16 Гбайт AMD Entertainment Memory @ 1600 МГц – спасибо, AMD! |

Видеокарта | ZOTAC GeForce GTX TITAN 6 Гбайт (837/6008) |

Жёсткие диски | 4×1 Тбайт Seagate ES.2 @ RAID0 |

Операционная система | MS Windows 8 Professional x64 + upd |

Версия драйверов видеокарты | 314.09 WHQL |

Как вы уже поняли, в качестве основы для тестового стенда использовалась система на базе AMD FX 8150, разогнанного до 4400 МГц. В таком виде эта машина весьма производительная и способна осилить любую из современных игр, однако в сравнении с флагманскими системами Intel, наш боец FX всё-таки проигрывает и местами достаточно заметно. Именно поэтому, для того, чтобы минимизировать влияние процессора на потенциал GeForce GTX TITAN, нужно нагрузить графическую систему по максимуму. Так я и сделал. Помимо стандартных настроек игр на максимальное качество при разрешении 1920×1080 с 4-х кратным полноэкранным сглаживанием MSAA и 16-ти кратной анизотропной фильтрации, я провёл дополнительное тестирование, при котором настройки полноэкранного сглаживания форсировались вручную через драйвер или выставлялись в опциях игр, разумеется, при наличии соответствующих опций, эквивалентных настройкам драйверов. Форсированные настройки драйверов 314.09 выглядят так:

В деле влияния CPU на результаты, не стоит также забывать, что не каждая современная игра способна “получать удовольствие” от наличия в системе 8-ми ядерного CPU. Об этом, кстати, мы уже писали и подкрепили наши слова результатами тестов. С этим фактом, как мне кажется, связан проигрыш процессоров AMD FX в играх, которые не могут использовать все активные ядра флагманских процессоров FX, в то время как камни Intel за счёт большей мощи отдельных ядер вырывались вперёд. К сожалению, мы не можем сравнить полученные нами результаты с оными на платформе Intel ввиду временного отсутствия соответствующего оборудования, так что пока оставим эту тему, до появления актуальной системы на базе чипов Intel.

Что же касается разгона, то для выяснения частотного потенциала моего образца ZOTAC GeForce GTX TITAN, была использована утилита EVGA Precision X. Обороты системы охлаждения были установлены на максимум, значение Power Target было увеличено до 106%, а Temp Target до 90 градусов Цельсия. Базовую частоту GPU удалось поднять до стабильного уровня в 980 МГц, а частоту памяти до 7230 МГц. Максимальная турбо частота при активации технологии GPU Boost составила 1142 МГц, отмечу, правда, что такой потолок был достижим далеко не во всех играх, а там, где достижим, на такой частоте видеокарта работала не долго. Как правило, карта работала на 1078 МГц.

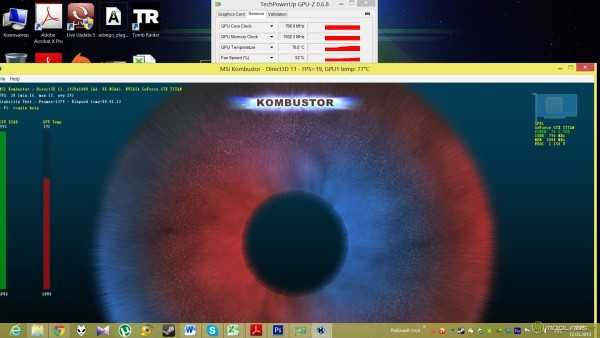

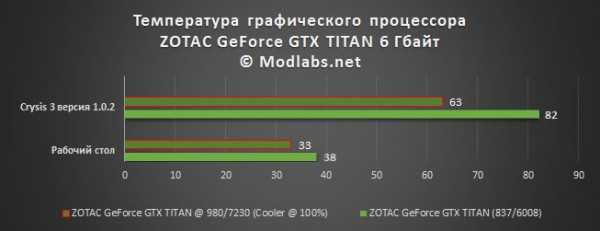

Для тестирования уровня шума и исследования процесса нагрева GPU я отказался от использования теста MSI Kombustor и FurMark, вместо этого тесты проводились в игре Crysis 3, при этом настройки качества картинки были выставлены на максимум, использовалось разрешение 1920×1080, также был задействован режим сглаживания MSAA 8x.

Без разгона графический процессор ускорителя ZOTAC GeForce GTX TITAN разогрелся не более 82 градусов Цельсия, при этом максимальная тактовая частота, которую удалось зафиксировать во время тестирования в играх, составила 1010 МГц. Что же касается уровня шума, то для столь быстрой видеокарты, я бы сказал, что ZOTAC GeForce GTX TITAN почти не шумит. В 2D карту не слышно, а в 3D, на фоне остальных компонентов из состава тестового стенда, этот ускоритель выделяется, но незначительно, долгой игре этот шум никак не мешает. Прямое сравнение температуры GPU GK110 до и после разгона вряд ли можно назвать справедливым, поскольку в момент разгона турбина ZOTAC GeForce GTX TITAN работает на 100% своей мощности.

Обращу ваше внимание на тот факт, что тестирование ускорителя GTX TITAN проводилось до фотосессии видеокарты, как следствие, использовалась термопаста, нанесённая производителем! После фотосессии, на очищенный кристалл GPU был нанесён слой Noctua NT-h2, на фото представлен не окончательный вариант (в реалии оставлен более тонкий слой):

Список тестовых приложений |

Синтетические и полусинтетические тесты |

3DMark Vantage 1.1.0 (Performance, Extreme) |

3DMark 11 1.0.3.0 (Performance, Extreme) |

Unigine Valley 1.0 |

Unigine Heaven 4.0 (Все детали и тесселляция установлены на максимум, 4xAA) |

Игры |

Во всех играх рабочее разрешение было установлено в 1920×1080, все детали, доступные в опциях игры или в настройках бенчмарка были выставлены на максимум, в том числе и тесселляция, полноэкранное сглаживание устанавливалось в режим 4x во всех играх. Режим PhysX, если был доступен, включался в режиме максимального качества. В драйверах PhysX не выключался нигде, кроме 3DMark Vantage. Также был проведён цикл игровых тестов с форсированными настройками драйверов или эквивалентными им настройками в опциях игр, если такие были доступны. Более подробно читайте об этом чуть выше. Десятые доли FPS отсекались, в силу неактуальности. |

Metro 2033 DX11 |

Batman Arkham City DX11 |

Lost Planet 2 DX11 |

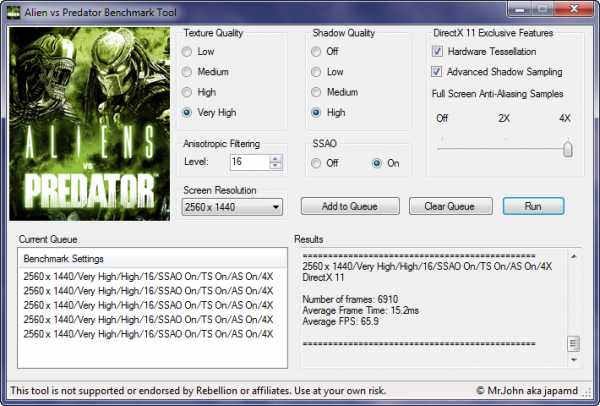

Alien Versus Predator DX11 |

S.T.A.L.K.E.R CoP DX11 |

DIRT Showdown DX11 |

Sleeping Dogs DX11 |

Far Cry 3 DX11 |

Hitman. Absolution |

Asassin’s Creed III |

Crysis 3 версия 1.0.2 |

Изначально я хотел включить в список тестов Tomb Raider 2013, однако игра отказалась запускаться и пока придётся обойтись без неё.

Выводы.

Результаты тестов свидетельствуют о том, что NVIDIA проделала очень серьёзную работу по подготовке GeForce GTX TITAN. И действительно, на примере ZOTAC GeForce GTX TITAN видно, что карта удалась. Восхитительная производительность в тяжёлых режимах делает её незаменимым спутником для богатого игрока, который хочет выжать всё, что только можно из своей системы. Любители собирать компьютер “про запас” также не будут обделены. Если позволяют средства, можно собрать связку из трёх Титанов, благодаря чему, как мне кажется, в ближайшие полтора – два года можно забыть об апгрейде, разумеется, если не произойдёт неожиданного скачка в области требований к графической подсистеме со стороны актуальных на тот момент игр.

Помимо высокой производительности, к достоинствам ZOTAC GeForce GTX TITAN можно отнести низкий уровень шума стандартной системы охлаждения, что тоже не маловажно в домашнем игровом ПК. Тем не менее, несмотря на столь выдающиеся возможности, я бы не стал торопиться с выводами и записывать GeForce GTX TITAN в однозначные лидеры среди всех одиночных видеокарт, ведь красному лагерю тоже есть чем ответить, например “залпом” из двух GPU видеокарты ASUS ARES II, но об этом в другой раз. А пока битва Богов и Титанов только готовится, я, пожалуй, выдам продукту ZOTAC награду.

Графический ускоритель ZOTAC GeForce GTX TITAN удостоен награды «Выбор редактора» за март 2013 года.

Графический ускоритель ZOTAC GeForce GTX TITAN удостоен награды «Выбор редактора» за март 2013 года.

Предлагаю обсудить материал у нас в форуме.

P.S. Заранее отвечая на вопрос о целесообразности покупки трёх Титанов для объединения их в связку, скажу, что помимо обычных конфигураций, работающих с одним монитором, пусть даже и очень большим, есть ещё конфиги, например, с тремя мониторами, да ещё и с поддежкой 3D, а это значит, что столь мощные конфигурации оправданы уже сегодня!

www.modlabs.net

Обзор видеокарты Gigabyte GeForce GTX TITAN Black GHz Edition: «Титаново-чёрный» гигагерц

⇡#Предисловие

После выхода видеокарты AMD Radeon R9 295X2 ($1 499) и тем более NVIDIA GeForce GTX TITAN Z ($2 999) ценой «обычных» GeForce GTX TITAN ($999) уже никого не удивишь, хотя не так давно именно эти видеокарты являлись самыми дорогими на рынке. Занимавшие прежде это место двухпроцессорные AMD Radeon HD 7990 и NVIDIA GeForce GTX 690 не только подешевели, но и постепенно исчезают из продажи. В этой связи отдельные производители, не опасаясь рыночного провала, выпускают ещё более интересные и дорогие версии TITAN Black.

Одной из таких компаний является Gigabyte Technology Co., Ltd., анонсировавшая сразу четыре варианта TITAN Black, самым интересным из которых является GeForce GTX TITAN Black GHz Edition.

На данный момент это самая быстрая однопроцессорная видеокарта. Справедливости ради отметим, что у EVGA есть столь же скоростная модель GeForce GTX TITAN BLACK Hydro Copper Signature, но она требует жидкостного охлаждения, а в Gigabyte обошлись охлаждением воздушным, правда использовали при этом не совсем обычный подход. Но обо всём по порядку.

⇡#Технические характеристики и рекомендованная стоимость

Технические характеристики и стоимость видеокарты Gigabyte GeForce GTX TITAN Black GHz Edition приведены в таблице — в сравнении со спецификациями NVIDIA GeForce GTX TITAN Black, NVIDIA GeForce GTX 780 Ti, а также AMD Radeon R9 290X.

| Наименование технических характеристик | Gigabyte GeForce GTX TITAN BlackGHz Edition | NVIDIA GeForce GTX TITAN Black | NVIDIA GeForce GTX 780 Ti | AMD Radeon R9 290X | |

|---|---|---|---|---|---|

| Графический процессор | GK110-B1 Kepler (TSMC) | GK110-B1 Kepler (TSMC) | GK110-B1 Kepler (TSMC) | Hawaii XT (TSMC) | |

| Техпроцесс, нм | 28 (low-k) | 28 (low-k) | 28 (low-k) | 28 (low-k) | |

| Площадь кристалла, мм2 | 561 | 438 | |||

| Число транзисторов, млн | 7100 | 6200 | |||

| Частота графического процессора, МГц | 3D | 1006 (1111 — boost) | 889 (980 — boost) | 876 (928 — boost) | до 1000 |

| 2D | 324 | 300 | |||

| Число унифицированных шейдерных процессоров, шт. | 2880 | 2816 | |||

| Число текстурных блоков, шт. | 240 | 176 | |||

| Число блоков растровых операций (ROPs), шт. | 48 | 64 | |||

| Теоретическая максимальная скорость закраски, Гпикс/с | 48,3 | 42,7 | 42 | 64 | |

| Теоретическая максимальная скорость выборки текстур, Гтекс/с | 241,4 | 213,4 | 210,2 | 176 | |

| Поддержка версии Pixel Shaders / Vertex Shaders | 5.0 / 5.0 | ||||

| Тип поддерживаемой памяти | GDDR5 | ||||

| Разрядность шины обмена с памятью, бит | 384 | 512 | |||

| Эффективная частота работы видеопамяти, МГц | 3D | 7000 | 5000 | ||

| 2D | 648 | 600 | |||

| Объем памяти, Мбайт | 6148 | 3072 | 4096 | ||

| Полоса пропускания видеопамяти, Гбайт/с | 336 | 320 | |||

| Пиковая потребляемая мощность в 3D режиме работы, Вт | 3D | 250 | 275 | ||

| 2D | н/д | 70 / 3 | |||

| Требования к мощности блока питания, Вт | 600 | ||||

| Размеры видеокарты, мм (ДхВхТ) | 267х100х39 | 276х99х39 | |||

| Интерфейс | PCI-Express x16 (v3.0) | ||||

| Выходы | DVI-I+DVI-D (Dual-Link), 1 HDMI v1.4a, 1 DisplayPort v1.2 | ||||

| Рекомендованная/минимальная розничная стоимость, долларов США | н/д / 1239 | 999 / 1029 | 699 / 660 | 549 / 490 | |

⇡#Упаковка и комплектация

Gigabyte GeForce GTX TITAN Black GHz Edition поставляется в большущей картонной коробке, габариты которой вдвое превышают размеры обычных упаковок для топовых видеокарт. На её лицевой стороне наибольшую площадь занимает изображение какого-то высокотехнологичного глаза, с ним соседствуют название модели, информация о частоте, системе охлаждения, а также объёме и типе видеопамяти.

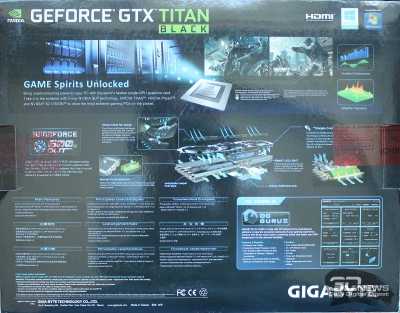

Обратная сторона коробки на порядок более информативна. Здесь обнаруживается и описание технологий NVIDIA, и перечисление достоинств фирменной системы охлаждения WINDFORCE 3X 600W, и основные характеристики, и демонстрация возможностей утилиты OC Guru II.

|  |

Внутрь цветной оболочки вставлена чёрная коробка из плотного картона. Открыв её, покупатель обнаружит сверху огромный коврик для мыши.

Под ним расположена плоская коробка с аксессуарами.

В ней находятся два кабеля-переходника для подключения дополнительного питания, кабель HDMI, переходник DVI-to-D-Sub, гарантийная памятка, краткая инструкция по установке и компакт-диск с драйверами и утилитой.

Игр в комплекте поставки нет. По всей видимости, предполагается, что пользователи, которые могут позволить себе продукт такой стоимости, и сами способны приобрести все интересные им игровые новинки. Логично, но, на наш взгляд, пара-тройка не так давно появившихся игр были бы здесь не лишними.

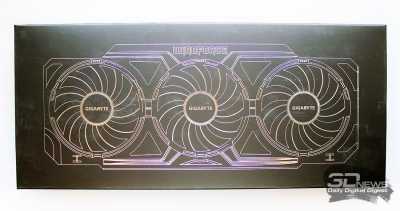

В нижнем ярусе основной коробки есть два отсека, в одном из которых зафиксирована видеокарта, а рядом вставлена коробка с системой охлаждения WINDFORCE 3X 600W с картонной и прозрачной пластиковой оболочками.

|  |

Gigabyte GeForce GTX TITAN Black GHz Edition выпускается на Тайване, на неё предоставляется трёхлетняя гарантия. Что касается стоимости, то информации о рекомендованной цене мы не нашли, а в интернет-магазинах эту модель можно приобрести за 1 239 долларов США, что на 24% больше рекомендованной стоимости обычных GeForce GTX TITAN Black.

⇡#Дизайн и особенности печатной платы

Несмотря на тот факт, что в комплект поставки видеокарты Gigabyte GeForce GTX TITAN Black GHz Edition входит альтернативная система охлаждения, сама видеокарта поставляется отнюдь не в «голом» виде, а в форме самого обычного GeForce GTX TITAN Black эталонного дизайна.

Лишь надпись на верхней кромке кожуха кулера и информация на стикере с обратной стороны платы выдаёт принадлежность продукта к компании Gigabyte.

Разумеется, Gigabyte GeForce GTX TITAN Black GHz Edition оснащена совершенно стандартными выходами DVI-I и DVI-D (оба — Dual-Link), а также HDMI версии 1.4a и DisplayPort версии 1.2, совмещёнными с решёткой для выброса нагретого воздуха за пределы корпуса системного блока.

Нет ничего примечательного и в плане разъёмов для подключения питания: GeForce GTX TITAN Black требуется один восьмиконтактный и один шестиконтактный кабели для подключения, да и от SLI-разъёмов вряд ли кто-то из наших читателей ждал каких-то инноваций.

|  |

Несмотря на серьёзно повышенную частоту графического процессора, предельный уровень энергопотребления видеокарты заявлен на отметке 250 ватт, а мощность рекомендованного блока питания для системы с одной такой видеокартой должна составлять не менее 600 ватт.

Под стандартной системой охлаждения вполне закономерно мы обнаружили эталонную печатную плату GeForce GTX TITAN Black/TITAN/780 Ti.

Силовую часть на транзисторах DrMOS с восьмифазной системой питания графического процессора мы видели совсем недавно в обзоре видеокарты ZOTAC GeForce GTX TITAN Black.

Точно такой же здесь и контроллер ON Semiconductor NCP4206, управляющий питанием GPU.

Графический процессор оказался даже чуть старше, чем у ZOTAC, — он выпущен на 47-й неделе 2013 года (середина ноября), но также относится к самой новой версии B1.

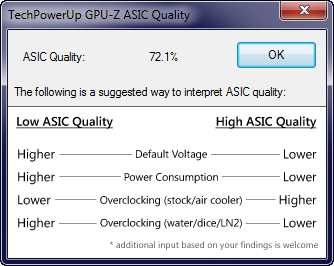

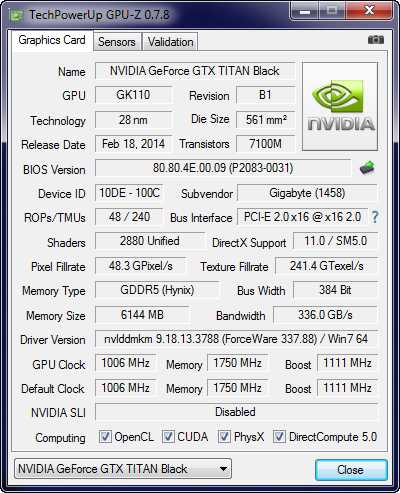

Информации о каком-то отборе кристаллов процессоров для данной видеокарты Gigabyte мы не нашли, тем не менее его базовая частота в 3D-режиме повышена сразу до 1006 МГц, что на 13,2% выше номинальной частоты эталонных GeForce GTX TITAN Black. Более того, в boost-режиме частота GPU может увеличиваться до 1111 МГц! Это весьма впечатляющий и, можно даже сказать, рискованный заводской разгон топового графического процессора, но именно он делает видеокарту Gigabyte GeForce GTX TITAN Black GHz Edition самым быстрым однопроцессорным решением на рынке. При этом качество ASIC GPU нашего экземпляра видеокарты оказалось невысоким — 72,1%.

Это в очередной раз подтверждает, что никакой связи между ASIC и частотным потенциалом видеокарты не существует.

Обычные для TITAN шесть гигабайт видеопамяти стандарта GDDR5 набраны 12 микросхемами производства компании SK Hynix (H5GQ2h34AFR-R2C).

Эффективная частота работы видеопамяти на Gigabyte GeForce GTX TITAN Black GHz Edition равна теоретической частоте этих микросхем и составляет 7000 МГц. То есть здесь о заводском разгоне говорить не приходится. С точки зрения маркетинга это, на наш взгляд, упущение, поскольку даже 200 МГц плюсом сделали бы эту видеокарту ещё привлекательнее на прилавках магазинов. А вот с точки зрения производительности жалеть об отсутствии заводского разгона видеопамяти смысла нет — практика показывает, что на видеокартах NVIDIA данного класса от этого очень и очень мало толку.

Технические характеристики Gigabyte GeForce GTX TITAN Black GHz Edition в интерпретации утилиты GPU-Z выглядят следующим образом.

Как и все остальные эталонные GeForce GTX TITAN Black, видеокарта имеет двойной BIOS с основной и резервной микросхемой. Версии BIOS в них одинаковые, а изучить один из них вы можете, скачав его из файлового архива.

⇡#Системы охлаждения — эффективность и уровень шума

Прежде чем перейти к самому интересному, а именно — к изучению новейшей системы охлаждения Gigabyte WINDFORCE 3X 600W, мы посчитали важным проверить эффективность штатного кулера на этой видеокарте. Напомним, что он представляет собой сочетание испарительной камеры и алюминиевого радиатора, а также металлической пластины с термопрокладками на микросхемах памяти и силовых элементах и прокачивающего сквозь них воздушный поток радиального вентилятора с адаптивной PWM-регулировкой скорости вращения.

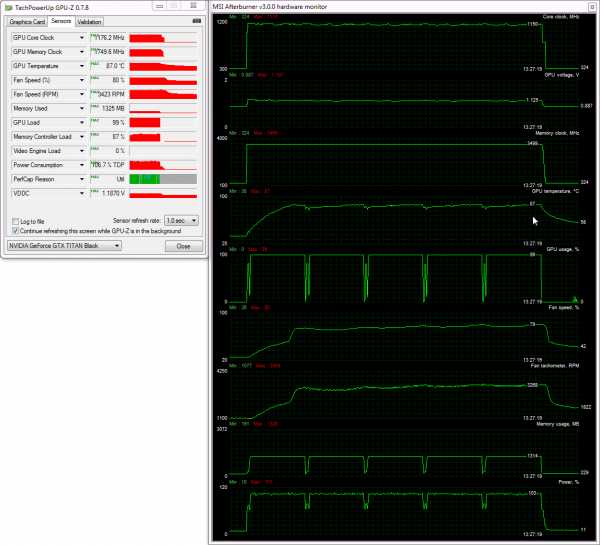

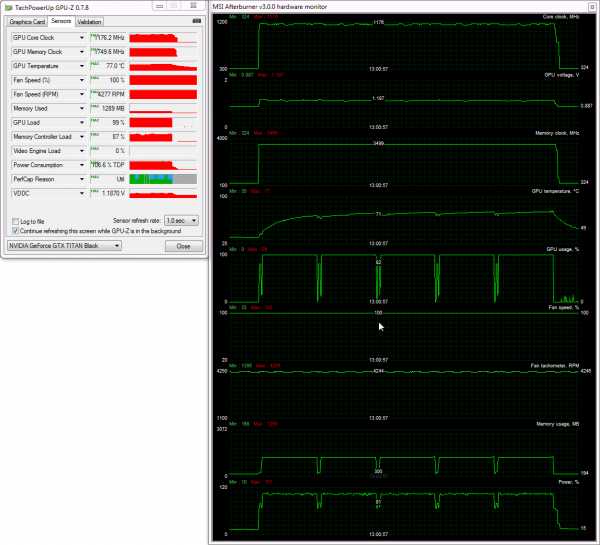

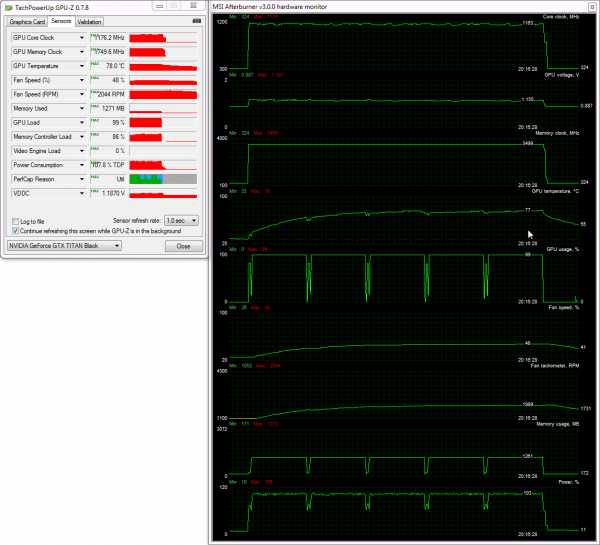

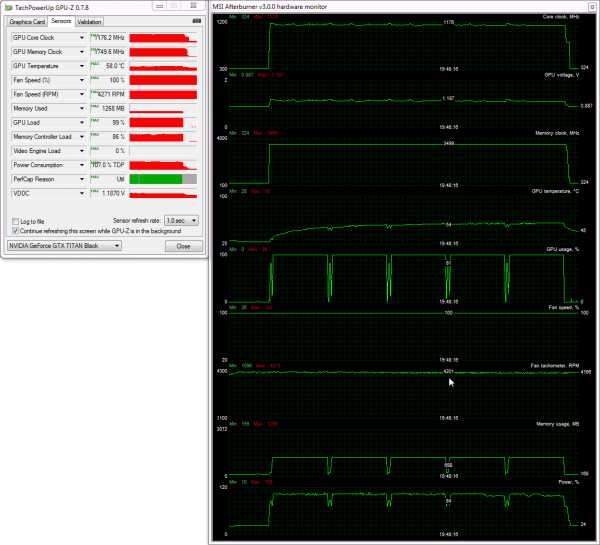

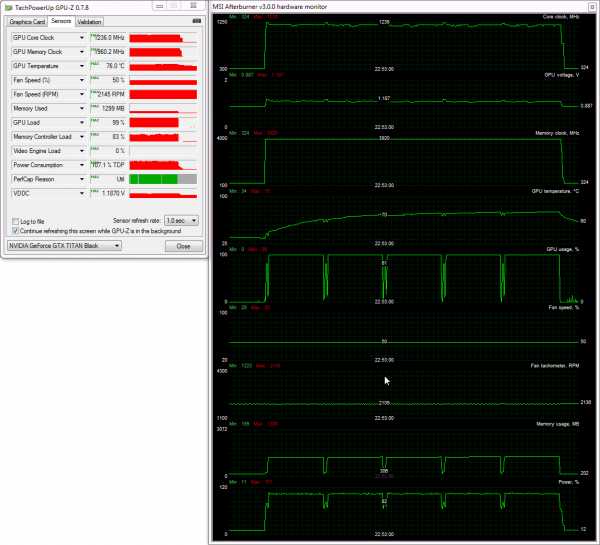

Для проверки температурного режима работы видеокарты Gigabyte GeForce GTX TITAN Black GHz Edition в качестве нагрузки мы использовали пять циклов теста весьма ресурсоёмкой игры Aliens vs. Predator (2010) при максимальном качестве графики в разрешении 2560х1440 пикселей с анизотропной фильтрацией уровня 16х и MSAA-сглаживанием степени 4x.

Для мониторинга температур и всех прочих параметров применялись программа MSI Afterburner версии 3.0.0 и утилита GPU-Z версии 0.7.8. Все тесты проводились в закрытом корпусе системного блока, конфигурацию которого вы сможете увидеть в следующем разделе статьи, при средней комнатной температуре 26,5 °C.

При автоматической регулировке скорости вентилятора кулера температурный режим работы видеокарты Gigabyte почти такой же, как у ZOTAC GeForce GTX TITAN Black: температура графического процессора достигла 87 градусов Цельсия, но вот скорость вентилятора оказалась выше — 3420 об/мин.

Автоматический режим

Правда, здесь нужно учитывать и тот факт, что температура окружения во время этого тестирования была на 1,5 градуса Цельсия выше, чем в случае с видеокартой ZOTAC.

Если же выставить скорость вентилятора на максимум (4280 об/мин по данным мониторинга), то пиковая температура графического процессора не превысит 77 градусов Цельсия.

Максимальная скорость

То есть можно сказать, что это вполне штатные температурные режимы работы для видеокарт класса GeForce GTX TITAN/TITAN Black/780 Ti.

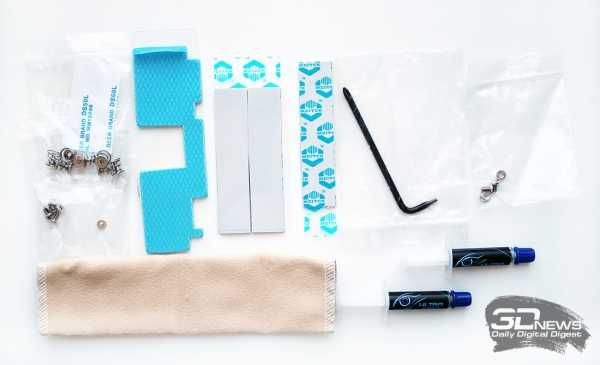

Gigabyte WINDFORCE 3X 600W укомплектована набором винтов, термопрокладками, специальной мягкой тряпочкой для очистки, г-образным ключом и двумя шприцами термопасты.

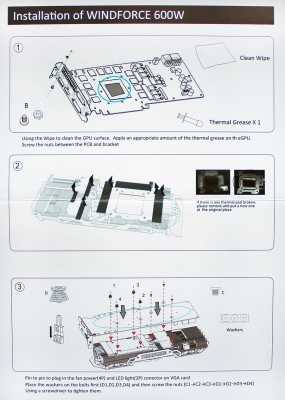

Входит в комплект и пошаговая инструкция по установке с подробным описанием всего процесса, начиная с демонтажа штатного кулера.

|  |

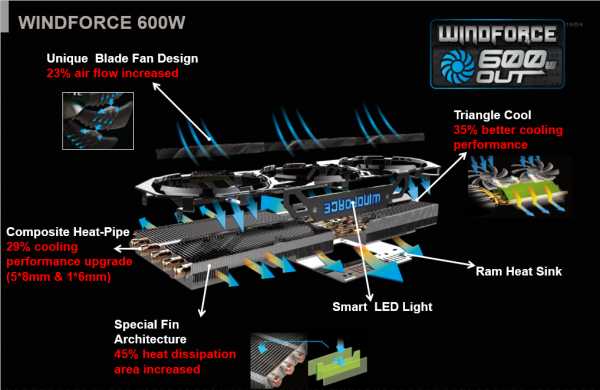

Gigabyte WINDFORCE 3X 600W является дальнейшим развитием оригинальных систем охлаждения серии WindForce и имеет ряд нововведений. В целом этот кулер сравнительно компактен, а по толщине не выходит за пределы двухслотового дизайна.

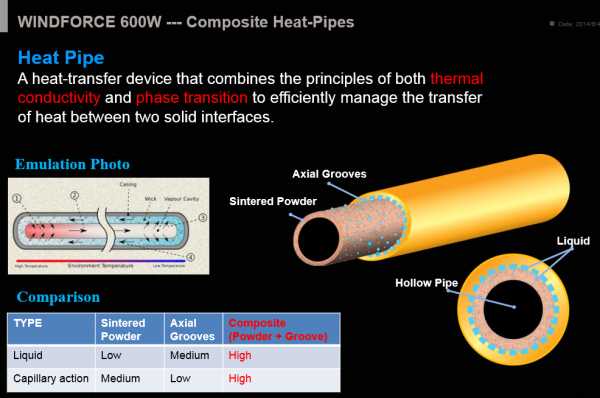

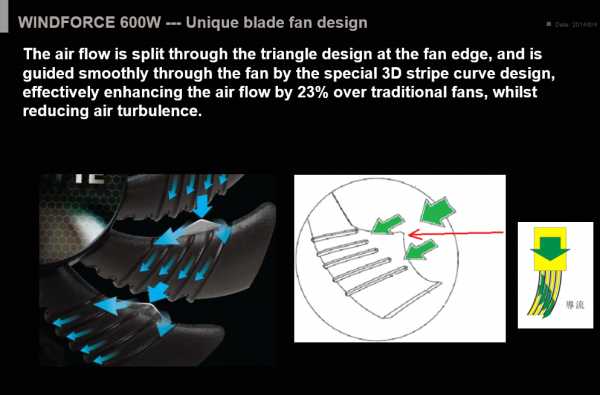

Система охлаждения является сочетанием алюминиевого радиатора с технологией Triangle Cool и специальной структурой рёбер на новых композитных тепловых трубках и алюминиевой рамки с тремя современными вентиляторами с увеличенным объёмом воздушного потока.

Всего в радиаторе пять медных тепловых трубок диаметром 8 мм и одна тепловая трубка диаметром 6 мм.

|  |

Трубками пронизаны обе секции очень плотного радиатора, кроме того, они контактируют с медным основанием по всей его длине. Контакт тепловых трубок с пластинами и основанием осуществлён пайкой.

Композитные тепловые трубки, применённые в Gigabyte WINDFORCE 3X 600W, за счёт дополнительного слоя капилляров обеспечивают более эффективный теплообмен между компонентами радиатора.

Модернизированы и вентиляторы — теперь на их лопастях появилось по пять насечек и дополнительный «плавник» на переднем торце.

По мнению инженеров Gigabyte, данные оптимизации позволили не только уменьшить турбулентность нагнетаемого в радиатор воздушного потока, но и увеличить его объём сразу на 23% в сравнении с вентиляторами с традиционной формой лопастей.

Регулировка скорости вентиляторов осуществляется посредством PWM-модуляции в диапазоне от 1000 до 4300 об/мин. Помимо всего прочего, система охлаждения Gigabyte WINDFORCE 3X 600W оснащена «умной» подсветкой на верхней грани кожуха, но почему её так назвали — нам не очень понятно, так как во время тестирования подсветка всегда была синего цвета.

Кулер устанавливается на видеокарту элементарно, нужно только не забыть снять защитные плёнки с его термопрокладок и нанести термоинтерфейс на кристалл графического процессора. В результате длина видеокарты увеличивается на 20 мм, но в целом WINDFORCE 3X 600W выглядит очень компактной.

Первая проверка Gigabyte WINDFORCE 3X 600W на видеокарте подтвердила, что система охлаждения получилась весьма удачной.

Автоматический режим

Уже в автоматическом режиме работы вентиляторов кулера, когда их скорость очень плавно увеличивалась с бесшумных 1000 об/мин до сравнительно комфортных 2040 об/мин, максимальная температура графического процессора видеокарты достигла отметки 78 градусов Цельсия. Это почти на 20 (!) градусов Цельсия лучше, чем у эталонного кулера, не говоря про существенно более низкий уровень шума. На наш взгляд, для самой быстрой однопроцессорной видеокарты это попросту великолепный результат!

Если же такой эффективности охлаждения разогнанной на заводе GeForce GTX TITAN Black будет недостаточно, то можно задать вентиляторам кулера максимальную скорость и получить такие же температуры, как при использовании бюджетного жидкостного охлаждения.

Максимальная скорость

Шутка ли, температура GPU в этом случае не превышает 58 градусов Цельсия. А речь идёт, напомним, о кристалле GK110-B1, частота которого во время тестирования автоматически увеличивалась до 1176 МГц. Инженерам Gigabyte удалось создать поистине уникальную систему охлаждения с крайне высоким уровнем эффективности. Как у неё обстоят дела с уровнем шума, сейчас мы с вами узнаем.

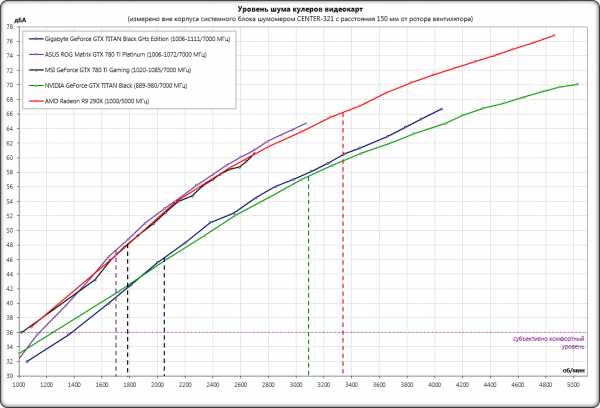

Измерение уровня шума систем охлаждения видеокарт осуществлялось с помощью электронного шумомера CENTER-321 после часа ночи в полностью закрытой комнате площадью около 20 м2 со стеклопакетами. Уровень шума измерялся вне корпуса системного блока, когда источником шума в комнате являлась только система охлаждения и её вентиляторы. Шумомер, зафиксированный на штативе, всегда располагался строго в одной точке на расстоянии ровно 150 мм от ротора вентилятора/турбины кулера. Материнская плата, в которую была вставлена видеокарта с установленной на неё системой охлаждения, размещалась на самом углу стола на пенополиуретановой подложке. Нижняя граница измерений шумомера составляет 29,8 дБА, а субъективно комфортный (не путать с низким) уровень шума при измерениях с такого расстояния находится около отметки 36 дБА. Скорость вращения вентиляторов изменялась во всём диапазоне их работы с помощью специального точного контроллера путём изменения питающего напряжения с шагом 0,5 В.

На график и в таблицу с уровнем шума системы охлаждения видеокарты Gigabyte GeForce GTX TITAN Black GHz Edition мы включили результаты измерений уровня шума эталонных видеокарт NVIDIA GeForce GTX TITAN Black и AMD Radeon R9 290X, а также оригинальных видеокарт MSI GeForce GTX 780 Ti Gaming и ASUS ROG Matrix GTX 780 Ti Platinum, последняя из которых ещё и принимает участие в сегодняшних тестах производительности. Вертикальными пунктирными линиями соответствующего цвета отмечены верхние границы скорости систем охлаждения при их автоматической PWM-регулировке.

Несмотря на достаточно серьёзных соперников в лице MSI GeForce GTX 780 Ti Gaming и ASUS ROG Matrix GTX 780 Ti Platinum с оригинальными системами охлаждения, новая Gigabyte GeForce GTX TITAN Black GHz Edition с кулером WINDFORCE 3X 600W выигрывает у них по уровню шума. Во всём скоростном диапазоне работы трёх вентиляторов Gigabyte они шумят меньше, чем вентиляторы на MSI или ASUS, не говоря уже про эталонный кулер видеокарты AMD Radeon R9 290X. Эталонная NVIDIA GeForce GTX TITAN по уровню шума вполне даже способна соперничать с GeForce GTX TITAN Black GHz Edition, правда только в абсолютных цифрах, ведь если посмотреть на границы работы вентиляторов этих систем охлаждения при автоматической регулировке, то преимущество WINDFORCE 3X 600W нельзя не назвать колоссальным. В общем, в сегодняшних тестах новинка является лидером по уровню шума. Особо отметим бесшумность работы видеокарты в 2D-режиме, чего нельзя сказать обо всех остальных оригинальных системах охлаждения.

⇡#Оверклокерский потенциал

Честно говоря, при столь высоком заводском разгоне графического процессора особых надежд на дополнительное поднятие его частоты мы не возлагали, однако ещё немного всё же удалось выжать. Без потери стабильности и появления дефектов изображения графический процессор был разогнан ещё на 60 МГц, а эффективную частоту видеопамяти мы подняли на 840 МГц.

В результате частоты видеокарты составили 1066-1171/7840 МГц, то есть почти столько же, сколько мы получили при разгоне ZOTAC GeForce GTX TITAN Black.

Примечательно, что после разгона температурный режим работы видеокарты не изменился, разве что скорость вентиляторов немного выросла.

Поскольку эффективность кулера Gigabyte WINDFORCE 3X 600W очень высокая, мы рискнули попробовать разгон и с увеличением напряжения на GPU, что позволило поднять его частоту на 110 МГц, однако это уже сопровождалось дефектами рендеринга картинки в виде полос или мерцания отдельных текстур. То есть для каких-нибудь личных рекордов разогнать видеокарту так, конечно, можно, но, увы, играть на ней при таких частотах не выйдет.

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

3dnews.ru