Обзор видеокарты ASUS TUF Gaming GeForce RTX 3080 Ti OC. NVIDIA заигралась

09.07.21

Недавно NVIDIA пополнила семейство видеокарт GeForce RTX 3000, основанных на архитектуре Ampere, моделями RTX 3080 Ti и RTX 3070 Ti.

Они являются более производительными версиями RTX 3080 и RTX 3070.

В нашем тесте мы рассматриваем модель ASUS ROG Strix GeForce RTX 3080 Ti OC, основанную, как нетрудно догадаться, на базе RTX 3080 Ti. Это графический адаптер самой верхней категории.

Сравнение референсных характеристик видеокарт NVIDIA GeForce RTX 30890, RTX 3080 Ti и RTX 3080

Судя по характеристикам, RTX 3080 Ti разместилась между RTX 3080 и флагманской RTX 3090.

Если не считать объем видеопамяти, который вырос с 10 до 12 ГБ, то по большинству параметров новая RTX 3080 Ti вплотную приблизилась к RTX 3090.

Знакомимся с ASUS TUF Gaming GeForce RTX 3080 Ti OC (TUF-RTX3080TI-O12G-GAMING)

Современные видеокарты ASUS TUF-серии уже неоднократно были у нас на обзорах.

Представленная в тесте ASUS ROG Strix GeForce RTX 3080 Ti OC является практически копией ASUS ROG Strix GeForce RTX 3080 (без приставки Ti), которую мы рассматривали ранее.

В коробке помимо видеокарты что-то примечательное отметить сложно. Каких-то дополнительных бонусов, вроде коврика, фирменных стяжек или наклеек тут нет.

Модель получилась крупной, но по сравнению с 3080 Ti серии ASUS ROG Strix она не такая длинная и не такая широкая.

На наш взгляд, выглядит ASUS TUF Gaming GeForce RTX 3080 Ti OC очень классно. Причем отдельно заметим, что лицевая и задняя панели — металлические.

Радиатор обдувают три фирменных вентилятора одинакового размера. ASUS иногда ставит центральный вентилятор с большим числом лопастей, но не в этот раз.

Центральный вентилятор крутится в другую сторону по сравнению с боковыми, что должно более оптимально распределять воздушные потоки.

На обратной стороне хорошо заметены вырезы. За счет них небольшая часть радиатора продувается «насквозь».

Отдельный переключатель отвечает за выбор микросхем BIOS с режимами P (Performance) и Q (Quiet). Подробнее об их отличиях мы расскажем далее.

В районе GPU на оборотной стороне платы ASUS решила использовать исключительно керамические MLCC-конденсаторы (теоретически это некоторое достоинство).

С такой мощностью (TDP для видеокарт на базе RTX 3080 Ti составляет 350 ВТ) ожидаешь наличия трех 8Pin-разъемов питания, но производитель реализовал схему с двумя. Нюансы такого решения мы укажем в разделе, связанном с энергопотреблением.

Набор разъемов включает три выхода DisplayPort и два HDMI.

Довольно существенным отличием видеокарт серии ASUS TUF от ASUS ROG Strix является более скромная подсветка.

Подсвечиваются только два небольших элемента (полоса и логотип ASUS TUF). При этом есть выбор цвета и эффектов с возможностью синхронизации с другими компонентами.

При этом есть выбор цвета и эффектов с возможностью синхронизации с другими компонентами.

Система охлаждения

Судя по всему, модели TUF-серии RTX 3080 Ti и RTX 3080 используют идентичную систему охлаждения.

Крупный радиатор содержит серию тепловых трубок. Кристалл графического процессора соприкасается с теплораспределительной плитой через которую проходят тепловые трубки. Теоретически это более выигрышное, но и более дорогое решение по сравнению с технологией «прямого контакта» тепловых трубок.

Любопытно, что чипы памяти охлаждаются отдельной металлической рамкой, а не соприкасаются с основным радиатором.

Задняя пластина помимо декоративной роли и механической защиты принимает также участие и в охлаждении. На нее через термопрокладки отводится некоторая часть тепла от платы.

В режиме с малыми нагрузками, когда температура GPU опускается ниже заданного значения, вентиляторы полностью останавливаются.

Система охлаждения получилась очень продвинутой, но и энергоаппетиты у ASUS TUF Gaming GeForce RTX 3080 Ti OC немалые. Будет интересно посмотреть, насколько эффективным получился отвод тепла.

Небеспроблемный первый запуск

Первый запуск видеокарты ASUS TUF Gaming GeForce RTX 3080 Ti OC на нашей материнской плате ASUS TUF Z390-PRO GAMING оказался неудачным. Видеокарта просто не определялась на этапе инициализации устройств.

Сменив тип подключения с DisplayPort на HDMI все проблемы ушли и система заработала без каки-либо проблем.

Видимо, мы наткнулись на какие нюансы совместимости. Погуглив, обнаружили, что мы не одиноки и некоторые другие пользователи также испытывают подобные неудобства.

Причем, судя по упоминаниям, проблема касается не только нашей TUF Gaming GeForce RTX 3080 Ti OC, а в целом многих моделей на базе RTX 3080 Ti от разных производителей.

Возможно, это решится банальным выходом новой прошивки BIOS, но на момент подготовки материала (начало июля) такого обновления ни для видеокарты, ни для материнской платы не было.

Дополнение от 2021.08.16:

Как и предполагали, компания ASUS выпустила в августе обновление прошивки (Version V1) для данной видеокарты. В описании указано, что решается вышеуказанная проблема с подключением по DisplayPort.

Проверяем в работе: частоты, энергопотребление, температуры, шум

В названии ASUS TUF Gaming GeForce RTX 3080 Ti OC приставка «OC» (overclocking) подразумевает некоторый заводской разгон по сравнению с референсной RTX 3080 Ti.

Действительно, Boost-частота GPU повышена со стандартных 1665 до 1755 МГЦ. А вот память без разгона. Ее результирующая частота — 19 000 МГц.

На практике максимальная частота GPU зависит от игр и приложений. В играх, которые нагружают видеокарту до предела энергопотребления, частота составляет примерно 1750 –1850 МГц. Такую картину наблюдали, например, в Witcher 3, тесте 3DMark Time Spy.

В нашей системе в Assassin’s Creed Valhalla до лимита энергопотребления видеокарта не доходила и предельная частота GPU держалась на более высоком уровне — 1950 –1980 МГц.

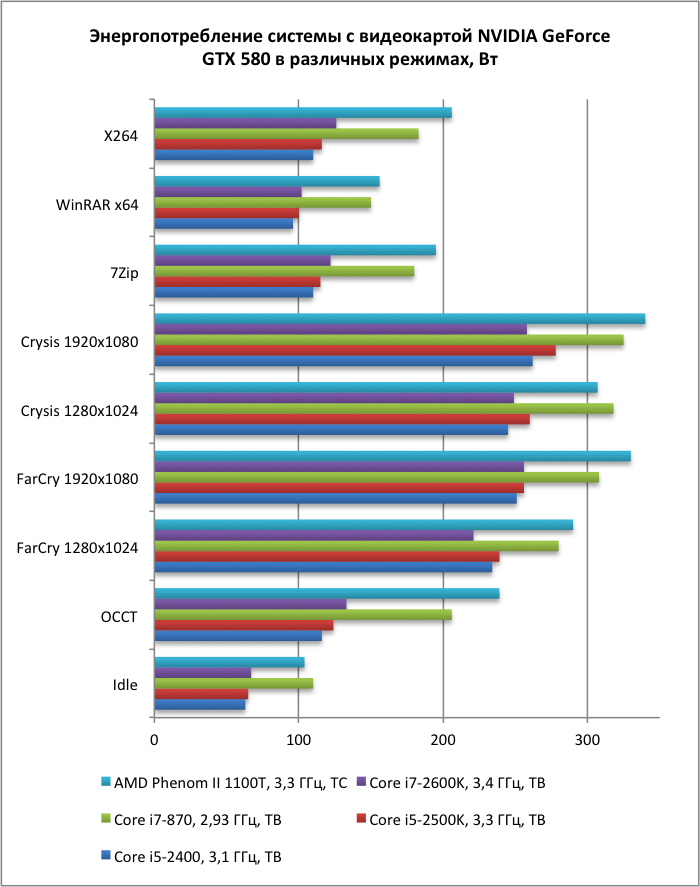

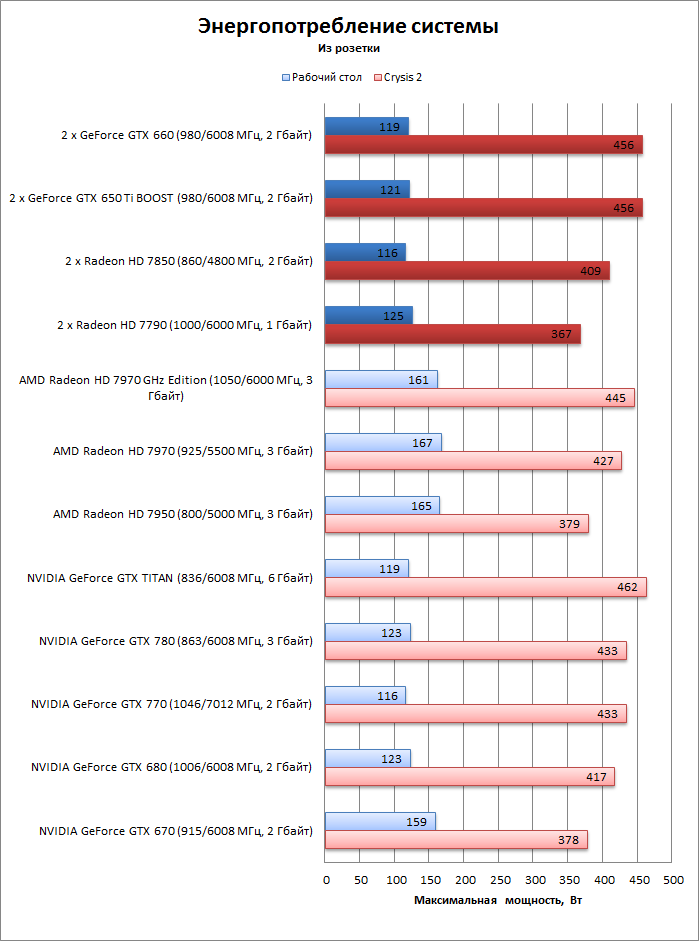

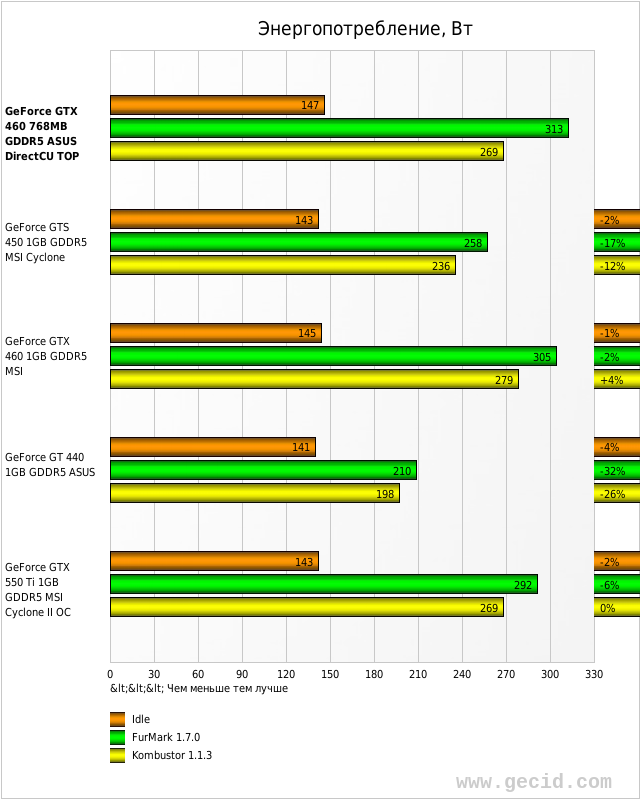

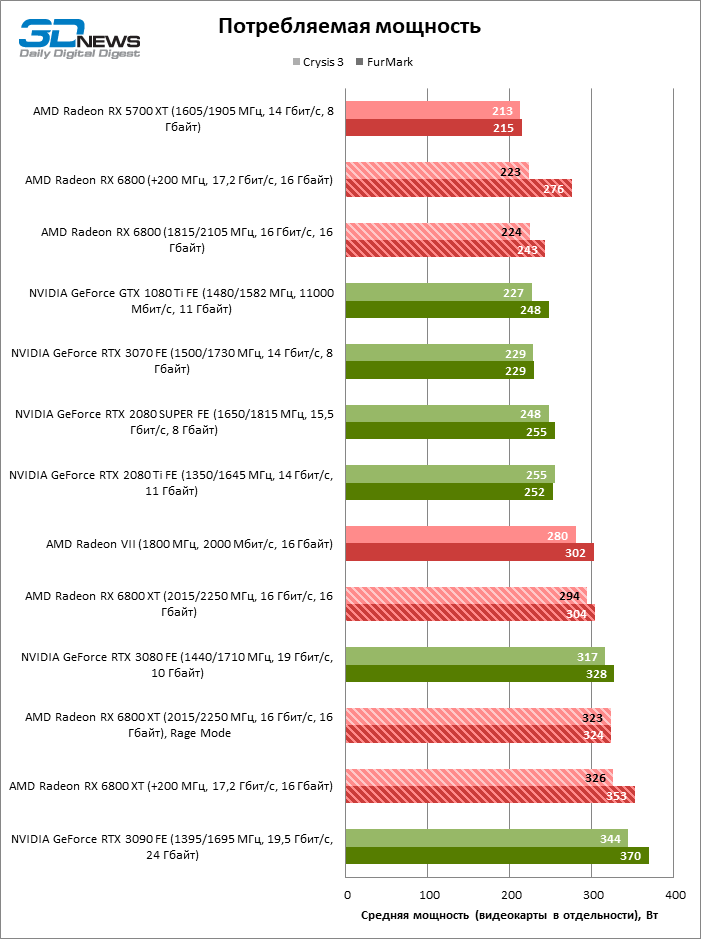

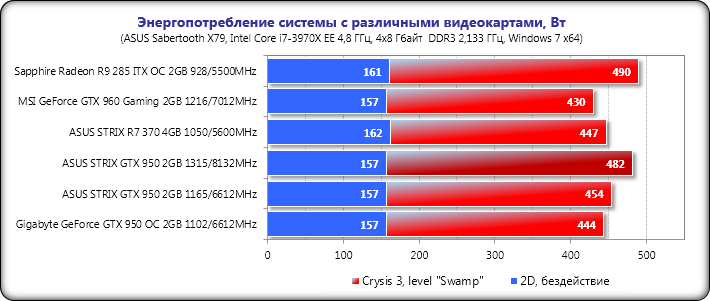

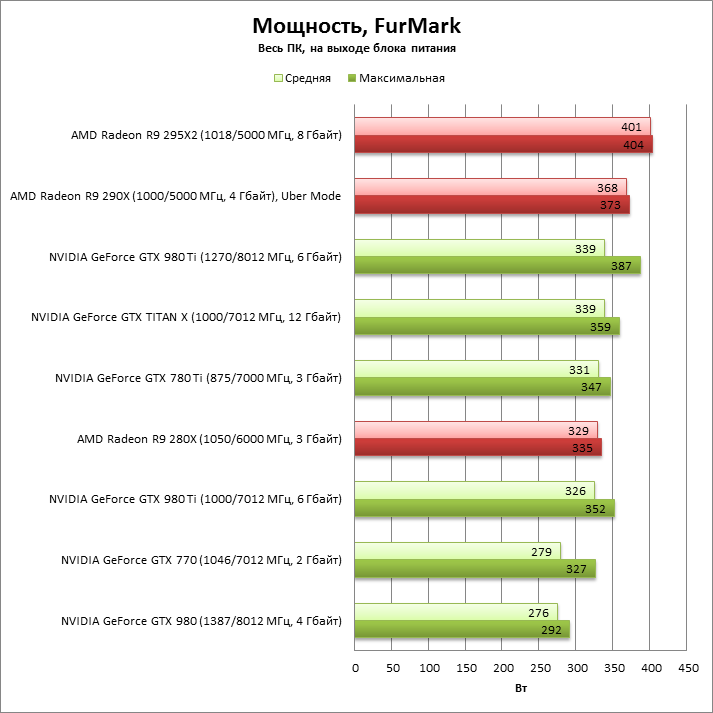

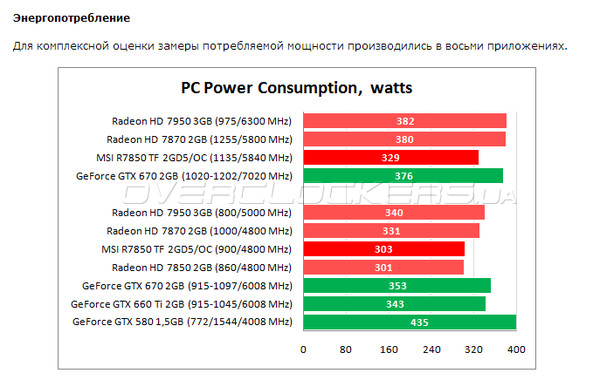

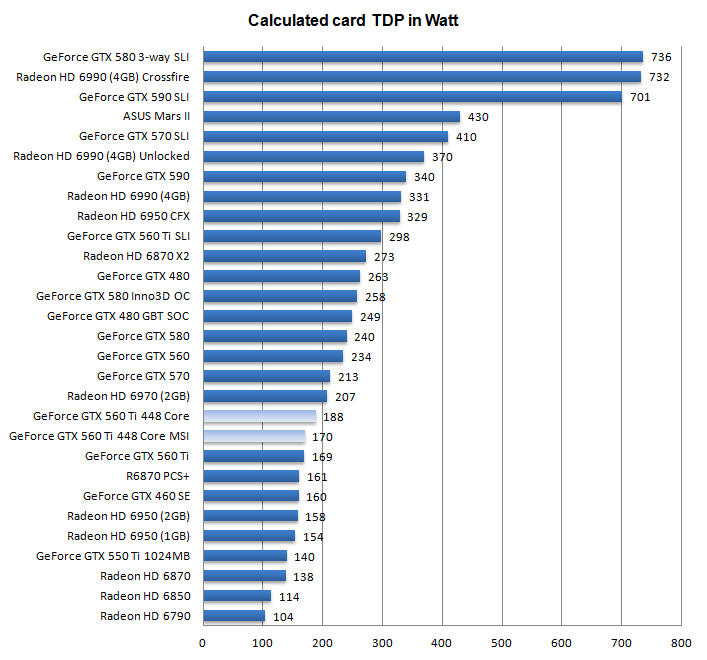

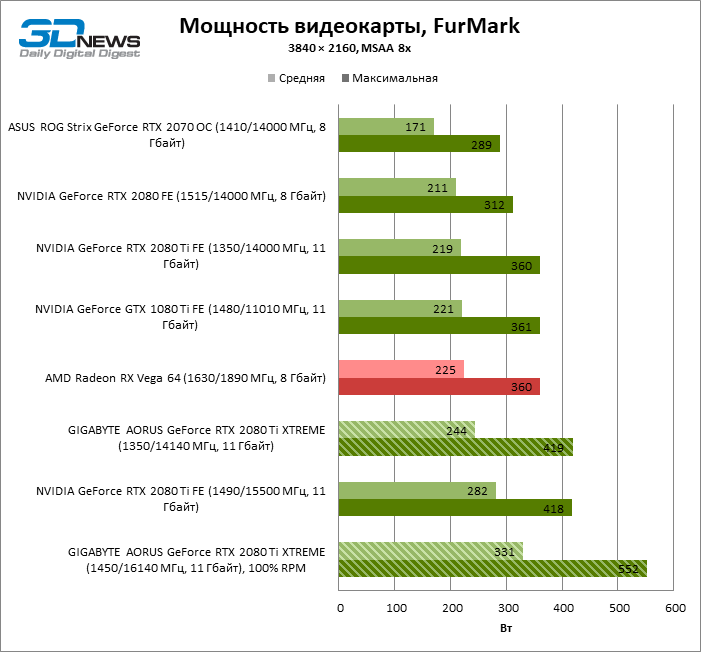

Энергопотребление ASUS TUF Gaming GeForce RTX 3080 Ti OC полностью соответствует референтному — 350 Вт при максимальной нагрузке. Это, конечно, очень немало, но таковы реалии сегмента топовых видеокарт.

В видеокартах подобной мощности нередко можно видеть три разъема дополнительного питания, но тут распаяны всего два.

У данного решения есть как достоинства, так и недостатки.

Многие блоки питания мощностью около 600 Вт, которых, в общем-то будет достаточно для системы с RTX 3080 Ti, имеют всего два коннектора для видеокарт. Соответственно, сложностей с подключением ASUS TUF Gaming GeForce RTX 3080 Ti OC в таком случае не будет.

С другой стороны, из-за меньшего числа разъемов питания, при максимальной нагрузке все каналы питания нагружаются почти до предусмотренного предела.

Предусмотренный предел для двух 8Pin-разъемов — это 150 + 150 Вт. По шине PCI-e может передаваться еще до 75 Вт. Суммарно получается 375 Вт, при том, что видеокарта потребляет до 350 Вт.

Суммарно получается 375 Вт, при том, что видеокарта потребляет до 350 Вт.

Распределение питания под нагрузкой по «каналам» 8pin1, 8Pin2 и шине PCI-e

Это накладывает дополнительные требования к качеству коннекторов, проводов. Никакого «колхоза» с применением переходников тут быть не должно.

Также могут быть нюансы с существенной просадкой напряжения при использовании блоков питания с групповой стабилизацией (это БП начального уровня).

Лимит энергопотребления можно увеличить всего до 107%.

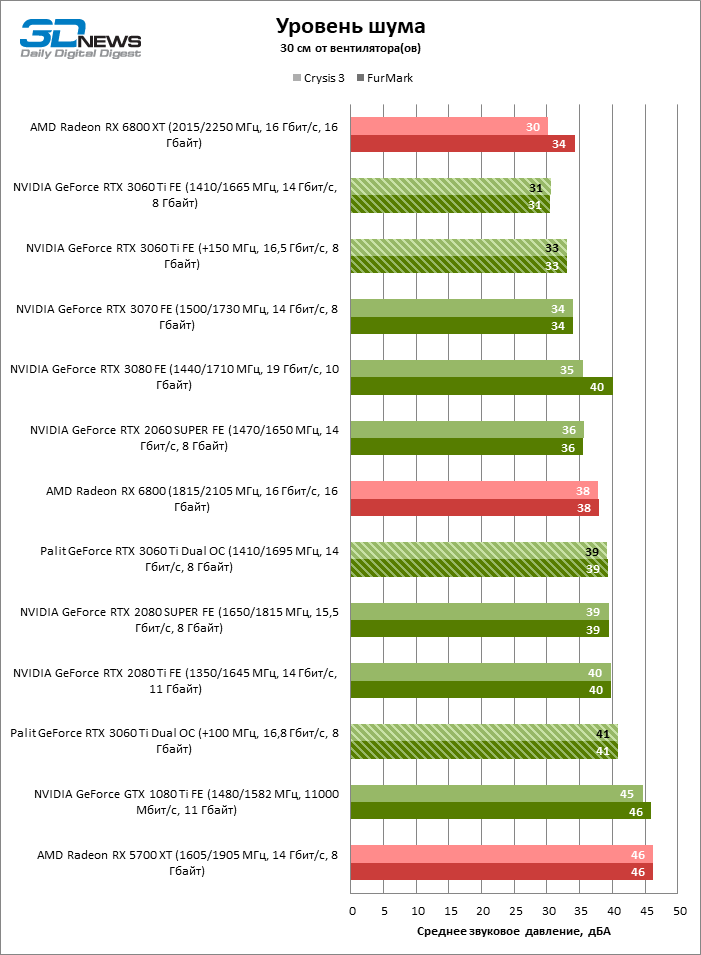

По нашим наблюдениям, два режима P (Performance) и Q (Quiet), которые выбираются механическим переключателем на плате, отличаются профилями работы вентиляторов. Разницы в частотах, потреблении в данных режимах мы не заметили.

Режим P удерживает более низкий уровень температур за счет повышенных оборотов вентиляторов. Соответственно, в Q (Quiet)-режиме видеокарта работает несколько тише, но температуры получаются немного больше.

Параметры видеокарты по данным GPU-Z (слева включена микросхема BIOS с P-режимом, справа — с Q-режимом)

Дополнительным источником внимания является температура видеопамяти. Дело в том, что память GDDR6X, которая стоит на борту RTX 3080, RTX 3080 Ti, RTX 3090, греется заметно сильнее памяти GDDR6. В некоторых видеокартах температура микросхем памяти GDDR6X может доходить до весьма пугающих значений (100 °C и выше).

Показания температуры видеопамяти для данной видеокарты можно отслеживать в приложении GPU-Z.

Хотелось бы отдельно сказать, что тесты мы проводили в довольно сложных (для видеокарты) условиях при высокой комнатной температуре около 29 °C. Специально подобрали игру, где достигается максимальное энергопотребление (350 Вт).

Режим P (Performance)

Замеры параметров видеокарты в приложении MSI Afterburner (режим Performance)

Температура GPU стабилизировалась на уровне 66 °C при оборотах около 2150 об. /мин. Работа вентиляторов становится, скажем так, ощутимой на слух, но, при этом, видеокарту шумной не назовешь.

/мин. Работа вентиляторов становится, скажем так, ощутимой на слух, но, при этом, видеокарту шумной не назовешь.

Температура видеопамяти доходила до 84–86 °C.

Режим Q (Quiet)

Температура GPU стабилизировалась на уровне 72 °C при скорости вентиляторов около 1550 об./мин.

Сниженные обороты в данном режиме сделали видеокарту ощутимо более тихой.

Температура видеопамяти доходила уже до 92–94 °C. Мы бы не назвали это экстремальным уровнем, но, пожалуй, при высокой температуре в помещении или в условиях недостаточной продувки корпуса режим Performance является более оптимальным, если речь идет о работе с максимальным энергопотреблением.

К слову, профиль работы вентиляторов вы можете настраивать самостоятельно. Мы описываем лишь варианты, которые заложил производитель изначально.

Несмотря на сложные условия тестов и высокое энергопотребление видеокарты, система охлаждения ASUS TUF Gaming GeForce RTX 3080 Ti OC в целом хорошо справилась с отводом тепла.

По части «свиста дросселей» данная видеокарта оказалась чуть ли не самой тихой из всех, которые мы тестировали с начала года.

Производительность

Конфигурация тестовой системы:

- Процессор: Intel Core i5-9600KF с разгоном до 4,8 ГГц по всем ядрам

- Процессорный кулер: Thermalright MUX-120 + вентилятор Arctic P12 PWM

- Материнская плата: ASUS TUF Z390-PRO GAMING

- Оперативная память: 2×8 ГБ DDR4 3200 МГц (Kingston HyperX FURY DDR4 RGB HX432C16FB3AK2/16)

- Накопители: ADATA S511 120 ГБ (система) + Goodram SSD IRDM M.2 1 ТБ

- Блок питания: Enermax Revolution D.F. 650W

- Используемый драйвер с видеокартой ASUS TUF Gaming GeForce RTX 3080: 456.55

- Используемый драйвер с видеокартой ASUS TUF Gaming GeForce RTX 3080 Ti OC: 471.11

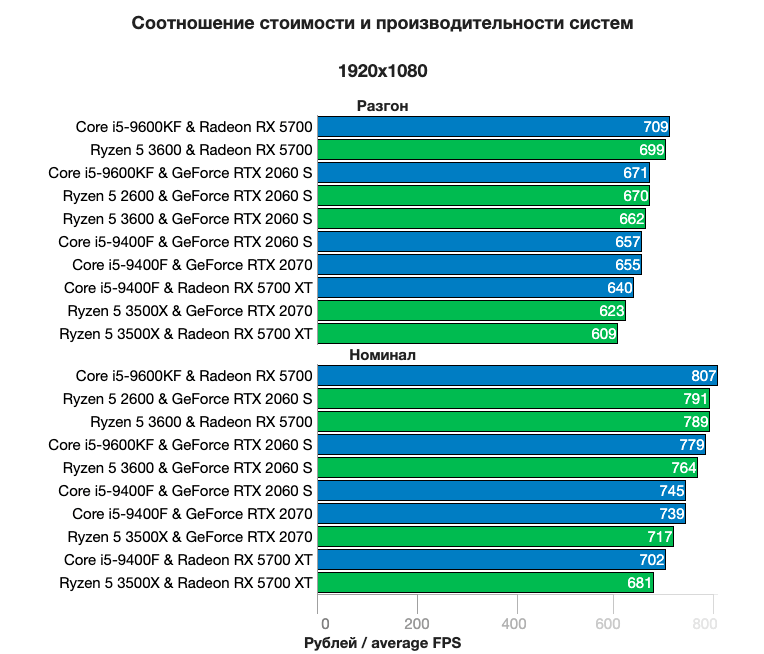

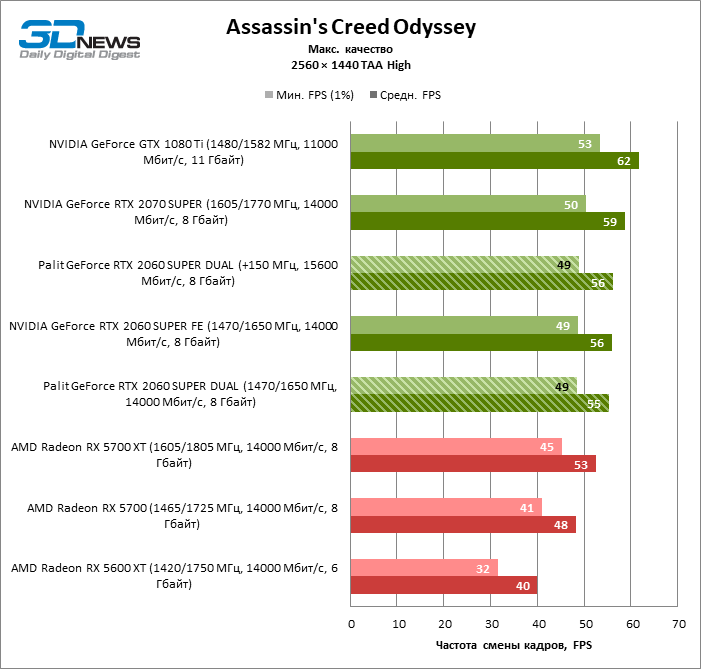

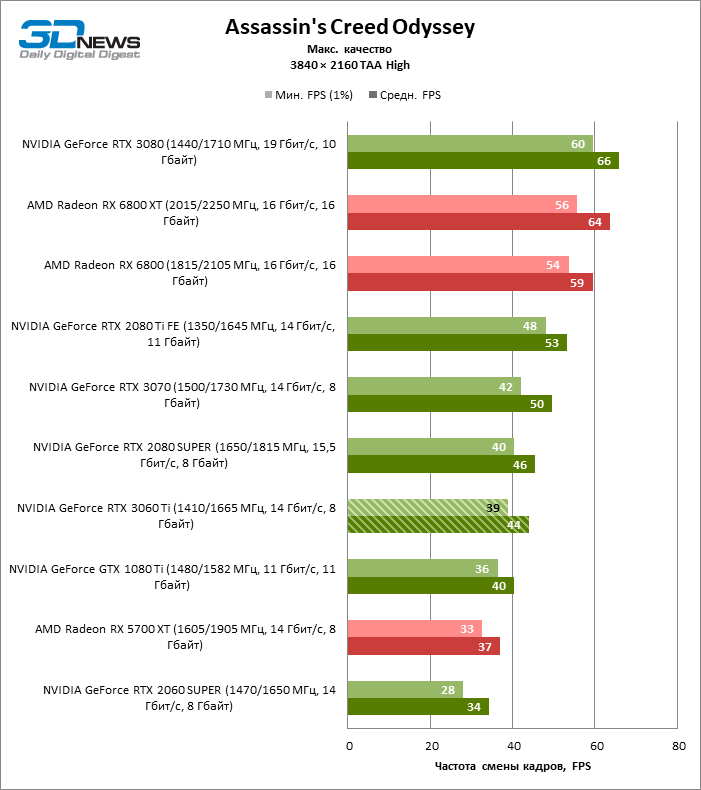

Рассматриваемую ASUS TUF Gaming GeForce RTX 3080 Ti OC мы сравнили с видеокартой на базе NVIDIA GeForce RTX 3080 в роли которой выступила ASUS TUF Gaming GeForce RTX 3080.

В играх использовали разрешение 2K (2560×1440 пикс.) и 4K (3820×2160 пикс.).

При переходе от разрешения 2K к 4K преимущество RTX 3080 Ti над RTX 3080 растет, что логично.

В целом же разница в производительности между данными моделями доходит до 10 –15%, в более редких случаях — чуть больше.

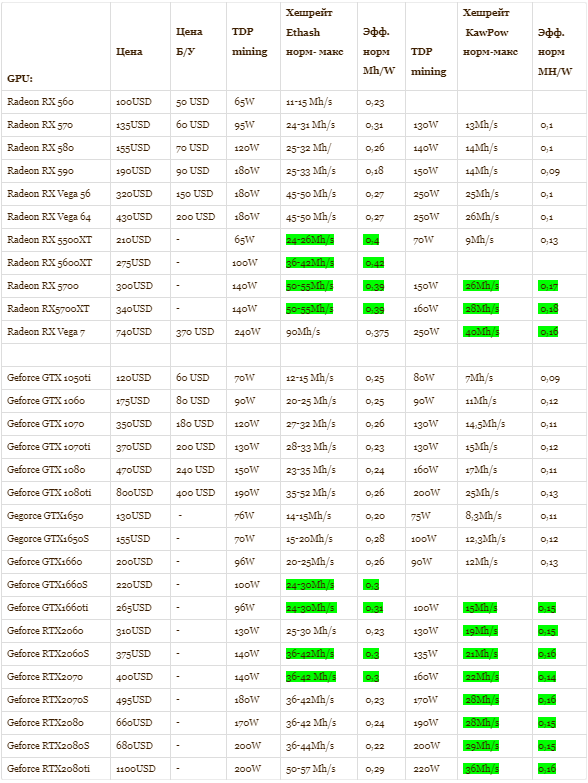

NVIDIA GeForce RTX 3080 Ti и майнинг

NVIDIA решила сделать свои новые видеокарты менее привлекательными для майнеров, вводя различные ограничения производительности при майнинге.

Такую особенность получили и графические адаптеры на базе RTX 3080 Ti. Причем, NVIDIA учла предыдущий опыт и защита ограничителя теперь более совершенная.

В данном случае, если не ошибаемся, ограничитель предусмотрен только для майнинга с использованием алгоритма хеширования Ethash. Это самый популярный алгоритм для майнинга на видеокартах и с его помощью добывается криптовалюта Ethereum (ETH).

С настройками по умолчанию хешрейт для добычи Ethereum (ETH) получился около 56 Mh/s при потреблении в районе 305 Вт.

Но так никто не майнит. Поэтому поэкспериментировали с настройками и после андервольтинга в сочетании с разгоном видеопамяти получили около 66 Mh/s при потреблении 210 Вт.

В таком режиме, при желании, температуру видеопамяти несложно держать ниже отметки 90 °C (алгоритм Ethash сильно нагружает именно видеопамять).

Для сравнения, RTX 3080 без ограничений майнинга может выдавать 90+ Mh/s.

Получается, что по соотношению хешрейта и энергопотребления RTX 3080 Ti лишь немного лучше «древних» видеокарт поколения GTX 1000 (Polaris) и это делает ее действительно не очень привлекательной для добытчиков криптовалют с учетом того, сколько она стоит.

Если же доходность майнинга увеличится в разы по сравнению с ситуацией на начало июля 2021, даже она станет интересна майнерам.

Выводы

Прибавка производительности на 10–15% по сравнению с RTX 3080 и большая 1,7-кратная разница в цене (речь о рекомендованных ценах). Именно так можно наиболее точно и коротко охарактеризовать новую RTX 3080 Ti.

RTX 3080 Ti — это не совсем то, чего ожидали пользователи. Вместо какой-то сравнительно доступной RTX 3050/3050 Ti, разбалованная диким спросом, по большей части вызванным именно майнинг-бумом, компания NVIDIA выкатывает очередного «монстра» верхней категории с далеко не самым привлекательным соотношением производительности и цены.

При просто великолепной производительности NVIDIA GeForce RTX 3080 Ti рискует оказаться не слишком интересной и для майнеров (из-за ограничений и цены), и для геймеров (RTX 3080 и более младшие модели более привлекательны по цене), и для профессионалов (для которых будет интереснее RTX 3090 с ее объемом памяти в 24 ГБ).

Но рекомендуемые цены, тем более для США, это одно, а рынок вполне может все расставить в соответствии со спросом.

К слову, с падением доходности майнинга цены на видеокарты чуть снизились по сравнению с ситуацией месячной давности, хотя по-прежнему очень высоки.

А к ASUS TUF Gaming GeForce RTX 3080 Ti OC (TUF-RTX3080TI-O12G-GAMING) у нас особых претензий нет.

Это очередная классная модель современной линейки ASUS TUF и весьма привлекательный вариант графической карты на базе RTX 3080 Ti.

Отвести тепло от платы с потреблением 350 Вт задача не из простых, но установленная система охлаждения справляется с этим очень достойно.

ASUS TUF Gaming GeForce RTX 3080 Ti OC еще не добралась до каталогов украинских магазинов поэтому конкретную цену не указываем. В целом же в первой половине июля видеокарты RTX 3080 Ti в Украине стоят около 60 000 грн ($2200).

| Характеристики ASUS TUF Gaming GeForce RTX 3080 Ti OC (TUF-RTX3080TI-O12G-GAMING) | |

| Модель: | NVIDIA GeForce RTX 3080 Ti |

| Интерфейс: | PCI Express 4. 0 ×16 0 ×16 |

| Графический процессор: | GA106 (Ampere) |

| Техпроцесс: | 8 нм |

| Видеопамять: | 12 ГБ, GDDR6X |

| Шина памяти: | 384 бит |

| Частота графического процессора: | 1365 (1755 boost) МГц |

| Частота памяти результирующая: | 19 000 МГц |

| Выходы: | 2×HDMI (2.1), 3× DisplayPort (1.4a) |

| Разъем дополнительного питания: | 2×8 Pin |

| Энергопотребление: | 350 Вт |

| Поставщик: | Представ-во ASUS |

| Рекомендованная цена в США: | $1199 |

| Условная цена в Украине (на момент публикации): | $2200 |

Оценка:

+ великолепная производительность

+ качественные материалы «корпуса»

+ эффективная система охлаждения

+ отключение вентиляторов при низкой нагрузке

+ двойной BIOS

— большие габариты

— высокое энергопотребление

— цена

Смотрите также:

Обзор видеокарты ASUS ROG Strix Radeon RX 6700 XT OC. Огромная видеокарта среднего класса

Огромная видеокарта среднего класса

Обзор видеокарты ASUS ROG Strix GeForce RTX 3060. Сильно ли отстает от RTX 3060 Ti?

Обзор видеокарты ASUS TUF GAMING Radeon RX 6800. У AMD получилось

Обзор видеокарты MSI GeForce RTX 3080 Suprim X 10G. Бентли в мире видеокарт

Обзор видеокарты MSI GeForce RTX 3080 GAMING X TRIO 10G. Сравниваем с RTX 2080 Super

Обзор видеокарты ASUS ROG Strix GeForce RTX 3070. С большим запасом

Обзор видеокарты ASUS TUF Gaming GeForce RTX 3080 и RGB-сборка ПК в стиле ASUS

evoИнженер тестовой лаборатории

Читайте также

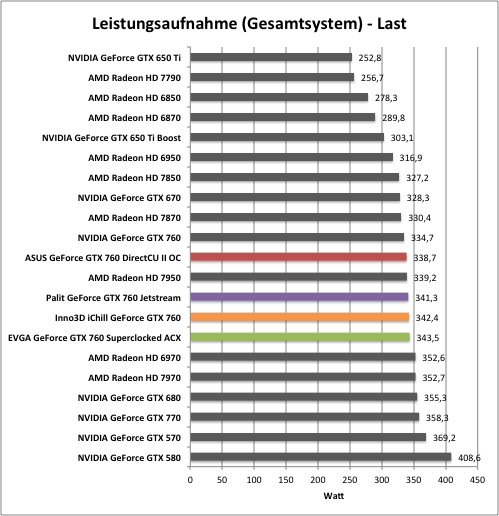

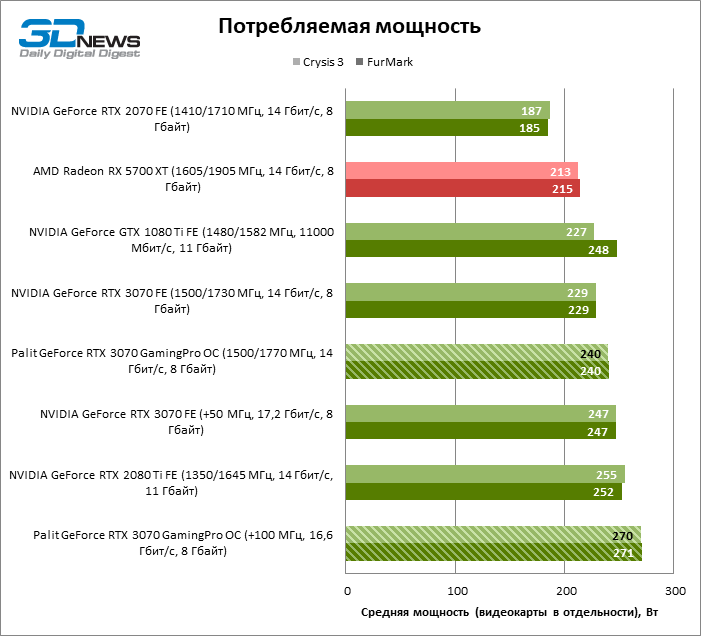

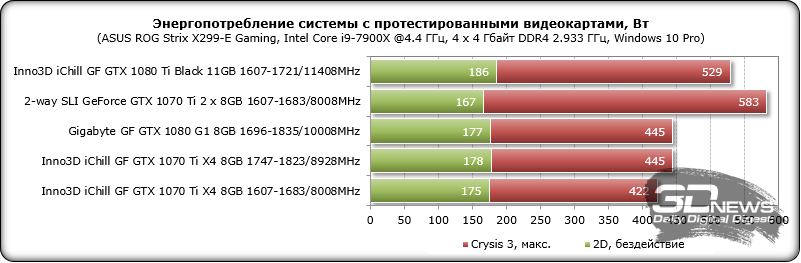

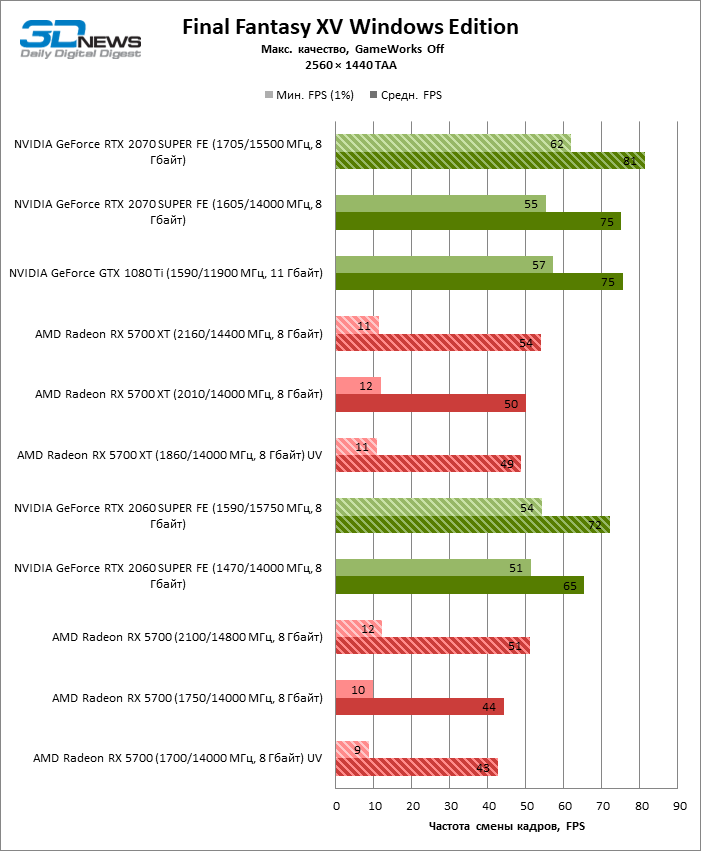

Сколько ватт потребляет видеокарта?

Опубликовано 4.10.2020 автор Андрей Андреев — 0 комментариев

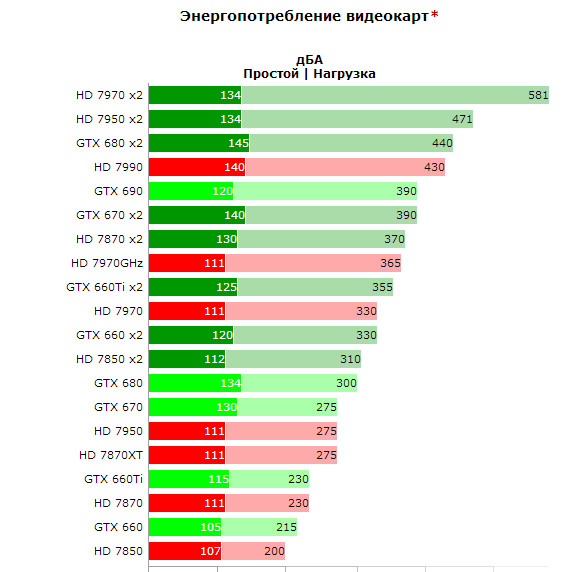

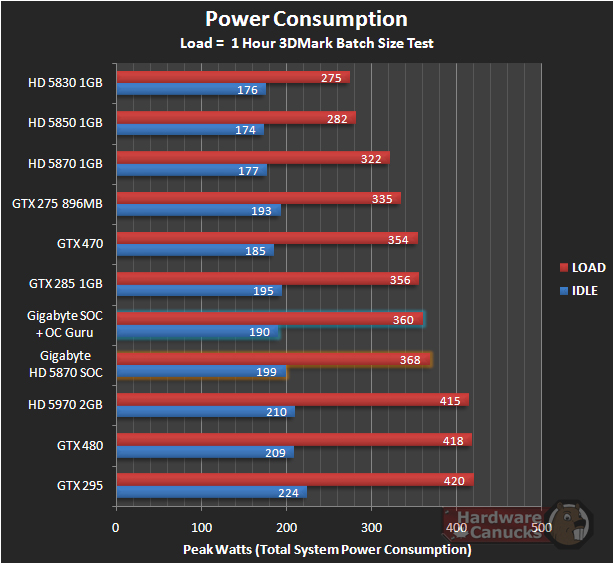

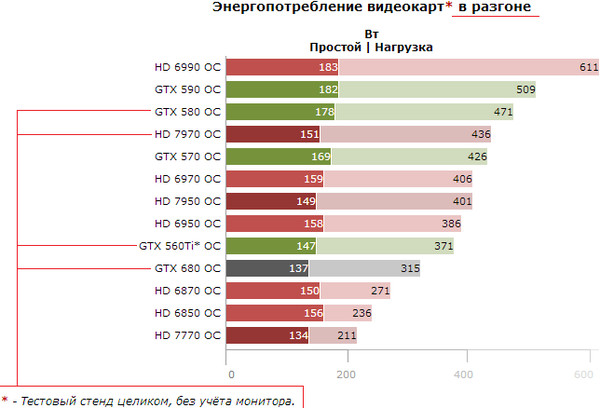

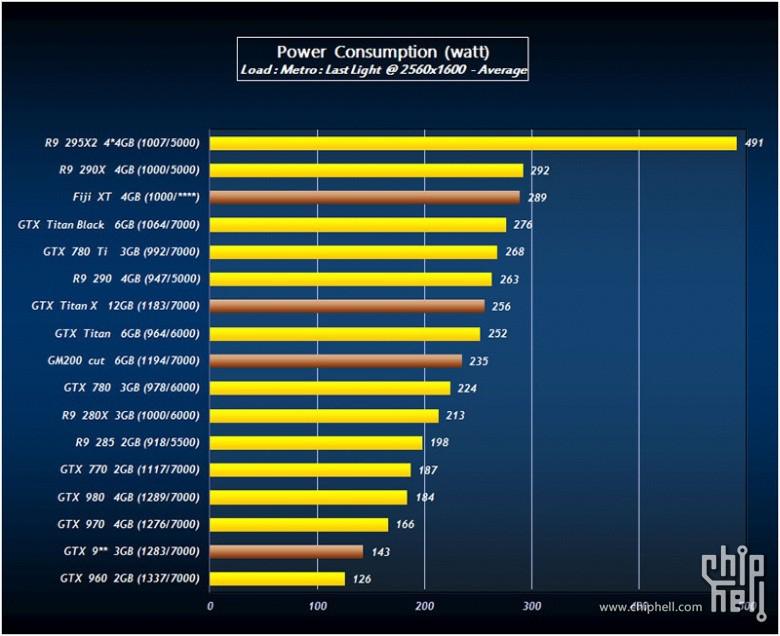

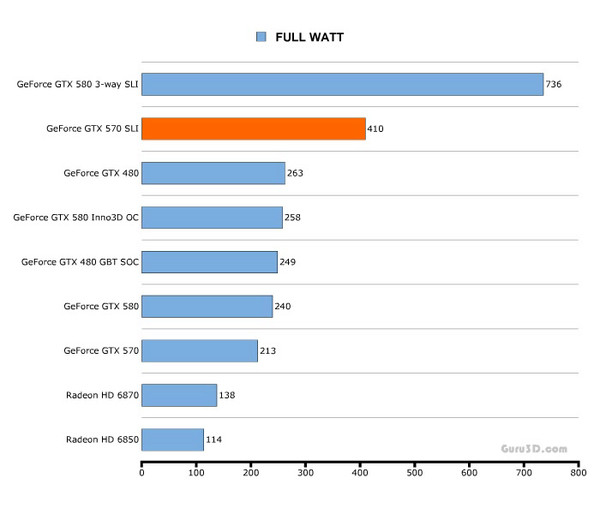

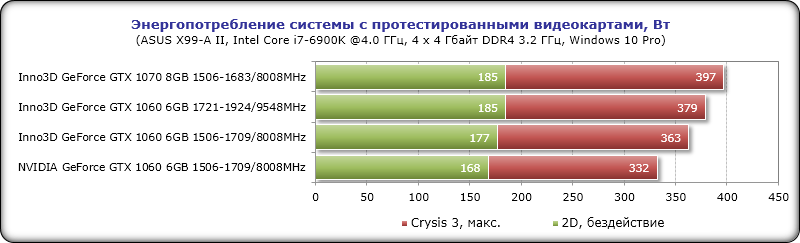

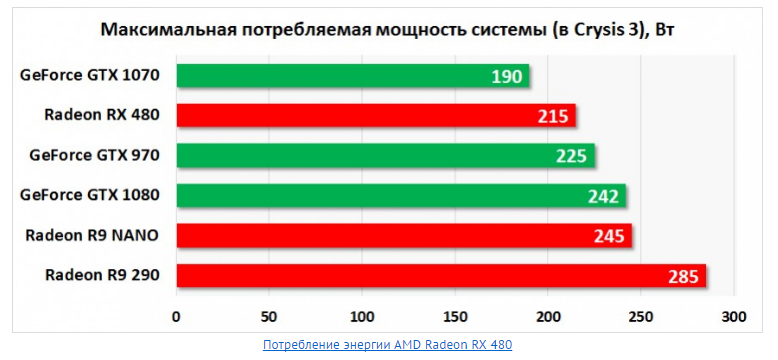

Всем привет! Сегодня поговорим, сколько ватт потребляет видеокарта на компьютере, как узнать эти характеристики по модели, почему разные карты потребляют разное количество энергии, какой мощности нужен БП.

О том, как узнать производителя видеокарты, разные способы, можно почитать здесь.

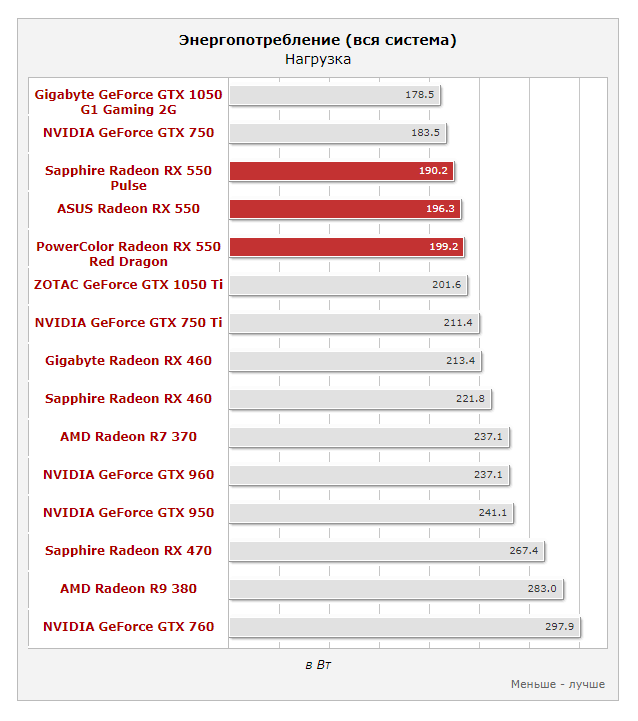

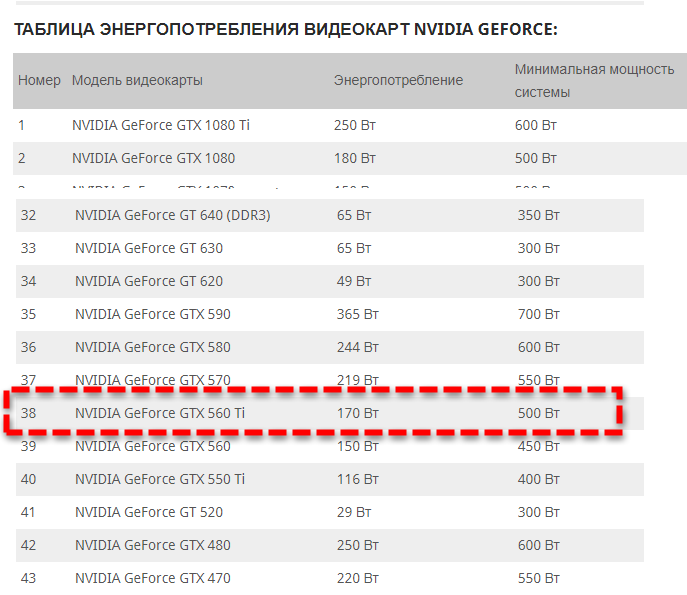

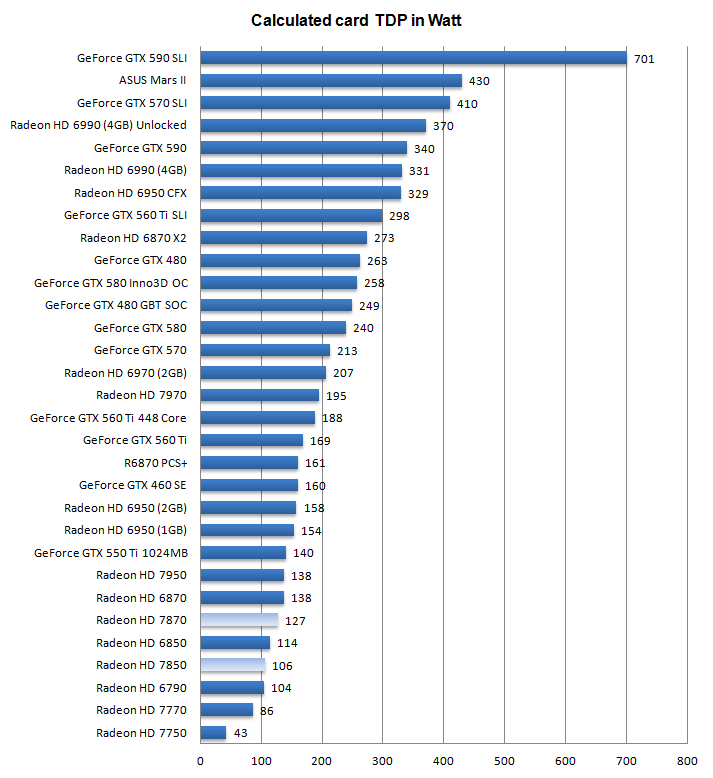

Для вашего удобства я собрал данные по современным графическим адаптерам. Энергопотребление указано в ваттах.

Посмотреть эту информацию вы можете на сайте производителя видеоадаптера.

Определяем энергопотребление GPU Nvidia GT и GTX

| 1030 — 30; | 1660 Super — 125; |

| 1050 — 75; | 1660 Ti — 120; |

| 1050 Ti — 75; | 2060 — 160; |

| 1060 — 120; | 2060 Super — 175; |

| 1070 — 150; | 2070 — 175; |

| 1070 Ti — 180; | 2070 Super — 215; |

| 1080 — 180; | 2080 — 225; |

| 1080 Ti — 250; | 2080 Super — 250; |

| Titan — 250; | 2050 Ti — 260; |

| 1650 — 75; | Titan RTX — 280. |

| 1660 — 120; |

Сколько ватт потребляют видеоадаптеры AMD

| R5 220 — 19; | R5 310 — 27; |

| R5 230 — 18; | R5 330 — 50; |

| R5 235 — 35; | R5 340 — 65; |

| R5 235X — 40; | R5 340X — 30; |

| R7 240 — 50; | R7 340 — 65; |

| R5 240 — 50; | R7 350 — 65; |

| R7 250 — 65; | R7 350X — 30; |

| R7 250E — 55; | R7 360 — 100; |

| R7 250XE — 95; | R7 360E — 75; |

| R7 250X — 95; | R7 370 — 110; |

| R7 260 — 95; | R9 350 — 95; |

| R9 260 — 85; | R9 360 — 115; |

| R7 260X — 115; | R9 370 — 110; |

| R7 265 — 150; | R9 370X — 140; |

| R9 270 — 150; | R9 380 — 190; |

| R9 270X — 180; | R9 380X — 190; |

| R9 280 — 250; | R9 390 — 230; |

| R9 280X — 250; | R9 390X —275; |

| R9 285 — 190; | RX Vega 56 — 210; |

| R9 290 — 230; | RX Vega 64 — 295; |

| R9 290X — 300; | VII — 295. |

Как узнать текущее энергопотребление

Если вы немного знакомы с характеристиками перечисленных девайсов, то могли заметить, что чем мощнее деталь, тем больше энергии ей требуется для нормальной работы. Исходя из этого производитель на официальном сайте в спецификации устройства обычно указывает рекомендованную мощность блока питания, с которым видеоадаптер будет нормально работать.

Указанные данные — усредненное значение. В моменты пиковых нагрузок видеоадаптер может потреблять больше энергии, чем я указал. Проверить, сколько конкретно энергии уходит в определенный момент, можно с помощью диагностической утилиты AIDA64.

Необходимая информация находится в разделе «Общее — Датчики». В правой части открывшегося окна будет значение мощности для CPU и графического процессора. Если мониторить показатели в режиме реального времени, можно заметить, как они меняются в зависимости от нагрузки, которую испытывает видеоплата.

Также советую почитать «Уменьшаем частоту на видеокартах от Nvidia» и «Понижаем тактовую частоту GPU от AMD Radeon». Буду признателен всем, кто расшарит этот пост в любой социальной сети — так вы поможете продвижению моего блога. До скорой встречи!

Буду признателен всем, кто расшарит этот пост в любой социальной сети — так вы поможете продвижению моего блога. До скорой встречи!

С уважением, автор блога Андрей Андреев.

Друзья, поддержите блог! Поделитесь статьёй в социальных сетях:

|

09.02.2021 Есть определенные факторы, которые не вызывают беспокойства у большинства пользователей ноутбуков, или это не повод для беспокойства. Если вы любопытный человек и пытаетесь понять все о машине, которую вы используете в течение многих лет, или хотите выяснить потребление энергии той, которую вы планируете получить, мы поможем вам с этим. Если вы просто в цифрах, то ответ очень прост: типичный 15-дюймовый ноутбук потребляет около 60 Вт в час. Но тогда это не точное количество, которое он потребил бы. Потребление энергии зависит от множества факторов, о которых вы можете не знать. Такие факторы, как зарядка, яркость экрана, работающее программное обеспечение, использование видеокарты и т. Одним из основных факторов, влияющих на потребление энергии, является тип используемого вами ноутбука.  Если вы используете очень простой ноутбук общего назначения, он будет потреблять около 60 Вт / час энергии. Если это игровой ноутбук или любой другой ноутбук высокого класса, это будет намного больше. Как было проверено в наших лабораториях, некоторые модели могут в среднем потреблять более 100 Вт в час, поэтому ноутбук сильно нагревается и ему требуется охлаждающая подставка для его охлаждения. Точно так же, если вы заряжаете такие ноутбуки, она увеличивается еще больше. Если вы используете очень простой ноутбук общего назначения, он будет потреблять около 60 Вт / час энергии. Если это игровой ноутбук или любой другой ноутбук высокого класса, это будет намного больше. Как было проверено в наших лабораториях, некоторые модели могут в среднем потреблять более 100 Вт в час, поэтому ноутбук сильно нагревается и ему требуется охлаждающая подставка для его охлаждения. Точно так же, если вы заряжаете такие ноутбуки, она увеличивается еще больше.Понятно, что ноутбук с очень низкокачественным процессором или процессором потребляет дополнительную мощность, чем любой мощный процессор, такой как Intel i7 или Intel i9. Причина этого проста, как может показаться. Процессору, который может быть недостаточно хорошим, потребуется больше энергии, чтобы обеспечить вашему ноутбуку достаточно хорошую производительность, в то время как отличный процессор отлично работает при небольшом потреблении энергии. 3. Графическая карта ВЫШЕ производительность видеокарты, ВЫШЕ энергопотребление.  Ноутбук с высокопроизводительным графическим процессором сопровождается также высокопроизводительным процессором. В большинстве случаев он также имеет более качественный дисплей, большую емкость аккумулятора и т. Д. Следовательно, все они вместе потребляют больше энергии. В этом посте есть специальный раздел, в котором рассказывается о энергопотреблении игровых ноутбуков. 4. Мощность адаптера Большинство 15,6-дюймовых ноутбуков поставляются с зарядным адаптером на 60 Вт. Большинство 17-дюймовых ноутбуков поставляются с адаптером для зарядки на 90 Вт.  Если ваш ноутбук поставляется с адаптером на 60 Вт, он будет потреблять меньше, чем ноутбук с адаптером на 90 Вт, потому что это количество ватт, которое он будет тратить при использовании. У нас есть еще одна важная категория ноутбуков, о которой следует особо упомянуть, поскольку все, что связано с игровыми ноутбуками, является мощным и требует специальной сборки компонентов. Как геймер, вы понимаете, что запускать некоторые высококлассные игры; Ноутбук должен быть на своем уровне лучше всех. Более того, почти все игровые ноутбуки тяжелые и громоздкие, так как в них есть все самое лучшее. В игровых ноутбуках есть все: от процессоров до мощных аккумуляторов. Чтобы проверить энергопотребление игрового ноутбука, вы можете проверить зарядное устройство, которым оно заряжено. Один из самых популярных игровых ноутбуков, Acer Predator Helios 300, который мы упоминали почти в каждой серии ноутбуков как один из лучших ноутбуков, имеет зарядное устройство мощностью 180 Вт.  Сколько ватт потребляет Apple MacBook? Если вы пользователь Macbook, вы должны знать, что типичный 13-дюймовый Macbook Pro потребляет 61 Вт мощности, как предусмотрено в зарядном устройстве, а 15-дюймовый Macbook потребляет 87 Вт / ч. Основываясь на приведенных выше предположениях, вы можете легко рассчитать стоимость электроэнергии, которую вы можете потреблять каждый день и в течение недели. Поскольку Macbook в среднем потребляет 61 Вт / ч, то есть 0,061 кВтч, и работает около 10 часов в день, он будет стоить около 7,32 цента, что в сумме составляет примерно 51,24 цента в неделю (с учетом стоимости электроэнергии 12 центов / кВт-ч. ). Если вы уже поняли уровень энергопотребления вашего ноутбука и очень недовольны результатами, возможно, вам придется подумать о некоторых способах снижения энергопотребления. Мы опробовали несколько способов для наших ноутбуков, а также несколько способов, которые вы можете попробовать:

Есть много других вещей, которые вы можете попробовать для потребления энергии. Экран с высокой яркостью потребляет много энергии. Вы можете избежать этого, уменьшив яркость экрана, когда он не нужен, а также это защитит ваши глаза.

|

Процессор Intel® Core™ i3-3220

Вся информация, приведенная в данном документе, может быть изменена в любое время без предварительного уведомления. Корпорация Intel сохраняет за собой право вносить изменения в цикл производства, спецификации и описания продукции в любое время без уведомления. Информация в данном документе предоставлена «как есть». Корпорация Intel не делает никаких заявлений и гарантий в отношении точности данной информации, а также в отношении характеристик, доступности, функциональных возможностей или совместимости перечисленной продукции. За дополнительной информацией о конкретных продуктах или системах обратитесь к поставщику таких систем.

Корпорация Intel сохраняет за собой право вносить изменения в цикл производства, спецификации и описания продукции в любое время без уведомления. Информация в данном документе предоставлена «как есть». Корпорация Intel не делает никаких заявлений и гарантий в отношении точности данной информации, а также в отношении характеристик, доступности, функциональных возможностей или совместимости перечисленной продукции. За дополнительной информацией о конкретных продуктах или системах обратитесь к поставщику таких систем.

Классификации Intel приведены исключительно в информационных целях и состоят из номеров классификации экспортного контроля (ECCN) и номеров Гармонизированных таможенных тарифов США (HTS). Классификации Intel должны использоваться без отсылки на корпорацию Intel и не должны трактоваться как заявления или гарантии в отношении правильности ECCN или HTS. В качестве импортера и/или экспортера ваша компания несет ответственность за определение правильной классификации вашей транзакции.

Формальные определения свойств и характеристик продукции представлены в техническом описании.

‡ Эта функция может присутствовать не во всех вычислительных системах. Свяжитесь с поставщиком, чтобы получить информацию о поддержке этой функции вашей системой или уточнить спецификацию системы (материнской платы, процессора, набора микросхем, источника питания, жестких дисков, графического контроллера, памяти, BIOS, драйверов, монитора виртуальных машин (VMM), платформенного ПО и/или операционной системы) для проверки совместимости с этой функцией. Функциональные возможности, производительность и другие преимущества этой функции могут в значительной степени зависеть от конфигурации системы.

Номера процессоров Intel® не служат мерой измерения производительности. Номера процессоров указывают на различия характеристик процессоров в пределах семейства, а не на различия между семействами процессоров. Дополнительную информацию смотрите на сайте https://www.intel.com/content/www/ru/ru/processors/processor-numbers.html.

Дополнительную информацию смотрите на сайте https://www.intel.com/content/www/ru/ru/processors/processor-numbers.html.

Анонсированные артикулы (SKUs) на данный момент недоступны. Обратитесь к графе «Дата выпуска» для получения информации о доступности продукции на рынке.

Расчетная мощность системы и максимальная расчетная мощность рассчитаны для максимально возможных показателей. Реальная расчетная мощность может быть ниже, если используются не все каналы ввода/вывода набора микросхем.

Максимальная тактовая частота с технологией Turbo Boost — это максимальная тактовая частота одноядерного процессора, которую можно достичь с помощью технологии Intel® Turbo Boost. Более подробную информацию можно найти по адресу https://www.intel.com/content/www/ru/ru/architecture-and-technology/turbo-boost/turbo-boost-technology.html.

Для получения дополнительной информации, в том числе о процессорах, поддерживающих технологию Intel® HT, посетите сайт https://www. intel.com/content/www/ru/ru/architecture-and-technology/hyper-threading/hyper-threading-technology.html?wapkw=hyper+threading.

intel.com/content/www/ru/ru/architecture-and-technology/hyper-threading/hyper-threading-technology.html?wapkw=hyper+threading.

Для процессоров с поддержкой 64-разрядных архитектур Intel® требуется поддержка технологии Intel® 64 в BIOS.

Подробнее о системах с поддержкой технологии защиты конфиденциальности Intel® (Intel® IPT) можно найти по адресу: https://www.intel.com/content/www/ru/ru/architecture-and-technology/identity-protection/identity-protection-technology-general.html.

Некоторые продукты могут поддерживать новые наборы инструкций AES с обновлением конфигурации процессоров, в частности, i7-2630QM/i7-2635QM, i7-2670QM/i7-2675QM, i5-2430M/i5-2435M, i5-2410M/i5-2415M. Свяжитесь с OEM-поставщиком для получения BIOS, включающего последнее обновление конфигурации процессора.

Розничные цены, представленные по состоянию на 06 Feb 2022 00:49:59 GMT

СКОЛЬКО ЭЛЕКТРОЭНЕРГИИ ПОТРЕБЛЯЕТ КОМПЬЮТЕР — КАК УЗНАТЬ

Будет любопытно проанализировать не только бережливым. При перепадах в электросети первым под удар попадает блок питания (БП). От этого частые поломки, которые обычно подразумевают замену узла на новый.

При перепадах в электросети первым под удар попадает блок питания (БП). От этого частые поломки, которые обычно подразумевают замену узла на новый.

Необязательно ставить БП такой же, как был. Если возникают вопросы, есть сомнения в правильности выбора, можно провести необходимые подсчеты.

Как узнать, сколько электроэнергии потребляет компьютер

Объемы потребляемого тока зависят от комплектующих. Если к розеткам подключены системник и монитор, учитывают «аппетиты» процессора, видеоадаптера, накопителей, материнки, ОЗУ и прочее, не забывая о дисплее. Можно:

- Сложить их мощности на калькуляторе.

- Воспользоваться специализированным онлайн-калькулятором.

- Подключить оборудование через измеритель мощности.

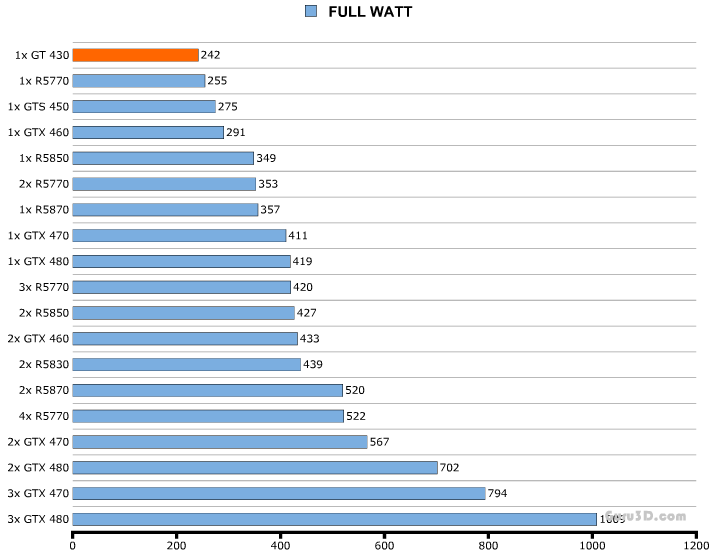

Геймерский ПК

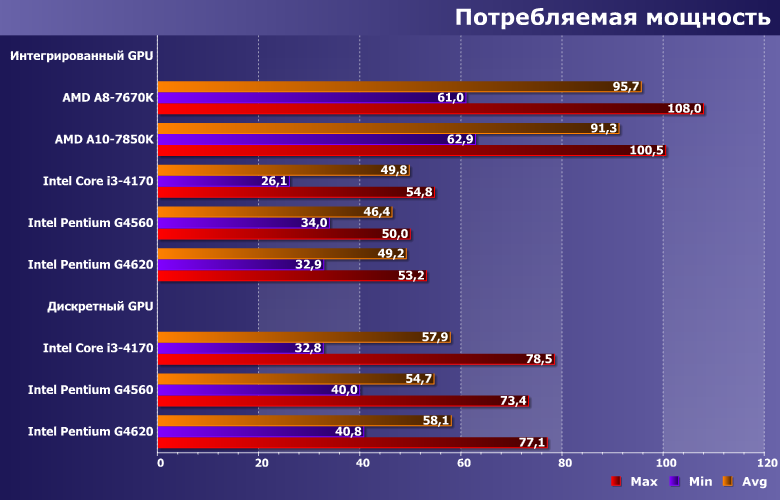

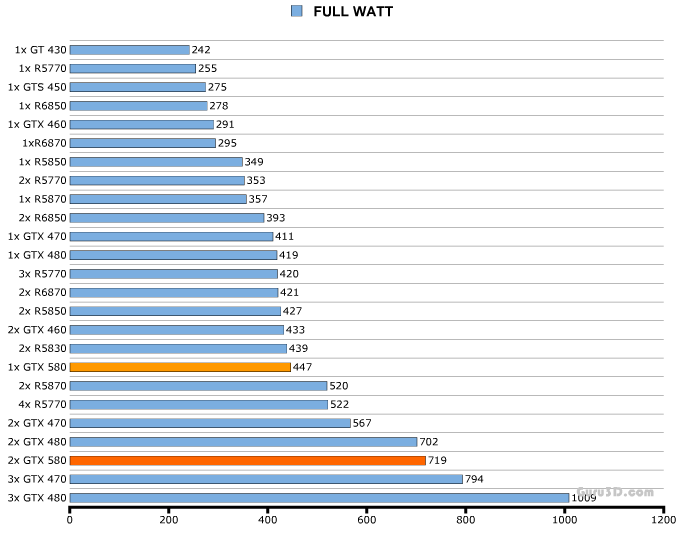

При подсчетах в онлайн-калькуляторах не получится воссоздать точную картину энергопотребления за день или месяц, поскольку в них фигурируют возможные максимумы. Самый точный способ подсчитать, сколько электроэнергии расходует игровой компьютер — протестировать его под нагрузкой, подключив через измеритель мощности. При работающих современных играх дисплей прибора может показывать до 400 Ватт и больше.

При работающих современных играх дисплей прибора может показывать до 400 Ватт и больше.

Приведем пример тестирования средненького игрового компа с воздушной системой охлаждения и одной видеокартой:

- На прогретом ПК не запущено тяжелых программ. Энергопотребление — 140 Вт.

- Запустили рендеринг видео — 240 Вт.

- Не прерывая рендеринг, решили поиграть — 400 Вт.

- Закончили рендерить, продолжаем стрелять/гонять — 300 Вт.

Если использовать комп исключительно для игр, и тратить на это ежедневно по 5 час. — за месяц выйдет 300*5*30=45 кВт/ч. Аналогичный расчет для монитора: 40*5*30=6 кВт/ч. Итого: 45+6=51 кВт/ч

Интересная статья: Сетевой фильтр или стабилизатор напряжения — что выбрать: 6 параметров выбора

Обычный ПК

Люди, не увлекающиеся играми, обычно проводят время за менее ресурсоемкими задачами: серфингом в интернете, общением в соцсетях, по видеосвязи и т. п. На потребление электроэнергии домашним компьютером, не оснащенным продвинутым процессором и видеокартой, более существенное значение оказывает монитор.

п. На потребление электроэнергии домашним компьютером, не оснащенным продвинутым процессором и видеокартой, более существенное значение оказывает монитор.

Его тоже учтем в примерных расчетах, но сделаем это после тестирования системного блока. Если гонять системник с процессором i5 и видеоадаптером GTX650Ti, он потребляет при чтении и просмотре в YouTube — 110, незамысловатых игрушках — 150, рендеринге — 160 Вт.

Усредняем и выходит 140 Вт. Плюсуем 40 Вт, которые «кушает» дисплей — выходит 180 Ватт/час. Если брать те же 5 ч. в день, в ежемесячную платежку попадает 180*5*30=27 кВт/ч Тестирование подтверждает, что, в отличие от игрового компа, для офисного ПК достаточно БП на 400 Вт.

Выбираем материнку: Какую материнскую плату выбрать — 8 ключевых критериев

Ноутбук

В основном пользователей интересует, сколько киловаттушек потребляет компьютер, а ноутбуки люди не отключают целыми днями, не опасаясь за показания счетчика. Такая позиция оправдана, поскольку мощность обычного лэптопа находится примерно на уровне LED-ламы. Она зависит от:

Такая позиция оправдана, поскольку мощность обычного лэптопа находится примерно на уровне LED-ламы. Она зависит от:

- диагонали ноута,

- его начинки,

- интенсивности эксплуатации.

У многих 15-дюймовых лэптопов БП рассчитаны на 45 Вт, у 17-дюймовых — на 65 Вт. Если мощность не указана, ее узнают, умножив выходящее напряжение блока питания V на силу тока A. К примеру, так: 20*3,25=65 Вт. Игровой ноутбук может потреблять 170 Вт и более. По прожорливости офисный лэптоп можно сравнить с лампочкой накаливания, игровой — со стационарным бюджетным устройством.

Выбираем геймерский ноут: Как выбрать игровой ноутбук — 9 основных параметров

Потребление электроэнергии компьютером в спящем режиме

ОС Windows дает возможность воспользоваться спящим режимом в паузах между усердным трудом или развлечениями на компе. Сколько придремавший компьютер берет электроэнергии? Около 4 Вт. В состоянии отдыха тухнет экран монитора, останавливаются винчестеры и кулеры, несохраненные данные остаются в ОЗУ. Пробуждение ПК настает после нажатия на любую клавишу или после движения мышкой.

Пробуждение ПК настает после нажатия на любую клавишу или после движения мышкой.

Режим гибернации работает аналогичным способом, только несохраненные данные пишутся на жесткий диск, и при внезапном обесточивании ПК информация не теряется. Также существует гибридный режим, при котором сохранение открытых вкладок и файлов производится и в быструю, и в постоянную память. Расход электричества при гибернации — около 2 Вт. Переход во все эти режимы можно настроить или запускать вручную.

Материал по теме: Что такое гибернация в ноутбуке или компьютере: 4 «за» и «против»

Как уменьшить потребление электроэнергии компьютером

Экономить электричество можно следующими способами:

- Установить в Windows схему экономного питания. Пусть ПК уходит в спячку при простое.

- Выключать неработающий компьютер на ночь.

- Когда не пользуетесь, держать выключенными прожорливые периферийные устройства, например, лазерный принтер.

- Попробовать андервольтинг процессора. После этой процедуры сокращается подача на чип избыточного напряжения. Комп работает быстрее, тише, экономнее.

- Снизить аппетит игрового ПК можно, сократив частоту кадров на экране. Видеоадаптер будет брать меньше электроэнергии, а на качестве картинки — это может не сказаться.

После всех этих манипуляций компьютер будет тянуть сколько ему действительно нужно. Возможно, суммы за электричество в платежках немного сократятся.

Напоследок приведем табличку сравнения онлайн-калькуляторов, с помощью которых можно подсчитать, сколько современный компьютер тянет электричества, заполнив поля основными комплектующими:

Из таблички видно, что наиболее объективно считает сервис Bequiet, но тут нужно учесть, что все эти онлайн-площадки предназначены в основном для оценки возможностей БП в контексте подобранного для сборки железа. Остальные виртуальные калькуляторы дают большой запас на комплектующие, которые могут понадобиться в дальнейшем.

На заметку: Какой браузер выбрать: 5 лучших программ

Сбер назван лучшим ESG-брендом в Беларуси: Деловой климат: Экономика: Lenta.ru

Дочерний банк Сбера в Беларуси признан лидером системных изменений в области ESG на национальном уровне. Банк стал обладателем главной награды конкурса «Бренд года» — золотой медали в социальной номинации. Кроме этого, жюри отметило достижения Сбера в сфере маркетинговой стратегии и продвижения, присудив дипломы победителя за ребрендинг и телевизионное бизнес-шоу «Это мое дело». Церемония награждения конкурса состоялась 27 января в Минске.

ESG-трансформация в белорусском Сбере стартовала в конце 2020 года, а уже в 21-ом по мнению экспертного жюри конкурса банк добился впечатляющих результатов.

В частности, на оценку жюри повлияли решения, направленные на внедрение электронного документооборота, открытие зеленых офисов, установку энергосберегающего оборудования, существенное сокращение потребления бумаги.

«Мы осознаем свою роль и ответственность лидерства в области ESG и устойчивого развития и в финансовой сфере, и в стране в целом. Так и должны действовать современные компании — менять общество к лучшему. Более года банк живет, основываясь на принципах ESG, которые подразумевают ответственное потребление, ответственное управление банком с заботой об экологии. Да, это начало пути, и еще многое предстоит сделать. Будем приобщать к нашей философии клиентов и партнёров, будем развивать офисы будущего, уменьшим углеродный след, будем развивать зеленый тренд в продуктовой линейке. Сделаем максимум, чтобы и в будущем бренд Сбера ассоциировался не только с технологиями и инновациями, но и с зеленым компонентом — проектами, направленными на устойчивое развитие. Берегите нашу планету вместе с нами», — отметил председатель правления Сбер Банка, дочернего банка Сбера в Беларуси Игорь Меркулов.

Помимо этого, Сбер получил награды в профессиональных номинациях. В частности, награду за ребрендинг — осенью вслед за названием сменился логотип и визуальный стиль банка; а также за «Успешную репутационную кампанию» — банк наградили за запуск бизнес-шоу «Это мое дело» на телеканале TNT International, в котором ведущий пробует себя в разных областях бизнеса и вдохновляет белорусов задуматься о своём деле, раскрывая все нюансы, которых не найти в учебниках.

«Бренд года» — ежегодно определяет самые успешные бренды Беларуси. В потребительских номинациях победителей выбирают обычные покупатели, а в профессиональных эксперты. Последние выделяют компании за особые достижения в сфере маркетинговой стратегии и продвижения. В социальной номинации жюри отмечает вклад брендов в охрану окружающей среды, работу с локальными сообществами и так далее. В конкурсе участвуют как белорусские, так и международные бренды.

Ожидайте, что графические карты следующего поколения будут потреблять больше энергии

Даже если графические процессоры станут более эффективными, карты следующего поколения могут по-прежнему потреблять более 400 Вт

Опубликовано: 3 августа 2021 г. | Источник: Различные источники | Автор: Марк КэмпбеллОжидается, что графические карты следующего поколения будут потреблять больше энергии

Графические карты текущего поколения уже потребляют много энергии: у Nvidia RTX 3090 официальное энергопотребление составляет 350 Вт, а у моделей AMD Reference RX 6900 XT — около 300 Вт. , мы ожидаем, что требования к энергии графического процессора будут расти с предложениями следующего поколения каждой компании.Технологии, лежащие в основе графических карт, быстро меняются, и стремление к более высоким уровням производительности доведет до предела энергопотребление и охлаждение графических карт.

, мы ожидаем, что требования к энергии графического процессора будут расти с предложениями следующего поколения каждой компании.Технологии, лежащие в основе графических карт, быстро меняются, и стремление к более высоким уровням производительности доведет до предела энергопотребление и охлаждение графических карт.Хотя эффективность энергопотребления является основной целью AMD и Nvidia при разработке, их предложения графических процессоров следующего поколения, по слухам, будут более энергоемкими, чем их предшественники. Эта перспектива должна восприниматься сборщиками ПК как захватывающая и пугающая. Удивительно, потому что более высокий уровень эффективности и повышенное энергопотребление значительно повысят уровень производительности, и ужасающе, потому что более высокое потребление энергии приводит к большему выделению тепла и более строгим требованиям к охлаждению.

400 Вт недостаточно?

Nvidia RTX 3090 Founders Edition уже потребляет 350 Вт энергии, а разогнанные модели AMD RX 6900 XT и Nvidia RTX 3080. RTX 3080 Ti и RTX 3090 уже могут потреблять больше энергии. Если AMD и Nvidia не смогут добиться безумного повышения эффективности своих видеокарт следующего поколения, максимальные TDP снова вырастут.

RTX 3080 Ti и RTX 3090 уже могут потреблять больше энергии. Если AMD и Nvidia не смогут добиться безумного повышения эффективности своих видеокарт следующего поколения, максимальные TDP снова вырастут.

Конкуренция между AMD и Nvidia сейчас находится на самом высоком уровне за более чем полвека, что дает обоим поставщикам повод повышать производительность настолько, насколько это возможно.Когда каждый результат теста имеет значение, нет особых причин не повышать TDP как можно выше, особенно если более высокие уровни производительности позволяют производителям ориентироваться на более высокие ценники.

В недавнем твите автор @kopite7kimi заявил, что «400 недостаточно», имея в виду серию RTX 40 следующего поколения от Nvidia. Мы того же мнения.

Графические процессоры MCM — Грядут многочиповые графические процессоры!

Ходят слухи, что и AMD, и Nvidia планируют создать видеокарты MCM (Multi-Chip-Module) со своей будущей архитектурой GPU..png) Сообщается, что AMD стремится поставлять многочиповые конструкции со своей архитектурой RDNA 3, в то время как отчеты Nvidia немного хуже.

Сообщается, что AMD стремится поставлять многочиповые конструкции со своей архитектурой RDNA 3, в то время как отчеты Nvidia немного хуже.

В 2017 году Nvidia выпустила документ с подробным описанием своих планов MCM GPU , и мы уже знаем, что AMD активно инвестирует в новейшие технологии упаковки чипов. Многочиповые видеокарты — четкая цель дизайна для обеих компаний, что делает MCM GPU вопросом «когда», а не «если».

Конструкции чипов MCM позволяют производителям сократить расходы и облегчить создание крупных чипов, выход которых в противном случае был бы низким.Чипы меньшего размера позволяют производителям тратить меньше площади кристалла на каждую производимую ими кремниевую пластину, а меньшие чипы часто имеют более высокую производительность. Эти факторы могут сделать многочиповые продукты более экономичными в производстве, и успех AMD с Ryzen и EPYC уже доказал, что проекты MCM могут быть успешными.

Гипотетическая конструкция графического процессора RDNA 3 с несколькими кристаллами будет сочетать в себе преимущества новейшей графической архитектуры AMD Radeon, преимущества новейших технологических процессов и потенциальные преимущества производительности за счет многочиповой конструкции. Если этот дизайн будет работать как задумано (действуя с точки зрения игры как одна большая видеокарта), многочиповая видеокарта RDNA 3 обеспечит более чем двукратный прирост производительности по сравнению с сегодняшней RX 6900 XT.

Если этот дизайн будет работать как задумано (действуя с точки зрения игры как одна большая видеокарта), многочиповая видеокарта RDNA 3 обеспечит более чем двукратный прирост производительности по сравнению с сегодняшней RX 6900 XT.

Если бы AMD смогла объединить 2 ядра, как AMD RX 6900 XT, добавить дополнительные архитектурные улучшения и добавить преимущества новых технологий обработки, мы без проблем верим, что для AMD возможен более чем двукратный прирост производительности. Тем не менее, мы не видим, чтобы AMD делала это ниже предела мощности RX 6900 XT в 300 Вт.

Графические процессоры MCM поднимут требования к энергопотреблению на новый уровень на рынке потребительских графических процессоров.

Nvidia уже знает, как питать видеокарты мощностью 450 Вт+. Почему существует 12-контактный разъем питания Nvidia

С запуском серии RTX 30 компания Nvidia представила миру свой новый 12-контактный разъем питания графического процессора. Этот разъем питания предназначен для обеспечения мощности более 500 Вт, сигнализируя миру о появлении видеокарт с более высокой мощностью.

Этот разъем питания предназначен для обеспечения мощности более 500 Вт, сигнализируя миру о появлении видеокарт с более высокой мощностью.

В большинстве вторичных моделей RTX 3080 и RTX 3090 используются традиционные 8-контактные разъемы питания PCIe, которые рассчитаны на мощность 150 Вт. 12-контактный кабель питания Nvidia может заменить более трех таких кабелей, освобождая драгоценное пространство на печатной плате и значительно упрощая прокладку кабелей.

Хотя многие считают дизайн 12-контактного разъема питания графического процессора Nvidia неудачным, он проложил путь к графическим картам с более высоким TDP. Nvidia может без проблем выпустить видеокарту мощностью 450 Вт и питать ее одним 12-контактным кабелем.Графические процессоры с более высокой мощностью в конечном итоге заставят производителей блоков питания и разработчиков графических процессоров использовать конструкцию кабеля Nvidia. В какой-то момент использование все большего количества 8-контактных кабелей питания PCIe на одной видеокарте станет слишком большим.

Вам нужен блок питания большей мощности?

В конечном счете, мы не можем предсказать будущее, но похоже, что TDP GPU будет расти в течение следующих нескольких поколений, а не снижаться. Эпоха высококлассных видеокарт мощностью 250 Вт закончилась. Мы уже достигли 350 Вт с Nvidia RTX 3090 Founders Edition, и не похоже, что в ближайшее время TDP станет ниже.

В то время как AMD и Nvidia, несомненно, нацелены на увеличение производительности на ватт в своих новейших архитектурах графических процессоров, также ясно, что все эти преимущества эффективности будут использованы для повышения тактовой частоты и для поддержки большего количества шейдеров графических процессоров и других компонентов.

Хорошей новостью является то, что большая мощность и более высокая энергоэффективность дадут потребителям еще больший прирост производительности. Когда дело доходит до производительности, все выглядит хорошо для будущего рынка высокопроизводительных графических процессоров.

Вы можете присоединиться к обсуждению графических процессоров следующего поколения и наших высоких ожиданий TDP на форумах OC3D .

Последние комментарии

08-04-2021, 12:51:13

греч Отвечать25 лет спустя: краткий анализ эффективности обработки GPU

Первые 3D-видеокарты появились 25 лет назад, и с тех пор их мощность и сложность выросли в масштабе больше, чем у любого другого микрочипа в ПК.Тогда эти процессоры содержали около 1 миллиона транзисторов, имели размер менее 100 мм2 и потребляли всего несколько ватт электроэнергии.

Перенесемся вперед сегодня, и типичная графическая карта может иметь 14 миллиардов транзисторов в кристалле размером 500 мм 2 и потреблять более 200 Вт энергии. Возможности этих бегемотов будут неизмеримо больше, чем у их древних предшественников, но стали ли они лучше работать со всеми этими крошечными переключателями и энергией?

Сказка о двух числах

В этой статье мы рассмотрим, насколько хорошо разработчики графических процессоров использовали увеличение размера кристалла и энергопотребления, чтобы обеспечить еще большую вычислительную мощность. Прежде чем мы углубимся, вы можете сначала освежить в памяти компоненты видеокарты или пройтись по истории современного графического процессора. С этой информацией у вас будет отличная основа для использования этой функции.

Прежде чем мы углубимся, вы можете сначала освежить в памяти компоненты видеокарты или пройтись по истории современного графического процессора. С этой информацией у вас будет отличная основа для использования этой функции.

Чтобы понять, как изменилась эффективность конструкции графического процессора, если вообще изменилась за эти годы, мы использовали превосходную базу данных TechPowerUp, взяв образец процессоров за последние 14 лет. Мы выбрали этот временной интервал, потому что он знаменует собой начало того, когда графические процессоры имели унифицированную структуру шейдеров.

Вместо того, чтобы иметь отдельные схемы внутри чипа для обработки треугольников и пикселей, унифицированные шейдеры представляют собой арифметико-логические устройства, предназначенные для обработки всех математических операций, необходимых для выполнения любых вычислений, связанных с 3D-графикой. Это позволяет нам использовать относительное измерение производительности последовательно для разных графических процессоров: операций с плавающей запятой в секунду (для краткости FLOPS).

AMD использует унифицированную шейдерную архитектуру почти 12 лет

Поставщики оборудования часто стремятся указать цифры FLOPS как меру пиковой вычислительной способности графического процессора, и хотя это абсолютно не единственный аспект, определяющий скорость графического процессора, FLOPS дает нам число, с которым мы можем работать.

То же самое относится и к размеру кристалла, который является мерой площади поверхности процессорного чипа. Однако у вас может быть два чипа одинакового размера, но с сильно различающимся количеством транзисторов.

Например, процессор Nvidia G71 (например, GeForce 7900 GT) 2005 года имеет размер 2 196 мм и содержит 278 миллионов транзисторов; их TU117, выпущенный в начале прошлого года (GeForce GTX 1650), всего на 4 мм больше, но имеет 4,7 миллиарда маленьких переключателей.

Диаграмма основных графических процессоров Nvidia, показывающая изменения плотности транзисторов с течением времени

Естественно, это должно означать, что новые транзисторы графического процессора намного меньше, чем старые чипы, и это очень верно. Так называемый узел процесса — общий масштаб производственного процесса, используемого для изготовления процессора, — используемый поставщиками оборудования, менялся с годами, становясь все меньше и меньше. Итак, мы проанализируем эффективность с точки зрения плотности кристалла, которая является мерой того, сколько миллионов транзисторов приходится на 2 мм площади кристалла.

Так называемый узел процесса — общий масштаб производственного процесса, используемого для изготовления процессора, — используемый поставщиками оборудования, менялся с годами, становясь все меньше и меньше. Итак, мы проанализируем эффективность с точки зрения плотности кристалла, которая является мерой того, сколько миллионов транзисторов приходится на 2 мм площади кристалла.

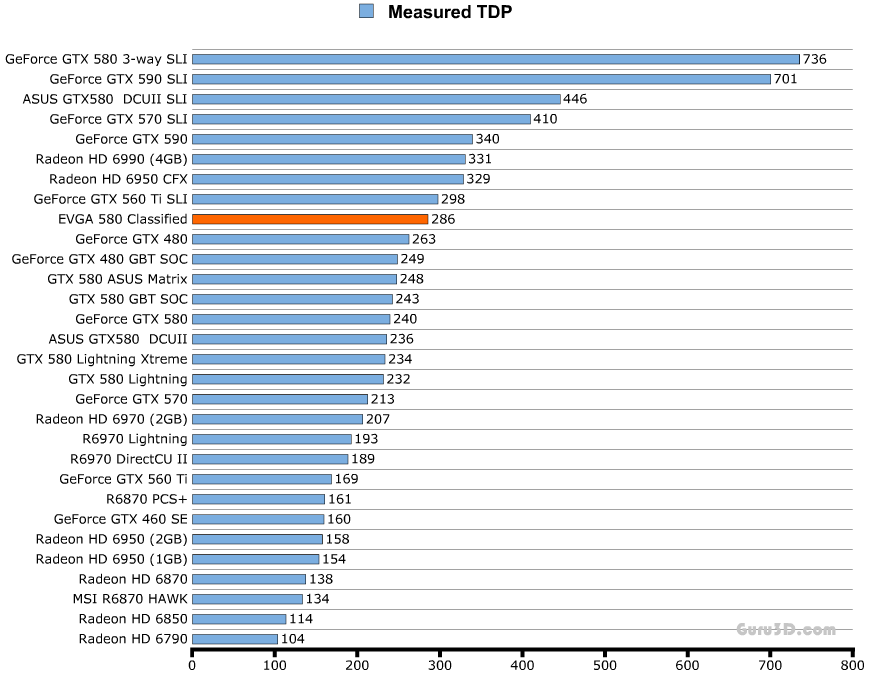

Возможно, наиболее спорным показателем, который мы будем использовать, является показатель энергопотребления графического процессора. Мы не сомневаемся, что многим читателям это не понравится, поскольку мы используем заявленное производителем значение расчетной тепловой мощности (TDP).На самом деле это мера (или, по крайней мере, так должно быть) количества тепла, выделяемого всей видеокартой в средней, но высокой нагрузке, ситуации.

С кремниевыми чипами потребляемая ими мощность в основном превращается в тепло, но это не причина, по которой использование TDP является проблемой. Дело в том, что разные поставщики указывают это число в разных условиях, и это также не обязательно энергопотребление при пиковых значениях FLOPS. Это также значение мощности для всей видеокарты, включая встроенную память, хотя большая ее часть будет приходиться на сам графический процессор.

Это также значение мощности для всей видеокарты, включая встроенную память, хотя большая ее часть будет приходиться на сам графический процессор.

Можно напрямую измерить энергопотребление видеокарты. Например, TechPowerUp делает это для своих обзоров графических процессоров, и когда они протестировали GeForce RTX 2080 Super с заявленным поставщиком TDP 250 Вт, они обнаружили, что в среднем он составляет 243 Вт, но пиковое значение во время тестирования составило 275 Вт.

Но мы остановились на использовании TDP для простоты, и мы были несколько осторожны, делая какие-либо суждения, основанные исключительно на производительности обработки по сравнению с расчетной тепловой мощностью.

Мы собираемся напрямую сравнить 2 показателя: GFLOPS и единичную плотность кристаллов. Один GFLOPS соответствует 1 000 миллионам операций с плавающей запятой в секунду, и мы имеем дело со значением для вычислений FP32, выполняемых исключительно унифицированными шейдерами. Сравнение примет вид графика, подобного этому:

Ось x отображает GFLOPS на единицу TDP, поэтому вы хотите, чтобы это значение было как можно выше: чем ниже положение по оси, тем менее энергоэффективен чип. То же самое верно и для оси y , так как она отображает GFLOPS на единицу плотности кристалла. Чем больше транзисторов вы упаковали на квадратный миллиметр, тем большей производительности вы ожидаете. Таким образом, общая эффективность обработки GPU (с учетом количества транзисторов, размера кристалла и TDP) увеличивается по мере приближения к верхнему правому углу графика.

То же самое верно и для оси y , так как она отображает GFLOPS на единицу плотности кристалла. Чем больше транзисторов вы упаковали на квадратный миллиметр, тем большей производительности вы ожидаете. Таким образом, общая эффективность обработки GPU (с учетом количества транзисторов, размера кристалла и TDP) увеличивается по мере приближения к верхнему правому углу графика.

Любые точки данных в левом верхнем углу в основном говорят о том, что «этот графический процессор обеспечивает хорошую производительность благодаря конструкции кристалла, но за счет использования относительно большого количества энергии.Если перейти к нижнему правому углу, «хорошо использовать энергию эффективно, но конструкция кристалла не обеспечивает высокой производительности».

Короче говоря, мы определяем эффективность обработки как то, сколько GPU делает для пакета и мощности, которые у него есть.

Эффективность графического процессора: TDP и плотность кристалла

Без лишних слов перейдем к результатам:

На первый взгляд, результаты кажутся довольно разбросанными, но мы можем увидеть основную закономерность: старые графические процессоры, такие как G80 или RV670, гораздо менее эффективны по сравнению с более новыми разработками, такими как Vega 20 или GP102. Чего и следовало ожидать! В конце концов, это была бы довольно слабая команда инженеров-электронщиков, которые изо всех сил старались бы постоянно разрабатывать и выпускать новые продукты, которые с каждым выпуском становятся все менее эффективными.

Чего и следовало ожидать! В конце концов, это была бы довольно слабая команда инженеров-электронщиков, которые изо всех сил старались бы постоянно разрабатывать и выпускать новые продукты, которые с каждым выпуском становятся все менее эффективными.

Но есть некоторые интересные данные. Первыми из которых являются ТУ102 и ГВ100. Оба они сделаны Nvidia и могут быть найдены в таких графических процессорах, как GeForce RTX 2080 Ti и Titan V соответственно.

Можно возразить, что ни один из графических процессоров, особенно GV100, не предназначен для массового потребительского рынка, так как на самом деле они предназначены для рабочих станций или вычислительных серверов.Таким образом, хотя они кажутся наиболее эффективными из всех, именно этого и следовало ожидать от процессоров, предназначенных для специализированных рынков, которые стоят намного дороже, чем стандартные.

Еще один графический процессор, который выделяется и чем-то напоминает больной палец, — это GP108 — это еще один чип Nvidia, который чаще всего встречается в GeForce GT 1030. Этот бюджетный продукт, выпущенный в 2017 году, имеет очень маленький процессор размером всего 74 мм 2 с TDP всего 30 Вт. Однако его относительная производительность с плавающей запятой на самом деле не лучше, чем у первого унифицированного шейдерного графического процессора Nvidia, G80, выпущенного в 2006 году.

Этот бюджетный продукт, выпущенный в 2017 году, имеет очень маленький процессор размером всего 74 мм 2 с TDP всего 30 Вт. Однако его относительная производительность с плавающей запятой на самом деле не лучше, чем у первого унифицированного шейдерного графического процессора Nvidia, G80, выпущенного в 2006 году.

Графический процессор Nvidia G80. Источник изображения: Хайнс

Напротив GP108 находится чип AMD Fuji, который используется в серии Radeon R9 Fury. Этот дизайн не кажется слишком энергоэффективным, особенно с учетом того, что использование памяти с высокой пропускной способностью (HBM) должно было помочь в этом отношении. Конструкция Fiji сильно нагревалась, что делает полупроводниковые процессоры менее энергоэффективными из-за увеличения утечки. Именно здесь электрическая энергия теряется в упаковке и окружении, а не ограничивается схемой.Все чипы протекают, но скорость потерь увеличивается с температурой.

Возможно, самым интересным пунктом данных является Navi 10: это самый последний дизайн графического процессора AMD, который производится TSMC с использованием своего технологического узла N7, который в настоящее время используется в наименьшем масштабе. Однако чип Vega 20 сделан на том же узле, но он кажется более производительным, несмотря на более старый дизайн. Итак, что здесь происходит?

Однако чип Vega 20 сделан на том же узле, но он кажется более производительным, несмотря на более старый дизайн. Итак, что здесь происходит?

Под этими вентиляторами находится графический процессор Vega 20. Изображение: Verte95 | Викисклад

Vega 20 (AMD использовала только одну потребительскую видеокарту — Radeon VII) был последним процессором AMD, использующим архитектуру GCN (Graphics Core Next).Он объединяет огромное количество унифицированных ядер шейдеров в макет, который в значительной степени ориентирован на пропускную способность FP32. Однако запрограммировать устройство для достижения такой производительности было нелегко, и ему не хватало гибкости.

Navi 10 использует новейшую архитектуру RDNA, которая решает эту проблему, но за счет пропускной способности FP32. Тем не менее, это новая компоновка, и она производится на относительно новом технологическом узле, поэтому мы можем ожидать повышения эффективности по мере того, как TSMC разрабатывает свой технологический узел, а AMD обновляет архитектуру.

Если не учитывать выбросы, то самыми эффективными графическими процессорами в нашем графике являются GP102 и GP104. Они используют архитектуру Pascal от Nvidia и могут быть найдены в видеокартах, таких как GeForce GTX 1080 Ti, GTX 1070 и GTX 1060. Рядом с GP102, но без маркировки для ясности, находится TU104, который использует Последний дизайн Turing от Nvidia, и его можно найти во множестве моделей GeForce RTX: 2060, 2070 Super, 2080, 2080 Super, и это лишь некоторые из них.

Они также производятся TSMC, но с использованием узла процесса, специально разработанного для продуктов Nvidia, под названием 12FFN, который сам по себе является усовершенствованной версией узла 16FF.

Улучшения сосредоточены на увеличении плотности кристаллов при одновременном снижении утечек, что в некоторой степени объясняет, почему графические процессоры Nvidia кажутся наиболее эффективными.

Эффективность графического процессора: TDP и площадь кристалла

Мы можем уменьшить влияние узла процесса на анализ, заменив метрику плотности штампа просто площадью штампа. Это дает нам совсем другую картину…

Это дает нам совсем другую картину…

На этом графике эффективность растет в том же направлении, но теперь мы видим, что некоторые ключевые позиции поменялись местами.TU102 и GV100 упали сразу, тогда как Navi 10 и Vega 20 подскочили на графике. Это связано с тем, что два первых процессора представляют собой огромные чипы (754 мм 2 и 815 мм 2 ), тогда как последние два от AMD намного меньше (251 мм 2 и 331 мм 2 ).

Если мы сфокусируем график так, чтобы он отображал только более новые графические процессоры, то различия станут еще более заметными:

Эта точка зрения убедительно свидетельствует о том, что AMD уделяла меньше внимания энергоэффективности, чем эффективности размера кристалла.

Другими словами, они хотели получить больше чипов графического процессора на каждую произведенную пластину. Nvidia, с другой стороны, похоже, выбрала подход, при котором они проектируют свои чипы все больше и больше (и, таким образом, каждая пластина содержит меньше кристаллов), но они лучше используют электроэнергию.

Будут ли AMD и Nvidia продолжать в том же духе со своими следующими графическими процессорами? Что ж, первые уже заявили, что они сосредоточены на улучшении отношения производительности на ватт в RDNA 2.0 на 50%, поэтому мы должны увидеть, что их будущие графические процессоры будут располагаться правее на нашей диаграмме выше.А как же Нвидиа?

К сожалению, они печально известны тем, что очень молчат о будущих разработках, но мы знаем, что их следующие процессоры будут производиться TSMC и Samsung на технологическом узле, аналогичном тому, что используется для Navi. Были некоторые заявления о том, что мы увидим значительное снижение энергопотребления, а также значительное увеличение количества унифицированных шейдеров, поэтому, возможно, мы увидим аналогичную позицию на графике для Nvidia.

Так как же графические процессоры стали более эффективными?

Вышеизложенное довольно убедительно: за прошедшие годы AMD и Nvidia повысили производительность обработки на единицу плотности кристалла и единицу TDP. В некоторых случаях увеличение было поразительным…

В некоторых случаях увеличение было поразительным…

Возьмите процессоры Nvidia G92 и TU102. Первый питал подобные GeForce 8800 GT и 9800 GTX и упаковывал 754 миллиона транзисторов в чип площадью 324 мм 2 . Когда он появился в октябре 2007 года, он был хорошо принят за свои требования к производительности и мощности.

Одиннадцать лет спустя Nvidia предложила нам TU102 в виде GeForce RTX 2080 Ti с почти 19 миллиардами транзисторов на площади 754 мм.в 3 раза больше.

Ничего из этого не было бы возможным, если бы не работа, проделанная TSMC по постоянному совершенствованию своей технологии производства: G92 в 8800 GT был построен на 65-нм технологическом узле, тогда как последний TU102 — это их специальный масштаб 12FFN. Названия методов производства на самом деле не говорят нам о смысле разницы между ними, но номера графических процессоров говорят. Текущий имеет плотность кристалла 24,67 миллиона транзисторов на мм 2 по сравнению со значением старого 2. 33 миллиона.

33 миллиона.

Десятикратное увеличение упаковки компонентов является основной причиной огромной разницы в эффективности двух графических процессоров. Меньшие логические блоки требуют меньше энергии для работы, а более короткие пути, соединяющие их, означают, что для передачи данных требуется меньше времени. Наряду с улучшениями в производстве кремниевых чипов (уменьшение дефектов и лучшая изоляция) это приводит к возможности работать на более высоких тактовых частотах при том же потреблении энергии или потреблять меньше энергии при той же тактовой частоте.

Процессор AMD Vega 10 с двумя чипами HBM по 4 ГБ слева

Говоря о часах, это еще один фактор, который следует учитывать. Давайте сравним RV670, выпущенный в ноябре 2007 года в составе Radeon HD 3870, с Vega 10 в составе Radeon RX Vega 64, выпущенного в августе 2017 года.

Первая имеет фиксированную тактовую частоту около 775 МГц, а вторая имеет как минимум три доступные частоты:

- 850 МГц — при простом выполнении рабочего стола, 2D обработка

- 1250 МГц — для очень тяжелой 3D-работы (известной как базовая частота )

- 1550 МГц — для легких и средних 3D-нагрузок (известный как тактовая частота )

Мы говорим «по крайней мере», потому что графическая карта может динамически изменять свою тактовую частоту и потребляемую мощность между указанными выше значениями в зависимости от ее рабочей нагрузки и рабочей температуры. Это то, что мы считаем само собой разумеющимся сейчас, с новейшими графическими процессорами, но такого уровня контроля просто не существовало 13 лет назад. Однако эта возможность не влияет на наши результаты эффективности, поскольку мы рассмотрели только пиковую производительность (т. е. на максимальных тактовых частотах), но она влияет на то, как карта работает для обычного потребителя.

Это то, что мы считаем само собой разумеющимся сейчас, с новейшими графическими процессорами, но такого уровня контроля просто не существовало 13 лет назад. Однако эта возможность не влияет на наши результаты эффективности, поскольку мы рассмотрели только пиковую производительность (т. е. на максимальных тактовых частотах), но она влияет на то, как карта работает для обычного потребителя.

Но наиболее важной причиной постоянного повышения эффективности обработки GPU на протяжении многих лет были изменения в использовании самого процессора.В июне 2008 г. все лучшие суперкомпьютеры мира работали на процессорах AMD, IBM и Intel; одиннадцать лет спустя в списке появился еще один поставщик чипов: Nvidia.

Tesla P100 от Nvidia с чипом GP100

Их процессоры GV100 и GP100 были разработаны почти исключительно для рынка вычислений, они имеют множество ключевых архитектурных функций для поддержки этого, и многие из них очень похожи на процессоры. Например, внутренняя память чипов (кеш) выглядит примерно так же, как у типичного серверного ЦП:

.

- Регистровый файл на SM = 256 КБ

- Кэш L0 на SM = 12 КБ инструкция

- Кэш L1 на SM = 128 КБ инструкций / 128 КБ данных Кэш L2

- на GPU = 6 МБ

Сравните это с Intel Xeon E5-2692 v2, который использовался во многих вычислительных серверах:

- Кэш L1 на ядро = 32 КБ инструкций / 32 КБ данных Кэш L2

- на ядро = 256 КБ Кэш L3

- на ЦП = 30 МБ

Логические блоки современного графического процессора поддерживают ряд форматов данных; некоторые из них имеют специальные блоки для целочисленных, плавающих и матричных вычислений, тогда как другие имеют сложные структуры, которые выполняют все эти операции.Устройства подключаются к кэш-памяти и локальной памяти с помощью высокоскоростных широких межсоединений. Эти изменения, безусловно, помогают в обработке 3D-графики, но для большинства игр это будет считаться излишним. Но эти GPU были разработаны для более широкого набора рабочих нагрузок, чем просто изображения, и для этого есть название: GPU общего назначения (GPGPU).

Машинное обучение и интеллектуальный анализ данных — это две области, которые получили огромную выгоду от разработки GPGPU и поддерживаемых программных пакетов и API (например,г. CUDA от Nvidia, ROMc от AMD, OpenCL), поскольку они включают множество сложных, массивно-параллельных вычислений.

Крупные графические процессоры, оснащенные тысячами унифицированных шейдерных блоков, идеально подходят для таких задач, и как AMD, так и Nvidia (а теперь к веселью присоединяется и Intel) вложили миллиарды долларов в исследования и разработки чипов, обеспечивающих все более высокую вычислительную производительность.

Первый дискретный графический процессор Intel почти за 20 лет

В настоящее время обе компании разрабатывают архитектуры графических процессоров, которые можно использовать в различных секторах рынка, и обычно избегают создания полностью отдельных компоновок для графики и вычислений.Это связано с тем, что основная часть прибыли от производства графических процессоров по-прежнему поступает от продажи 3D-видеокарт, но неизвестно, останется ли так. Возможно, поскольку спрос на вычисления продолжает расти, AMD или Nvidia могли бы выделить больше ресурсов на повышение эффективности чипов для этих рынков и меньше на рендеринг.

Возможно, поскольку спрос на вычисления продолжает расти, AMD или Nvidia могли бы выделить больше ресурсов на повышение эффективности чипов для этих рынков и меньше на рендеринг.

Но что бы ни случилось дальше, мы знаем точно одно: следующая серия мощных графических процессоров с многомиллиардными транзисторами будет по-прежнему немного более эффективной, чем их предшественники.И это хорошая новость, независимо от того, кто ее производит и для чего она используется.

Ярлыки для покупок:

Битва видеокарты с блоком питания — демистификация энергопотребления и пиковых нагрузок

Его знают и ненавидят, любимый момент, когда блок питания внезапно отключается посреди игры, несмотря на то, что он новый и не имеет никаких других заметных особенностей. Раздражение пользователя становится еще больше, когда вы думаете, что правильно рассчитали мощность блока питания.Но достаточно ли того, что производители видеокарт или блоков питания указывают в качестве значения производительности? С блоками питания можно быть относительно уверенным, но как насчет видеокарт?

И взамен всегда забавляются расчетами питания поставщиков графических карт, которые достаточно часто выдают гораздо более высокие значения, чем то, что находят при нормальных измерениях. Если вы знакомы с моими тестами видеокарт, вы также знаете, что я всегда включаю так называемые всплески (<20 мс), но я также предпочитаю относительные значения этих гораздо более высоких значений.Современные блоки питания должны легко справляться с такими очень короткими пиками нагрузки. Должен.

Если вы знакомы с моими тестами видеокарт, вы также знаете, что я всегда включаю так называемые всплески (<20 мс), но я также предпочитаю относительные значения этих гораздо более высоких значений.Современные блоки питания должны легко справляться с такими очень короткими пиками нагрузки. Должен.

Но смогут ли они это сделать? И главное: как долго? А чем отличается игра от постоянной нагрузки типа расчетов или стресс-теста? Именно за этим вопросом я сейчас и слежу, потому что, по-видимому, и, к сожалению, никто больше не интересуется им в деталях. А как насчет защитных цепей, встроенных в блоки питания?

Коллеги из PCGH недавно сообщили в статье, что Seasonic обнаружил необычные пики нагрузки на AMD RX Vega56, которые могли привести к отключению определенного типа блока питания.Вывод таков, что до 600 Вт будет присутствовать в интервале 10 мс, что будет соответствовать току более 50 ампер на линии 12 В для карты. Тот факт, что 550-ваттный блок питания после накопления таких нагрузок отключается, на самом деле вполне логичен. Но в чем суть?

Но в чем суть?

Однако в качестве обновления я должен добавить, что эта информация исходит от службы поддержки Seasonic и что здесь измерялась не только видеокарта, но и вся система. К сожалению, это не так ясно из соответствующей записи Reddit:

.Quelle Seasonic/PCGHГрафическая карта AMD Vega 56/64 имеет очень высокое кратковременное энергопотребление.На приведенном ниже снимке экрана осциллографа показан переходный ток при использовании двух Vega 56 CrossFire для теста FurMark до 102 А/10 мс, что означает, что блок питания должен выдерживать пиковую мощность 1200 Вт. Даже одна видеокарта Vega 56 может потреблять около 600 Вт в переходном режиме.

Что ждет читателя? Измерения и факты!

Я думаю, что немного несправедливо ставить AMD в центр внимания и с самого начала окрашивать игру «Черный Питер» в ярко-красный цвет.Именно поэтому я выбрал три карты с одинаковым энергопотреблением: AMD Radeon RX Vega64 (около 250 Вт, эталонная и пользовательская), Nvidia GeForce GTX 1080 Ti FE (около 250 Вт) и GeForce RTX 2080 Ti FE ( около 275 ватт), при этом эти характеристики в ваттах относятся к фактически измеренному энергопотреблению.

Так что я явно выше того, что мог бы выдать Seasonic (якобы) с гораздо более экономичным RX Vega56 номинально по нагрузкам. И я также покажу, какие токи и какие интервалы я действительно определил в более чем 200 автоматических одиночных измерениях на карту.Таким образом, также будет сводка с поправкой на производителя и поколение, какая карта генерирует самые длинные или самые высокие пики нагрузки, когда именно.

Мы сразу увидим, как карты регулируют все это дело, каждая с максимальной игровой нагрузкой и постоянно требовательным стресс-тестом. Power Tune (AMD) и Boost (Nvidia) накладывают больше ограничений, чем вы думаете, и многое становится лучше. И это также покажет, что производителям блоков питания следует прописать в своих спецификациях еще несколько вещей, а не демонизировать только видеокарты.Здесь причина и следствие будут явно заменены местами.

Коллеги производителя блока питания жалуются, что им удалось измерить пики тока более 50 ампер длительностью 10 мс, что на первый взгляд кажется сложным, но очень легко проверяется в лаборатории. Поэтому я ограничил весь период измерения 20 миллисекундами, но измеряю там все с интервалом в 10 микросекунд! Мы можем исключить эффекты алиасинга, используя измерительную установку и оборудование.Параллельно с теми же интервалами проверяю и стабильность напряжений блока питания.

Поэтому я ограничил весь период измерения 20 миллисекундами, но измеряю там все с интервалом в 10 микросекунд! Мы можем исключить эффекты алиасинга, используя измерительную установку и оборудование.Параллельно с теми же интервалами проверяю и стабильность напряжений блока питания.

Я также соединяю два разъема внешнего питания с общей шиной и измеряю, как будут протекать токи в источнике питания с одной шиной. Сеть мощностью 550 Вт, использованная специально для этого теста (Be Quiet Dark Power Pro 11 550 Вт, режим OC as single rail), немного перенапряжена, но это довольно незначительно и полностью соответствует спецификациям. Поскольку нас интересуют только токи, это нормально, потому что защита от перегрузки (OPP) также основана на защите от перегрузки по току (OCP).

Система испытаний и методы измерения

Тестовая система и методология хорошо известны, но поскольку я сейчас тестирую самостоятельно здесь, в Германии, тестовая система также была снова модернизирована без учета бывших коллег из США.

Резюме в табличной форме предлагает заинтересованным читателям краткий обзор:

| Testsysteme und Messräume | |

|---|---|

| Система: | Intel Core i7-8700K @5 ГГц MSI MEG Z390 Ace 16 ГБ KFA2 DDR4 4000 Зал славы 1x 1 ТБ Toshiba OCZ RD400 (M.2, системный SSD) 2x 960 ГБ Toshiba OCZ TR150 (хранилище, изображения) Be Quiet Dark Power Pro 11, 550 Вт, Netzteil |

| Охлаждение: | Alphacool Eisblock XPX 5x Be Quiet! Silent Wings 3 PWM (имитация закрытого корпуса) Thermal Grizzly Kryonaut (термальная смазка) |

| Кейс: | Lian Li PC-T70 (с кожухом) Modi: открытый стол, закрытый кейс |

| Монитор: | Эйзо ЭВ3237-БК |

| Потребляемая мощность: | Бесконтактное измерение постоянного тока в разъеме PCIe (Riser-Card) Бесконтактное измерение постоянного тока на внешних разъемах питания PCIe Прямое измерение напряжения на соответствующих разъемах и на блоке питания 2x Rohde & Schwarz HMO 3054, многоканальный осциллограф 500 МГц 4x Rohde & Schwarz HZO50, токоизмерительные клещи 4x Rohde & Schwarz HZ355, пробники 1x Rohde & Schwarz HMC 8012, цифровой мультиметр |

| Инфракрасный/тепловизор: | 1x Optris PI640, 2x тепловизор Xi400 Программное обеспечение Pix Connect |

| Шум/Акустика: | NTI Audio M2211 (калиброванный) Steinberg UR12 Creative X7, Smaart v.  7 7 Полубезэховая измерительная комната, 3,5 x 1,8 x 2,2 м (ДxГxВ) Измерения в осевом направлении, перпендикулярно, расстояние измерения 50 см Уровень шума в дБА (медленный) при измерении RTA Частотный спектр, как на графике |

| Операционная система | Windows 10 Pro (1903, все обновления) |

Как не поджарить видеокарту, играя в New World

Новый мир, новый день, новый способ убивать. (Скриншот: Amazon Game Studios)

New World от Amazon Game Studios в последнее время был в моде, и крупные стримеры, такие как Shroud, транслировали игру вместо его обычных шутеров от первого лица.

В последнее время игра собрала около миллиона одновременных игроков в самом Steam, и не похоже, что она остановится в ближайшее время.

Но, как это обычно бывает в любой крупной игре, подобной этой, в самой игре неизбежно возникает множество технических проблем, и я имел «удовольствие» столкнуться с большинством из них во время погружения. в мир Aeternum, будь то техническая сторона вещей или проблемы с сервером.

в мир Aeternum, будь то техническая сторона вещей или проблемы с сервером.

Однако, несмотря на все это, одна серьезная проблема с игрой больше всего выделялась для меня и делала меня абсолютно параноиком, поэтому я решил глубоко погрузиться в это, чтобы ответить на этот очень важный вопрос:

Взорвется ли моя видеокарта?

Во время бета-тестирования поступали сообщения о том, что New World ломает и поджаривает компьютерные видеокарты.Amazon заявила, что они «исправили» эту проблему во время бета-тестирования, но все еще есть сообщения о том, что графические процессоры умирают (и даже буквально дымятся) в официальном выпуске.

Во время моего собственного наблюдения (да, я отслеживаю ВСЕ, что происходит на моем компьютере, потому что это мое детище) я заметил нечто очень странное в энергопотреблении New World и почему это может быть причиной отказа графических процессоров.

У меня есть Asus ROG Strix AMD Radeon 6900 XT с тремя 8-контактными разъемами питания. Каждый 8-контактный разъем питания рассчитан на потребление до 150 Вт мощности, поэтому теоретически карта может потреблять 450 Вт мощности через свои кабели и дополнительные 75 Вт через разъем PCIe карты, по сути, имея возможность потреблять 525 Вт. мощности от блока питания.

Каждый 8-контактный разъем питания рассчитан на потребление до 150 Вт мощности, поэтому теоретически карта может потреблять 450 Вт мощности через свои кабели и дополнительные 75 Вт через разъем PCIe карты, по сути, имея возможность потреблять 525 Вт. мощности от блока питания.

Карты Asus Strix всегда отличались надежностью, а компоненты карты хорошо приспособлены для того, чтобы потреблять столько энергии. Тем не менее, карта жестко ограничена пределом мощности чипа, который установлен на максимальное энергопотребление 381 Вт.

За время работы с картой я ни разу не видел, чтобы она потребляла больше 400 Вт, независимо от того, какую игру или тесты я запускал, из-за ограничения мощности карты. Ограничение мощности всегда будет стабилизировать энергопотребление карты примерно до 380 Вт, если некоторые приложения решат резко увеличить использование графического процессора.

История продолжается

New World увеличил энергопотребление моего графического процессора примерно до 480-500 Вт.

Когда это происходит, у меня также возникают случайные зависания в игре, и мне приходится перезагружаться, чтобы снова запустить ее.

Это крайне важно из-за того, что игра требует функционирования графического процессора.

Я знаю, что мой графический процессор может без особых проблем достичь этих показателей энергопотребления, но Amazon Game Studios нужно как можно скорее обратить внимание на то, что он превышает мой предел мощности.

Мне повезло, что у меня есть мощный графический процессор, который может справиться с этими всплесками, но что, если бы у меня было что-то более «низшее»?