| Максимальный графический Memory1 | ||||

| Графические контроллеры Intel® | Windows 2000* | Windows XP* | ОС Windows Vista* | Windows 7* |

| Intel® Iris® Pro Graphics 580 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® Iris® Graphics 550 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® Iris® Graphics 540 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® HD Graphics 530 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® HD Graphics 520 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® HD Graphics 515 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® Iris® Pro Graphics 6200 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® Iris® Graphics 6100 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® HD Graphics 6000 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® HD Graphics 5500 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| HD-графика Intel® 5300 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® Iris® Pro Graphics 5200 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® Iris® Graphics 5100 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| HD-графика Intel® 5000/4600/4400/4200 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel® HD Graphics 4000/2500 (Соединенный с Intel® 7 Наборы микросхем) | Неподдерживаемая ОС | До 1 GB1 | Неподдерживаемая ОС | До ~1.7 GB1 |

| Процессоры Intel® Pentium® 2000/G2000/G2100 Серия с Intel® HD Графическая система | Неподдерживаемая ОС | До 1 GB1 | Неподдерживаемая ОС | До ~1.7 GB1 |

| Процессор Intel® Celeron® Процессоры 900/1000/ Серия G1000 с HD-графика Intel® | Неподдерживаемая ОС | До 1 GB1 | Неподдерживаемая ОС | До ~1.7 GB1 |

| Intel Atom® Процессоры с Графические решения Intel® Media Accelerator 3600 | Неподдерживаемая ОС | Неподдерживаемая ОС | Неподдерживаемая ОС | Общее количество на 1 ГБ RAM приводит к макс. видео RAM1 на 247 Мбайт; Общее количество на 2 ГБ RAM приводит к макс. видео RAM1 на 759 Мбайт; Общее количество на 4 ГБ RAM приводит к макс. видео RAM1 на 1399 Мбайт |

| HD-графика Intel® 3000/2000 (Соединенный с Intel® 6 Наборы микросхем) | Неподдерживаемая ОС | До 1 GB1 | До ~1.7 GB1 | До ~1.7 GB1 |

| Процессоры Intel® Pentium® 900/B900/G600/G800 Серия с Intel® HD Графическая система | Неподдерживаемая ОС | До 1 GB1 | До ~1.7 GB1 | До ~1.7 GB1 |

| Процессор Intel® Celeron® Процессоры 700/800/B700/B800/ G400/G500 Серия с HD-графика Intel® | Неподдерживаемая ОС | До 1 GB1 | До ~1.7 GB1 | До ~1.7 GB1 |

| 1st Generation Intel® Процессоры Core с HD-графика Intel® (Соединенный с Intel® 5 Наборы микросхем) | Неподдерживаемая ОС | До 1 GB1 | До ~1.7 GB1 | До ~1.7 GB1 |

| Процессор Intel® Pentium® Процессоры G6000/P6000/U5000 Серия с HD-графика Intel® | Неподдерживаемая ОС | До 1 GB1 | До ~1.7 GB1 | До ~1.7 GB1 |

| Процессор Intel® Celeron® Процессоры P4000/U3000 Серия с HD-графика Intel® | Неподдерживаемая ОС | До 1 GB1 | До ~1.7 GB1 | До ~1.7 GB1 |

| Mobile Intel® 4 Экспресс серии Семейство наборов микросхем | Неподдерживаемая ОС | До 1 GB1 | До ~1.7 GB1 | До ~1.7 GB1 |

| Intel® G41, G43, G45, Q43 и Q45 Наборы микросхем | Неподдерживаемая ОС | До 1 GB1 | До ~1.7 GB1 | До ~1.7 GB1 |

| Intel® G35 Наборы микросхем | 384 MB1 | 384 MB1 | 358 MB1 | 358 MB1 |

| Intel® G31, G33, Q33 и Q35 Наборы микросхем | 384 MB1 | 384 MB1 | 256 MB1 | 256 MB1 |

| Mobile Intel® GL960 и GM965 Наборы микросхем | 384 MB1 | 384 MB1 | 358 MB1 | 358 MB1 |

| Intel® G965 Наборы микросхем | 384 MB1 | 384 MB1 | 358 MB1 | 358 MB1 |

| Intel® Q963 и Q965 Наборы микросхем | 256 MB1 | 256 MB1 | 256 MB1 | 256 MB1 |

| Intel® 946GZ Наборы микросхем | 256 MB1 | 256 MB1 | 256 MB1 | 256 MB1 |

| Intel® 945GM для мобильных ПК Набор микросхем Express Семейство | 224 MB1 | 224 MB1 | 256 MB1 | 256 MB1 |

| Экспресс Intel® 945G Семейство наборов микросхем | 224 MB1 | 224 MB1 | 256 MB1 | 256 MB1 |

| Графические решения Intel® Media Accelerator 3150 | 256 MB1 | 384 MB1 | 286 MB1 | 256 MB1 |

www.intel.ru

Как увеличить память видеокарты

Несмотря на то, что современный контент требует все более мощных графических ускорителей, некоторые задачи вполне по силам интегрированным в процессор или материнскую плату видеоядрам. Встроенная графика не имеет собственной видеопамяти, поэтому пользуется частью ОЗУ.

Из этой статьи мы узнаем, как увеличить объем памяти, выделяемой интегрированной видеокарте.

Увеличиваем память видеокарты

Первым делом стоит заметить, что если Вы ищете информацию о том, как добавить видеопамяти дискретному графическому адаптеру, то спешим Вас разочаровать: это невозможно. Все видеокарты, которые подключаются к материнской плате, имеют собственные чипы памяти и только иногда, когда они переполняются, «перекидывают» часть информации в ОЗУ. Объем чипов фиксированный и коррекции не подлежит.

В свою очередь, встроенные карты используют так называемую Shared memory, то есть ту, которой система с ней «делится». Размер выделенного места в оперативке определяется типом чипа и материнской платы, а также настройками БИОС.

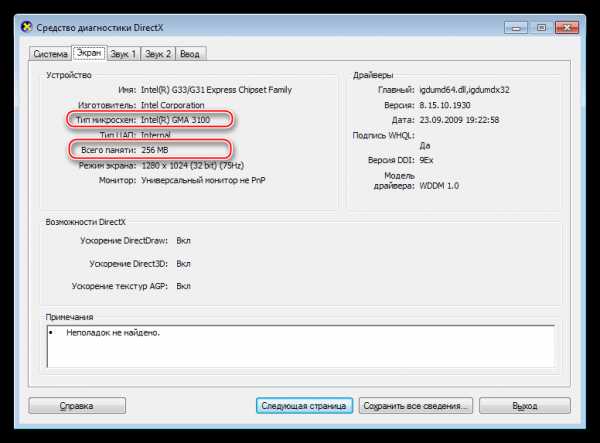

Прежде, чем пытаться увеличить количество выделенной памяти для видеоядра, необходимо выяснить, какой максимальный объем поддерживает чип. Посмотрим, какого типа встроенное ядро стоит у нас в системе.

- Нажимаем сочетание клавиш WIN+R и в поле ввода окна «Выполнить» пишем команду dxdiag.

- Откроется панель диагностики DirectX, где нужно перейти на вкладку «Экран». Здесь мы видим всю необходимую информацию: модель графического процессора и объем видеопамяти.

- Поскольку не обо всех видеочипах, особенно старых, можно легко отыскать информацию на официальных сайтах, то воспользуемся поисковой системой. Вводим запрос вида «intel gma 3100 характеристики» или «intel gma 3100 спецификация».

Ищем информацию.

Видим, что в данном случае ядро пользуется максимальным количеством памяти. Это значит, что никакие манипуляции не помогут увеличить его производительность. Существуют кастомные драйвера, которые добавляют некоторые свойства таким видеоядрам, например, поддержку более новых версий DirectX, шейдеров, увеличенных частот и прочего. Использование такого ПО крайне не рекомендуется, так как может вызвать неполадки в работе и даже вывести из строя Вашу встроенную графику.

Идем дальше. Если «Средство диагностики DirectX» показывает объем памяти, отличный от максимального, то существует возможность, изменив настройки БИОС, добавить размер выделенного места в ОЗУ. Доступ к настройкам материнской платы можно получить при загрузке системы. Во время появления логотипа производителя необходимо несколько раз нажать на клавишу DELETE. Если этот вариант не сработал, то почитайте мануал к материнке, возможно, в вашем случае используется другая кнопка или комбинация.

Поскольку BIOS на разных материнских платах могут сильно отличаться друг от друга, то точной инструкции по настройке привести невозможно, только общие рекомендации.

Для БИОСов типа AMI нужно перейти на вкладку c названием «Advanced» с возможными дописками, например, «Advanced BIOS Features» и найти там пункт, где имеется возможность выбрать значение, определяющее объем памяти. В нашем случае это «UMA Frame Buffer Size». Здесь просто выбираем нужный размер и сохраняем настройки клавишей F10.

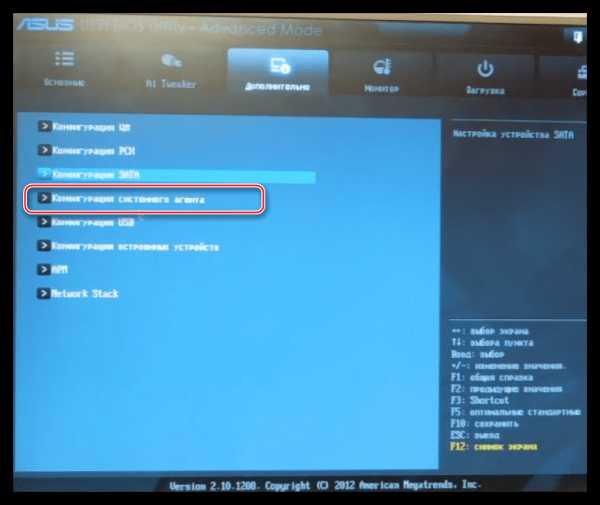

В UEFI БИОСах необходимо вначале включить расширенный режим. Рассмотрим пример с BIOS материнской платы ASUS.

- Здесь также нужно перейти на вкладку «Дополнительно» и выбрать раздел «Конфигурация системного агента».

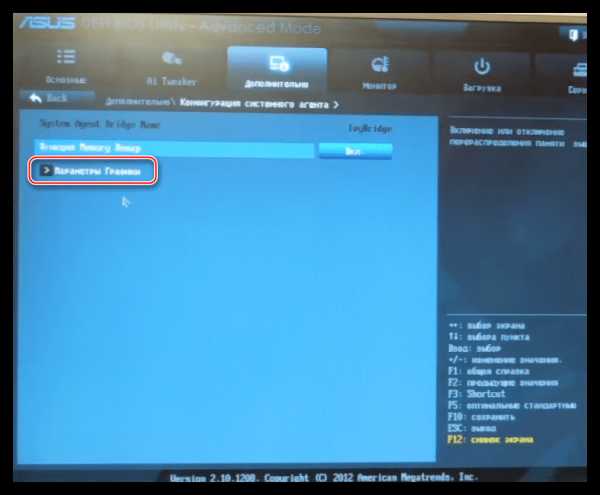

- Далее ищем пункт «Параметры графики».

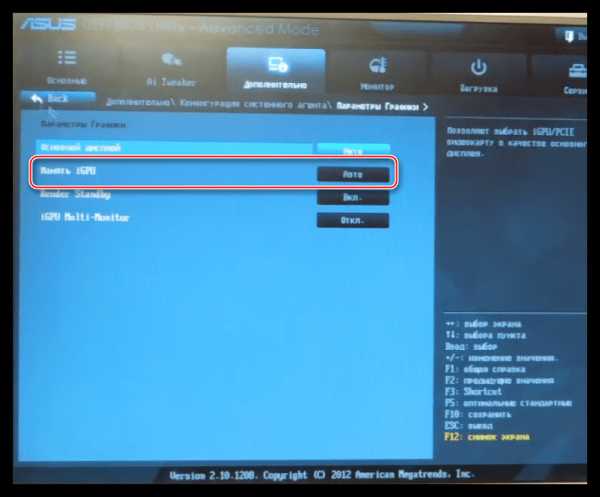

- Напротив параметра «Память iGPU» меняем значение на нужное.

Использование встроенного графического ядра несет в себе пониженную производительность в играх и приложениях, которые используют видеокарту. Вместе с тем, если для повседневных задач не требуется мощь дискретного адаптера, то встроенное видеоядро вполне может стать бесплатной альтернативой последнему.

Не стоит требовать от интегрированной графики невозможного и пытаться «разогнать» ее при помощи драйверов и другого программного обеспечения. Помните, что нештатные режимы работы могут привести к неработоспособности чипа или других компонентов на материнской плате.

Мы рады, что смогли помочь Вам в решении проблемы.Опишите, что у вас не получилось. Наши специалисты постараются ответить максимально быстро.

Помогла ли вам эта статья?

ДА НЕТlumpics.ru

Настройка NVIDIA для максимальной производительности в играх

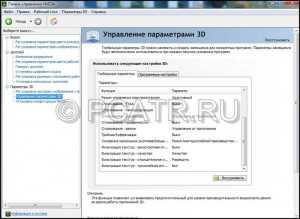

В руководстве подробно описан процесс управления настройками видеокарты NVIDIA. Также мы расскажем как настраивать параметры 3D NVIDIA для некоторых игр. Перед тем как производить настройку, необходимо установить драйвера для Nvidia.

Настройка параметров видеокарты NVIDIA для игр.

Если драйвера установлены, мы приступаем к настройке.

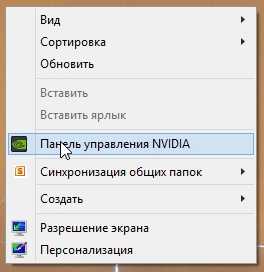

Кликаем по рабочему столу правой кнопкой мыши, чтобы появилось всплывающее меню. В котором выбираем пункт: Панель управления NVIDIA

После этого мы попадаем в панель управления. Переходим в раздел: Параметры 3D

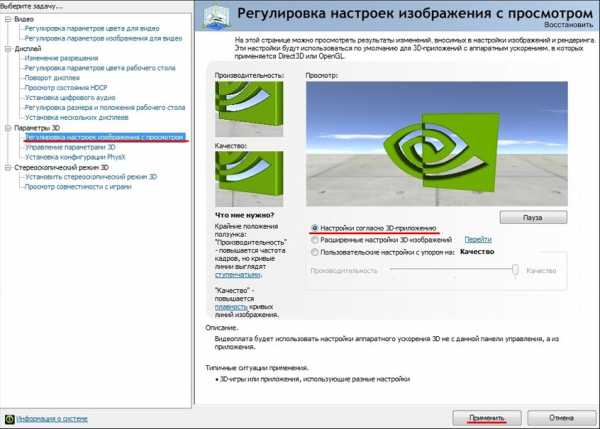

В появившемся окне сначала выбираем пункт: Регулировка настроек изображения с просмотром

Далее выбираем: Настройки согласно 3D-приложению

Нажимаем: Применить (как показано на рисунке ниже)

Теперь начинается самое интересное.

Настройка параметров 3D NVIDIA для игр

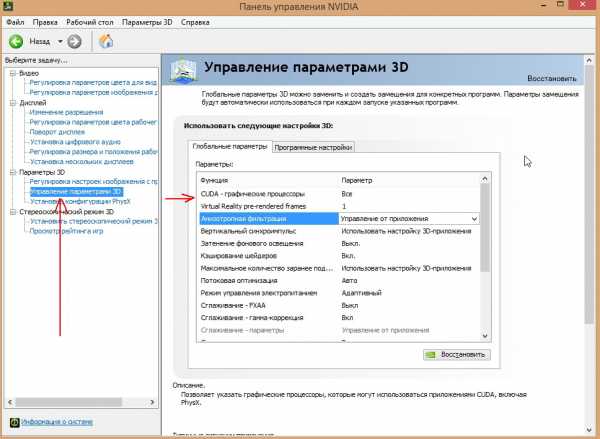

Переходим в раздел: Управление параметрами 3D

После этого приступаем к настройке параметров в правом окне.

После этого приступаем к настройке параметров в правом окне.

Для корректной работы приложений необходимо выставить следующие параметры:

- CUDA — графические процессоры: Все

- Анизотропная фильтрация: Выключаем

- V-Sync (вертикальная синхронизация): Выключаем

- Вертикальный синхроимпульс»: Использовать настройку 3D-приложения

- Затенение фонового освещения»: Выключаем

- Максимальное количество заранее подготовленных кадров: следует выбрать пункт, который отмечен значком NVIDIA

- Потоковая оптимизация: Автоматически

- Режим управления электропитанием: Адаптивный

- Сглаживание — гамма-коррекция: Выключаем

- Сглаживание — параметры: Выключаем

- Сглаживание — прозрачность: Выключаем

- Сглаживание — режим: Выключаем

- Тройная буферизация: Выключаем

- Ускорение нескольких дисплеев/смешанных ГП: Режим многодисплейной производительности

- Фильтрация текстур — анизотропная оптимизация по выборке:

- Фильтрация текстур — качество»: Наивысшая производительность

- Фильтрация текстур — отрицательное отклонение УД: Включаем

- Фильтрация текстур — трилинейная оптимизация»: Включаем

- Анизотропная фильтрация. Прямым образом влияет на качество текстур в играх. Поэтому рекомендуется выключить.

- Включить масштабируемые текстуры: Выключаем

- Ограничение расширения: Выключаем

После изменения всех настроек, нажимаем кнопку применить. Данные настройки не гарантируют 100% результата, но в 90% случаем они могут повысить FPS до 30%.

Для тех кому лень читать, мы представляем видео по настройке параметров NVIDIA

inarena.ru

Оптимальная настройка видеокарт NVIDIA

Привет всем. В одной из своих прошлых статей я уже поднимал тему увеличения быстродействия компьютера, теперь же я хочу рассказать вам, как можно добиться максимальной производительности видеокарты путём выставления оптимальных настроек её параметров. В данном примере будут рассмотрены настройки видеокарт от NVIDIA, для пользователей с картами радеон будет подготовлена отдельная статья, так что наберитесь терпения.

Оптимальные настройки видеокарт от NVIDIA

В целом, эффект от приведённых ниже настроек может достигать до 40% к производительности видеокарты в 3D-приложениях, причем это без использования специализированных программ для разгона, что может весьма существенно, для примера, повысить fps в World of Tanks и других современных игрушках.

Выставляем оптимальные настройки видеокарты:

- Анизотропная фильтрация – 16x (в 3D графике позволяет улучшить отображение текстур на поверхностях, сильно наклонённых относительно камеры.)

- Тройная буферизация – Выкл. (позволяет уменьшить количество артефактов, но требует больших системных ресурсов)

- Фильтрация текстур / анизотропная оптимизация по выборке – Выкл.

- Фильтрация текстур / отрицательное отклонение УД – Привязка

- Фильтрация текстур / качество – производительность

- Фильтрация текстур / трилинейная оптимизация – Выкл.

- Фильтрация текстур / анизотропная оптимизация фильтрацией – Выкл.

- Ускорение нескольких дисплеев / смешанных ГП – Режим однодисплейной производительности

- Вертикальный синхроимпульс – Адаптивный

- Потоковая оптимизация – Вкл. (Управляет количеством GPU, использемых 3D приложениями)

- PhysX – ЦП

- Сглаживание-прозрач. – Выкл.

- Режим управления электропитанием – предпочтителен режим максимальной производительности

- Максимальное количество заранее подготовленных кадров – 1

После выставления этих настроек, нажмите кнопку «Применить». Замечу, что для разных видеокарт количество настроек может быть другим, поэтому меняйте только те, которые доступны для вашей модели. Оценить прирост производительности можно запустив какую нибудь игрушку или с помощью специальных программ, таких как 3DMark, например.

У нас вы можете скачать бесплатно плей маркет на телефон. Как улучшить производительность компьютера.

pcatr.ru

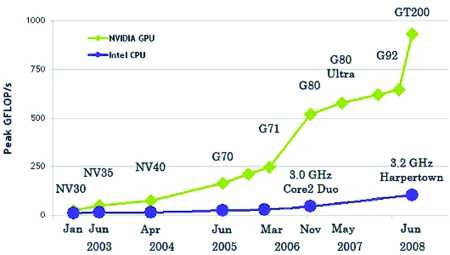

Суперкомпьютер из видеокарты: задействуем возможности GPU для ускорения софта

Сегодня новости об использовании графических процессоров для общих вычислений можно услышать на каждом углу. Такие слова, как CUDA, Stream и OpenCL, за каких-то два года стали чуть ли не самыми цитируемыми в айтишном интернете. Однако, что значат эти слова, и что несут стоящие за ними технологии, известно далеко не каждому. А для линуксоидов, привыкших «быть в пролете», так и вообще все это видится темным лесом.

Предисловие

В этой статье мы попытаемся разобраться, зачем нужна технология GPGPU (General-purpose graphics processing units, Графический процессор общего назначения) и все связанные с ней реализации от конкретных производителей. Узнаем, почему эта технология имеет очень узкую сферу применения, в которую подавляющее большинство софта не попадает в принципе, и конечно же, попытаемся извлечь из всего этого выгоду в виде существенных приростов производительности в таких задачах, как шифрование, подбор паролей, работа с мультимедиа и архивирование.

Рождение GPGPU

Мы все привыкли думать, что единственным компонентом компа, способным выполнять любой код, который ему прикажут, является центральный процессор. Долгое время почти все массовые ПК оснащались единственным процессором, который занимался всеми мыслимыми расчетами, включая код операционной системы, всего нашего софта и вирусов.

Позже появились многоядерные процессоры и многопроцессорные системы, в которых таких компонентов было несколько. Это позволило машинам выполнять несколько задач одновременно, а общая (теоретическая) производительность системы поднялась ровно во столько раз, сколько ядер было установлено в машине. Однако оказалось, что производить и конструировать многоядерные процессоры слишком сложно и дорого. В каждом ядре приходилось размещать полноценный процессор сложной и запутанной x86-архитектуры, со своим (довольно объемным) кэшем, конвейером инструкций, блоками SSE, множеством блоков, выполняющих оптимизации и т.д. и т.п. Поэтому процесс наращивания количества ядер существенно затормозился, и белые университетские халаты, которым два или четыре ядра было явно мало, нашли способ задействовать для своих научных расчетов другие вычислительные мощности, которых было в достатке на видеокарте (в результате даже появился инструмент BrookGPU, эмулирующий дополнительный процессор с помощью вызовов функций DirectX и OpenGL).

Графические процессоры, лишенные многих недостатков центрального процессора, оказались отличной и очень быстрой счетной машинкой, и совсем скоро к наработкам ученых умов начали присматриваться сами производители GPU (а nVidia так и вообще наняла большинство исследователей на работу). В результате появилась технология nVidia CUDA, определяющая интерфейс, с помощью которого стало возможным перенести вычисление сложных алгоритмов на плечи GPU без каких-либо костылей. Позже за ней последовала ATi (AMD) с собственным вариантом технологии под названием Close to Metal (ныне Stream), а совсем скоро появилась ставшая стандартом версия от Apple, получившая имя OpenCL.

GPU — наше все?

Несмотря на все преимущества, техника GPGPU имеет несколько проблем. Первая из них заключается в очень узкой сфере применения. GPU шагнули далеко вперед центрального процессора в плане наращивания вычислительной мощности и общего количества ядер (видеокарты несут на себе вычислительный блок, состоящий из более чем сотни ядер), однако такая высокая плотность достигается за счет максимального упрощения дизайна самого чипа.

В сущности основная задача GPU сводится к математическим расчетам с помощью простых алгоритмов, получающих на вход не очень большие объемы предсказуемых данных. По этой причине ядра GPU имеют очень простой дизайн, мизерные объемы кэша и скромный набор инструкций, что в конечном счете и выливается в дешевизну их производства и возможность очень плотного размещения на чипе. GPU похожи на китайскую фабрику с тысячами рабочих. Какие-то простые вещи они делают достаточно хорошо (а главное — быстро и дешево), но если доверить им сборку самолета, то в результате получится максимум дельтаплан. Поэтому первое ограничение GPU — это ориентированность на быстрые математические расчеты, что ограничивает сферу применения графических процессоров помощью в работе мультимедийных приложений, а также любых программ, занимающихся сложной обработкой данных (например, архиваторов или систем шифрования, а также софтин, занимающихся флуоресцентной микроскопией, молекулярной динамикой, электростатикой и другими, малоинтересными для линуксоидов вещами).

Вторая проблема GPGPU в том, что адаптировать для выполнения на GPU можно далеко не каждый алгоритм. Отдельно взятые ядра графического процессора довольно медлительны, и их мощь проявляется только при работе сообща. А это значит, что алгоритм будет настолько эффективным, насколько эффективно его сможет распараллелить программист. В большинстве случаев с такой работой может справиться только хороший математик, которых среди разработчиков софта совсем немного.

И третье: графические процессоры работают с памятью, установленной на самой видеокарте, так что при каждом задействовании GPU будет происходить две дополнительных операции копирования: входные данные из оперативной памяти самого приложения и выходные данные из GRAM обратно в память приложения. Нетрудно догадаться, что это может свести на нет весь выигрыш во времени работы приложения (как и происходит в случае с инструментом FlacCL, который мы рассмотрим позже).

Но и это еще не все. Несмотря на существование общепризнанного стандарта в лице OpenCL, многие программисты до сих пор предпочитают использовать привязанные к производителю реализации техники GPGPU. Особенно популярной оказалась CUDA, которая хоть и дает более гибкий интерфейс программирования (кстати, OpenCL в драйверах nVidia реализован поверх CUDA), но намертво привязывает приложение к видеокартам одного производителя.

KGPU или ядро Linux, ускоренное GPU

Исследователи из университета Юты разработали систему KGPU, позволяющую выполнять некоторые функции ядра Linux на графическом процессоре с помощью фреймворка CUDA. Для выполнения этой задачи используется модифицированное ядро Linux и специальный демон, который работает в пространстве пользователя, слушает запросы ядра и передает их драйверу видеокарты с помощью библиотеки CUDA. Интересно, что несмотря на существенный оверхед, который создает такая архитектура, авторам KGPU удалось создать реализацию алгоритма AES, который поднимает скорость шифрования файловой системы eCryptfs в 6 раз.

Что есть сейчас?

В силу своей молодости, а также благодаря описанным выше проблемам, GPGPU так и не стала по-настоящему распространенной технологией, однако полезный софт, использующий ее возможности, существует (хоть и в мизерном количестве). Одними из первых появились крэкеры различных хэшей, алгоритмы работы которых очень легко распараллелить. Также родились мультимедийные приложения, например, кодировщик FlacCL, позволяющий перекодировать звуковую дорожку в формат FLAC. Поддержкой GPGPU обзавелись и некоторые уже существовавшие ранее приложения, самым заметным из которых стал ImageMagick, который теперь умеет перекладывать часть своей работы на графический процессор с помощью OpenCL. Также есть проекты по переводу на CUDA/OpenCL (не любят юниксоиды ATi) архиваторов данных и других систем сжатия информации. Наиболее интересные из этих проектов мы рассмотрим в следующих разделах статьи, а пока попробуем разобраться с тем, что нам нужно для того, чтобы все это завелось и стабильно работало.

GPU уже давно обогнали x86-процессоры в производительности

Во-первых, понадобится видеокарта, поддерживающая технологию CUDA или Stream. Необязательно, чтобы она была топовая, достаточно только, чтобы год ее выпуска был не менее 2009. Полный список поддерживаемых видюшек можно посмотреть в Википедии: en.wikipedia.org/wiki/CUDA и en.wikipedia.org/wiki/AMD_Stream_Processor. Также о поддержке той или иной технологии можно узнать, прочитав документацию, хотя в большинстве случаев будет достаточным взглянуть на коробку из под видеокарты или ноутбука, обычно на нее наклеены различные рекламные стикеры.

Во-вторых, в систему должны быть установлены последние проприетарные драйвера для видеокарты, они обеспечат поддержку как родных для карточки технологий GPGPU, так и открытого OpenCL.

И в-третьих, так как пока дистрибутивостроители еще не начали распространять пакеты приложений с поддержкой GPGPU, нам придется собирать приложения самостоятельно, а для этого нужны официальные SDK от производителей: CUDA Toolkit или ATI Stream SDK. Они содержат в себе необходимые для сборки приложений заголовочные файлы и библиотеки.

Ставим CUDA Toolkit

Идем по вышеприведенной ссылке и скачиваем CUDA Toolkit для Linux (выбрать можно из нескольких версий, для дистрибутивов Fedora, RHEL, Ubuntu и SUSE, есть версии как для архитектуры x86, так и для x86_64). Кроме того, там же надо скачать комплекты драйверов для разработчиков (Developer Drivers for Linux, они идут первыми в списке).

Запускаем инсталлятор SDK:

$ sudo sh cudatoolkit_4.0.17_linux_64_ubuntu10.10.run

Когда установка будет завершена, приступаем к установке драйверов. Для этого завершаем работу X-сервера:

# sudo /etc/init.d/gdm stop

Открываем консоль <Ctrl+Alt+F5> и запускаем инсталлятор драйверов:

$ sudo sh devdriver_4.0_linux_64_270.41.19.run

После окончания установки стартуем иксы:

$ startx

Чтобы приложения смогли работать с CUDA/OpenCL, прописываем путь до каталога с CUDA-библиотеками в переменную LD_LIBRARY_PATH:

$ export LD_LIBRARY_PATH=/usr/local/cuda/lib64

Или, если ты установил 32-битную версию:

$ export LD_LIBRARY_PATH=/usr/local/cuda/lib32

Также необходимо прописать путь до заголовочных файлов CUDA, чтобы компилятор их нашел на этапе сборки приложения:

$ export C_INCLUDE_PATH=/usr/local/cuda/include

Все, теперь можно приступить к сборке CUDA/OpenCL-софта.

Ставим ATI Stream SDK

Stream SDK не требует установки, поэтому скачанный с сайта AMD-архив можно просто распаковать в любой каталог (лучшим выбором будет /opt) и прописать путь до него во всю ту же переменную LD_LIBRARY_PATH:

$ wget http://goo.gl/CNCNo

$ sudo tar -xzf ~/AMD-APP-SDK-v2.4-lnx64.tgz -C /opt

$ export LD_LIBRARY_PATH=/opt/AMD-APP-SDK-v2.4-lnx64/lib/x86_64/

$ export C_INCLUDE_PATH=/opt/AMD-APP-SDK-v2.4-lnx64/include/

Как и в случае с CUDA Toolkit, x86_64 необходимо заменить на x86 в 32-битных системах. Теперь переходим в корневой каталог и распаковываем архив icd-registration.tgz (это своего рода бесплатный лицензионный ключ):

$ sudo tar -xzf /opt/AMD-APP-SDK-v2.4-lnx64/icd-registration.tgz -С /

Проверяем правильность установки/работы пакета с помощью инструмента clinfo:

$ /opt/AMD-APP-SDK-v2.4-lnx64/bin/x86_64/clinfo

ImageMagick и OpenCL

Поддержка OpenCL появилась в ImageMagick уже достаточно давно, однако по умолчанию она не активирована ни в одном дистрибутиве. Поэтому нам придется собрать IM самостоятельно из исходников. Ничего сложного в этом нет, все необходимое уже есть в SDK, поэтому сборка не потребует установки каких-то дополнительных библиотек от nVidia или AMD. Итак, скачиваем/распаковываем архив с исходниками:

$ wget http://goo.gl/F6VYV

$ tar -xjf ImageMagick-6.7.0-0.tar.bz2

$ cd ImageMagick-6.7.0-0

Далее устанавливаем инструменты сборки:

$ sudo apt-get install build-essential

Запускаем конфигуратор и грепаем его вывод на предмет поддержки OpenCL:

$ LDFLAGS=-L$LD_LIBRARY_PATH ./confi gure | grep -e cl.h -e OpenCL

Правильный результат работы команды должен выглядеть примерно так:

checking CL/cl.h usability... yes

checking CL/cl.h presence... yes

checking for CL/cl.h... yes

checking OpenCL/cl.h usability... no

checking OpenCL/cl.h presence... no

checking for OpenCL/cl.h... no

checking for OpenCL library... -lOpenCL

Словом «yes» должны быть отмечены либо первые три строки, либо вторые (или оба варианта сразу). Если это не так, значит, скорее всего, была неправильно инициализирована переменная C_INCLUDE_PATH. Если же словом «no» отмечена последняя строка, значит, дело в переменной LD_LIBRARY_PATH. Если все окей, запускаем процесс сборки/установки:

$ sudo make install clean

Проверяем, что ImageMagick действительно был скомпилирован с поддержкой OpenCL:

$ /usr/local/bin/convert -version | grep Features

Features: OpenMP OpenCL

Теперь измерим полученный выигрыш в скорости. Разработчики ImageMagick рекомендуют использовать для этого фильтр convolve:

$ time /usr/bin/convert image.jpg -convolve '-1, -1, -1, -1, 9, -1, -1, -1, -1' image2.jpg

$ time /usr/local/bin/convert image.jpg -convolve '-1, -1, -1, -1, 9, -1, -1, -1, -1' image2.jpg

Некоторые другие операции, такие как ресайз, теперь тоже должны работать значительно быстрее, однако надеяться на то, что ImageMagick начнет обрабатывать графику с бешеной скоростью, не стоит. Пока еще очень малая часть пакета оптимизирована с помощью OpenCL.

FlacCL (Flacuda)

FlacCL — это кодировщик звуковых файлов в формат FLAC, задействующий в своей работе возможности OpenCL. Он входит в состав пакета CUETools для Windows, но благодаря mono может быть использован и в Linux. Для получения архива с кодировщиком выполняем следующую команду:

$ mkdir flaccl && cd flaccl

$ wget www.cuetools.net/install/flaccl03.rar

Далее устанавливаем unrar, mono и распаковываем архив:

$ sudo apt-get install unrar mono

$ unrar x fl accl03.rar

Чтобы программа смогла найти библиотеку OpenCL, делаем символическую ссылку:

$ ln -s $LD_LIBRARY_PATH/libOpenCL.so libopencl.so

Теперь запускаем кодировщик:

$ mono CUETools.FLACCL.cmd.exe music.wav

Если на экран будет выведено сообщение об ошибке «Error: Requested compile size is bigger than the required workgroup size of 32», значит, у нас в системе слишком слабенькая видеокарта, и количество задействованных ядер следует сократить до указанного числа с помощью флага ‘—group-size XX’, где XX — нужное количество ядер.

Сразу скажу, из-за долгого времени инициализации OpenCL заметный выигрыш можно получить только на достаточно длинных дорожках. Короткие звуковые файлы FlacCL обрабатывает почти с той же скоростью, что и его традиционная версия.

oclHashcat или брутфорс по-быстрому

Как я уже говорил, одними из первых поддержку GPGPU в свои продукты добавили разработчики различных крэкеров и систем брутфорса паролей. Для них новая технология стала настоящим святым граалем, который позволил с легкостью перенести от природы легко распараллеливаемый код на плечи быстрых GPU-процессоров. Поэтому неудивительно, что сейчас существуют десятки самых разных реализаций подобных программ. Но в этой статье я расскажу только об одной из них — oclHashcat.

oclHashcat — это ломалка, которая умеет подбирать пароли по их хэшу с экстремально высокой скоростью, задействуя при этом мощности GPU с помощью OpenCL. Если верить замерам, опубликованным на сайте проекта, скорость подбора MD5-паролей на nVidia GTX580 составляет до 15800 млн комбинаций в секунду, благодаря чему oclHashcat способен найти средний по сложности восьмисимвольный пароль за какие-то 9 минут.

Программа поддерживает OpenCL и CUDA, алгоритмы MD5, md5($pass.$salt), md5(md5($pass)), vBulletin < v3.8.5, SHA1, sha1($pass.$salt), хэши MySQL, MD4, NTLM, Domain Cached Credentials, SHA256, поддерживает распределенный подбор паролей с задействованием мощности нескольких машин.

Автор не раскрывает исходники (что, в общем-то, логично), но у программы есть нормально работающая Linux-версия, которую можно получить на официальной страничке.

Далее следует распаковать архив:

$ 7z x oclHashcat-0.25.7z

$ cd oclHashcat-0.25

И запустить программу (воспользуемся пробным списком хэшей и пробным словарем):

$ ./oclHashcat64.bin example.hash ?l?l?l?l example.dict

oclHashcat откроет текст пользовательского соглашения, с которым следует согласиться, набрав «YES». После этого начнется процесс перебора, прогресс которого можно узнать по нажатию <s>. Чтобы приостановить процесс, кнопаем <p>, для возобновления — <r>. Также можно использовать прямой перебор (например, от aaaaaaaa до zzzzzzzz):

$ ./oclHashcat64.bin hash.txt ?l?l?l?l ?l?l?l?l

И различные модификации словаря и метода прямого перебора, а также их комбинации (об этом можно прочитать в файле docs/examples.txt). В моем случае скорость перебора всего словаря составила 11 минут, тогда как прямой перебор (от aaaaaaaa до zzzzzzzz) длился около 40 минут. В среднем скорость работы GPU (чип RV710) составила 88,3 млн/с.

Выводы

Несмотря на множество самых разных ограничений и сложность разработки софта, GPGPU — будущее высокопроизводительных настольных компов. Но самое главное — использовать возможности этой технологии можно прямо сейчас, и это касается не только Windows-машин, но и Linux.

Info

- Суть технологии GPGPU — произвольные вычисления на видеокартах.

- Существует OpenCL SDK, разрабатываемый компанией Intel, но пока с его помощью можно запускать приложения только на классическом CPU.

- FASTRA II — суперкомпьютер, построенный с использованием 13 видеокарт, мощностью 12TFLOPS.

Links

- bzip2-cuda.github.com — реализация архиватора bzip2с использованием CUDA.

- www.hoopoe-cloud.com — облачный сервис, позволяющий загружать и запускать софт с поддержкой CUDA и OpenCL.

xakep.ru

Какая видеокарта лучше всего подходит для игр 💻

При покупке или модернизации компьютера у любого более-менее играющего человека возникает вопрос о хорошей видеокарте. Конечно, если вы не любите играть или любимая игрушка это «Косынка» или что-нибудь другое на логику, то подойдёт любая видеокарта.

Для двумерных игр (не 3D) нет разницы по мощности видеокарты, потому что она используется практически только для вывода изображения и от неё не требуется сложных обсчётов пространства. В этом случае подойдёт даже встроенная видеокарта. Для трёхмерных игр всё наоборот. Производительность в играх напрямую зависит от характеристик и мощности начинки. Для лучшего понимания вопроса, давайте рассмотрим какие видеокарты бывают:

- Встроенные (интегрированные)

- Дешёвые «затычки» для слота в материнской плате

- Бюджетные

- Среднего класса

- Высокого класса

А теперь посмотрим для каких целей лучше подходят видеокарты из каждой категории.

Встроенные или интегрированные видеокарты

Интегрированные графические решения начали использовать уже давно и пользуются популярностью у нетребовательных пользователей. Основное её преимущество – это цена. Ведь за неё практически ничего не нужно платить, бесплатная видеокарта. Раньше под встроенным видео предполагалось, что это отдельный чип, установленный на материнской плате. Но так уже давно не делают, теперь вся логика встроена в центральный процессор, а на системной плате расположены только видеовыходы на монитор.

Помню, в 1999 году мой друг первый купил себе модную материнку на чипсете Intel i810 со встроенной графикой. В своей глубинке мы впервые смогли поиграть в 3D игрушки и радости небыло предела 🙂 Сегодня 3D-графикой уже никого не удивишь и если собираетесь играть, то интегрированные видеокарты не то, что вам нужно.

В гибридных процессорах Intel встроена более слабая по производительности графика, чем в AMD. Исключение составляет ядро Iris Pro (HD) 5200, 6200, которое при прочих равных довольно неплохое и позволяет даже играть на минимальных настройках в новых играх, и на средних в игрушки 2-3 лет давности.

Обычные же видеоядра Intel называются Intel HD Graphics 510, 520.. — .. 620, 630. Здесь первая цифра обозначает серию, а вторая — производительность. Т.е., чем больше первая цифра, тем больше поддерживаемых технологий, а чем выше второе число, тем быстрее чип, грубо говоря. С каждой новой архитектурой, встроенное видео в процессорах Intel прилично улучшалось, при этом сама модель процессора значения не имеет. Ради интереса, если распределить скорость обработки графики по возрастанию, то получится так:

- Sandy Bridge

- Ivy Bridge

- Haswell

- Broadwell (E)

- Skylake

- Kaby Lake

- Coffee Lake

AMD применяют технологию Fusion для объединения вычислительного процессора и видеологики в одном месте. Такие процессоры называются APU и в них встроен полноценный видеочип. С каждой новой архитектурой (LIano, Richland, Zen и др.) производительность чипов повышается. Чем выше серия процессора, тем быстрее ядро. Например A4->A12, Ryzen 3->Ryzen 7. В процессорах Ryzen встроенная графика есть в моделях в буквой «G».

То же самое относится и к модели видеочипа, история такая же: первая цифра это серия, остальные — индекс производительности. Чем выше серия, тем больше поддерживаемых технологий, например DirectX 11, 12, 13 и другие фишки. А чем больше следующее число, тем быстрее «карточка». Если сравнить AMD HD8370 и HD7480, то окажется что они почти одинаковые по производительности. Цифры ..480 немного больше чем ..370, зато серия 8000 лучше чем 7000.

Топовое видеоядро от AMD Radeon RX Vega даже заменяет дискретные видеокарточки бюджетного и начального уровня. Если есть встроенное видео, то также можно установить отдельную видеокарту и использовать только её. А если процессор поддерживает технологию Dual Graphics, то оба чипа вместе.

Характеристики дискретных видеокарт

Сразу скажу, что знание технических характеристик выбранной видеокарты не даёт однозначного понятия о её производительности, потому что очень много факторов на это влияет. По характеристикам можно лишь в общих чертах понять с чем имеем дело, но реально сравнивать видеокарты нужно по тестам в интернете.

Так уж получается, что производительность во многом зависит от архитектуры видеочипа и его внутренних характеристик, о которых в прайсах не пишут. То же самое и с процессорами. Можно взять два процессора с одинаковой частотой, но они могут отличаться по быстродействию в два раза, из-за разной внутренней архитектуры (принципиальной схемы, другими словами).

Вот основные характеристики видеокарт:

Видеочип (GPU, графический процессор) – это основной параметр, влияющий на скорость обработки 3D-графики. Но, как я уже сказал, его название вам ни о чём не скажет, надо смотреть сравнительные тесты. Каждый GPU рассчитан на свою частоту работы (как процессор) и имеет определённое количество потоковых, шейдерных, вершинных процессоров и текстурных блоков. Зная их количество и частоту можно примерно сравнить видеокарты одной линейки и одного производителя (для NVidia и AMD (ATI) принцип работы сильно отличается).

Чем больше процессоров, блоков и частота, тем лучше. Техпроцесс изготовления чипа немаловажная характеристика, на неё можно смотреть всегда и на любых картах. Чем он меньше, тем больше соотношение производительность/энергопотребление. Измеряется в нанометрах, например 14-28нм. Кстати, GPU может быть несколько. Тогда для каждого GPU используется отдельный вентилятор.

Видеопамять, по типу разделяется на DDR3-4, GDDR4-6. Чем выше – тем лучше. Старая память DDR2 уже не используется, а вот DDR3-4 ещё ставят на бюджетные модели, от неё лучше держаться подальше. Можно доплатить немного и взять карточку с уже заметно более производительной памятью GDDR4.

Частота работы видеопамяти – не менее важная характеристика, чем тактовая частота работы графического процессора. Как правило, зависит от типа памяти. Чем больше цифра, тем выше частота, и тем лучше. Очень высокая частота: 8000 MHz.

По разрядности шины память бывает 64, 128, 256, 352, 384, 512 и 2048 бит (больше – лучше). Это означает сколько можно передать информации за один такт. Считаю что это самая важная характеристика после модели графического процессора.

Объём памяти я не случайно поставил на последнее место, сейчас расскажу почему. Как вы думаете, почему на бюджетных и дорогих картах устанавливается почти одинаковый объём видеопамяти? Это чистый маркетинг, потому что для бюджетных карт лишняя видеопамять абсолютно ни к чему. Более важны разрядность шины и частота работы памяти.

Например, карта с 4096 Мб и 128 бит шиной будет намного медленней, чем карта с 2048 Мб памяти и 256 бит шиной. Слабая видеокарта просто не справится с большими объёмами текстур, и большой объём памяти в них может пригодиться лишь узкоспециализированным дизайнерам. Не гонитесь за объёмом памяти!

Интерфейс, например PCI-Express x16 3.0, не имеет значения. Главное, чтобы материнская плата поддерживала такой же интерфейс или чуть ниже.

Остальные характеристики не влияют на прямую на производительность карты, например RAMDAC – частота цифро-аналогового преобразователя практически у всех видеокарт равна 400МГц и отвечает за максимально поддерживаемое разрешение экрана (400МГц хватит ещё на много лет вперёд). Все эти параметры можно узнать с помощью специальной программы.

И «человеческая» характеристика – это актуальность видеокарты. Это значит сколько лет карточка сможет тянуть современные игры на средних или максимальных настройках. Например, можно взять топовую карту из линейки, и она переживёт ещё несколько поколений карточек, прежде чем вы задумаетесь о её замене. И скорее всего поводом для замены станет не тормоза в последних играх, а отсутствие поддержки последней версии DirectX или нужного интерфейса для подключения монитора или ЖК-телевизора.

«Затычки» для слота в материнской плате

Самые бюджетные видеокарты покупают чтобы просто подключить к ней монитор, ни о каких играх речи не идёт, кроме самых простых или очень старых. Поэтому их называют затычками PCI-Express слота в материнской плате. В принципе, её вполне могла бы заменить встроенная видеокарта, но, за неимением оной, берут недорогие затычки, поэтому их ещё называют «офисными».

В эти видеокарты установлен «обрезанный» со всех сторон видеочип, урезанная шина видеопамяти (64 или если повезёт 128 бит) и небольшой объём видеопамяти. Ради справедливости стоит упомянуть что такие видеокарты ценятся любителями домашних кинотеатров на основе компьютера HTPC (Home Theater Personal Computer). И не зря, ведь «затычки» обладают рядом преимуществ:

- низкое энергопотребление

- отсутствие шума, если охлаждение пассивное

- наличие необходимых видеовыходов для подключения монитора или ЖК телевизора

Такие видеокарты часто поставляются с пассивным охлаждением без вентилятора. Имейте ввиду, что видеокарты с пассивным охлаждением почти никогда не подходят для игр! Они сильно греются и при продолжительном нагреве портятся или сгорают. Как минимум, нужно позаботиться о хорошо вентилируемом корпусе, особенно летом.

А так как играть за домашним кинотеатром никто не собирается, то больше ничего и не нужно. На данный момент у NVidia это видеокарты моделей (от худшего к лучшему): GeForce G210-220, GT610-620, GT710-720. У AMD это видеокарты типа RadeOn R5 230.

Бюджетные видеокарты

Эти видюхи хорошо подходят для тех, кто любит иногда поиграться, пострелять монстров или играет в нетребовательные игры. Бюджетные решения это хороший вариант для замены старенькой карточки, если та, например, сгорела или начала глючить. Эти карты обычно имеют 128 бит разрядность шины памяти с обёмом 1024-20148МБ.

К бюджетным можно отнести не только те, которые позиционируются как бюджетные, но и приличные карточки прошлого поколения. Дело в том, что с выходом новой линейки видеокарт, прошлая линейка считается устаревшей. Но вся соль в том, что устаревшие карты более высокого класса переиграют бюджетные из новой линейки по той же цене!

Если подумать логически, то напрашивается вопрос, а на кой тогда новая линейка? Всё просто, компании выпускают новую топовую видеокарту, которая уделывает предыдущую топовую модель, и при этом выпускаются урезанные версии от высокого до инфрабюджетного классов, чтобы заполнить модельный ряд.

Новые недорогие модели могут иметь поддержку новых стандартов, но это чистый маркетинг. Например, появляется бюджетная видеокарта с поддержкой новой версии DirectX 12, но в реальности она не потянет игры в режиме DirectX 12 даже с минимальными настройками. При этом в новой дешёвой карте будет урезанная шина памяти. Надеюсь теперь понятно, почему более старые небюджетные видеокарты будут лучше новых бюджетных по одной и той же цене.

Среди бюджетных видеокарт NVidia на данный момент можно отметить модели GeForce GT730, GT1030. Для AMD это видеокарты типа RadeOn R7 240.

Видеокарты среднего класса

Эти видеокарты являются оптимальным выбором при покупке или модернизации компьютера. Они позволяют играть в любые современные игры на средних или даже высоких настройках. Как правило, если такая видеокарта потом меняется на более мощную, то меняется почти весь компьютер (материнская плата, процессор, оперативная память, блок питания…). Эти карточки остаются актуальными ещё один-три года. Видеокарты среднего класса могут иметь 256-384 бит шину памяти и до 4096МБ видеопамяти.

При покупке стоит обратить внимание на достаточную мощность вашего блока питания. Если кто не знает, хорошие видеокарты под нагрузкой потребляют больше, чем весь компьютер. Тут же надо обращать внимание на достаточную мощность процессора. Если процессор окажется неспособным обеспечить видеокарту данными для обработки, то она останется недогруженной и не будет работать на всю силу. Просто нужно чтобы видео и проц были из одного ценового сегмента.

Для примера, современные видеокарты среднего класса у NVidia это GeForce GTS1050, GTX1060(Ti). У AMD это модельки RadeOn RX460, RX550, RX560 и другие.

Высококлассные видеокарты для всех игр

Это — эталон производительности, мечта любого геймера! Именно они участвуют в борьбе производителей за право называться лучшим. Это видеокарты с двумя и более графическими процессорами, с максимальной разрядностью шины и видеопамяти. Прожорливы и выглядят как танк! Под такую видеокарту компьютер подбирать надо изначально, а то потом придётся менять всю комплектуху (материнскую плату, процессор, оперативную память, блок питания и может быть даже корпус).

Стоят они как весь ваш компьютер! Никакая игрушка не осмелиться тормознуть на такой системе 🙂 Учтите, что не во всякий корпус такая влезет, и охлаждение в корпусе должно быть продуманным.

Есть большой плюс в покупке такой карты – это большой срок актуальности, он может составлять несколько лет. Но минус в том, что через год после выпуска топовой карты цена на неё может сильно упасть. Явных энтузиастов это никогда не останавливало 🙂 С такой видеокартой вы ещё долго не будете искать что-то получше!

В качестве примера видеокарт высшего ценового диапазона можно привести Nvidia GTX1070, GTX1080(Ti), для AMD это видеокарты моделей RadeOn RX470, 570, 580. Модели с приставкой «Ti» означают «Titanium», более мощные. Кстати, самые классные видеокарты сильно дороже средних, потому что их используют для майнинга криптовалют, спрос очень высокий. Поэтому геймеры ненавидят майнеров 🙁

Существуют ещё профессиональные видеокарты, например NVidia Quadro. Лучше дам выдержку из Википедии:

Quadro — бренд графических карт фирмы NVIDIA, предназначенный для профессионального использования в рабочих станциях САПР, станциях компьютерной графики и создания цифрового контента. Графические процессоры, используемые в продуктах Quadro, идентичны процессорам в графических картах GeForce. Конечные продукты графических карт отличаются по существу драйверами устройств и профессиональным уровнем поддержки программного обеспечения.

Quadro NVS — видеокарты, разработанные для бизнес-приложений (финансовых, корпоративных, ECAD) и для многомониторных решений

Что можно сделать чтобы увеличить производительность без замены видеокарты?

В некоторых случаях производительность зависит от драйверов видеокарты. Если они были криво установлены, то придётся удалить драйвера видеокарты и установить их заново.

Есть такое призвание «оверклокер». Это люди, которые выжимают всё из своего компьютера. Они разгоняют процессор, память и видеокарту до предельно возможных значений и пользуются бОльшей производительностью. В принципе, в небольшом разгоне нет ничего плохого, но небольшой разгон не даст большого прироста производительности.

Некоторые производители выпускают видеокарты уже с заводским разгоном. Например, у Palit в названии разогнанных карт есть слово «Sonic». Куда лучше прикупить на барахолке такую же видеокарту как у вас и поставить рядом с имеющейся. Для этого понадобится специальный мостик, который также продаётся, и поддержка материнской платой двух и более карт. Тогда обе карточки будут трудиться на одно общее дело по технологии SLI для NVidia, и CrossFireX для AMD. При этом производительность поднимется в 1,5-1,8 раз.

Полезный совет: будьте осторожны при подключении к компьютеру телевизора по HDMI!

На этом всё, если вам понравилась статья буду премного благодарен, если вы поделитесь ей с друзьями через социальные сети. Подпишитесь на обновления блога, чтобы получать новую полезную информацию прямо на почту!

Предлагаю посмотреть видео моего коллеги, узнаете ещё интересные фишки:

it-like.ru