Сравните спецификации видеокарт серии GeForce GTX 10

GEFORCE GTX 1080

1080 Ti / 1080

GEFORCE GTX 1070

1070 Ti / 1070

GEFORCE GTX 1060

6ГБ / 3ГБ

GEFORCE GTX 1050

1050 Ti / 1050

Спецификации GPU

NVIDIA CUDA® Cores

3584 / 2560

2423/1920

1280 / 1152

768 / 640

Базовая тактовая частота (МГц)

1480 / 1607

1607 / 1506

1506

1290 / 1354

Тактовая частота с ускорением (МГц)

1582 / 1733

1683 / 1683

1708

1392 / 1455

Спецификации памяти

Быстродействие памяти

11 Гбит/с / 10 Гбит/с

8.0 Гбит/с

8.0 Гбит/с

7.0 Гбит/с

Стандартная конфигурация памяти

11 GB GDDR5X / 8 GB GDDR5X

8 GB GDDR5

6 GB GDDR5 / 3 GB GDDR5

4 GB GDDR5 / 2 GB GDDR5

Полоса пропускания шины памяти

256-bit

192-bit

128-bit

Пропускная способность памяти (Гбит/с)

484 / 320

256

192

112

Дополнительная информация

Потребление энергии (W)

250W / 180W

180W /150W

120W

75W

Максимальное цифровое разрешение*

7680×4320 @60Hz

7680×4320 @60Hz

7680×4320 @60Hz

7680×4320 @60Hz

Максимальное VGA разрешение

2048×1536

2048×1536

2048×1536

2048×1536

Стандартные разъемы

Dual Link DVI-I, HDMI 2.0b, 3x Display Port 1.4

Dual Link DVI-I, HDMI 2.0b, 3x Display Port 1.4

Dual Link DVI-I, HDMI 2.0b, 3x Display Port 1.4

Dual Link DVI-I, HDMI 2.0b, 3x Display Port 1.4

Поддержка нескольких мониторов

4 displays

4 displays

4 displays

4 displays

* Разрешение 5120×3200 при 60Гц при использовании двух разъемов DisplayPort.

Поддержка технологий

Поддержка NVIDIA SLI®

Да

Да

Нет

Нет

Да

Да

Да

Да

Поддержка технологии NVIDIA GameStream™

Да

Да

Да

Да

GeForce ShadowPlay™

Да

Да

Да

Да

NVIDIA GPU Boost™

Да

Да

Да

Да

Dynamic Super Resolution

Да

Да

Да

Да

NVIDIA GameWorks™

Да

Да

Да

Да

Microsoft DirectX

Да

Да

Да

Да

OpenGL

Да

Да

Да

www.nvidia.com

Краткая история компании NVIDIA в видеокартах GeForce серий GT, GTX и RTX

Краткая история компании NVIDIA в видеокартах GeForce серий GT, GTX и RTX

NVIDIA Corporation — американская технологическая компания, разработчик графических процессоров и систем-на-чипе (SoC). Разработки NVIDIA получили распространение в индустрии видеоигр, сфере профессиональной визуализации, области высокопроизводительных вычислений и автомобильной промышленности, где бортовые компьютеры NVIDIA используются в качестве основы для беспилотных автомобилей. Важным приоритетом для компании также является рынок искусственного интеллекта (ИИ).

Компания была основана в 1993 году. На III квартал 2018 года NVIDIA была крупнейшим в мире производителем PC-совместимой дискретной графики с долей 74,3% (статистика включает все графические процессоры, доступные для прямой покупки конечными пользователями — GeForce, Quadro и ускорители вычислений на базе GPU Tesla). По состоянию на январь 2018 года численность сотрудников превышала 11,5 тысяч человек. Штаб-квартира компании находится в городе Санта-Клара, штат Калифорния (США).

Желаю всем приятного просмотра!

Ещё больше интересного материала, качественного косплея и превосходных артов вы сможете найти здесь!

NV 1. Первый графический 3D-ускоритель от NVIDIA, выпущен в 1995 году.

Примечательная особенность данной карты состоит как в необычном подходе с 3D-рендерингом, когда использовались Quadratic Texture Maps, вместо привычных нынче полигонов, так и в наличии микросхемы, отвечавшей за обработку звука.

Riva 128/128ZX. В 1997 году компанией был выпущен второй графический чип, основанный на 350-нм техпроцессе, сыскавший звание «народного».

Название RIVA является акронимом Real-time Interactive Video and Animation, а цифра 128 указывает на разрядность шины. Главной «фишкой» GPU является технология рендеринга, основанной на квадратическом маппинге текстур, который не поддерживался в Direct3D.

В 1998 году была выпущена Riva TNT — комбинированный 2D/3D ускоритель

Суффикс TNT означал, что чип способен работать с двумя текселями одновременно, а TNT сокращение от TwiN Texel. Для справки: Тексель это минимальная единица текстуры 3D объекта, а пиксель наименьшая единица текстуры 2D объекта.

Riva TNT2

В начале 1999 года компания NVIDIA начала производство графического процессора пятого поколения.

Riva TNT2 была доработанным вариантом TNT: добавлена поддержка AGP интерфейса, техпроцесс уменьшился до 250-нм, а частота чипа выросла с 90 до 150 мегагерц.

GeForce 256

Всё в том же 1999 году появился первый GPU из линейки GeForce.

Название GeForce появилось в результате конкурса, который проводился компанией. Главной фишкой GeForce 256 являлось наличие встроенного геометрического процессора, а также появился аппаратный блок трансформации и освещения (T&L). Кроме того именно с GeForce 256 началось использование самой быстрой на тот момент памяти DDR.

GeForce 2

В 2000 году на свет появился новый графический процессор, ядро которого было самым совершенным и производительным на то время.

Всего на базе GeForce 2 появилось более десятка модификаций, отличавшихся друг от друга разными частотами и шириной шины памяти. Именно в линейке GeForce 2 появились первые вариации для старшего модельного ряда, обозначенные суффиксом Ti — Titanium. Основу бюджетной линейки составляли карты с приставкой MX. К слову, в основу первого чипсета для материнских плат nForce легли именно GeForce 2 MX.

Следуя своему 6-месячному циклу, уже в 2001 году, компанией было представлено новое поколение графических процессоров — GeForce 3.

Следует отметить, что в отличие от GeForce 2, у GeForce 3 не было GPU начального уровня, все вариации обладали высокими на тот момент частотами, 256-битной шириной шины памяти, а также 128 битной DDR памятью. Тогда же появился шейдерный движок nfiniteFX.

GeForce 4

В 2002 году появилось четвертое поколение видеокарт GeForce, под этим именем выпускалось две линейки карт, Ti – высокопроизводительные, и бюджетные с приставкой MX.

И если старшая линейка GF4 продолжала развивать архитектуру GeForce 3, то бюджетная линейка ограничилась архитектурой GeForce 2. Ядро бюджетной модели GeForce 4 MX легло в основу чипсета nForce 2.

GeForce FX. Пятое поколение процессоров GeForce появилось в 2003 году.

Приставке FX карты обязаны новой версии шейдеров Shader Model 2.0, на тот момент продвигавшими графику на новый кинематографический уровень.

GeForce 6. В 2004 году появилось шестое поколение микропроцессоров от компании NVIDIA.

Примечательной особенностью GeForce 6 являлась обработка видео PureVideo, наличие технологии SLI, а также поддержка Shader Model 3.0.

GeForce 7

Седьмое поколение графических процессоров NVIDIA появилось в 2005 году.

Линейка GeForce 7 не привнесла каких-либо революционных нововведений, однако вполне успешно продолжила развивать заложенные технологии в GeForce 6. Например, за счет изменений в поточно-конвейерной архитектуре удалось добиться повышения производительности в полтора раза, при том же количестве потоковых конвейеров.

GeForce 8

В 2006 году состоялся выпуск восьмой серии графических акселераторов GeForce.

Эта серия имела унифицированную шейдерную архитектуру, благодаря которой изменилось представление о специализированном графическом конвейере. Например, унифицированные процессоры могли проводить как геометрические, так и пиксельные, вершинные и даже физические рассчеты. Также GeForce 8 дал свет программно-аппаратной архитектуре параллельных вычислений, которая называется CUDA (Compute Unified Device Architecture).

В 2008 году появилось девятое поколение графических процессоров GeForce 9.

Новый графический чип использовал доработанную архитектуру Tesla, заложенную в предыдущей модели карт GeForce 8. Следует отметить, что эта архитектура послужила базой для карт серий: GeForce 8, GeForce 9, GeForce 100, GeForce 200 и даже GeForce 300, настолько успешной на тот момент оказалась Tesla. Относительно GeForce 9 примечательной особенностью было очередное уменьшение техпроцесса до 65нм, а позднее и до 55нм, что положительно сказалось на габаритах печатных плат, а также на энергоэффективности конечного решения.

GeForce 100

В 2009 году появилось десятое поколение графических процессоров семейства GeForce.

Самой младшей в линейке являлись карты сотой серии, о которых мало кто слышал у нас, по причине нацеленности карт на ОЕМ-рынок. Относительно технических характеристик, то G150 были урезаны вдвое относительно GTX9800, GT130 были немногим лучше GeForce 9600GSO, а G100 являлась картой начального уровня и уступала в возможностях GT9400.

GeForce 200

Всё в том же 2009 году на рынке появилось логическое продолжение карт 9 серии в лице GeForce 200.

Первыми свет увидели GTX 280 и GTX 250, которые поддерживали технологию CUDA версии 2.0, PhysX а также улучшенную PureVideo с поддержкой декодирования видео в формате H.264, VC-1 и MPEG-2. Кроме того картами поддерживался DirectX 10 и Shader Model 4.0. Позже вышедшие 210/G210, GT 220 и GT240 получили поддержку DirectX 10.1 и Shader Model 4.1

GeForce 400

В 2010 году появилось новое поколение графических процессоров, основанное на архитектуре NVIDIA Fermi, первом ускорителе в арсенале компании с поддержкой DirectX 11.

Примечательной особенностью чипа является поддержка технологий DirectCompute и OpenCL, позволяющих проводить вычисления компьютерной графики при помощи графического процессора. Также появилась поддержка Shader Model 5.0

GeForce 500

В 2010 году компания продолжила развивать архитектуру Fermi.

Графический процессор получил поддержку технологий: 3D Vision Surround, CUDA, PhysX, а также 3-Way SLI. Карты на базе GTX 590 получили поддержку NVIDIA Quad SLI. Следует отметить, что улучшения коснулись не только новых технологий, но и была проведена работа по повышению общей производительности, а также по снижению энергопотребления, по сравнению с картами предыдущего поколения.

GeForce 600

В 2012 году, спустя два года после своего анонса, миру были представлены первые графические процессоры на основе новой архитектуры Kepler.

Новая архитектура подразумевала под собой не только ряд нововведений, среди которых есть технология GPU Boost, динамически управляющая частотой чипа, но и поддержка Nvidia TXAA. Однако самой главной особенностью 600 серии является переход на 28нм техпроцесс, что благоприятно сказывается на эргономичности и энерегоэффективности конечных решений. К слову, карты 600 серии получили поддержку не только DirectX 11.0, но и частично еще не вышедшей DirectX 12

GeForce 700

В 2013 году появились карты семейства GeForce 700, которые были представлены как на базе предыдущей архитектуры Kepler, так и новейшего Maxwell.

Следует отметить, что первыми ласточками в 700 серии стали карты GeForce GTX Titan и GTX 780 — флагманские карты, демонстрирующие всю мощь архитектуры Kepler. В 2014 году начали выходить карты GeForce GTX 750 и GTX 750 Ti на основе архитектуры Maxwell. Основной фишкой архитектуры можно назвать как динамическое разрешение для сглаживания неровностей без ущерба производительности, так и развитие технологии CUDA. Совместимость с DirectX 12 является немаловажным фактором как для геймеров, так и для разработчиков.

GeForce 900

Новейшая линейка видеокарт 900 серии основана на архитектуре Maxwell.

На данном этапе на рынке представлены две карты высшего ценового диапазона, относящихся к 900 серии — это GTX 970 и 980, а также среднего ценового диапазона GTX 960. Энергоэффективность на ватт у карт существенно возросла в отношении предшествующей линейки карт, а также снизилась теплоотдача, что выгодно сказалось на температурных режимах.

GeForce GTX 10 — Совершенство для игр

8 июля 2016 года была представлена видеокарта среднего ценового диапазона GeForce GTX 1060, сопоставимая по производительности с GeForce GTX 980, но потребляющая намного меньше энергии.

22 июля 2016 года компания NVIDIA представила профессиональную видеокарту NVIDIA TITAN X (Pascal) (не путать с видеокартой предыдущего поколения GeForce GTX Titan X (GM200), однако она не относится к игровой серии видеокарт, несмотря на то, что она основана на новом флагманском чипе GP102. Однако по обещаниям компании в дальнейшем должен выйти игровой аналог новинки.

1 марта 2017 года в ходе мероприятия GDC 2017 компания NVIDIA представила видеокарту GeForce GTX 1080 Ti, которую глава компании назвал самым мощным игровым графическим ускорителем в мире. По словам NVIDIA, новинка на 35 % производительнее GeForce GTX 1080 и обходит даже Titan X Pascal.

GeForce 20

GeForce RTX 20 Series — семейство графических процессоров NVIDIA, представленное 20 августа 2018 в рамках конференции Gamescom. Чипы семейства GeForce RTX 20 основаны на новой архитектуре Turing, названной в честь английского математика, логика и криптографа Алана Тьюринга. Заявлено увеличение производительности до 6 раз в области трассировки лучей по сравнению с графическими процессорами предыдущего поколения. В продаже с 20 сентября 2018 года.

Серия GeForce RTX 20 поддерживает трассировку лучей в реальном времени, которая реализована с помощью новых RT-ядер. Для увеличения детализации изображения используются решения на базе искусственного интеллекта

Ещё больше интересного материала, качественного косплея и превосходных артов вы сможете найти здесь!

А какой была ваша первая видеокарта?

overclockers.ru

|

Nvidia GeForce |

AMD Radeon |

|

Nvidia GeForce RTX 2080 Ti ($1,598.42) |

|

|

Titan Xp ($1,367) |

|

|

GTX Titan X (Maxwell) |

R9 295X2 |

|

GTX Titan Black |

R9 Fury |

|

GTX Titan |

RX 580 ($294.02) |

|

GTX 770 |

R9 380X |

|

GTX 1050 Ti ($219.98) |

R9 285 |

|

GTX 1050 ($129.99) |

RX 560 ($139.99) |

|

GTX 660 |

R7 265 |

|

GTX 750 Ti |

R7 260X |

|

GTX 750 |

HD 7790 |

|

GT 1030 ($84.99) |

RX 550 ($119.99) |

|

GT 740 GDDR5 |

R7 250E |

|

GTS 450 |

R7 250 (DDR3) |

|

GT 730 (64-bit, GDDR5) |

HD 4770 |

|

GT 740 DDR3 |

HD 7730 (GDDR5) |

|

GT 240 (GDDR5) |

HD 6570 (GDDR5) |

|

GT 240 (DDR3) |

R7 240 |

|

GT 730 (128-bit, GDDR5) |

HD 5550 (GDDR5) |

|

GT 730 (128-bit, DDR3) |

HD 7660D (integrated) |

|

GT 530 |

X1900 XTX |

|

GT 220 (DDR3) |

HD 7560D (integrated) |

|

GT 220 (DDR2) |

HD 7540D (integrated) |

|

9500 GT (DDR2) |

7480D (integrated) |

|

GT 520 |

6480G (integrated) |

|

6800 GS (AGP) |

6380G (integrated) |

|

8600M GS |

X1650 Pro |

|

9400 GT |

HD 6320 (integrated) |

|

9400 (integrated) |

HD 6290 (integrated) |

|

FX 5900 XT |

X1050 (128-bit) |

|

G 310 |

Xpress 1250 (integrated) |

|

9300M GS |

X1050 (64-bit) |

|

8300 (integrated) |

X1150 |

|

FX 5500 |

9250 |

|

FX 7050 (integrated) |

Xpress 1150 (integrated) |

|

2 Ti 200 |

7500 |

|

2 MX 400 |

7200 |

|

Nvidia TNT |

Rage 128

|

pro-spo.ru

| Процессор | Частота ядра | Частота памяти | Разрядность шины памяти | Частота передачи данных | Пикселей за такт | DirectX |

| GeForce4 MX 420 | 250 МГц | 166 МГц | 128-бит | 2.6 Гб/с | 1 | 7 |

| GeForce4 MX 440 SE | 250 МГц | 333 МГц | 64-бит | 2.6 Гб/с | 1 | 7 |

| GeForce4 MX 440 | 270 МГц | 400 МГц | 128-бит | 6.4 Гб/с | 1 | 7 |

| GeForce 4 MX 440 AGP 8x | 275 МГц | 512 МГц | 128-бит | 8.1 Гб/с | 1 | 7 |

| GeForce 4 MX 460 | 300 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 1 | 7 |

| GeForce MX 4000 | 250 МГц | * | 32-, 64- или 128-бит | * | 1 | 7 |

| GeForce4 Ti 4200 | 250 МГц | 514 МГц (64 МБ) или 444 МГц (128 МБ) | 128-бит | 8.2 Гб/с (64 МБ) или 7.1 Гб/с (128 МБ) | 4 | 8.1 |

| GeForce4 Ti 4200 AGP 8x | 250 МГц | 500 МГц | 128-бит | 8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4400 | 275 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4600 | 300 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4800 SE | 275 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4800 | 300 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 8.1 |

| GeForce FX 5200 | 250 МГц | 400 МГц | 64-бит или 128-бит | 3.2 Гб/с или 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5200 Ultra | 350 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 9.0 |

| GeForce FX 5600 | 325 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 9.0 |

| GeForce FX 5500 | 270 МГц | 400 МГц | 64-бит или 128-бит | 3.2 Гб/с или 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5600 Ultra | 500 МГц | 800 МГц | 128-бит | 12.8 Гб/с | 4 | 9.0 |

| GeForce FX 5700 LE | 250 МГц | 400 МГц | 128-бит | 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5700 | 425 МГц | 600 МГц | 128-бит | 9,6 Гб/с | 4 | 9.0 |

| GeForce FX 5700 Ultra | 475 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 4 | 9.0 |

| GeForce FX 5800 | 400 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 8 | 9.0 |

| GeForce FX 5800 Ultra | 500 МГц | 1 ГГц | 128-бит | 16 Гб/с | 8 | 9.0 |

| GeForce FX 5900 XT | 390 МГц | 680 МГц | 256-бит | 21.7 Гб/с | 8 | 9.0 |

| GeForce FX 5900 | 400 МГц | 850 МГц | 256-бит | 27.2 Гб/с | 8 | 9.0 |

| GeForce FX 5900 Ultra | 450 МГц | 850 МГц | 256-бит | 27.2 Гб/с | 8 | 9.0 |

| GeForce FX 5950 Ultra | 475 МГц | 950 МГц | 256-бит | 30.4 Гб/с | 8 | 9.0 |

| GeForce PCX 5300 | 325 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 9.0 |

| GeForce PCX 5750 | 475 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 4 | 9.0 |

| GeForce PCX 5900 | 350 МГц | 500 МГц | 256-бит | 17.6 Гб/с | 8 | 9.0 |

| GeForce PCX 5950 | 475 МГц | 900 МГц | 256-бит | 30.4 Гб/с | 8 | 9.0 |

| GeForce 6200 | 300 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 9.0c |

| GeForce 6200 LE | 350 МГц | 550 МГц | 64-бит | 4.4 Гб/с | 2 | 9.0c |

| GeForce 6200 (TC) | 350 МГц | 666 МГц * | 32-бит или 64-бит | 2.66 Гб/с или 5.32 Гб/с * | 4 | 9.0c |

| GeForce 6500 (TC) | 400 МГц | 666 МГц * | 32-бит или 64-бит | 2.66 Гб/с или 5.32 Гб/с * | 4 | 9.0c |

| GeForce 6600 | 300 МГц | 550 МГц * | 64-бит или 128-бит | 4.4 Гб/с или 8.8 Гб/с * | 8 | 9.0c |

| GeForce 6600 DDR2 | 350 МГц | 800 МГц * | 128-бит | 12.8 Гб/с * | 8 | 9.0c |

| GeForce 6600 LE | 300 МГц | * | 64-бит или 128-бит | * | 4 | 9.0c |

| GeForce 6600 GT | 500 МГц | 1 ГГц | 128-бит | 16 Гб/с | 8 | 9.0c |

| GeForce 6600 GT AGP | 500 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 8 | 9.0c |

| GeForce 6800 LE | 300 МГц | 700 МГц | 256-бит | 22.4 Гб/с | 8 | 9.0c |

| GeForce 6800 XT | 325 МГц | 600 МГц | 256 битs | 19.2 Гб/с | 8 | 9.0c |

| GeForce 6800 XT AGP | 325 МГц | 700 МГц | 256 битs | 22.4 Гб/с | 8 | 9.0c |

| GeForce 6800 | 325 МГц | 600 МГц | 256-бит | 19.2 Гб/с | 12 | 9.0c |

| GeForce 6800 AGP | 325 МГц | 700 МГц | 256-бит | 22.4 Гб/с | 12 | 9.0c |

| GeForce 6800 GS | 425 МГц | 1 ГГц | 256-бит | 32 Гб/с | 12 | 9.0c |

| GeForce 6800 GS AGP | 350 МГц | 1 ГГц | 256-бит | 32 Гб/с | 12 | 9.0c |

| GeForce 6800 GT | 350 МГц | 1 ГГц | 256-бит | 32 Гб/с | 16 | 9.0c |

| GeForce 6800 Ultra | 400 МГц | 1.1 ГГц | 256-бит | 35.2 Гб/с | 16 | 9.0c |

| GeForce 6800 Ultra Extreme | 450 МГц | 1.1 ГГц | 256-бит | 35.2 Гб/с | 16 | 9.0c |

| GeForce 7100 GS (TC) | 350 МГц | 666 МГц * | 64-бит | 5.3 Гб/с * | 4 | 9.0c |

| GeForce 7200 GS (TC) | 450 МГц | 800 МГц * | 64-бит | 6.4 Гб/с * | 4 | 9.0c |

| GeForce 7300 SE (TC) | 225 МГц | * | 64-бит | * | 4 | 9.0c |

| GeForce 7300 LE (TC) | 450 МГц | 648 МГц * | 64-бит | 5.2 Гб/с * | 4 | 9.0c |

| GeForce 7300 GS (TC) | 550 МГц | 810 МГц * | 64-бит | 6.5 Гб/с * | 4 | 9.0c |

| GeForce 7300 GT (TC) | 350 МГц | 667 МГц | 128-бит | 10.6 Гб/с | 8 | 9.0c |

| GeForce 7600 GS | 400 МГц | 800 МГц | 128-бит | 12.8 Гб/с | 12 | 9.0c |

| GeForce 7600 GT | 560 МГц | 1.4 ГГц | 128-бит | 22.4 Гб/с | 12 | 9.0c |

| GeForce 7800 GS | 375 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 16 | 9.0c |

| GeForce 7800 GT | 400 МГц | 1 ГГц | 256-бит | 32 Гб/с | 20 | 9.0c |

| GeForce 7800 GTX | 430 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 24 | 9.0c |

| GeForce 7800 GTX 512 | 550 МГц | 1.7 ГГц | 256-бит | 54.4 Гб/с | 24 | 9.0c |

| GeForce 7900 GS | 450 МГц | 1.32 ГГц | 256-бит | 42.2 Гб/с | 20 | 9.0c |

| GeForce 7900 GT | 450 МГц | 1.32 ГГц | 256-бит | 42.2 Гб/с | 24 | 9.0c |

| GeForce 7900 GTX | 650 МГц | 1.6 ГГц | 256-бит | 51.2 Гб/с | 24 | 9.0c |

| GeForce 7950 GT | 550 МГц | 1.4 ГГц | 256-бит | 44.8 Гб/с | 24 | 9.0c |

| GeForce 7950 GX2 ** | 500 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 24 | 9.0c |

| GeForce 8400 GS *** | 450 / 900 МГц | 800 МГц | 64-бит | 6.4 Гб/с | 16 | 10 |

| GeForce 8500 GT *** | 450 / 900 МГц | 666 МГц или 800 МГц | 128-бит | 10.6 Гб/с или 12.8 Гб/с | 16 | 10 |

| GeForce 8600 GT DDR2 *** | 540 / 1.18 ГГц | 666 МГц или 800 МГц | 128-бит | 10.6 Гб/с или 12.8 Гб/с | 32 | 10 |

| GeForce 8600 GT GDDR3 *** | 540 / 1.18 ГГц | 1.4 ГГц | 128-бит | 22.4 Гб/с | 32 | 10 |

| GeForce 8600 GTS *** | 675 / 1.45 ГГц | 2 ГГц | 128-бит | 32 Гб/с | 32 | 10 |

| GeForce 8800 GS *** ^ | 550 / 1,375 МГц | 1.6 ГГц | 192-бит | 38.4 Гб/с | 96 | 10 |

| GeForce 8800 GT *** ^ | 600 / 1.5 ГГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 112 | 10 |

| GeForce 8800 GTS *** | 500 / 1.2 ГГц | 1.6 ГГц | 320-бит | 64 Гб/с | 96 | 10 |

| GeForce 8800 GTS 512 *** ^ | 650 / 1,625 МГц | 1.94 ГГц | 256-бит | 62.08 Гб/с | 128 | 10 |

| GeForce 8800 GTX *** | 575 / 1.35 ГГц | 1.8 ГГц | 384-бит | 86.4 Гб/с | 128 | 10 |

| GeForce 8800 Ultra *** | 612 / 1.5 ГГц | 2.16 ГГц | 384-бит | 103.6 Гб/с | 128 | 10 |

| GeForce 9400 GT *** ^ | 550 / 1.4 ГГц | 800 МГц | 128-бит | 12.8 Гб/с | 16 | 10 |

| GeForce 9500 GT *** ^ | 550 / 1.4 ГГц | 1 ГГц (DDR2) или 1.6 ГГц (GDDR3) | 128-бит | 16 Гб/с (DDR2) или 25.6 Гб/с (GDDR3) | 32 | 10 |

| GeForce 9600 GSO *** ^ | 550 / 1.35 ГГц | 1.6 ГГц | 192-бит | 38.4 Гб/с | 96 | 10 |

| GeForce 9600 GSO 512 *** ^ | 650 / 1,625 МГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 48 | 10 |

| GeForce 9600 GT *** ^ | 600 / 1.5 ГГц или 650 / 1,625 МГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 64 | 10 |

| GeForce 9800 GT *** ^ | 600 / 1,500 ГГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 112 | 10 |

| GeForce 9800 GTX *** ^ | 675 / 1,688 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce 9800 GTX+ *** ^ | 738 / 1,836 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce 9800 GX2 ** *** ^ | 600 / 1.5 ГГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce G 100 *** ^ | 567 / 1.4 ГГц | 1 ГГц | 64-бит | 8 Гб/с | 8 | 10 |

| GeForce GT 120 *** ^ | 500 / 1.4 ГГц | 1 ГГц | 128-бит | 16 Гб/с | 32 | 10 |

| GeForce GT 130 *** ^ | 500 / 1.25 ГГц | 1 ГГц | 192-бит | 24 Гб/с | 48 | 10 |

| GeForce GTS 150 *** ^ | 738 / 1,836 МГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce 205 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 8 | 10.1 |

| GeForce 210 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 16 | 10.1 |

| GeForce GT 220 *** ^ | 625 / 1,360 МГц | 1.58 ГГц | 128-бит | 25.28 Гб/с | 48 | 10.1 |

| GeForce GT 240 *** ^ | 550 / 1,340 МГц | 1.8 ГГц (DDR3) или 2 ГГц (GDDR3) или 3.4 ГГц (GDDR5) | 128-бит | 28.8 Гб/с (DDR3) или 32 Гб/с (GDDR3) или 54.4 Гб/с (GDDR5) | 96 | 10.1 |

| GeForce GTS 240 *** ^ | 675 / 1,620 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 112 | 10 |

| GeForce GTS 250 512 МБ *** ^ | 675 / 1,620 МГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce GTS 250 1 GB *** ^ | 738 / 1,836 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce GTX 260 *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 192 | 10 |

| GeForce GTX 260/216 *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 216 | 10 |

| GeForce GTX 275 *** ^ | 633 / 1,404 МГц | 2.268 ГГц | 448-бит | 127 Гб/с | 240 | 10 |

| GeForce GTX 280 *** ^ | 602 / 1,296 МГц | 2.21 ГГц | 512-бит | 141.7 Гб/с | 240 | 10 |

| GeForce GTX 285 *** ^ | 648 / 1,476 МГц | 2.48 ГГц | 512-бит | 159 Гб/с | 240 | 10 |

| GeForce GTX 295 ** *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 240 | 10 |

| GeForce 310 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 16 | 10.1 |

| GeForce 315 *** ^ | 475 / 1,100 МГц | 1.58 ГГц | 64-бит | 12.6 Гб/с | 48 | 10.1 |

| GeForce GT 320 *** ^ | 540 / 1,302 МГц | 1.58 ГГц | 128-бит | 25.3 Гб/с | 72 | 10.1 |

| GeForce GT 330 *** ^ | 500 / 1,250 МГц или 550 / 1,340 МГц | 1 ГГц или 1.6 ГГц | 128-бит, 192-бит, или 256-бит | (depends on config) | 96 или 112 | 10 |

| GeForce GT 340 *** ^ | 550 / 1,340 МГц | 3.4 ГГц | 128-бит | 54.4 Гб/с | 96 | 10.1 |

| GeForce GT 420 *** ^ | 700 / 1,400 МГц | 1.8 ГГц | 128-бит | 28.8 Гб/с | 48 | 11 |

| GeForce GT 430 *** ^ | 700 / 1,400 МГц | 1.8 ГГц | 128-бит | 28.8 Гб/с | 96 | 11 |

| GeForce GT 440 *** ^ | 594 / 1,189 МГц | 1.6 (1.5 GB) или 1.8 ГГц (3 GB) | 192-бит | 38.4 (1.5 GB) или 43.2 Гб/с (3 GB) | 144 | 11 |

| GeForce GTS 450 *** ^ | 783 / 1,566 МГц | 3.6 ГГц | 128-бит | 57.7 Гб/с | 192 | 11 |

| GeForce GTX 460 SE *** ^ | 650 / 1,300 МГц | 3.4 ГГц | 256-бит | 108.8 Гб/с | 288 | 11 |

| GeForce GTX 460 *** ^ | 675 / 1,350 МГц | 3.6 ГГц | 192-бит (768 МБ) или 256-бит (1 GB) | 86.4 Гб/с (768 МБ) или 115.2 Гб/с (1 GB) | 336 | 11 |

| GeForce GTX 465 *** ^ | 607 / 1,215 МГц | 3,206 МГц | 256-бит | 102.6 Гб/с | 352 | 11 |

| GeForce GTX 470 *** ^ | 607 / 1,215 МГц | 3,348 МГц | 320-бит | 133.9 Гб/с | 448 | 11 |

| GeForce GTX 480 *** ^ | 700 / 1,401 МГц | 3,696 МГц | 384-бит | 177.4 Гб/с | 480 | 11 |

| GeForce GTX 560 Ti *** ^ | 822 / 1,644 МГц | 4,008 МГц | 256-бит | 128.3 Гб/с | 384 | 11 |

| GeForce GTX 570 *** ^ | 732 / 1,464 МГц | 3.8 ГГц | 320-бит | 152 Гб/с | 480 | 11 |

| GeForce GTX 580 *** ^ | 772 / 1,544 МГц | 4,008 МГц | 384-бит | 192.4 Гб/с | 512 | 11 |

| GeForce GTX 580 | 607 / 1,215 МГц x2 | 3,414 МГц x2 | 3 |

hardwareguide.ru

Вспоминаем поколение видеокарт NVIDIA часть 3 — Блоги

NV30 5 поколение графических процессоров семейства GeForce, разработанное и выпущенное компанией NVIDIA в 2003—2004 годах

В январе 2003 года nVidia выпустила GeForce FX 5800 (NV30). Эта карта была раскритикована как за производительность, которая попросту была недостойна high-end модели, так и за высокий уровень шума NV30 оказалась коммерческим провалом, хотя nVidia иногда и говорит, что промахи — одни из лучших событий, что могут случаться с компанией

Используемая версия шейдеров DirectX Shader Model 2.0a преподносилась компанией как прорыв в область кинематографичных эффектов. Однако, производительность шейдеров оказалась низкой, по сравнению с линейкой конкурентов

но при соответствующей оптимизации вполне удовлетворительна для игроков.

Первоначально выпущенный чип NV30 обладал очень низкой производительностью в вычислениях одинарной точности. Nvidia призывала разработчиков использовать половинную точность и включала в драйвера оптимизации, заменяющие вычисления одинарной точности на вычисления с половинной точностью.

Версия Ultra у видеокарты была быстрее (или, скажем, не такая медленная), с тактовой частотой 500 МГц для GPU и памяти (DDR2).

Даже после провала NV30, nVidia решила сохранить архитектуру, представив GeForce FX 5900, призванную заменить GeForce FX 5800. С 256-битной шиной памяти и улучшенной производительностью вершинных шейдеров

Выпущенный позже NV35 обладал гораздо лучшей производительностью в расчётах одинарной точности, чем NV30.

GeForce FX 5900

FX 5950 Ultra (NV38)

шестое поколение трёхмерных графических акселераторов от корпорации NVIDIA .После провала NV30 nVidia приложила все усилия для возвращения утраченных позиции.

компани удалось чделать чип NV40,известной как GeForce 6800 карта была намного производительной, чем FX 5900, в том числе и из-за немалого числа транзисторов 222 млн

NV45, которая тоже называлась GeForce 6800, представляла собой ни что иное, как NV40 с мостом AGP-to-PCI Express, что позволяло карте поддерживать новый стандарт интерфейса и, кроме того, SLI. Технология SLI позволяла сочетать две видеокарты PCI Express GeForce 6 для повышения производительности.

GeForce 6800, AGP

6800 Ultra PCI-E

В 2005 году nVidia объявила седьмое поколение графических процессоров? Rодовое название GPU, которое традиционно было в виде NVxx, изменилось на Gxx.они так же поддерживают DirectX 9.0c и OpenGL 2.1 поточно-конвейерная архитектура претерпела серьёзные изменения, что позволило повысить производительность в полтора раза при том же количестве потоковых конвейеров.

Производство NVIDIA GeForce 7 серии началось с чипа G70 , GeForce 7800

за которой довольно быстро последовала G71 GeForce 7900

Видеокарты продавались во многих версиях, таких каких GTX и GS. Были выпущены и версии для интерфейса AGP с мостом PCI Express-to-AGP.

После выпуска GeForce 7900 nVidia стала впервые использовать технику, к которой не раз прибегали конкуренты: видеокарты с двумя GPU. У 7900GX2 и 7950GX2 два GPU G71 работали параллельно

7900GX2

7950GX2

8 серия графических акселераторов,анонсированная 8 ноября 2006 года G80 который имеет унифицированную шейдерную архитектуру. Эти видеокарты также имеют поддержку DirectX 10, OpenCL и Shader Model 4.0.Это первая серия видеокарт от NVIDIA, которая поддерживает CUDA — программирование общего назначения.

nVidia выжала из G80 максимум, а переход на 65-нм техпроцесс с G92 позволил компании сэкономить средства, снизив себестоимость производства чипа. nVidia меняла число потоковых процессоров, ширину шины памяти и тактовые частоты, чтобы увеличить ассортимент версий GeForce 8800 и 9800. Появились даже видеокарты с двумя GPU: GeForce 9800GX2.

Карты линейки GeForce 8800 все совместимы с DirectX 10, и nVidia оказалась очень и очень успешной с новой линейкой, что позволило не особо торопиться с преемницей.

G80 GeForce 8800gtx

G80 GeForce 8800 ultra

9 серия поколение графических микропроцессоров семейства GeForce базируется на модернизированной архитектуре G80, которая использовалась в видеокартах серии GeForce 8. Видеокарты верхнего ценового диапазона, которые базируются на графическом процессоре G92 являются ничем иным как переименованные видеокарты предыдущего поколения. Первая модель GeForce 9 появилась 29 февраля 2008 года.

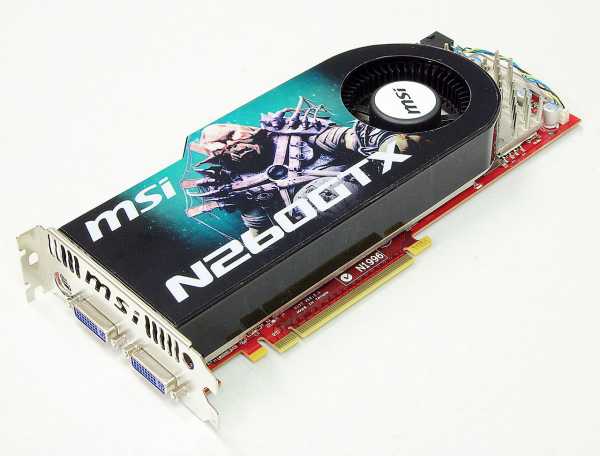

G92 9800 GTX

2 x G92 9800GX2

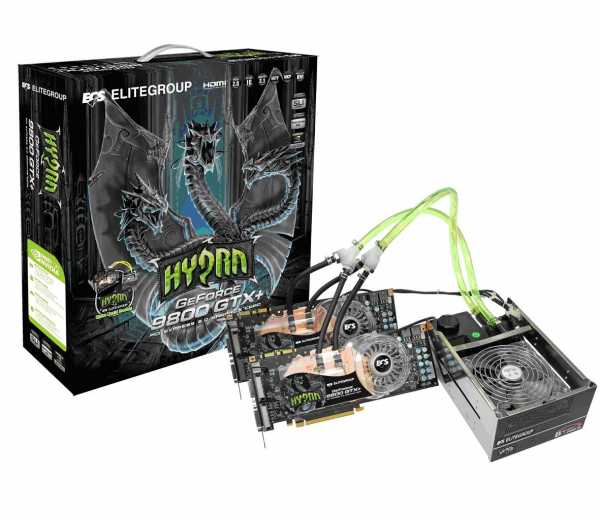

Еще одной ожидаемой новинкой является графический процессор NVIDIA GeForce 9800 GTX+, точнее видеокарты на нем основными отличительными особенностями GeForce 9800 GTX+ от обычногоGeForce 9800GTX является новый более тонкий 55 нм техпроцесс, что позволило при условно неизменном тепловыделении задать графическому процессору более высокие тактовые частоты. Это, конечно же, должно положительно сказаться на производительности. Кроме того, любители разгона получают надежду на лучший разгонный потенциал обновленного GPU.

GeForce 9800 GTX+

www.playground.ru

Почему 10 поколение видеокарт Nvidia — реальный ТОП — Блоги

Начну я с того что обычно ударенные на голову фанаты зеленых всегда меня считают почемут сторонником АМД. Хотя если судить по решениям которые у меня были в плане видеокарт – может сложиться такое ложное впечатление. Связано это с тем что АМД начиная с 5000й серии делала всегда карты в том ценовом диапазоне что меня интересовали всегда лучше в плане цена\производительность – повышенное ТПД и кривоватые драйвера на начальной стадии выхода продукта меня мало пугали. Но продукцию зеленых когда она была оптимальна я тоже юзал – была у меня и Riva TNT2, и Geforce 2MX, и легендарная 8600GT – те когда у АМД карты хуже по всем параметрам – без колебаний выбиралась продукция зеленой компании. И вот похоже снова пришло такое время – взамен старой карты был выбран продукт зеленой компании – GTX 1060 6g. Почему – потому что 10я серия мало того что по сравнению со старой 9й выглядит в разы интересней, но она смогла обставить и конкурентов даже в тех пунктах, за счет которых раньше они выбивались вперед. А почему так – описано ниже.

1.Полный охват всех ценовых диапазонов.

Итак по сравнению с 9й серией были учтены ошибки. Что мы имеем – практически полный охват картами даже бюджетных решений.

Супербдюджет –GTX 1030\1050

Бюджет –GTX 1050TI\1060

Средний сегмент –GTX 1070\1080

Топ —GTX 1080TI\Titan Xp

В той же 9й серии лоу-энд супербюджета вообще не был представлен – зеленые отмахнулись типа юзайте старые решения типа 750TI\750 и выпустили только GTX 950. А в топе предназначенном для 4к карт вообще тупо не было – хваленый Титан даже в стандартных 60фпс это разрешение не тянул.

- Правильное позиционирование оперативной памяти видеокарт.

«Испокон веков» карты зеленых страдали одной проблемой – вечным дефицитом оперативной памяти. Карты красных на фоне них всегда хорошо выделялись. В том же 9м поколении зеленых дошло до того что к примеру паритетные карты GTX 970\980 имели в 2!!! раза меньший объем чем конкурентные им R9 380\380X. Но в 10м поколении до Нвидивцев походу доперло что «так жить нельзя»(с). И мало того – объем видеопамяти ПРАВИЛЬНО распределили по сегментам.

Супербюджет – 2g

Бюджет 4-6g

Средний сегмент – 8г

Топ – 11\12г

Честь и хвала инженерам зеленой компании – тут они не промахнулись НИ РАЗУ. Хотя есть один…но об этом в конце повествования.

3.Полная поддержкаDX12.

Тут все понятно, если все старые решения поддерживали DX12 только на уровне драйвера (при этом сливая аналогичным старым решениям от АМД в режиме работы в этом API), то 10я серия – 100% DX12 совместимая, такой проблемы у нее уже нет, игры как и должны на ней в DX12 работают БЫСТРЕЙ чем в DX11.

Подытожим – хотя всеж ложка дегтя во всей серии чутка есть (это «отбракованные» картыGTX 1060c 3г оперативной памяти), в целом серия – идеал. То что Хуанг смог дополнительно уменьшить энергопотребление продуктов и практически сразу вывел все базовые решения на рынок только дополняет эпик вин.

А теперь пару слов как компания АМД помогла в этот раз своим конкурентам. Хотелось бы тут сказать матом, но постараемся всеж без него. Во первых – задержка выхода решений даже среднего сегмента (низкий и высокий вообще отстали от слова совсем). Во вторых – отсутствие карт в продаже и как следствие – повышенный ценник на продукты АМД. И мне глубоко насрать кто там виноват – майнеры, масоны, инопланетяне и тд – факт остается фактом, AМД тупо не смогли обеспечить нужное количество видеокарт для потребления рынком. Далее непонятная история с размером оперативной памяти для RX 470\570\480\580. 100% ЛОГИЧНО было сделать по ней старшие решения — только 8г, младшие – только 4г. Но этого сделано не было. В результате – имеем никому не нужные 480\580ки с 4мя гигами (любой нормальный человек выберет 1060 6g) и опять же никому не нужные (уже исходя из ценника, ибо память ДОРОГАЯ) 470\570 с 8ю гигами которые младшей карте по сути не нужны от слова совсем (опять же любой нормальный выберет GTX 1060 6g потому что она БЫСТРЕЙ и ДЕШЕВЛЕ). И последнее – если вышедшая Вега очень хорошо смотрится в среднем сегменте перекрывая все решения от зеленых, то в топе ее тупо нет. Я понимаю есть VEGA 64 LC но при всем уважении к красным – это обычная 64 Вега «на стероидах» — выбрали чипы получше и разогнали на воде – реально нормального решения под 4к у красных на данный момент НЕТ.

На сим и откланиваюсь.

www.playground.ru